Heim >Technologie-Peripheriegeräte >KI >Wie zuverlässig sind große Modelle? Das neueste Tutorial von IBM und anderen Wissenschaftlern zum Thema „Grundlegende Robustheit von Basismodellen'

Wie zuverlässig sind große Modelle? Das neueste Tutorial von IBM und anderen Wissenschaftlern zum Thema „Grundlegende Robustheit von Basismodellen'

- 王林nach vorne

- 2023-04-11 22:43:061304Durchsuche

Als eine der renommiertesten akademischen KI-Konferenzen der Welt ist NeurIPS jedes Jahr eine wichtige Veranstaltung in der akademischen Gemeinschaft. Der vollständige Name lautet „Neural Information Processing Systems“ und wird normalerweise jedes Jahr im Dezember von der NeurIPS Foundation ausgerichtet.

Die auf der Konferenz diskutierten Inhalte umfassen Deep Learning, Computer Vision, groß angelegtes maschinelles Lernen, Lerntheorie, Optimierung, Sparsity-Theorie und viele andere Unterteilungen.

In diesem Jahr ist NeurIPS die 36. Ausgabe und findet zwei Wochen lang vom 28. November bis 9. Dezember statt.

Die erste Woche wird ein persönliches Treffen im Ernest N. Morial Convention Center in New Orleans, USA, sein und die zweite Woche wird ein Online-Meeting sein.

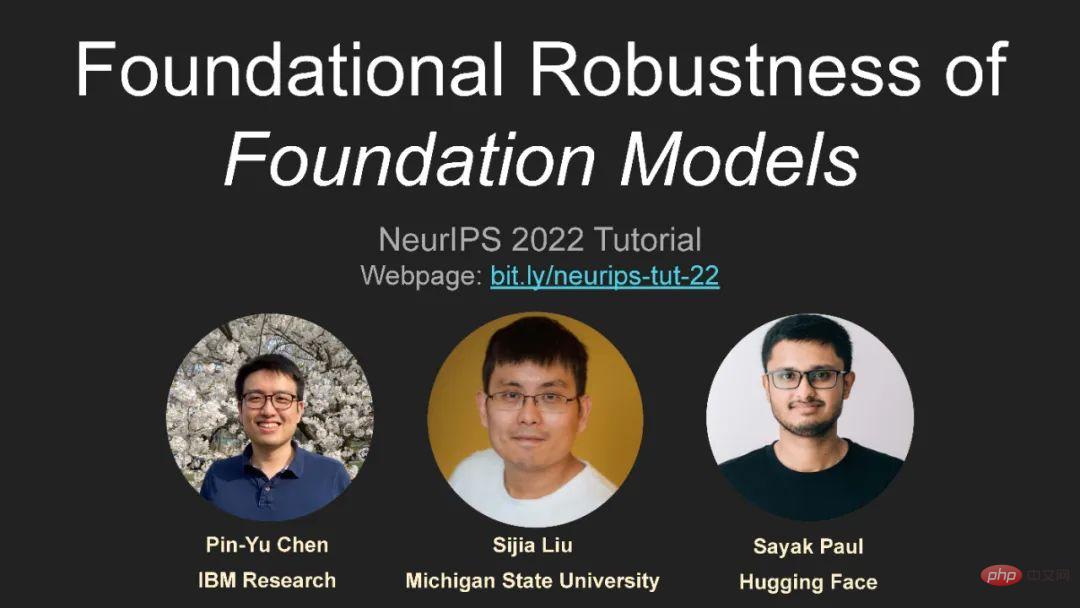

Wissenschaftler des IBM Research Center und andere Wissenschaftler sprechen über die Robustheit großer Modelle, die sehr beachtenswert ist!

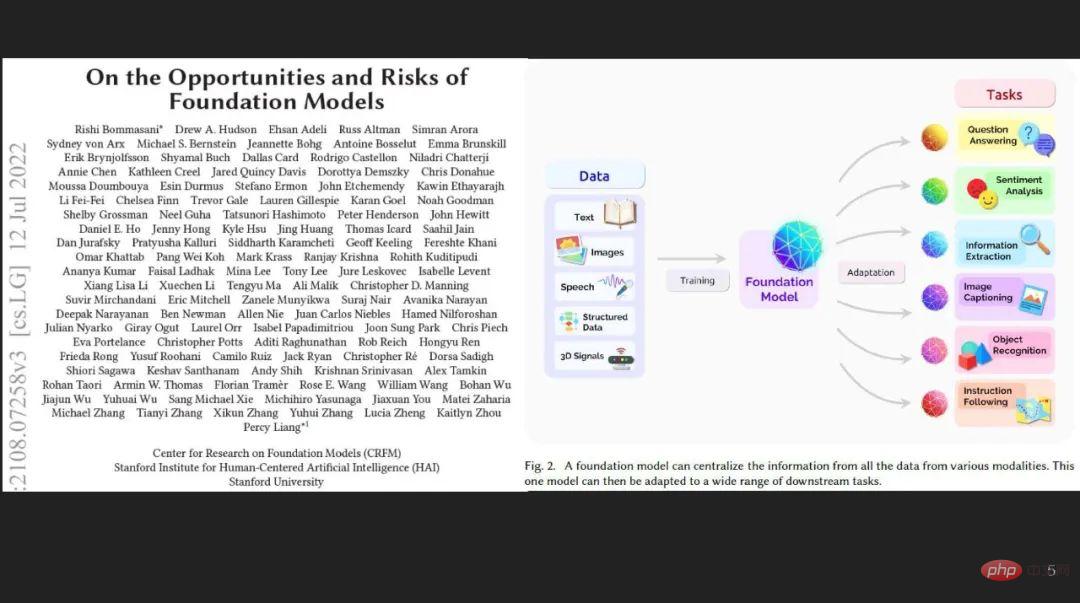

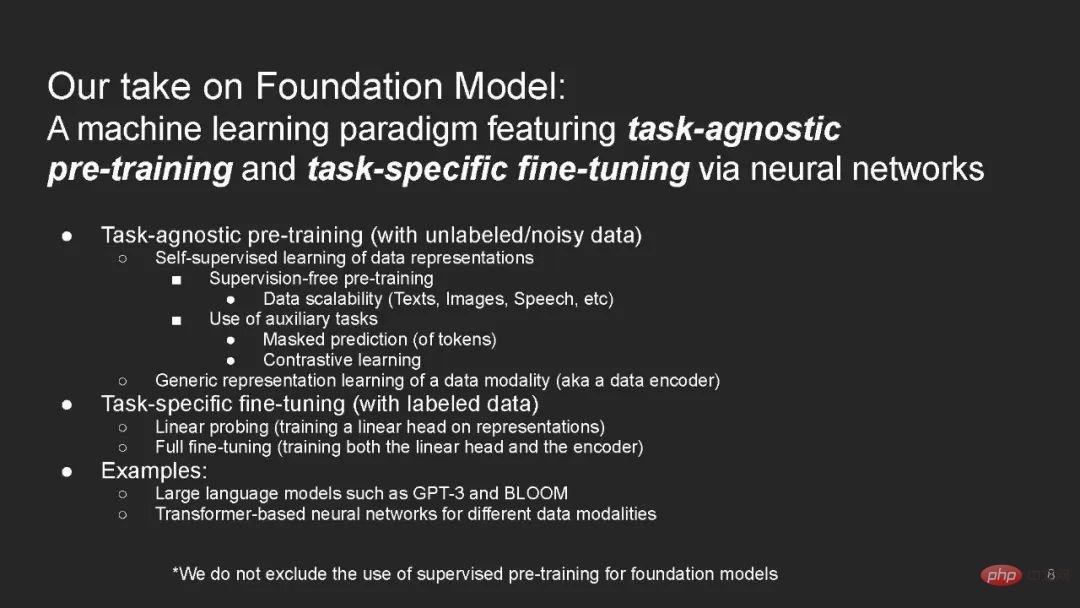

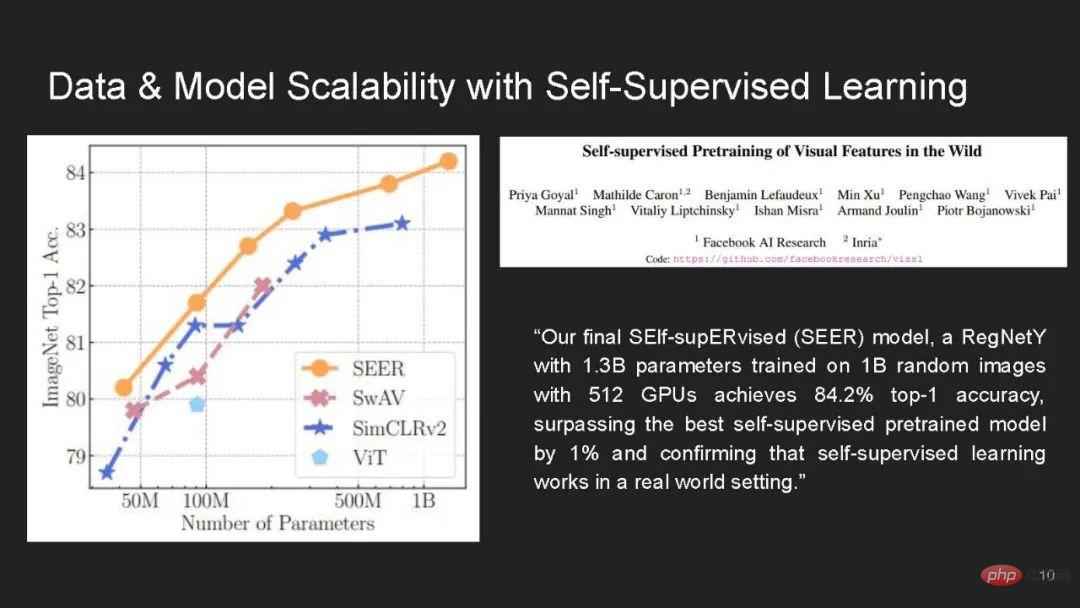

Das Grundmodell verwendet eine Deep-Learning-Methode, ein Vortraining auf großen, unbeschrifteten Daten und eine Feinabstimmung durch Überwachung spezifischer Aufgaben, die zur Mainstream-Technologie des maschinellen Lernens wird.

Während Basismodelle beim Erlernen allgemeiner Darstellungen und der Verallgemeinerung mit wenigen oder null Schüssen über Domänen und Datenmuster hinweg vielversprechend sind, leiden sie gleichzeitig unter Einschränkungen aufgrund der Verwendung übermäßiger Datenmengen und komplexer neuronaler Netzwerkarchitekturen Dies bringt beispiellose Herausforderungen und erhebliche Risiken in Bezug auf Sicherheit und Datenschutz mit sich.

Dieses Tutorial zielt darauf ab, ein Coursera-ähnliches Online-Tutorial mit umfassenden Vorlesungen, einer praktischen und interaktiven Jupyter/Colab-Live-Coding-Demonstration und einer Gruppendiskussion über verschiedene Aspekte der Vertrauenswürdigkeit im zugrunde liegenden Modell bereitzustellen.

https://sites.google.com/view/neurips2022-frfm-turotial

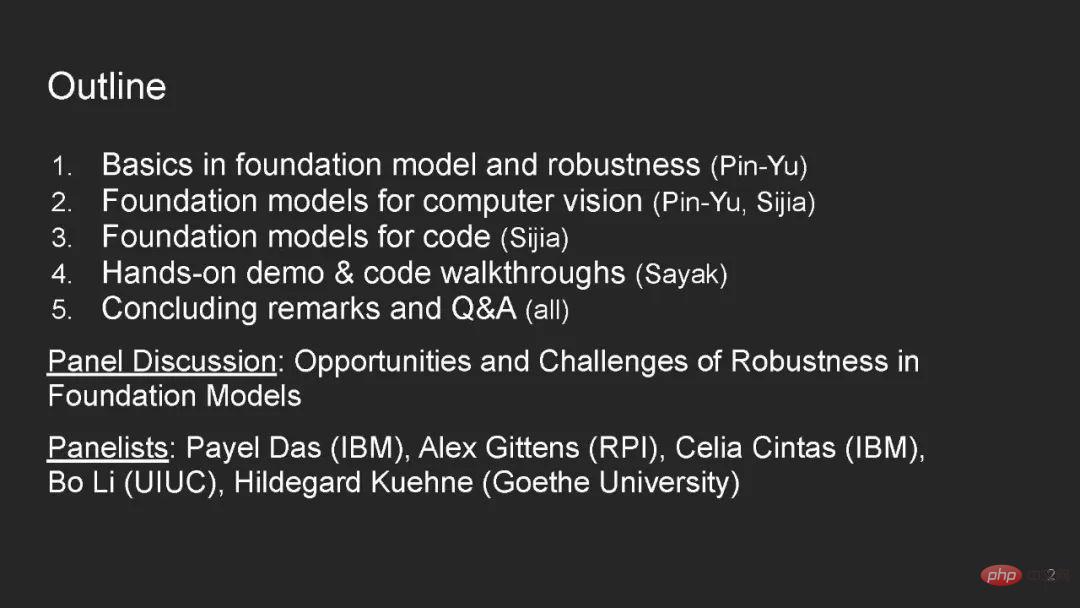

Verzeichnisinhalt:

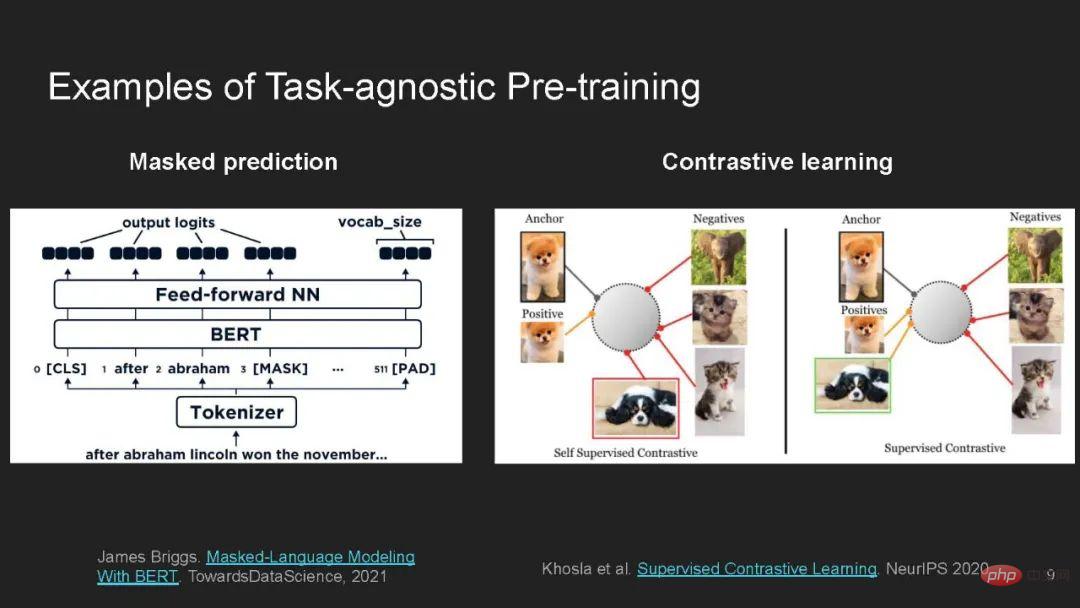

- Grundlagen zu Fundamentmodellen und Robustheit

- Tiefer Einblick in Fundamentmodelle für Computer Vision: Detaillierter Einblick in Grundlagenmodelle für Code Sprecher:

- Reale maschinelle Lernsysteme müssen robust gegenüber Verteilungsänderungen sein – sie sollten gut auf Testverteilungen funktionieren, die sich von der Trainingsverteilung unterscheiden.

- Wie Armutskarten in Ländern mit geringen Ressourcen [Xie et al. 2016], selbstfahrende Autos [Yu et al. 2020a], medizinische Diagnose al. 2018; Dai und Gool 2018] Solche Hochrisikoanwendungen erfordern eine gute Verallgemeinerung des Modells auf Umgebungen, die in den Trainingsdaten nicht vorkommen. Beispielsweise stammen die Testproben aus verschiedenen Ländern, befinden sich in unterschiedlichen Fahrbedingungen oder stammen aus unterschiedlichen Ländern Krankenhäuser.

- Frühere Arbeiten haben gezeigt, dass diese Verteilungsänderungen selbst für aktuelle Modelle nach dem Stand der Technik führen können [Blitzer et al. 2007; Peng et al. 2019; Szegedy et al. 2019; Yu et al. 2020b; Geirhos et al. 2021;

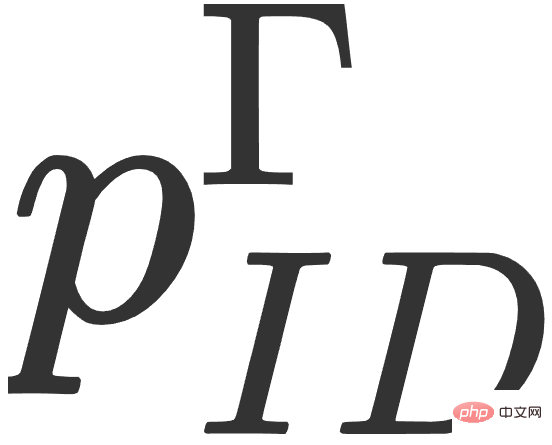

Ein Basismodell wird anhand eines großen und vielfältigen unbeschrifteten Datensatzes trainiert, der aus einer Verteilung  entnommen wurde, und kann dann an viele nachgelagerte Aufgaben angepasst werden.

entnommen wurde, und kann dann an viele nachgelagerte Aufgaben angepasst werden.

Für jede Downstream-Aufgabe  wird das Basismodell anhand gekennzeichneter In-Distribution (ID)-Trainingsdaten trainiert, die aus der Trainingsverteilung

wird das Basismodell anhand gekennzeichneter In-Distribution (ID)-Trainingsdaten trainiert, die aus der Trainingsverteilung  entnommen werden, und anschließend wird die Out-Distribution of-Distribution (OOD) anhand dieser ausgewertet Testverteilung

entnommen werden, und anschließend wird die Out-Distribution of-Distribution (OOD) anhand dieser ausgewertet Testverteilung  .

.

Zum Beispiel kann ein Armutskarten-Vorhersagemodell [Xie et al. 2016] nützliche Funktionen für alle Länder in unbeschrifteten Satellitendaten aus der ganzen Welt lernen und dann beschriftete Stichproben aus Nigeria verwenden. Die Abstimmung erfolgt anhand von Beispielen und wird schließlich in Malawi ausgewertet, wo es an gekennzeichneten Beispielen mangelt.

Wir glauben, dass: 1) Das Basismodell ein besonders vielversprechender Ansatz in Bezug auf Robustheit ist. Vorhandene Arbeiten zeigen, dass das Vortraining an unbeschrifteten Daten eine wirksame und allgemeine Methode zur Verbesserung der Genauigkeit der OOD-Testverteilung ist, im Gegensatz zu vielen Robustheitsinterventionen, die auf begrenzte Verteilungsänderungen beschränkt sind.

Allerdings haben wir auch 2) besprochen, warum das zugrunde liegende Modell möglicherweise nicht immer mit Verteilungsänderungen zurechtkommt, beispielsweise aufgrund von falschen Korrelationen oder Verteilungsänderungen im Laufe der Zeit.

Abschließend 3) skizzieren wir mehrere Forschungsrichtungen, um die Robustheit des zugrunde liegenden Modells zu nutzen und zu verbessern.

Wir haben festgestellt, dass eine Möglichkeit für das Basismodell, die Leistung nachgelagerter Aufgaben zu verbessern, darin besteht, induktive Verzerrungen (durch Modellinitialisierung) für das angepasste Modell bereitzustellen. Diese Verzerrungen werden zusätzlich zum nachgelagerten Modell auf einer Vielzahl von Datensätzen gelernt Trainingsdaten von.

Derselbe induktive Bias kann jedoch auch schädliche Assoziationen aus Daten vor dem Training kodieren und bei Verteilungsänderungen zu Darstellungs- und Zuordnungsschäden führen.

Das obige ist der detaillierte Inhalt vonWie zuverlässig sind große Modelle? Das neueste Tutorial von IBM und anderen Wissenschaftlern zum Thema „Grundlegende Robustheit von Basismodellen'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr