Heim >Technologie-Peripheriegeräte >KI >Ist Metas Open-Source-ChatGPT-Ersatz einfach zu verwenden? Die Testergebnisse und Modifikationsmethoden wurden veröffentlicht, 5,2.000 Sterne in 2 Tagen

Ist Metas Open-Source-ChatGPT-Ersatz einfach zu verwenden? Die Testergebnisse und Modifikationsmethoden wurden veröffentlicht, 5,2.000 Sterne in 2 Tagen

- PHPznach vorne

- 2023-04-11 22:25:011330Durchsuche

Die anhaltende Beliebtheit von ChatGPT hat große Technologieunternehmen bereits unruhig gemacht.

Erst in der vergangenen Woche hat Meta eine neue große Modellreihe „Open Source“ veröffentlicht – LLaMA#🎜 🎜# (Large Language Model Meta AI), die Anzahl der Parameter reicht von 7 Milliarden bis 65 Milliarden. Da LLaMA über weniger Parameter, aber eine bessere Leistung als viele zuvor veröffentlichte große Modelle verfügt, waren viele Forscher bei seiner Veröffentlichung begeistert.

Zum Beispiel kann das LLaMA-Modell mit 13 Milliarden Parametern das GPT-3 mit 175 Milliarden Parametern „bei den meisten Benchmarks“ übertreffen und auf einem einzelnen V100 laufen, das auf einer GPU läuft; Das größte LLaMA-Modell mit 65 Milliarden Parametern ist mit Googles Chinchilla-70B und PaLM-540B vergleichbar.

Die Reduzierung der Anzahl der Parameter ist eine gute Sache für normale Forscher und kommerzielle Institutionen, aber schneidet LLaMA wirklich so gut ab, wie es im Papier heißt? Kann LLaMA im Vergleich zum aktuellen ChatGPT kaum mithalten? Um diese Fragen zu beantworten, haben einige Forscher dieses Modell getestet.

Einige Unternehmen versuchen bereits, die Mängel von LLaMA auszugleichen und möchten sehen, ob sie die Leistung von LLaMA verbessern können, indem sie Trainingsmethoden wie RLHF hinzufügen.

LLaMA Vorläufige RezensionDiese Rezension stammt von einem Medium-Autor namens @Enryu. Es vergleicht die Leistung von LLaMA und ChatGPT bei drei anspruchsvollen Aufgaben der Witzinterpretation, der Zero-Shot-Klassifizierung und der Codegenerierung. Der dazugehörige Blogbeitrag ist „Mini-Beitrag: Erster Blick auf LLaMA“.

Der Autor führt die LLaMA 7B/13B-Version auf RTX 3090/RTX 4090 und die 33B-Version auf einem einzelnen A100 aus.

Es ist zu beachten, dass andere Modelle im Gegensatz zu ChatGPT nicht auf der Feinabstimmung von Anweisungen basieren, sodass die Struktur der Eingabeaufforderung anders ist.

Den Witz erklären

Dies wird im Original-PaLM von Google angezeigt Papier Ein Anwendungsfall für: Machen Sie einen Witz und bitten Sie das Modell, zu erklären, warum er lustig ist. Diese Mission erfordert eine Kombination aus Weltwissen und einer grundlegenden Logik. Alle Modelle vor PaLM waren dazu nicht in der Lage. Die Autoren extrahierten einige Beispiele aus dem PaLM-Artikel und verglichen die Leistung von LLaMA-7B, LLaMA-13B, LLaMA-33B mit ChatGPT.

# 🎜 🎜#

Allerdings hat ChatGPT zumindest den Witz über Schmidthuber verstanden. Aber insgesamt ist die Leistung dieser Modelle bei der Null-Stichproben-Witzinterpretationsaufgabe weit von PaLM entfernt (es sei denn, die Beispiele von PaLM werden sorgfältig ausgewählt). Die zweite vom Autor als noch anspruchsvollere Aufgabe betrachtete die Clickbait-Klassifizierung. Da sich nicht einmal Menschen darüber einig sind, was Clickbait ist, stellen die Autoren in der Eingabeaufforderung einige Beispiele für diese Modelle bereit (also tatsächlich kleine Stichproben statt Nullstichproben). Das Folgende ist die Eingabeaufforderung von LLaMa:

I will tell whether the following news titles are clickbait:

1) The WORST care homes in England: Interactive map reveals the lowest-rated 2,530 residences - so is there one near you?

Clickbait: yes

2) Netflix's top 10 most-watched movies of all time

Clickbait: yes

3) Peering Through the Fog of Inflation

Clickbait: no

4) You’ll never believe which TV cook this cheeky chap grew up to be

Clickbait: yes

很明显,赢家为 LLaMA-33B,它是唯一一个能够遵循所有请求格式(yes/no)的模型,并且预测合理。ChatGPT 也还可以,但有些预测不太合理,格式也有错误。较小的模型(7B/13B)不适用于该任务。

代码生成

虽然 LLM 擅长人文学科,但在 STEM 学科上表现糟糕。LLaMA 虽然有基准测试结果,但作者在代码生成领域尝试了一些特别的东西,即将人类语言零样本地转换为 SQL 查询。这并不是很实用,在现实生活中直接编写查询会更有效率。这里只作为代码生成任务的一个示例。

在 prompt 中,作者提供表模式(table schema)以及想要实现的目标,要求模型给出 SQL 查询。如下为一些随机示例,老实说,ChatGPT 看起来效果更好。

-- We have a table `events` with columns `event_id`, `timestamp`, `user_id`, `rpc_method`. -- We want to count how many users issued request "Login" over the last week. -- SQL query for this is: -- 7b SELECT count (*) FROM events WHERE user_id IN (SELECT user_id FROM events WHERE timestamp >= NOW () - INTERVAL 7 DAY) AND rpc_method = 'Login'; -- 13b SELECT COUNT (*) FROM events WHERE rpc_method = "Login" AND UNIX_TIMESTAMP (timestamp) >= UNIX_TIMESTAMP (CURRENT_DATE - INTERVAL 7 DAY) -- 33b SELECT user_id, COUNT (DISTINCT user_id) AS total FROM events WHERE timestamp BETWEEN TIMESTAMP '2013-08-14 00:00:00' AND TIMESTAMP '2013-08-21 00:00:00' AND rpc_method = 'Login' GROUP BY user_id -- ChatGPT SELECT COUNT (DISTINCT user_id) FROM events WHERE rpc_method = 'Login' AND timestamp >= DATE_SUB (NOW (), INTERVAL 1 WEEK);

从测试结果来看,LLaMA 在一些任务上表现还不错,但在另一些任务上和 ChatGPT 还有一些差距。如果能像 ChatGPT 一样加入一些「训练秘籍」,效果会不会大幅提升?

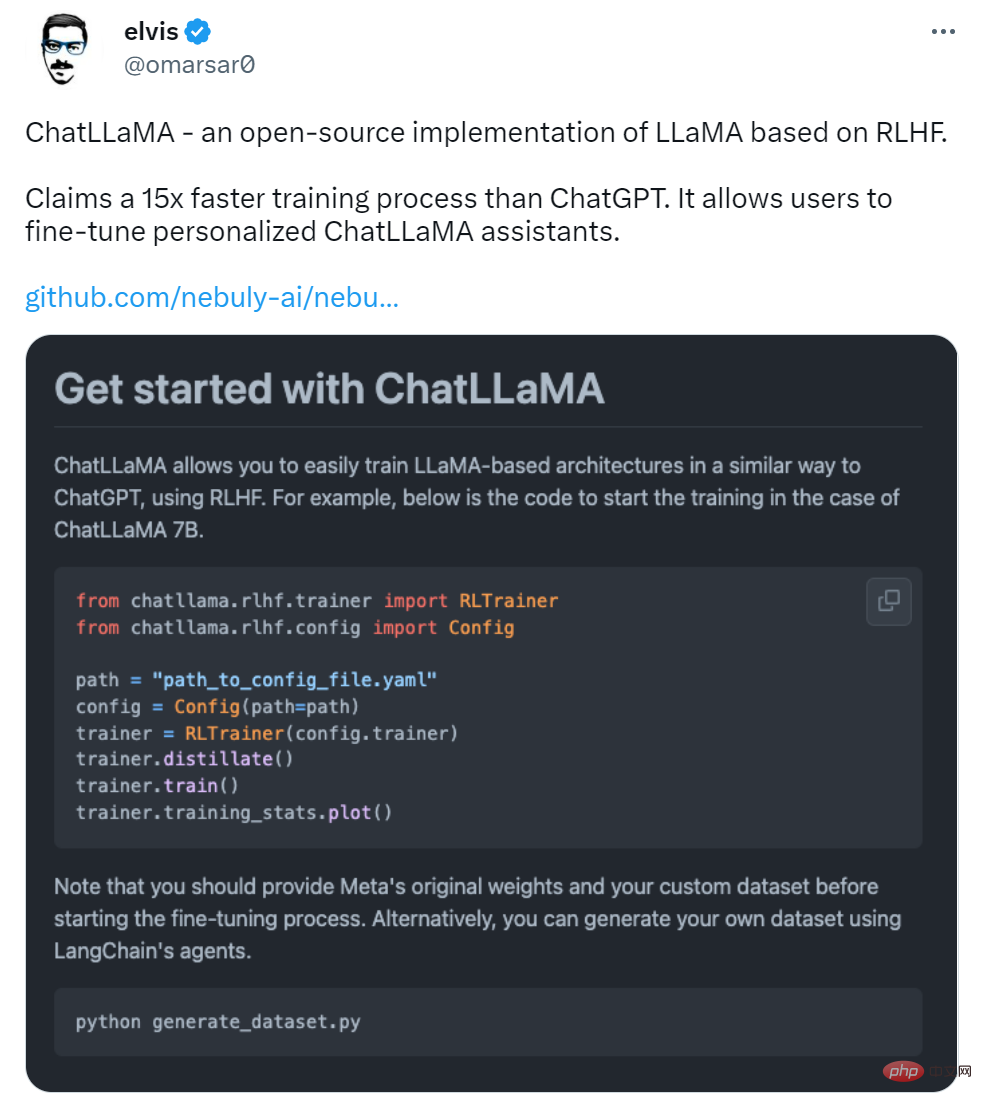

加入 RLHF,初创公司 Nebuly AI 开源 ChatLLaMA 训练方法

虽然 LLaMA 发布之初就得到众多研究者的青睐,但是少了 RLHF 的加持,从上述评测结果来看,还是差点意思。

在 LLaMA 发布三天后,初创公司 Nebuly AI 开源了 RLHF 版 LLaMA(ChatLLaMA)的训练方法。它的训练过程类似 ChatGPT,该项目允许基于预训练的 LLaMA 模型构建 ChatGPT 形式的服务。项目上线刚刚 2 天,狂揽 5.2K 星。

项目地址:https://github.com/nebuly-ai/nebullvm/tree/main/apps/accelerate/chatllama

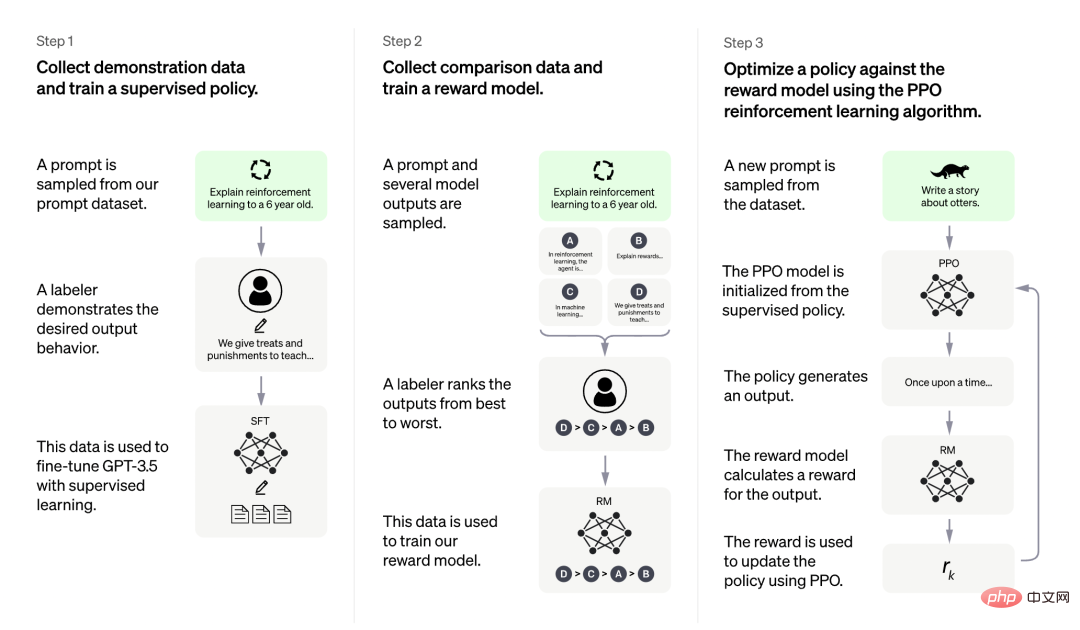

ChatLLaMA 训练过程算法实现主打比 ChatGPT 训练更快、更便宜,我们可以从以下四点得到验证:

- ChatLLaMA 是一个完整的开源实现,允许用户基于预训练的 LLaMA 模型构建 ChatGPT 风格的服务;

- 与 ChatGPT 相比,LLaMA 架构更小,但训练过程和单 GPU 推理速度更快,成本更低;

- ChatLLaMA 内置了对 DeepSpeed ZERO 的支持,以加速微调过程;

- 该库还支持所有的 LLaMA 模型架构(7B、13B、33B、65B),因此用户可以根据训练时间和推理性能偏好对模型进行微调。

图源:https://openai.com/blog/chatgpt

更是有研究者表示,ChatLLaMA 比 ChatGPT 训练速度最高快 15 倍。

不过有人对这一说法提出质疑,认为该项目没有给出准确的衡量标准。

项目刚刚上线 2 天,还处于早期阶段,用户可以通过以下添加项进一步扩展:

- 带有微调权重的 Checkpoint;

- 用于快速推理的优化技术;

- 支持将模型打包到有效的部署框架中。

Nebuly AI 希望更多人加入进来,创造更高效和开放的 ChatGPT 类助手。

该如何使用呢?首先是使用 pip 安装软件包:

pip install chatllama-py

然后是克隆 LLaMA 模型:

git clone https://github.com/facebookresearch/llama.gitcd llama pip install -r requirements.txt pip install -e .

一切准备就绪后,就可以运行了,项目中介绍了 ChatLLaMA 7B 的训练示例,感兴趣的小伙伴可以查看原项目。

Das obige ist der detaillierte Inhalt vonIst Metas Open-Source-ChatGPT-Ersatz einfach zu verwenden? Die Testergebnisse und Modifikationsmethoden wurden veröffentlicht, 5,2.000 Sterne in 2 Tagen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr