Heim >Technologie-Peripheriegeräte >KI >AIGC, das sich an den menschlichen kreativen Prozess anpasst: Es entsteht ein Modell zur automatischen Generierung von Wachstumsgeschichten

AIGC, das sich an den menschlichen kreativen Prozess anpasst: Es entsteht ein Modell zur automatischen Generierung von Wachstumsgeschichten

- 王林nach vorne

- 2023-04-11 22:13:011827Durchsuche

Im heutigen Bereich der künstlichen Intelligenz tauchen nach und nach KI-Schreibartefakte auf, und Technologie und Produkte ändern sich mit jedem Tag.

Wenn es beim vor zwei Jahren von OpenAI veröffentlichten GPT-3 noch ein wenig an Schrift mangelt, dann können die generierten Ergebnisse von ChatGPT vor einiger Zeit als „wunderschön“ angesehen werden Schreiben und Handlung. „Es ist sowohl vollständig als auch logisch und in sich stimmig.“

Manche Leute sagen, wenn KI anfängt zu schreiben, hat das wirklich nichts mit Menschen zu tun.

Aber egal, ob es sich um Menschen oder KI handelt, sobald die „Wortzahlanforderung“ erhöht wird, wird es schwieriger, den Artikel zu „kontrollieren“.

Kürzlich haben der chinesische KI-Forscher Tian Yuandong und mehrere andere Forscher kürzlich ein neues Sprachmodell veröffentlicht – Re^3. Diese Forschung wurde auch für EMNLP 2022 ausgewählt.

Papierlink: https://arxiv. org/pdf/2210.06774.pdf

Tian Yuandong hat dieses Modell einmal auf Zhihu vorgestellt:

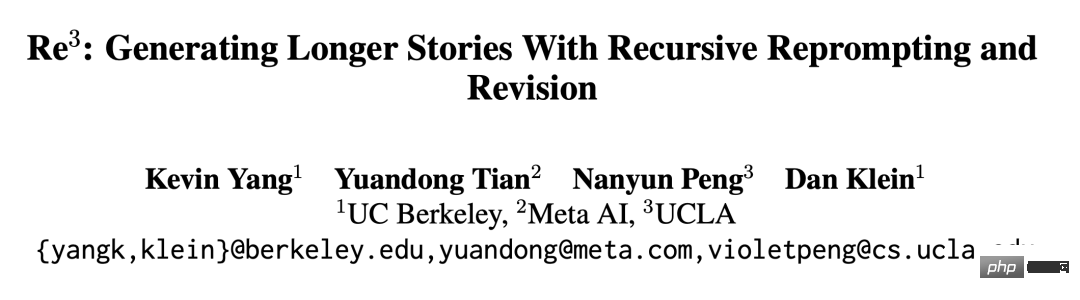

Das Die Idee von Re^3 ist äußerst einfach. Durch das Entwerfen von Eingabeaufforderungen können konsistente Geschichten generiert werden, ohne dass große Modelle optimiert werden müssen. Wir verlassen die lineare Logik der Wort-für-Wort-Generierung des Sprachmodells und verwenden eine hierarchische Generierungsmethode: Generieren Sie zunächst die Story-Charaktere, verschiedene Attribute und Umrisse der Charaktere in der Planphase und geben Sie dann die Story-Umrisse und Rollen in der Entwurfsphase und generieren wiederholt bestimmte Absätze. Diese spezifischen Absätze werden in der Rewrite-Phase gefiltert, um generierte Absätze auszuwählen, die in hohem Maße mit dem vorherigen Absatz zusammenhängen, während diejenigen verworfen werden, die nicht eng miteinander verbunden sind (dies erfordert das Training eines kleinen Modells). und schließlich einige offensichtliche sachliche Fehler in der Bearbeitungsphase korrigieren. MethodeneinführungDie Idee von Re^3 besteht darin, durch rekursives Reprompt und Anpassungen längere Geschichten zu generieren, was eher dem kreativen Prozess entspricht menschlicher Schriftsteller. Re^3 unterteilt den menschlichen Schreibprozess in vier Module: Planung, Entwurf, Umschreiben und Bearbeitung. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜##Plan -Modul

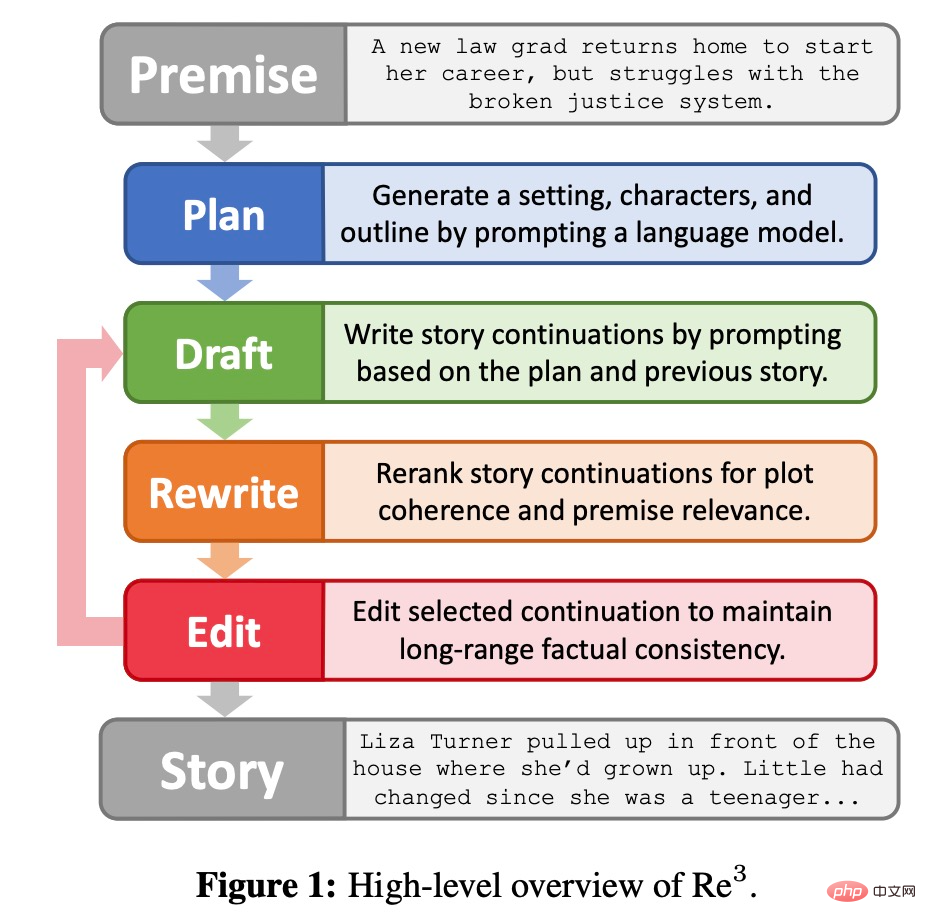

### 🎜🎜##🎜🎜 🎜🎜 #Wie in Abbildung 2 unten dargestellt, erweitert das Planungsmodul die Story-Prämisse um Hintergrund, Charaktere und Story-Umriss. Erstens ist der Hintergrund eine einfache Ein-Satz-Erweiterung der Story-Prämisse, die mit GPT3-Instruct-175B (Ouyang et al., 2022) erhalten wurde; dann generiert GPT3-Instruct175B Charakternamen neu und generiert Charakterbeschreibungen basierend auf der Prämisse und dem Hintergrund ; schließlich fordert die Methode GPT3-Instruct175B auf, die Story-Gliederung zu schreiben. Die Komponenten im Planungsmodul werden von prompt selbst generiert und immer wieder verwendet.

Entwurfsmodul

# 🎜 🎜#

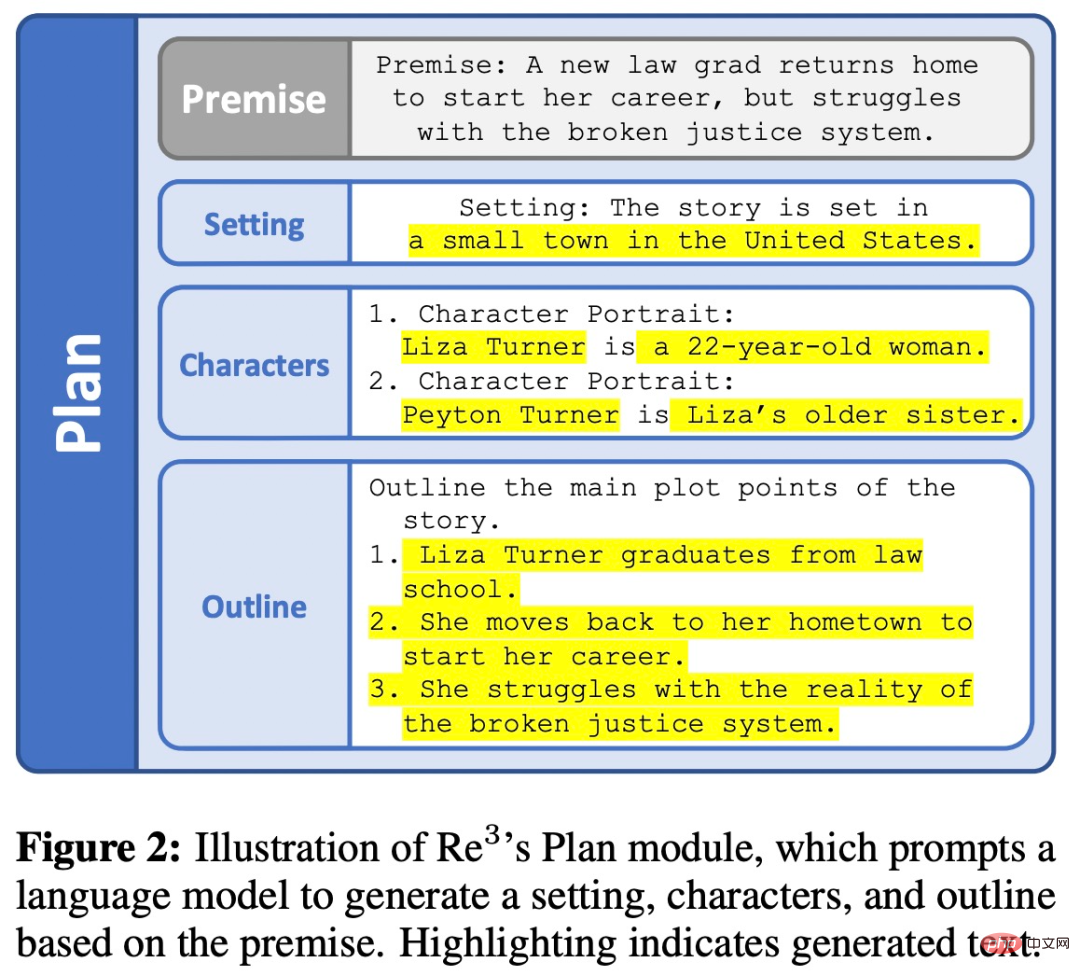

Für jede vom Planungsmodul erhaltene Gliederung generiert das Entwurfsmodul weiterhin mehrere Story-Absätze. Jeder Absatz ist eine Fortsetzung mit fester Länge, die aus einer strukturierten Eingabeaufforderung generiert wird, die durch eine rekursive erneute Eingabeaufforderung gebildet wird. Das Entwurfsmodul ist in Abbildung 3 unten dargestellt.

Modul neu schreiben

# 🎜🎜 # Die erste Ausgabe des Generators ist normalerweise von geringer Qualität, wie der erste Entwurf, den die Leute fertigstellen, der zweite Entwurf erfordert möglicherweise das Umschreiben eines Artikels auf der Grundlage von Feedback.

Bearbeitungsmodul

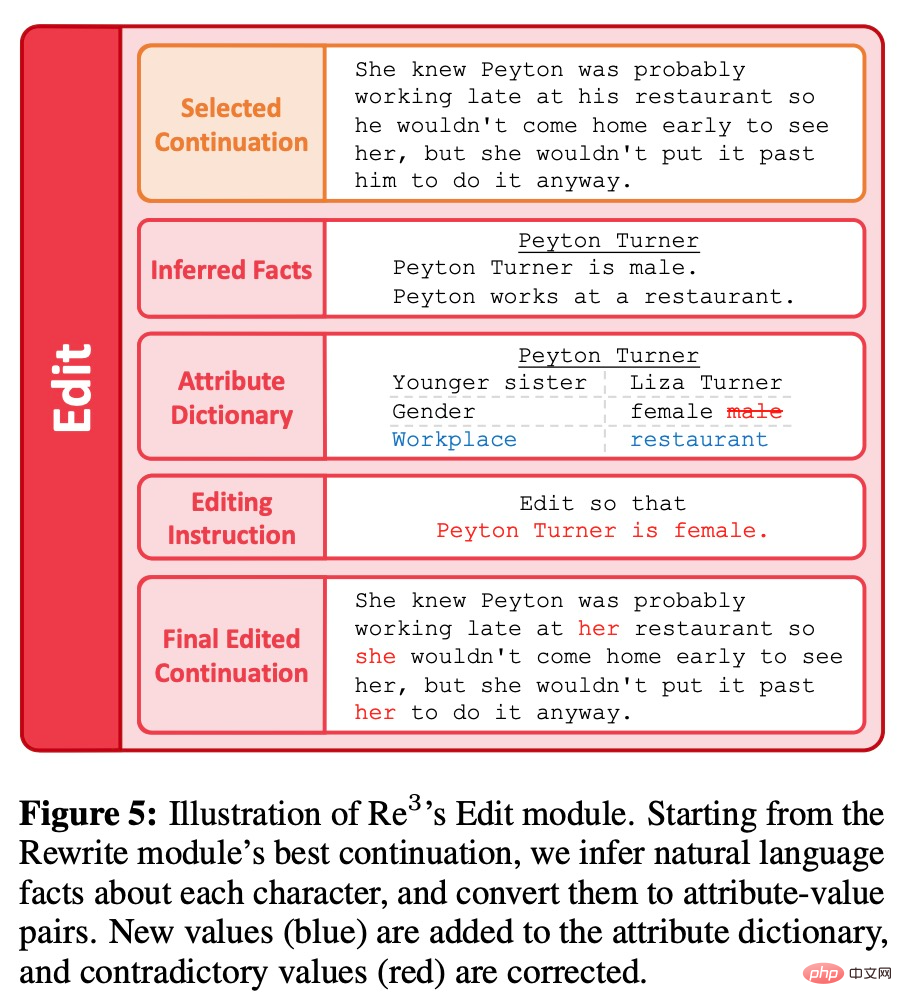

Im Gegensatz zum umfangreichen Umschreiben handelt es sich beim Bearbeitungsmodul um eine teilweise Bearbeitung der durch die Planungs-, Entwurfs- und Umschreibungsmodule generierten Absätze, um den generierten Inhalt weiter zu verbessern. Konkret geht es darum, lange Abfolgen sachlicher Inkonsistenzen zu beseitigen. Wenn man beim Korrekturlesen eine kleine sachliche Diskontinuität entdeckt, kann man einfach das problematische Detail bearbeiten, anstatt den übergeordneten Artikelplan umfassend zu überarbeiten oder inhaltlich umzuschreiben. Das Bearbeitungsmodul ahmt diesen Prozess des menschlichen Verfassens in zwei Schritten nach: Erkennen sachlicher Inkonsistenzen und deren Korrektur, wie in Abbildung 5 unten dargestellt.

Bewertung

In der Bewertungsphase stellte der Forscher die Aufgabe, auf der Grundlage eines kurzen Ausgangskontexts eine Geschichte zu generieren. Da es schwierig ist, „Geschichten“ auf regelbasierte Weise zu definieren, haben wir den akzeptablen Ergebnissen keine regelbasierten Einschränkungen auferlegt und sie stattdessen anhand mehrerer von Menschen kommentierter Metriken bewertet. Um erste Prämissen zu generieren, forderten die Forscher mit GPT3-Instruct-175B auf, 100 verschiedene Prämissen zu erhalten.

Baseline

Da sich die vorherige Methode im Vergleich zu Re^3 mehr auf Kurzgeschichten konzentrierte, ist ein direkter Vergleich schwierig. Daher verwendeten die Forscher die folgenden zwei Basislinien basierend auf GPT3-175B:

1, generieren Sie 256 Token gleichzeitig über GPT3-175B, verwenden Sie die vorherige Situation und den gesamten zuvor generierten Story-Text als Eingabeaufforderung, falls es mehr gibt Wenn ein Token größer als 768 ist, wird die Eingabeaufforderung links abgeschnitten. Daher beträgt die maximale Kontextlänge des „Rolling Window“ 1024, was der gleichen maximalen Kontextlänge entspricht, die in RE^3 verwendet wird. Nach der Generierung von 3072 Token verwendeten die Forscher denselben Story-Ende-Mechanismus wie RE^3.

2. Das Gleiche wie ROLLING, außer dass GPT3-175B zunächst Hunderte von Absätzen in der WritingPrompts-Story verfeinert, die mindestens 3000 Token haben.

Indikatoren

Zu den von Forschern verwendeten Bewertungsindikatoren gehören:

1. Interessant. Seien Sie für die Leser interessant.

2. Konsistenz. Die Handlung ist stimmig.

3. Relevanz. Bleiben Sie dem Original treu.

4. Humanoid. Vermutlich von Menschen geschrieben.

Darüber hinaus verfolgten die Forscher auch, wie oft die generierten Geschichten Schreibprobleme in den folgenden Aspekten hatten:

1. Eine schockierende Veränderung in der Erzählung oder im Stil.

2. Inkonsistenz. Es ist sachlich falsch oder enthält sehr seltsame Details.

3. Chaos. Verwirrend oder schwer verständlich.

4. Wiederholbarkeit. Hohe Wiederholgenauigkeit.

5. Nicht glatt. Häufige Grammatikfehler.

Ergebnisse

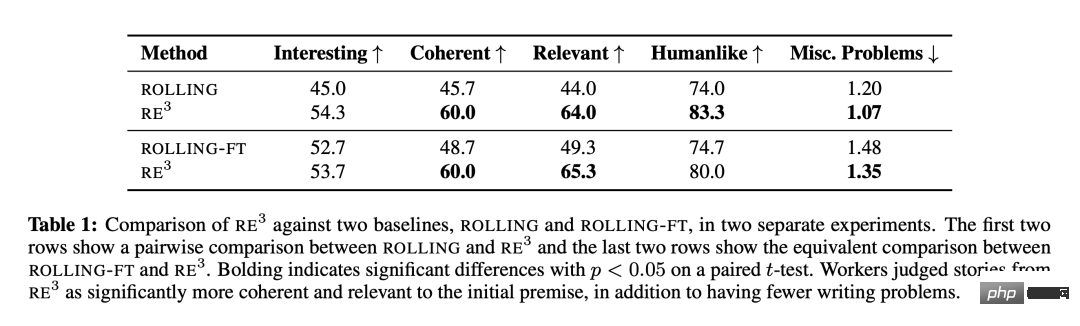

Wie in Tabelle 1 gezeigt, ist Re^3 sehr effektiv, wenn es darum geht, eine längere Geschichte basierend auf der erwarteten Situation zu schreiben und gleichzeitig eine kohärente Gesamthandlung beizubehalten. Überprüfung Es beinhaltet Design Entscheidungen von Forschern, die vom menschlichen Schreibprozess inspiriert sind, sowie rekursive Generierungsmethoden für erneute Eingabeaufforderungen. Im Vergleich zu ROLLING und ROLLING-FT verbessert Re^3 sowohl Kohärenz als auch Relevanz erheblich. Der Kommentator bezeichnete die Geschichte von Re^3 auch als „deutlich weniger redundante Schreibprobleme“.

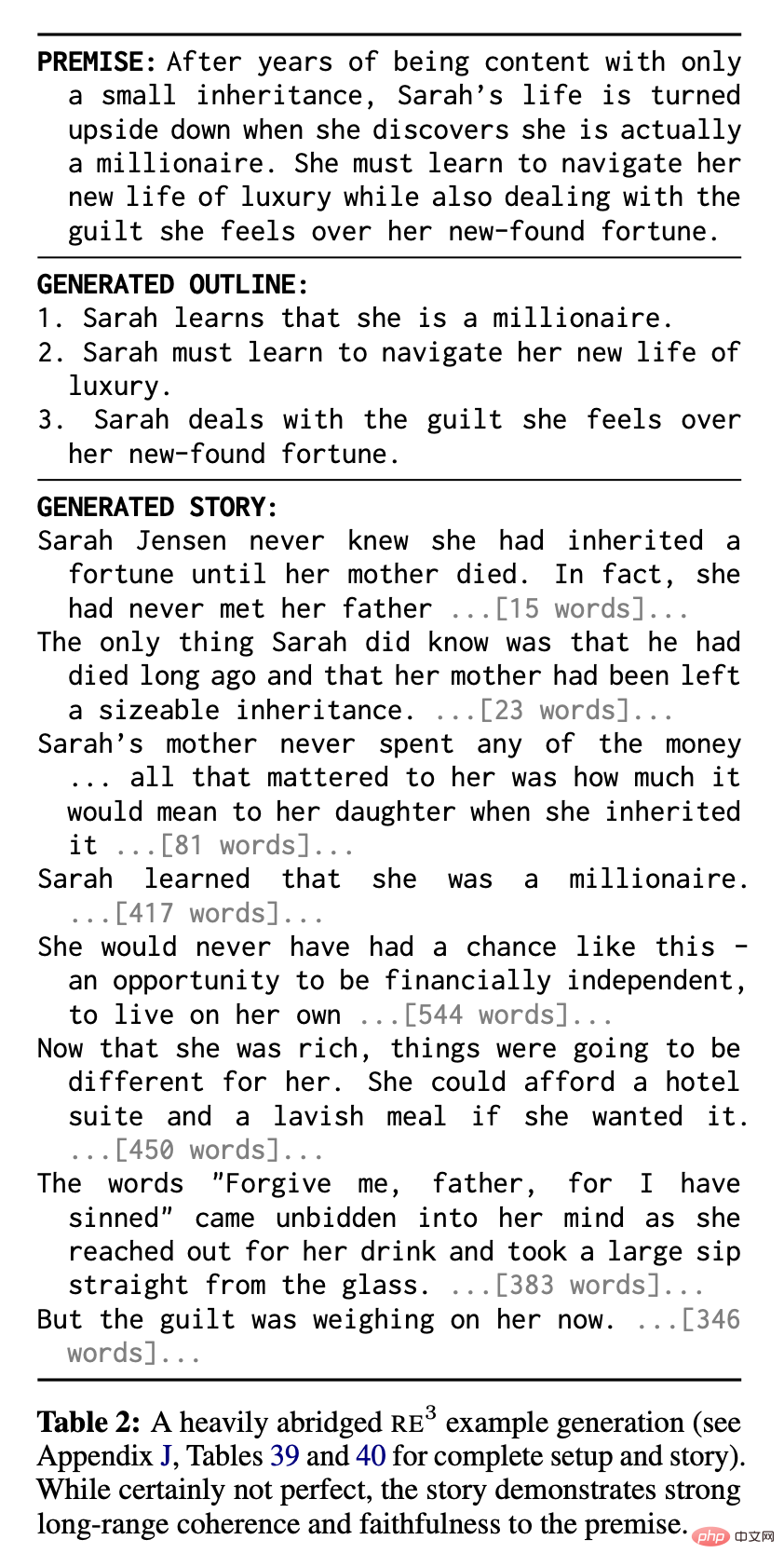

Re^3 zeigt im absoluten Sinne eine starke Leistung: Kommentatoren glauben, dass in den beiden Vergleichen 83,3 % bzw. 80,0 % der Re^3-Geschichten von Menschen geschrieben wurden. Tabelle 2 zeigt ein Beispiel einer stark gekürzten Geschichte aus Re^3, in der starke Kohärenz und Kontextrelevanz erkennbar sind: Verbesserung durch Re^3.

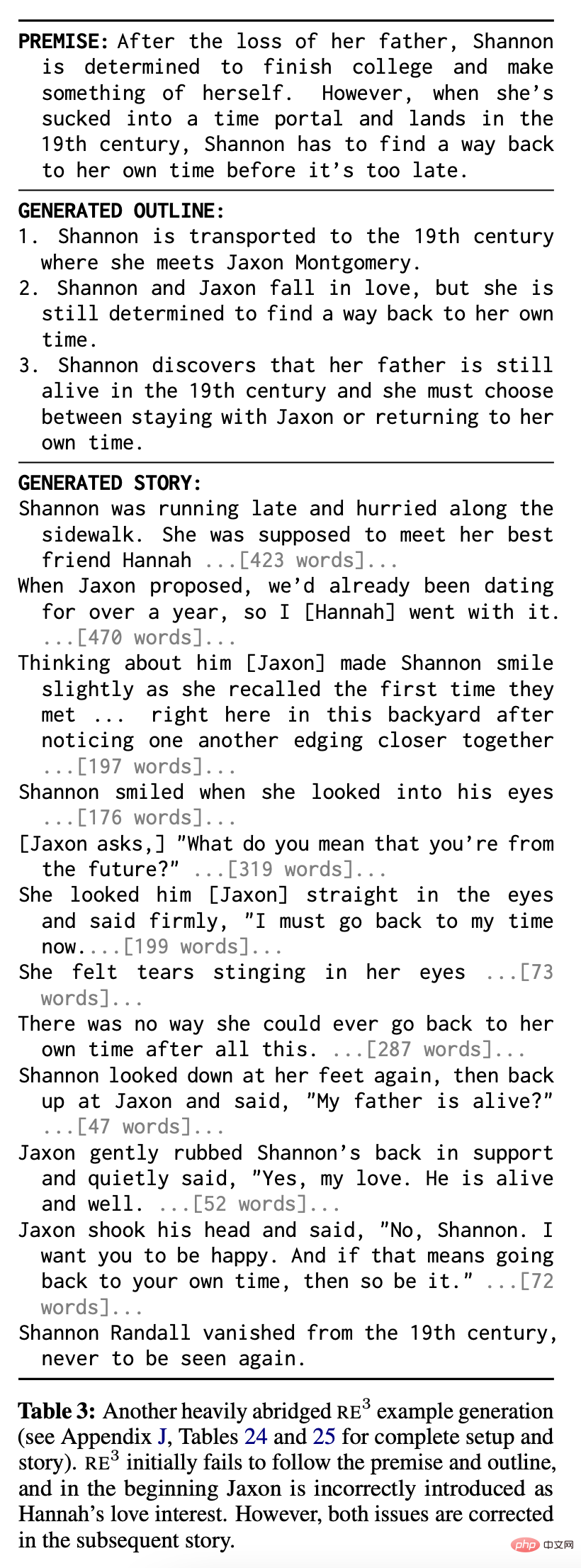

Zwei häufige Probleme sind in Tabelle 3 aufgeführt. Erstens: Obwohl Re^3s im Gegensatz zu Basisgeschichten fast immer bis zu einem gewissen Grad der Prämisse der Geschichte folgen, erfassen sie möglicherweise nicht alle Teile der Prämisse und folgen möglicherweise nicht der vom Planungsmodul generierten Teilgliederung (z. B. Tabelle 3 Der erste Teil von die Geschichte und die Gliederung). Zweitens gibt es aufgrund des Ausfalls des Rewriting-Moduls, insbesondere des Editing-Moduls, immer noch einige verwirrende Passagen oder widersprüchliche Aussagen: Beispielsweise hat die Figur Jaxon in Tabelle 3 an einigen Stellen eine widersprüchliche Identität.

Zwei häufige Probleme sind in Tabelle 3 aufgeführt. Erstens: Obwohl Re^3s im Gegensatz zu Basisgeschichten fast immer bis zu einem gewissen Grad der Prämisse der Geschichte folgen, erfassen sie möglicherweise nicht alle Teile der Prämisse und folgen möglicherweise nicht der vom Planungsmodul generierten Teilgliederung (z. B. Tabelle 3 Der erste Teil von die Geschichte und die Gliederung). Zweitens gibt es aufgrund des Ausfalls des Rewriting-Moduls, insbesondere des Editing-Moduls, immer noch einige verwirrende Passagen oder widersprüchliche Aussagen: Beispielsweise hat die Figur Jaxon in Tabelle 3 an einigen Stellen eine widersprüchliche Identität.

Im Gegensatz zur Rolling-Window-Methode kann sich die Planungsmethode von Re^3 jedoch „selbst korrigieren“ und zur ursprünglichen Handlung zurückkehren. Die zweite Hälfte der Geschichte in Tabelle 3 veranschaulicht diese Fähigkeit.

Analyse

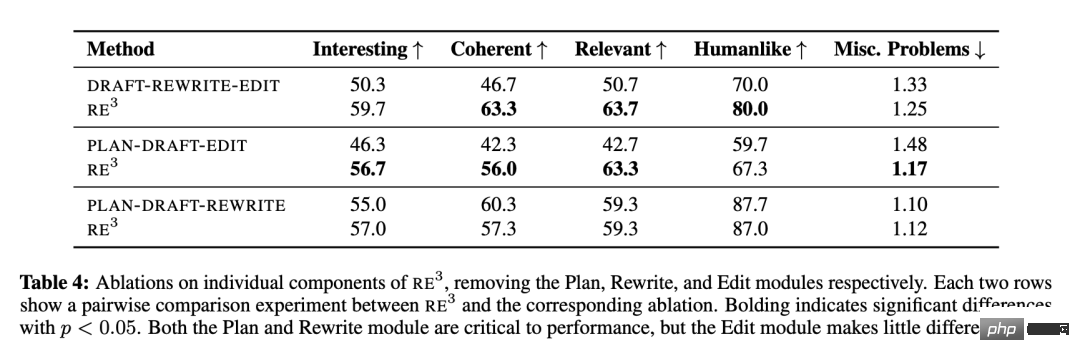

Die Forscher untersuchten den relativen Beitrag jedes Moduls von Re^3: Planung, Entwurf, Umschreiben und Bearbeitung, und führten nacheinander Ablationsexperimente für jedes Modul durch. Die Ausnahme bildet das Draft-Modul, da unklar ist, wie das System ohne dieses funktionieren würde.

Tabelle 4 zeigt, dass die Module „Planung“ und „Umschreiben“, die den menschlichen Planungs- und Umschreibungsprozess nachahmen, für die Gesamtkohärenz der Handlung und die Relevanz der Prämisse von entscheidender Bedeutung sind. Allerdings trägt das Modul „Bearbeiten“ nur sehr wenig zu diesen Kennzahlen bei. Die Forscher stellten auch qualitativ fest, dass es in der letzten Geschichte von Re^3 immer noch viele Kohärenzprobleme gibt, die nicht vom Bearbeitungsmodul behoben werden, dass diese Probleme jedoch von einem sorgfältigen menschlichen Redakteur gelöst werden könnten.

Weitere Analyse des Moduls „Bearbeiten“

Weitere Analyse des Moduls „Bearbeiten“

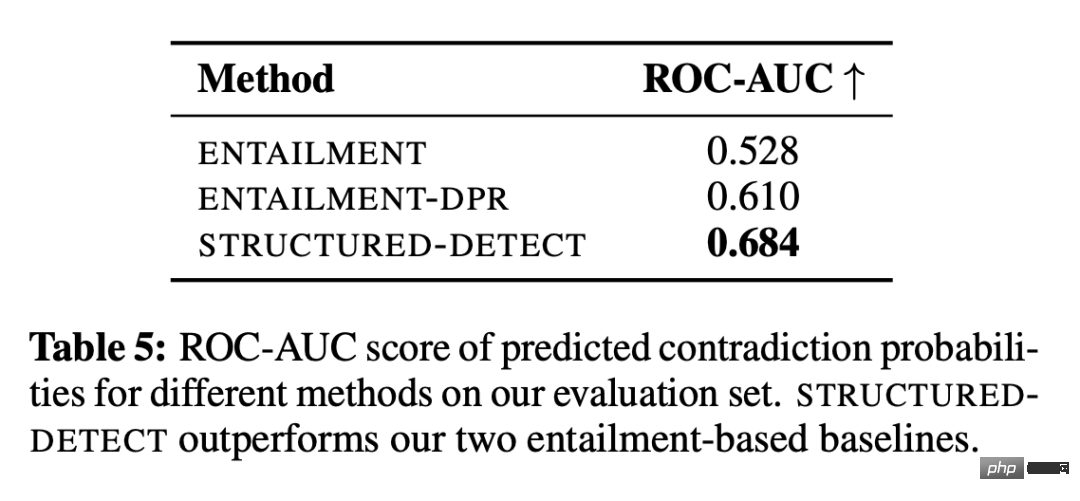

Die Forscher untersuchten in einer kontrollierten Umgebung, ob das Modul „Bearbeiten“ zumindest rollenbasierte Sachinkonsistenzen erkennen konnte. Das Erkennungssubsystem heißt STRUCTURED-DETECT, um Verwechslungen mit dem gesamten Bearbeitungsmodul zu vermeiden.

Wie in Tabelle 5 gezeigt, übertrifft STRUCTUREDDETECT beide Baselines bei der Erkennung rollenbasierter Inkonsistenzen gemäß der Standard-ROC-AUC-Klassifizierungsmetrik. Der ROC-AUC-Score des ENTAILMENT-Systems ist kaum besser als die Zufallsleistung (0,5), was die zentrale Herausforderung verdeutlicht, dass Erkennungssysteme äußerst genau sein müssen. Darüber hinaus ist STRUCTURED-DETECT so konzipiert, dass es auf längere Absätze skaliert werden kann. Die Forscher stellten die Hypothese auf, dass sich die Leistungslücke bei Auswertungen mit längeren Eingaben im Vergleich zum Ausgangswert vergrößern würde.

Selbst in dieser vereinfachten Umgebung ist die absolute Leistung aller Systeme immer noch gering. Darüber hinaus enthalten viele der generierten vollständigen Geschichten Inkonsistenzen, die nicht mit den Charakteren zusammenhängen, beispielsweise Hintergrundinkonsistenzen mit der aktuellen Szene. Obwohl die Forscher die Fähigkeit der GPT-3-Bearbeitungs-API, Inkonsistenzen nach deren Erkennung zu korrigieren, nicht offiziell analysierten, stellten sie auch fest, dass sie isolierte Details korrigieren kann, bei größeren Änderungen jedoch Probleme bereitet.

Zusammenfassend lässt sich sagen, dass zusammengesetzte Fehler aus den Erkennungs- und Korrektur-Subsystemen es für das aktuelle Bearbeitungsmodul dieser Studie schwierig machen, die sachliche Konsistenz über Tausende von Wörtern hinweg effektiv zu verbessern, ohne gleichzeitig unnötige Änderungen einzuführen.

Das obige ist der detaillierte Inhalt vonAIGC, das sich an den menschlichen kreativen Prozess anpasst: Es entsteht ein Modell zur automatischen Generierung von Wachstumsgeschichten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr