Heim >Technologie-Peripheriegeräte >KI >Li Feifei vertritt diese Ansichten im AIGC|Stanford HAI Viewpoint Report

Li Feifei vertritt diese Ansichten im AIGC|Stanford HAI Viewpoint Report

- 王林nach vorne

- 2023-04-11 21:52:021357Durchsuche

Kürzlich hat das Stanford HAI Institute unter der Leitung von Li Feifei einen Perspektivbericht zum Thema „Generative AI“ veröffentlicht.

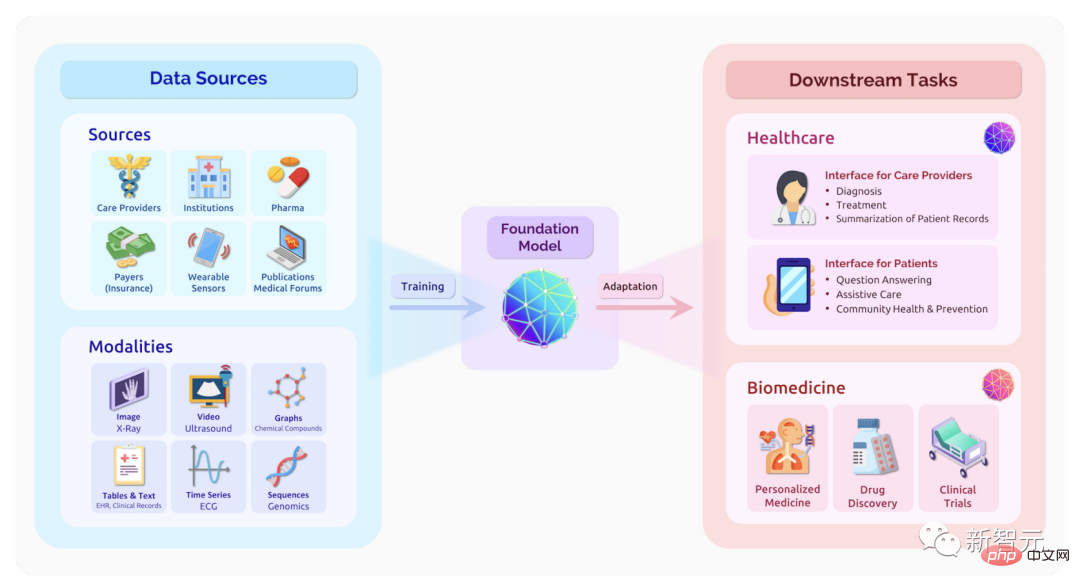

Der Bericht weist darauf hin, dass die meisten aktuellen generativen künstlichen Intelligenzen auf Basismodellen basieren.

Die Chancen, die diese Modelle für unser Leben, unsere Gemeinschaften und die Gesellschaft mit sich bringen, sind enorm, aber auch die Risiken.

Einerseits kann generative KI den Menschen produktiver und kreativer machen. Andererseits können sie soziale Vorurteile verstärken und sogar unser Vertrauen in Informationen untergraben.

Wir glauben, dass die Zusammenarbeit zwischen den Disziplinen unerlässlich ist, um sicherzustellen, dass diese Technologien uns allen zugute kommen. Hier erfahren Sie, was Führungskräfte aus den Bereichen Medizin, Naturwissenschaften, Ingenieurwesen, Geistes- und Sozialwissenschaften darüber zu sagen haben, wie sich „generative künstliche Intelligenz“ auf ihre Bereiche und unsere Welt auswirken wird.

In diesem Artikel haben wir die Erkenntnisse von Li Feifei und Percy Liang zur aktuellen generativen KI ausgewählt.

Den vollständigen Meinungsbericht finden Sie unter:

https://hai.stanford.edu/generative-ai-perspectives-stanford-hai

Li Feifei: The großer Wendepunkt der künstlichen Intelligenz

Li Feifei, Co-Direktor von Stanford HAI, schrieb: „Der große Wendepunkt der künstlichen Intelligenz.“

Das menschliche Gehirn kann alle Muster auf der Welt erkennen und darauf basierend Modelle bauen oder Konzepte generieren. Generationen von Wissenschaftlern der künstlichen Intelligenz träumen davon, Maschinen diese generative Fähigkeit zu verleihen, und sie arbeiten seit langem hart auf dem Gebiet der Entwicklung generativer Modellalgorithmen.

Im Jahr 1966 starteten Forscher am MIT das „Summer Vision Project“ (Summer Vision Project) mit dem Ziel, mithilfe von Technologie einen wichtigen Teil des visuellen Systems effektiv aufzubauen. Dies war der Beginn der Forschung im Bereich Computer Vision und Bilderzeugung.

Dank der engen Verbindung zwischen Deep Learning und Big Data scheinen die Menschen in letzter Zeit einen wichtigen Wendepunkt erreicht zu haben, der Maschinen die Fähigkeit geben wird, Sprache, Bilder, Audio usw. zu generieren.

Obwohl die Inspiration von Computer Vision darin besteht, eine KI zu bauen, die sehen kann, was Menschen sehen können, geht das Ziel dieser Disziplin weit darüber hinaus. Die KI, die in Zukunft gebaut werden soll, sollte sehen, was Menschen nicht sehen können sehen. zu etwas.

Wie nutzt man generative künstliche Intelligenz, um das menschliche Sehvermögen zu verbessern?

Zum Beispiel sind Todesfälle durch medizinische Fehler in den Vereinigten Staaten ein besorgniserregendes Problem. Generative KI kann Gesundheitsdienstleistern dabei helfen, potenzielle Probleme zu erkennen.

Wenn in seltenen Situationen Fehler auftreten, kann generative KI simulierte Versionen ähnlicher Daten erstellen, um KI-Modelle weiter zu trainieren oder medizinisches Personal zu schulen.

Bevor Sie mit der Entwicklung eines neuen generativen Tools beginnen, sollten Sie sich darauf konzentrieren, was die Leute mit dem Tool erreichen möchten.

In einem aktuellen Projekt zum Benchmarking von Roboteraufgaben führte das Forschungsteam vor Beginn der Arbeit eine groß angelegte Benutzerstudie durch und fragte die Menschen, wie sehr sie davon profitieren würden, wenn bestimmte Aufgaben von Robotern ausgeführt würden. Die Aufgaben, die am meisten profitieren Der Mensch steht im Mittelpunkt des Projekts.

Um die großen Chancen generativer künstlicher Intelligenz nutzen zu können, müssen auch die damit verbundenen Risiken sinnvoll eingeschätzt werden.

Joy Buolamwini leitete eine Studie mit dem Titel „Gender Shading“ und stellte fest, dass KI oft Probleme hat, Frauen und farbige Menschen zu identifizieren. Ähnliche Vorurteile gegenüber unterrepräsentierten Gruppen werden auch in der generativen KI weiterhin auftauchen.

Es ist auch eine sehr wichtige Fähigkeit zu beurteilen, ob ein Bild mithilfe von KI erstellt wurde. Die menschliche Gesellschaft basiert auf dem Vertrauen in die Staatsbürgerschaft, und ohne diese Fähigkeit wird unser Vertrauensgefühl gemindert.

Fortschritte bei maschinengenerierten Fähigkeiten sind äußerst aufregend, ebenso wie das Potenzial der KI, Dinge zu sehen, die Menschen nicht sehen können.

Wir müssen uns jedoch der Tatsache bewusst sein, dass diese Fähigkeiten unser tägliches Leben und unsere Umwelt stören und unsere Rolle als Weltbürger untergraben können.

Percy Liang: „The New Cambrian Era: The Excitement and Anxiety of Science“

Percy Liang, Direktor des Institute for Human-Centered Artificial Intelligence an der Stanford University und außerordentlicher Professor für Informatik, hat einen Artikel veröffentlicht „The New Cambrian Era: The Excitement and Anxiety of Science“ Anxiety“

In der Menschheitsgeschichte war es schon immer schwierig, Neues zu erschaffen, und diese Fähigkeit besitzen fast nur Experten.

Aber mit den jüngsten Fortschritten bei Basismodellen findet die „kambrische Explosion“ der künstlichen Intelligenz statt, und künstliche Intelligenz wird in der Lage sein, alles zu erschaffen, von Videos über Proteine bis hin zu Codes.

Diese Fähigkeit senkt die Schwelle zur Schöpfung, nimmt uns aber auch die Fähigkeit, die Realität zu erkennen.

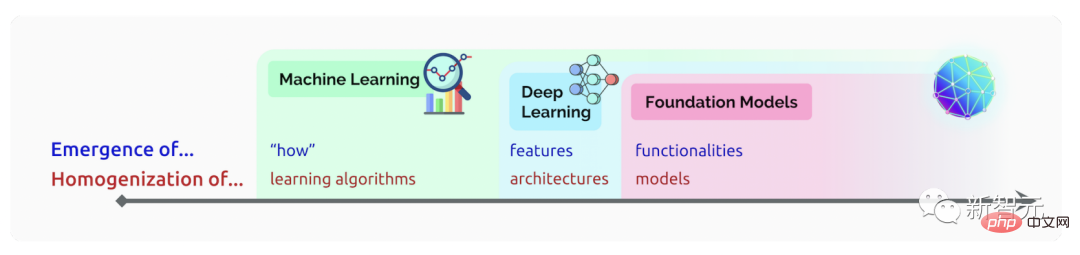

Grundlegende Modelle, die auf tiefen neuronalen Netzen und selbstüberwachtem Lernen basieren, gibt es schon seit Jahrzehnten. In jüngster Zeit hat jedoch die schiere Datenmenge, auf der diese Modelle trainiert werden können, zu raschen Fortschritten bei den Modellfähigkeiten geführt.

Ein im Jahr 2021 veröffentlichtes Papier beschreibt die Chancen und Risiken des zugrunde liegenden Modells. Diese neuen Fähigkeiten werden zu einer „Quelle der Aufregung für die wissenschaftliche Gemeinschaft“ und können auch zu „unbeabsichtigten Konsequenzen“ führen.

Auch die Frage der Homogenität wird in dem Beitrag thematisiert. Dieselben wenigen Modelle werden als Grundlage für viele Anwendungen wiederverwendet, sodass sich Forscher auf einen kleinen Satz von Modellen konzentrieren können. Die Zentralisierung macht diese Modelle jedoch auch zu einem Single Point of Failure, mit potenziellen Schäden für viele nachgelagerte Anwendungen.

Es ist auch sehr wichtig, das Basismodell zu vergleichen, damit Forscher seine Fähigkeiten und Mängel besser verstehen und vernünftigere Entwicklungsstrategien formulieren können. Zu diesem Zweck wurde

HELM (Holistic Evaluation of Language Models) entwickelt. HELM bewertet die Leistung von mehr als 30 bekannten Sprachmodellen in einer Reihe von Szenarien anhand verschiedener Indikatoren wie Genauigkeit, Robustheit und Fairness.

Es werden weiterhin neue Modelle, neue Anwendungsszenarien und neue Bewertungsindikatoren erscheinen. Wir begrüßen jeden, der zur Entwicklung von HELM beiträgt.

Das obige ist der detaillierte Inhalt vonLi Feifei vertritt diese Ansichten im AIGC|Stanford HAI Viewpoint Report. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr