Heim >Technologie-Peripheriegeräte >KI >Die umfassendste Transformers-Sammlung der Geschichte! LeCun empfiehlt: Erstellen Sie einen Katalog für 60 Modelle. Welches Papier haben Sie verpasst?

Die umfassendste Transformers-Sammlung der Geschichte! LeCun empfiehlt: Erstellen Sie einen Katalog für 60 Modelle. Welches Papier haben Sie verpasst?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 21:22:011077Durchsuche

Wenn es etwas gibt, das in den letzten Jahren die Entwicklung von Großmodellen unterstützt hat, dann muss es Transformer sein!

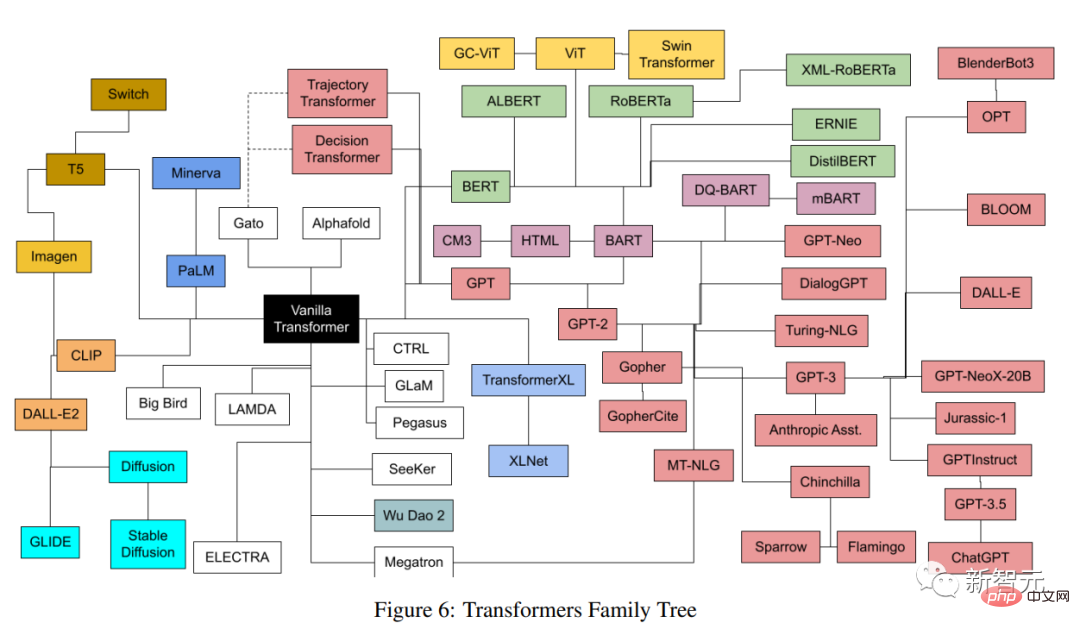

Basierend auf Transformer entstehen zahlreiche Modelle in verschiedenen Bereichen. Jedes Modell hat eine andere Architektur, andere Details und einen Namen, der nicht leicht zu erklären ist.

Kürzlich hat ein Autor eine umfassende Klassifizierung und Indizierung aller in den letzten Jahren veröffentlichten beliebten Transformer-Modelle durchgeführt und einen möglichst umfassenden, aber einfachen Katalog bereitgestellt Transformatorinnovation und ein Rückblick auf ihre Entwicklungsgeschichte.

Link zum Papier: https://arxiv.org/pdf/2302.07730.pdf

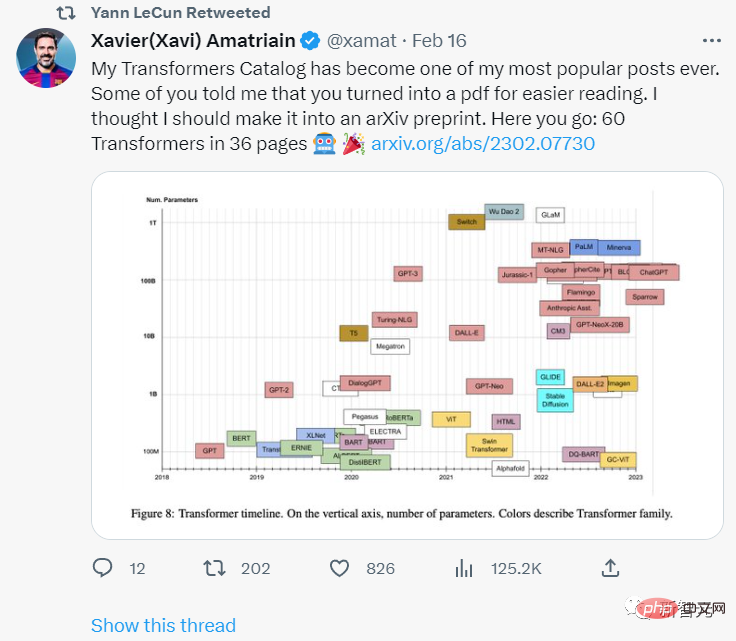

Turing-Award-Gewinner Yann LeCun drückte seine Zustimmung aus.

Der Autor des Artikels, Xavier (Xavi) Amatriain, schloss 2005 sein Doktorat an der Universität Pompeu Fabra in Spanien ab. Derzeit ist er Vizepräsident für Technik bei LinkedIn und hauptsächlich verantwortlich für künstliche Produkte Geheimdienststrategie.

Was ist Transformer?

Transformer ist eine Art Deep-Learning-Modell mit einigen einzigartigen Architekturmerkmalen. Es erschien erstmals im berühmten Artikel „Attention is All you Need“, der 2017 von Google-Forschern veröffentlicht wurde. In diesem Artikel wurden in nur 5 Jahren viele Forschungsergebnisse gesammelt . Erstaunliche 38.000 Zitate.

Die Transformatorarchitektur gehört ebenfalls zum Encoder-Decoder-Modell (Encoder-Decoder), aber in früheren Modellen war Aufmerksamkeit nur einer der Mechanismen, von denen die meisten auf LSTM (Long Short-Term Memory) und anderen RNN basierten Variante (Recurrent Neural Network).

Eine der wichtigsten Erkenntnisse des Artikels, der Transformer vorschlägt, ist, dass, wie der Titel schon sagt, der Aufmerksamkeitsmechanismus als einziger Mechanismus verwendet werden kann, um Abhängigkeiten zwischen Eingaben und Ausgaben abzuleiten. Dieser Artikel beabsichtigt nicht, sich auf alles einzulassen Die Details der Transformer-Architektur können interessierte Freunde im Blog „The Illustrated Transformer“ durchsuchen.

Blog-Link: https://jalammar.github.io/illustrated-transformer/

Im Folgenden werden nur einige der wichtigsten Komponenten kurz beschrieben.

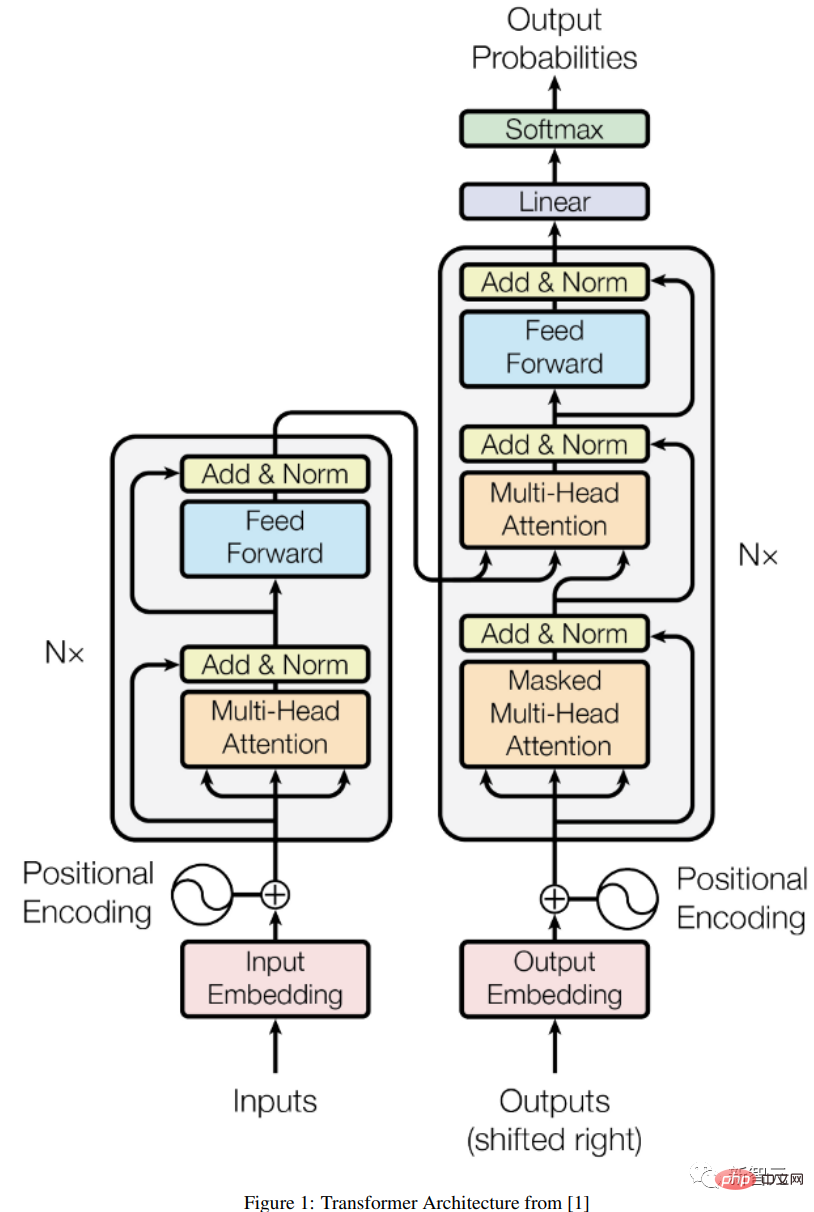

Encoder-Decoder-Architektur

Eine allgemeine Encoder-/Decoder-Architektur besteht aus zwei Modellen: Der Encoder nimmt die Eingabe und codiert sie in einen Vektor fester Länge. Der Decoder empfängt diesen Vektor und dekodiert es in eine Ausgabesequenz.

Encoder und Decoder werden gemeinsam trainiert, um die bedingte Log-Likelihood zu minimieren. Nach dem Training kann der Encoder/Decoder eine Ausgabe basierend auf einer bestimmten Eingabesequenz generieren oder ein Paar Eingabe-/Ausgabesequenzen bewerten.

Unter der ursprünglichen Transformer-Architektur verfügen sowohl der Encoder als auch der Decoder über 6 identische Schichten. In jeder dieser 6 Schichten verfügt der Encoder über zwei Unterschichten: eine Multi-Head-Aufmerksamkeitsschicht und ein einfaches Feedforward-Netzwerk, jede Unterschicht verfügt über eine Restverbindung und eine Schichtnormalisierung.

Die Ausgabegröße des Encoders beträgt 512, und der Decoder fügt eine dritte Unterschicht hinzu, die eine weitere Multi-Head-Aufmerksamkeitsschicht auf dem Encoder-Ausgang darstellt. Darüber hinaus wird eine weitere Multi-Head-Schicht im Decoder ausgeblendet, um zu verhindern, dass Informationslecks die Aufmerksamkeit auf nachfolgende Positionen lenken.

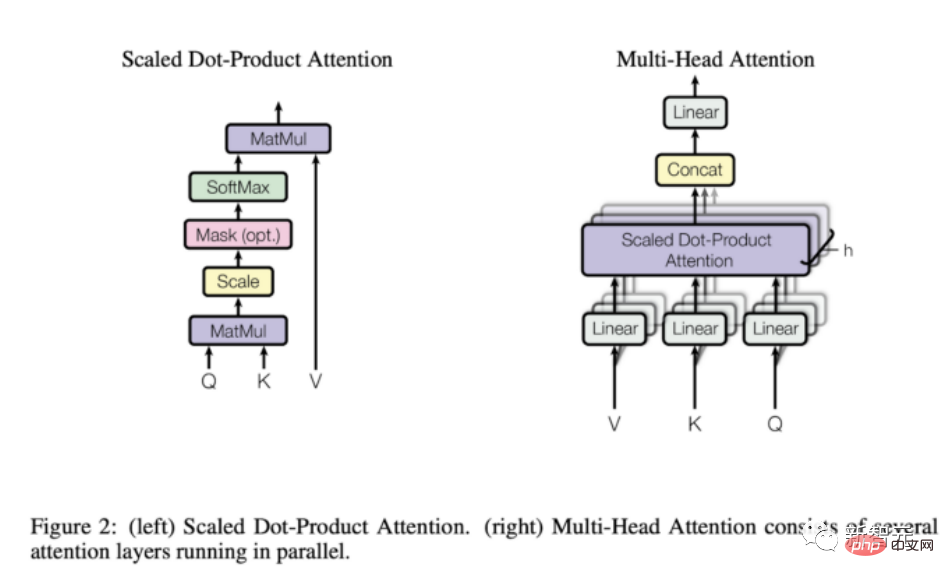

Aufmerksamkeitsmechanismus

Wie aus der obigen Beschreibung ersichtlich ist, ist das einzige „seltsame“ Element in der Modellstruktur die Aufmerksamkeit der Bullen, die die volle Kraft des Bullen ausübt Modellstandort.

Die Aufmerksamkeitsfunktion ist eine Zuordnung zwischen Abfrage und einem Satz von Schlüssel-Wert-Paaren zur Ausgabe. Die Ausgabe wird als gewichtete Summe von Werten berechnet, wobei die jedem Wert zugewiesene Gewichtung durch die Kompatibilitätsfunktion der bestimmt wird Abfrage und der entsprechende Schlüssel berechnet.

Transformer verwendet Multi-Head-Aufmerksamkeit, bei der es sich um die parallele Berechnung einer Reihe von Aufmerksamkeitsfunktionen handelt, die auch als Skalierungspunktprodukt-Aufmerksamkeit bezeichnet werden.

Im Vergleich zu rekurrenten und Faltungsnetzwerken hat die Aufmerksamkeitsschicht mehrere Vorteile. Die wichtigeren sind ihre geringere Rechenkomplexität und höhere Konnektivität, was besonders nützlich ist, um langfristige Abhängigkeiten in Sequenzen zu lernen.

Was kann Transformer? Warum wurde es populär?

Der ursprüngliche Transformer war für die Sprachübersetzung hauptsächlich vom Englischen ins Deutsche konzipiert, aber die experimentellen Ergebnisse der ersten Version des Papiers haben gezeigt, dass die Architektur gut auf andere Sprachaufgaben verallgemeinert werden kann.

Dieser besondere Trend wurde von der Forschungsgemeinschaft schnell bemerkt.

In den nächsten Monaten werden die Rankings aller sprachbezogenen ML-Aufgaben vollständig von einer bestimmten Version der Transformer-Architektur besetzt sein. Beispielsweise wurde die Frage- und Antwort-Aufgabengruppe schnell von verschiedenen Transformer-Modellen eliminiert.

Einer der Hauptgründe, warum Transofrmer so schnell die meisten NLP-Rankings belegen können, ist: Ihre Fähigkeit, sich schnell an andere Aufgaben anzupassen, nämlich vorab trainierte Transformer-Modelle, können sehr einfach und schnell angepasst werden, wenn sie nicht verwendet werden Die trainierten Aufgaben haben gegenüber anderen Modellen enorme Vorteile.

Als ML-Praktiker müssen Sie nicht mehr ein großes Modell von Grund auf auf einem riesigen Datensatz trainieren, sondern können das vorab trainierte Modell einfach für die jeweilige Aufgabe wiederverwenden, vielleicht nur mit viel kleineren Daten. Passen Sie es leicht an.

Die spezifische Technik, mit der vorab trainierte Modelle an verschiedene Aufgaben angepasst werden, ist das sogenannte Feintuning.

Es stellt sich heraus, dass Transformers so anpassungsfähig an andere Aufgaben sind, dass sie, obwohl sie ursprünglich für sprachbezogene Aufgaben entwickelt wurden, schnell für andere Aufgaben nützlich wurden, von visuellen oder Audio- und Musikanwendungen bis hin zum Schachspielen oder Basteln Mathe.

Natürlich wären all diese Anwendungen nicht möglich, wenn es nicht die unzähligen Tools gäbe, die jedem zur Verfügung stehen, der ein paar Zeilen Code schreiben kann.

Transformer lässt sich nicht nur schnell in große Frameworks für künstliche Intelligenz (z. B. Pytorch und TensorFlow) integrieren, sondern es gibt auch einige Unternehmen, die sich ausschließlich Transformer widmen.

Huggingface, ein Startup, das bisher über 60 Millionen US-Dollar eingesammelt hat, basiert fast ausschließlich auf der Idee, seine Open-Source-Transformer-Bibliothek zu kommerzialisieren.

GPT-3 ist ein Transformer-Modell, das im Mai 2020 von OpenAI eingeführt wurde. Es ist eine Nachfolgeversion ihrer früheren GPT und GPT-2. Das Unternehmen sorgte für viel Aufsehen, als es das Modell in einem Vorabdruck vorstellte und behauptete, das Modell sei so leistungsstark, dass sie nicht qualifiziert seien, es der Welt zu präsentieren.

Darüber hinaus hat OpenAI nicht nur GPT-3 nicht veröffentlicht, sondern auch die Kommerzialisierung durch eine sehr große Partnerschaft mit Microsoft erreicht.

Mittlerweile bietet GPT-3 zugrunde liegenden technischen Support für mehr als 300 verschiedene Anwendungen und ist die Grundlage der Geschäftsstrategie von OpenAI. Das ist für ein Unternehmen, das mehr als eine Milliarde US-Dollar an Finanzmitteln erhalten hat, von Bedeutung.

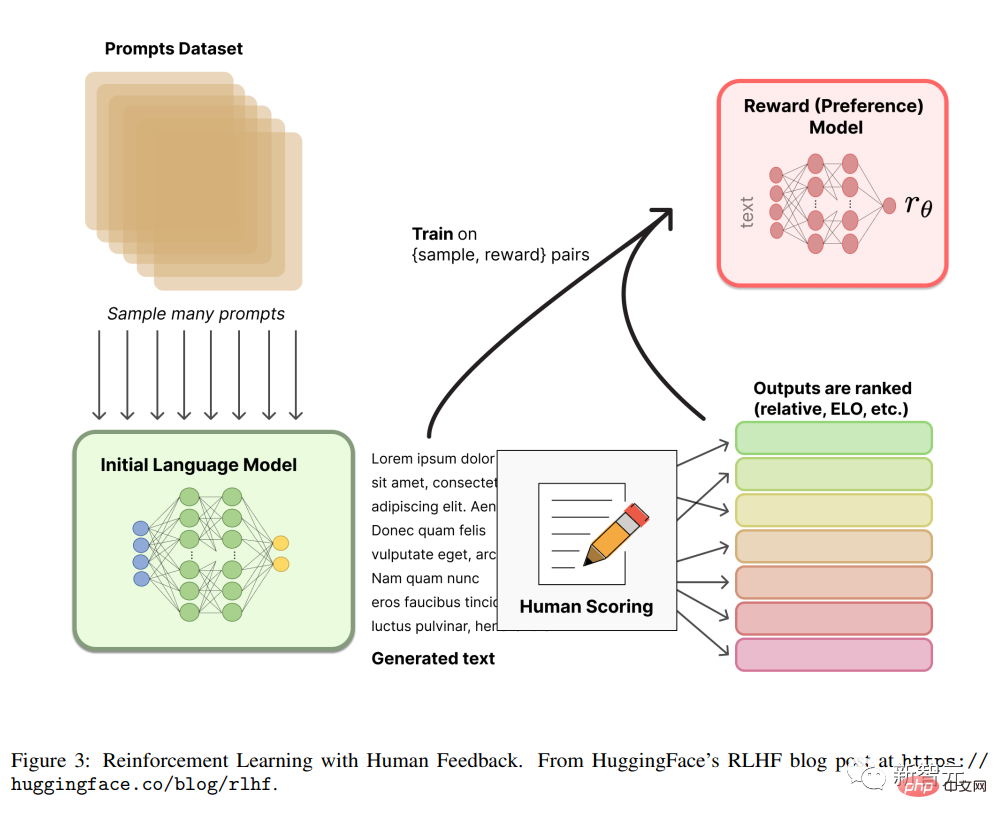

RLHF

Reinforcement Learning aus menschlichem Feedback (oder Präferenzen), auch bekannt als RLHF (oder RLHP), ist in letzter Zeit zu einer großen Ergänzung des Werkzeugkastens der künstlichen Intelligenz geworden.

Dieses Konzept stammt ursprünglich aus dem Artikel „Deep Reinforcement Learning from Human Preferences“ aus dem Jahr 2017, wurde jedoch kürzlich auf ChatGPT und ähnliche Konversationsagenten angewendet und hat damit durchaus Erfolge erzielt gute Ergebnisse und erregte öffentliche Aufmerksamkeit. Die Idee ist sehr einfach: Sobald das Sprachmodell vorab trainiert ist, ist es möglich, unterschiedliche Antworten auf die Konversation zu generieren und die Ergebnisse von Menschen bewerten zu lassen (auch als Präferenzen oder Feedback bezeichnet), um Belohnungen zu trainieren Verstärkungslernmechanismen. Diffusion 🎜#

Das Diffusionsmodell ist zum neuen SOTA für die Bildgenerierung geworden und hat eine starke Tendenz, GANs (Generative Adversarial Networks) zu ersetzen.

Ein so trainiertes Netzwerk lernt tatsächlich aus diesen Bildern das Latente Raum dargestellt. Starten Sie nach dem Lesen der Einleitung die Retrospektivreise von Transformer

!

Das obige ist der detaillierte Inhalt vonDie umfassendste Transformers-Sammlung der Geschichte! LeCun empfiehlt: Erstellen Sie einen Katalog für 60 Modelle. Welches Papier haben Sie verpasst?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr