Heim >Technologie-Peripheriegeräte >KI >Transformer imitiert das Gehirn, übertrifft 42 Modelle bei der Vorhersage der Bildgebung des Gehirns und kann auch die Übertragung zwischen den Sinnen und dem Gehirn simulieren

Transformer imitiert das Gehirn, übertrifft 42 Modelle bei der Vorhersage der Bildgebung des Gehirns und kann auch die Übertragung zwischen den Sinnen und dem Gehirn simulieren

- 王林nach vorne

- 2023-04-11 21:16:211268Durchsuche

Viele KI-Anwendungsmodelle müssen jetzt eine Modellstruktur erwähnen:

Transformer.

Es verzichtet auf traditionelles CNN und RNN und besteht ausschließlich aus Aufmerksamkeitsmechanismen.

Transformer gibt verschiedenen KI-Anwendungsmodellen nicht nur die Möglichkeit, Artikel und Gedichte zu schreiben, sondern glänzt auch in multimodalen Aspekten.

Insbesondere nach der Veröffentlichung von ViT (Vision Transformer) wurde die Modellbarriere zwischen CV und NLP durchbrochen und nur ein Transformer-Modell kann multimodale Aufgaben bewältigen.

(Wer kann nach der Lektüre nicht sagen, wie leistungsfähig es ist?)

Obwohl Transformer ursprünglich für Sprachaufgaben entwickelt wurde, hat es auch großes Potenzial bei der Nachahmung des Gehirns.

Nein, ein wissenschaftlicher Autor hat einen Blog darüber geschrieben, wie Transformer das Gehirn modelliert.

Was hat er gesagt, als ich nach Kangkang kam?

Transformer: Machen Sie, was das Gehirn tut

Zuerst müssen wir seinen Evolutionsprozess klären.

Der Transformer-Mechanismus erschien erstmals vor 5 Jahren. Seine Leistungsfähigkeit ist größtenteils auf seinen Selbstaufmerksamkeitsmechanismus zurückzuführen.

Wie Transformer das Gehirn imitiert, lesen Sie weiter unten.

Im Jahr 2020 nutzte das Forschungsteam des österreichischen Informatikers Sepp Hochreiter Transformer, um das Hopfield Neural Network (ein Memory-Retrieval-Modell, HNN) neu zu organisieren.

Tatsächlich wurde das Hopfield-Neuronale Netzwerk vor 40 Jahren vorgeschlagen, und der Grund, warum sich das Forschungsteam nach Jahrzehnten für eine Neuorganisation dieses Modells entschieden hat, ist folgender:

Erstens folgt dieses Netzwerk einer universellen Regel: Neuronale Netzwerke, die aktiv sind Gleichzeitig werden die Elemente starke Verbindungen untereinander aufbauen.

Zweitens weist der Prozess des Abrufens von Erinnerungen durch das neuronale Hopfield-Netzwerk gewisse Ähnlichkeiten mit der Implementierung des Selbstaufmerksamkeitsmechanismus durch den Transformer auf.

Deshalb hat das Forschungsteam HNN neu organisiert, um bessere Verbindungen zwischen Neuronen herzustellen, sodass mehr Erinnerungen gespeichert und abgerufen werden können.

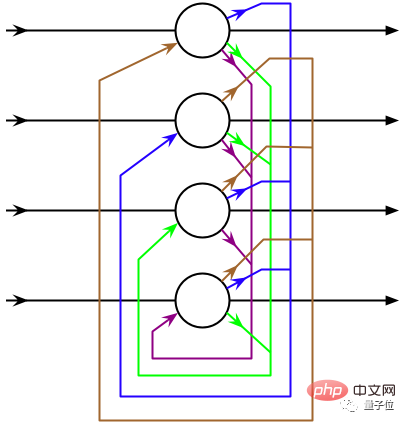

Der Reorganisationsprozess besteht, vereinfacht gesagt, darin, den Aufmerksamkeitsmechanismus des Transformers in HNN zu integrieren, sodass das ursprüngliche diskontinuierliche HNN zu einem kontinuierlichen Zustand wird.

△Quelle: Wikipedia

Das neu organisierte Hopfield-Netzwerk kann als Schicht in die Deep-Learning-Architektur integriert werden, um die Speicherung und den Zugriff auf ursprüngliche Eingabedaten, Zwischenergebnisse usw. zu ermöglichen.

Deshalb sagten sowohl Hopfield selbst als auch Dmitry Krotov vom MIT Watson Artificial Intelligence Laboratory:

Das transformatorbasierte neuronale Hopfield-Netzwerk ist biologisch vernünftig.

Obwohl dies bis zu einem gewissen Grad dem Funktionsprinzip des Gehirns ähnelt, ist es in einigen Aspekten nicht genau genug.

Also passten die Computerneurowissenschaftler Whittington und Behrens die Methode von Hochreiter an und nahmen einige Korrekturen am neu organisierten Hopfield-Netzwerk vor, wodurch die Leistung des Modells bei neurowissenschaftlichen Aufgaben (Replikation neuronaler Feuermuster im Gehirn) weiter verbessert wurde.

△Tim Behrens (links) James Whittington (rechts) Quelle: quantamagazine

Einfach ausgedrückt: Während der Kodierung-Dekodierung kodiert das Modell den Speicher nicht mehr als lineare Sequenz, sondern als Koordinaten auf hoher Ebene Dimensionsraum.

Konkret wird TEM (Tolman-Eichenbaum-Maschine) in das Modell eingeführt.

TEM ist ein assoziatives Gedächtnissystem, das die räumliche Navigationsfunktion des Hippocampus nachahmt.

Es ist in der Lage, räumliches und nichträumliches Strukturwissen zu verallgemeinern, die bei räumlichen und assoziativen Gedächtnisaufgaben beobachtete neuronale Leistung vorherzusagen und Neuzuordnungsphänomene im Hippocampus und im entorhinalen Kortex zu erklären.

Verschmelzung von TEM und Transformer, die so viele Funktionen haben, zum TEM-Transformer (TEM-t).

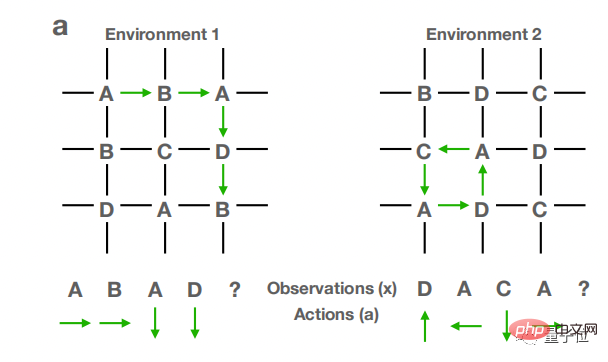

Lassen Sie dann das TEM-t-Modell in mehreren verschiedenen Weltraumumgebungen trainieren. Die Struktur der Umgebung ist in der folgenden Abbildung dargestellt.

In TEM-t verfügt es immer noch über den Selbstaufmerksamkeitsmechanismus von Transformer. Auf diese Weise können die Lernergebnisse des Modells auf neue Umgebungen übertragen und zur Vorhersage neuer räumlicher Strukturen genutzt werden.

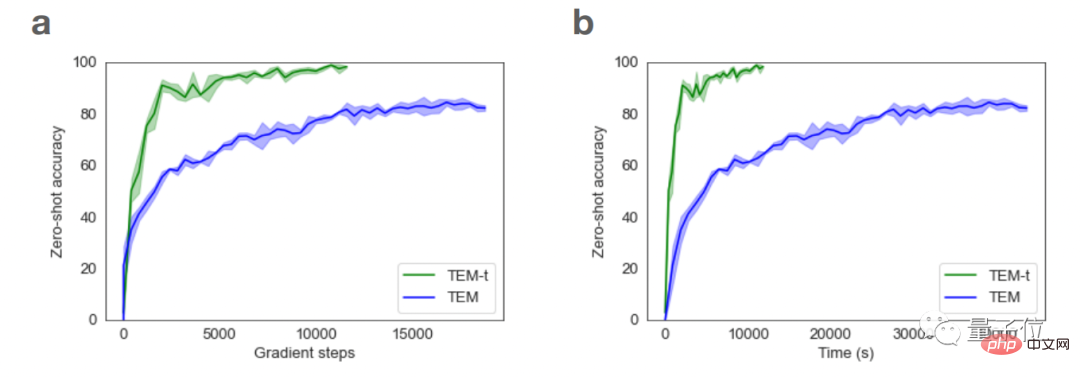

Untersuchungen zeigen außerdem, dass TEM-t im Vergleich zu TEM bei der Durchführung neurowissenschaftlicher Aufgaben effizienter ist und auch mehr Probleme mit weniger Lernproben bewältigen kann.

Transformer beschäftigt sich immer tiefer mit der Nachahmung von Gehirnmustern. Mit anderen Worten: Die Entwicklung von Transformer-Mustern fördert auch ständig unser Verständnis der Funktionsprinzipien von Gehirnfunktionen.

Darüber hinaus kann Transformer in mancher Hinsicht auch unser Verständnis anderer Funktionen des Gehirns verbessern.

Transformer hilft uns, das Gehirn zu verstehen

Zum Beispiel analysierte der Computerneurowissenschaftler Martin Schrimpf letztes Jahr 43 verschiedene Modelle neuronaler Netzwerke, um zu sehen, wie sie sich auf Messungen neuronaler Aktivität beim Menschen auswirken: funktionelle Magnetresonanztomographie (fMRT) und prädiktive Kraft des Elektrogramms im kortikalen Gehirn (EEG)-Berichte.

Unter anderem kann das Transformer-Modell fast alle in der Bildgebung festgestellten Veränderungen vorhersagen.

Rückblickend können wir vielleicht auch die Funktionsweise der entsprechenden Funktionen des Gehirns anhand des Transformer-Modells vorhersagen.

Darüber hinaus haben die Informatiker Yujin Tang und David Ha kürzlich ein Modell entworfen, das bewusst große Datenmengen auf zufällige und ungeordnete Weise durch das Transformer-Modell senden kann und so simuliert, wie der menschliche Körper sensorische Beobachtungen an das Gehirn übermittelt.

Dieser Transformer ist wie das menschliche Gehirn und kann erfolgreich mit einem gestörten Informationsfluss umgehen.

Obwohl das Transformer-Modell ständig verbessert wird, ist es nur ein kleiner Schritt in Richtung eines genauen Gehirnmodells und es sind eingehendere Untersuchungen erforderlich, um den Endpunkt zu erreichen.

Wenn Sie mehr darüber erfahren möchten, wie Transformer das menschliche Gehirn imitiert, können Sie auf den Link unten klicken~

Referenzlink:

[1]https://www.quantamagazine.org/how-ai-transformers- mimic-parts-of-the-brain-20220912/

[2]https://www.pnas.org/doi/10.1073/pnas.2105646118

[3]https://openreview.net/forum? id=B8DVo9B1YE0

Das obige ist der detaillierte Inhalt vonTransformer imitiert das Gehirn, übertrifft 42 Modelle bei der Vorhersage der Bildgebung des Gehirns und kann auch die Übertragung zwischen den Sinnen und dem Gehirn simulieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr