Heim >Technologie-Peripheriegeräte >KI >Beidahetu veröffentlicht Galvatron, ein verteiltes Trainingsartefakt, um eine effiziente und automatische Parallelisierung großer Modelle mit einem Klick zu realisieren

Beidahetu veröffentlicht Galvatron, ein verteiltes Trainingsartefakt, um eine effiziente und automatische Parallelisierung großer Modelle mit einem Klick zu realisieren

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 21:10:011239Durchsuche

In letzter Zeit glänzen „große Modelle“ in verschiedenen Anwendungsszenarien im KI-Bereich. Unter ihnen ist das auf Transformer basierende groß angelegte Pre-Training-Modell eines der typischsten große Modelle und ist zur Kernarchitektur des aktuellen Foundation-Modells geworden. Beispielsweise verwenden die BERT- und GPT-Serien im NLP-Bereich, die ViT- und Swin-Transformer-Serien im CV-Bereich sowie das in letzter Zeit sehr beliebte Multi-Experten-Hybridmodell MoE und das multimodale Modell CLIP usw. alle Transformer als Kerninfrastruktur. Dementsprechend haben solche dichten großen Modelle oft Parameter im Milliarden-, Dutzendmilliarden- oder sogar Billionenbereich. Sie sind mit einem hohen Rechen-, Speicher- und Kommunikationsaufwand verbunden und bringen auch große Herausforderungen für die KI-Infrastruktur mit sich.

Um das Training großer Modelle zu unterstützen, haben Menschen viele Tools entwickelt (z. B. Megatron von NVIDIA, DeepSpeed von Microsoft, FairSeq von Meta). usw. usw.), um verschiedene parallele Methoden zu implementieren, wie z. B. Datenparallelität, Tensormodellparallelität, Pipeline-Parallelität, Sharded-Datenparallelität usw. Diese Systeme bieten eine gute Kapselung der oben genannten parallelen Methoden und schirmen die entsprechenden Implementierungsdetails von außen ab, sodass Benutzer hybride parallele Strategien durch Hinzufügen von Konfigurationen implementieren können.

Auf der Grundlage der oben genannten Ideen wurde viel daran gearbeitet, verschiedene parallele Methoden auf Tensor- oder Operatorebene auszudrücken. Die „Automatisierung“ davon Die Art der Arbeit spiegelt sich hauptsächlich im Transformationsprozess von der parallelen API zur Ausführungsschicht wider. Wenn man sich jedoch nur auf das Entwerfen paralleler APIs oder Zwischenausdrücke beschränkt, löst diese technische Kapselung das Problem des verteilten Trainings nicht grundsätzlich. Das intuitivste Ergebnis ist, dass Benutzer immer noch nicht von den Problemen der verteilten Bereitstellung befreit werden können. Tatsächlich ist die verteilte Bereitstellung großer Modelle ein sehr komplexes Problem. Die meisten aktuellen verteilten Trainingssysteme sind auf die manuellen wiederholten Versuche der Benutzer und die Erfahrung von Systemexperten angewiesen, was zu ernsthaften Problemen mit der geringen Effizienz der Ressourcennutzung führt zwischen ihr und der echten „automatischen Parallelität“ besteht eine beträchtliche Lücke.

Auf dieser Grundlage schlug das Beidahetu-Team ein verteiltes Trainingsartefakt Galvatron vor, um eine effiziente automatische Parallelisierung großer Modelle zu erreichen. Das Forschungspapier wurde für die internationale Spitzenkonferenz VLDB 2023 ausgewählt .

- Papieradresse: https://arxiv.org/abs/2211.13878

- Projektcode-Link: https://github. com/PKU-DAIR/Hetu/tree/main/tools/Galvatron

Was ist die Schwierigkeit bei der automatischen Parallelisierung großer Modelle

# 🎜🎜 #Forscher glauben, dass sich die Schwierigkeit der automatischen Parallelisierung großer Modelle hauptsächlich in den folgenden drei Aspekten widerspiegelt:

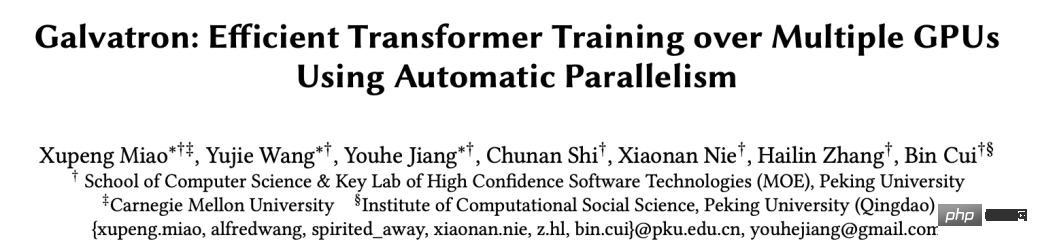

(1) Vielfalt: Erstens, In Bezug auf die Methoden blühen die aktuellen parallelen Methoden großer Modelle auf. Unabhängig von hybriden parallelen Methoden wird es erhebliche Unterschiede bei verschiedenen grundlegenden parallelen Methoden geben, was zu unterschiedlichen Speicheraufwand- und Kommunikationskosten führt Recheneffizienz. Die folgende Abbildung zeigt die vier wichtigsten grundlegenden parallelen Methoden, nämlich Datenparallelität, Tensorparallelität, Pipeline-Parallelität und Sharded-Data-Parallelität. Der Prozess der verteilten Ausführung einfacher Matrixmultiplikationsoperatoren auf der Zhang-GPU.

Parallelmethoden-Vergleichsdiagramm# 🎜🎜#

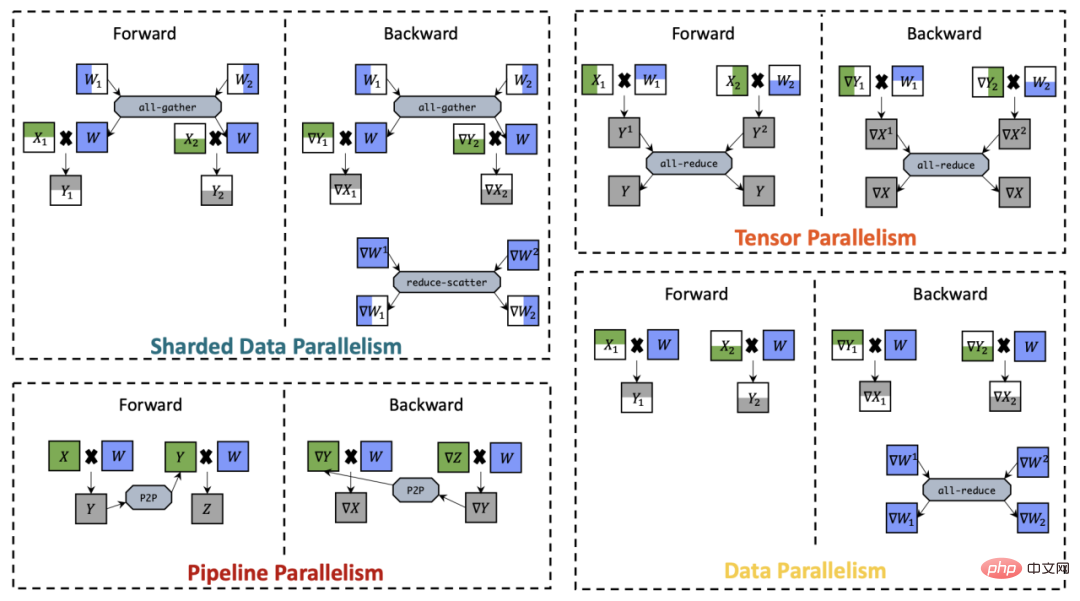

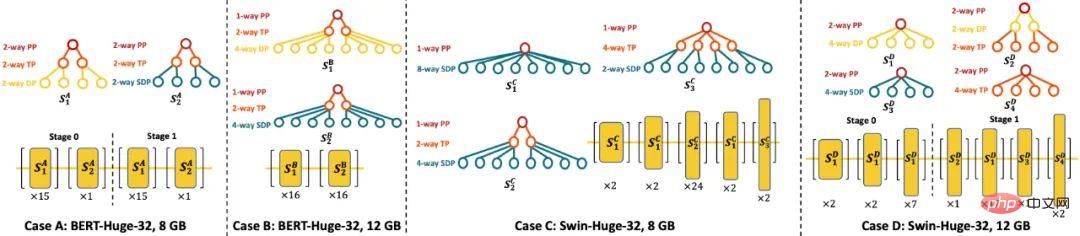

Zweitens sind in Bezug auf Modelle in letzter Zeit unzählige verschiedene Modellarchitekturen entstanden, die häufig mit unterschiedlichen Modellkonfigurationen einhergehen (z. B , unterschiedliche Eingabesequenzlängen, Anzahl der Modellebenen, Breite der verborgenen Modellebene usw.), was zu Unterschieden in der Rechenlast führt. Darüber hinaus sind Benutzer hinsichtlich der Hardware häufig mit sehr differenzierten Clusterumgebungen konfrontiert und können mit unterschiedlichen Speicherkapazitäten, Kommunikationsbandbreiten, Rechenkapazitäten usw. konfrontiert werden. Im Allgemeinen kann aufgrund der oben genannten Vielfalt keine parallele Technologie immer die beste Trainingseffizienz erzielen, und „automatische Parallelität“ ist zur zentralen Herausforderung des verteilten Trainings geworden.(2) Komplexität: Die obige Analyse ist tatsächlich relativ einfach, sogar für denselben Operator können mehrere verschiedene grundlegende parallele Methoden gleichzeitig angewendet werden, wenn wir die hybride Parallelität betrachten, die aus der Kombination dieser grundlegenden Parallelen besteht Methodenmethode, das Problem wird sehr kompliziert. Noch wichtiger ist, dass der Berechnungsgraph eines großen Modells oft eine sehr große Struktur aufweist, was einen größeren Cluster erfordert. Wenn jeder Operator untersucht wird (einschließlich der Auswahl geeigneter Rechenressourcen im Cluster und des Entwurfs entsprechender hybrider paralleler Methoden), wird das Problem auftreten Die Kombinationsraumexplosion führt dazu, dass es schwierig wird, den optimalen verteilten Ausführungsplan für das gesamte Modell zu finden. (3) Praktikabilität: Darüber hinaus ist auch die Praktikabilität ein sehr wichtiges Thema. Einerseits muss bei der automatischen parallelen Suche für verschiedene verteilte Ausführungslösungen ein relativ genauer Speicher-, Kommunikations- und Rechenaufwand bereitgestellt werden. Andernfalls weichen die Ergebnisse zu stark von der tatsächlichen Ausführung ab, was zu suboptimalen Lösungen führt überhaupt nicht in der Lage zu sein, dies zu tun. Aus diesem Grund ist ein sehr genaues Kostenmodell erforderlich, um verschiedene Modellstrukturen und Hardwarebedingungen abzubilden. Andererseits muss der zusätzliche Zeitaufwand durch die automatische Parallelität des Systems in einem akzeptablen Rahmen liegen und auch zu hohe Suchkosten sind nicht akzeptabel. Systemfunktionen: Suche: Eine Art von Arbeit befasst sich hauptsächlich mit dem Suchraum, der sowohl Datenparallelität als auch Modellparallelität berücksichtigt. Die andere Art von Arbeit wird aus Pipeline-Parallelitätsszenarien generiert und mit Datenparallelität kombiniert. SPRENKELN. Auf dieser Basis gibt es auch einige abgeleitete Werke wie Unity und Alpa, die den Umfang der automatischen parallelen Erkundung weiter erweitern. Das vom Beidahetu-Team vorgeschlagene System „Galvatron“ gehört ebenfalls zum Forschungsgebiet der automatischen Parallelsuche, hat aber im Vergleich zu bestehenden Arbeiten vor allem die folgenden drei Vorteile: (1) In Bezug auf Diversität ist die Parallele Die Dimensionen, die vorhandene Arbeiten unterstützen können, sind noch relativ begrenzt, und Galvatron kann nicht nur parallelere Dimensionen unterstützen, sondern auch die differenziertere Transformer-Modellstruktur genau modellieren und seine adaptiven Abstimmungsfähigkeiten unter verschiedenen Cluster-Hardwarebedingungen verifizieren.

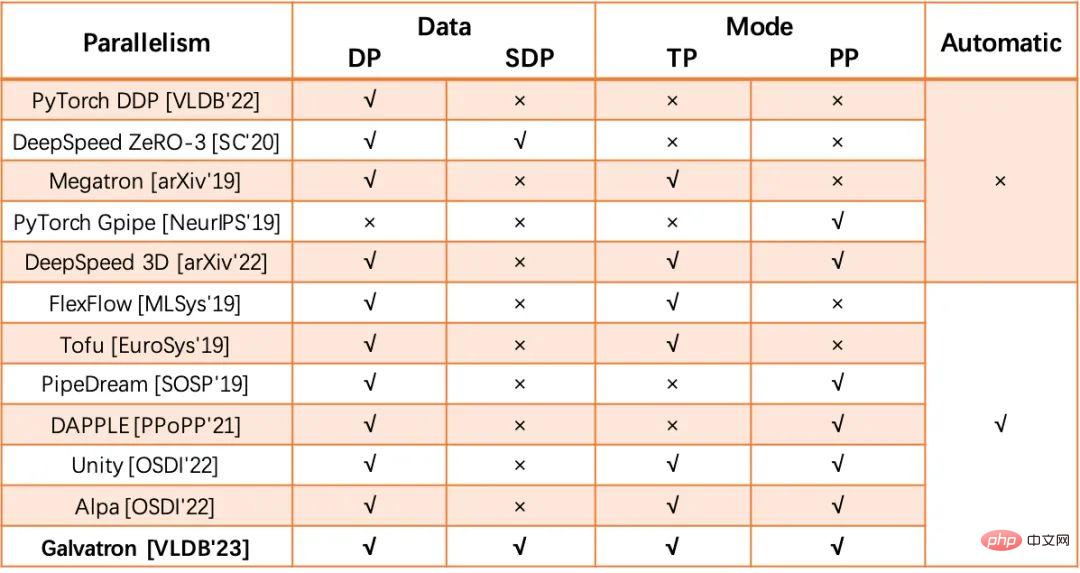

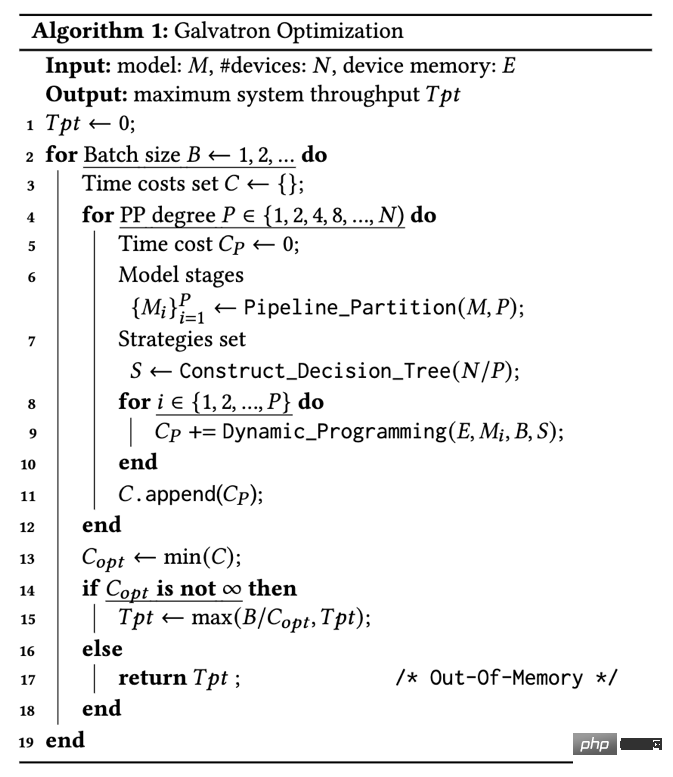

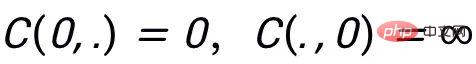

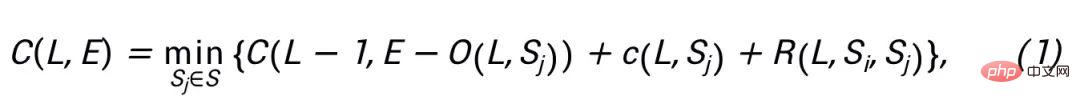

Vergleichsdiagramm eines verteilten Trainingssystems mit großem Modell (2) Aufgrund seiner Vorteile in der Vielfalt steht Galvatron ein beispiellos großer Suchraum gegenüber Die Forscher untersuchten mehrere wichtige Beobachtungen, die im aktuellen groß angelegten verteilten Trainingsprozess experimentell oder theoretisch verifiziert wurden, als Bereinigungskriterien für den Suchraum und erreichten so eine effiziente Optimierung des verteilten Ausführungsplans. (3) Im Hinblick auf die Praktikabilität kombiniert diese Forschung die Vorteile theoretischer Modellierung und experimenteller Messungen, um genaue Schätzungen des Speicher-, Kommunikations- und Rechenaufwands zu erhalten, und berücksichtigt sogar den GPU-Overhead, der durch die Überschneidung der Rechenleistung verursacht wird und Kommunikation Das Problem der verringerten Ausführungseffizienz wird beseitigt, um sicherzustellen, dass ausreichend genaue Ergebnisse der automatischen parallelen Optimierung erzielt werden können. Darüber hinaus wählt die unterste Ebene von Galvatron PyTorch als Ausführungs-Engine, das mit gängigen Mainstream-Transformer-Modellimplementierungen wie Huggingface kompatibel ist, sodass es gleichzeitig keine zusätzliche Belastung für PyTorch-Benutzer darstellt Sie müssen nicht für zusätzliche Systeminstallationen oder Debugging bezahlen. Bei der Verwendung müssen Sie nur wenige Codezeilen hinzufügen und können den gesamten Prozess der automatischen Parallelisierung problemlos abschließen. Galvatron-Workflow und Benutzeroberflächenanzeige Schlüsseltechnologien Galvatron wurde entwickelt, um effizient und automatisch in einem komplexen und großen parallelen Richtlinienraum zu suchen und den optimalen parallelen Ausführungsplan für ein bestimmtes Transformer-Modell und eine verteilte Umgebung zu generieren. In Bezug auf den Suchraum ist Galvatron das erste automatische Paralleltrainingssystem der Branche, das vier gängige Parallelmethoden berücksichtigt, darunter Datenparallelität (DP), Sharded Data Parallelism (SDP) und Tensorparallelität (Tensorparallelität (TP). und Pipeline-Parallelität (PP). Da die hybride Parallelstrategie eine beliebige Kombination der oben genannten vier parallelen Algorithmen umfasst, ist der durch diese Kombination bereitgestellte Suchraum in einem Szenario mit mehreren GPUs sehr groß. Beispielsweise besteht in einem Szenario mit zwei Maschinen und vier Karten eine mögliche Strategie darin, 2-Wege-TP innerhalb der Maschine und 2-Wege-PP zwischen Maschinen zu verwenden. Eine andere mögliche Strategie ist die Verwendung von 2-Wege-PP innerhalb der Maschine und zwischen Maschinen . Verwenden Sie 2-Wege-DP. Wenn die Anzahl der GPUs in einem Knoten auf 8 Karten erweitert wird, gibt es Hunderte von Kandidatenstrategien für jede Schicht des Modells. Mit zunehmender Anzahl der Modellebenen nimmt die Größe des Suchraums exponentiell zu, was eine effektive Erkundung erschwert. Um einen so großen Suchraum effizient zu durchsuchen, schlägt die Studie zunächst die folgenden Beobachtungen als Leitfaden vor: Basierend auf den oben genannten wichtigen Beobachtungen schlägt diese Studie eine Suchraumkonstruktionsmethode basierend auf Entscheidungsbäumen vor: (1) Galvatron verwendet zunächst ein Transformer-Modell, das auf Takeway#1 und Takeway#2 basiert PP unterteilt das Modell in mehrere Stufen und unterteilt die Ausrüstung gleichmäßig und kontinuierlich in mehrere Ausrüstungsgruppen. Im 8-Karten-Szenario ist das Modell beispielsweise in 1/2/4/8-Wege-PP unterteilt, und die entsprechenden Gerätegruppengrößen sind jeweils 8/4/2/1. (2) Jede PP-Segmentierung entspricht einem Entscheidungsbaum und einem Untersuchraum. Die Gesamtzahl der Entscheidungsblattknoten entspricht der Größe der Gerätegruppe und die Höhe des Entscheidungsbaums entspricht der Anzahl der verfügbaren Parallelen Methoden, das heißt, jede Ebene des Entscheidungsbaums Eine parallele Strategie kann angewendet werden. (3) Parallele Strategien können nicht zwischen verschiedenen Ebenen des Entscheidungsbaums wiederverwendet werden. (4) Der Grad der Nicht-Blattknoten wird standardmäßig aus der Exponentialpotenz von 2 {2,4,8,…} ausgewählt. Basierend auf den oben genannten Regeln für die Konstruktion des Entscheidungsbaums kann der von Galvatron erstellte Entscheidungsbaum jede Kombination der oben genannten Parallelität darstellen. Takeway#1 und Takeway#2 helfen Galvatron, ineffiziente Parallelkombinationen zu vermeiden und den Suchraum zu reduzieren. Für das Szenario des Trainings eines einschichtigen Modells auf einer 8-Karten-GPU ergeben die oben genannten Regeln 34 Kandidaten für hybride Parallelstrategien. Darüber hinaus wird die Anzahl der 8-Karten-Kandidatenstrategien auf 22 reduziert, nachdem Takeway#3 verwendet wurde, um die Situation zu bereinigen, in der DP und SDP gleichzeitig in einem Entscheidungsbaum erscheinen. Die folgende Abbildung zeigt ein schematisches Diagramm des Entscheidungsbaums unter unterschiedlicher PP-Parallelität (8/4/2/1) im 8-Karten-GPU-Szenario. Schematisches Diagramm des Entscheidungsbaums unter unterschiedlicher PP-Parallelität (8/4/2/1) im 8-Karten-GPU-Szenario 2. Paralleler Optimierungsalgorithmus basierend auf dynamischer Programmierung Bestehende Systeme wie z wie Megatron oder DeepSpeed erfordern normalerweise, dass Benutzer das globale Parallelschema und den entsprechenden Parallelitätsgrad angeben, was die Fähigkeit, verteilte Ausführungspläne auszudrücken, erheblich einschränkt. Das Optimierungsziel von Galvatron besteht darin, automatisch den optimalen verteilten Ausführungsplan zu generieren, ohne dass der Benutzer eine parallele Konfiguration angeben muss, wenn dem Benutzer eine Modelldefinition und eine verteilte Umgebung gegeben wird. Insbesondere besteht das Optimierungsziel von Galvatron bei gegebenen M- und N-GPU-Geräten mit L-Schicht darin, nach dem höchsten Systemdurchsatz T_pt zu suchen und die entsprechende parallele Lösung zurückzugeben. Die parallele Lösung bezieht sich hier auf die Schicht (oder den Operator). ) als Grundeinheit einer feinkörnigen hybriden Parallelstrategie. Algorithmus 1: Galvatron-Optimierungsprozess Optimierungsprozess: Der Optimierungsprozess von Galvatron wird in Algorithmus 1 dargestellt. Die äußerste Schleife von Galvatron erhöht schrittweise die Suchstapelgröße, bis sie den Gerätespeicher bei gegebener Stapelgröße B jedes Kandidaten überschreitet. Galvatron teilt zunächst das Modell PP gemäß Takeaway Nr. 1 auf und sucht nach unterschiedlichen Parallelitätsgraden P (Zeile 4). Nach Auswahl von P -way PP, das Modell wird in P-Stufen unterteilt (Zeile 6) und alle entsprechenden Geräte werden in P-Gruppen unterteilt, wobei jede Gruppe N/P-Geräte enthält. Anschließend erstellt Galvatron den entsprechenden Entscheidungsbaum, der jede Kombination von DP ausdrücken kann , SDP und TP ohne Duplizierung, wodurch der Strategiesatz S erhalten wird. Dann verwendet Galvatron für jede Modellstufe M_i unter der Gerätespeichergrenze E die dynamische Programmiersuche, um die optimale Hybrid-Parallelstrategie für jede Schicht zu erhalten, und gibt die minimalen Zeitkosten zurück ( Zeile 9); schließlich wählt Galvatron die Strategie mit dem höchsten Durchsatz unter allen möglichen PP-Parallelitäten und Chargengrößen aus und gibt sie zurück (Zeile 15). Dynamische Programmiersuche: Im Folgenden wird der dynamische Programmiersuchalgorithmus im parallelen Optimierungsworkflow von Galvatron vorgestellt. Für eine gegebene Modellstufe mit L Schichten wird die Kostenfunktion C(L,E) verwendet, um die Gesamtausführungszeit des L-Schicht-Modells unter der Gerätespeichergrenze E darzustellen, und stellt die Ausführungszeit der L-Schicht unter Verwendung der Strategie dar S_j, wobei die Strategie S_j die Strategie im parallelen Strategiekandidatensatz S ist. Durch Festlegen des Anfangswerts folgt die dynamische Programmiersuche von Galvatron der folgenden Zustandsübergangsgleichung (Formel 1): wobei der Speicher von Schicht L unter Verwendung der Strategie S_j ist Der Overhead, , ist der Konvertierungs-Overhead, der durch die L-te Schicht mit der Strategie S_j und die vorherige Schicht mit der Strategie S_i verursacht wird. Wenn während des Zustandsübertragungsprozesses der Speicher-Overhead die Gerätespeichergrenze E überschreitet, gibt die Overhead-Funktion C Unendlich zurück. Komplexitätsanalyse: Die rechnerische Komplexität der von Galvatron verwendeten dynamischen Programmiersuche (Formel 1) beträgt O(LE|S|). Es ist ersichtlich, dass die Größe des Suchraums S jeder Schicht für die Gesamtkomplexität der Suche sehr wichtig ist. Die von Galvatron vorgeschlagene Suchraumzerlegung auf der Grundlage von Entscheidungsbäumen kann den Suchraum erheblich reduzieren und den Suchaufwand innerhalb eines angemessenen Bereichs steuern . 3. Methode zur Schätzung der Ausführungskosten basierend auf Hybridmodellierung Galvatron verwendet ein Modul zur Kostenschätzung von Richtlinien, um den Rechen-, Kommunikations- und Speicheraufwand hybrider paralleler Strategien abzuschätzen. Bestehende Kostenschätzungsmethoden umfassen hauptsächlich Messung (Profilierung) und Simulation (Simulation). Galvatron nutzt die Stärken beider und entwickelt eine kostengünstige, effiziente und genaue Kostenschätzungsmethode. Insbesondere für den Speicheraufwand verwendet Galvatron die Form und den Datentyp des Tensors, um die Schätzung für die Berechnungszeit abzuschließen. Galvatron misst die Berechnungszeit für jede Probe durch Profilierung auf einem einzigen Gerät und kombiniert die Chargengröße und die Anpassungsfunktion Schätzen Sie die Gesamtberechnungszeit. Für die Kommunikationszeit erhält Galvatron die geschätzte Kommunikationszeit, indem es das Kommunikationsvolumen durch die Kommunikationsbandbreite des Geräts dividiert, wobei das Kommunikationsvolumen theoretisch berechnet und die Kommunikationsbandbreite durch Profilierung gemessen wird. Basierend auf den obigen Schätzergebnissen berechnet Galvatron die Kosten c(l,s) einer gegebenen Schicht unter Verwendung einer gegebenen Strategie durch den simulierenden Ausführungsprozess. Anders als beim Kostenmodell bestehender verteilter Trainingssysteme berücksichtigt Galvatron bei der Modellierung erstmals die Auswirkungen überlappender Berechnungen und Kommunikation auf die Verschlechterung der GPU-Leistung. In dieser Studie wurde experimentell festgestellt, dass eine Verschlechterung der GPU-Leistung aufgrund von Überlappungen die Ausführungseffizienz des Systems erheblich beeinträchtigen kann, was in früheren Arbeiten ignoriert wurde. Dadurch sind die Kostenschätzungen von Galvatron genauer und die parallele Optimierung besser. Experimentelle Einstellungen: Im Experiment verglichen die Forscher Galvatron und vier Basissysteme (DP, SDP, TP, PP) und DeepSpeed 3D Parallelism wurden von Experten zum Vergleich festgelegt. Gleichzeitig wurden zwei abgeschwächte Versionen von Galvatron als zusätzliche Basislinien im begrenzten Parallelstrategie-Kombinationsraum eingerichtet (d. h. TP+DP, PP+DP). suchen. In dieser Studie wurden die NLP-Transformer-Modelle BERT und T5 sowie die CV-Transformer-Modelle ViT und Swin Transformer als Versuchspersonen ausgewählt. Durchsatzvergleich zwischen Galvatron und Basissystemen unter 8 GPUs 20G Videospeicher Experimenteller Vergleichseffekt: Die Studie wurde zunächst in einer Nvidia RTX TITAN 24GB-Umgebung mit acht Karten durchgeführt. Experimente zeigen, dass Galvatron bei unterschiedlichen Modellgrößen und unterschiedlichen Speicherbeschränkungen immer den optimalen Durchsatz erreicht und der Trainingsdurchsatz im Vergleich zu den bestehenden hochmodernen Einzelparallelmethoden und Hybridparallelmethoden deutlich verbessert wird. Insbesondere beim ViT-Modell kann das Durchsatzbeschleunigungsverhältnis von Galvatron im Vergleich zu einer Einzelstrategie bis zu 338 % erreichen, und sein Durchsatzbeschleunigungsverhältnis kann im Vergleich zu anderen Hybrid-Parallelstrategien bis zu 55 % erreichen und bestehende gemischte Strategie, Galvatron hat ein Beschleunigungsverhältnis von bis zu 200 %-334 % und 28 %-52 %. Schematische Darstellung eines Teils der durch Galvatron-Suche erhaltenen optimalen Parallelstrategie# 🎜🎜# Interpretierbarkeitsexperiment: In dieser Studie wurden einige optimale Parallelstrategien ausgewählt, die durch die Galvatron-Suche für die Anzeige ermittelt wurden. Für das BERT-Modell im Fall von 8 GB (Fall A) wählte Galvatron zwei hybride Parallelstrategien: PP-TP-DP und PP-TP-SDP. Als der verfügbare Videospeicher auf 12 GB anstieg, gab Galvatron PP auf und entschied sich für die Verwendung von mehr Mehrere DPs und SDP werden eingeführt, um Videospeicherplatz zu sparen. Bei Swin Transformer ist die Situation etwas anders. Wenn der Speicher relativ knapp ist (Fall C), ist die Parallelität bei flachem SDP höher und die Parameter werden größer, sodass TP nach und nach SDP ersetzt. Wenn der Videospeicher zunimmt (Fall D), wird nicht nur PP wieder aktiviert, um einen Teil des ineffizienten SDP zu ersetzen, sondern die flache Schicht tendiert auch dazu, DP offensichtlicher zu verwenden. Die Studie testete Galvatron außerdem auf größeren Clustern, einschließlich einer Umgebung mit Nvidia RTX TITAN-GPUs mit 16 Karten und Nvidia A100-GPUs mit 64 Karten. In der 16-Karten-Umgebung weist Galvatron im Vergleich zu anderen Strategien immer noch den höchsten Durchsatz auf. Aufgrund der vielfältigeren Hybrid-Parallel-Strategie kann Galvatron im Vergleich zu den experimentellen Ergebnissen mit 8 Karten einen mehr als doppelten Durchsatz erzielen auf 16 Karten. Im 64-Karten-Experiment hatte Galvatron neben anderen Strategien auch die höchste Durchsatzrate. Dies zeigt, dass Galvatron eine gute Skalierbarkeit aufweist. Detaillierte Ergebnisse finden Sie im Originalpapier. Das Hetu-Entwicklungsteam kommt vom Data and Intelligence Research Lab der Peking-Universität (im Folgenden als: Labor bezeichnet), das Labor wird von Professor geleitet Cui Bin von der Fakultät für Informatik der Universität Peking hat im Laufe der Jahre vor allem Spitzenforschung in den Bereichen künstliche Intelligenz und Big Data betrieben und zahlreiche Ergebnisse in der theoretischen und technologischen Innovation sowie in der Systemforschung und -entwicklung erzielt. und wurde zu den führenden internationalen akademischen Institutionen gezählt. Er hat mehr als 100 wissenschaftliche Arbeiten in Konferenzen und Fachzeitschriften veröffentlicht. Das Hetu-System ist ein verteiltes Deep-Learning-System für sehr große Modelle und weist eine bessere Systemfunktionalität und Systemkomplexität auf hat viele innovative Beiträge in Bezug auf Sicherheit und Benutzerfreundlichkeit des Systems geleistet, wie z. B. automatische verteilte Parallelstrategien, Konsistenzprotokolle und Kommunikationsarchitekturen, GPU-Operatoroptimierung usw. Das Hetu-Team hat derzeit akademische Innovationen in verschiedenen verteilten maschinellen Lern- oder Deep-Learning-Szenarien durchgeführt und entsprechende Ergebnisse wurden in internationale Top-Konferenzen wie SIGMOD, VLDB, ICML, KDD usw. aufgenommen. Darunter das spärliche große Modell Das verteilte Trainingssystem HET gewann den VLDB 2022 Best Prize. Galvatron, das von VLDB 2023 angenommene Papier, ist ein weiterer Durchbruch des Hetu-Teams in verteilten Trainingsszenarien mit dichten, großen Modellen. Es wurde in das Hetu-System integriert und ist Open Source. Derzeit hat das Hetu-Team wissenschaftliche Forschungskooperationen und Anwendungsimplementierungen mit vielen namhaften Unternehmen wie Tencent, Alibaba, Kuaishou und ByteDance durchgeführt. Das verteilte Trainingsartefakt Galvatron realisiert eine effiziente automatische Parallelisierung großer Modelle mit einem Klick.

und

und  , darunter

, darunter  .

.

Experimentelle Ergebnisse

北大河图 Teamprofil

Das obige ist der detaillierte Inhalt vonBeidahetu veröffentlicht Galvatron, ein verteiltes Trainingsartefakt, um eine effiziente und automatische Parallelisierung großer Modelle mit einem Klick zu realisieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr