Heim >Technologie-Peripheriegeräte >KI >Zehn häufige Interviewfragen für Bewertungsmetriken für maschinelles Lernen

Zehn häufige Interviewfragen für Bewertungsmetriken für maschinelles Lernen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 20:58:021789Durchsuche

Bewertungsmetriken sind quantitative Metriken, die zur Bewertung der Leistung von Modellen für maschinelles Lernen verwendet werden. Sie bieten eine systematische und objektive Möglichkeit, verschiedene Modelle zu vergleichen und ihren Erfolg bei der Lösung eines bestimmten Problems zu messen. Durch den Vergleich der Ergebnisse verschiedener Modelle und die Bewertung ihrer Leistung können Sie die richtigen Entscheidungen darüber treffen, welche Modelle Sie verwenden, wie Sie vorhandene Modelle verbessern und wie Sie die Leistung einer bestimmten Aufgabe optimieren können. Daher spielen Bewertungsmetriken dabei eine wichtige Rolle Entwicklung und Einsatz von Modellen für maschinelles Lernen spielen eine entscheidende Rolle. Daher sind Bewertungsindikatoren grundlegende Fragen, die häufig in Vorstellungsgesprächen gestellt werden. In diesem Artikel wurden 10 häufig gestellte Fragen zusammengestellt.

1. Können Sie den Unterschied zwischen Präzision und Erinnerung im Zusammenhang mit maschinellem Lernen erklären?

In Modellen für maschinelles Lernen sind Präzision und Erinnerung zwei häufig verwendete Bewertungsmetriken. Präzision ist ein Maß für die Anzahl richtig positiver Vorhersagen, die ein Modell aus allen positiven Vorhersagen macht, und gibt die Fähigkeit des Modells an, falsch positive Vorhersagen zu vermeiden.

Präzision = TP/TP+FP

Recall ist ein Maß für die Anzahl wahrer Vorhersagen, die ein Modell über alle tatsächlichen positiven Instanzen im Datensatz hinweg macht. Der Rückruf stellt die Fähigkeit des Modells dar, alle positiven Instanzen korrekt zu identifizieren.

Recall = TP/TP+FN

Sowohl Präzision als auch Recall sind wichtige Bewertungsmetriken, aber der Kompromiss zwischen beiden hängt von den Anforderungen des spezifischen zu lösenden Problems ab. In der medizinischen Diagnostik kann der Rückruf beispielsweise wichtiger sein, da es entscheidend ist, alle Fälle einer Krankheit zu identifizieren, auch wenn dies zu einer höheren Falsch-Positiv-Rate führt. Bei der Betrugserkennung ist jedoch möglicherweise Präzision wichtiger, da die Vermeidung falscher Anschuldigungen von entscheidender Bedeutung ist, auch wenn dies zu einer höheren Falsch-Negativ-Rate führt.

2. Wie wählt man eine geeignete Bewertungsmetrik für ein bestimmtes Problem aus?

Die Auswahl einer geeigneten Bewertung für ein bestimmtes Problem ist ein Schlüsselaspekt des Modellentwicklungsprozesses. Bei der Auswahl der Indikatoren ist es wichtig, die Art des Problems und die Ziele der Analyse zu berücksichtigen. Zu den häufig zu berücksichtigenden Faktoren gehören:

Problemtyp: Handelt es sich um ein binäres Klassifizierungsproblem, ein Mehrklassen-Klassifizierungsproblem, ein Regressionsproblem oder etwas anderes?

Geschäftsziel: Was ist das Endziel der Analyse und welche Art von Leistung? erforderlich? Wenn das Ziel beispielsweise darin besteht, falsch-negative Ergebnisse zu minimieren, ist die Erinnerung eine wichtigere Messgröße als die Präzision.

Datensatzeigenschaften: Sind die Klassen ausgeglichen oder unausgeglichen?

Datenqualität: Wie ist die Qualität der Daten, wie viel Rauschen ist im Datensatz vorhanden? Metrik kann ausgewählt werden, z. B. Genauigkeit, F1-Score, AUC-ROC, Precision-Recall, mittlerer quadratischer Fehler usw. Es ist jedoch üblich, mehrere Bewertungsmetriken zu verwenden, um ein umfassendes Verständnis der Modellleistung zu erhalten.

3. Können Sie die Verwendung des F1-Scores vorstellen?

Der F1-Score ist ein häufig verwendeter Bewertungsindikator beim maschinellen Lernen, der zum Ausgleich von Präzision und Erinnerung verwendet wird. Präzision misst den Anteil positiver Beobachtungen an allen positiven Vorhersagen des Modells, während Recall den Anteil positiver Vorhersagen an allen tatsächlich positiven Beobachtungen misst. Der F1-Score ist das harmonische Mittel aus Präzision und Erinnerung und wird oft als einzelne Metrik verwendet, um die Leistung eines binären Klassifikators zusammenzufassen.

F1 = 2 * (Präzision * Rückruf) / (Präzision + Rückruf)

In Situationen, in denen ein Modell einen Kompromiss zwischen Präzision und Rückruf eingehen muss, liefert der F1-Score ein detaillierteres Bild als die alleinige Verwendung von Präzision oder Rückruf. Leistungsbewertung. Beispielsweise kann in Fällen, in denen falsch-positive Vorhersagen teurer sind als falsch-negative Vorhersagen, die Optimierung der Präzision wichtiger sein, wohingegen in Fällen, in denen falsch-negative Vorhersagen teurer sind, der Rückruf priorisiert werden kann. Der F1-Score kann verwendet werden, um die Leistung des Modells in diesen Szenarien zu bewerten und entsprechende Datenunterstützung für die Anpassung seines Schwellenwerts oder anderer Parameter zur Optimierung der Leistung bereitzustellen.

4. Können Sie den Grund für die Verwendung der ROC-Kurve bei der Modellbewertung erklären? FPR). Es hilft bei der Bewertung des Kompromisses zwischen Sensitivität (echte positive Ergebnisse) und Spezifität (echte negative Ergebnisse) eines Modells und wird häufig zur Bewertung von Modellen verwendet, die Vorhersagen auf der Grundlage binärer Klassifizierungsergebnisse (z. B. Ja oder Nein, Bestanden oder Nicht bestanden usw.) treffen .).

ROC-Kurve misst die Leistung eines Modells, indem es seine vorhergesagten Ergebnisse mit den tatsächlichen Ergebnissen vergleicht. Ein gutes Modell verfügt über eine große Fläche unter der ROC-Kurve, was bedeutet, dass es genau zwischen positiven und negativen Klassen unterscheiden kann. ROC AUC (Area Under the Curve, Fläche unter der Kurve) wird verwendet, um die Leistung verschiedener Modelle zu vergleichen, insbesondere eine gute Möglichkeit, die Modellleistung zu bewerten, wenn die Klassen unausgeglichen sind.5. Wie ermittelt man den optimalen Schwellenwert für ein binäres Klassifizierungsmodell?

Der optimale Schwellenwert für ein binäres Klassifizierungsmodell wird ermittelt, indem man einen Schwellenwert findet, der Präzision und Erinnerung in Einklang bringt. Dies kann durch die Verwendung von Bewertungsmetriken wie dem F1-Score erreicht werden, der Präzision und Erinnerung ausgleicht, oder durch die Verwendung von ROC-Kurven, die die Richtig-Positiv- und Falsch-Positiv-Raten für verschiedene Schwellenwerte darstellen. Der optimale Schwellenwert wird normalerweise als der Punkt auf der ROC-Kurve gewählt, der der oberen linken Ecke am nächsten liegt, da hierdurch die Richtig-Positiv-Rate maximiert und die Falsch-Positiv-Rate minimiert wird. In der Praxis kann der optimale Schwellenwert auch von den spezifischen Zielen des Problems und den mit falsch positiven und falsch negativen Ergebnissen verbundenen Kosten abhängen.

6. Können Sie den Kompromiss zwischen Präzision und Erinnerung in der folgenden Modellbewertung vorstellen? Rückruf) Kompromiss. Hohe Präzision bedeutet eine geringe Anzahl falsch-positiver Ergebnisse, während ein hoher Recall eine geringe Anzahl falsch-negativer Ergebnisse bedeutet. Für ein bestimmtes Modell ist es oft unmöglich, Präzision und Rückruf gleichzeitig zu maximieren. Um diesen Kompromiss einzugehen, müssen die spezifischen Ziele und Bedürfnisse des Problems berücksichtigt und eine Bewertungsmetrik ausgewählt werden, die mit diesen übereinstimmt.

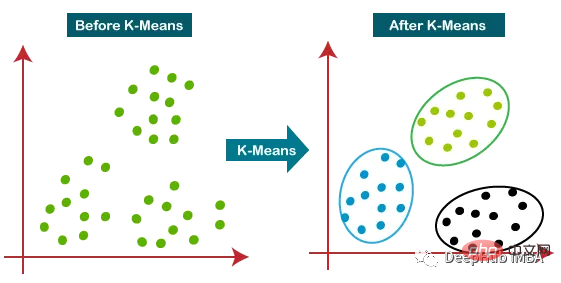

7. Wie lässt sich die Leistung des Clustering-Modells bewerten?

Die Leistung des Clustering-Modells kann anhand vieler Indikatoren bewertet werden. Einige gängige Metriken sind:

Silhouette Score: Er misst die beobachtete Ähnlichkeit des eigenen Clusters im Vergleich zu anderen Clustern. Die Werte reichen von -1 bis 1, wobei Werte näher an 1 auf eine stärkere Clusterstruktur hinweisen.- Calinski-Harabasz-Index: Er misst das Verhältnis der Varianz zwischen Clustern zur Varianz innerhalb der Cluster. Höhere Werte weisen auf bessere Clustering-Lösungen hin.

- Davies-Bouldin-Index: Er misst die durchschnittliche Ähnlichkeit zwischen jedem Cluster und seinem ähnlichsten Cluster. Kleinere Werte weisen auf bessere Clustering-Lösungen hin.

- Angepasster Rand-Index: Er misst die Ähnlichkeit zwischen echten Klassenbezeichnungen und vorhergesagten Clusterbezeichnungen, angepasst auf Basis der Wahrscheinlichkeit. Höhere Werte weisen auf bessere Clustering-Lösungen hin.

- Verwirrungsmatrix: Sie kann die Genauigkeit des Clustering-Modells bewerten, indem sie die vorhergesagten Cluster mit den wahren Klassen vergleicht.

Aber die Wahl einer geeigneten Bewertungsmetrik hängt auch von der konkreten Problemstellung und den Zielen der Clusteranalyse ab.

Aber die Wahl einer geeigneten Bewertungsmetrik hängt auch von der konkreten Problemstellung und den Zielen der Clusteranalyse ab.

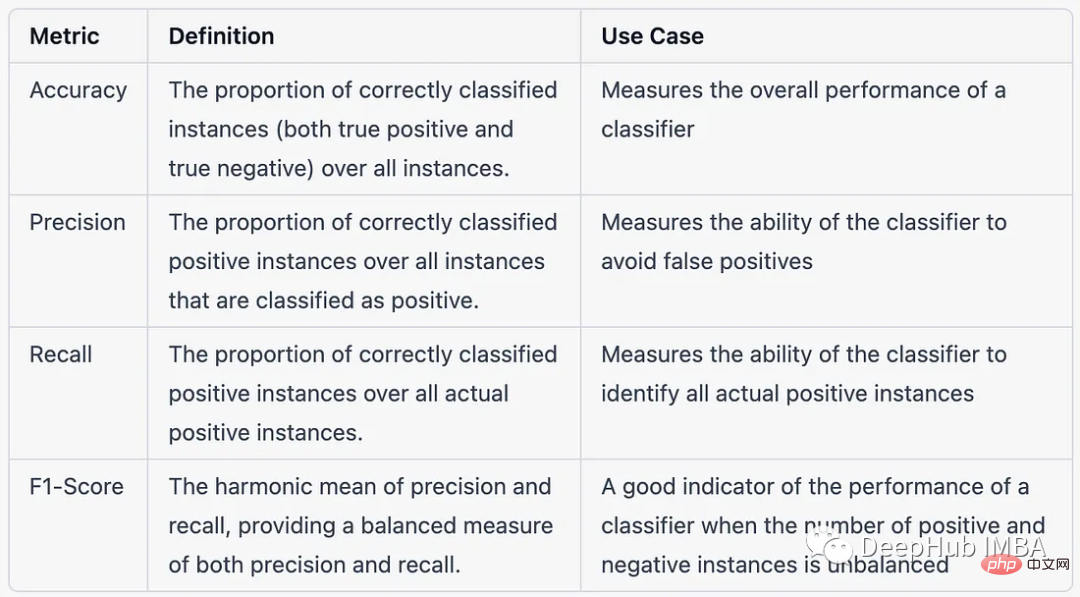

8. Der Unterschied zwischen Genauigkeit, Präzision, Rückruf und F1-Punktzahl im Kontext von Klassifizierungsproblemen mit mehreren Klassen

Das Folgende ist ein Tabellenvergleich von Genauigkeit, Präzision, Rückruf und F1-Punktzahl im Kontext von Multi-Klassen-Klassifizierungsproblemen -Klassenklassifizierungsprobleme:

9. Wie bewertet man die Leistung eines Empfehlungssystems? . Einige häufig verwendete Metriken zur Bewertung der Leistung von Empfehlungssystemen sind:

9. Wie bewertet man die Leistung eines Empfehlungssystems? . Einige häufig verwendete Metriken zur Bewertung der Leistung von Empfehlungssystemen sind:

- F1-Score: das harmonische Mittel aus Präzision und Erinnerung.

- Mittlere durchschnittliche Präzision (MAP): Ein Maß für die durchschnittliche Präzision der gesamten Benutzer eines Empfehlungssystems.

- Normalized Discounted Cumulative Gain (NDCG): Misst die ranggewichtete Relevanz empfohlener Artikel.

- Root Mean Square Error (RMSE): Ein Maß für die Differenz zwischen vorhergesagten und tatsächlichen Bewertungen für eine Reihe von Elementen.

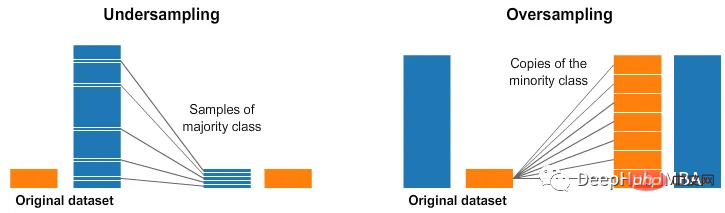

- 10. Wie gehe ich mit unausgeglichenen Datensätzen bei der Bewertung der Modellleistung um?

- Um mit unausgeglichenen Datensätzen bei der Modellbewertung umzugehen, können die folgenden Techniken verwendet werden:

Resampling des Datensatzes B. die Minderheitsklasse oder eine Überabtastung der Mehrheitsklasse, um die Klassenverteilung auszugleichen.

- Verwenden Sie kostensensitives Lernen: Weisen Sie verschiedenen Arten von Fehlklassifizierungen Kosten zu, z. B. weisen Sie falsch-negativen Ergebnissen höhere Kosten zu als falsch-positiven Ergebnissen, um das Modell empfindlicher gegenüber Minderheitenklassen zu machen.

- Verwenden Sie Ensemble-Methoden: Durch die Kombination der Ergebnisse mehrerer Modelle können Techniken wie Bagging, Boosting und Stacking verwendet werden, um die Modellleistung bei unausgeglichenen Datensätzen zu verbessern.

- Hybride Methoden: Eine Kombination der oben genannten Techniken kann verwendet werden, um unausgeglichene Datensätze bei der Modellbewertung zu verarbeiten.

- Zusammenfassung

- Bewertungsmetriken spielen eine Schlüsselrolle beim maschinellen Lernen. Die Auswahl der richtigen Bewertungsmetrik und deren angemessene Verwendung sind entscheidend für die Sicherstellung der Qualität und Zuverlässigkeit von Modellen für maschinelles Lernen und der Erkenntnisse, die sie generieren. Da es auf jeden Fall zum Einsatz kommt, ist dies eine häufig gestellte Frage in Vorstellungsgesprächen. Ich hoffe, dass die in diesem Artikel zusammengestellten Fragen für Sie hilfreich sind.

Das obige ist der detaillierte Inhalt vonZehn häufige Interviewfragen für Bewertungsmetriken für maschinelles Lernen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr