Heim >Technologie-Peripheriegeräte >KI >Die richtige Art, Deep Learning aus Bausteinen zu spielen! Die National University of Singapore veröffentlicht DeRy, ein neues Transfer-Lernparadigma, das den Wissenstransfer in den Druck mit beweglichen Lettern umwandelt

Die richtige Art, Deep Learning aus Bausteinen zu spielen! Die National University of Singapore veröffentlicht DeRy, ein neues Transfer-Lernparadigma, das den Wissenstransfer in den Druck mit beweglichen Lettern umwandelt

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 20:43:012026Durchsuche

Während der Qingli-Zeit von Renzong in der Nördlichen Song-Dynastie vor 980 Jahren fand in China still und leise eine Wissensrevolution statt.

Der Auslöser für all das sind nicht die Worte der Weisen, die in Tempeln leben, sondern die Stück für Stück gebrannten Tonziegel mit regelmäßigen Inschriften.

Diese Revolution ist genau „Druck mit beweglichen Lettern“.

Die Feinheit des Drucks mit beweglichen Lettern liegt in der Idee der „Bausteinmontage“: Der Handwerker fertigt zunächst die umgekehrte Zeichenform des einzelnen Zeichens an und wählt dann das einzelne Zeichen entsprechend dem Manuskript und den Pinseln aus Die Tinte und reibt es. Diese Zeichenformen können nach Bedarf angepasst werden.

Verglichen mit dem umständlichen Prozess „Ein Druck, eine Version“ des Gravierens und Druckens verbessert der Arbeitsmodus „Modular-on-Demand-Montage-Mehrfachverwendung“ geometrisch die Arbeitseffizienz des Druckens und bietet außerdem eine Jahrtausend. Es legte den Grundstein für die Entwicklung und das Erbe der menschlichen Zivilisation in der Zukunft.

Um auf den Bereich des Deep Learning zurückzukommen: Heute, wo große vorab trainierte Modelle beliebt sind, ist die Frage, wie die Fähigkeiten einer Reihe großer Modelle auf bestimmte nachgelagerte Aufgaben übertragen werden können, zu einem zentralen Thema geworden.

Die vorherige Wissenstransfer- oder Wiederverwendungsmethode ähnelt dem „Blockdrucken“: Wir müssen häufig ein neues vollständiges Modell entsprechend den Aufgabenanforderungen trainieren. Diese Methoden sind oft mit enormen Schulungskosten verbunden und lassen sich nur schwer auf eine große Anzahl von Aufgaben skalieren.

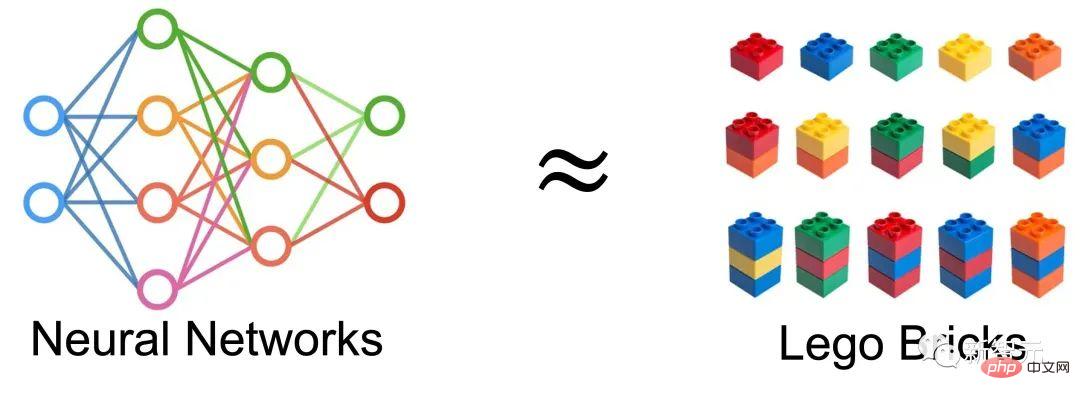

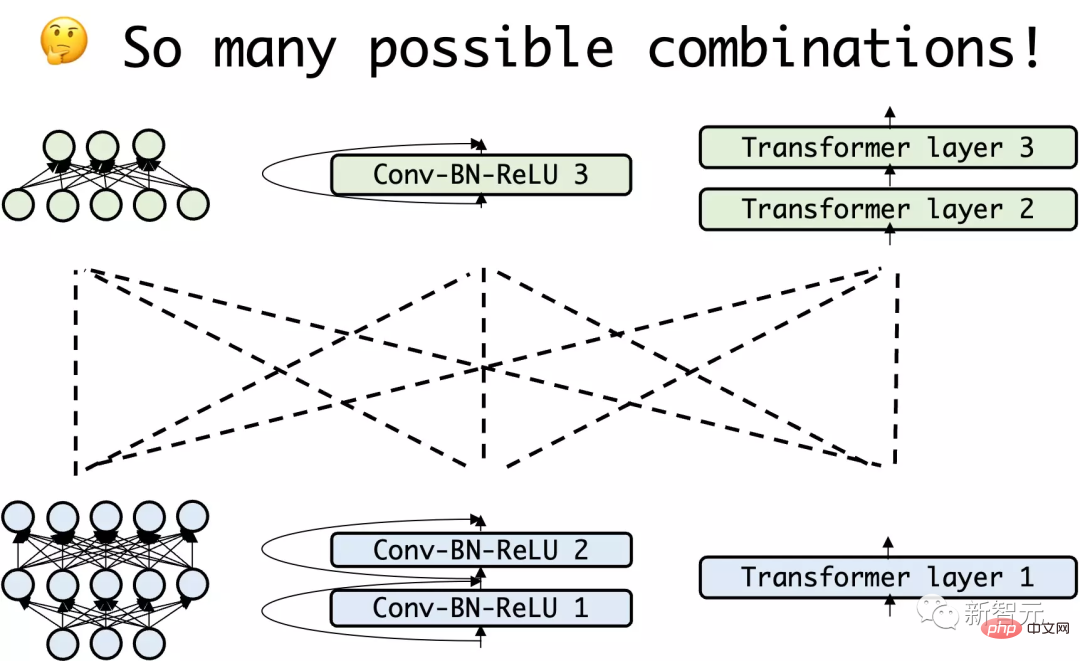

So entstand eine ganz natürliche Idee: Können wir das neuronale Netzwerk als eine Ansammlung von Bausteinen betrachten und durch den Zusammenbau des bestehenden Netzwerks ein neues Netzwerk erhalten und es für Transferlernen verwenden?

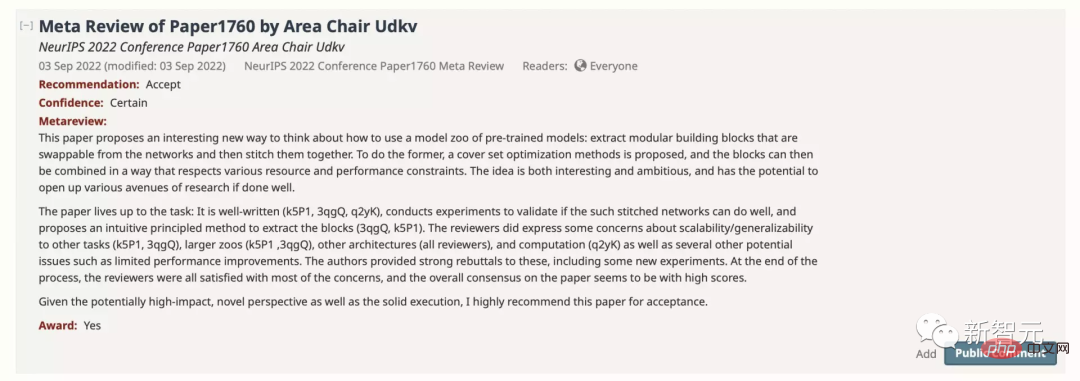

Auf der NeurIPS 2022 schlug das Team vom LVlab der National University of Singapore ein neues Transfer-Lernparadigma namens „Deep Model Reassembly“ vor.

Auf der NeurIPS 2022 schlug das Team vom LVlab der National University of Singapore ein neues Transfer-Lernparadigma namens „Deep Model Reassembly“ vor.

Papierlink: https://arxiv.org/abs/2210.17409

Codelink: https://github.com/Adamdad/DeRy

Projekt. Startseite Seite : https://adamdad.github.io/dery/

OpenReview: https://openreview.net/forum?id=gtCPWaY5bNh

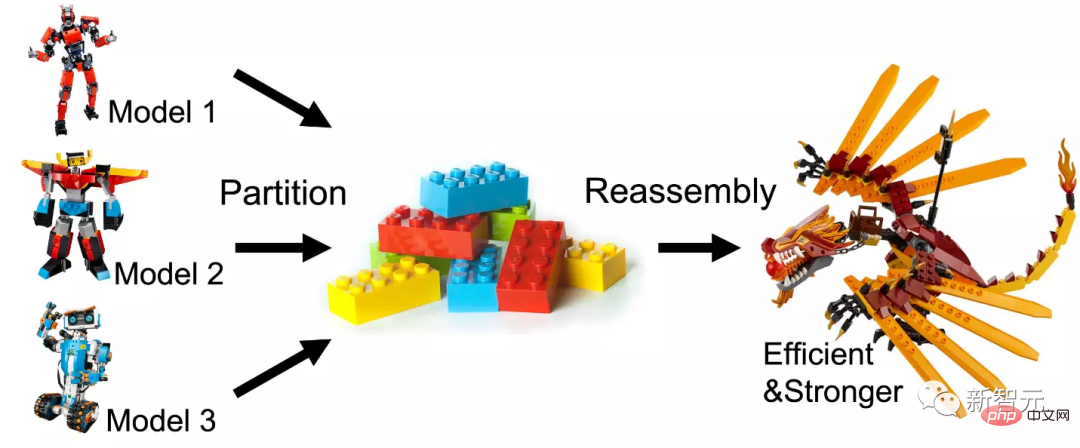

Der Autor hat zunächst die vorhandenen vorab trainierten Modelle entsprechend unterteilt zu ähnlichen Funktionen Zerlegen Sie es in ein Subnetzwerk und setzen Sie das Subnetzwerk dann wieder zusammen, um ein effizientes und benutzerfreundliches Modell für bestimmte Aufgaben zu erstellen.Das Paper wurde von NeurIPS mit einer Punktzahl von 886 angenommen und für die Nominierung für den Paper Award empfohlen.

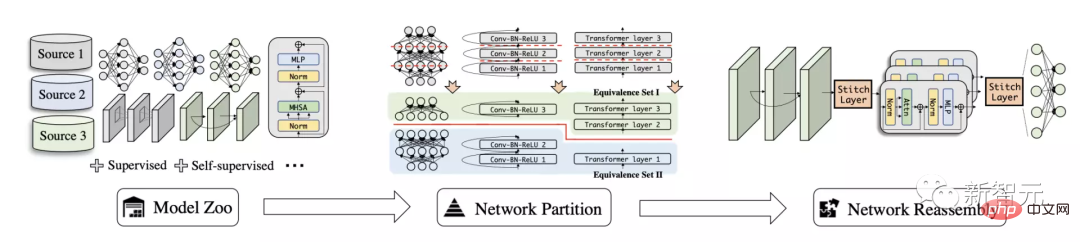

Anhand einer Reihe vorab trainierter Modelle, die auf verschiedenen Daten und heterogenen Architekturen trainiert wurden, wird bei der tiefgreifenden Modellrestrukturierung zunächst jedes Modell in unabhängige Modellblöcke aufgeteilt und dann die Untermodellteile selektiv wieder zusammengesetzt.

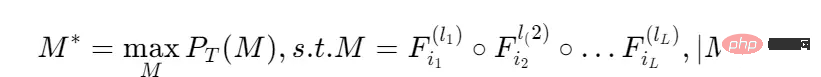

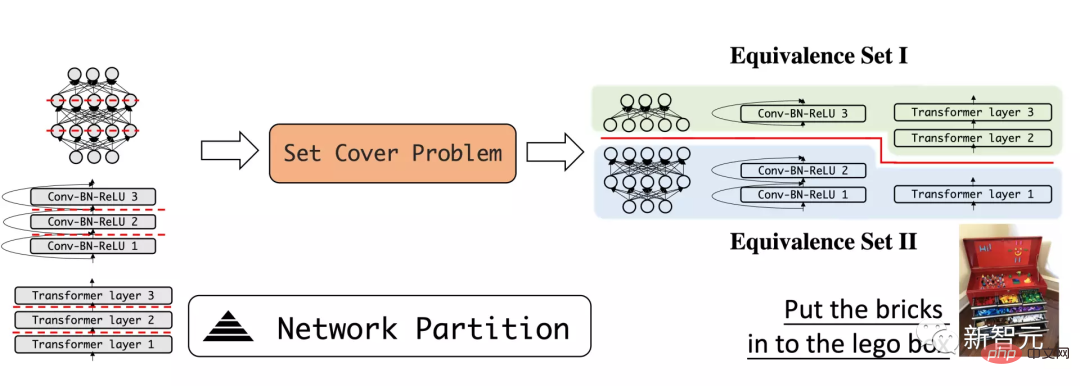

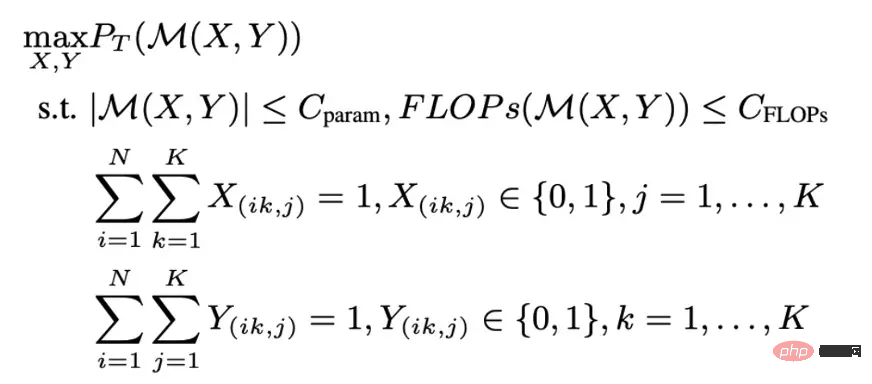

Diese Methode ähnelt der Behandlung des tiefen neuronalen Netzwerkmodells als Bausteine: Zerlegen Sie die vorhandenen großen Bausteine in kleine Bausteine und setzen Sie die Teile dann nach Bedarf zusammen. Das zusammengebaute neue Modell sollte nicht nur eine stärkere Leistung aufweisen; der Montageprozess sollte auch die Struktur und Parameter des Originalmoduls möglichst nicht verändern, um dessen Effizienz sicherzustellen. Die Methode in diesem Artikel kann in zwei Teile unterteilt werden. DeRy löst zunächst ein Set-Cover-Problem und teilt alle vorab trainierten Netzwerke nach Funktionsebenen auf. Im zweiten Schritt formalisiert DeRy die Modellassemblierung in ein 0-1-Ganzzahl-Programmierproblem, um sicherzustellen, dass das zusammengestellte Modell bei bestimmten Aufgaben die beste Leistung erbringt. Deep Model Reassembly Zunächst definiert der Autor das Problem der Deep Model Reassembly: Bei einem trainierten Tiefenmodell wird es als Modellbibliothek bezeichnet. Jedes Modell besteht aus Ebenenverknüpfungen, dargestellt als . Unterschiedliche Netzwerke können völlig unterschiedliche Strukturen und Abläufe haben, solange das Modell Schicht für Schicht verbunden ist. Bei einer gegebenen Aufgabe hoffen wir, das Schichtmischungsmodell mit der besten Leistung zu finden, und die Berechnungsmenge des Modells erfüllt bestimmte Einschränkungen: Leistung bei der Aufgabe Stellt den th des th dar Modellebenenoperationen; Dieses Problem erfordert die Suche aller Permutationen aller Modellebenen, um den Gewinn zu maximieren. Im Wesentlichen handelt es sich bei dieser Aufgabe um eine äußerst komplexe kombinatorische Optimierung. Um die Suchkosten zu vereinfachen, wird in diesem Artikel zunächst das Modell der Modellbibliothek in Tiefenrichtung aufgeteilt, um einige flachere und kleinere Teilnetze zu bilden. Anschließend wird eine Spleißsuche auf Teilnetzebene durchgeführt. Teilen Sie das Netzwerk nach Funktionsebenen auf Der erste Schritt von DeRy besteht darin, das Deep-Learning-Modell wie Bausteine zu zerlegen. Der Autor verwendet eine Methode zur Aufteilung tiefer Netzwerke, um das tiefe Modell in einige flachere kleine Modelle aufzuteilen. Der Artikel hofft, dass die zerlegten Untermodelle möglichst unterschiedliche Funktionen aufweisen. Dieser Vorgang lässt sich mit dem Vorgang vergleichen, Bausteine zu zerlegen und in Spielzeugkisten in Kategorien einzuteilen: Ähnliche Bausteine werden zusammengesetzt und unterschiedliche Bausteine auseinandergenommen. Teilen Sie das Modell beispielsweise in die untere und die obere Ebene auf und gehen Sie davon aus, dass die untere Ebene hauptsächlich für die Identifizierung lokaler Muster wie Kurven oder Formen verantwortlich ist, während die obere Ebene die Gesamtsemantik beurteilen kann Probe. Mit dem allgemeinen Merkmalsähnlichkeitsmessindex kann die funktionale Ähnlichkeit jedes Modells quantitativ gemessen werden. Die Schlüsselidee ist, dass neuronale Netze mit derselben Funktion für ähnliche Eingaben ähnliche Ausgaben erzeugen können. Für die Eingabetensoren X und Dann kann die Modellbibliothek durch funktionale Ähnlichkeit in funktionale Äquivalenzmengen unterteilt werden. Die Teilnetzwerke in jedem Äquivalenzsatz weisen eine hohe funktionale Ähnlichkeit auf, und die Unterteilung jedes Modells gewährleistet die Trennbarkeit der Modellbibliothek. Ein Hauptvorteil des Abbaus auf diese Weise besteht darin, dass die Teilnetze in jedem Äquivalenzsatz aufgrund funktionaler Ähnlichkeit als annähernd austauschbar betrachtet werden können, d. h. ein Netzwerkblock kann durch ein anderes Teilnetz des ersetzt werden gleichen Äquivalenzsatz, ohne die Netzwerkvorhersagen zu beeinflussen. Das obige Aufteilungsproblem kann als dreistufiges eingeschränktes Optimierungsproblem formalisiert werden: Die Optimierung dieses Problems auf innerer Ebene steht in größerem Zusammenhang mit dem allgemeinen Covering-Set-Problem oder dem Graphsegmentierungsproblem. Ähnlichkeit. Daher verwendet der Autor einen heuristischen Kernighan-Lin (KL)-Algorithmus, um die innere Schicht zu optimieren. Die allgemeine Idee besteht darin, dass für zwei zufällig initialisierte Untermodelle jeweils eine Schicht von Operationen ausgetauscht wird. Wenn der Austausch den Wert der Bewertungsfunktion erhöhen kann, wird der Austausch beibehalten. Die äußere Schleife verwendet hier einen K-Means-Clustering-Algorithmus. Für jede Netzwerkteilung wird jedes Teilnetzwerk immer dem Funktionssatz mit dem größten Achsabstand zugeordnet. Da die inneren und äußeren Schleifen iterativ sind und eine Konvergenzgarantie haben, kann durch die Lösung des oben genannten Problems die optimale Aufteilung des Teilnetzes nach Funktionsebenen erreicht werden. Netzwerkzusammenstellung basierend auf ganzzahliger Optimierung Die Netzwerkaufteilung unterteilt jedes Netzwerk in Teilnetzwerke, und jedes Teilnetzwerk gehört zu einer Äquivalenzmenge. Dieser kann als Suchraum genutzt werden, um das optimale Netzwerkspleißen für nachgelagerte Aufgaben zu finden. Aufgrund der Vielfalt der Untermodelle handelt es sich bei dieser Netzwerkassemblierung um ein kombinatorisches Optimierungsproblem mit einem großen Suchraum, und bestimmte Suchbedingungen sind definiert: Jede Netzwerkkombination entnimmt einen Netzwerkblock aus demselben Funktionsumfang und entsprechend ihrer Position im ursprünglichen Netzwerk platziert werden, muss das synthetisierte Netzwerk die Rechengrenze erfüllen. Dieser Prozess wird als Optimierung eines ganzzahligen 0-1-Optimierungsproblems beschrieben. Um den Trainingsaufwand für jede Berechnung der kombinierten Modellleistung weiter zu reduzieren, greift der Autor auf eine alternative Funktion im NAS-Training zurück, die kein Training erfordert, genannt NASWOT. Daraus kann die tatsächliche Leistung des Netzwerks angenähert werden, indem einfach die Rückschlüsse des Netzwerks auf einen bestimmten Datensatz verwendet werden. Durch den oben genannten „Split-Rekombination“-Prozess können verschiedene vorab trainierte Modelle gespleißt und fusioniert werden, um ein neues und stärkeres Modell zu erhalten. Experimentelle Ergebnisse Im Experiment wurden zwei verschiedene Trainingsmethoden verwendet: Full-Tuning, was bedeutet, dass alle Parameter des Modells nach dem Spleißen trainiert werden; Freeze-Tuning, was bedeutet, dass nur die Verbindungsschicht nach dem Spleißen trainiert wird .

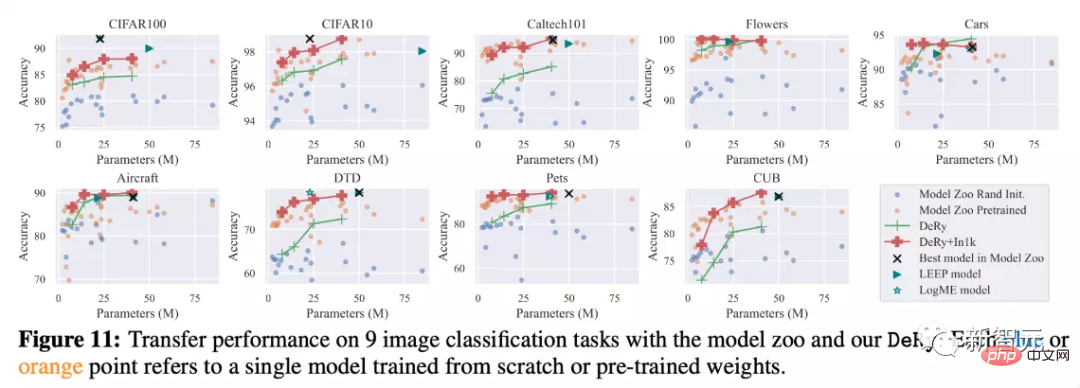

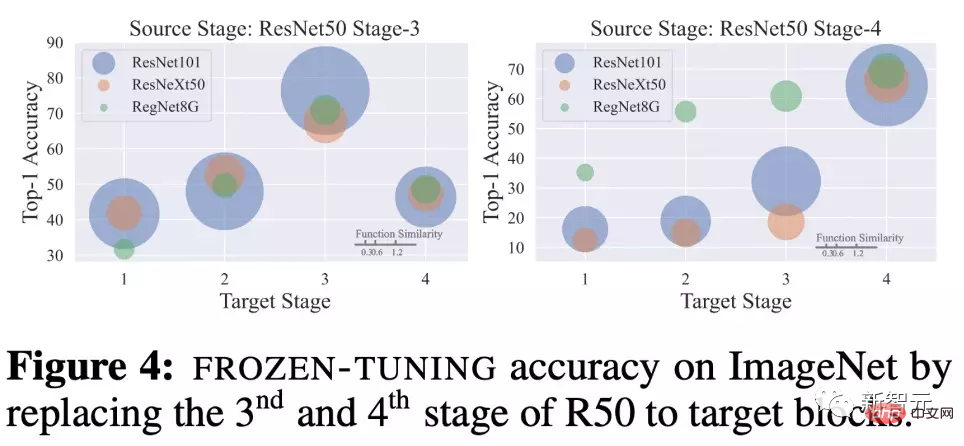

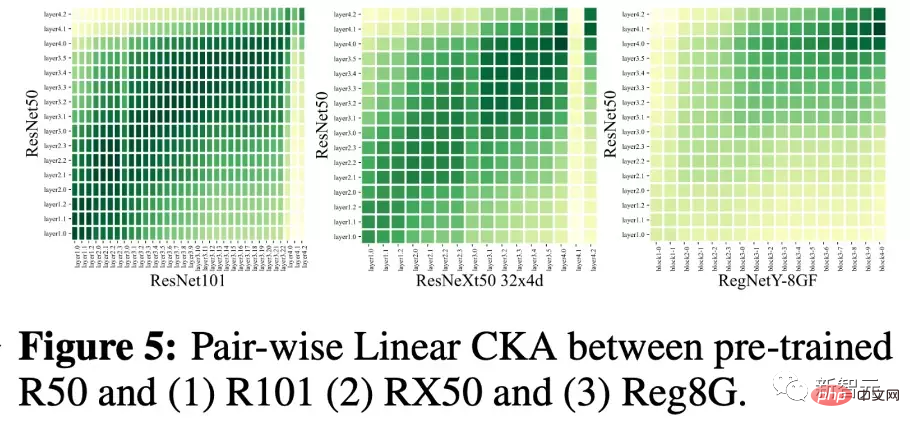

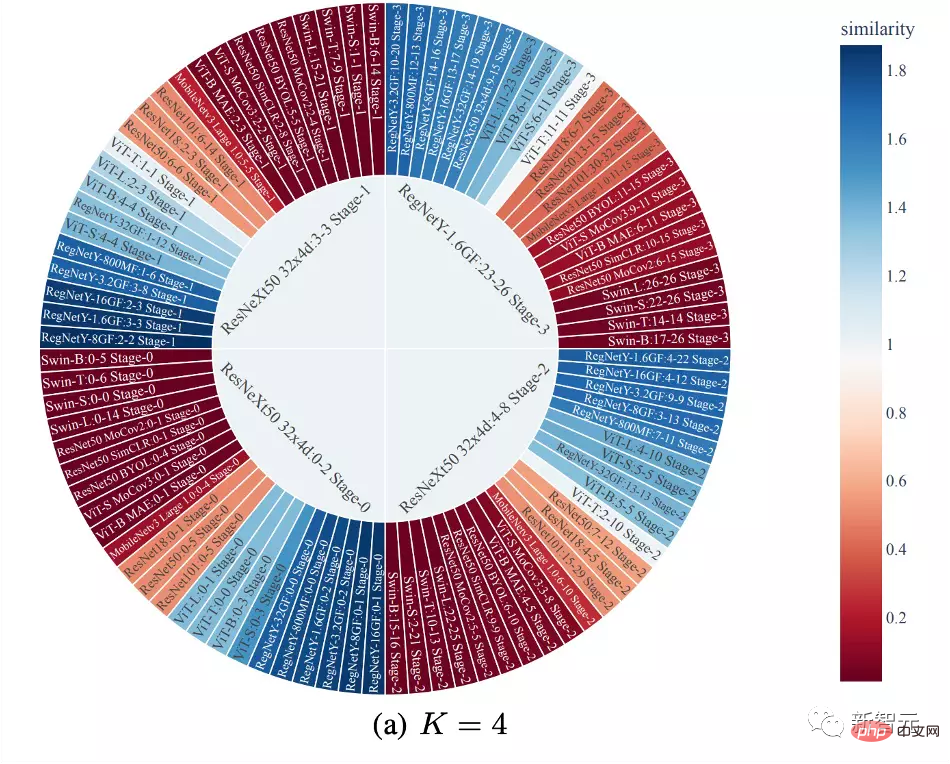

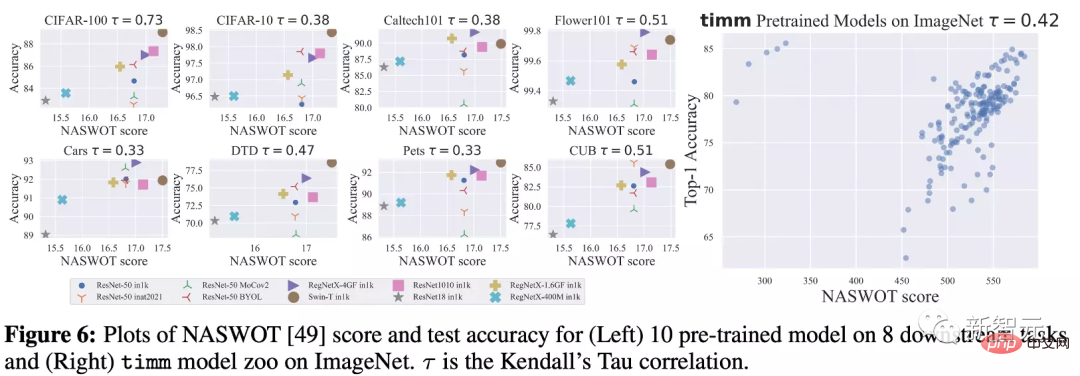

Wie Sie im Bild oben sehen können, können die von DeRy erhaltenen Modelle unterschiedlicher Maßstäbe im ImageNet-Datensatz besser oder gleich den Modellen ähnlicher Größe in der Modellbibliothek sein. Es kann festgestellt werden, dass das Modell auch dann noch starke Leistungssteigerungen erzielen kann, wenn nur die Parameter des Linkteils trainiert werden. Beispielsweise erreichte das DeRy(4,90,20)-Modell mit nur 1,27 Millionen trainierten Parametern eine Top1-Genauigkeit von 78,6 %. Gleichzeitig bestätigten 9 Transfer-Learning-Experimente auch die Wirksamkeit von DeRy. Es ist ersichtlich, dass das Modell von DeRy beim Vergleich verschiedener Modellgrößen ohne Vortraining besser sein kann. Durch kontinuierliches Vortraining des neu zusammengesetzten Modells kann die Modellleistung erheblich verbessert werden. Im Vergleich zu anderen Transferlernmethoden aus der Modellbibliothek wie LEEP oder LogME kann DeRy die Leistungsbeschränkungen der Modellbibliothek selbst übertreffen und sogar besser sein als das beste Modell in der ursprünglichen Modellbibliothek. Untersuchung der Art der Modellreorganisation Der Autor ist auch neugierig auf die Art der in diesem Artikel vorgeschlagenen Modellreorganisation, wie zum Beispiel „Nach welcher Art von Muster wird das Modell aufgeteilt?“ „ und „Nach welchem Muster wird das Modell aufgeteilt?“ Regeln müssen neu strukturiert werden?“ Der Autor stellt Experimente zur Analyse zur Verfügung. Funktionelle Ähnlichkeit, Rekombinationsposition und Rekombinationsleistung Der Autor untersuchte Freeze-Tuning 20 Epochen nach dem Ersetzen desselben Netzwerkblocks durch andere Netzwerkblöcke mit unterschiedlichen funktionalen Ähnlichkeiten. Für ResNet50, das auf ImageNet trainiert wurde, ersetzen Sie die Netzwerkblöcke der 3. und 4. Stufe durch verschiedene Netzwerkblöcke von ResNet101, ResNeXt50 und RegNetY8G. Es ist zu beobachten, dass die Ersatzposition einen großen Einfluss auf die Leistung hat. Wenn beispielsweise die dritte Stufe durch die dritte Stufe eines anderen Netzwerks ersetzt wird, wird die Leistung des neu organisierten Netzwerks besonders stark sein. Gleichzeitig korreliert die funktionale Ähnlichkeit auch positiv mit der Rekombinationsleistung. Netzwerkmodellblöcke in derselben Tiefe weisen eine größere Ähnlichkeit auf, was nach dem Training zu stärkeren Modellfähigkeiten führt. Dies weist auf die Abhängigkeit und den positiven Zusammenhang zwischen Ähnlichkeit – Rekombinationsposition – Rekombinationsleistung hin. Beobachtung der Aufteilungsergebnisse Im Bild unten zeichnet der Autor die Ergebnisse des ersten Schrittes der Aufteilung. Die Farbe stellt die Ähnlichkeit zwischen dem Netzwerkblock und dem Netzwerkblock in der Mitte des Äquivalenzsatzes des Songs dar. Es ist ersichtlich, dass die in diesem Artikel vorgeschlagene Aufteilung dazu neigt, die Teilnetze nach Tiefe zu gruppieren und aufzuteilen. Gleichzeitig sind die funktionalen Ähnlichkeitsdaten von CNN und Transformer gering, aber die funktionale Ähnlichkeit zwischen CNN und CNNs unterschiedlicher Architektur ist normalerweise größer. Verwendung von NASWOT als Leistungsindikator Da dieser Artikel NASWOT zum ersten Mal für die Transfervorhersage ohne Training anwendet, hat der Autor auch die Zuverlässigkeit dieses Indikators getestet. In der folgenden Abbildung berechnet der Autor die NASWOT-Scores verschiedener Modelle anhand verschiedener Datensätze und vergleicht sie mit der Genauigkeit des Transferlernens plus eins. Es ist zu beobachten, dass die NASWOT-Scores eine genauere Leistungseinstufung erhalten haben (Kendalls Tau-Korrelation). Dies zeigt, dass der in diesem Artikel verwendete Null-Trainingsindex die Leistung des Modells anhand nachgelagerter Daten effektiv vorhersagen kann. Dieses Papier schlägt eine neue Wissenstransferaufgabe namens Deep Model Reassembly (DeRy) vor. Er konstruiert ein Modell, das an nachgelagerte Aufgaben angepasst ist, indem er bestehende heterogene vorab trainierte Modelle aufbricht und neu zusammensetzt. Der Autor schlägt eine einfache zweistufige Implementierung vor, um diese Aufgabe zu erfüllen. Zunächst löst DeRy ein Covering-Set-Problem und teilt alle vorab trainierten Netzwerke nach Funktionsebenen auf. Im zweiten Schritt formalisiert DeRy die Modellassemblierung in ein ganzzahliges 0-1-Programmierproblem, um die Leistung des zusammengestellten Modells bei bestimmten Aufgaben sicherzustellen. optimal. Diese Arbeit erzielte nicht nur starke Leistungsverbesserungen, sondern kartierte auch die mögliche Konnektivität zwischen verschiedenen neuronalen Netzen.

Das Tiefenmodell aufbrechen und neu organisieren

Der Autor hat eine Modellbibliothek mit 30 verschiedenen vorab trainierten Netzwerken sorgfältig zerlegt und neu organisiert und eine Leistungsbewertung für ImageNet und 9 andere nachgelagerte Klassifizierungsaufgaben durchgeführt.

Zusammenfassung

Das obige ist der detaillierte Inhalt vonDie richtige Art, Deep Learning aus Bausteinen zu spielen! Die National University of Singapore veröffentlicht DeRy, ein neues Transfer-Lernparadigma, das den Wissenstransfer in den Druck mit beweglichen Lettern umwandelt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr