Heim >Technologie-Peripheriegeräte >KI >90 % des menschlichen Gehirns sind selbstüberwachtes Lernen. Wie weit ist ein großes KI-Modell von der Simulation des Gehirns entfernt?

90 % des menschlichen Gehirns sind selbstüberwachtes Lernen. Wie weit ist ein großes KI-Modell von der Simulation des Gehirns entfernt?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 20:29:131209Durchsuche

Wir alle wissen, dass das menschliche Gehirn zu 90 % aus selbstüberwachtem Lernen besteht und Organismen ständig Vorhersagen darüber treffen, was als nächstes passieren wird. Selbstüberwachtes Lernen bedeutet, dass Entscheidungen ohne externes Eingreifen getroffen werden können. Es gibt nur wenige Fälle, in denen wir externe Rückmeldungen akzeptieren, etwa wenn der Lehrer sagt: „Du hast einen Fehler gemacht.“ Jetzt haben einige Wissenschaftler herausgefunden, dass der selbstüberwachte Lernmechanismus großer Sprachmodelle unserem Gehirn sehr ähnlich ist. Quanta Magazine, ein bekanntes populärwissenschaftliches Medium, berichtete kürzlich, dass immer mehr Studien herausgefunden haben, dass selbstüberwachte Lernmodelle, insbesondere die Selbstlernmethoden groß angelegter Sprachmodelle, dem Lernmodell unseres Gehirns sehr ähnlich sind .

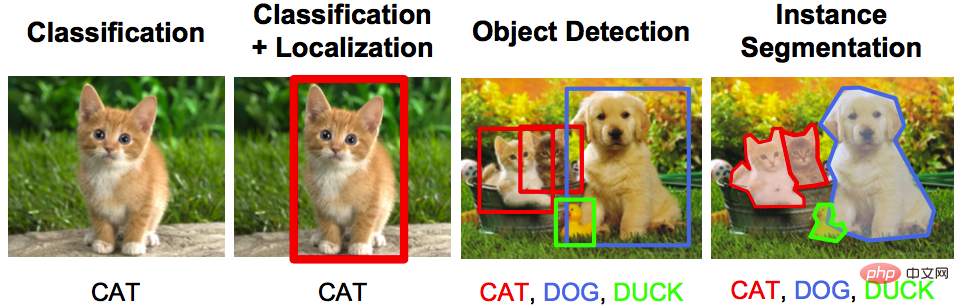

Gängige KI-Systeme wurden in der Vergangenheit mithilfe großer Mengen gekennzeichneter Daten trainiert. Beispielsweise könnten Bilder mit der Bezeichnung „Tabby-Katze“ oder „Tiger-Katze“ versehen werden, um ein künstliches neuronales Netzwerk darauf zu trainieren, korrekt zwischen Tabby und Tiger zu unterscheiden.

Diese Art des „selbstüberwachten“ Trainings erfordert eine mühsame manuelle Kennzeichnung von Daten, und neuronale Netze nehmen häufig Abkürzungen und lernen, Kennzeichnungen mit minimalen und manchmal oberflächlichen Informationen zu verknüpfen. Beispielsweise könnte ein neuronales Netzwerk das Vorhandensein von Gras nutzen, um Fotos von Kühen zu identifizieren, da Kühe häufig auf Feldern fotografiert werden. Alexei Efros, Informatiker an der University of California in Berkeley, sagte:

Die Algorithmen, die wir trainieren, sind wie Studenten, die ein ganzes Semester lang nicht zum Unterricht gekommen sind, obwohl sie den Stoff nicht studiert haben systematisch, aber sie haben die Prüfung gut bestanden.

Darüber hinaus könnte sich dieses „überwachte Lernen“ für Forscher, die sich für die Schnittstelle zwischen tierischer Intelligenz und maschineller Intelligenz interessieren, auf das beschränken, was es über biologische Gehirne verrät. Viele Tiere, darunter auch Menschen, nutzen zum Lernen keine gekennzeichneten Datensätze. Meistens erkunden sie ihre Umgebung auf eigene Faust und erlangen dabei ein umfassendes und tiefes Verständnis der Welt.

Jetzt haben einige computergestützte Neurowissenschaftler damit begonnen, neuronale Netze zu erforschen, die mit wenigen oder keinen vom Menschen markierten Daten trainiert wurden. Jüngste Erkenntnisse deuten darauf hin, dass Computermodelle der visuellen und auditiven Systeme von Tieren, die mithilfe selbstüberwachter Lernmodelle erstellt wurden, die Gehirnfunktion besser annähern als überwachte Lernmodelle.

Für einige Neurowissenschaftler scheinen künstliche neuronale Netze Möglichkeiten aufzuzeigen, das Gehirn als Analogie für maschinelles Lernen zu nutzen.

Fehlerhafte Überwachung

Vor etwa 10 Jahren begannen Gehirnmodelle zu entstehen, die von künstlichen neuronalen Netzen inspiriert waren, während ein neuronales Netz namens AlexNet die Aufgabe der Klassifizierung unbekannter Bilder revolutionierte. Dieses Ergebnis wurde in der Arbeit „ImageNet Classification with Deep Convolutional Neural Networks“ von Alex Krizhevsky, Ilya Sutskever und Geoffrey E. Hinton veröffentlicht.

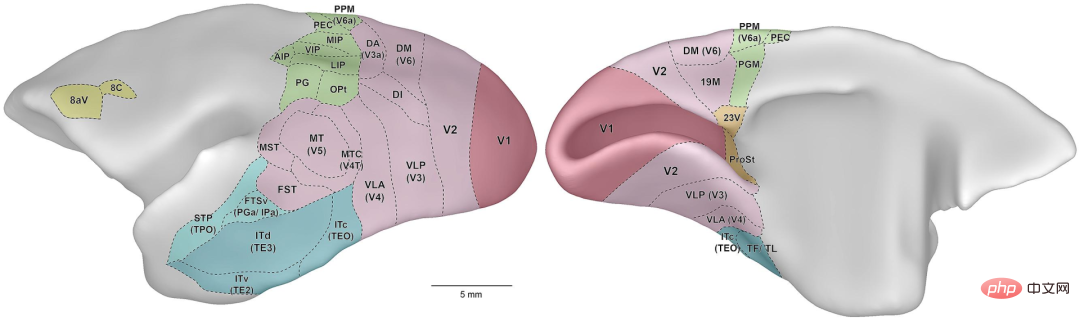

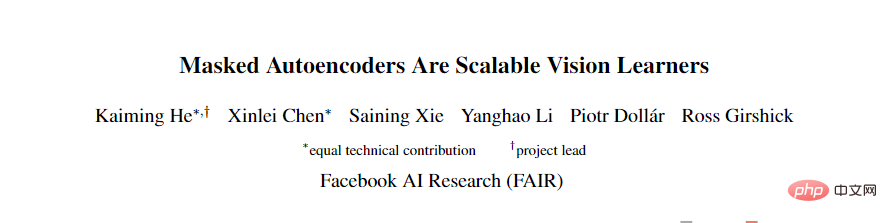

Papieradresse: https://dl.acm.org/doi/10.1145/3065386 Wie alle neuronalen Netze besteht dieses Netzwerk aus mehreren Schichten künstlicher Neuronen, in denen die Gewichte der Verbindungen zwischen verschiedenen Neuronen liegen anders. Wenn das neuronale Netzwerk ein Bild nicht richtig klassifizieren kann, aktualisiert der Lernalgorithmus die Gewichtungen der Verbindungen zwischen Neuronen, um die Wahrscheinlichkeit einer Fehlklassifizierung in der nächsten Trainingsrunde zu verringern. Der Algorithmus wiederholt diesen Vorgang mehrmals und passt die Gewichte an, bis die Fehlerrate des Netzwerks akzeptabel niedrig ist. Später verwendeten Neurowissenschaftler AlexNet, um das erste Computermodell des visuellen Systems von Primaten zu entwickeln. Als man Affen und künstlichen neuronalen Netzen die gleichen Bilder zeigte, zeigte die Aktivität realer und künstlicher Neuronen ähnliche Reaktionen. Ähnliche Ergebnisse wurden mit künstlichen Modellen der Hör- und Geruchserkennung erzielt. Doch als sich das Gebiet weiterentwickelte, erkannten die Forscher die Grenzen des selbstüberwachten Trainings. Im Jahr 2017 machten der Informatiker Leon Gatys von der Universität Tübingen in Deutschland und seine Kollegen ein Foto eines Ford Model T und überzogen das Foto anschließend mit einem Leopardenfellmuster. Während das neuronale Netzwerk mit künstlicher Intelligenz das Originalbild korrekt als Modell T klassifizierte, betrachtete das modifizierte Bild jedoch als Leopard. Der Grund dafür ist, dass es sich nur auf die Bildtextur konzentriert und die Form des Autos (oder Leoparden) nicht versteht. Selbstüberwachte Lernmodelle sollen solche Probleme vermeiden. In einem sogenannten großen Sprachmodell zeigt beispielsweise ein Trainingsalgorithmus einem neuronalen Netzwerk die ersten paar Wörter eines Satzes und fordert es auf, das nächste Wort vorherzusagen. Beim Training mit großen Textmengen aus dem Internet schien das Modell die syntaktische Struktur der Sprache zu lernen und beeindruckende sprachliche Fähigkeiten zu demonstrieren – und das alles ohne externe Etiketten oder Aufsicht. Ähnliche Bemühungen gibt es im Bereich Computer Vision. Ende 2021 demonstrierten He Kaiming und seine Kollegen die berühmte maskierte Autoencoder-Forschung „Masked Auto-Encoder“ (MAE). Papieradresse: https://arxiv.org/abs/2111.06377 MAE wandelt den unmaskierten Teil in eine latente Darstellung um – eine mathematische Beschreibung der Komprimierung, die enthält Wichtige Informationen zum Objekt. Bei Bildern könnte die zugrunde liegende Darstellung eine mathematische Beschreibung sein, die die Form der Objekte im Bild umfasst. Der Decoder wandelt diese Darstellungen dann wieder in vollständige Bilder um. Das Gehirn ist auch „selbstüberwacht“In einem solchen System glauben einige Neurowissenschaftler, dass unser Gehirn tatsächlich selbstüberwacht lernt. „Ich denke, es steht außer Frage, dass 90 Prozent dessen, was das Gehirn tut, selbstüberwachtes Lernen ist“, sagt Blake Richards, ein Computerneurowissenschaftler an der McGill University und dem Institut für Künstliche Intelligenz (Mila) in Quebec. Betrachten Sie es als ständig Vorhersagen zum Beispiel der zukünftigen Position eines sich bewegenden Objekts oder des nächsten Wortes in einem Satz, ähnlich wie ein selbstüberwachter Lernalgorithmus, der versucht, Lücken in einem Bild oder einem Textstück vorherzusagen. Der computergestützte Neurowissenschaftler Blake Richards hat ein KI-System entwickelt, das das visuelle Netzwerk im lebenden Gehirn nachahmt. Richards und sein Team haben ein autonomes System entwickelt. Überwachte Modelle schlagen eine Antwort vor. Sie trainierten eine künstliche Intelligenz, die zwei verschiedene neuronale Netze kombinierte. Die erste, sogenannte ResNet-Architektur, ist für die Verarbeitung von Bildern konzipiert; die zweite, sogenannte Recurrent Network, kann die vorherige Eingabesequenz verfolgen und Vorhersagen über die nächste erwartete Eingabe treffen. Um die gemeinsame KI zu trainieren, beginnt das Team mit einer Sequenz von Videos, beispielsweise 10 Frames, und lässt diese von ResNet einzeln verarbeiten. Dann sagt das rekurrente Netzwerk die latente Darstellung von Frame 11 voraus, anstatt einfach die vorherigen 10 Frames abzugleichen. Selbstüberwachte Lernalgorithmen vergleichen vorhergesagte Werte mit tatsächlichen Werten und weisen das neuronale Netzwerk an, seine Gewichte zu aktualisieren, um bessere Vorhersagen zu treffen. Um es weiter zu testen, zeigten die Forscher der KI eine Reihe von Videos, die Forscher am Allen Institute for Brain Science in Seattle zuvor Mäusen gezeigt hatten. Wie Primaten verfügen auch Mäuse über Gehirnregionen, die für statische Bilder und Bewegungen zuständig sind. Allen-Forscher zeichneten die neuronale Aktivität im visuellen Kortex von Mäusen auf, während die Mäuse Videos ansahen. Richards‘ Team fand Ähnlichkeiten in der Art und Weise, wie KI und lebende Gehirne auf Videos reagieren. Während des Trainings ähnelte ein Pfad im künstlichen neuronalen Netzwerk mehr dem ventralen Objekterkennungsbereich des Mausgehirns, während der andere Pfad dem dorsalen Bereich ähnlicher wurde, der sich auf Bewegung konzentriert. Diese Ergebnisse deuten darauf hin, dass unser Sehsystem über zwei spezialisierte Bahnen verfügt, da diese nicht ausreichen, um die Zukunft des Sehvermögens vorherzusagen. Modelle des menschlichen Hörsystems erzählen eine ähnliche Geschichte. Im Juni trainierte ein Team unter der Leitung von Jean-Rémi King, einem Forscher bei Meta AI, eine künstliche Intelligenz namens Wav2Vec 2.0, die ein neuronales Netzwerk verwendet, um Audio in latente Darstellungen umzuwandeln. Die Forscher maskierten einige dieser Darstellungen und speisten sie dann in eine andere Komponente des neuronalen Netzwerks ein, einen sogenannten Konverter. Während des Trainingsprozesses sagt der Konverter blockierte Informationen voraus. Dabei lernt die KI als Ganzes, Geräusche in zugrunde liegende Darstellungen umzuwandeln, wiederum ohne dass Labels erforderlich sind. Das Team nutzte etwa 600 Stunden Sprachdaten, um das Netzwerk zu trainieren. „Das ist ungefähr das, was ein Kind in den ersten zwei Jahren an Erfahrung bekommt“, sagte King. Jean-Rémy King von Meta AI hat dabei geholfen, eine künstliche Intelligenz zu trainieren, die Audio auf eine Weise verarbeitet, die das Gehirn nachahmt – unter anderem durch die Vorhersage, was als nächstes passieren sollte, sobald das System durch Spielen trainiert wurde Teile von Hörbüchern auf Englisch, Französisch und Mandarin und verglichen dann die Leistung der KI mit Daten von 412 Personen, die alle diese drei Sprachen Muttersprachler waren. Sie hörten sich denselben langen Audioclip an, während MRT-Scans ihr Gehirn abbildeten. Die Ergebnisse zeigen, dass die fMRT-Bilder zwar verrauscht sind und eine geringe Auflösung haben, das KI-Neuronale Netzwerk und das menschliche Gehirn jedoch „nicht nur miteinander, sondern auch auf systematische Weise zusammenhängen.“ Die Aktivität in den frühen Schichten der KI steht im Einklang mit der Aktivität im primären auditorischen Kortex, während die Aktivität in den tiefsten Schichten der KI mit der Aktivität in höheren Ebenen des Gehirns, wie dem präfrontalen Kortex, übereinstimmt. „ Das sind wunderschöne Daten, und obwohl sie nicht schlüssig sind, sind sie doch ein überzeugender Beweis dafür, dass es bei der Art und Weise, wie wir Sprache lernen, größtenteils darum geht, vorherzusagen, was wir als nächstes sagen werden.“ Natürlich sind nicht alle mit dieser Aussage einverstanden. Josh McDermott, ein Computerneurowissenschaftler am MIT, hat überwachtes und selbstüberwachtes Lernen genutzt, um Modelle des Sehens und Hörens zu untersuchen. Sein Labor entwickelte synthetische Audio- und visuelle Signale, die für Menschen nur schwer fassbares Rauschen wären. Für künstliche neuronale Netze scheinen diese Signale jedoch nicht von echter Sprache und Bildern zu unterscheiden zu sein. Dies zeigt, dass die tief in neuronalen Netzen gebildeten Darstellungen, selbst beim selbstüberwachten Lernen, nicht dieselben Darstellungen in unserem Gehirn sind. McDermott sagte: „Diese selbstüberwachten Lernmethoden stellen eine Verbesserung dar, da Sie Darstellungen lernen können, die viele Erkennungsverhaltensweisen unterstützen können, ohne dass alle Etiketten erforderlich sind. Es gibt jedoch immer noch viele Merkmale überwachter Modelle.“ Auch der Algorithmus selbst bedarf weiterer Verbesserungen. Beispielsweise sagt die KI im Wav2Vec 2.0-Modell von Meta AI die potenzielle Darstellung eines Tons nur für einige zehn Millisekunden voraus, was kürzer ist als die Zeit, die ein Mensch benötigt, um eine Lautsilbe auszusprechen, geschweige denn ein Wort vorherzusagen. Um KI-Modelle wirklich dem menschlichen Gehirn ähnlich zu machen, müssen wir noch viel tun, sagte Jin. Wenn die bisher entdeckten Parallelen zwischen dem Gehirn und Modellen des selbstüberwachten Lernens auch für andere sensorische Aufgaben zutreffen, wäre das ein umso stärkerer Hinweis darauf, dass ungeachtet der wundersamen Fähigkeiten unseres Gehirns irgendeine Form des selbstüberwachten Lernens erforderlich ist.

Bei diesem Ansatz kennzeichnen Menschen die Daten nicht, sagte Friedemann Zenke, ein computergestützter Neurowissenschaftler am Friedrich-Michel-Institut für biomedizinische Forschung in Basel, Schweiz. Stattdessen stammen die Etiketten aus den Daten selbst. Selbstüberwachte Algorithmen erzeugen im Wesentlichen Lücken in den Daten und fordern das neuronale Netzwerk auf, diese Lücken zu schließen.

Bei diesem Ansatz kennzeichnen Menschen die Daten nicht, sagte Friedemann Zenke, ein computergestützter Neurowissenschaftler am Friedrich-Michel-Institut für biomedizinische Forschung in Basel, Schweiz. Stattdessen stammen die Etiketten aus den Daten selbst. Selbstüberwachte Algorithmen erzeugen im Wesentlichen Lücken in den Daten und fordern das neuronale Netzwerk auf, diese Lücken zu schließen.

Einige Leute sind anderer Meinung: Simulieren das Gehirn? Die Modelle und Algorithmen sind weitaus schlimmer

Das obige ist der detaillierte Inhalt von90 % des menschlichen Gehirns sind selbstüberwachtes Lernen. Wie weit ist ein großes KI-Modell von der Simulation des Gehirns entfernt?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr