Heim >Technologie-Peripheriegeräte >KI >Aufruf zur Aussetzung der GPT-5-Forschung und -Entwicklung löst heftigen Kampf aus! Andrew Ng und LeCun übernahmen die Führung in der Opposition, während Bengio zur Unterstützung auftrat

Aufruf zur Aussetzung der GPT-5-Forschung und -Entwicklung löst heftigen Kampf aus! Andrew Ng und LeCun übernahmen die Führung in der Opposition, während Bengio zur Unterstützung auftrat

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 20:29:021190Durchsuche

Gestern explodierte wie eine Bombe im Internet im In- und Ausland.

Nach einem Tag voller Streit kamen mehrere Schlüsselfiguren und andere große Namen heraus, um öffentlich zu antworten.

Manche sind sehr offiziell, manche sehr persönlich und manche gehen nicht direkt auf das Problem ein. Aber eines ist sicher: Sowohl die Ansichten dieser großen Jungs als auch die Interessengruppen, die sie vertreten, verdienen eine sorgfältige Prüfung.

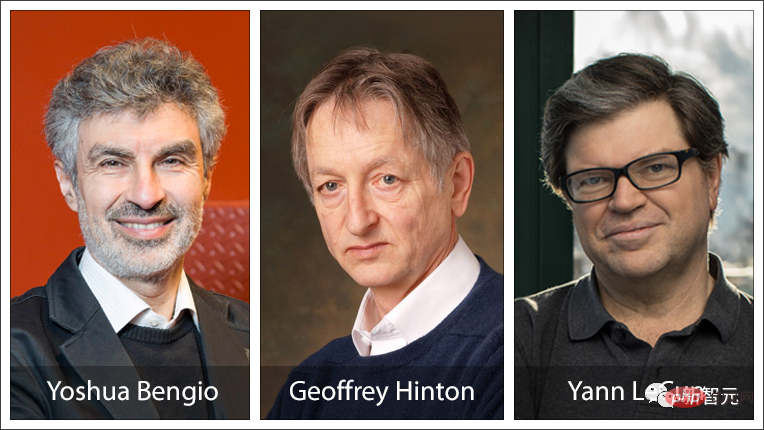

Interessant ist, dass unter den Turing Big Three einer die Führung bei der Unterzeichnung übernahm, einer entschieden dagegen war und einer kein Wort sagte.

Bengios Unterschrift, Hintons Schweigen, LeCuns Opposition

Enda Ng (Opposition)

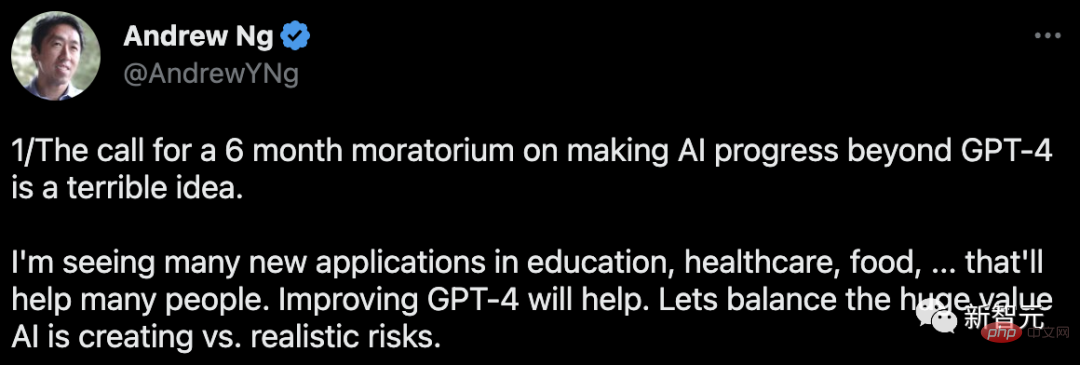

In diesem Vorfall hat Andrew Ng, ein ehemaliges Mitglied von Google Brain und Gründer der Online-Bildungsplattform Coursera, ist eine klare Opposition.

Er hat seine Haltung klar zum Ausdruck gebracht: Es ist eine schreckliche Idee, „KI-Fortschritte über GPT-4 hinaus zu machen“ für 6 Monate auszusetzen.

Er sagte, dass er viele neue KI-Anwendungen in Bildung, Gesundheitswesen, Ernährung und anderen Bereichen gesehen habe und viele Menschen davon profitieren würden. Und auch eine Verbesserung von GPT-4 wäre von Vorteil.

Was wir tun sollten, ist, ein Gleichgewicht zwischen dem enormen Wert, der durch KI geschaffen wird, und den tatsächlichen Risiken zu finden.

Zu dem, was in dem gemeinsamen Brief erwähnt wurde: „Wenn die Ausbildung supermächtiger KI nicht schnell eingestellt werden kann, sollte die Regierung ebenfalls einbezogen werden, dass diese Idee schrecklich ist.“

Er sagte, dass die Aufforderung an die Regierung, aufkommende Technologien, die sie nicht versteht, auszusetzen, wettbewerbswidrig sei, einen schlechten Präzedenzfall schaffe und eine schreckliche politische Innovation sei.

Er gab zu, dass verantwortungsvolle KI wichtig ist und dass KI Risiken birgt.

Aber die mediale Darstellung von „KI-Unternehmen veröffentlichen hektisch gefährliche Codes“ ist offensichtlich zu übertrieben. Die überwiegende Mehrheit der KI-Teams legt großen Wert auf verantwortungsvolle KI und Sicherheit. Aber er gab auch zu, dass „leider nicht alle“ seien.

Abschließend betonte er noch einmal:

Eine 6-monatige Sperrfrist ist kein praktischer Vorschlag. Um die Sicherheit der KI zu verbessern, werden Vorschriften zu Transparenz und Prüfung praktischer und haben eine größere Wirkung. Wenn wir die Technologie vorantreiben, sollten wir auch mehr in die Sicherheit investieren, anstatt den Fortschritt zu ersticken.

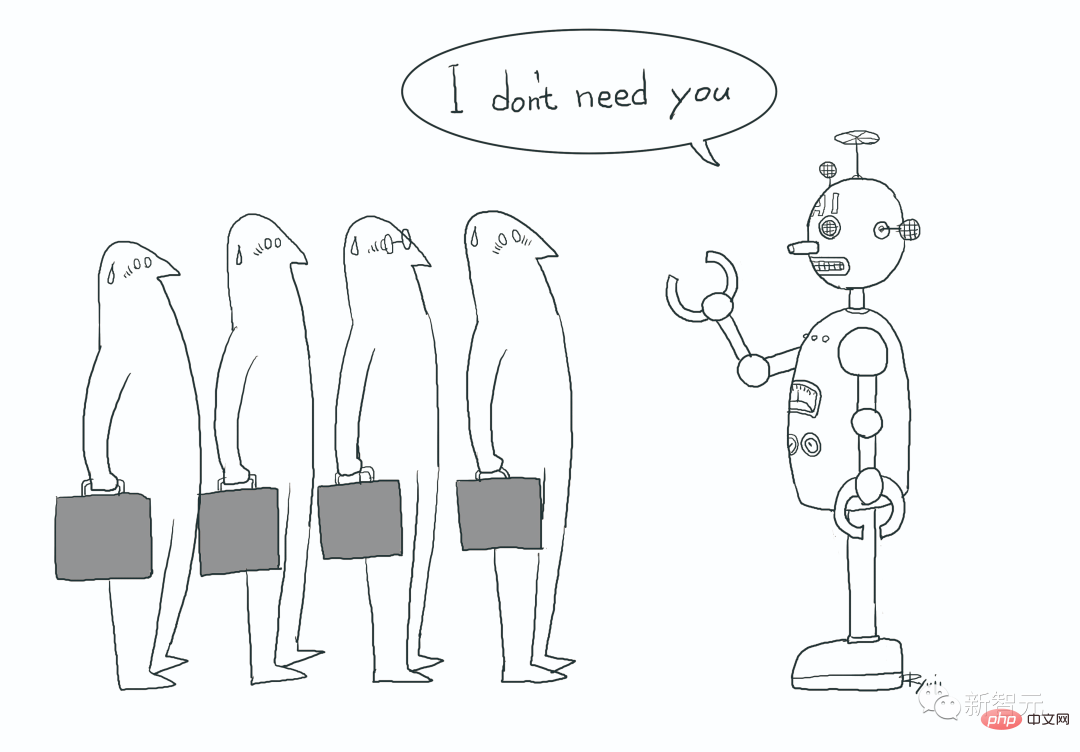

Unter seinem Twitter haben Internetnutzer bereits heftigen Widerstand geäußert: Der Grund, warum die Chefs ruhig sind, liegt wahrscheinlich darin, dass der Schmerz der Arbeitslosigkeit sie nicht treffen wird.

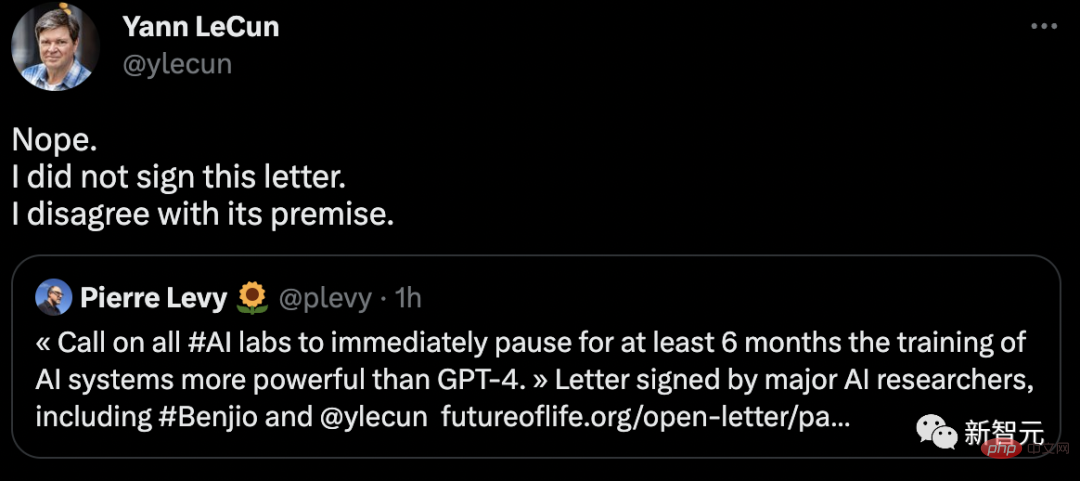

LeCun (Opposition)

Sobald der gemeinsame Brief verschickt wurde, beeilten sich Internetnutzer, ihnen zu sagen: Die Turing-Award-Giganten Bengio und LeCun haben beide den Brief unterschrieben!

LeCun, der immer an vorderster Front im Internet surft, widerlegte die Gerüchte sofort: Nein, ich habe nicht unterschrieben und bin mit der Prämisse dieses Briefes nicht einverstanden.

Einige Internetnutzer sagten, dass ich mit diesem Brief auch nicht einverstanden bin, aber ich bin sehr neugierig: Der Grund, warum Sie mit diesem Brief nicht einverstanden sind, ist, dass Sie das Gefühl haben, dass LLM nicht weit genug fortgeschritten ist und die Menschheit überhaupt nicht bedrohen kann, oder Hat das andere Gründe?

Aber LeCun beantwortete keine dieser Fragen.

Nach 20 Stunden mysteriöser Stille leitete LeCun plötzlich den Tweet eines Internetnutzers weiter:

# 🎜🎜# „OpenAI wartete 6 Monate vor der Veröffentlichung von GPT4! Sie haben sogar ein Whitepaper dafür geschrieben ...“ „Forschung und Entwicklung“ ist nichts anderes als „geheime Forschung und Entwicklung“, was genau das Gegenteil von dem ist, was manche Unterzeichner wollen.

Es scheint, dass nichts vor LeCuns anspruchsvollen Augen verborgen bleiben kann.

Der Internetnutzer, der zuvor gefragt hat, stimmte ebenfalls zu: Deshalb lehne ich diese Petition ab – kein „Bösewicht“ wird wirklich aufhören.

„Das ist also wie ein Waffenvertrag, an den sich niemand hält? Gibt es in der Geschichte nicht viele Beispiele dafür?“ 🎜 🎜#Nach einer Weile retweetete er den Tweet eines weiteren Big Shots.

Der Chef sagte: „Ich habe es auch nicht unterschrieben. Dieser Brief ist voller schrecklicher Rhetorik und ungültiger/nicht vorhandener Richtlinienvorschriften.“ sagte: „Ich stimme zu“.

Bengio und Marcus (ja)

Der erste große Unterzeichner des offenen Briefes Er ist der berühmte Turing-Preisträger Yoshua Bengio.

Natürlich stimmte auch Professor Marcus von der New York University dafür. Er scheint der Erste zu sein, der diesen offenen Brief enthüllt.

Nachdem die Diskussion lauter wurde, postete er auch schnell einen Blog, um seine Position zu erklären, die immer noch voller war Höhepunkte.

Breaking News: Der Brief, den ich zuvor erwähnt habe, ist jetzt öffentlich. Der Brief fordert ein sechsmonatiges Moratorium für das Training von KI, die „leistungsstärker als GPT-4“ ist. Viele berühmte Leute haben es unterzeichnet. Ich bin auch beigetreten. Ich war nicht am Entwurf beteiligt, weil es noch andere Dinge gibt, über die man sich Sorgen machen muss (z. B. leistungsfähigere KI als GPT-4, welche KI genau? Seit der Architektur oder dem Trainingssatz von GPT-4. Die Details sind noch nicht veröffentlicht worden, woher sollen wir das wissen? ) – aber der Geist des Briefes ist einer, den ich unterstütze: Bis wir die Risiken und Vorteile besser bewältigen können, sollten wir mit Vorsicht vorgehen.

Ich war nicht am Entwurf beteiligt, weil es noch andere Dinge gibt, über die man sich Sorgen machen muss (z. B. leistungsfähigere KI als GPT-4, welche KI genau? Seit der Architektur oder dem Trainingssatz von GPT-4. Die Details sind noch nicht veröffentlicht worden, woher sollen wir das wissen? ) – aber der Geist des Briefes ist einer, den ich unterstütze: Bis wir die Risiken und Vorteile besser bewältigen können, sollten wir mit Vorsicht vorgehen.

Es wird interessant sein zu sehen, was als nächstes passiert.

Und ein anderer Standpunkt, mit dem Marcus gerade 100% einverstanden war, ist auch sehr interessant. Dieser Standpunkt sagt:#🎜 🎜# GPT-5 wird kein AGI sein. Es ist fast sicher, dass kein GPT-Modell AGI wäre. Es ist völlig unmöglich, dass ein Modell, das mit den heute verwendeten Methoden (Gradientenabstieg) optimiert wurde, AGI ist. Das kommende GPT-Modell wird definitiv die Welt verändern, aber es zu übertreiben ist verrückt.

Altman (unverbindlich)Bisher hat Sam Altman zu diesem offenen Brief keine klare Position bezogen.

Allerdings äußerte er einige Ansichten zur allgemeinen künstlichen Intelligenz.

Was eine gute allgemeine künstliche Intelligenz ausmacht:1. Richten Sie die technischen Fähigkeiten der Superintelligenz aus

2. Die meisten führen die vollständige Koordination zwischen AGI-Arbeit3. Ein wirksamer globaler Regulierungsrahmen

Einige Internetnutzer fragten: „Auf was abgestimmt? Auf wen abgestimmt? Auf abgestimmt? Auf einige Leute abgestimmt bedeutet.“ Fehleinschätzung mit anderen.

Greg Brockman, ein weiterer Gründer von OpenAI, retweetete Altmans Tweet und betonte erneut, dass die Mission von OpenAI darin besteht, „sicherzustellen, dass AGI der gesamten Menschheit zugute kommt.“

Ein Internetnutzer wies erneut auf Folgendes hin Punkte: Ihr redet den ganzen Tag davon, „sich an der Absicht des Designers auszurichten“, aber ansonsten weiß niemand, was Ausrichtung eigentlich bedeutet.

Yudkowsky (Radikal)

Es gibt auch einen Entscheidungstheoretiker namens Eliezer Yudkowsky, der eine radikalere Haltung vertritt:

Es reicht nicht aus, die KI-Entwicklung auszusetzen, wir müssen die gesamte KI abschalten! Alles geschlossen!

Wenn das so weitergeht, wird jeder von uns sterben.

Sobald der offene Brief veröffentlicht wurde, schrieb Yudkowsky sofort einen langen Artikel und veröffentlichte ihn im TIME-Magazin.

Er sagte, dass er nicht unterschrieben habe, weil seiner Meinung nach der Brief zu mild gewesen sei.

Dieser Brief unterschätzt den Ernst der Lage und fordert, dass zu wenige Probleme gelöst werden.

Er sagte, dass das Schlüsselproblem nicht die Intelligenz des „Wettbewerbs mit Menschen“ sei. Wenn KI intelligenter als Menschen wird, ist dieser Schritt offensichtlich.

Der Punkt ist, dass viele Forscher, darunter auch er, glauben, dass die wahrscheinlichste Konsequenz des Aufbaus einer KI mit übermenschlicher Intelligenz darin besteht, dass jeder auf dem Planeten sterben wird.

ist nicht „vielleicht“, sondern „wird auf jeden Fall“.

Wenn die Genauigkeit nicht ausreicht, ist das wahrscheinlichste Ergebnis, dass die von uns erstellte KI weder das tut, was wir wollen, noch sich um uns oder andere Lebewesen kümmert.

Theoretisch sollten wir der KI beibringen können, diese Art der Pflege zu erlernen, aber im Moment wissen wir nicht wie.

Wenn es keine solche Fürsorge gibt, ist das Ergebnis: KI liebt dich nicht und hasst dich auch nicht. Du bist nur ein Haufen atomarer Materialien, mit denen man alles machen kann.

Und wenn Menschen der übermenschlichen KI widerstehen wollen, werden sie unweigerlich scheitern, genau wie „das 11. Jahrhundert versuchte, das 21. Jahrhundert zu besiegen“ oder „Australopithecus versuchte, Homo sapiens zu besiegen“.

Yudkowsky sagte, dass die KI, von der wir uns vorstellen, dass sie schlechte Dinge tut, ein Denker ist, der im Internet lebt und jeden Tag bösartige E-Mails an Menschen sendet, aber tatsächlich könnte es sich um eine feindselige übermenschliche KI handeln, eine Denkgeschwindigkeitszahl Aus der Perspektive einer außerirdischen Zivilisation, die eine Million Mal größer ist als der Mensch, sind Menschen dumm und langsam.

Wenn diese KI intelligent genug ist, bleibt sie nicht einfach im Computer. Es kann die DNA-Sequenz per E-Mail an das Labor senden, und das Labor wird das Protein bei Bedarf produzieren, und dann wird die KI eine Lebensform haben. Dann werden alle Lebewesen auf der Erde sterben.

Wie soll der Mensch in dieser Situation überleben? Im Moment haben wir keine Pläne.

OpenAI ist nur ein öffentlicher Aufruf für die Ausrichtung, die die zukünftige KI braucht. Und DeepMind, ein weiteres führendes KI-Labor, hat überhaupt keine Pläne.

Aus dem offiziellen Blog von OpenAI

Diese Gefahren bestehen unabhängig davon, ob die KI bei Bewusstsein ist oder nicht. Sein leistungsstarkes kognitives System kann hart arbeiten, um Standardausgaben zu optimieren und zu berechnen, die komplexe Ergebnisse erfüllen.

Tatsächlich imitiert die aktuelle KI möglicherweise einfach die Selbstwahrnehmung aus Trainingsdaten. Tatsächlich wissen wir jedoch nur sehr wenig über die interne Struktur dieser Systeme.

Wenn wir GPT-4 immer noch nicht kennen und GPT-5 erstaunliche Fähigkeiten entwickelt hat, genau wie von GPT-3 zu GPT-4, dann ist es für uns schwierig zu wissen, was die Menschen es geschaffen haben . GPT-5 oder AI selbst.

Am 7. Februar brüstete sich Microsoft-Chef Nadella öffentlich damit, dass das neue Bing Google gezwungen habe, „herauszukommen und einen kleinen Tanz aufzuführen“.

Sein Verhalten ist sehr irrational.

Wir hätten vor 30 Jahren über dieses Thema nachdenken sollen, um die Lücke zu schließen.

Es ist mehr als 60 Jahre her, seit das Konzept der KI vorgeschlagen wurde. Wir sollten mindestens 30 Jahre damit verbringen, sicherzustellen, dass übermenschliche KI „niemanden tötet“.

Wir können einfach nicht aus unseren Fehlern lernen, denn wenn man einmal falsch liegt, ist man tot.

Wenn eine 6-monatige Pause es der Erde ermöglichen würde, zu überleben, würde ich zustimmen, aber das wird nicht der Fall sein.

Was wir tun müssen, ist Folgendes:

1 Das Training neuer großer Sprachmodelle muss nicht nur auf unbestimmte Zeit ausgesetzt, sondern auch auf globaler Ebene umgesetzt werden.

Und es kann keine Ausnahmen geben, auch nicht die Regierung oder das Militär.

2. Schalten Sie alle großen GPU-Cluster ab, bei denen es sich um die großen Rechenanlagen handelt, die zum Trainieren der leistungsstärksten KI verwendet werden.

Pausieren Sie alle Modelle, die groß angelegte KI trainieren, legen Sie eine Obergrenze für die Rechenleistung fest, die jeder beim Training von KI-Systemen verbraucht, und senken Sie diese Obergrenze in den nächsten Jahren schrittweise, um effizientere Trainingsalgorithmen zu kompensieren.

Regierungen und Militärs bilden da keine Ausnahme und haben sofort multinationale Abkommen geschlossen, um zu verhindern, dass verbotenes Verhalten anderswo übertragen wird.

Verfolgen Sie alle verkauften GPUs. Wenn bekannt wird, dass GPU-Cluster in Ländern außerhalb des Abkommens gebaut werden, sollte das betroffene Rechenzentrum durch Luftangriffe zerstört werden.

Wir sollten uns mehr Sorgen über die Verletzung des Moratoriums als über den bewaffneten Konflikt zwischen Ländern machen. Betrachten Sie nichts als einen Konflikt nationaler Interessen und seien Sie sich darüber im Klaren, dass jeder, der von einem Wettrüsten spricht, ein Dummkopf ist.

In dieser Hinsicht leben wir alle entweder zusammen oder sterben zusammen, das ist keine Politik, sondern eine Tatsache der Natur.

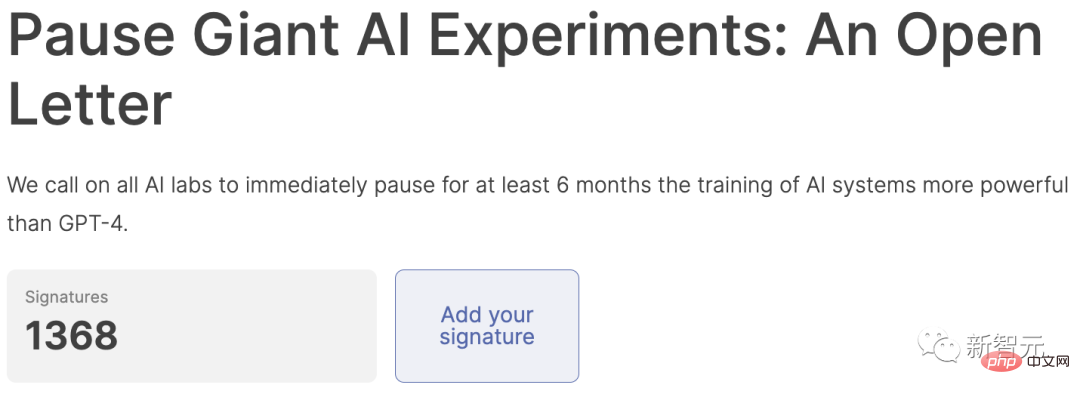

Abstimmen

Aufgrund der überwältigenden Anzahl an Unterschriften hat das Team beschlossen, die Anzeige zunächst zu pausieren, damit die Rezension nachgeholt werden kann. (Die Unterschriften oben in der Liste sind alle direkt verifiziert)

Das obige ist der detaillierte Inhalt vonAufruf zur Aussetzung der GPT-5-Forschung und -Entwicklung löst heftigen Kampf aus! Andrew Ng und LeCun übernahmen die Führung in der Opposition, während Bengio zur Unterstützung auftrat. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr