Heim >Technologie-Peripheriegeräte >KI >Die Methodik zur Industrialisierung großer Modelle ist vollständig in der GPU verborgen

Die Methodik zur Industrialisierung großer Modelle ist vollständig in der GPU verborgen

- 王林nach vorne

- 2023-04-11 20:04:071338Durchsuche

Einführung

Im Zeitalter der Datenintelligenz ist Computing sowohl eine Notwendigkeit als auch ein Schmerzpunkt. Das wichtigste Merkmal ist ein Wort – groß.

Unterteilen Sie „groß“ in drei Merkmale, darunter:

- Große Datenmengen

- Berechnen serieller Abhängigkeiten

- Komplexe Berechnung Hoher Sex

Dazu gehört die Komplexität von Daten und Algorithmen, und Daten, Algorithmen und Rechenleistung sind die drei Elemente des intelligenten Zeitalters. Die Komplexität der ersten beiden wird letztendlich von der Rechenleistung getragen.

Dies hat dazu geführt, dass der Bedarf der Branche an Rechenleistung sowohl räumlich als auch zeitlich rapide angestiegen ist, wie ein Tsunami.

GPU hat eine Möglichkeit, den Tsunami in Tausende von Rinnsalen im Raum zu unterteilen, den Weg des Wassers zeitlich zu verkürzen, die Wegzweige in der Struktur zu rationalisieren und große Aufgaben in kleine zu zerlegen. Die Aufgabe trägt Bewältigt den enormen Bedarf an Rechenleistung mühelos und wird zur Grundlage der Rechenleistung im intelligenten Zeitalter.

Als Reaktion auf die oben genannten drei Merkmale verwendet die GPU drei Methoden: Parallelität, Fusion und Vereinfachung, um auf Bedienerebene basierend auf Durchsatz, Videospeicher und anderen Indikatoren zu beschleunigen.

Die Hauptmethode der GPU-Beschleunigung eignet sich auch für die Industrialisierung großer Modelle.

Mit der Verbesserung und dem Fortschritt der zugrunde liegenden Chips, Rechenleistung, Daten und anderen Infrastrukturen bewegt sich die globale KI-Industrie schrittweise von der Computerintelligenz zur Wahrnehmungsintelligenz und zur kognitiven Intelligenz und bildet entsprechend einen „Chip, Rechenleistungseinrichtungen“. , KI-Framework“ & Algorithmusmodell, Anwendungsszenario“ industrielles Arbeitsteilungs- und Kollaborationssystem. Seit 2019 haben große KI-Modelle die Fähigkeit zur Verallgemeinerung von Problemlösungen erheblich verbessert, und „große Modelle + kleine Modelle“ haben sich nach und nach zum Mainstream-Technologieweg in der Branche entwickelt und die allgemeine Beschleunigung der Entwicklung der globalen KI-Branche vorangetrieben.

Vor nicht allzu langer Zeit veranstaltete DataFun eine Austauschveranstaltung zum Thema „AI Large Model Technology Roadmap and Industrialization Implementation Practice“. Sechs Experten von NVIDIA, Baidu, ByteDance Volcano Translation, Tencent WeChat usw. teilten ihre Ansichten zur Modelltrainingstechnologie und Inferenz Lösungen und vielfältige Anwendungen der maschinellen Sprachübersetzung, die Entwicklung und Implementierung groß angelegter Sprachmodelle usw. bringen einen spannenden Austausch von KI-Technologierouten für große Modelle und Implementierungspraktiken für die Industrialisierung mit sich.

Als sie große Modelle in der Branche implementierten, übernahmen sie größtenteils Methoden der Parallelität, Fusion und Vereinfachung und erweiterten sie auch von der Trainings- und Inferenzebene auf die Ebene der Algorithmusmodellierung.

1. Parallel

Die Parallelmethode ist eine Methode zum Austausch von Raum gegen Zeit, die den Tsunami in Rinnsale unterteilt. Insbesondere bei Berechnungen mit großen Datenmengen dauert jeder Berechnungsschritt relativ lange. Die GPU nutzt paralleles Rechnen, das heißt, Daten ohne Rechenabhängigkeit werden so weit wie möglich parallelisiert und große Stapel werden in kleine Stapel aufgeteilt, um die GPU-Leerlaufzeit für jeden Berechnungsschritt zu verkürzen und den Rechendurchsatz zu verbessern.

Um das Training großer Modelle tatsächlich abzuschließen, ist ein hocheffizientes Software-Framework erforderlich, um das Training auf einer einzelnen GPU, einem einzelnen Knoten oder sogar auf einem großen Cluster hoch recheneffizient zu gestalten.

Daher hat NVIDIA das Megatron-Trainingsframework entwickelt.

Megatron verwendet Optimierungsmethoden wie Modellparallelität und Sequenzparallelität, um große Transformer-Modelle effizient zu trainieren, und kann Modelle mit Billionen von Parametern trainieren.

Auf der Ebene der Algorithmusmodellierung untersuchten Huoshan Translation und Baidu hauptsächlich Modellierungsmethoden wie MoE-Modelle.

1. Modellparallelität

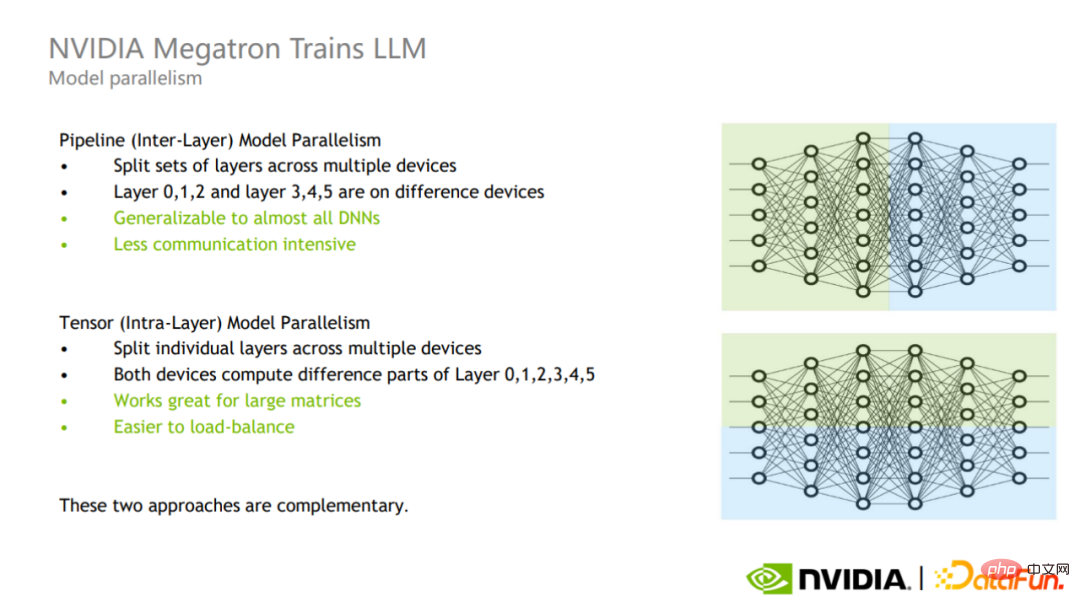

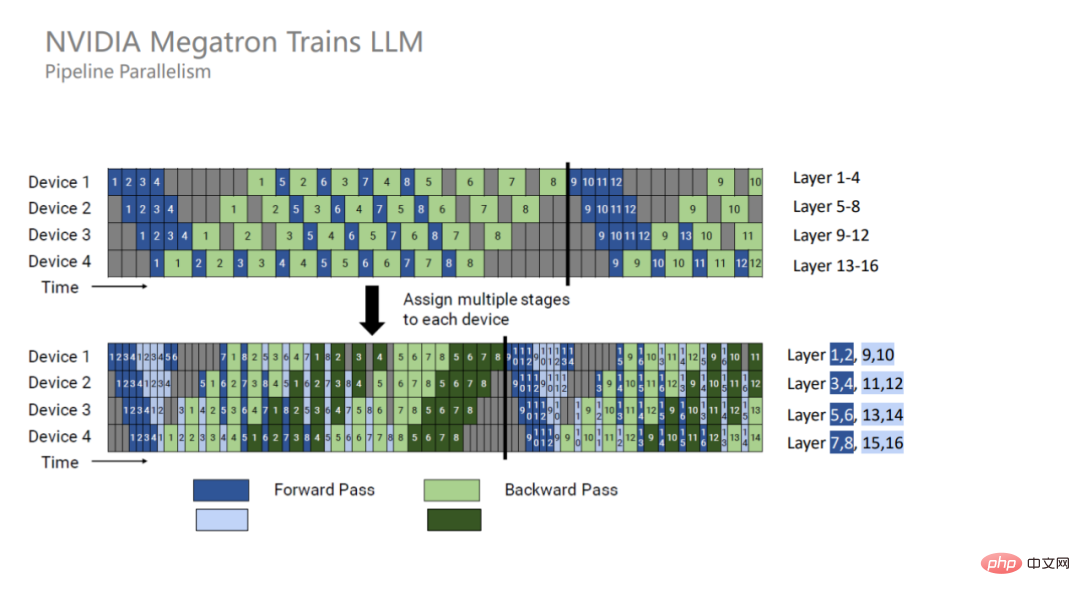

Modellparallelität kann in Pipeline-Parallelität und Tensor-Parallelität unterteilt werden.

Pipeline-Parallelität ist Parallelität zwischen Schichten (oberer Teil des Bildes), die verschiedene Schichten zur Berechnung in verschiedene GPUs aufteilt. Die Kommunikation in diesem Modus findet nur an der Grenze der Schicht statt, und die Anzahl der Kommunikationen und die Menge der Kommunikationsdaten sind gering, es entsteht jedoch eine zusätzliche Wartezeit für den GPU-Speicherplatz.

Tensorparallelität ist Intra-Layer-Parallelität (unterer Teil des Bildes), die die Berechnung einer Schicht auf verschiedene GPUs aufteilt. Dieser Modus ist einfacher zu implementieren, hat bessere Auswirkungen auf große Matrizen und kann einen besseren Lastausgleich zwischen GPUs erreichen, aber die Anzahl der Kommunikationen und die Datenmenge sind relativ groß.

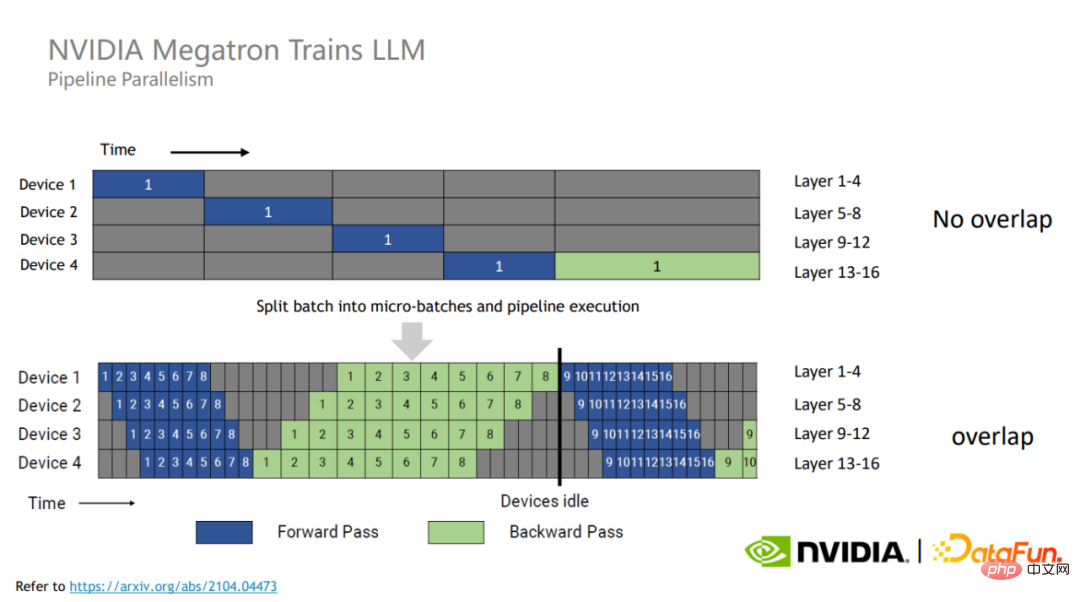

Um die GPU-Ressourcen voll auszunutzen, teilt Megatron jeden Trainingsbatch in kleinere Mikrobatches auf.

Da zwischen verschiedenen Mikrobatches keine Datenabhängigkeit besteht, können sie sich gegenseitig die Wartezeit überbrücken, wodurch die GPU-Auslastung und damit die gesamte Trainingsleistung verbessert werden.

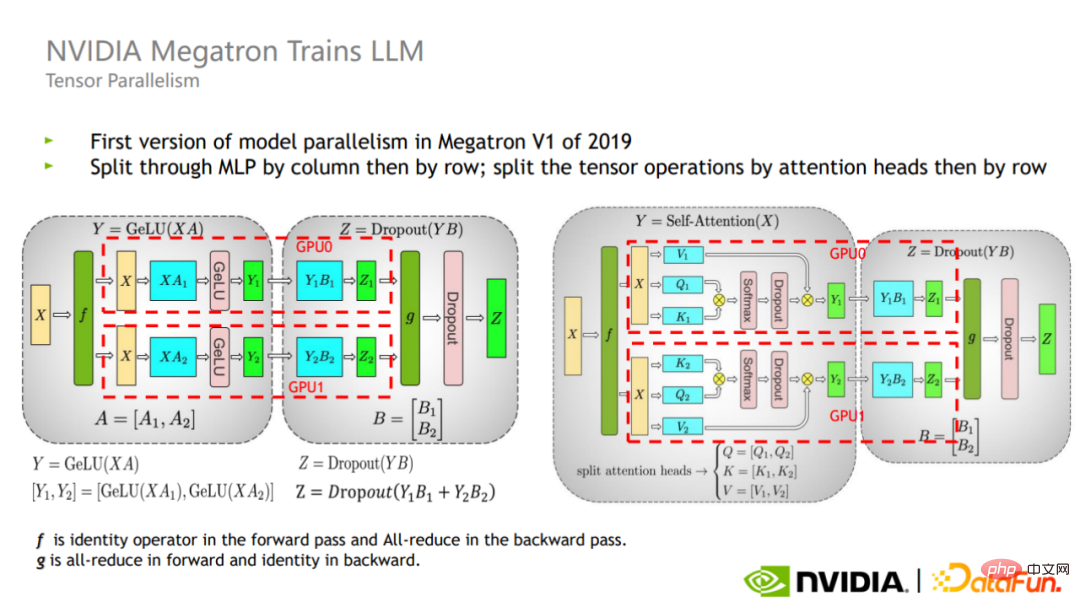

Tensor teilt die Berechnung jedes Operators parallel auf verschiedene GPUs auf. Für eine Matrixebene gibt es zwei Methoden: Cross-Cutting und Vertical Cutting.

Wie in der Abbildung gezeigt, führt Megatron diese beiden Segmentierungsmethoden in den Aufmerksamkeits- und MLP-Teilen des Transformer-Blocks ein.

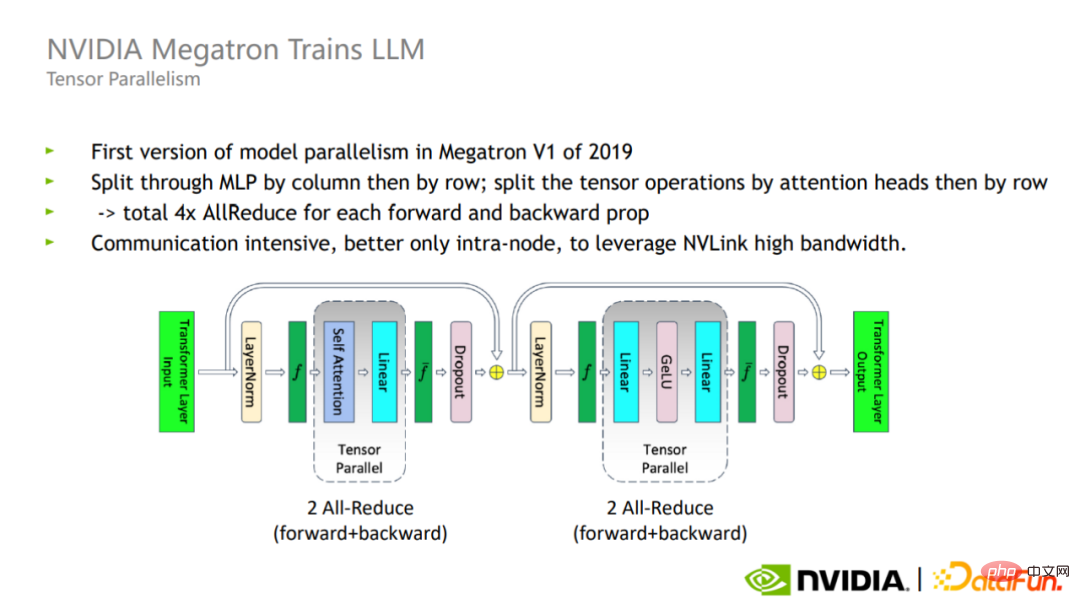

Im Tensor-Parallelmodus erfordern die Vorwärts- und Rückwärtsschritte jeder Transformer-Schicht insgesamt vier All-Reduction-Kommunikationen. Aufgrund des großen Umfangs der All-Reduction-Kommunikation eignet sich die Tensor-Parallelität besser für eine einzelne Karte. Für den internen Gebrauch.

Durch die Kombination von Pipeline-Parallelität und Tensor-Parallelität kann Megatron das Training eines Modells mit 170 Milliarden Parametern auf 32 GPUs auf das Training eines Modells mit einer Skala von 1 Billion Parametern auf 3072 GPUs skalieren.

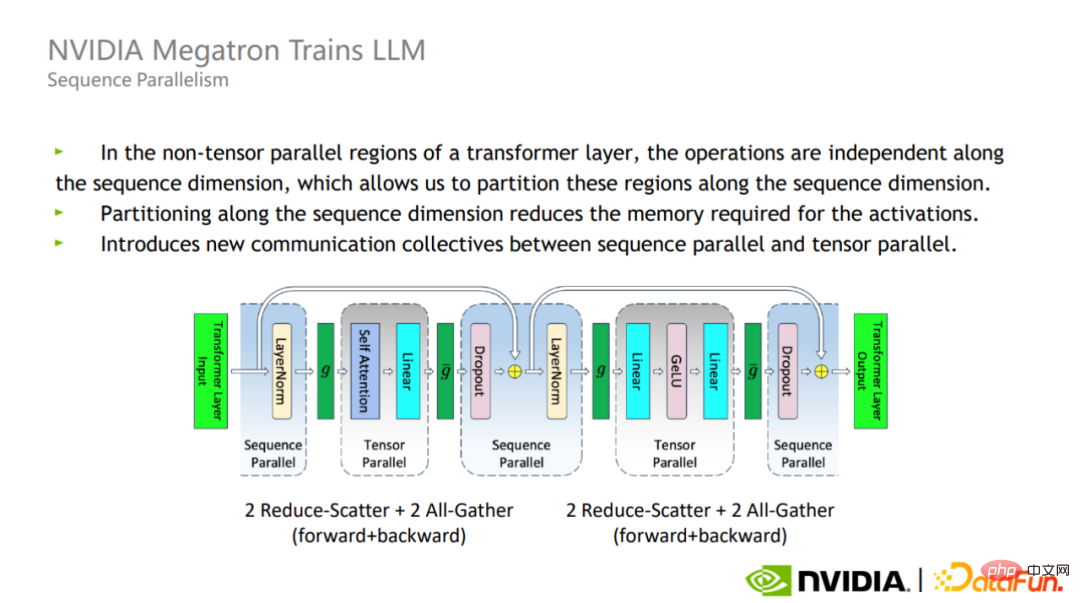

2. Sequenzparallelität

Tensorparallelität trennt Layer-Norm und Dropout tatsächlich nicht, daher werden diese beiden Operatoren zwischen den einzelnen GPUs kopiert.

Diese Vorgänge selbst erfordern jedoch nicht viele Berechnungen, belegen jedoch viel aktiven Videospeicher.

Zu diesem Zweck hat Megatron eine Methode zur sequenzparallelen Optimierung vorgeschlagen. Der Vorteil der Sequenzparallelität besteht darin, dass sie das Kommunikationsvolumen nicht erhöht und die Speichernutzung erheblich reduzieren kann. Da Layer-Norm und Dropout entlang der Sequenzdimension unabhängig sind, können sie entsprechend der Sequenzdimension aufgeteilt werden.

Nach der Verwendung der Sequenzparallelität ist der Speicherverbrauch bei sehr großen Modellen immer noch sehr groß. Aus diesem Grund hat Megatron die Technologie zur Neuberechnung der Aktivierung eingeführt.

Megatrons Ansatz besteht darin, einige Operatoren zu finden, die wenig Berechnung erfordern, aber viel Videospeicher belegen, wie z. B. Softmax, Dropout und andere Operatoren. Durch die Aktivierung und Neuberechnung dieser Operatoren kann der Videospeicher und der Rechenaufwand erheblich reduziert werden Zunahme.

Die Kombination aus Sequenzparallelität und selektiver Aktivierungsneuberechnung kann die Videospeichernutzung auf etwa 1/5 des Originals reduzieren. Im Vergleich zur ursprünglichen Lösung, bei der alle Aktivierungen direkt neu berechnet werden, ist der Videospeicher nur doppelt so groß und der Rechenaufwand wird erheblich reduziert. Mit zunehmender Modellskala nimmt der Anteil des Rechenaufwands allmählich ab. Wenn das Modell im Billionenmaßstab erreicht ist, machen die Kosten für die Neuberechnung nur noch etwa 2 % der Gesamtkosten aus.

3. Algorithmusparallelität

Das MoE-Modell hat aufgrund seines einfachen Designkonzepts und seiner starken Skalierbarkeit immer mehr Aufmerksamkeit in der Branche erhalten.

Das MoE-Modell schlägt die Designidee vor, ein großes Modell in mehrere kleine Modelle aufzuteilen. Für jede Probe muss nur ein Teil des Expertenmodells zur Berechnung aktiviert werden, wodurch Rechenressourcen erheblich gespart werden.

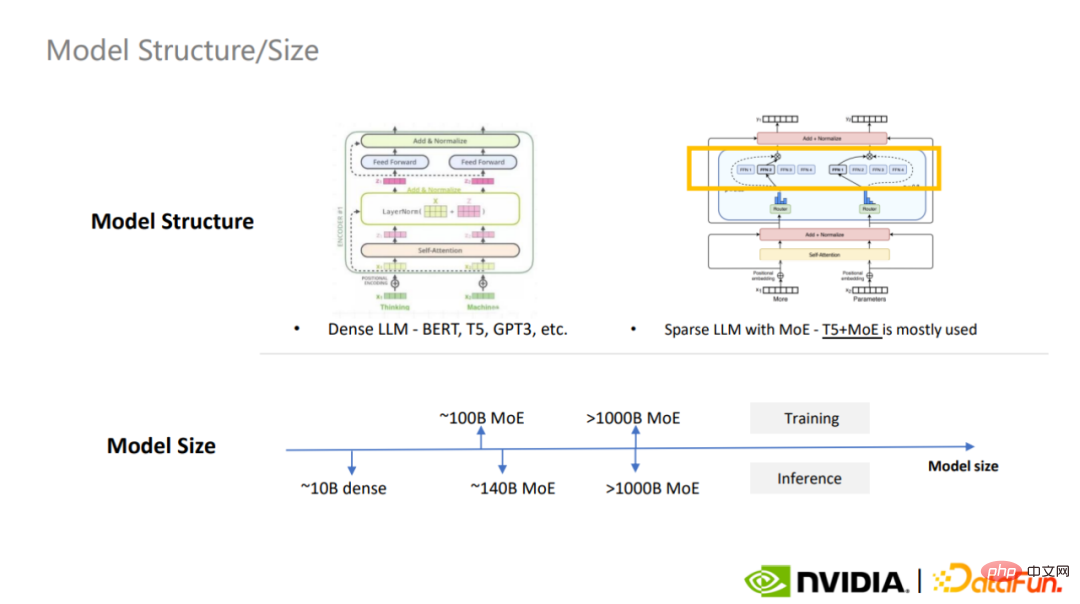

Die derzeit am häufigsten verwendeten dichten Großmodelle sind BERT, T5 und GPT-3, und das am häufigsten verwendete Sparse-MoE-Modell ist T5+MoE. MoE entwickelt sich zu einem Trend im Großmodellbau.

Man kann sagen, dass MoE die Idee des Parallelrechnens auf der Ebene der Algorithmusmodellierung kombiniert.

Die Vielseitigkeit großer Modelle spiegelt sich in vielen Aspekten wider, die wir bereits kennen, wie z. B. einer schwächeren induktiven Vorspannung des Aufmerksamkeitsmechanismus, einer großen Modellkapazität, großen Modelldaten usw Kann auch in Aufgaben zur Optimierung der Modellierungsmethode verwendet werden. MoE ist ein typischer Vertreter.

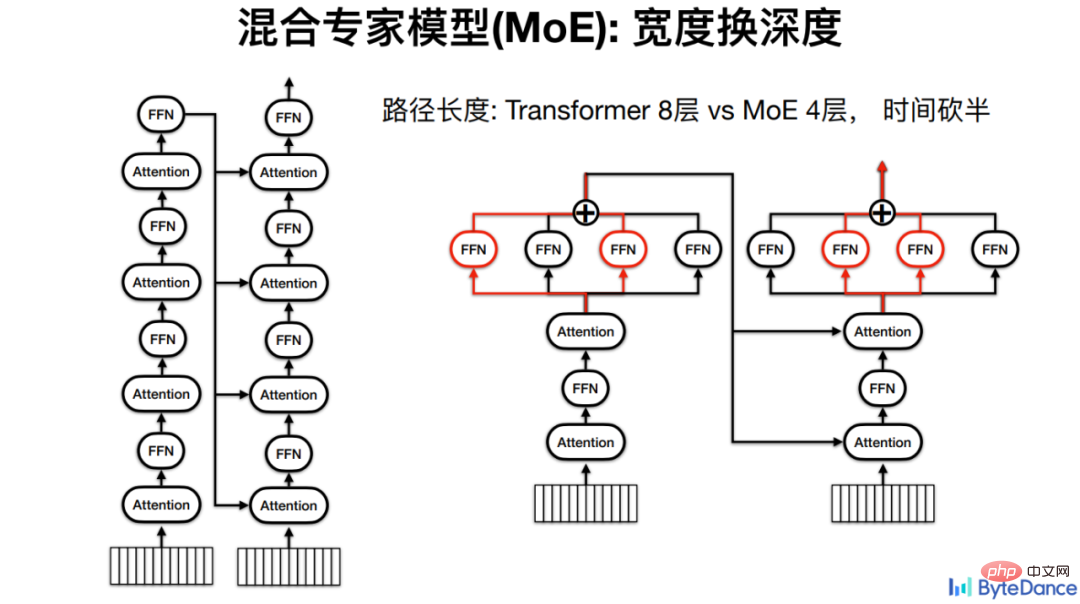

Bei der Vulkanübersetzung besteht die Grundidee von MoE darin, Breite gegen Tiefe auszutauschen, denn je tiefer das Modell, desto mehr Rechenschichten und desto länger die Inferenzzeit.

Zum Beispiel muss für ein Transformer-Modell mit 4 Encoder- und 4 Decoder-Ebenen jede Berechnung die Berechnung aller 8 FFNs durchlaufen. Wenn es sich um ein gemischtes Expertenmodell handelt, kann das FFN parallel platziert werden, was letztendlich den Berechnungspfad und damit die Inferenzzeit halbiert.

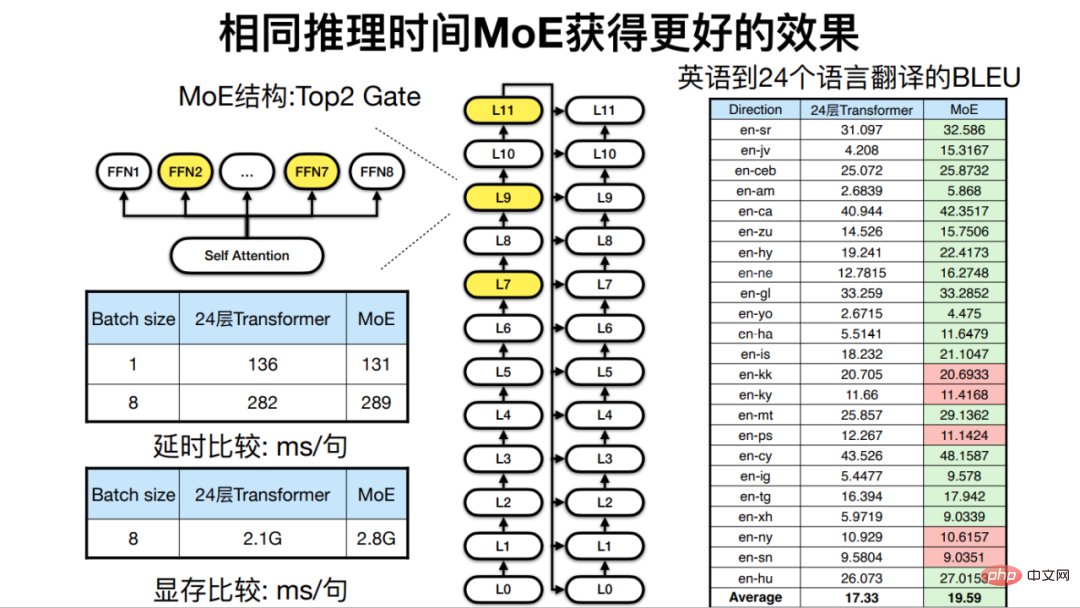

Unter der gleichen Inferenzzeit, das heißt, wenn die Modelltiefe ähnlich ist, da MoE die Modellbreite erhöhen kann, wird auch der Endeffekt der maschinellen Übersetzung verbessert.

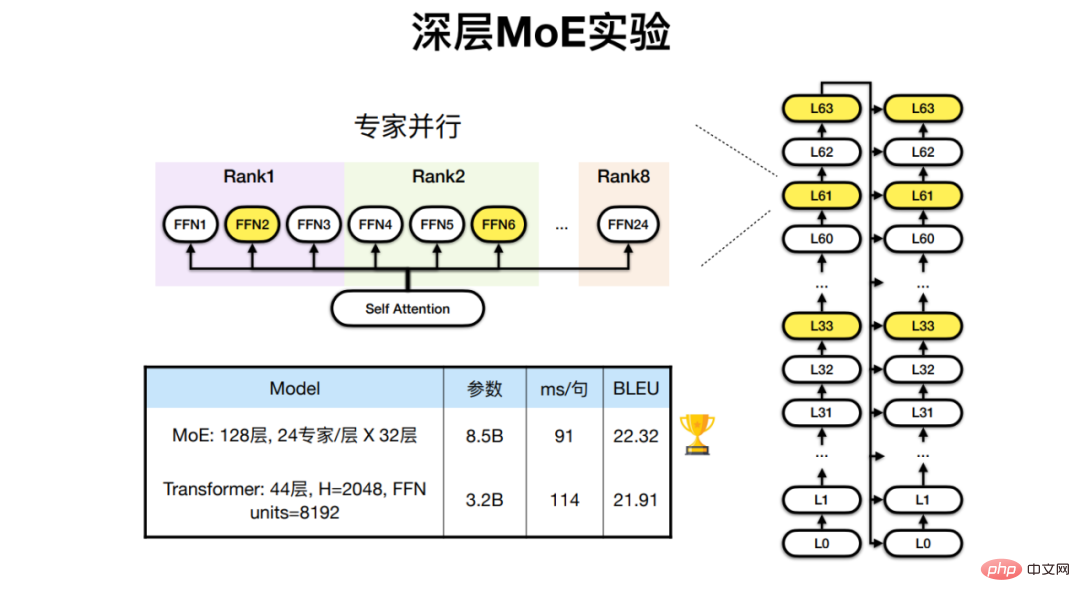

Für mehrsprachige Übersetzungsaufgaben in 24 afrikanischen Sprachen sowie Englisch und Französisch hat Huoshan Translation ein MoE-Modell mit 128 Transformer-Ebenen und 24 Expertenebenen entwickelt, das bessere Ergebnisse als traditionell erzielt Architekturübersetzungseffekt.

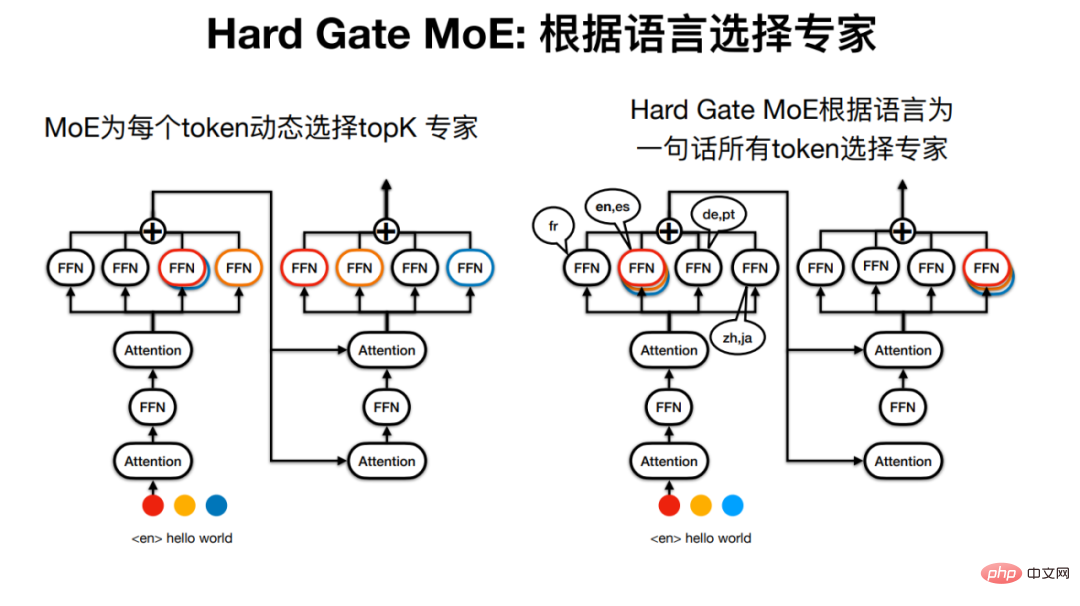

Aber das „Expertenmodell“ in Sparse MoE verdient seinen Namen möglicherweise nicht, da beispielsweise für einen Satz die von jedem Token übergebenen Experten unterschiedlich sein können.

Huoshan Translation hat daher Hard Gate MoE entwickelt, sodass die vom Experten übergebenen Sätze durch die Sprache bestimmt werden. Dadurch wird die Modellstruktur einfacher und experimentelle Ergebnisse zeigen auch, dass der Übersetzungseffekt besser ist.

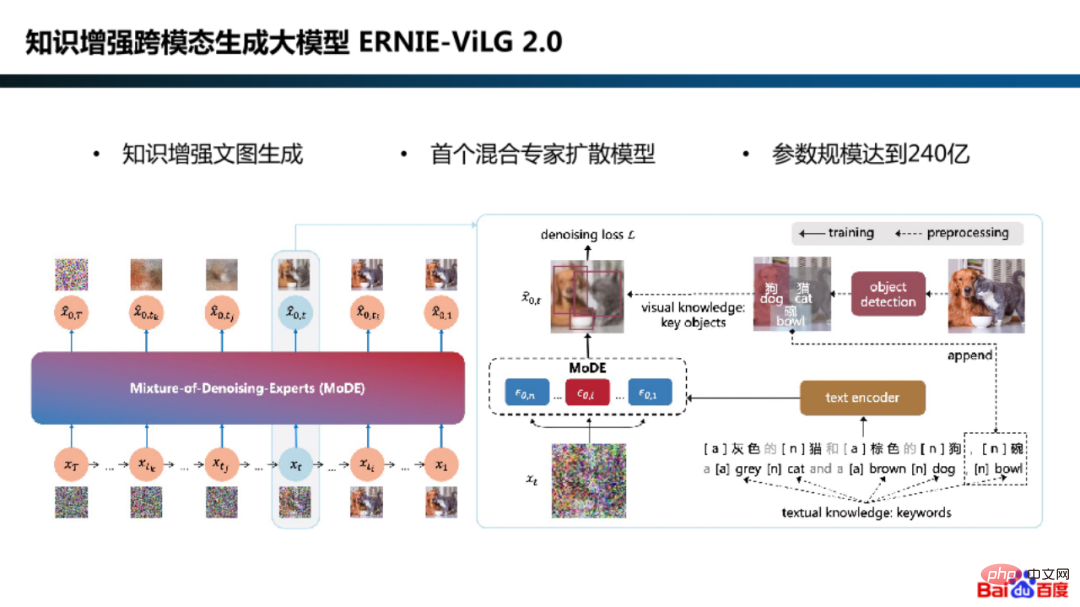

Bei der parallelen Erforschung der Algorithmusmodellierung hat Baidu auch das hybride Expertendiffusionsmodell-Framework im wissensverstärkten, modalübergreifenden Generierungsgroßmodell ERNIE-ViLG 2.0 übernommen.

Warum sollten wir Expertenmodelle für Diffusionsmodelle verwenden?

Tatsächlich liegt es daran, dass die Modellierungsanforderungen in den verschiedenen Generationsstadien unterschiedlich sind. In der Anfangsphase konzentriert sich das Modell beispielsweise auf das Erlernen der Generierung semantischer Bilder aus Gaußschem Rauschen, und in der Endphase konzentriert sich das Modell auf die Wiederherstellung von Bilddetails aus verrauschten Bildern.

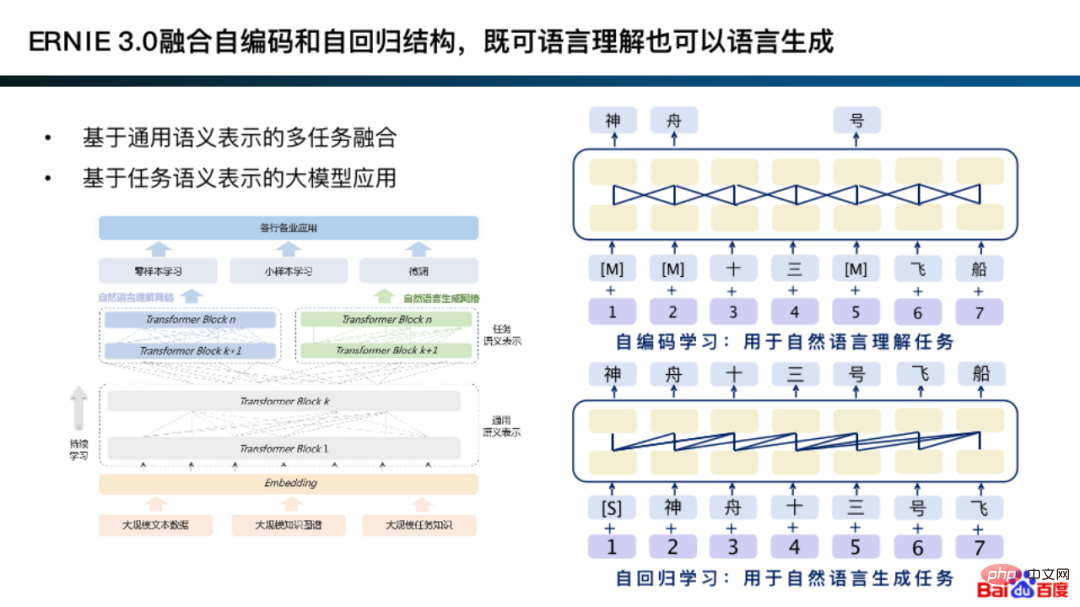

Tatsächlich integrierte die frühe Version von ERNIE 3.0 Autoencoding und Autoregression, die die beiden Modellierungsmethoden zu einer allgemeinen semantischen Darstellung für spezifische Generierungsaufgaben und Verständnisaufgaben kombinieren können.

Die Grundidee der Integration von Autoencoding und Autoregression ähnelt tatsächlich der Modellierungsmethodik des Expertenmodells.

Konkret wird auf der Grundlage der universellen Darstellung eine Modellierung danach durchgeführt, ob die Verständnisaufgabe für die automatisch kodierende Netzwerkstruktur und die Generierungsaufgabe für die autoregressive Netzwerkstruktur geeignet ist. Darüber hinaus erlernt diese Art der Modellierung häufig bessere allgemeine Darstellungen.

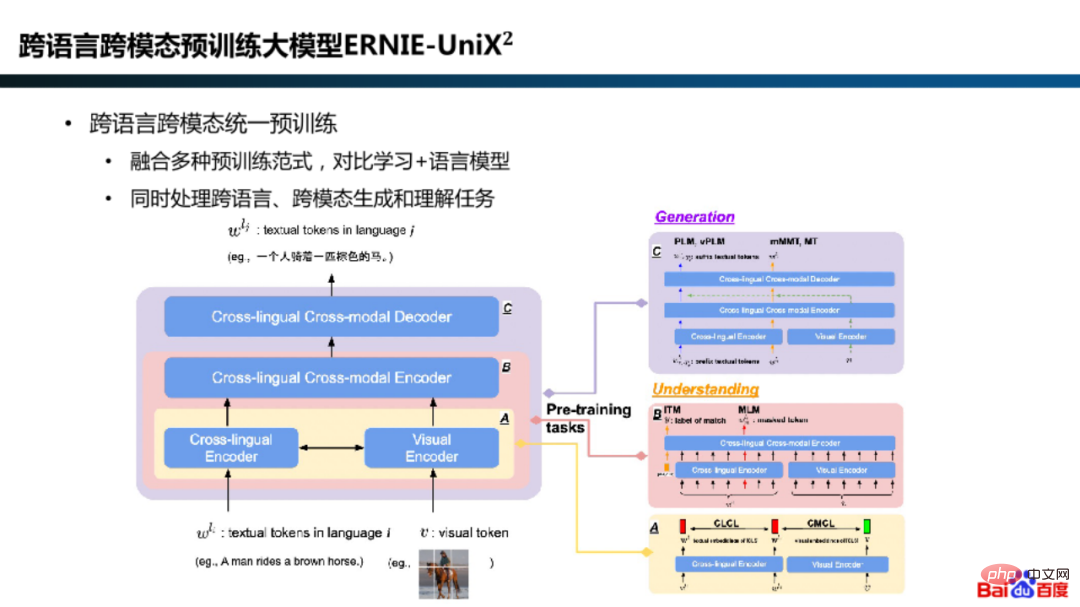

Darüber hinaus kombiniert Baidu im ERNIE-UniX2-Modell mehrsprachige und multimodale Verständnis- und Generierungsaufgaben durch die Integration von Pre-Training-Paradigmen wie kontrastivem Lernen und Sprachmodellen . Einheitlich.

Nach dem Training des MoE-Modells ist auch die Inferenzbereitstellung ein Glied, das großen Wert auf Effizienz legt.

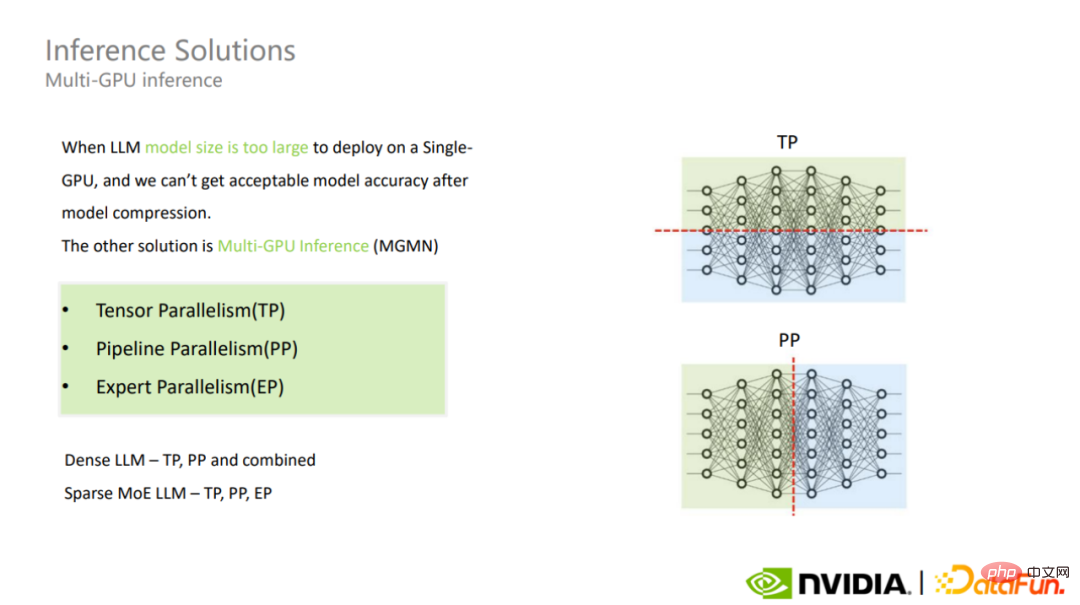

Bei der Auswahl einer Bereitstellungslösung für die Modellinferenz in extrem großem Maßstab entscheiden Sie zunächst, ob Sie eine Einzelkarteninferenz oder mehrere Karten verwenden möchten, basierend auf der Parameterskala, der Modellstruktur, dem GPU-Speicher und dem Inferenzrahmen des Modells sowie dem Kompromiss zwischen Modellgenauigkeit und Inferenzleistung. Wenn nicht genügend Videospeicher vorhanden ist, werden Modellkomprimierungs- oder Multi-Card-Inferenzlösungen in Betracht gezogen.

Multi-Card-Inferenz umfasst Tensor-Parallelität, Pipeline-Parallelität, Experten-Parallelität und andere Modi.

Die Verwendung verschiedener MoE-Modi für sehr große Modelle wird auf unterschiedliche Herausforderungen stoßen. Darunter sind die Tensor-Parallel- und Dense-Modelle des MoE-Modells ähnlich.

Wenn Sie den Experten-Parallelmodus auswählen, werden die Experten jeder MoE-Schicht auf verschiedene GPUs aufgeteilt, was zu Lastausgleichsproblemen führen kann, was dazu führt, dass eine große Anzahl von GPUs im Leerlauf ist, was letztendlich den Gesamtdurchsatz nicht verringert hoch. Dies ist ein wichtiger Punkt, auf den man sich bei der MoE-Doka-Argumentation konzentrieren sollte.

Für Tensor-Parallelität und Pipeline-Parallelität besteht neben der Reduzierung der Kommunikation zwischen Karten durch Feinabstimmung eine direktere Methode darin, die Bandbreite zwischen Karten zu erhöhen. Wenn die Verwendung der Expert-Parallelität für das MoE-Modell zu Lastausgleichsproblemen führt, kann diese durch Profiling analysiert und optimiert werden.

Die Multi-Card-Inferenzlösung erhöht den Kommunikationsaufwand und hat einen gewissen Einfluss auf die Verzögerung der Modellinferenz.

2. Fusion

Fusion ist eine Methode zur Lösung der natürlichen Widersprüche, die beim parallelen Rechnen auftreten. Paralleles Rechnen und serielles Rechnen sind zwei grundlegende Rechenmodi. Bei der Anwendung paralleler Berechnungen ist die häufigste Schwierigkeit die große Anzahl serieller Abhängigkeiten und das daraus resultierende Problem der Zwischenspeicherbelegung, und der GPU-Speicher wird normalerweise zu einem der Hardware-Leistungsengpässe für das Training und die Inferenz großer Modelle.

Für das Problem der seriellen Abhängigkeit beim Massive Computing besteht die wichtigste Methode darin, den Weg des Rinnsals zu verkürzen, dh den Zwischenverweilprozess zu reduzieren. Konkret wird die Operatorfusion verwendet, um Operatoren mit sequentiellen Abhängigkeiten zusammenzuführen, um die Videospeichernutzung zu reduzieren.

Operatorfusion wird nicht nur auf der Computerebene, sondern auch auf der Operatordesignebene implementiert.

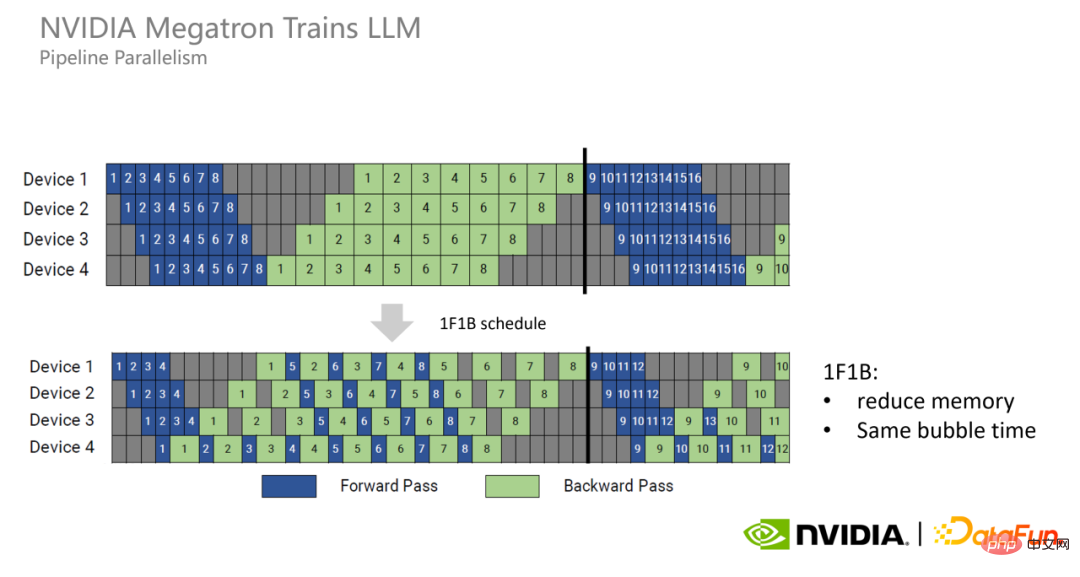

1, 1F1B

Pipeline Wenn die Vorwärts- und Rückwärtsprozesse parallel getrennt werden, tritt das Problem einer übermäßigen Videospeichernutzung auf.

Daher hat Megatron ein neues Modell der Pipeline-Parallelität vorgeschlagen: 1F1B. Jede GPU führt die Vorwärts- und Rückwärtsprozesse jedes Mikrobatches abwechselnd aus, um den von ihr belegten Videospeicher so früh wie möglich freizugeben und so die Videospeichernutzung zu reduzieren.

1F1B kann die Blasenzeit nicht reduzieren. Um die Blasenzeit weiter zu reduzieren, hat Megatron den interleaved 1F1B-Modus vorgeschlagen. Das heißt, jede GPU war ursprünglich für die Berechnung von vier aufeinanderfolgenden Schichten verantwortlich, jetzt ist sie jedoch für die Berechnung von zwei aufeinanderfolgenden Schichten verantwortlich, was nur noch der Hälfte der ursprünglichen entspricht, sodass auch die Blasenzeit halbiert ist Original.

2. Kernel FusionBei der Durchführung von GPU-Berechnungen kann jeder Berechnungsprozess in einen GPU-Kernel gekapselt und zur Ausführung auf der GPU platziert werden, und zwar sequentiell. Aus Gründen der Vielseitigkeit sind die Operatoren herkömmlicher Operatoren sehr einfach, sodass die Anzahl sehr groß ist. Der Nachteil besteht darin, dass sie viel Videospeicher beanspruchen, da sie zusätzlich eine große Menge versteckter Zwischendarstellungen speichern müssen Dies erfordert eine relativ hohe Bandbreite, was möglicherweise zu Verzögerungen oder Leistungseinbußen führt.

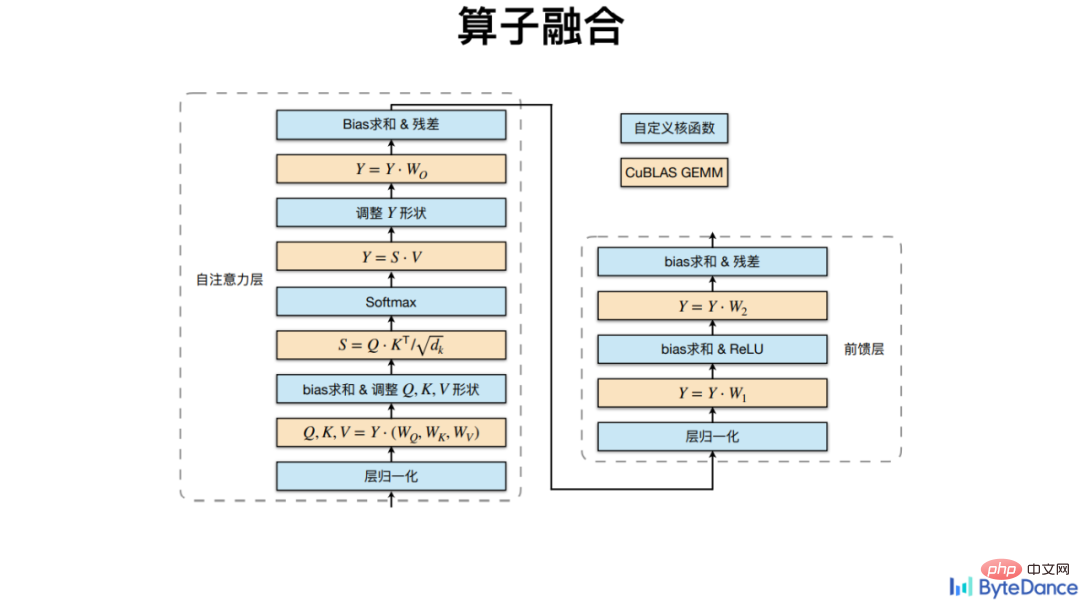

Volcano Translation integriert andere Nicht-Matrix-Multiplikationsoperatoren basierend auf der CuBLAS-Multiplikationsschnittstelle, einschließlich Softmax, LayerNorm usw.

Volcano Translation integriert andere Nicht-Matrix-Multiplikationsoperatoren basierend auf der CuBLAS-Multiplikationsschnittstelle, einschließlich Softmax, LayerNorm usw.

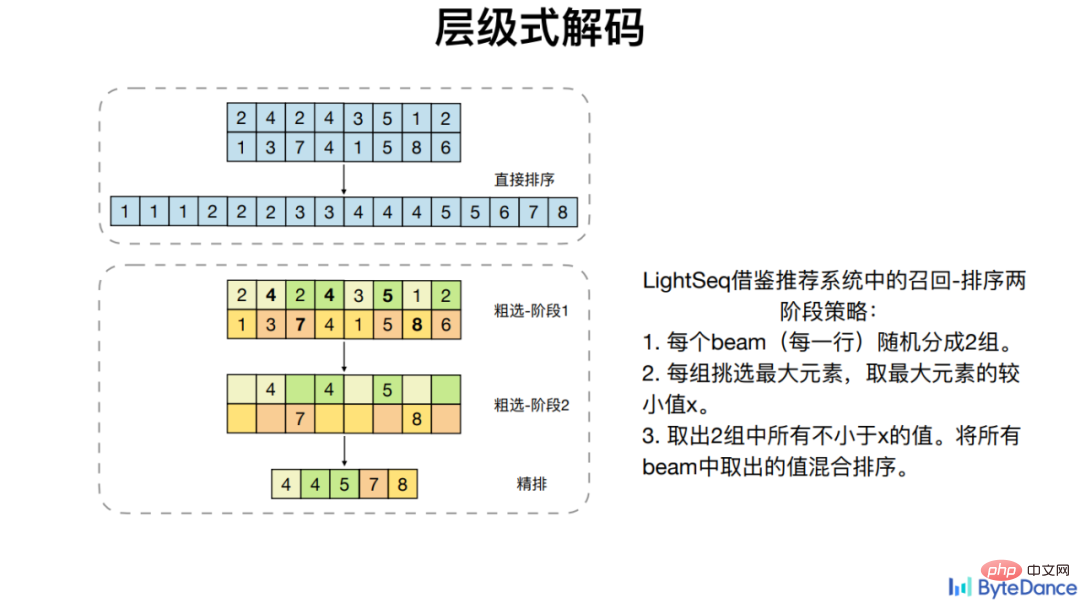

Volcano Translation vergleicht nicht nur die Fusion allgemeiner Operatoren, sondern optimiert auch die Rechenabhängigkeit einiger spezifischer Operatoren wie Beam Search, die die GPU-Parallelität nicht sinnvoll nutzen können, wodurch eine Beschleunigung erzielt wird.

Bei vier gängigen Transformer-Modellen hat die LightSeq-Operatorfusion basierend auf PyTorch eine bis zu achtfache Beschleunigung erreicht.

3.Vereinfachung

Vereinfachung ist eine relativ einfache und intuitive Möglichkeit, die Pipeline-Zweige im Detail zu beschleunigen und zu optimieren. Insbesondere bei hoher Rechenkomplexität wird die Bedienerkomplexität bei gleichzeitiger Sicherstellung der Leistung vereinfacht und letztendlich der Rechenaufwand reduziert.

Die Einzelkarteninferenz sehr großer Modelle beinhaltet im Allgemeinen eine Modellkomprimierung.

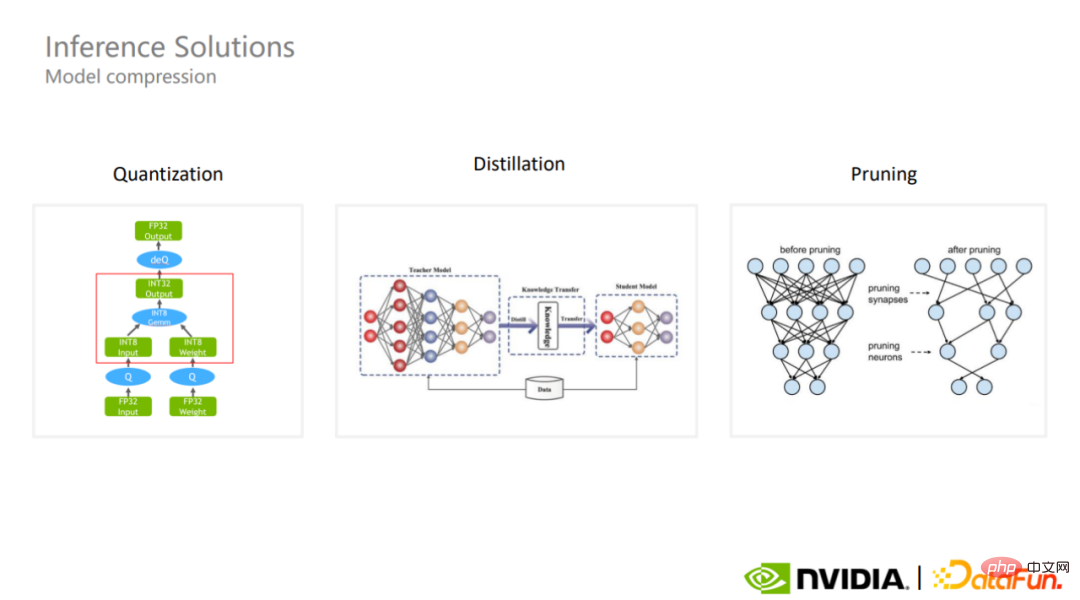

Gängige Modellkomprimierungsschemata sind Quantisierung, Destillation und Beschneidung. Die Quantisierung ist eines der am häufigsten verwendeten Modellkomprimierungsschemata in der Branche. Obwohl die quantitative Berechnung eine geringere Genauigkeit verwendet, kann sie die Parametergröße des Modells beibehalten und in einigen Fällen möglicherweise die Gesamtgenauigkeit des Modells besser garantieren.

1. Quantisierung

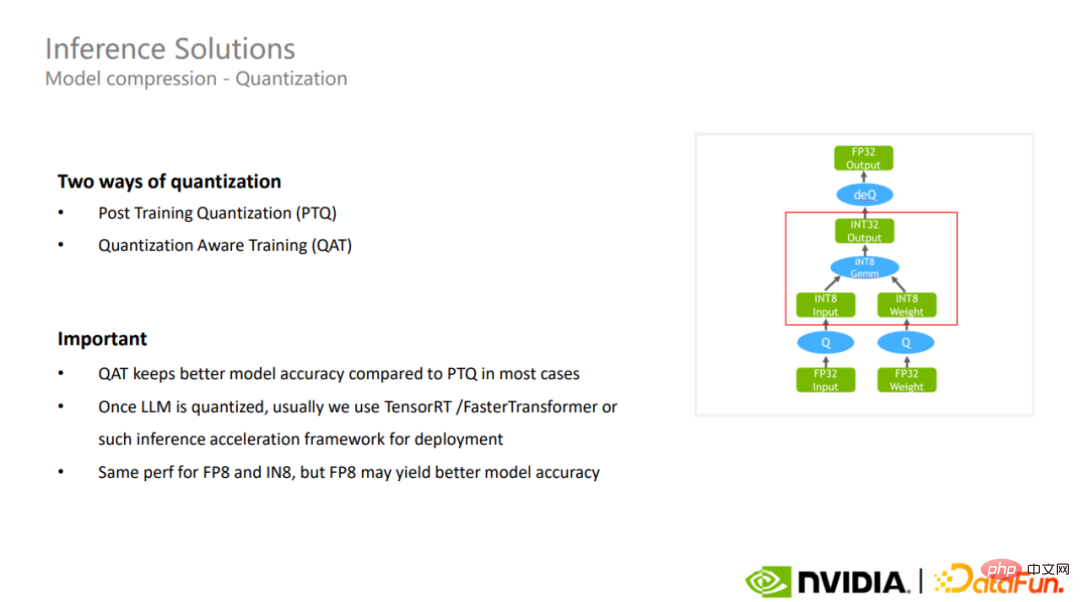

Es gibt derzeit zwei Quantisierungsmethoden, eine ist Post-Training-Quantisierung und die andere ist quantisierungsbewusstes Training. Letzteres bewahrt die Genauigkeit des Modells normalerweise besser als Ersteres.

Nach Abschluss der Quantisierung können Inferenzbeschleunigungs-Frameworks wie TensorRT oder FasterTransformer verwendet werden, um die Inferenz sehr großer Modelle weiter zu beschleunigen.

LightSeq verwendet bei der Quantisierung des Trainingsprozesses die echte int8-Quantisierung, dh die Quantisierungsoperation wird vor der Matrixmultiplikation und die inverse Quantisierungsoperation nach der Matrixmultiplikation durchgeführt. Im Gegensatz zur Pseudoquantisierung in der Vergangenheit werden Quantisierungs- und Dequantisierungsoperationen vor der Matrixmultiplikation durchgeführt, damit sich das Modell an die durch die Quantisierung verursachten Verluste und Schwankungen anpassen kann. Letzteres führt nicht zu einer Beschleunigung der tatsächlichen Berechnungen, kann jedoch die Verzögerung erhöhen oder den Speicherverbrauch erhöhen. Und echte int8-Quantisierung bringt auch in praktischen Anwendungen gute Beschleunigungseffekte mit sich.

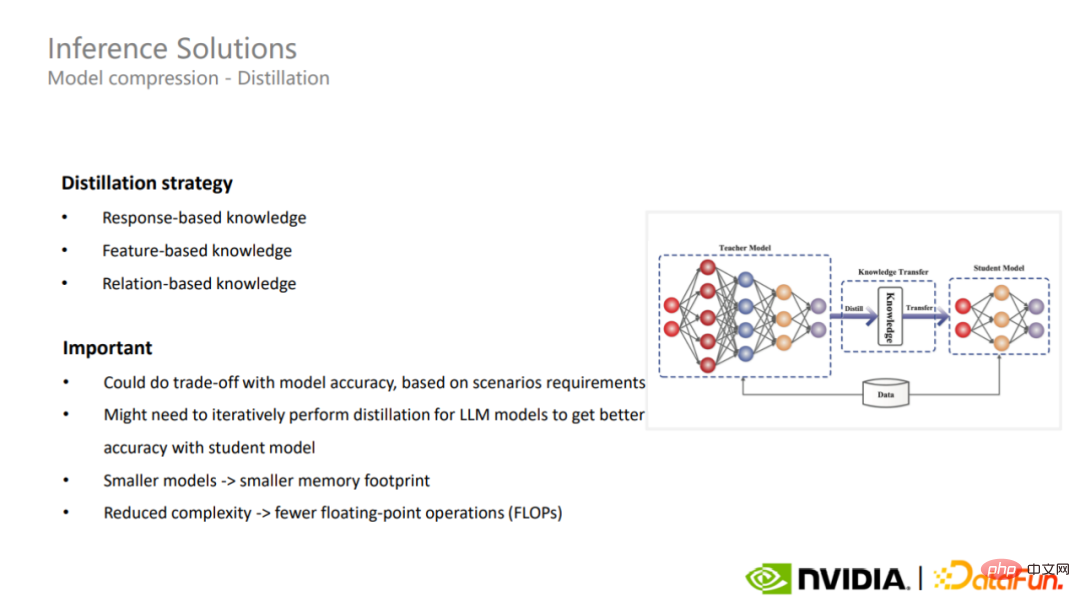

2. Destillation

Die zweite Modellkomprimierungsmethode ist die Destillation. Bei der Destillation können unterschiedliche Strategien zum Komprimieren sehr großer Modelle für unterschiedliche Anwendungsszenarien verwendet werden. In einigen Fällen kann die Destillation sehr großen Modellen bessere Generalisierungsfähigkeiten verleihen.

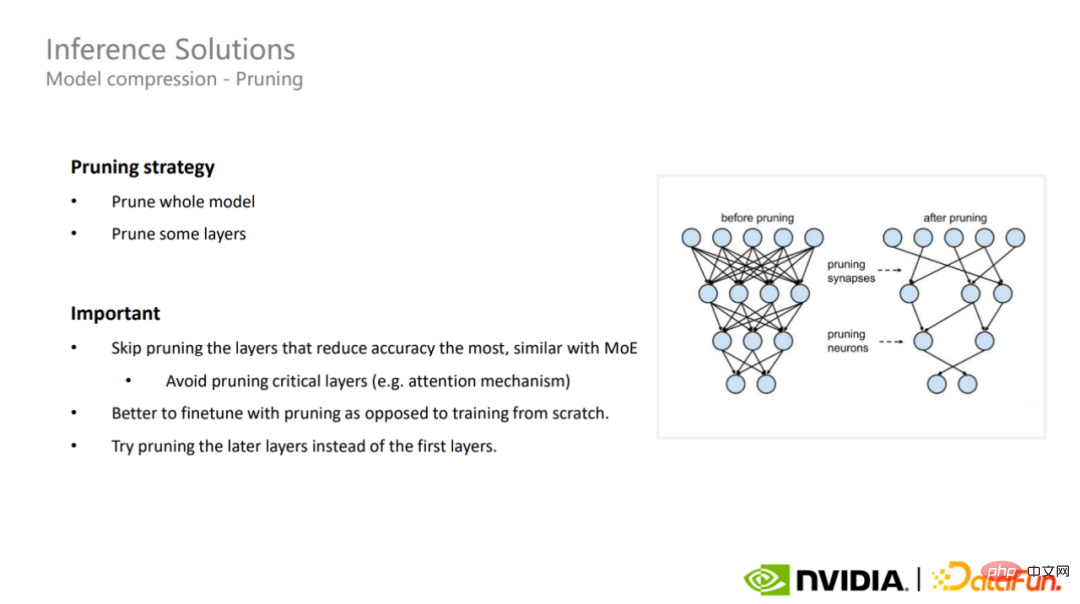

3. Beschneiden

Die letzte Modellkomprimierungslösung ist das Beschneiden. Das Beschneiden kann in das vollständige Beschneiden des Modells und das Beschneiden teilweiser Schichten unterteilt werden. Bei sehr großen Modellen ist es wichtig, das Beschneiden dieser Teile zu vermeiden, die den größten Einfluss auf die Genauigkeit haben Gilt auch für Sparse-MoE-Modelle. 4. Industrialisierung großer Modelle ist mehr als das, was Transformers gerade vor fünf Jahren vorgeschlagen hat, um das Siebenfache. Darüber hinaus verfügen große Modelle über ein breites Anwendungsspektrum, z. B. Bildgenerierung, Empfehlungssysteme, maschinelle Übersetzung und sogar Biowissenschaften, Codegenerierung usw.

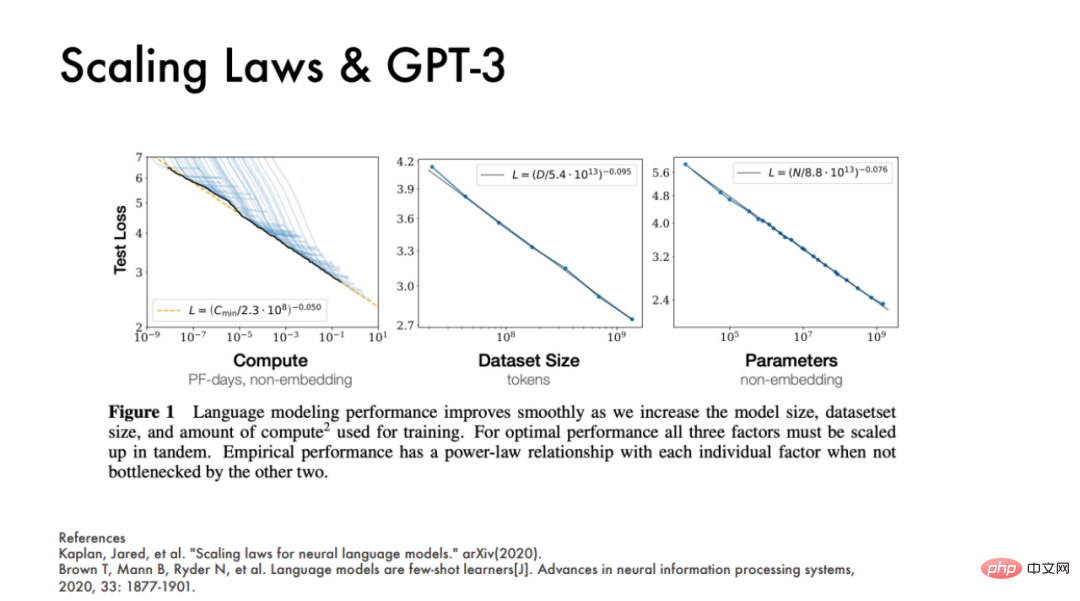

OpenAI veröffentlichte im Jahr 2020 außerdem zwei Artikel, die zeigten, dass die Leistung eines Modells im Wesentlichen mit drei Hauptfaktoren zusammenhängt, nämlich der Rechenleistung, der Datensatzgröße und der Menge der Modellparameter die Leistung des Modells gut vorhersagen.

Richard Sutton hat einmal gesagt, dass in den letzten 70 Jahren der KI-Entwicklung ein wiederkehrender Trend darin besteht, dass eine allgemeine Methode, die Rechenressourcen effizient nutzen kann, am Ende immer der Gewinner sein wird. Laut Richard Suttons „Winner’s Law“ hat Deep Learning im letzten Jahrzehnt an Vielseitigkeit gewonnen.

Aber heutzutage sind die Herausforderungen der Ausbildung großer Models selbstverständlich. Nehmen Sie als Beispiel GPT-3. Wenn Sie während des Trainings die ursprüngliche gemischte Präzision verwenden, müssen Sie die Parameter und Steigungen während des Trainings sowie die Hauptparameter von FP 32 speichern. Wenn Sie den Adam-Optimierer verwenden, müssen Sie auch speichern Aufgrund der Impulsinformationen der beiden Optimierer sind letztendlich insgesamt 2,8 TB Videospeicher erforderlich, was die Videospeicherkapazität einer einzelnen Karte bei weitem übersteigt und mehr als 35 A100 erfordert.

Aber heutzutage sind die Herausforderungen der Ausbildung großer Models selbstverständlich. Nehmen Sie als Beispiel GPT-3. Wenn Sie während des Trainings die ursprüngliche gemischte Präzision verwenden, müssen Sie die Parameter und Steigungen während des Trainings sowie die Hauptparameter von FP 32 speichern. Wenn Sie den Adam-Optimierer verwenden, müssen Sie auch speichern Aufgrund der Impulsinformationen der beiden Optimierer sind letztendlich insgesamt 2,8 TB Videospeicher erforderlich, was die Videospeicherkapazität einer einzelnen Karte bei weitem übersteigt und mehr als 35 A100 erfordert.

NVIDIAs Papier „Efficient Large-Scale Language Model Training on GPU Clusters Using Megatron-LM“ aus dem Jahr 2021 hat eine empirische Formel abgeleitet, die darauf hinweist, dass ein GPT-3-Modell mit einem einzelnen Iterationsparameter von 175 Milliarden 4,5 100 Millionen FLOPs erfordert Rechenleistung. Besteht der gesamte Trainingszyklus aus 95.000 Iterationen, sind 430 ZettaFLOPs erforderlich. Mit anderen Worten: Ein A100 benötigt für das Training 16.000 Tage, was unabhängig von der Recheneffizienz eine Schlussfolgerung ist.

Mit anderen Worten, die bloße Anhäufung dieser drei Indikatoren wäre im Zeitalter der groß angelegten Modellindustrialisierung eine enorme Ressourcenverschwendung. DeepMind stellte in ChinChillas im Jahr 2022 veröffentlichtem Artikel fest, dass große Modelle wie GPT-3, OPT und PaLM tatsächlich grundsätzlich unterpassende Modelle sind. Wenn auf der Grundlage derselben Rechenressourcen die Anzahl der Modellparameter reduziert und mehr Schritte trainiert werden, ist der endgültige Modelleffekt besser. Dies ist auch die Designphilosophie, die WeChat im groß angelegten WeLM-Sprachmodell verfolgt.

Unternehmen in der Branche beginnen grundsätzlich, ihren Fokus von der Skalierung zu lösen und sich stattdessen auf Effizienzfragen bei der Implementierung großer Modelle zu konzentrieren.

Aus Sicht der Gesamtausführungseffizienz weisen beispielsweise fast alle von Megatron optimierten Modelle eine Durchsatzverbesserung von 30 % auf, und mit zunehmender Modellgröße kann eine höhere GPU-Auslastung erreicht werden. Beim GPT-3-Modell mit 175 Milliarden Parametern kann die GPU-Auslastung 52,8 % erreichen. Bei Modellen mit einer Parameterskala von mehr als 530 Milliarden kann die Auslastungsrate 57 % erreichen.

Mit anderen Worten: Nach Richard Suttons „Winner’s Law“ wird Effizienz zum Hauptfaktor der Industrialisierung von Großmodellen werden.

Das obige ist der detaillierte Inhalt vonDie Methodik zur Industrialisierung großer Modelle ist vollständig in der GPU verborgen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr