Heim >Technologie-Peripheriegeräte >KI >Xiao Zha hat viel Geld ausgegeben! Meta hat speziell für das Metaverse ein KI-Modell entwickelt

Xiao Zha hat viel Geld ausgegeben! Meta hat speziell für das Metaverse ein KI-Modell entwickelt

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 19:58:22929Durchsuche

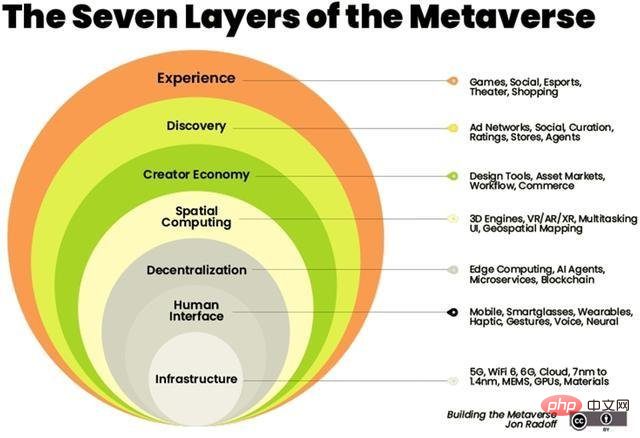

Künstliche Intelligenz wird zum Rückgrat der virtuellen Welt.

Künstliche Intelligenz kann mit einer Vielzahl verwandter Technologien im Metaversum kombiniert werden, wie z. B. Computer Vision, Verarbeitung natürlicher Sprache, Blockchain und digitale Zwillinge.

Im Februar zeigte Zuckerberg auf der ersten virtuellen Veranstaltung des Unternehmens, Inside The Lab, wie das Metaverse aussehen würde. Er sagte, das Unternehmen entwickle eine neue Reihe generativer KI-Modelle, die es Benutzern ermöglichen würden, ihre eigenen Virtual-Reality-Avatare zu generieren, indem sie diese einfach beschreiben.

Zuckerberg kündigte eine Reihe bevorstehender Projekte an, wie etwa das Projekt CAIRaoke, ein vollständig durchgängiges neuronales Modell zum Aufbau von Sprachassistenten auf Geräten, das Benutzern dabei helfen kann, natürlicher mit ihren Sprachassistenten zu kommunizieren. Unterdessen arbeitet Meta intensiv an der Entwicklung eines universellen Sprachübersetzers, der eine direkte Sprach-zu-Sprache-Übersetzung für alle Sprachen ermöglicht.

Ein paar Monate später hat Meta ihr Versprechen gehalten. Allerdings ist Meta nicht das einzige Technologieunternehmen, das mit von der Partie ist. Unternehmen wie Nvidia haben auch ihre eigenen, selbst entwickelten KI-Modelle veröffentlicht, um ein umfassenderes Metaverse-Erlebnis zu bieten.

Vorab trainierter Open-Source-Transformer (OPT-175 Milliarden Parameter)

GANverse 3D

GANverse 3D wurde von NVIDIA AI Research entwickelt. Es handelt sich um ein Modell, das Deep Learning verwendet, um 2D-Bilder in eine 3D-Animation zu verarbeiten Version vom letzten Jahr Das Tool, beschrieben in einem am ICLR und CVPR veröffentlichten Forschungspapier, kann Simulationen schneller und zu geringeren Kosten erstellen.

Dieses Modell verwendet StyleGAN, um automatisch mehrere Ansichten aus einem einzelnen Bild zu generieren. Die Anwendung kann als Erweiterung in NVIDIA Omniverse importiert werden, um 3D-Objekte in virtuellen Welten präzise darzustellen. Omniverse von NVIDIA hilft Benutzern dabei, Simulationen ihrer endgültigen Ideen in einer virtuellen Umgebung zu erstellen.

Die Produktion von 3D-Modellen ist zu einem Schlüsselfaktor beim Aufbau des Metaversums geworden. Einzelhändler wie Nike und Forever21 haben ihre virtuellen Geschäfte im Metaverse eingerichtet, um den E-Commerce-Umsatz anzukurbeln.

Visual Acoustic Matching Model (AViTAR)

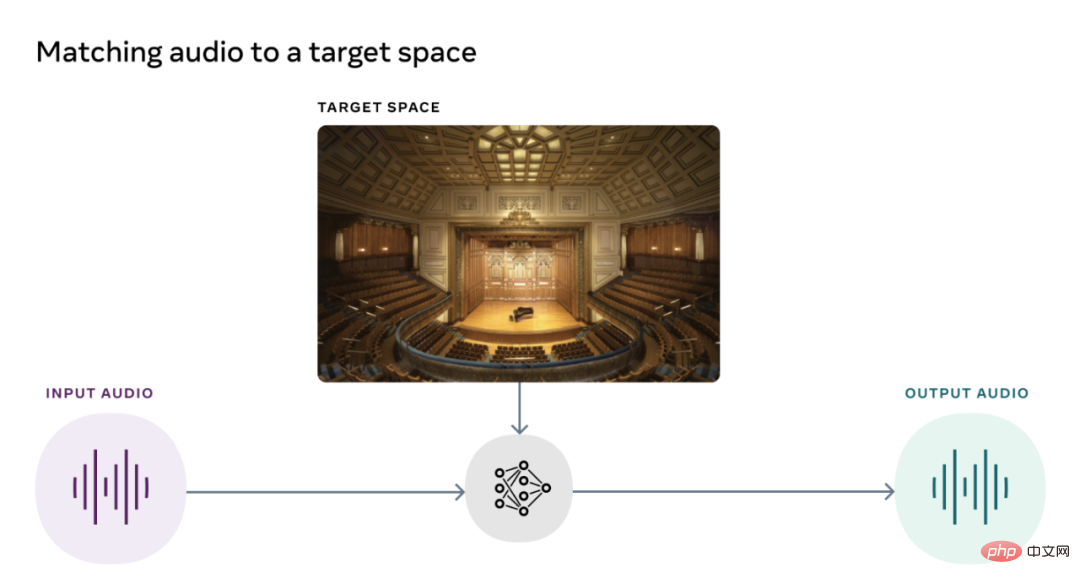

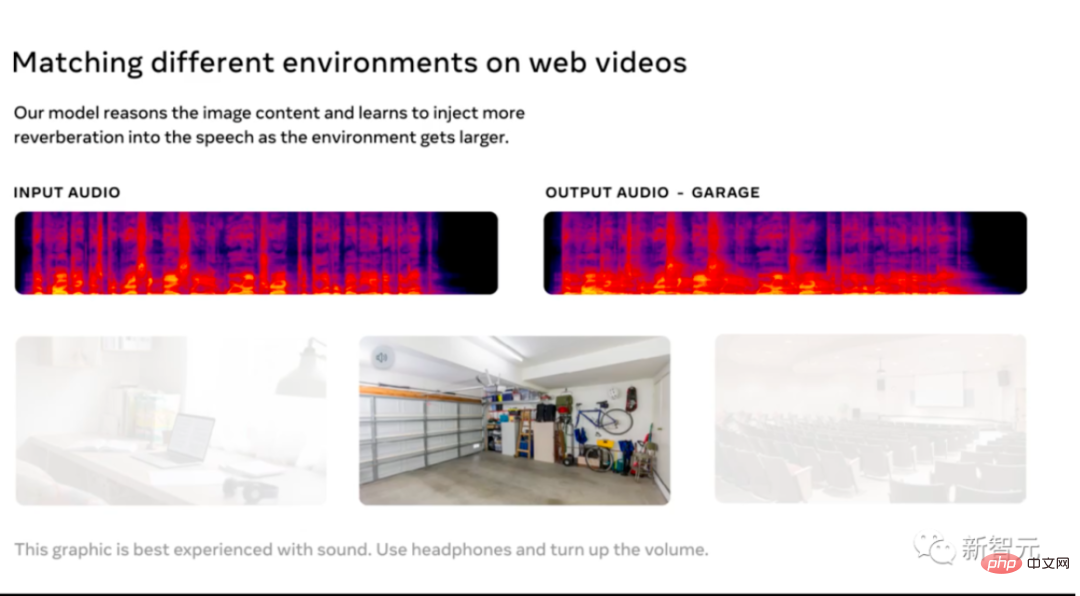

Das Reality Lab-Team von Meta arbeitete mit der University of Texas zusammen, um ein Modell für künstliche Intelligenz zu entwickeln, um die Klangqualität des Metaraums zu verbessern. Dieses Modell hilft dabei, Audio und Video in einer Szene abzugleichen. Es transformiert Audioclips so, dass sie so klingen, als wären sie in einer bestimmten Umgebung aufgenommen worden. Das Modell nutzt selbstüberwachtes Lernen, nachdem Daten aus zufälligen Online-Videos extrahiert wurden. Im Idealfall sollten Benutzer ihre Lieblingserinnerungen auf ihrer AR-Brille betrachten und genau die Geräusche hören können, die das tatsächliche Erlebnis erzeugt.

Meta AI hat AViTAR zusammen mit zwei anderen akustischen Modellen als Open Source veröffentlicht, was sehr selten ist, wenn man bedenkt, dass Sound ein oft übersehener Teil des Metaverse-Erlebnisses ist.

Visually Impacted Vibration Reduction (VIDA)

Das zweite von Meta AI veröffentlichte Akustikmodell wird verwendet, um Nachhall in der Akustik zu entfernen.

Das Modell wird anhand eines großen Datensatzes mit verschiedenen realistischen Audiowiedergaben von 3D-Hausmodellen trainiert. Reverb verringert nicht nur die Qualität des Audios und macht es schwer zu verstehen, sondern verbessert auch die Genauigkeit der automatischen Spracherkennung.

VIDA ist insofern einzigartig, als es sowohl akustische als auch visuelle Hinweise zur Beobachtung nutzt. Als Verbesserung typischer reiner Audiomethoden verbessert VIDA die Sprache und identifiziert Stimmen und Sprecher.

Visual Voice (VisualVoice)

VisualVoice, das dritte von Meta AI veröffentlichte akustische Modell, kann Sprache aus Videos extrahieren. Wie VIDA ist VisualVoice auf audiovisuelle Hinweise aus unbeschrifteten Videos trainiert. Das Modell verfügt über eine automatische Sprachtrennung.

Dieses Modell verfügt über wichtige Anwendungsszenarien, z. B. die Entwicklung von Technologie für Hörgeschädigte, die Verbesserung des Klangs tragbarer AR-Geräte, die Transkription von Sprache aus Online-Videos in lauten Umgebungen usw.

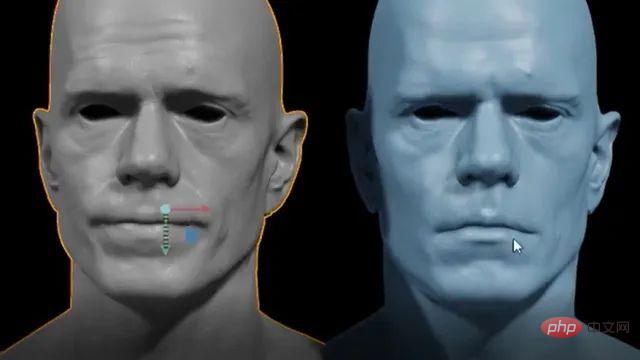

Audio2Face

Letztes Jahr veröffentlichte NVIDIA eine offene Beta von Omniverse Audio2Face, um KI-gesteuerte Gesichtsanimationen zu generieren, die zu jedem Voiceover passen. Dieses Tool vereinfacht den langen und mühsamen Prozess der Animation von Spielen und visuellen Effekten. Die App ermöglicht es Benutzern außerdem, Befehle in mehreren Sprachen zu erteilen.

Anfang des Jahres veröffentlichte NVIDIA ein Update für das Tool, das Funktionen wie BlendShape Generation hinzufügte, um Benutzern die Erstellung einer Reihe von Blendhapes aus einem neutralen Avatar zu erleichtern . Darüber hinaus wurde die Funktionalität eines Streaming-Audio-Players hinzugefügt, der das Streamen von Audiodaten mithilfe von Text-to-Speech-Anwendungen ermöglicht. Audio2Face erstellt ein 3D-Charaktermodell, das mit Audiospuren animiert werden kann. Das Audio wird dann in ein tiefes neuronales Netzwerk eingespeist. Benutzer können Charaktere auch in der Nachbearbeitung bearbeiten, um ihre Leistung zu ändern.

Das obige ist der detaillierte Inhalt vonXiao Zha hat viel Geld ausgegeben! Meta hat speziell für das Metaverse ein KI-Modell entwickelt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr