Heim >Technologie-Peripheriegeräte >KI >Das einheitliche AIGC-Modell ist da! Das von Huang Xutao, einem führenden Unternehmen der CV-Branche, gegründete Team schlug „Almighty Diffusion' vor.

Das einheitliche AIGC-Modell ist da! Das von Huang Xutao, einem führenden Unternehmen der CV-Branche, gegründete Team schlug „Almighty Diffusion' vor.

- 王林nach vorne

- 2023-04-11 19:30:161150Durchsuche

Die jüngsten Fortschritte bei Diffusionsmodellen stellen einen beeindruckenden Meilenstein für viele generative Aufgaben dar. Attraktive Arbeiten wie DALL·E 2, Imagen und Stable Diffusion (SD) haben großes Interesse in Wissenschaft und Industrie geweckt.

Obwohl diese Modelle eine erstaunliche Leistung erbringen, konzentrieren sie sich im Wesentlichen auf eine bestimmte Art von Aufgabe, beispielsweise auf die Generierung von Bildern aus gegebenem Text. Für verschiedene Arten von Aufgaben müssen sie häufig separat trainiert oder neu erstellt werden.

Können wir also eine „allseitige“ Diffusion basierend auf früheren Modellen aufbauen, um die Vereinheitlichung des AIGC-Modells zu erreichen? Einige Leute versuchen, in diese Richtung zu forschen und haben Fortschritte gemacht.

Dieses gemeinsame Team der University of Illinois in Urbana-Champaign und der University of Texas in Austin versucht, die bestehende Single-Stream-Diffusion in ein Multi-Stream-Netzwerk namens Versatile Diffusion (VD) zu erweitern 1. Das einheitliche Multi-Stream-Multi-Modal-Diffusions-Framework ist ein Schritt in Richtung allgemeiner generativer künstlicher Intelligenz.

Papieradresse: https://arxiv.org/abs/2211.08332

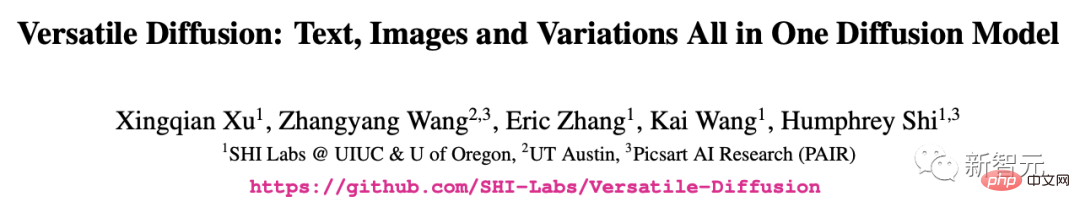

Zusätzlich zur normalen Bildgenerierungsfunktion für Text kann Versatile Diffusion auch Bilder eingeben, um ähnliche Bilder zu generieren . Geben Sie Bilder ein, um Text zu generieren, geben Sie Text ein, um ähnlichen Text zu generieren, bearbeiten Sie Bilder mit semantischer Entkopplung, geben Sie Bilder und Text ein, um Videos zu generieren, bearbeiten Sie Bildinhalte basierend auf latentem Raum usw.

Zukünftige Versionen werden auch mehr Modi wie Sprache, Musik, Video und 3D unterstützen.

Dem Papier zufolge haben VD und das zugrunde liegende Framework nachweislich die folgenden Vorteile:

a) Kann alle Teilaufgaben mit wettbewerbsfähig hoher Qualität bewältigen.

b) Unterstützung neuer Erweiterungen und Anwendungen, wie z. B. die Trennung von Grafikstil und Semantik, die Generierung von Bild-Text-Doppelführung usw.

c) Diese Experimente und Anwendungen liefern umfassendere semantische Einblicke in die generierte Ausgabe.

In Bezug auf den Trainingsdatensatz verwendet VD Laion2B-en mit benutzerdefinierten Datenfiltern als Hauptdatensatz.

Eine aufregende Entdeckung aus der ersten Erkundung von

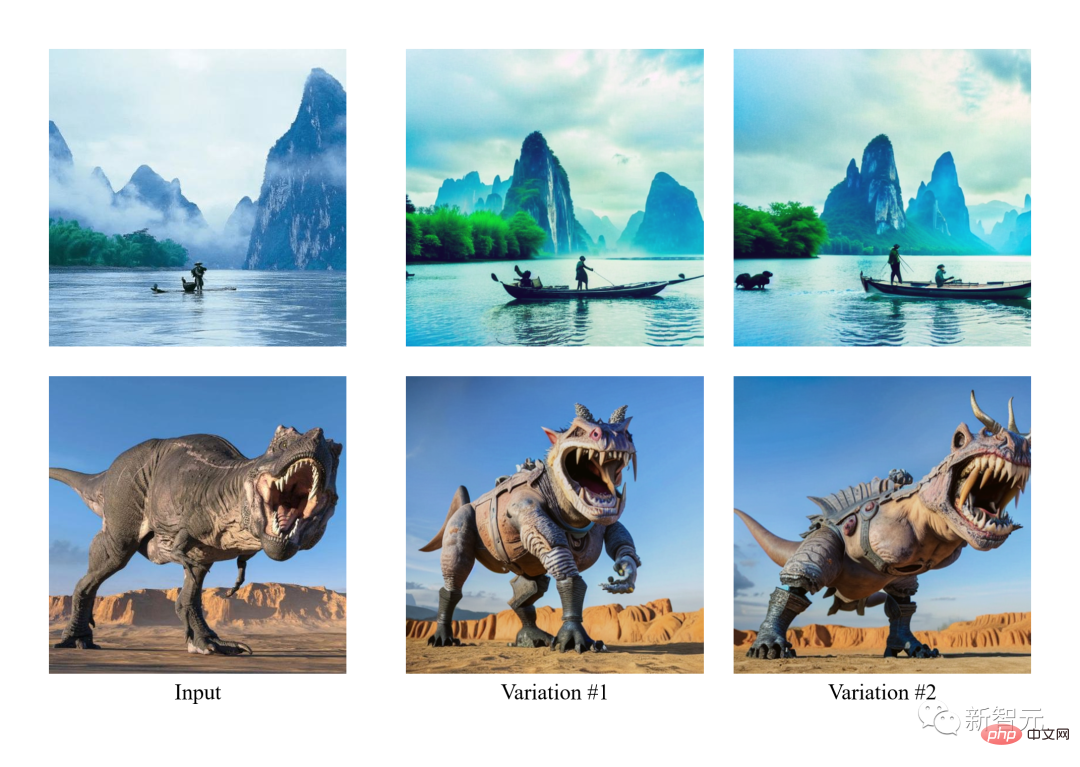

VD ist, dass es den Bildstil ohne weitere Aufsicht semantisch verbessern oder reduzieren kann.

Ein solches Phänomen inspirierte den Autor dazu, ein völlig neues Feld zu erkunden, in dem die Trennung zwischen Stil und Semantik für Bilder mit beliebigen Stilen und beliebigen Inhalten erfolgen kann.

Die Autoren gaben an, dass sie das erste Team sind, das Folgendes untersucht: a) semantische und stilistische Interpretation natürlicher Bilder ohne Domänenspezifikation; b) semantische und stilistische Zerlegung im latenten Raum von Diffusionsmodellen.

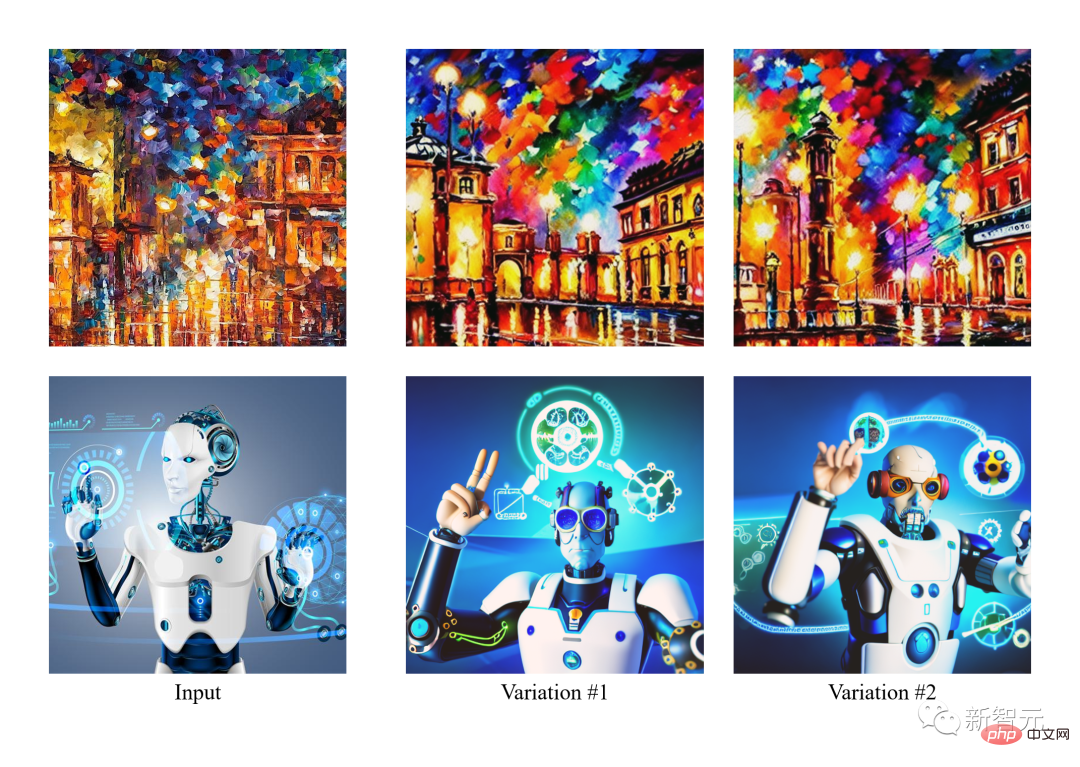

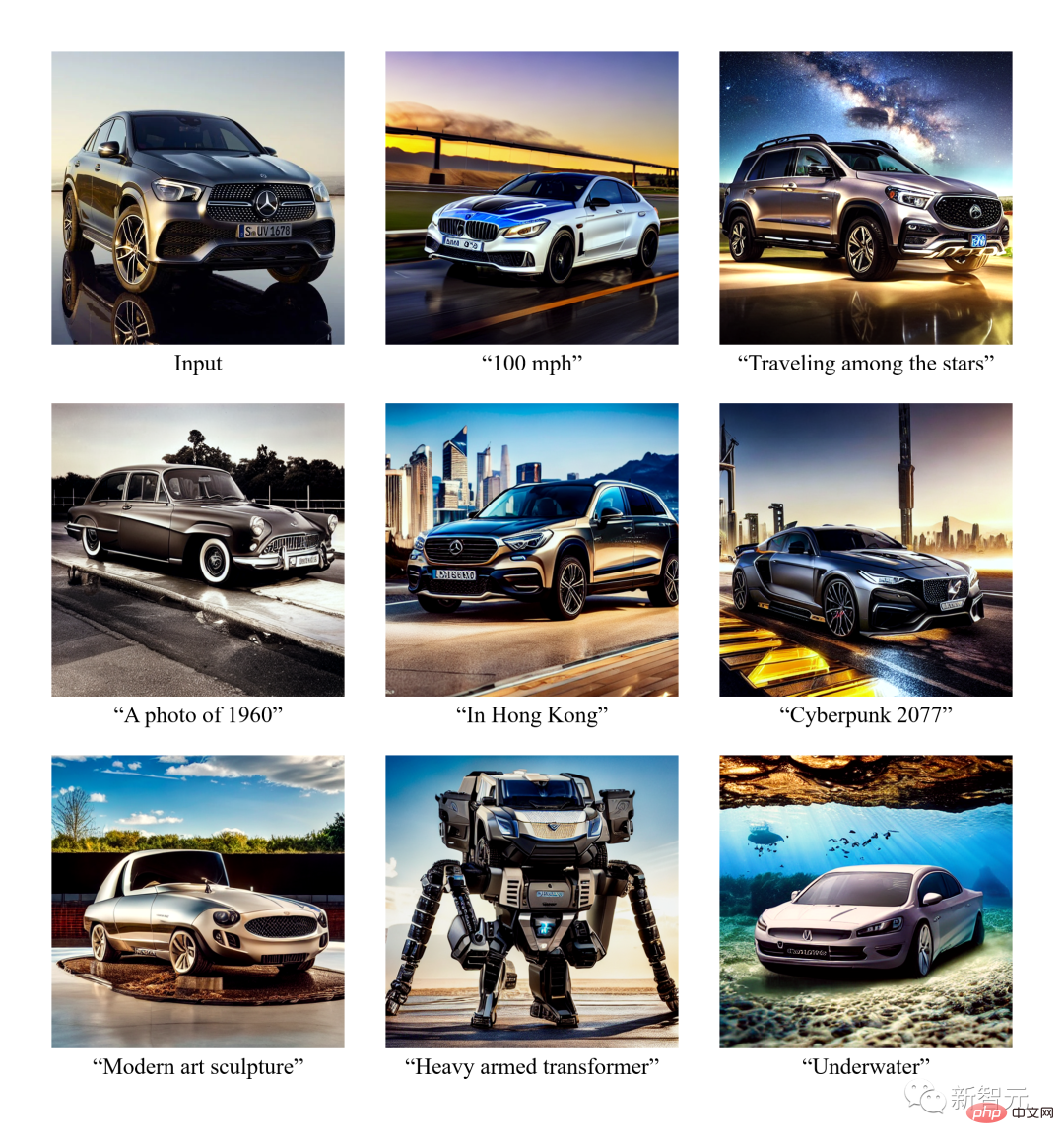

Im Bild unten generiert der Autor zunächst Varianten des Eingabebildes und bearbeitet diese dann mit semantischem (links) oder stilistischem (rechts) Fokus.

Da VD sowohl Bild zu Text als auch Text zu Bild unterstützt, versuchte das Autorenteam zum ersten Mal, Bilder aus der Perspektive von Textaufforderungen zu bearbeiten, indem es die Schritte befolgte: a) Bild in Text konvertieren, b) Bearbeiten Sie den Text. c) Wandeln Sie den Text wieder in ein Bild um.

Im Experiment entfernte der Autor den beschriebenen Inhalt aus dem Bild und fügte dann mithilfe dieses Bild-Text-Bild-Paradigmas (I2T2I) neue Inhalte hinzu. Im Gegensatz zum Malen oder anderen Bildbearbeitungsmethoden, die die Position von Objekten als Eingabe erfordern, benötigt I2T2I von VD keine Masken, da es Objekte automatisch nach Anweisung positionieren und ersetzen kann.

Das Ausgabebild von I2T2I stimmt jedoch nicht mit den Pixeln des Eingabebildes überein, was durch die semantische Verfeinerung von Bild zu Text und die Erstellung von Text-zu-Bild-Inhalten verursacht wird.

In der Anzeige unten wird das Eingabebild zunächst in eine Eingabeaufforderung übersetzt und dann die Eingabeaufforderung durch Subtraktion (rotes Feld) und Addition (grünes Feld) bearbeitet. Abschließend wird die bearbeitete Eingabeaufforderung in ein Bild übersetzt.

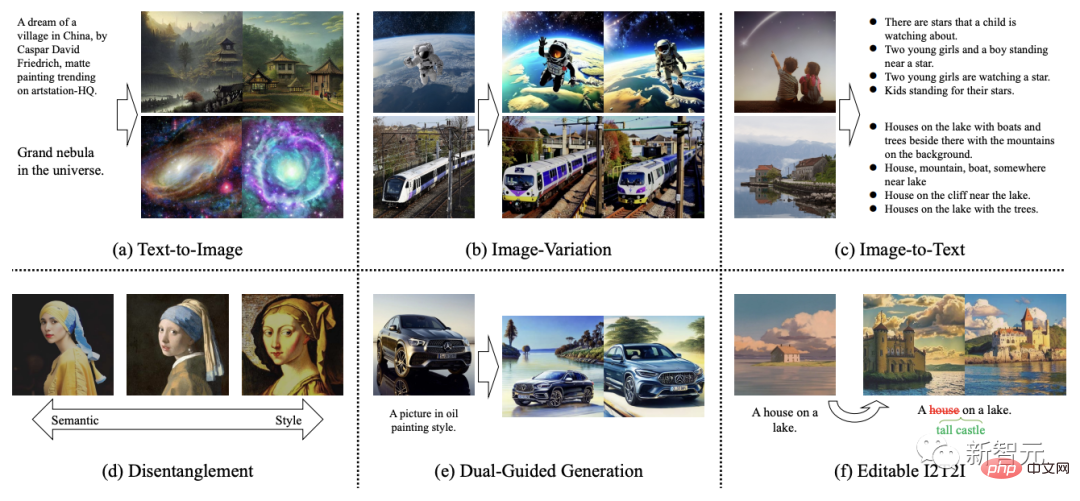

Darüber hinaus sind sie auch das erste Team, das die Generierung ähnlicher Texte auf der Grundlage eines vorgegebenen Textes erforscht.

Netzwerk-Framework

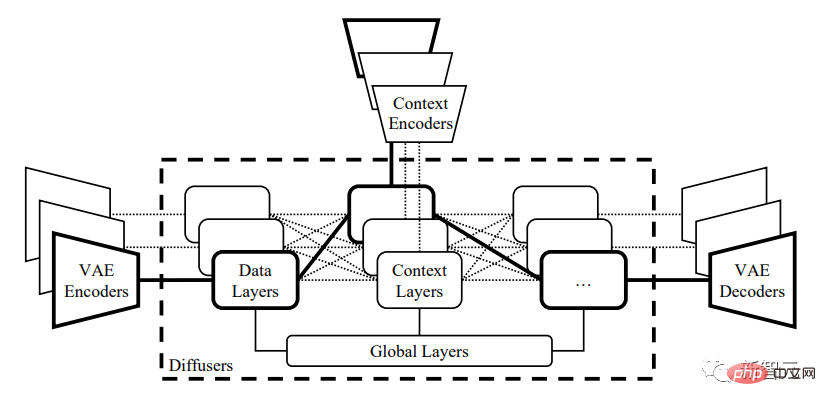

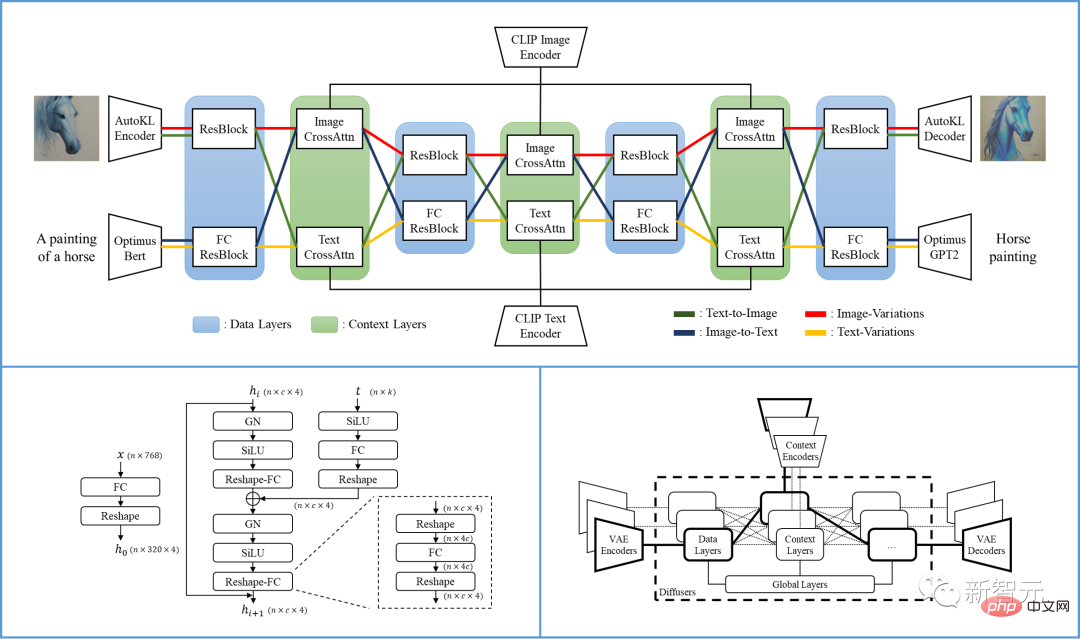

Konkret handelt es sich bei dem im Papier vorgeschlagenen VD-Framework um ein Multi-Stream-Netzwerk mit verschiedenen Datentypen als Eingabe und Hintergrund.

VD Multi-Stream-Multimodal-Diffusions-Framework erbt die Vorteile von LDM/SD, mit interpretierbarem Latentraum, Modalstruktur und niedrigen Rechenkosten.

VD kann mehrere Streams gemeinsam trainieren, wobei jeder Stream eine modalübergreifende Aufgabe darstellt. Sein Kerndesign besteht darin, die Gruppierungs-, Freigabe- und Umschaltprotokolle innerhalb des Netzwerks zu verbreiten und das Framework an alle unterstützten Aufgaben und darüber hinaus anzupassen.

Diffusor ist in drei Gruppen unterteilt: globale Schicht, Datenschicht und Kontextschicht. Die globale Schicht ist die zeitliche Einbettungsschicht, die Datenschicht ist der Restblock und die Kontextschicht ist die Queraufmerksamkeit.

Diese Gruppierung entspricht der Funktionalität der Ebene. Wenn Sie an mehreren Aufgaben arbeiten, wird die globale Ebene von allen Aufgaben gemeinsam genutzt. Die Datenschicht und die Kontextschicht enthalten mehrere Datenflüsse. Jeder Datenstrom kann basierend auf dem aktuellen Daten- und Kontexttyp geteilt oder ausgetauscht werden.

Beim Verarbeiten von Text-Bild-Anfragen verwendet Diffuser beispielsweise die Bilddatenebene und die Textkontextebene. Bei der Bearbeitung von Bildmutationsaufgaben werden die Bilddatenschicht und die Bildkontextschicht verwendet.

Ein einzelner VD-Prozess enthält eine VAE, einen Diffusor und einen Kontextencoder und verarbeitet eine Aufgabe (z. B. Text in Bild) unter einem Datentyp (z. B. Bild) und einem Kontexttyp (z. B. Text).

Die Multi-Stream-Struktur von Versatile Diffusion ist in der folgenden Abbildung dargestellt:

Basierend auf Versatile Diffusion schlugen die Forscher außerdem ein allgemeines Multi-Stream-Multimodal-Framework vor, das VAE und Kontext umfasst Encoder und ein dreischichtiger Diffusor (d. h. globale, Daten- und Kontextschicht).

Diffusor:

VD verwendet das weit verbreitete Cross-Focus-UNet als Hauptarchitektur des Diffusornetzwerks und unterteilt die Schichten in globale Schicht, Datenschicht und Kontextschicht. Die Datenschicht und die Kontextschicht verfügen über zwei Datenströme zur Unterstützung von Bildern und Text.

Für den Bilddatenfluss folgen Sie LDM und verwenden Sie den Restblock (ResBlock), dessen räumliche Dimension allmählich abnimmt und die Anzahl der Kanäle allmählich zunimmt.

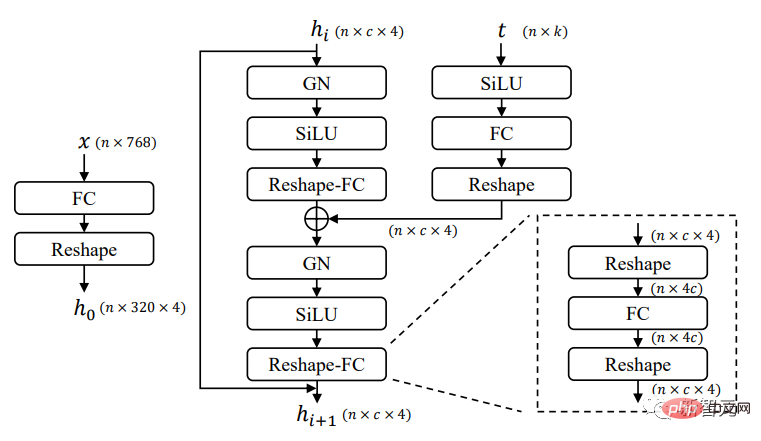

Verwenden Sie für den Textdatenfluss den neuen vollständig verbundenen Restblock (FCResBlock), um den latenten 768-dimensionalen Textvektor in 320 * 4 versteckte Merkmale zu erweitern, und folgen Sie einem ähnlichen Kanalerhöhungsparadigma und verwenden Sie dann GroupNorms, SiLU und Überspringen Sie Verbindungen, genau wie bei normalem ResBlock.

Wie in der Abbildung oben gezeigt, enthält FCResBlock zwei Sätze vollständig verbundener Schichten (FC), Gruppennormalisierung (GN) und Sigmoid-Lineareinheit (SiLU). x ist der latente Code des Eingabetextes, t ist die Einbettungszeit der Eingabe und hi ist das Zwischenmerkmal.

Für Kontextgruppen werden Queraufmerksamkeitsebenen sowohl für Bild- als auch für Kontextströme verwendet, wobei die Einbettung von Inhalten Datenfunktionen über Projektionsebenen, Skalarprodukte und Sigmoide bedient.

Variativer Autoencoder (VAE):

VD verwendet den vorherigen Autoencoder des latenten Diffusionsmodells (Latent Diffusion Model, LDM) -KL als Bilddaten-VAE und Optimus als Text-DataVAE. Optimus besteht aus dem BERT-Text-Encoder und dem GPT2-Text-Decoder, die Sätze bidirektional in 768-dimensionale normalverteilte latente Vektoren umwandeln können.

Gleichzeitig zeigt Optimus mit seinem rekonfigurierbaren und interpretierbaren Textlatenzraum auch zufriedenstellende VAE-Eigenschaften. Daher wurde Optimus als Text-VAE gewählt, da es gut zu den Voraussetzungen eines Multi-Stream-Multimodal-Frameworks passt.

Kontext-Encoder:

VD verwendet CLIP-Text- und Bild-Encoder als Kontext-Encoder. Im Gegensatz zu LDM und SD, die nur Rohtexteinbettungen als Kontexteingabe verwenden, verwendet VD normalisierte und projizierte Einbettungen, um den CLIP-Kontrastverlust von Text und Bildern zu minimieren.

Experimente zeigen, dass ein engerer Einbettungsraum zwischen Kontexttypen dazu beiträgt, dass das Modell schneller konvergiert und eine bessere Leistung erbringt. Ähnliche Schlussfolgerungen lassen sich auch in DALL·E 2 ziehen, das das Text-zu-Bild-Modell mit einer zusätzlichen Projektionsebene verfeinert, um den Unterschied zwischen Text- und Bildeinbettungen für Bildvariationen zu minimieren.

Leistung

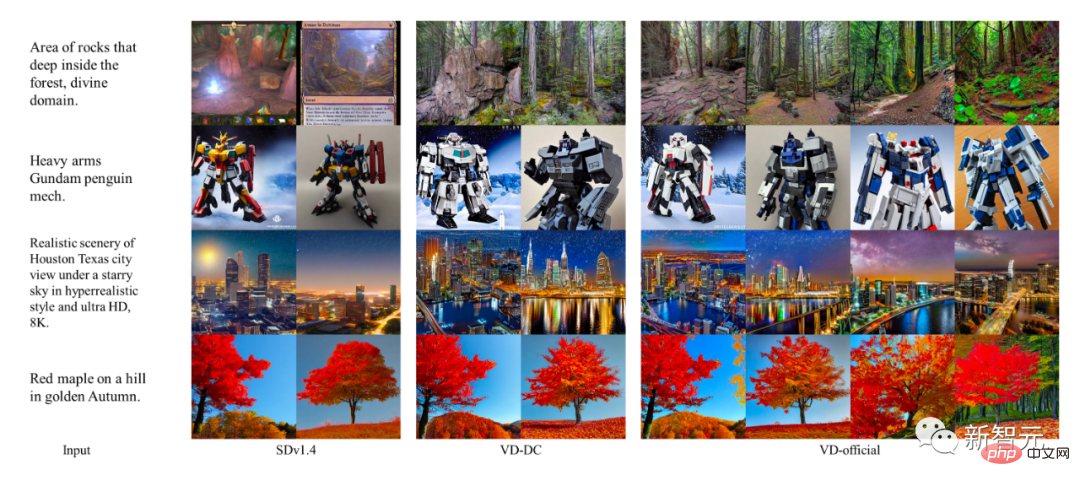

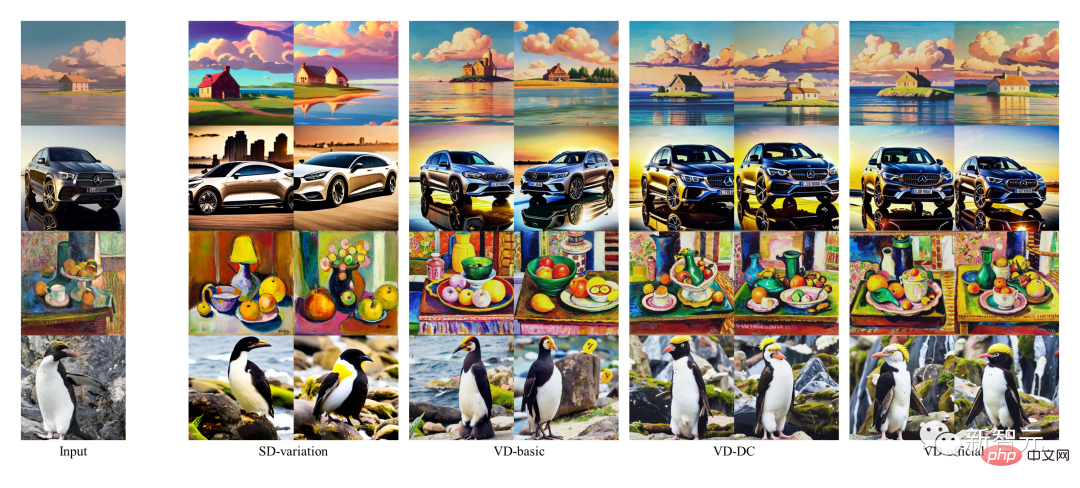

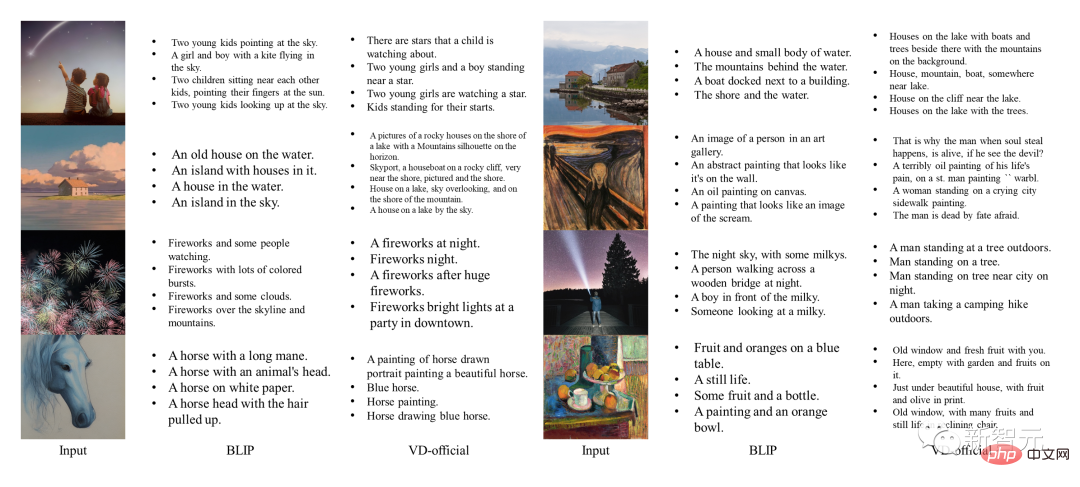

Die Autoren verwendeten frühe Einzelaufgabenmodelle als Basismodelle und verglichen die Ergebnisse von VD mit diesen Basismodellen. Unter diesen wird SDv1.4 als Basismodell von Text zu Bild verwendet, SD-Variation wird für Bildvariation verwendet und BLIP wird für Bildtext verwendet.

Mittlerweile führten die Autoren auch einen qualitativen Vergleich verschiedener VD-Modelle durch, wobei VDDC und VD-official für Text-to-Image und alle drei Modelle für Bildvarianten verwendet wurden.

Die Bildbeispiele von SD und VD werden zur besseren Qualitätsprüfung mit kontrollierten Zufalls-Seeds generiert.

Text-to-Image-Leistung

Während DALLE 2 und Imagen bei diesen Aufgaben ebenfalls Spitzenleistung erzielten, haben die Autoren auf Tests verzichtet, da es keinen öffentlichen Code oder Code gibt Trainingsdetails. Vergleichen.

Die Ergebnisse zeigen, dass Multi-Prozess-Struktur und Multi-Task-Training VD dabei helfen können, kontextuelle Semantik zu erfassen, eine Ausgabe genauer zu generieren und alle Unteraufgaben hervorragend zu erledigen.

Leistung der Bildvariante

Darüber hinaus enthält die von VD generierte Bildanmerkung auch einige kreative Wörter. Im Vergleich dazu ist die Generierung von BLIP sehr kurz und es fehlen Beschreibungen von Details.

Bild-zu-Text-Performance

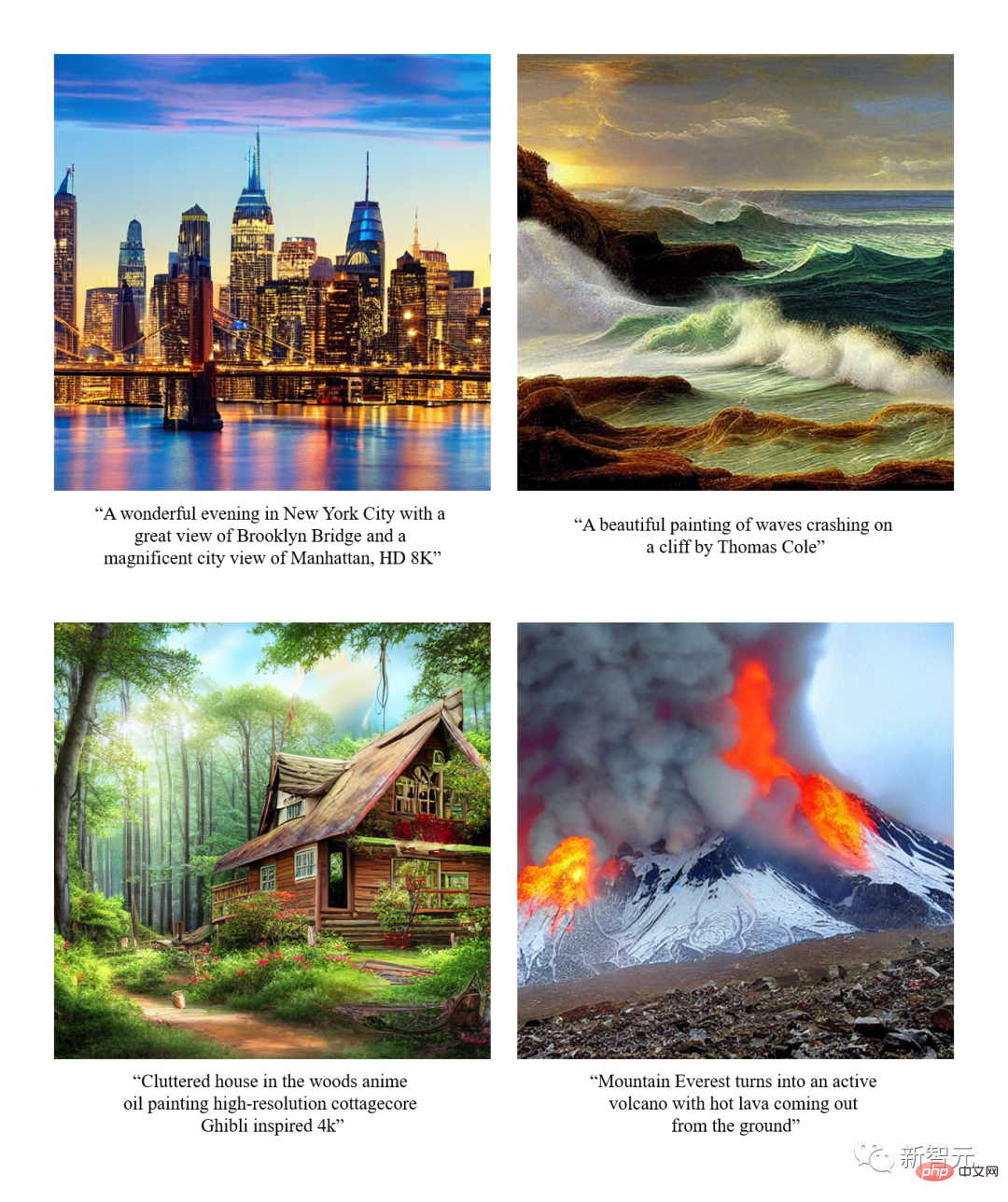

Effektanzeige

Vincent Picture

Bildvarianten

Semantisch fokussierte Bildvarianten

Dual Boot

Zusammenfassung

- Der Autor stellt Versatile Diffusion (VD) vor, a Multi-Stream-Multimodal-Diffusionsnetzwerk, das Text, Bilder und Variationen in einem einheitlichen Modell behandelt. Basierend auf VD stellt der Autor außerdem ein allgemeines multimodales Multi-Stream-Framework vor, das neue Aufgaben und Domänen umfassen kann.

- Durch Experimente hat der Autor herausgefunden, dass VD bei allen unterstützten Aufgaben eine qualitativ hochwertige Ausgabe erzeugen kann, wobei die Ergebnisse von VDs Text-zu-Bild und Bild-zu-Variante die Semantik im Kontext besser erfassen können und VDs Bild- to-text Die Ergebnisse sind kreativ und anschaulich.

- Angesichts der multimodalen Multi-Stream-Eigenschaften von VD stellen die Autoren neuartige Erweiterungen und Anwendungen vor, die nachgeschalteten Benutzern, die an dieser Technologie arbeiten, weiteren Nutzen bringen können.

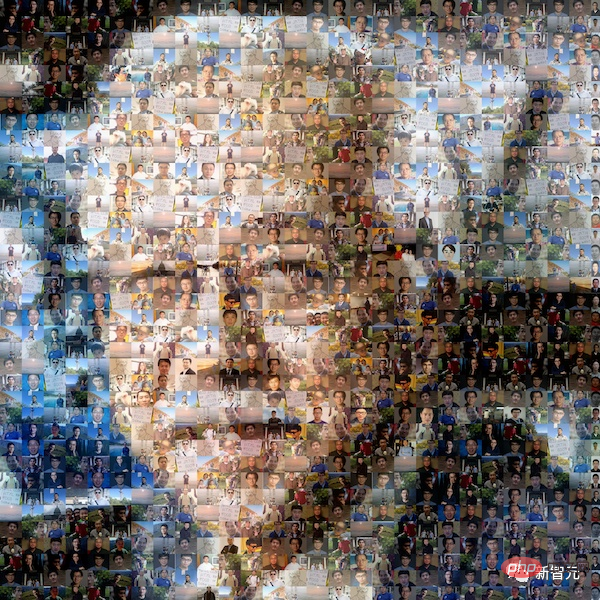

Teamvorstellung

Das IFP-Team an der University of Illinois in Urbana-Champaign wurde in den 1980er Jahren von Professor Huang Xutao gegründet, ursprünglich als Bilderzeugungs- und Verarbeitungsgruppe des Beckman Institute for Advanced Science and Technology.

Im Laufe der Jahre hat sich das IFP der Forschung und Innovation über Bilder hinaus verschrieben, darunter Bild- und Videokodierung, multimodale Mensch-Computer-Interaktion, Multimedia-Annotation und -Suche, Computer Vision und Mustererkennung, maschinelles Lernen, Big Data, Deep Learning und Hochleistungsrechnen.

Die aktuelle Forschungsrichtung des IFP besteht darin, das Problem der multimodalen Informationsverarbeitung durch die gemeinsame Kombination von Big Data, Deep Learning und Hochleistungsrechnen zu lösen.

Darüber hinaus hat IFP mehrere beste Beiträge auf Top-Konferenzen im Bereich der künstlichen Intelligenz gewonnen und zahlreiche internationale Wettbewerbe gewonnen, darunter den ersten NIST TrecVID, die erste ImageNet Challenge und die erste Artificial Intelligence City Challenge.

Interessanterweise gehörten zu den „Mitgliedern“ der IFP-Gruppe, seit Professor Huang in den 1960er Jahren am MIT zu unterrichten begann, sogar Freunde, Studenten, Studenten von Studenten, Studenten von Studenten und sogar Studenten von Studenten von Studenten.

Das obige ist der detaillierte Inhalt vonDas einheitliche AIGC-Modell ist da! Das von Huang Xutao, einem führenden Unternehmen der CV-Branche, gegründete Team schlug „Almighty Diffusion' vor.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr