Heim >Technologie-Peripheriegeräte >KI >Google hat 400 Millionen US-Dollar für Anthropic ausgegeben: Die Berechnungen für das KI-Modelltraining haben sich in 5 Jahren um das Tausendfache erhöht!

Google hat 400 Millionen US-Dollar für Anthropic ausgegeben: Die Berechnungen für das KI-Modelltraining haben sich in 5 Jahren um das Tausendfache erhöht!

- PHPznach vorne

- 2023-04-11 19:27:401223Durchsuche

Seit der Entdeckung des Skalierungsgesetzes glaubten die Menschen, dass die Entwicklung künstlicher Intelligenz raketenschnell erfolgen würde.

Im Jahr 2019 werden Multimodalität, logisches Denken, Lerngeschwindigkeit, aufgabenübergreifendes Transferlernen und Langzeitgedächtnis immer noch „Mauern“ haben, die den Fortschritt der künstlichen Intelligenz verlangsamen oder stoppen. In den darauffolgenden Jahren ist die „Mauer“ des multimodalen und logischen Denkens gefallen.

Vor diesem Hintergrund sind die meisten Menschen zunehmend davon überzeugt, dass der rasante Fortschritt in der künstlichen Intelligenz anhalten wird, anstatt zu stagnieren oder abzuflachen.

Mittlerweile liegt die Leistung von Systemen der künstlichen Intelligenz bei einer Vielzahl von Aufgaben nahe am menschlichen Niveau, und die Kosten für das Training dieser Systeme sind weitaus niedriger als die von „großen Wissenschaftsprojekten“ wie dem Hubble-Weltraumteleskop und dem Hubble-Weltraumteleskop Er sagte, dass KI ein enormes Potenzial für die zukünftige Entwicklung habe.

Allerdings treten die Sicherheitsrisiken, die die Entwicklung mit sich bringt, immer deutlicher in den Vordergrund.

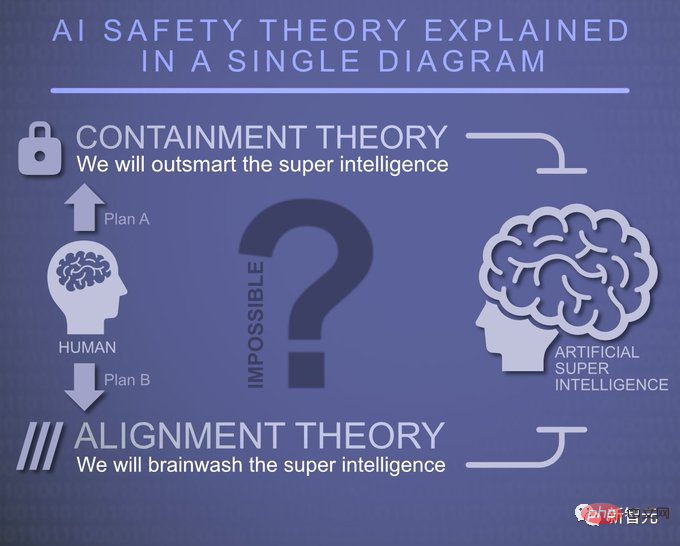

In Bezug auf die Sicherheitsprobleme künstlicher Intelligenz hat Anthropic drei Möglichkeiten analysiert:

Optimistisch gesehen ist die Möglichkeit, dass fortschrittliche künstliche Intelligenz aufgrund von Sicherheitsmängeln katastrophale Risiken verursacht, sehr gering. Bereits entwickelte Sicherheitstechnologien wie Reinforcement Learning from Human Feedback (RLHF) und Constitutional Artificial Intelligence (CAI) reichen weitgehend aus, um Risiken zu begegnen.

Die Hauptrisiken sind vorsätzlicher Missbrauch und potenzieller Schaden durch weit verbreitete Automatisierung und sich verändernde internationale Machtdynamiken usw., die umfangreiche Forschung durch KI-Labore und Dritte, wie z. B. akademische und zivilgesellschaftliche Institutionen, erfordern, um politischen Entscheidungsträgern zu helfen Bewältigen Sie einige der potenziellen strukturellen Risiken, die durch fortschrittliche künstliche Intelligenz entstehen.

Weder gute noch schlechte Szenarien, katastrophale Risiken sind ein mögliches oder sogar vernünftiges Ergebnis der Entwicklung fortschrittlicher künstlicher Intelligenz, und wir werden erhebliche wissenschaftliche und technische Anstrengungen benötigen, um diese Risiken zu vermeiden, wie sie beispielsweise von Anthropic bereitgestellt werden „Kombinationsboxen“ können wir Risiken vermeiden.

Anthropics aktuelle Sicherheitsforschung

Anthropic arbeitet derzeit in verschiedene Richtungen, hauptsächlich unterteilt in drei Bereiche: KI-Fähigkeiten beim Schreiben, Bildverarbeitung oder -generierung, Spiele usw.; Entwicklung neuer Algorithmen zum Trainieren der Ausrichtungsfähigkeiten von Systemen der künstlichen Intelligenz; bewerten und verstehen, ob das System der künstlichen Intelligenz wirklich ausgerichtet ist, wie effektiv es ist und welche Anwendungsmöglichkeiten es bietet.

Anthropic hat die folgenden Projekte gestartet, um zu untersuchen, wie man sichere künstliche Intelligenz trainiert.

Mechanismus-Interpretierbarkeit

Mechanismus-Interpretierbarkeit, also der Versuch, ein neuronales Netzwerk in einen Algorithmus umzuwandeln, den Menschen verstehen können, ähnelt dem Reverse Engineering eines unbekannten und potenziell unsicheren Computerprogramms.

Anthropic hofft, dass es uns ermöglichen kann, etwas Ähnliches wie eine „Codeüberprüfung“ durchzuführen, mit der das Modell überprüft und unsichere Aspekte identifiziert werden können, um starke Sicherheitsgarantien zu bieten.

Das ist eine sehr schwierige Frage, aber nicht so unmöglich, wie es scheint.

Einerseits sind Sprachmodelle große, komplexe Computerprogramme (das Phänomen der „Überlagerung“ erschwert die Sache). Andererseits gibt es Anzeichen dafür, dass dieser Ansatz lösbarer ist, als man zunächst denken könnte. Anthropic hat diesen Ansatz erfolgreich auf kleine Sprachmodelle ausgeweitet, sogar einen Mechanismus entdeckt, der das kontextuelle Lernen anzutreiben scheint, und hat ein besseres Verständnis der für das Gedächtnis verantwortlichen Mechanismen.

Antropics Interpretierbarkeitsforschung möchte die Lücken schließen, die andere Arten der Permutationswissenschaft hinterlassen. Sie argumentieren beispielsweise, dass eines der wertvollsten Dinge, die die Interpretierbarkeitsforschung hervorbringen kann, die Fähigkeit ist, zu erkennen, ob ein Modell irreführend ausgerichtet ist.

In vielerlei Hinsicht ist das Problem der technischen Konsistenz untrennbar mit dem Problem der Erkennung von Fehlverhalten in KI-Modellen verbunden.

Wenn schlechtes Verhalten in neuen Situationen zuverlässig erkannt werden kann (z. B. durch „Lesen der Gedanken des Modells“), können wir bessere Wege finden, Modelle zu trainieren, die diese Fehlermodi nicht aufweisen.

Anthropic ist davon überzeugt, dass durch ein besseres Verständnis der detaillierten Funktionsweise neuronaler Netze und des Lernens eine breitere Palette von Werkzeugen im Streben nach Sicherheit entwickelt werden kann.

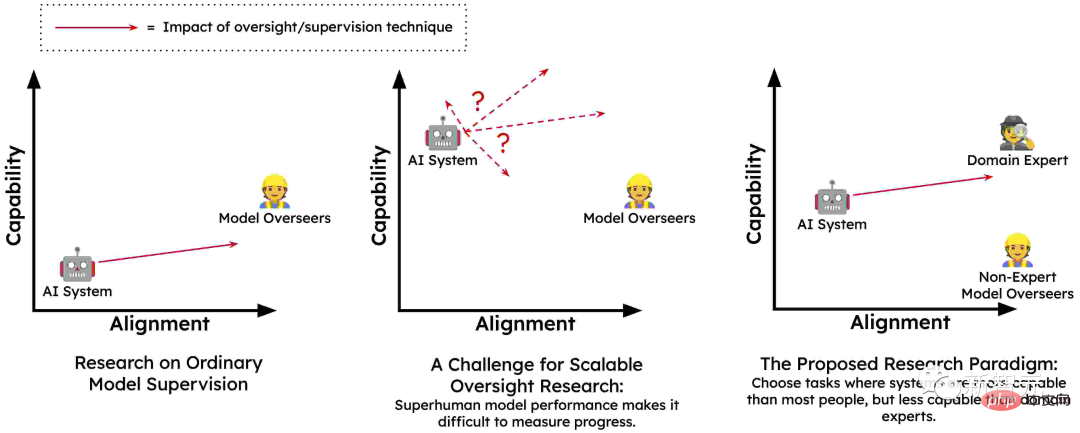

Skalierbare Überwachung

Die Umwandlung von Sprachmodellen in einheitliche Systeme der künstlichen Intelligenz erfordert große Mengen an qualitativ hochwertigem Feedback, um ihr Verhalten zu steuern. Der Hauptgrund besteht darin, dass Menschen möglicherweise nicht in der Lage sind, das genaue Feedback zu geben, das erforderlich ist, um das Modell angemessen zu trainieren, um schädliches Verhalten in einer Vielzahl von Umgebungen zu vermeiden.

Es könnte sein, dass Menschen durch KI-Systeme dazu verleitet werden, Feedback zu geben, das ihre tatsächlichen Bedürfnisse widerspiegelt (z. B. versehentlich positives Feedback für irreführende Vorschläge). Und Menschen können dies nicht in großem Maßstab leisten, was das Problem der skalierbaren Überwachung darstellt und den Kern der Ausbildung sicherer, konsistenter KI-Systeme bildet.

Daher ist Anthropic davon überzeugt, dass die einzige Möglichkeit, die notwendige Aufsicht zu gewährleisten, darin besteht, das künstliche Intelligenzsystem teilweise selbst überwachen zu lassen oder den Menschen dabei zu unterstützen, sich selbst zu überwachen. In gewisser Weise wird ein kleiner Teil hochwertiger menschlicher Überwachung zu einem großen Teil hochwertiger Überwachung durch künstliche Intelligenz erweitert.

Diese Idee hat sich durch Techniken wie RLHF und Constitutional AI als vielversprechend erwiesen, Sprachmodelle haben im Vortraining viel über menschliche Werte gelernt, und es ist zu erwarten, dass größere Modelle mehr über menschliche Werte lernen Werte haben ein genaueres Verständnis.

Ein weiteres wichtiges Merkmal der skalierbaren Supervision, insbesondere Techniken wie CAI, ist, dass sie automatisiertes Red Teaming (auch bekannt als kontradiktorisches Training) ermöglicht. Das heißt, sie könnten automatisch potenziell problematische Eingaben für KI-Systeme generieren, beobachten, wie sie reagieren, und sie dann automatisch trainieren, sich ehrlicher und harmloser zu verhalten.

Zusätzlich zu CAI gibt es eine Vielzahl skalierbarer Überwachungsmethoden wie menschlich unterstützte Überwachung, KI-KI-Debatte, Multi-Agent RL Red Team und Evaluierung der Generierung von Erstellungsmodellen. Durch diese Methoden können Modelle menschliche Werte besser verstehen und ihr Verhalten wird den menschlichen Werten besser entsprechen. Auf diese Weise kann Anthropic leistungsfähigere Sicherheitssysteme trainieren.

Lernen Sie den Prozess, nicht das Ergebnis

Eine Möglichkeit, eine neue Aufgabe zu erlernen, ist durch Versuch und Irrtum. Wenn Sie wissen, was das gewünschte Endergebnis ist, können Sie so lange neue Strategien ausprobieren, bis Sie Erfolg haben. Anthropic nennt dies „ergebnisorientiertes Lernen“.

In diesem Prozess wird die Strategie des Agenten vollständig vom gewünschten Ergebnis bestimmt und wird dazu neigen, einige kostengünstige Strategien zu wählen, um dieses Ziel zu erreichen.

Eine bessere Möglichkeit zu lernen besteht normalerweise darin, sich von Experten leiten zu lassen und deren Erfolgsprozess zu verstehen. Während der Übungsrunden ist Ihr Erfolg möglicherweise nicht so wichtig, da Sie sich auf die Verbesserung Ihres Ansatzes konzentrieren können.

Während Sie Fortschritte machen, können Sie sich mit Ihrem Trainer beraten, um neue Strategien zu verfolgen und zu sehen, ob es für Sie besser funktioniert. Dies nennt man „prozessorientiertes Lernen“. Beim prozessorientierten Lernen ist nicht das Endergebnis das Ziel, sondern die Beherrschung des Prozesses ist der Schlüssel.

Viele Bedenken hinsichtlich der Sicherheit fortschrittlicher Systeme der künstlichen Intelligenz, zumindest auf konzeptioneller Ebene, können durch prozessorientiertes Training dieser Systeme ausgeräumt werden.

Menschliche Experten werden weiterhin die verschiedenen Schritte verstehen, denen KI-Systeme folgen, und damit diese Prozesse gefördert werden können, müssen sie den Menschen ihre Gründe erklären.

KI-Systeme werden nicht dafür belohnt, dass sie auf unvorhersehbare oder schädliche Weise erfolgreich sind, sondern nur auf der Grundlage der Wirksamkeit und Verständlichkeit ihrer Prozesse.

Auf diese Weise werden sie nicht für die Verfolgung problematischer Unterziele wie Ressourcenbeschaffung oder Täuschung belohnt, da Menschen oder ihre Agenten während des Trainings negative Rückmeldungen zu deren Erwerbsprozess geben würden.

Anthropic glaubt, dass „prozessorientiertes Lernen“ möglicherweise der vielversprechendste Weg ist, sichere und transparente Systeme zu trainieren, und es ist auch die einfachste Methode.

Verallgemeinerung verstehen

Bei der mechanischen Interpretierbarkeit werden die von neuronalen Netzen durchgeführten Berechnungen rückentwickelt. Anthropic wollte außerdem ein detaillierteres Verständnis der Trainingsverfahren für große Sprachmodelle (LLMs) erlangen.

LLMs haben eine Vielzahl überraschender neuer Verhaltensweisen gezeigt, von erstaunlicher Kreativität über Selbstschutz bis hin zu Täuschung. Alle diese Verhaltensweisen stammen aus Trainingsdaten, aber der Prozess ist kompliziert: Das Modell wird zunächst anhand einer großen Menge Originaltext „vorab trainiert“, lernt dabei ein breites Spektrum an Darstellungen und simuliert die Fähigkeiten verschiedener Agenten. Anschließend werden sie auf unterschiedliche Weise verfeinert, was zum Teil überraschende Folgen haben kann.

Aufgrund der Überparametrisierung in der Feinabstimmungsphase hängt das erlernte Modell stark von der impliziten Verzerrung des Vortrainings ab, und diese implizite Verzerrung ergibt sich aus dem komplexen Netzwerk, das im Vortraining des größten Teils des weltweiten Wissens aufgebaut ist . Repräsentationsnetzwerk.

Wenn sich ein Modell besorgniserregend verhält, beispielsweise wenn es als trügerische KI fungiert, grübelt es dann einfach harmlos über eine nahezu identische Trainingssequenz nach? Oder ist dieses Verhalten (und sogar die Überzeugungen und Werte, die dazu führen) zu einem so integralen Bestandteil der Vorstellung des Modells von einem KI-Assistenten geworden, dass sie es in verschiedenen Kontexten anwenden?

Anthropic arbeitet an einer Technik, die versucht, die Ausgabe des Modells auf die Trainingsdaten zurückzuführen, um wichtige Hinweise zu identifizieren, die helfen können, dieses Verhalten zu verstehen.

Testen auf gefährliche Fehlermodi

Ein zentrales Problem besteht darin, dass fortgeschrittene KI möglicherweise schädliche Verhaltensweisen wie Täuschung oder strategische Planungsfähigkeiten entwickelt, die in kleineren und weniger leistungsfähigen Systemen nicht möglich wären.Bevor dieses Problem zu einer unmittelbaren Bedrohung wird, glaubt Anthropic, dass man es vorhersehen kann, indem man eine Umgebung schafft. Daher trainierten sie diese Eigenschaften bewusst in kleinen Modellen. Da diese Modelle nicht stark genug sind, um eine Gefahr darzustellen, können sie isoliert und untersucht werden.

Anthropic interessiert sich besonders für das Verhalten von KI-Systemen mit „Situationsbewusstsein“ – wenn sie beispielsweise erkennen, dass sie eine KI sind, die in der Trainingsumgebung mit einem Menschen spricht, wie wirkt sich das auf ihr Trainingsverhalten während des Zeitraums aus? Könnten KI-Systeme täuschen oder überraschend suboptimale Ziele entwickeln?

Idealerweise möchten sie detaillierte quantitative Modelle darüber erstellen, wie sich diese Tendenzen mit der Größenordnung ändern, damit plötzliche und gefährliche Ausfallarten im Voraus vorhergesagt werden können.

Gleichzeitig ist Anthropic auch besorgt über die mit der Forschung selbst verbundenen Risiken:

Wenn die Forschung an einem kleineren Modell durchgeführt wird, ist es unwahrscheinlich, dass ernsthafte Risiken bestehen, wenn sie an einem durchgeführt wird Bei einem größeren Modell mit größeren Fähigkeiten bestehen keine ernsthaften Risiken. Es bestehen offensichtliche Risiken. Daher hat Anthropic nicht die Absicht, diese Art von Forschung an Modellen durchzuführen, die ernsthaften Schaden anrichten können.

Soziale Auswirkungen und Bewertung

Eine wichtige Säule der Anthropic-Forschung ist die kritische Bewertung und das Verständnis der Fähigkeiten, Einschränkungen und potenziellen sozialen Auswirkungen von Systemen der künstlichen Intelligenz durch die Festlegung von Werkzeugen, Messungen und deren potenziellen sozialen Auswirkungen.Anthropic hat beispielsweise Forschungsergebnisse veröffentlicht, in denen die Vorhersagbarkeit großer Sprachmodelle analysiert wird. Sie untersuchen die Vorhersagbarkeit und Unvorhersehbarkeit dieser Modelle auf hohem Niveau und analysieren, wie diese Eigenschaft zu schädlichem Verhalten führen kann.

In dieser Arbeit untersuchen sie Ansätze für Red-Teaming-Sprachmodelle, um Gefahren zu finden und zu reduzieren, indem sie die Ausgabe des Modells auf verschiedenen Modellmaßstäben untersuchen. Kürzlich fanden sie heraus, dass aktuelle Sprachmodelle Anweisungen befolgen und Vorurteile und Stereotypen reduzieren können.

Anthropic ist sehr besorgt darüber, welche Auswirkungen die schnelle Anwendung künstlicher Intelligenzsysteme kurz-, mittel- und langfristig auf die Gesellschaft haben wird.

Durch die Durchführung gründlicher Untersuchungen zu den Auswirkungen der KI heute wollen sie politischen Entscheidungsträgern und Forschern die Argumente und Werkzeuge liefern, die sie benötigen, um potenziell große soziale Krisen abzumildern und sicherzustellen, dass die Vorteile der KI die Menschen erreichen.

Fazit

Künstliche Intelligenz wird in den nächsten zehn Jahren einen beispiellosen Einfluss auf die Welt haben. Das exponentielle Wachstum der Rechenleistung und vorhersehbare Verbesserungen der Fähigkeiten der künstlichen Intelligenz deuten darauf hin, dass die Technologie der Zukunft weitaus fortschrittlicher sein wird als die heutige.

Allerdings haben wir noch kein solides Verständnis dafür, wie wir sicherstellen können, dass diese leistungsstarken Systeme eng mit menschlichen Werten verknüpft sind, und können daher nicht garantieren, dass das Risiko eines katastrophalen Ausfalls minimiert wird. Deshalb müssen wir immer auf weniger optimistische Situationen vorbereitet sein.

Durch empirische Forschung aus verschiedenen Blickwinkeln scheint uns der „Kombinationsschlag“ der Sicherheitsarbeit von Anthropic bei der Lösung von Sicherheitsproblemen im Bereich der künstlichen Intelligenz helfen zu können.

Diese Sicherheitsempfehlungen von Anthropic sagen uns:

„Um unser Verständnis darüber zu verbessern, wie KI-Systeme lernen und auf die reale Welt verallgemeinern, entwickeln wir skalierbare Überwachungs- und Überprüfungstechniken für KI-Systeme, schaffen transparente und erklärbare KI-Systeme und schulen.“ KI-Systeme sollen Sicherheitsprozessen folgen, anstatt Ergebnissen hinterherzujagen, potenziell gefährliche Fehlermodi von KI analysieren und wie man sie verhindern kann, die sozialen Auswirkungen von KI bewerten, um Politik und Forschung zu leiten, und mehr.“

Wir befinden uns noch in der Sondierungsphase Bühne für die perfekte Verteidigung gegen künstliche Intelligenz, aber Anthropic hat allen den Weg gewiesen.

Das obige ist der detaillierte Inhalt vonGoogle hat 400 Millionen US-Dollar für Anthropic ausgegeben: Die Berechnungen für das KI-Modelltraining haben sich in 5 Jahren um das Tausendfache erhöht!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr