Heim >Technologie-Peripheriegeräte >KI >Über 580 Milliarden US-Dollar! Der Kampf zwischen Microsoft und Google hat den Marktwert von Nvidia in die Höhe schnellen lassen, etwa 5 Intel

Über 580 Milliarden US-Dollar! Der Kampf zwischen Microsoft und Google hat den Marktwert von Nvidia in die Höhe schnellen lassen, etwa 5 Intel

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 16:31:031537Durchsuche

ChatGPT ist in der Hand und Sie können alle Ihre Fragen beantworten.

Wissen Sie, der Rechenaufwand für jedes Gespräch damit ist einfach atemberaubend.

Zuvor sagten Analysten, dass die einmalige Beantwortung von ChatGPT 2 Cent kostet.

Sie müssen wissen, dass die für Chatbots mit künstlicher Intelligenz erforderliche Rechenleistung von GPUs bereitgestellt wird.

Dadurch machen Chip-Unternehmen wie NVIDIA einfach ein Vermögen.

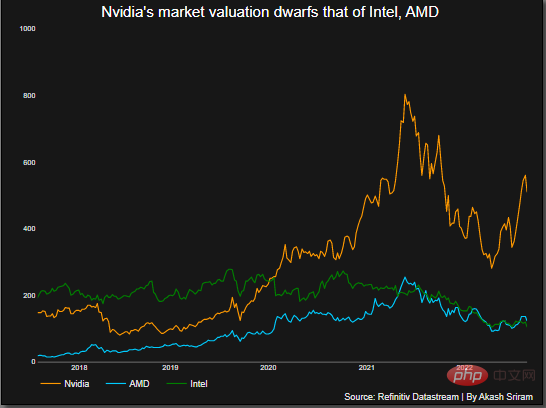

Am 23. Februar schoss der Aktienkurs von NVIDIA in die Höhe und steigerte seinen Marktwert um mehr als 70 Milliarden US-Dollar. Der Gesamtmarktwert überstieg 580 Milliarden US-Dollar, was etwa dem Fünffachen von Intel entspricht.

Neben NVIDIA kann AMD mit einem Marktanteil von etwa 20 % als zweitgrößter Hersteller in der Grafikprozessorbranche bezeichnet werden.

Und Intel hält weniger als 1 % Marktanteil.

ChatGPT läuft und NVIDIA verdient Geld

Da ChatGPT potenzielle Anwendungsfälle erschließt, könnte dies einen weiteren Wendepunkt bei Anwendungen der künstlichen Intelligenz einläuten.

Warum sagst du das?

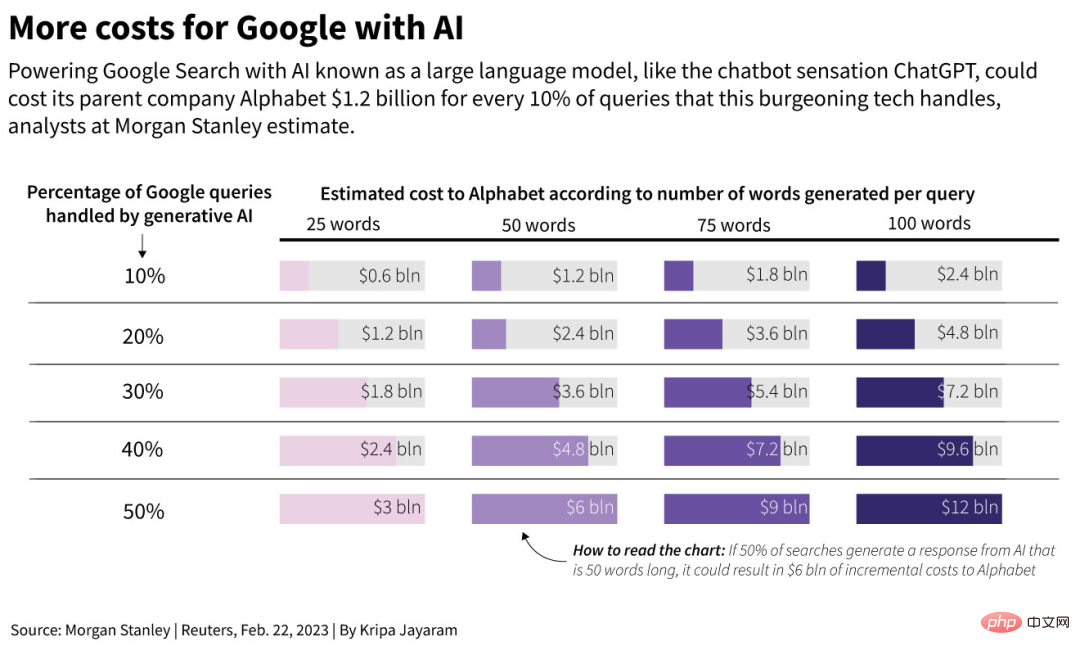

John Hennessy, Vorsitzender von Alphabet, der Muttergesellschaft von Google, sagte in einem Interview mit Reuters, dass die Kosten für Konversationen mit künstlicher Intelligenz wie großen Sprachmodellen mehr als zehnmal höher sein könnten als bei herkömmlichen Suchmaschinen.

Die Analyse von Morgan Stanley zeigt, dass Google im vergangenen Jahr insgesamt 3,3 Billionen Suchanfragen durchgeführt hat und die Kosten für jede Suche nur 0,2 Cent betrugen.

Es wird geschätzt, dass die möglichen Kosten des Unternehmens im Jahr 2024 steigen werden, wenn Googles Chatbot Bard in die Suchmaschine eingeführt und zur Bearbeitung der Hälfte der Suchanfragen und Fragen von Google verwendet wird, basierend auf 50 Wörtern pro Antwort Erhöhung um 6 Milliarden US-Dollar.

Ähnlich sagte SemiAnalysis, ein auf Chip-Technologie spezialisiertes Beratungsunternehmen, dass das Hinzufügen von Chatbots zu Suchmaschinen aufgrund der Auswirkungen von Googles internen Chips wie Tensor Processing Units Google zusätzliche 3 Milliarden US-Dollar kosten könnte.

Er glaubt, dass Google die Betriebskosten einer solchen künstlichen Intelligenz senken muss, aber dieser Prozess ist nicht einfach und wird im schlimmsten Fall mehrere Jahre dauern.

Deshalb erfordert die Suche durch KI-Sprachmodelle mehr Rechenleistung als herkömmliche Suchen.

Analysten gehen davon aus, dass die zusätzlichen Kosten in den kommenden Jahren Milliarden von Dollar betragen könnten.

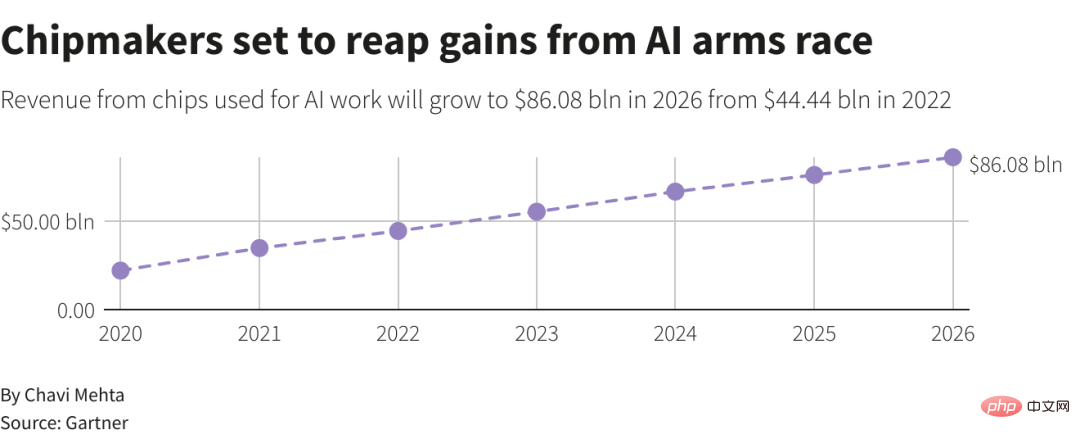

Gartner prognostiziert, dass der Anteil professioneller Chips wie GPUs, die in Rechenzentren verwendet werden, bis 2026 voraussichtlich um mehr als 15 % steigen wird, verglichen mit weniger als 3 % im Jahr 2020.

Obwohl es schwierig ist, genau zu bestimmen, wie viel von Nvidias Umsatz KI heute ausmacht, hat sie das Potenzial, exponentiell zu wachsen, da große Technologieunternehmen um die Entwicklung ähnlicher KI-Anwendungen konkurrieren.

Am Mittwoch kündigte Nvidia außerdem einen Cloud-Dienst für künstliche Intelligenz an und verpflichtete sich zur Zusammenarbeit mit Oracle, Microsoft und Google, um ihm die Möglichkeit zu geben, Nvidia GTX für die Verarbeitung künstlicher Intelligenz durch einfachen Browserzugriff zu nutzen.

Diese neue Plattform wird von anderen Cloud-Dienstanbietern bereitgestellt und Technologieunternehmen helfen, die nicht über die Infrastruktur verfügen, um eine eigene aufzubauen.

Huang Renxun sagte: „Die Begeisterung der Menschen für ChatGPT hat es Führungskräften ermöglicht, die Leistungsfähigkeit der künstlichen Intelligenz zu erkennen. Heute handelt es sich jedoch hauptsächlich um eine Allzwecksoftware. Die Erkenntnis ihres wahren Werts.“ Es muss immer noch auf die eigenen Bedürfnisse des Unternehmens zugeschnitten sein, um seine Dienstleistungen und Produkte zu verbessern Aktie.

Im Philadelphia Stock Exchange Semiconductor Index sind die Nvidia-Aktien in diesem Jahr um 42 % gestiegen und schneiden am besten ab.

Investoren strömen in Nvidia und setzen darauf, dass die Nachfrage nach künstlichen Intelligenzsystemen wie ChatGPT die Bestellungen für die Produkte des Unternehmens in die Höhe treiben und es erneut zum wertvollsten Chiphersteller der Welt machen wird.

Egal, ob es sich um das Top-ChatGPT oder Modelle wie Bard und Stable Diffusion handelt, die Rechenleistung wird seit langem von einem Chip Nvidia A100 im Wert von rund 10.000 US-Dollar bereitgestellt.

Der NVIDIA A100 ist in der Lage, viele einfache Berechnungen gleichzeitig durchzuführen, was für das Training und die Verwendung neuronaler Netzwerkmodelle sehr wichtig ist.

Die Technologie hinter dem A100 wurde ursprünglich zum Rendern komplexer 3D-Grafiken in Spielen verwendet. Das Ziel besteht nun darin, maschinelle Lernaufgaben zu bewältigen und in Rechenzentren auszuführen.

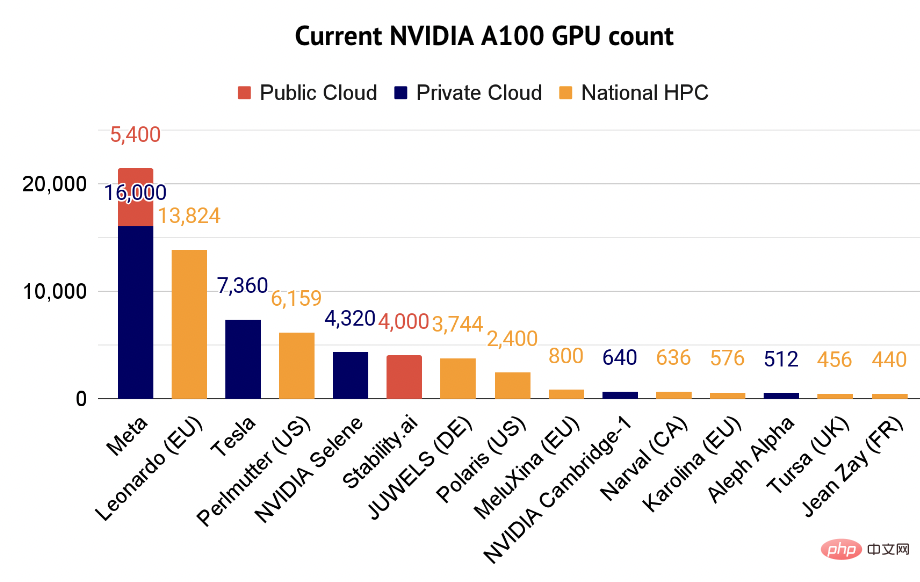

Investor Nathan Benaich sagte, dass A100 mittlerweile zum „Hauptarbeitstier“ von Fachleuten für künstliche Intelligenz geworden sei. In seinem Bericht werden auch einige Unternehmen aufgeführt, die den Supercomputer A100 nutzen.

Aufgaben des maschinellen Lernens können die Rechenleistung Ihres gesamten Computers verbrauchen, manchmal für Stunden oder Tage.

Das bedeutet, dass Unternehmen mit einem meistverkauften KI-Produkt oft mehr GPUs kaufen müssen, um Spitzenzugriffszeiten zu bewältigen oder ihre Modelle zu verbessern.

Zusätzlich zu einem einzelnen A100 auf einer Karte, die an einen vorhandenen Server angeschlossen werden kann, verwenden viele Rechenzentren ein System aus 8 A100-GPUs.

Dieses System ist Nvidia DGX A100 und ein einzelnes System wird für bis zu 200.000 US-Dollar verkauft.

Nvidia gab am Mittwoch bekannt, dass es den Cloud-Zugriff auf DGX-Systeme direkt verkaufen wird, was möglicherweise die Eintrittskosten für Forscher senkt.

Was kostet es also, die neue Version von Bing auszuführen? Eine Auswertung von New Street Research ergab, dass das OpenAI-basierte ChatGPT-Modell in der Bing-Suche möglicherweise 8 GPUs erfordert, um eine Antwort auf eine Frage in weniger als einer Sekunde zu geben. Bei diesem Tempo bräuchte Microsoft über 20.000 8-GPU-Server, um dieses Modell in jedermanns Hand bereitzustellen. Dann könnte Microsoft 4 Milliarden US-Dollar für Infrastrukturausgaben ausgeben. Das ist nur Microsoft. Wenn es die tägliche Abfrageskala von Google erreichen will, die täglich 8 bis 9 Milliarden Abfragen bereitstellen soll, muss es 80 Milliarden US-Dollar ausgeben. Ein weiteres Beispiel: Die neueste Version von Stable Diffusion läuft auf 256 A100-Grafikprozessoren oder 32 DGX A100 für 200.000 Rechenstunden. Mostaque, CEO von Stability AI, sagte, dass es auf der Grundlage der Marktpreise allein 600.000 US-Dollar kosten würde, das Modell zu trainieren. Der Preis ist im Vergleich zur Konkurrenz sehr erschwinglich. Darin sind die Kosten für die Ableitung oder Bereitstellung des Modells nicht enthalten. Huang Renxun sagte in einem Interview: In Bezug auf den für diese Art von Modell erforderlichen Berechnungsaufwand sind die Produkte von Stability AI tatsächlich nicht teuer. Wir haben ein Rechenzentrum genommen, dessen Betrieb eine Milliarde US-Dollar gekostet hätte, und haben es auf ein 100-Millionen-Dollar-Rechenzentrum verkleinert. Wenn dieses 100-Millionen-Dollar-Rechenzentrum nun in der Cloud platziert und von 100 Unternehmen gemeinsam genutzt wird, ist es nichts. Mit der NVIDIA-GPU können Start-ups Modelle zu geringeren Kosten trainieren. Jetzt können Sie für etwa 10 bis 20 Millionen US-Dollar ein großes Sprachmodell wie GPT erstellen. Es ist wirklich, wirklich erschwinglich. Der State of Artificial Intelligence Report 2022 besagt, dass mit Stand Dezember 2022 mehr als 21.000 Open-Source-KI-Artikel NVIDIA-Chips verwenden. Die meisten Forscher im State of AI Compute Index verwenden den 2017 eingeführten NVIDIA-Chip V100, aber der A100 wird im Jahr 2022 schnell wachsen und zum dritthäufigsten verwendeten Chip werden.

Die schärfste Konkurrenz des A100 dürfte sein Nachfolger H100 sein, der 2022 auf den Markt kommt und mit der Massenproduktion begonnen hat. Tatsächlich sagte Nvidia am Mittwoch, dass der Umsatz des H100 im Quartal, das im Januar endete, den des A100 überstieg.

Derzeit fährt Nvidia mit dem Schnellzug der KI und sprintet in Richtung „Geld“.

Das obige ist der detaillierte Inhalt vonÜber 580 Milliarden US-Dollar! Der Kampf zwischen Microsoft und Google hat den Marktwert von Nvidia in die Höhe schnellen lassen, etwa 5 Intel. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr