Heim >Technologie-Peripheriegeräte >KI >Ein neues Paradigma für Offline-Lernen zur Verstärkung! JD.com und die Tsinghua University schlagen einen entkoppelten Lernalgorithmus vor

Ein neues Paradigma für Offline-Lernen zur Verstärkung! JD.com und die Tsinghua University schlagen einen entkoppelten Lernalgorithmus vor

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 16:22:031108Durchsuche

Der Offline-Lernalgorithmus für Verstärkung (Offline RL) ist eine der beliebtesten Unterrichtungen des Lernens für Verstärkung. Offline-Lernen zur Verstärkung interagiert nicht mit der Umgebung und zielt darauf ab, Zielrichtlinien aus zuvor aufgezeichneten Daten zu lernen. Offline-Bestärkendes Lernen ist im Vergleich zu Online-Bestärkendes Lernen (Online RL) besonders attraktiv in Bereichen, in denen die Datenerfassung teuer oder gefährlich ist, in denen jedoch möglicherweise große Datenmengen vorhanden sind (z. B. Robotik, industrielle Steuerung, autonomes Fahren).

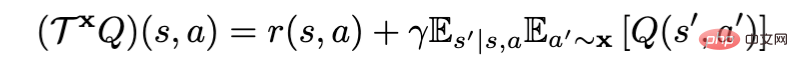

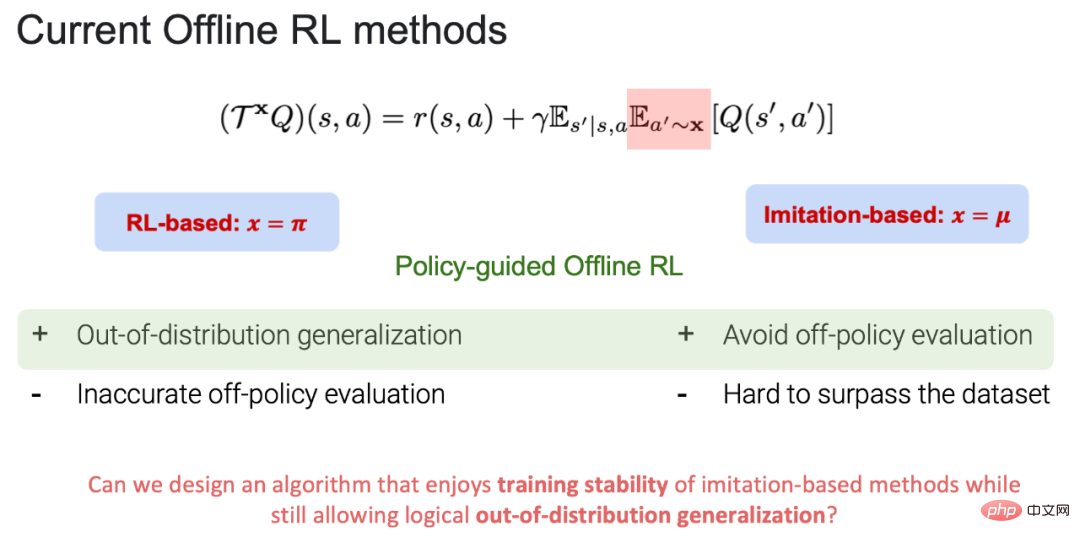

Bei Verwendung des Bellman-Richtlinienbewertungsoperators für die Richtlinienbewertung kann der aktuelle Offline-Lernalgorithmus zur Verstärkung in RL-basiert (x=π) und imitationsbasiert (x=μ) unterteilt werden, wobei π der ist Zielstrategie und μ ist die Verhaltensstrategie (Hinweis: Zielstrategie: die Strategie zum Lernen und Aktualisieren; Verhaltensstrategie: die Strategie in Offline-Daten). Derzeit haben sowohl RL-basiert als auch Imitationsbasiert ihre eigenen Vor- und Nachteile:

1 RL-basierter Vorteil: Es kann über die Daten hinaus verallgemeinert werden und schließlich das Ziel erreichen, eine Zielstrategie zu erlernen, die über Verhaltensstrategien hinausgeht. Nachteile: Es besteht ein Kompromiss zwischen einer genauen Wertschätzung bei der Richtlinienbewertung (mehr Verhaltensregulierung) und einer Richtlinienverbesserung (weniger Verhaltensregulierung). Wenn während des Richtlinienbewertungsprozesses eine Aktion außerhalb der Datenverteilung ausgewählt wird, kann die Aktionswertfunktion (Aktionszustandswert) nicht genau geschätzt werden, was letztendlich zum Scheitern des Zielrichtlinienlernens führt.

2.Imitationsbasierter Vorteil: Da im Prozess der Richtlinienbewertung alle Aktionen innerhalb der Datenverteilung erfolgen, kann dies nicht nur Stabilität in das Training bringen, sondern auch eine Richtlinienbewertung außerhalb der Datenverteilung vermeiden und lernen enge Verhaltensweisen Die besten Strategien in der Strategiebibliothek. Nachteile: Da alle Aktionen innerhalb der Datenverteilung durchgeführt werden, ist es schwierig, die in den Originaldaten vorhandenen Verhaltensstrategien zu übertreffen.

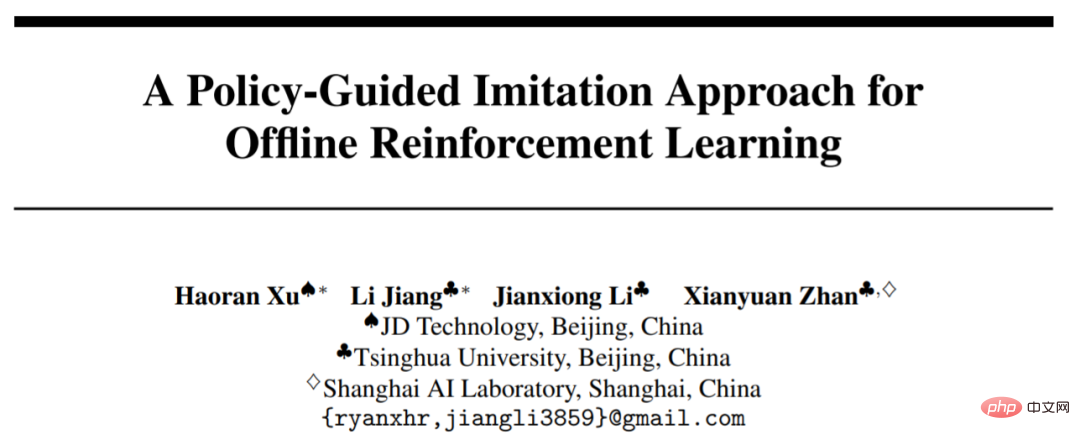

POR Auf dieser Grundlage können nicht nur Kompromisse im Strategiebewertungsprozess vermieden werden, sondern es besteht auch die Möglichkeit, außerhalb der Daten zu verallgemeinern. Diese Arbeit wurde von NeurIPS 2022 angenommen und zu einer mündlichen Präsentation eingeladen. Das Papier und der Code waren Open Source.

- Papier: https://arxiv.org/abs/2210.08323

- Code: https://github.com/ryanxhr/POR

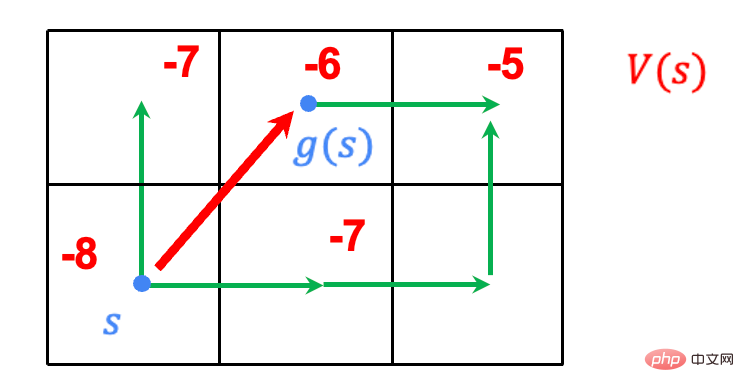

. Staat- Stitching vs. Action-Stitching

- Aufgabe: Gehen Sie durch das Raster, der Endpunkt ist in der oberen rechten Ecke und der Startpunkt ist in der unteren rechten Ecke. Finden Sie den kürzesten Weg vom Startpunkt zum Endpunkt.

- Regel: Der Agent kann die acht Gitter um ihn herum in einem beliebigen Gitter auswählen und wird am Ende mit 1 belohnt, und alle anderen Verhaltensbelohnungen sind 0.

- Daten: Der grüne Wanderweg sind die vorhandenen Wegdaten.

Frühere imitationsbasierte Algorithmen verwendeten alle Action-Stitching: das Zusammenfügen der in den Daten verfügbaren Trajektorien, um ein gezieltes politisches Lernen zu erreichen. Beispielsweise ist die blaue Flugbahn im Video die beste Flugbahn, die durch Action-Stitching erlernt werden kann. Sie kann jedoch außerhalb der Daten nicht effektiv verallgemeinert werden, um die Zielstrategie über die Verhaltensstrategie in den Daten hinaus zu lernen. Allerdings kann POR die Zielstrategie durch ein entkoppeltes Lernparadigma effektiv verallgemeinern und damit die Leistung von Verhaltensstrategien übertreffen.

Wie implementiert man State-Stitching?

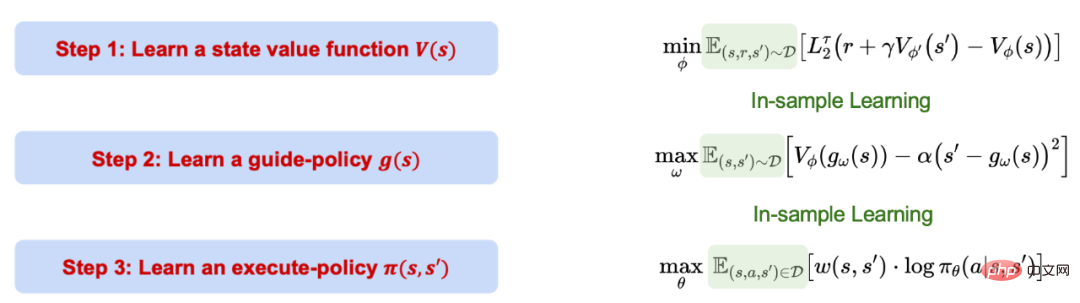

Der richtliniengesteuerte Offline-RL-Lernprozess (POR) ist in drei Schritte unterteilt, die voneinander getrennt sind und sich nicht gegenseitig beeinflussen. Es ist erwähnenswert, dass der gesamte Prozess von POR auf imitationsbasiertem Lernen, also Lernen in der Stichprobe, basiert und den Wert von Aktionen außerhalb der Datenverteilung nicht bewertet.

1. Verwenden Sie die Quantilregression, um die Konfidenzobergrenze der Wertfunktion zu ermitteln.

2. Verwenden Sie die Lernwertfunktion, um eine Führungsstrategie zu erlernen, die bei gegebenem aktuellen Zustand die nächste(n) optimale(n) Zustandsposition(en) innerhalb der Stichprobe generieren kann. Letzteres Element dient als Einschränkung, um sicherzustellen, dass der generierte Zustand die MDP-Bedingung erfüllt.

3. Nutzen Sie alle Beispiele in den Daten, um eine Ausführungsstrategie zu erlernen, die den aktuellen Zustand(en) und den nächsten Zustand(en) angibt. Anschließend den richtigen Es können Maßnahmen ergriffen werden, um vom aktuellen Zustand zum nächsten Zustand zu gelangen.

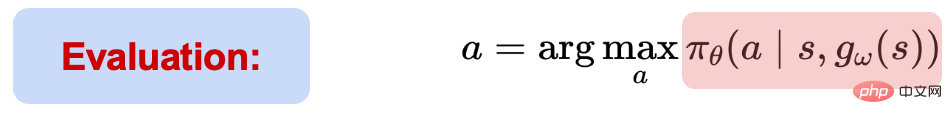

Während des Testprozesses wird zunächst auf Basis der aktuellen Statusinformationen der beste nächste Schritt vorgegeben durch die Führungsstrategie Excellent state(s').

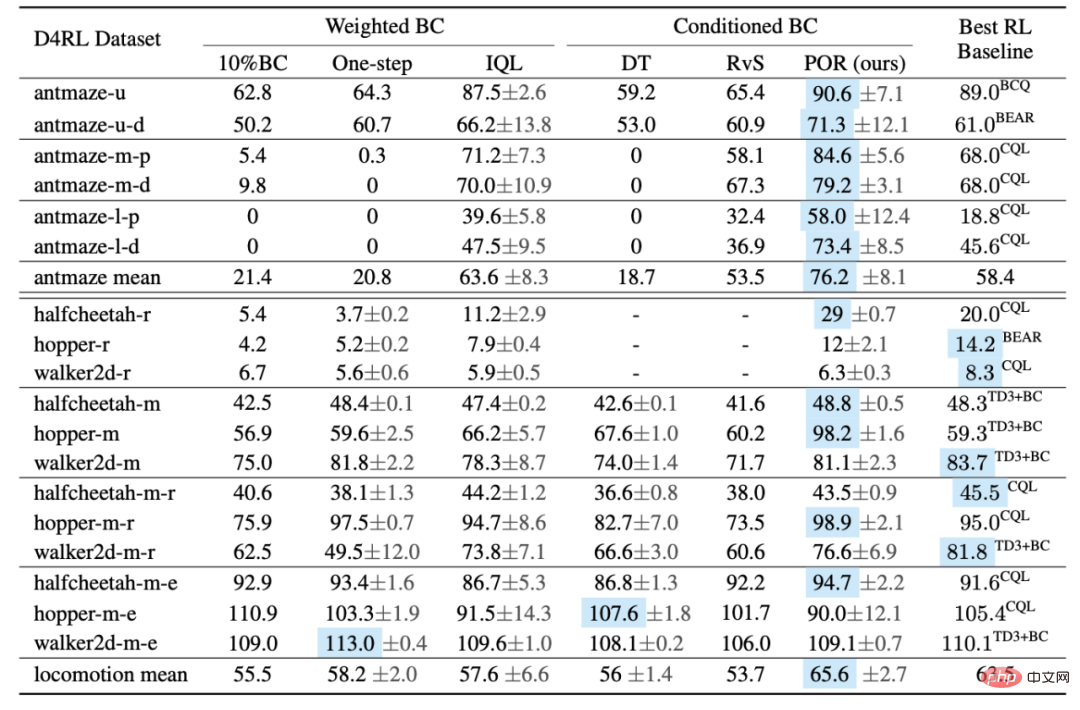

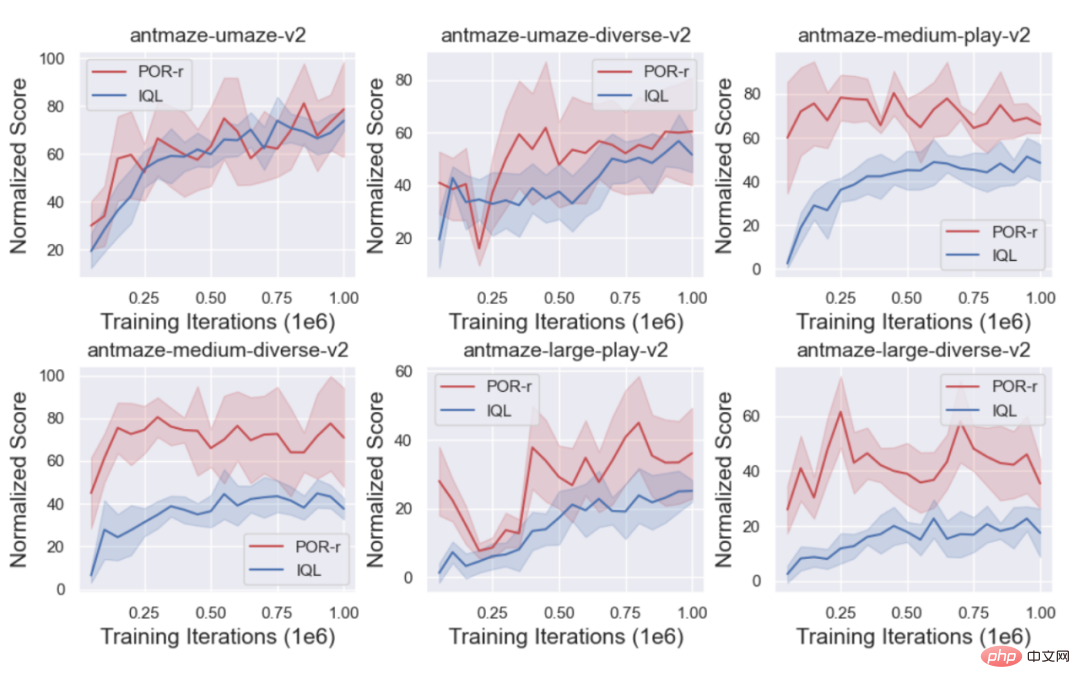

Gegeben (s, s'), kann die Ausführungsstrategie Aktionen auswählen und ausführen. Obwohl der gesamte Lernprozess von POR ein Lernen innerhalb der Stichprobe ist, kann die Generalisierungsleistung des neuronalen Netzwerks verwendet werden, um ein Generalisierungslernen außerhalb der Daten durchzuführen und schließlich eine Zustandszusammenführung zu erreichen. Der Autor verglich die Leistung von POR und anderen Algorithmen im D4RL-Benchmark. Der Tabelle zufolge schneidet POR bei suboptimalen Daten sehr gut ab und erreicht bei schwierigeren Antmaze-Aufgaben eine optimale Algorithmusleistung.

Was sind die zusätzlichen Vorteile der Entkopplung?

Was sind die zusätzlichen Vorteile der Entkopplung?

1. Lernen Sie Coaching-Strategien neu, um etwas zu erreichen Verbesserungen der Algorithmusleistung.

In der realen Welt gibt es oft eine große Anzahl suboptimaler oder sogar zufälliger Datensätze (D_o), wenn sie direkt in den Originaldatensatz (D_e) eingeführt werden. Dies kann zum Erlernen einer schlechten Strategie führen, aber bei entkoppelten Lernalgorithmen werden unterschiedliche Komponenten gezielt eingesetzt und unterschiedliche Datensätze erlernt, um die Leistung zu verbessern. Beim Lernen der Wertfunktion ist es umso besser, je mehr Datensätze vorhanden sind, da die Wertfunktion im Gegenteil genauer gelernt werden kann und die Lernstrategie nicht eingeführt werden soll (D_o).

In der realen Welt gibt es oft eine große Anzahl suboptimaler oder sogar zufälliger Datensätze (D_o), wenn sie direkt in den Originaldatensatz (D_e) eingeführt werden. Dies kann zum Erlernen einer schlechten Strategie führen, aber bei entkoppelten Lernalgorithmen werden unterschiedliche Komponenten gezielt eingesetzt und unterschiedliche Datensätze erlernt, um die Leistung zu verbessern. Beim Lernen der Wertfunktion ist es umso besser, je mehr Datensätze vorhanden sind, da die Wertfunktion im Gegenteil genauer gelernt werden kann und die Lernstrategie nicht eingeführt werden soll (D_o).

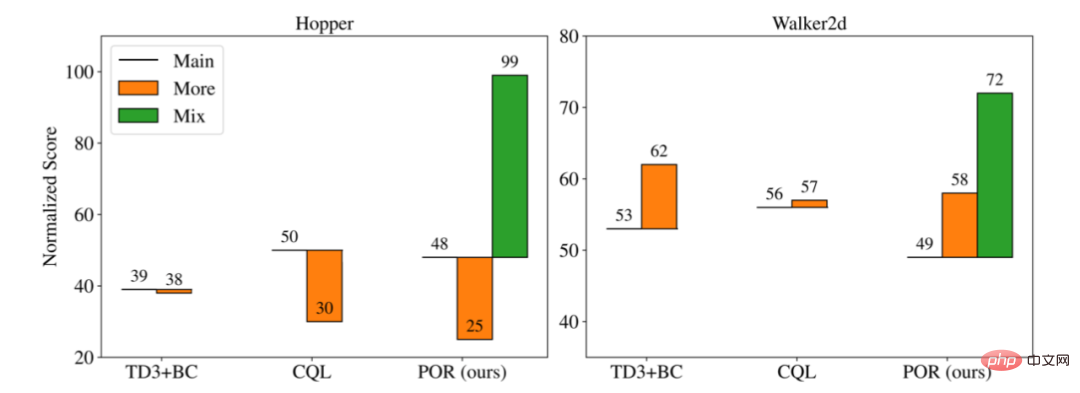

Der Autor verglich die Leistung von drei verschiedenen Algorithmen in verschiedenen Trainingsszenarien:

1. Lernen Sie anhand des Originaldatensatzes (D_e), ohne zusätzliche suboptimale Datensätze einzuführen.

2 Mehr: Mischen Sie den Originaldatensatz (D_e) und den neuen Datensatz (D_o), um als neuen Datensatz zu lernen.

3. Für entkoppelte Algorithmen können für verschiedene Lernteile unterschiedliche Datensätze zum Lernen verwendet werden, sodass nur POR das Mix-Lernparadigma haben kann.

Wie Sie auf dem Bild oben sehen können, wenn neue suboptimale Daten hinzugefügt und gemeinsam trainiert werden (Mehr ), ist es möglich, dass es zu einer besseren oder schlechteren Leistung als beim Original führt, wenn nur der Originaldatensatz (Main) verwendet wird, aber für eine entkoppelte Trainingsform, die zum erneuten Erlernen der Leitstrategie (D_o+D_e) des Autors verwendet wird Experimente haben gezeigt, dass mehr Daten die Selektivität und Generalisierungsfähigkeit der Führungsstrategie verbessern und gleichzeitig die Verhaltensstrategie unverändert lassen können, wodurch eine Verbesserung der Ausführungsstrategie erreicht wird.

4 Wenn Sie vor einer neuen Aufgabe stehen, müssen Sie nur die Führungsstrategie neu erlernen, da die Ausführungsstrategie für die Aufgabe irrelevant ist.

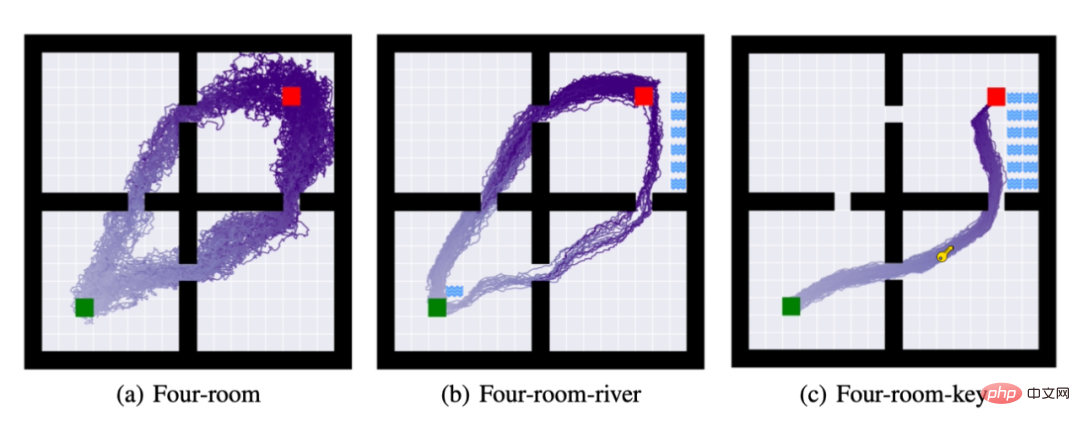

Zu diesem Zweck schlug der Autor drei Aufgaben vor: (a): Vierzimmer: Der Agent muss sich vom grünen Quadrat zum roten Quadrat bewegen. (b) Zusätzlich zur Erfüllung von Aufgabe (a) muss der Agent den Fluss nicht berühren. (c) Zusätzlich zur Erledigung der Aufgaben (a) und (b) muss der Agent den Schlüssel erhalten, um die Aufgabe abzuschließen.

Das Bild oben zeigt den Verlauf von 50 Rollouts der Strategie nach Abschluss des Strategielernens. In den Aufgaben (b) und Aufgabe (c) verwendete der Autor weiterhin die Ausführungsstrategie von Aufgabe (a) und Ich habe es nur neu gelernt. Wie aus der obigen Abbildung ersichtlich ist, kann die entkoppelte Lernmethode die Aufgabenmigration mit möglichst wenigen Rechenressourcen abschließen.

Das obige ist der detaillierte Inhalt vonEin neues Paradigma für Offline-Lernen zur Verstärkung! JD.com und die Tsinghua University schlagen einen entkoppelten Lernalgorithmus vor. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr