Heim >Technologie-Peripheriegeräte >KI >Alarm! Die durch die Explosion von ChatGPT verursachte Energieverbrauchskrise stellt Rechenzentrumsbetreiber vor große Herausforderungen

Alarm! Die durch die Explosion von ChatGPT verursachte Energieverbrauchskrise stellt Rechenzentrumsbetreiber vor große Herausforderungen

- 王林nach vorne

- 2023-04-11 15:58:031737Durchsuche

Vor kurzem hat ChatGPT, ein intelligentes Chat-Tool des amerikanischen Unternehmens OpenAI, die sozialen Medien im Sturm erobert, Investitionen in Höhe von über 10 Milliarden US-Dollar angezogen und eine große Begeisterung für Anwendungen der künstlichen Intelligenz auf dem Kapitalmarkt ausgelöst für eine Weile im Rampenlicht stehen.

Microsoft war der erste, der eine Investition von 10 Milliarden US-Dollar in OpenAI ankündigte, und dann gaben Amazon und die US-Version von „Today's Toutiao“ BuzzFeed bekannt, dass sie ChatGPT in ihrer täglichen Arbeit aktivieren würden. Baidu kündigte außerdem an, im März die „chinesische Version“ von ChatGPT auf den Markt zu bringen. Nachdem viele Technologieunternehmen Öl ins Feuer gegossen hatten, erregte ChatGPT sofort weltweite Aufmerksamkeit.

Daten zeigen, dass die Zahl der von Amazon eingesetzten Roboter schnell zunimmt, wobei der tägliche Anstieg etwa 1.000 erreicht. Darüber hinaus will der Facebook-Mutterkonzern Meta im Jahr 2023 weitere 4 bis 5 Milliarden US-Dollar in Rechenzentren investieren, die voraussichtlich vollständig für künstliche Intelligenz genutzt werden. Krishna, CEO von IBM, sagte, dass künstliche Intelligenz bis 2030 voraussichtlich 16 Billionen US-Dollar zur Weltwirtschaft beitragen werde.

Mit der Popularität von ChatGPT könnten Giganten im Jahr 2023 eine neue Runde erbitterter Kämpfe auf dem Gebiet der künstlichen Intelligenz beginnen.

Wenn ChatGPT-3 jedoch das nächste Wort vorhersagt, muss es mehrere Inferenzberechnungen durchführen, was viele Ressourcen beansprucht und mehr Strom verbraucht. Da die Infrastruktur von Rechenzentren erweitert wird, um das explosionsartige Wachstum von Cloud Computing, Video-Streaming und 5G-Netzwerken zu unterstützen, kann die GPU- und CPU-Architektur nicht effizient arbeiten, um den bevorstehenden Rechenbedarf zu decken, was für Betreiber von Hyperscale-Rechenzentren eine große Herausforderung darstellt.

Das GPT3.5-Training nutzt das speziell entwickelte KI-Computersystem von Microsoft, einen leistungsstarken Netzwerkcluster bestehend aus 10.000 V100-GPUs, mit einem gesamten Rechenleistungsverbrauch von etwa 3640 PF-Tagen (das heißt, wenn eine Billiarde pro Tag berechnet wird). zum zweiten Mal müssen 3640 Tage berechnet werden). Solch eine groß angelegte und langfristige GPU-Cluster-Trainingsaufgabe stellt extreme Anforderungen an die Leistung, Zuverlässigkeit, Kosten und andere Aspekte der Netzwerkverbindungsbasis.

Meta kündigte beispielsweise an, den Ausbau von Rechenzentren auf der ganzen Welt auszusetzen und diese Serverfarmen neu zu konfigurieren, um den Datenverarbeitungsanforderungen der künstlichen Intelligenz gerecht zu werden.

Der Datenverarbeitungsbedarf von Plattformen für künstliche Intelligenz ist enorm. Die OpenAI-Entwickler von ChatGPT haben die Plattform im November letzten Jahres gestartet. Ohne die bevorstehende Aktualisierung der Azure-Cloud-Plattform von Microsoft wird sie nicht weiter betrieben werden können.

Die Rechenzentrumsinfrastruktur, die diese digitale Transformation unterstützt, wird wie das menschliche Gehirn in zwei Hemisphären oder Lappen organisiert sein, wobei ein Lappen viel stärker sein muss als der andere. Eine Hemisphäre dient dem sogenannten „Training“, also der Rechenleistung, die zur Verarbeitung von bis zu 300 Milliarden Datenpunkten erforderlich ist, um den Wortsalat zu erstellen, den ChatGPT generiert.

Trainingslobes erfordern leistungsstarke Rechenleistung und modernste GPU-Halbleiter, aber in Rechenzentrumsclustern, die Cloud-Computing-Dienste und 5G-Netzwerke unterstützen, ist derzeit nur wenig Konnektivität erforderlich.

Gleichzeitig wird die Infrastruktur, die sich auf das „Training“ jeder KI-Plattform konzentriert, einen enormen Strombedarf erzeugen, was die Ansiedlung von Rechenzentren in der Nähe von Gigawatt erneuerbarer Energie, die Installation neuer Flüssigkeitskühlsysteme und die Neugestaltung erforderlich macht Notstrom- und Generatorsysteme sowie weitere neue Designmerkmale.

Künstliche Intelligenzplattformen Die andere Hemisphäre des Gehirns, eine höher funktionierende digitale Infrastruktur, die als „Inferenz“-Modus bekannt ist, unterstützt interaktive „generative“ Plattformen, die innerhalb von Sekunden nach Eingabe einer Frage oder Anweisung Abfragen in die modellierte Datenbank verarbeiten und antwortete mit überzeugender menschlicher Syntax.

Während die heutigen hypervernetzten Rechenzentrumsnetzwerke, wie der größte Rechenzentrumscluster in Nordamerika, verfügen die „Rechenzentren“ von Nord-Virginia auch über die umfangreichsten Glasfasernetze, um den Konnektivitätsanforderungen der nächsten Ebene der „Inferenz“ des KI-Gehirns gerecht zu werden ” Blätter , aber diese Anlagen müssen auch modernisiert werden, um die enorme erforderliche Verarbeitungskapazität zu erfüllen, und sie müssen näher an den Umspannwerken liegen.

Darüber hinaus zeigen Daten von Forschungseinrichtungen, dass Rechenzentren zu den weltweit größten Energieverbrauchern geworden sind und ihr Anteil am gesamten Stromverbrauch von 3 % im Jahr 2017 auf 4,5 % im Jahr 2025 steigen wird. Am Beispiel Chinas wird erwartet, dass der Stromverbrauch landesweit betriebener Rechenzentren im Jahr 2030 400 Milliarden kWh übersteigen wird, was 4 % des gesamten Stromverbrauchs des Landes ausmacht.

Daher benötigen sogar digitale Produkte Energie, um sich zu entwickeln und zu verbrauchen, und ChatGPT ist keine Ausnahme. Schätzungen zufolge macht die Inferenzverarbeitung bei der Arbeit mit maschinellem Lernen seit der Einführung von ChatGPT im November 2022 80–90 % des Rechenleistungsverbrauchs aus Seit der Inbetriebnahme am 30. haben die CO2-Emissionen 814,61 Tonnen überschritten.

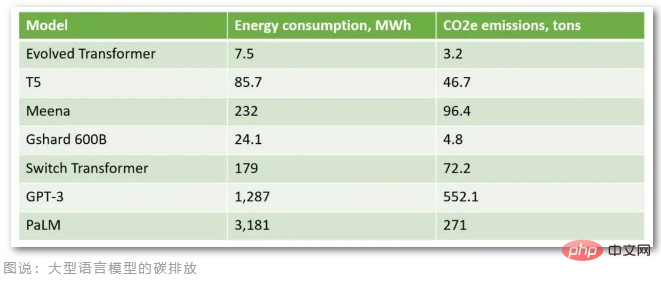

Nach Berechnungen von Berufsverbänden beträgt die maximale Leistung der A100-GPU 407 W, wenn man davon ausgeht, dass ChatGPT, das in der Azure-Cloud von Microsoft gehostet wird, 1 Million Benutzeranfragen pro Tag hat (ungefähr 29.167 Stunden pro Tag bei einer bestimmten Antwortzeit und einem bestimmten Vokabular). (Watt) erreichen die täglichen Kohlenstoffemissionen 3,82 Tonnen und die monatlichen Kohlenstoffemissionen übersteigen 100 Tonnen. Heute hat ChatGPT mehr als 10 Millionen tägliche Nutzer und der tatsächliche CO2-Ausstoß liegt weit über 100 Tonnen pro Monat. Darüber hinaus erfordert das Training eines so großen Sprachmodells mit 175 Milliarden Parametern Zehntausende CPUs/GPUs zur Dateneingabe rund um die Uhr, verbraucht etwa 1287 MWh Strom und stößt mehr als 552 Tonnen Kohlendioxid aus.

Gemessen an den CO2-Emissionen dieser großen Sprachmodelle weist GPT-3, der Vorgänger von ChatGPT, die höchsten CO2-Emissionen auf. Es wird berichtet, dass der durchschnittliche Amerikaner 16,4 Tonnen Kohlenstoffemissionen pro Jahr verursacht und der durchschnittliche Däne 11 Tonnen Kohlenstoffemissionen pro Jahr verursacht. Dadurch ist das ChatGPT-Modell darauf trainiert, mehr Kohlenstoffemissionen auszustoßen, als 50 Dänen pro Jahr ausstoßen.

Cloud-Computing-Anbieter haben ebenfalls erkannt, dass Rechenzentren große Mengen an Strom verbrauchen, und haben Maßnahmen zur Verbesserung der Effizienz ergriffen, beispielsweise den Bau und Betrieb von Rechenzentren in der Arktis, um erneuerbare Energien und natürliche Kühlbedingungen zu nutzen. Dies reicht jedoch nicht aus, um dem explosionsartigen Wachstum von KI-Anwendungen gerecht zu werden.

Das Lawrence Berkeley National Laboratory in den Vereinigten Staaten hat in einer Untersuchung herausgefunden, dass Verbesserungen der Rechenzentrumseffizienz das Wachstum des Energieverbrauchs in den letzten 20 Jahren kontrolliert haben, die Studie zeigt jedoch, dass die heutigen Energieeffizienzmaßnahmen dies möglicherweise nicht tun ausreichen, um die zukünftigen Anforderungen von Rechenzentren zu erfüllen.

Die Branche der künstlichen Intelligenz befindet sich jetzt an einem kritischen Wendepunkt. Technologische Fortschritte in den Bereichen generative KI, Bilderkennung und Datenanalyse offenbaren einzigartige Zusammenhänge und Einsatzmöglichkeiten für maschinelles Lernen, aber zunächst muss eine Technologielösung entwickelt werden, die diesen Bedarf decken kann, denn laut Gartner wird dies andernfalls bis 2025 der Fall sein, wenn keine nachhaltigere Wahl getroffen wird , KI wird mehr Energie verbrauchen als menschliche Aktivitäten.

Das obige ist der detaillierte Inhalt vonAlarm! Die durch die Explosion von ChatGPT verursachte Energieverbrauchskrise stellt Rechenzentrumsbetreiber vor große Herausforderungen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr