Heim >Technologie-Peripheriegeräte >KI >Es gibt auch einen Transformer im Gehirn! Der gleiche Mechanismus wie der „Hippocampus'

Es gibt auch einen Transformer im Gehirn! Der gleiche Mechanismus wie der „Hippocampus'

- PHPznach vorne

- 2023-04-11 15:43:031760Durchsuche

, Ich kann es nicht erschaffen und ich verstehe es nicht

—— Ferman

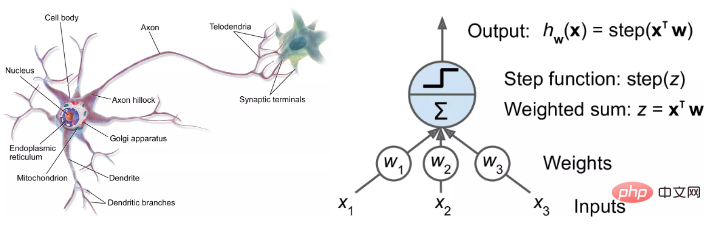

möchte künstliche Intelligenz erschaffen. Zunächst müssen wir verstehen, warum das menschliche Gehirn intelligent ist.Mit der Geburt neuronaler Netze und ihrer anschließenden brillanten Entwicklung haben Forscher nach „biologischen Erklärungen“ für neuronale Netze gesucht, und der biologische Fortschritt hat auch KI-Forscher dazu inspiriert, neue Modelle zu entwickeln.

Aber Forscher auf dem Gebiet der künstlichen Intelligenz haben tatsächlich ein ehrgeizigeres Ziel:  KI-Modelle nutzen, um das Gehirn zu verstehen

KI-Modelle nutzen, um das Gehirn zu verstehen

Neueste Untersuchungen haben ergeben, dass das beliebteste Transformer

-Modell zwarohne jegliche Unterstützung durch biologisches Wissen entwickelt wurde, seine Struktur jedoch der Hippocampusstruktur des menschlichen Gehirns sehr ähnlich ist.

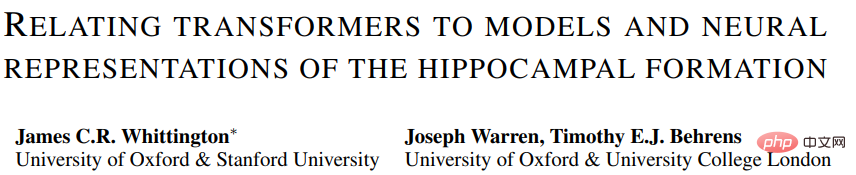

Link zum Papier: https://arxiv.org/pdf/2112.04035.pdf

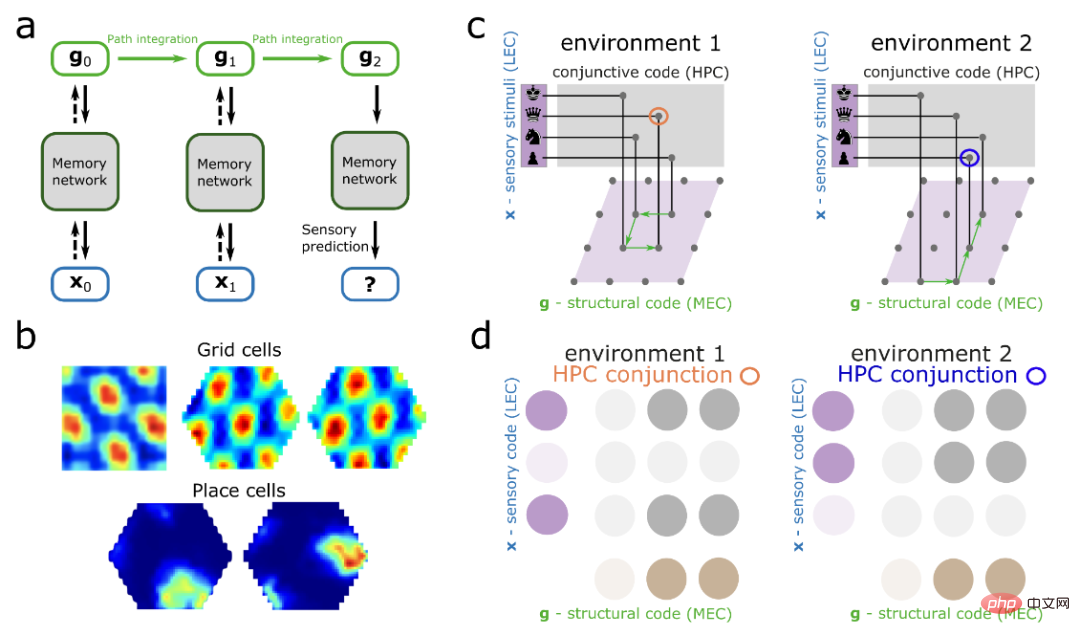

Nachdem die Forscher den Transformer mit rekursiver Positionskodierung ausgestattet hatten, stellten sie fest, dass das Modell den Hippocampus genau nachbilden konnte Formation. )s räumliche Darstellung.

Der Autor sagte jedoch auch, dass ihn dieses Ergebnis nicht überrascht, da Transformer eng mit dem aktuellen Hippocampus-Modell in den Neurowissenschaften verwandt ist. Die offensichtlichsten sind

Platzzellen(Platzzellen) und Gitter Zellen (Gitterzelle). Und durch Experimente wurde festgestellt, dass das Transformer-Modell im Vergleich zu dem Modell der neurowissenschaftlichen Version eine enorme Leistungsverbesserung aufweist.

Diese Arbeit kombiniert Berechnungen künstlicher neuronaler Netze und Gehirnnetzwerke, um ein neues Verständnis der Wechselwirkungen zwischen dem Hippocampus und der Großhirnrinde zu liefern und Hinweise darauf zu geben, wie kortikale Bereiche

über das aktuelle neurowissenschaftliche Modell hinausfür ein breiteres Spektrum komplexer Aufgaben funktionieren wie zum Beispiel Sprachverständnis. Transformer simuliert den Hippocampus? Für Menschen ist es immer noch schwierig, ihr eigenes Gehirn zu verstehen. Beispielsweise ist es immer noch eine schwierige Herausforderung, zu untersuchen, wie das Gehirn räumliche Informationen organisiert und darauf zugreift, um herauszufinden, „wo wir uns befinden, was vor uns liegt und wie wir dorthin gelangen“. .

Der gesamte Prozess kann das Abrufen ganzer Gedächtnisnetzwerke und gespeicherter räumlicher Daten von Dutzenden Milliarden Neuronen umfassen, von denen jedes mit Tausenden anderer Neuronen verbunden ist.

Während Neurowissenschaftler mehrere Schlüsselelemente identifiziert haben, wie z. B. Gitterzellen und Neuronen, die den Standort abbilden, ist die Durchführung tiefergehender Studien noch unbekannt: Forscher können keine Scheiben menschlicher grauer Substanz entfernen und untersuchen, um zu beobachten, wie ortsbezogene Erinnerungen an Bilder entstehen Geräusche, Geräusche und Gerüche fließen und verbinden sich miteinander.

Modelle der künstlichen Intelligenz bieten eine weitere Möglichkeit, das menschliche Gehirn zu verstehen. Im Laufe der Jahre haben Neurowissenschaftler verschiedene Arten neuronaler Netze verwendet, um das Feuern von Neuronen im Gehirn zu simulieren.

Neueste Forschungsergebnisse zeigen, dass der Hippocampus (eine für das Gedächtnis entscheidende Gehirnstruktur) grundsätzlich dem Transformer-Modell ähnelt.

Forscher haben einige bemerkenswerte Ergebnisse erzielt, indem sie neue Modelle verwendet haben, um räumliche Informationen auf eine Weise zu verfolgen, die dem Innenleben des Gehirns ähnelt.

James Whittington, ein kognitiver Neurowissenschaftler von der Universität Oxford und der Stanford University, sagte, wenn wir wissen, dass diese Gehirnmodelle den Transformers entsprechen, bedeutet das, dass die neuen Modelle eine bessere Leistung erbringen und einfacher zu trainieren sind .

Wie aus der Arbeit von Whittington und anderen hervorgeht, kann Transformer die Fähigkeit neuronaler Netzwerkmodelle, die verschiedenen Berechnungen zu imitieren, die von Gitterzellen und anderen Teilen des Gehirns durchgeführt werden, erheblich verbessern. Laut Whittington könnten solche Modelle unser Verständnis darüber verbessern, wie künstliche neuronale Netze funktionieren und, was wahrscheinlicher ist, wie Berechnungen im Gehirn durchgeführt werden.

David Ha, ein Google Brain-Informatiker, der sich hauptsächlich mit der Transformer-Modellforschung beschäftigt, sagte, dass wir nicht versuchen, ein neues Gehirn nachzubilden, sondern dass wir ein neues Gehirn erschaffen können Mechanismus, um das zu tun, was Ihr Gehirn tun kann?

Transformer wurde erstmals vor fünf Jahren als neues Modell für künstliche Intelligenz zur Verarbeitung natürlicher Sprache vorgeschlagen. Es war auch eines dieser „Starmodelle“ wie BERT und GPT -3 ”Geheimwaffe. Diese Modelle können überzeugende Songtexte generieren, Shakespeare-Sonette komponieren oder menschliche Kundendienstarbeiten durchführen.

Der Kernmechanismus von Transformer ist die Selbstaufmerksamkeit, bei der jede Eingabe (z. B. ein Wort, ein Pixel, eine Zahl in einer Sequenz) immer mit allen verknüpft ist andere Eingabeverbindungen, während andere gängige neuronale Netze einfach Eingaben mit bestimmten Eingaben verbinden.

Obwohl Transformer speziell für Aufgaben in natürlicher Sprache entwickelt wurde, haben spätere Untersuchungen auch gezeigt, dass Transformer auch bei anderen Aufgaben, wie der Klassifizierung von Bildern und jetzt der Modellierung des Gehirns, gute Leistungen erbringt .

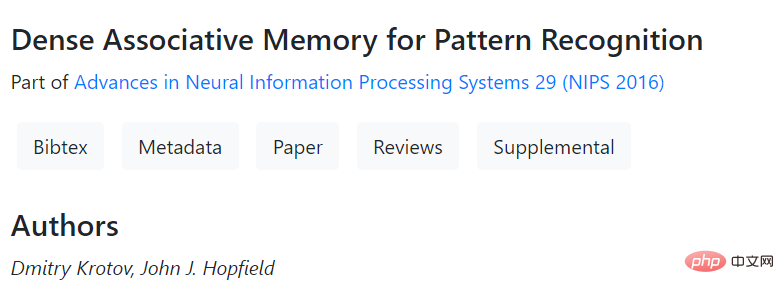

Im Jahr 2020 nutzte ein Team um den Informatiker Sepp Hochreiter (Erstautor des LSTM-Artikels) an der Johann Kepler Universität Linz in Österreich einen Transformer, um Optimieren Sie ein Hopfield-Netzwerk, ein leistungsstarkes, langlebiges Speicherabrufmodell.

Diese Netzwerke, die erstmals vor 40 Jahren vom Princeton-Physiker John Hopfield vorgeschlagen wurden, folgen einer allgemeinen Regel: Neuronen, die gleichzeitig aktiv sind, bauen starke Beziehungen zueinander auf. Eine kraftvolle Verbindung.

Hochreiter und seine Mitarbeiter stellten fest, dass Forscher nach besseren Speicherabrufmodellen gesucht haben, und sie sahen, wie eine neue Klasse von Hopfield-Netzwerken Erinnerungen abruft und wie Transformer die Verbindung herstellt zwischen Aufmerksamkeit.

Diese neuen Hopfield-Netzwerke wurden von Hopfield und Dmitry Krotov vom MIT-IBM Watson Artificial Intelligence Laboratory entwickelt und verfügen über effizientere Verbindungen, sodass mehr Erinnerungen gespeichert und abgerufen werden können.

Papierlink: https://papers.nips.cc/paper/2016/hash Hochreiters Team verbesserte diese Netzwerke, indem es eine Regel hinzufügte, die dem Aufmerksamkeitsmechanismus in Transformer ähnelt.

Papierlink: https://papers.nips.cc/paper/2016/hash Hochreiters Team verbesserte diese Netzwerke, indem es eine Regel hinzufügte, die dem Aufmerksamkeitsmechanismus in Transformer ähnelt.

Im Jahr 2022 wurde in dieser neuen Arbeit Hochreiters Methode weiter angepasst und der Transformer so modifiziert, dass er Erinnerungen nicht mehr als lineare Sequenzen, sondern wie Sätze behandelt. Eine Folge von Wörtern in , als Koordinaten in einem hochdimensionalen Raum kodiert.

Die Forscher sagen, dass diese „Wendung“ die Leistung des Modells bei neurowissenschaftlichen Aufgaben weiter verbessert. Die experimentellen Ergebnisse zeigten auch, dass das Modell mathematisch dem Modell der Gitterzellfeuerungsmuster entspricht, die Neurowissenschaftler in fMRT-Scans sehen. Caswell Barry, ein Neurowissenschaftler am University College London, sagte, dass Gitterzellen diese aufregende, schöne, regelmäßige Struktur haben, die ins Auge fällt. Es ist unwahrscheinlich, dass das Muster zufällig auftritt. Die neue Arbeit zeigt, wie der Transformer genau die im Hippocampus beobachteten Muster nachbildet. Sie erkannten auch, dass das Transformer-Modell anhand seines vorherigen Zustands und seiner Bewegung herausfinden kann, wo es sich befindet, und zwar auf entscheidende Weise in das traditionelle Gitterzellenmodell.

Andere neuere Arbeiten legen ebenfalls nahe, dass Transformer unser Verständnis anderer Gehirnfunktionen verbessern können.

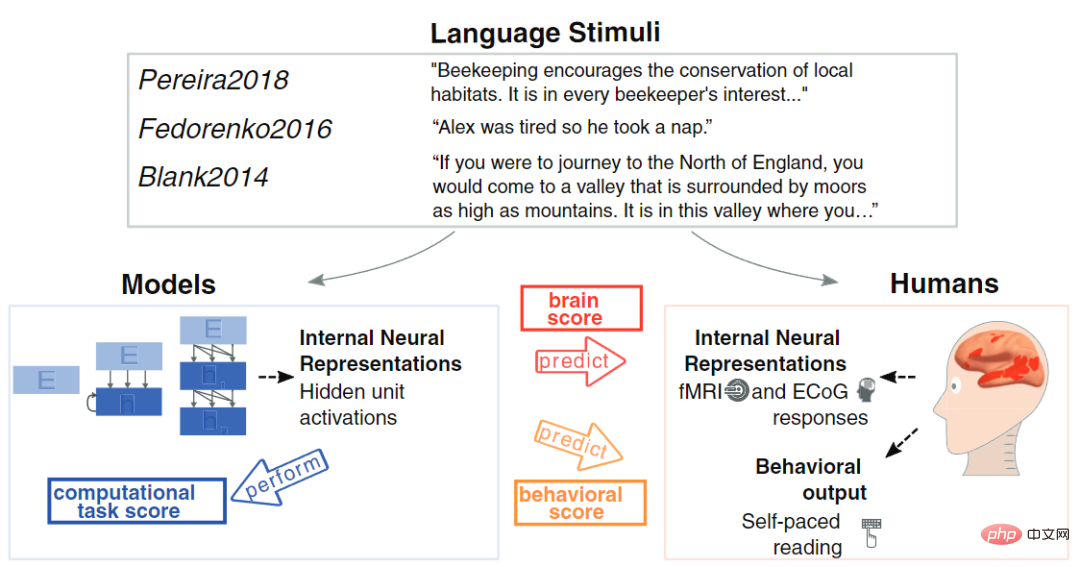

Letztes Jahr analysierte der Computerneurowissenschaftler Martin Schrimpf vom MIT 43 verschiedene neuronale Netzwerkmodelle, um deren Wirkung auf die von fMRT und Elektrokortikographie gemeldeten Daten zu verstehen Aktivität.

Er fand heraus, dass Transformer derzeit das führende und fortschrittlichste neuronale Netzwerk ist, das fast alle Veränderungen in der Bildgebung vorhersagen kann.

David Ha und Yujin Tang, der ebenfalls Informatiker ist, haben kürzlich auch ein Modell entworfen, das absichtlich eine große Datenmenge auf zufällige und ungeordnete Weise in den Transformer eingeben kann, um zu simulieren, wie der menschliche Körper sensorische Beobachtungen übermittelt das Gehirn. Es stellt sich heraus, dass Transformer genau wie unser Gehirn ungeordnete Informationsflüsse erfolgreich verarbeiten kann.

Link zum Papier: https://arxiv.org/abs/2111.14377

Yujin Tang sagte, dass neuronale Netze fest verdrahtet sind und nur bestimmte Eingaben empfangen können. Aber im wirklichen Leben ändern sich Datensätze oft schnell und die meisten KIs haben keine Möglichkeit, sich anzupassen. In Zukunft möchten wir eine Architektur ausprobieren, die sich schnell anpassen kann.

Das obige ist der detaillierte Inhalt vonEs gibt auch einen Transformer im Gehirn! Der gleiche Mechanismus wie der „Hippocampus'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr