Heim >Technologie-Peripheriegeräte >KI >„Bilderzeugungstechnologie' wandert am Rande des Gesetzes: In diesem Papier erfahren Sie, wie Sie vermeiden, zum „Angeklagten' zu werden.

„Bilderzeugungstechnologie' wandert am Rande des Gesetzes: In diesem Papier erfahren Sie, wie Sie vermeiden, zum „Angeklagten' zu werden.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 14:55:031533Durchsuche

In den letzten Jahren haben KI-generierte Inhalte (AIGC) viel Aufmerksamkeit auf sich gezogen. Ihr Inhalt umfasst Bilder, Text, Audio, Video usw. AIGC ist jedoch zu einem zweischneidigen Schwert geworden und wurde aufgrund seiner verantwortungslosen Verwendung kontrovers diskutiert .

Sobald die Bilderzeugungstechnologie nicht ordnungsgemäß eingesetzt wird, können Sie zum „Angeklagten“ werden.

Kürzlich haben Forscher von Sony AI und Wisdom Source die aktuellen Probleme von AIGC unter vielen Aspekten diskutiert und dargelegt, wie KI-generierte Inhalte verantwortungsvoller gestaltet werden können.

Link zum Papier: https://arxiv.org/pdf/2303.01325.pdf

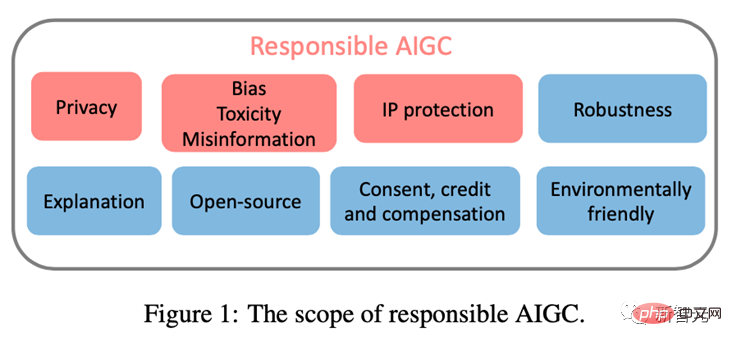

Dieser Artikel konzentriert sich auf drei Hauptprobleme, die die gesunde Entwicklung von AIGC behindern können, darunter: ( 1)Datenschutz; (2)Voreingenommenheit, Toxizität, Fehlinformationen; (3)Geistiges Eigentum (IP)Risiken.

Durch die Dokumentation der bekannten und potenziellen Risiken sowie möglicher AIGC-Missbrauchsszenarien soll dieser Artikel auf die potenziellen Risiken und den Missbrauch von AIGC aufmerksam machen und Anweisungen zur Bewältigung dieser Risiken zur Förderung von AIGC geben entwickelt sich in eine ethischere und sicherere Richtung zum Nutzen der Gesellschaft.

Datenschutz

Es ist bekannt, dass große Basismodelle eine Reihe von Datenschutzproblemen aufweisen.

Frühere Untersuchungen haben gezeigt, dass ein Eindringling Sequenzen aus einem trainierten GPT-2-Modell generieren und diese gespeicherten Sequenzen aus dem Trainingssatz identifizieren kann. [Kandpal et al., 2022] führt den Erfolg dieser Eingriffe in die Privatsphäre auf Folgendes zurück: Aufgrund des Vorhandenseins wiederholter Daten im Trainingssatz haben Studien gezeigt, dass Sequenzen, die mehrmals vorkommen, mit größerer Wahrscheinlichkeit generiert werden als Sequenzen, die nur einmal vorkommen.

Da das AIGC-Modell auf umfangreichen Web-Crawling-Daten trainiert wird, werden die Probleme der Überanpassung und des Verlusts der Privatsphäre besonders wichtig.

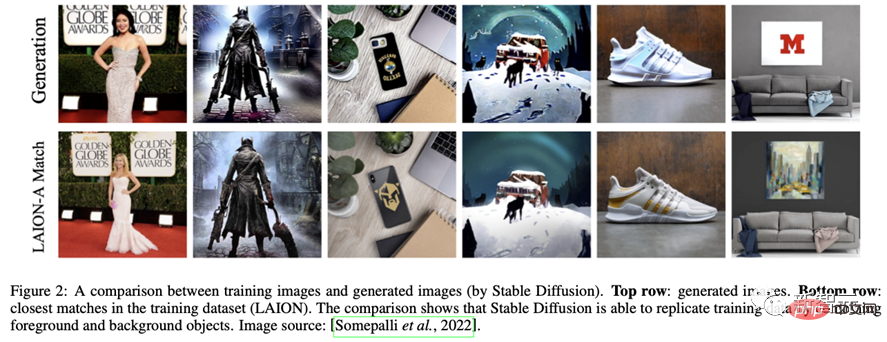

Zum Beispiel speichert das Stable Diffusion-Modell wiederholte Bilder in den Trainingsdaten [Rombach et al., 2022c]. [Somepalli et al., 2022] haben gezeigt, dass ein Stable Diffusion-Modell offensichtlich Bilder aus seinen Trainingsdaten kopiert und einfache Kombinationen von Vordergrund- und Hintergrundobjekten im Trainingsdatensatz generiert.

Darüber hinaus zeigt das Modell die Fähigkeit, das Gedächtnis zu rekonstruieren und dadurch Objekte zu erzeugen, die semantisch mit dem Originalobjekt identisch sind, aber unterschiedliche Pixelformen haben. Die Existenz solcher Bilder wirft Bedenken hinsichtlich des Datenspeichers und des Eigentums auf.

Ähnlicherweise zeigen aktuelle Untersuchungen, dass das Imagen-System von Google auch Probleme hat, Fotos von echten Personen und urheberrechtlich geschützte Bilder durchsickern zu lassen. In der jüngsten Klage von Matthew Butterick [Butterick, 2023] wies er darauf hin, dass alle visuellen Informationen im System aus urheberrechtlich geschützten Trainingsbildern stammen und die generierten Bilder unabhängig von ihrem Aussehen das Werk dieser Trainingsbilder sein müssen.

Ähnlich litt DALL·E 2 unter einem ähnlichen Problem: Es kopierte manchmal Bilder aus seinen Trainingsdaten, anstatt neue zu erstellen.

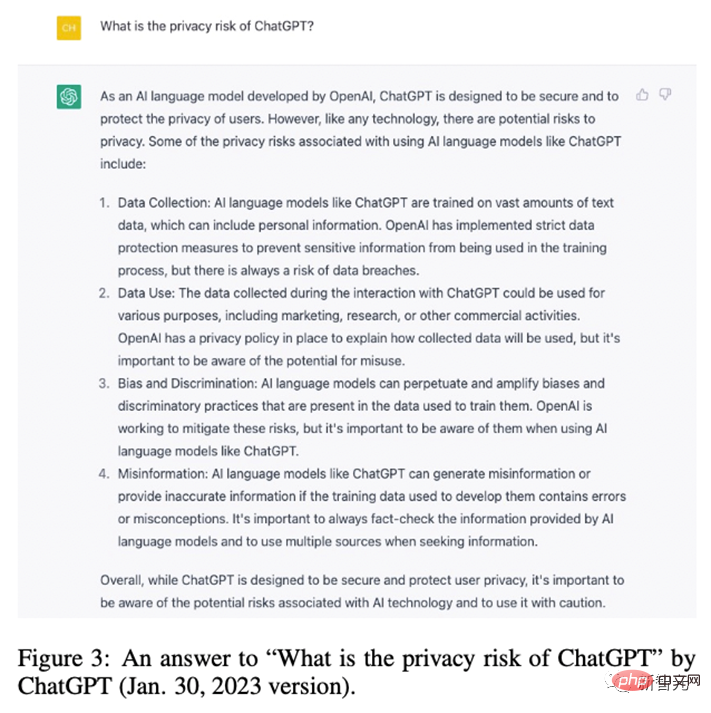

OpenAI stellte fest, dass dieses Phänomen auftrat, weil das Bild im Datensatz mehrmals kopiert wurde. Ebenso gab ChatGPT selbst zu, dass das Risiko eines Datenschutzverlusts bestand.

Um das Datenschutzproblem großer Modelle zu lindern, haben viele Unternehmen und Forscher große Anstrengungen zum Schutz der Privatsphäre unternommen. Auf industrieller Ebene hat Stability AI die Grenzen der stabilen Diffusion erkannt.

Zu diesem Zweck stellen sie eine Website (https://rom1504.github.io/clip-retrieval/) zur Verfügung, um von Stable Diffusion gespeicherte Bilder zu identifizieren.

Darüber hinaus hat das Kunstunternehmen Spawning AI eine Website mit dem Namen „Have I Been Trained“ (https://haveibeentrained.com) erstellt, um Benutzern dabei zu helfen, ihr Ob zu identifizieren Fotos oder Werke werden für das Training künstlicher Intelligenz verwendet.

OpenAI versucht, Datenschutzprobleme durch Reduzierung der Datenduplizierung zu lösen.

Darüber hinaus haben Unternehmen wie Microsoft und Amazon Mitarbeitern verboten, sensible Daten mit ChatGPT zu teilen, um zu verhindern, dass Mitarbeiter vertrauliche Informationen preisgeben, da diese Informationen künftig für Schulungen verwendet werden können Versionen von ChatGPT.

Auf akademischer Ebene untersuchten Somepalli et al. ein Bildabruf-Framework, um die Duplizierung von Inhalten zu identifizieren, und Dockhorn et al Privatsphäre des generierten Modells.

Voreingenommenheit, Toxizität, Fehlinformationen

Das AIGC-Modell wird auf Daten aus der realen Welt trainiert, diese Daten können jedoch unbeabsichtigt schädliche Stereotypen verstärken. bestimmte Gruppen ausschließen oder marginalisieren und toxische Datenquellen enthalten, die Hass oder Gewalt schüren und Einzelpersonen beleidigen können [Weidinger et al., 2021].

Modelle, die anhand dieser problematischen Datensätze geschult oder verfeinert wurden, können schädliche Stereotypen, soziale Vorurteile und Toxizität übernehmen oder sogar Fehlinformationen erzeugen, was zu unfairer Diskriminierung und Schädigung bestimmter sozialer Netzwerke führt Gruppen.

Zum Beispiel wird das Stable Diffusion v1-Modell hauptsächlich auf dem LAION-2B-Datensatz trainiert, der nur Bilder mit englischen Beschreibungen enthält. Daher ist das Modell auf Weiße und westliche Kulturen ausgerichtet und Hinweise aus anderen Sprachen werden möglicherweise nicht vollständig repräsentiert.

Während nachfolgende Versionen des Stable Diffusion-Modells anhand gefilterter Versionen des LAION-Datensatzes verfeinert wurden, blieben Probleme mit der Verzerrung bestehen. Ebenso weisen DALLA·E, DALLA·E 2 und Imagen soziale Vorurteile und negative Stereotypen gegenüber Minderheitengruppen auf.

Darüber hinaus hat sich gezeigt, dass Imagen soziale und kulturelle Vorurteile aufweist, selbst wenn Bilder von Nicht-Menschen erstellt werden. Aufgrund dieser Probleme hat Google beschlossen, Imagen nicht der Öffentlichkeit zugänglich zu machen.

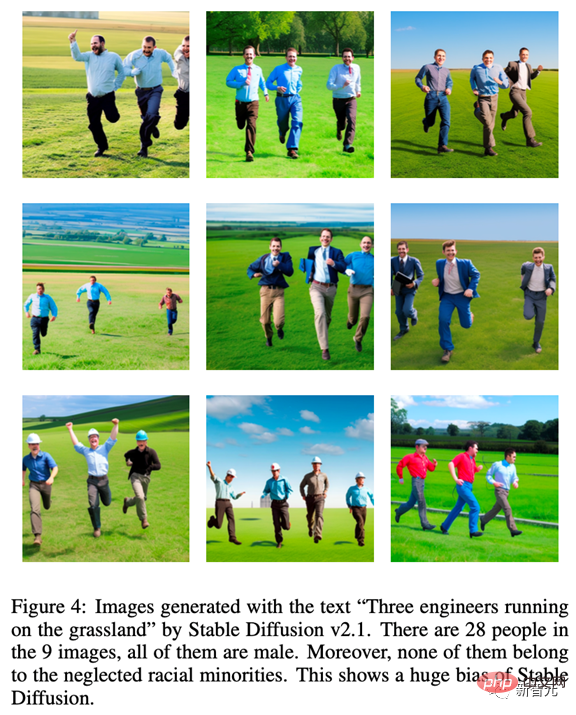

Um die inhärente Tendenz des AIGC-Modells zu veranschaulichen, haben wir Stable Diffusion v2.1 getestet und dabei das Bild verwendet, das durch die Eingabeaufforderung „Drei Ingenieure laufen auf dem Grasland“ generiert wurde „Alle waren männlich und keiner gehörte einer unterrepräsentierten Minderheit an, was den Mangel an Vielfalt in den resultierenden Bildern verdeutlicht.“

Darüber hinaus kann das AIGC-Modell auch falsche Informationen liefern. Beispielsweise können von GPT und seinen Derivaten generierte Inhalte korrekt und maßgeblich erscheinen, aber möglicherweise völlig falsche Informationen enthalten.

Daher kann es in einigen Bereichen zu irreführenden Informationen kommen (z. B. Schule, Recht, Medizin, Wettervorhersage). Im medizinischen Bereich können beispielsweise die von ChatGPT bereitgestellten Antworten zu medizinischen Dosierungen ungenau oder unvollständig sein, was lebensbedrohlich sein kann. Wenn Fahrer im Transportwesen die falschen Verkehrsregeln von ChatGPT befolgen, kann dies zu Unfällen oder sogar zum Tod führen.

Es wurden viele Abwehrmaßnahmen gegen problematische Daten und Modelle ergriffen.

OpenAI hat den ursprünglichen Trainingsdatensatz feingefiltert und alle gewalttätigen oder pornografischen Inhalte in den DALLA·E 2-Trainingsdaten entfernt. Durch die Filterung können jedoch Vorurteile eingeführt werden in das Modell übernommen und dann an nachgeschaltete Modelle weitergegeben.

Um dieses Problem zu lösen, hat OpenAI eine Pre-Training-Technologie entwickelt, um durch Filter verursachte Verzerrungen zu mildern. Um sicherzustellen, dass das AIGC-Modell die aktuelle soziale Situation zeitnah widerspiegeln kann, müssen Forscher außerdem die vom Modell verwendeten Datensätze regelmäßig aktualisieren, um die negativen Auswirkungen durch Informationsverzögerungen zu verhindern.

Es ist erwähnenswert, dass Vorurteile und Stereotypen in Quelldaten zwar reduziert werden können, sie sich jedoch während des Trainings und der Entwicklung von AIGC-Modellen dennoch verbreiten oder sogar verschärfen können. Daher ist es wichtig, das Vorhandensein von Voreingenommenheit, Toxizität und Fehlinformationen während des gesamten Trainings- und Entwicklungslebenszyklus des Modells zu bewerten, nicht nur auf Datenquellenebene.

Geistiges Eigentum (IP)

Mit der rasanten Entwicklung und weit verbreiteten Anwendung von AIGC ist die Urheberrechtsfrage von AIGC besonders wichtig geworden.

Im November 2022 reichte Matthew Butterick eine Sammelklage gegen die Microsoft-Tochter GitHub ein und beschuldigte deren Produktcode-Generierungsdienst Copilot, gegen Urheberrechte verstoßen zu haben. Wie bei Text-zu-Bild-Modellen wurde einigen generativen Modellen vorgeworfen, die ursprünglichen Rechte der Künstler an ihren Werken zu verletzen.

[Somepalli et al., 2022] zeigt, dass die von Stable Diffusion erzeugten Bilder aus den Trainingsdaten kopiert werden können. Obwohl Stable Diffusion jegliche Eigentumsrechte an den generierten Bildern verweigert und den Nutzern deren freie Nutzung gestattet, solange der Bildinhalt legal und harmlos ist, löst diese Freiheit dennoch heftige Auseinandersetzungen um das Urheberrecht aus.

Generative Modelle wie Stable Diffusion werden ohne Genehmigung des Inhabers des geistigen Eigentums auf großformatigen Bildern aus dem Internet trainiert, sodass einige Leute glauben, dass dies ihre Rechte verletzt.

Um Probleme mit geistigem Eigentum zu lösen, haben viele AIGC-Unternehmen Maßnahmen ergriffen.

Beispielsweise hat Midjourney eine DMCA-Deaktivierungsrichtlinie in seine Nutzungsbedingungen aufgenommen, die es Künstlern ermöglicht, bei Verdacht auf eine Urheberrechtsverletzung die Entfernung ihrer Werke aus dem Datensatz zu beantragen.

In ähnlicher Weise plant Stability AI, Künstlern die Möglichkeit zu geben, ihre Arbeit vom Trainingsset für zukünftige Versionen von Stable Diffusion auszuschließen. Darüber hinaus können Textwasserzeichen [He et al., 2022a; He et al., 2022b] auch verwendet werden, um festzustellen, ob diese AIGC-Tools ohne Genehmigung Proben aus anderen Quellen verwenden.

Stabile Diffusion generiert beispielsweise Bilder mit einem Getty Images-Wasserzeichen [Vincent, 2023].

OpenAI entwickelt eine Wasserzeichentechnologie zur Identifizierung von Text, der von GPT-Modellen generiert wurde, ein Tool, mit dem Pädagogen Plagiate in Aufgaben erkennen können. Google hat auch Parti-Wasserzeichen auf die von ihm veröffentlichten Bilder angewendet. Zusätzlich zu Wasserzeichen hat OpenAI kürzlich einen Klassifikator zur Unterscheidung zwischen KI-generiertem Text und von Menschen geschriebenem Text veröffentlicht.

Fazit

Obwohl AIGC noch in den Kinderschuhen steckt, expandiert es schnell und wird auf absehbare Zeit aktiv bleiben.

Damit Benutzer und Unternehmen diese Risiken vollständig verstehen und geeignete Maßnahmen zur Minderung dieser Bedrohungen ergreifen können, fassen wir in diesem Artikel die aktuellen und potenziellen Risiken im AIGC-Modell zusammen.

Wenn diese potenziellen Risiken nicht vollständig verstanden werden können und keine geeigneten Maßnahmen zur Risikoprävention und Sicherheitsgarantien ergriffen werden, kann die Entwicklung von AIGC vor erheblichen Herausforderungen und regulatorischen Hindernissen stehen. Deshalb brauchen wir eine breitere Beteiligung der Gemeinschaft, um zu einer verantwortungsvollen AIGC beizutragen.

Zum Schluss vielen Dank an SonyAI und BAAI!

Das obige ist der detaillierte Inhalt von„Bilderzeugungstechnologie' wandert am Rande des Gesetzes: In diesem Papier erfahren Sie, wie Sie vermeiden, zum „Angeklagten' zu werden.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr