Heim >Technologie-Peripheriegeräte >KI >Die „Top 100 AI Papers' im Jahr 2022 werden veröffentlicht: Tsinghua belegt den zweiten Platz nach Google und das Ningbo Institute of Technology wird zum größten dunklen Pferd

Die „Top 100 AI Papers' im Jahr 2022 werden veröffentlicht: Tsinghua belegt den zweiten Platz nach Google und das Ningbo Institute of Technology wird zum größten dunklen Pferd

- 王林nach vorne

- 2023-04-11 14:07:031985Durchsuche

Das Innovationstempo im Bereich der künstlichen Intelligenz wird immer schneller und die Zahl der Beiträge ist explosionsartig gestiegen und hat sogar ein für Menschen unleserliches Niveau erreicht.

Welche Institutionen haben unter den umfangreichen Veröffentlichungen im Jahr 2022 den größten Einfluss? Welche Artikel sind lesenswerter?

Kürzlich nutzte das ausländische Medium Zeta Alpha die klassische Zitatzahl als Bewertungsindikator, sammelte und stellte die 100 am häufigsten zitierten Artikel im Jahr 2022 zusammen und analysierte die in den letzten drei Jahren von verschiedenen Ländern und Institutionen veröffentlichten Artikel Jahre. Anzahl der am häufigsten zitierten Arbeiten. Die Vereinigten Staaten liegen immer noch an der Spitze, China an zweiter Stelle

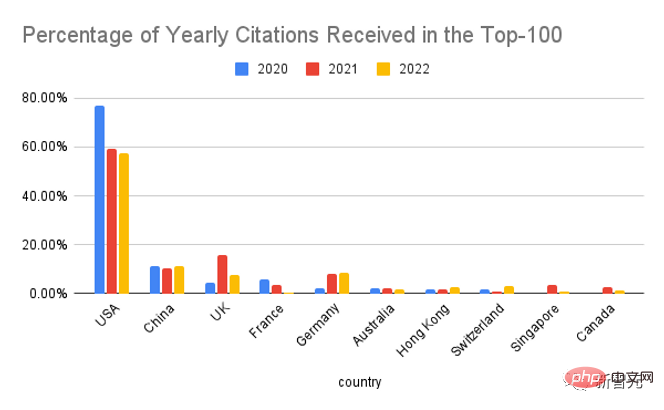

Unterteilt nach Ländern belegen die Vereinigten Staaten immer noch die Spitzenposition, ihr Anteil an den Top-100-Papieren ist jedoch im Vergleich zu 2020 deutlich zurückgegangen.

Unterteilt nach Organisation können wir sehen, dass Google schon immer der stärkste Akteur im Bereich KI war, gefolgt von Meta, Microsoft, der University of California, Berkeley, DeepMind und der Stanford University, die landesweit an erster Stelle steht Universität.

Als Leiter von Meta AI ist Yann LeCun auch stolz darauf, den Einfluss von Meta in der Branche bekannt zu geben und sagte, dass Meta AI mehr auf die Qualität der Veröffentlichung als auf die Quantität der Veröffentlichung achtet.

Obwohl die heutige Forschung im Bereich der künstlichen Intelligenz größtenteils von der Industrie geleitet wird und eine einzelne akademische Einrichtung aufgrund des Long-Tail-Effekts nur geringe Auswirkungen hat, ist die Wissenschaft insgesamt immer noch auf Augenhöhe mit der Industrie, wenn Daten nach Organisationstypen aggregiert werden Wenn man sieht, ist der Einfluss der beiden ungefähr gleich.

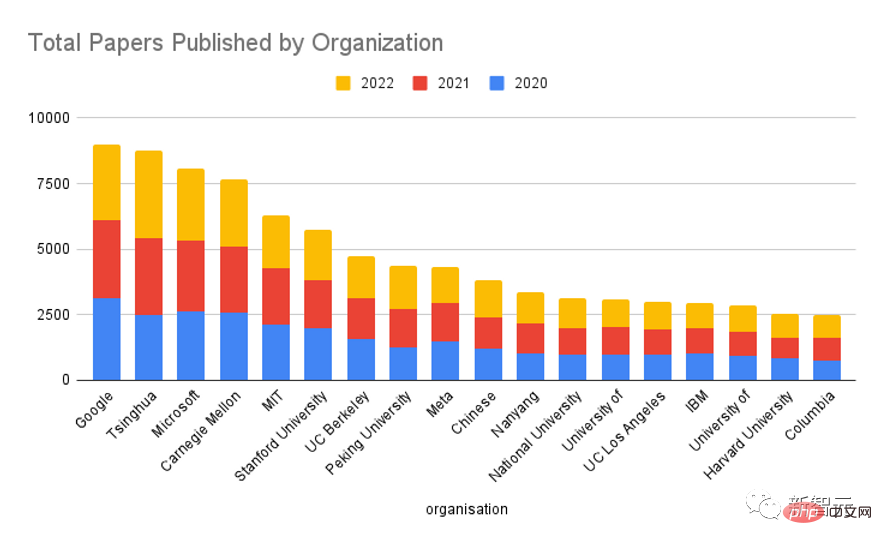

Wenn man auf die letzten drei Jahre zurückblickt und die Gesamtzahl der Forschungsergebnisse verschiedener Institutionen zählt, sieht man, dass Google immer noch vorne liegt, der Abstand im Vergleich zu anderen Institutionen jedoch deutlich geringer ist Erwähnenswert ist, dass die Tsinghua-Universität dicht hinter Google auf Platz zwei liegt.

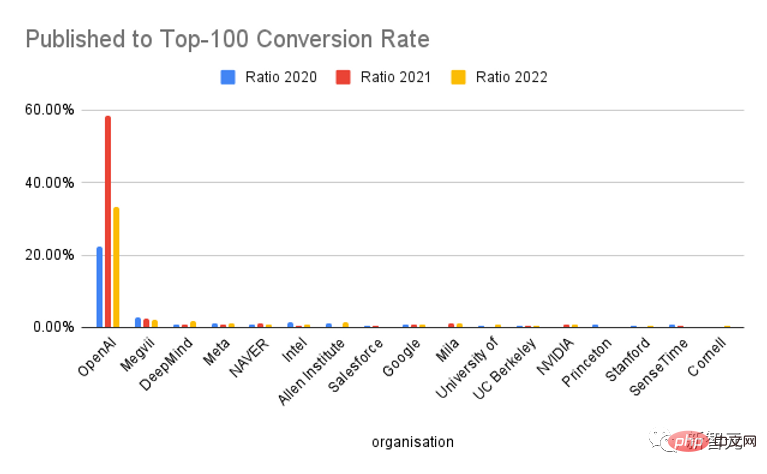

Wenn man sich den Anteil der Publikationen ansieht, die es in die Top-100 schaffen, ist OpenAI einzigartig und seine Conversion-Rate übertrifft die anderer Institutionen bei weitem. Im Grunde ist einer der beiden Artikel zu den „Top 100 Papers des Jahres“ geworden. .

Natürlich ist OpenAI, gemessen an der Popularität von ChatGPT, tatsächlich sehr gut im Marketing, was zu einem gewissen Anstieg der Zitationen geführt hat. Es ist unbestreitbar, dass die Qualität ihrer Forschungsergebnisse sehr hoch ist.

Sammeln Sie zunächst jedes Jahr die am häufigsten zitierten Papiere auf der Zeta Alpha-Plattform und überprüfen Sie dann manuell das Datum der ersten Veröffentlichung (normalerweise arXiv-Preprint). Kategorisieren Sie es entsprechend Jahr.

Ergänzen Sie diese Liste, indem Sie häufig zitierte KI-Artikel auf Semantic Scholar durchsuchen, das eine breitere Abdeckung bietet und nach der Anzahl der Zitate sortiert werden kann, hauptsächlich von einflussreichen Closed-Source-Verlagen (wie Nature, Elsevier, Springer und anderen Zeitschriften) für zusätzliche Artikel. Dann wird die Anzahl der Zitierungen jedes Aufsatzes bei Google Scholar als repräsentativer Indikator verwendet und die Aufsätze nach dieser Zahl sortiert, um die Top 100 Aufsätze innerhalb eines Jahres zu erhalten. Für diese Arbeiten verwenden Sie GPT-3, um die Autoren, ihre Zugehörigkeiten und Länder zu extrahieren und diese Ergebnisse manuell zu überprüfen (wenn das Land nicht in der Veröffentlichung enthalten ist, wird das Land verwendet, in dem die Organisation ihren Hauptsitz hat). Beiträge mit Autoren mehrerer Institutionen zählen einmal für jede Zugehörigkeit. 1. AlphaFold Protein Structure Database: Erweitert die strukturelle Abdeckung des Proteinsequenzraums massiv mit hochpräzisen Modellen Paper-Link: https://academic .oup.com/nar/article/50/D1/D439/6430488 Verlagsinstitution: European Molecular Biology Laboratory, DeepMind AlphaFold DB: https://alphafold.ebi. uk Anzahl der Zitate: 1331 AlphaFold Protein Structure Database AlphaFold DB ist eine öffentlich zugängliche, umfangreiche und hochpräzise Datenbank für Proteinstrukturvorhersagen. Diese Datenbank basiert auf AlphaFold v2.0 von DeepMind und ermöglicht eine beispiellose Erweiterung der strukturellen Abdeckung des bekannten Proteinsequenzraums. AlphaFold DB bietet programmgesteuerten Zugriff und interaktive Visualisierung vorhergesagter Atomkoordinaten, Modellkonfidenzschätzungen für jeden Rest und jedes Paar sowie vorhergesagte Ausrichtungsfehler. Die erste Version von AlphaFold DB enthält mehr als 360.000 vorhergesagte Strukturen, die die Proteome von 21 Modellorganismen abdecken, und wird in Zukunft erweitert, um die meisten (mehr als 100 Millionen) repräsentativen Sequenzen des UniRef90-Datensatzes abzudecken. 2. ColabFold: Proteinfaltung für alle zugänglich machen Code-Link: https://github.com/sokrypton/colabfold Umgebungs-Link: https://colabfold.mmseqs.comTop Five Papers im Jahr 2022

Zitate: 1138

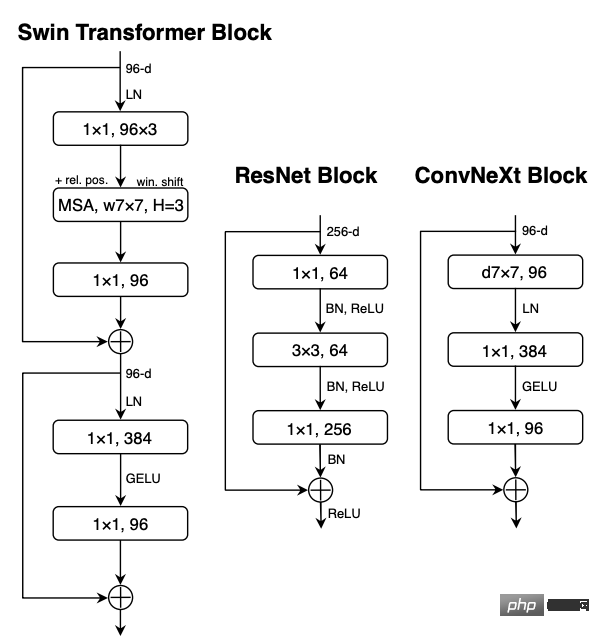

ColabFold beschleunigt die Vorhersage von Proteinstrukturen und -komplexen durch die Kombination der schnellen Homologiesuche von MMSEQS2 mit AlphaFold2 oder Rosettafold. ColabFold kann eine 40- bis 60-fach beschleunigte Suche und Optimierung der Modellnutzung erreichen und mit nur einer Grafikverarbeitungseinheit fast 1.000 Strukturen auf einem Server vorhersagen. ColabFold ist eine kostenlose und zugängliche Plattform für die Proteinfaltung, die auf Google Colaboratory basiert und außerdem eine verfügbare Open-Source-Software ist. 3. Ein ConvNet für die 2020er Jahre

Visuell erkennbar Das „ „Roaring 20s“ begann mit der Einführung von Visual Transformers (ViTs), die ConvNets schnell als fortschrittlichstes Bildklassifizierungsmodell ablösten. Andererseits stößt ein einfachstes ViT immer noch auf einige Schwierigkeiten, wenn es auf allgemeine Computer-Vision-Aufgaben wie Objekterkennung und semantische Segmentierung angewendet wird. Hierarchische Transformer (wie Swin Transformers) führen mehrere ConvNet-Priors wieder ein, wodurch der Transformer tatsächlich als allgemeines Vision-Modell-Backbone einsetzbar ist und bei verschiedenen Vision-Aufgaben eine signifikante Leistung zeigt.

Die Wirksamkeit dieses hybriden Ansatzes beruht jedoch immer noch hauptsächlich auf den inhärenten Vorteilen von Transformern und nicht auf der inhärenten induktiven Vorspannung von Faltungen.

In dieser Arbeit untersuchten die Forscher den Designraum erneut und testeten die Grenzen dessen, was reine ConvNets erreichen können.

Nach und nach wurde ein Standard-ResNet in das Design von ViT „modernisiert“ und dabei mehrere Schlüsselkomponenten entdeckt, die zum Leistungsunterschied beitrugen. Nach der Erkundung wurde ein reines ConvNet-Modell namens ConvNeXt entdeckt.

ConvNeXt besteht vollständig aus Standard-ConvNet-Modulen und ist in Bezug auf Genauigkeit und Skalierbarkeit auf Augenhöhe mit Transformer. Es erreicht eine ImageNet-Top-1-Genauigkeit von 87,8 % bei der COCO-Erkennung und ADE20K-Segmentierung und übertrifft Swin Transformers, während die Einfachheit und Effizienz von beibehalten wird Standard-ConvNets. 4. Hierarchische textbedingte Bildgenerierung mit CLIP-Latenten

Zitate: 718 Kontrastive Modelle wie CLIP erlernen nachweislich robuste Bilddarstellungen, die Semantik und Stil erfassen.

Um diese Darstellungen zur Generierung von Bildern zu nutzen, schlagen die Forscher ein zweistufiges Modell vor: einen Prior, der CLIP-Bilderinbettungen bei gegebener Textbeschriftung generiert, und einen Decoder, der von Bildeinbettungen abhängige Bilder generiert.

Experimente haben gezeigt, dass die explizite Generierung von Bilddarstellungen die Bildvielfalt bei minimalem Verlust an Wiedergabetreue und Titelähnlichkeit verbessern kann und dass auf Bilddarstellungen konditionierte Decoder auch Änderungen in Bildern erzeugen können, die ihre Semantik und ihren Stil bewahren, während sie gleichzeitig unwesentliche Details ändern sind in der Bilddarstellung nicht vorhanden.

Experimente haben gezeigt, dass die explizite Generierung von Bilddarstellungen die Bildvielfalt bei minimalem Verlust an Wiedergabetreue und Titelähnlichkeit verbessern kann und dass auf Bilddarstellungen konditionierte Decoder auch Änderungen in Bildern erzeugen können, die ihre Semantik und ihren Stil bewahren, während sie gleichzeitig unwesentliche Details ändern sind in der Bilddarstellung nicht vorhanden.

Verwenden Sie ein Diffusionsmodell für den Decoder und experimentieren Sie mit a priori autoregressiven Modellen und Diffusionsmodellen. Dabei stellen Sie fest, dass letzteres recheneffizienter ist und qualitativ hochwertigere Proben generieren kann. 5. PaLM: Skalierung der Sprachmodellierung mit Pathways Zitate: 426

Es hat sich gezeigt, dass große Sprachmodelle durch das Lernen mit wenigen Schüssen bei einer Vielzahl natürlicher Sprachaufgaben eine höhere Leistung erzielen, wodurch die Anzahl der aufgabenspezifischen Trainingsinstanzen, die zur Anpassung des Modells an eine bestimmte Anwendung erforderlich sind, erheblich reduziert wird. Um den Einfluss der Skalierung auf das Lernen mit wenigen Schüssen besser zu verstehen, trainierten die Forscher ein dicht aktiviertes Transformer-Sprachmodell mit 540 Milliarden Parametern, das Pathways Language Model (PaLM). PaLM wurde auf 6144 TPU v4-Chips mithilfe von Pathways (einem neuen ML-System, das ein effizientes Training auf mehreren TPU-Pods ermöglicht) trainiert und erreichte mit Hunderten von Sprachverständnis- und Generierungs-Benchmarks den neuesten Stand der Technik – die Lernergebnisse zeigen dies Vorteile der Skalierung.

Bei einigen dieser Aufgaben erreicht PaLM 540B eine bahnbrechende Leistung, übertrifft den Stand der Technik bei der Feinabstimmung einer Reihe mehrstufiger Inferenzaufgaben und übertrifft die durchschnittliche menschliche Leistung beim kürzlich veröffentlichten BIG-Bench-Benchmark.

Eine große Anzahl von BIG-Bench-Aufgaben zeigt diskontinuierliche Verbesserungen der Modellgröße, was auch bedeutet, dass sich die Leistung plötzlich verbessert, wenn der Maßstab auf das größte Modell erweitert wird.

PaLM verfügt außerdem über starke Fähigkeiten bei mehrsprachigen Aufgaben und der Quellcode-Generierung, was auch in einer Reihe von Benchmark-Tests nachgewiesen wurde.

Darüber hinaus führen die Forscher eine umfassende Analyse von Bias und Toxizität durch und untersuchen, inwieweit Trainingsdaten im Verhältnis zur Modellgröße gespeichert werden können. Abschließend diskutieren die Forscher ethische Überlegungen im Zusammenhang mit großen Sprachmodellen Mögliche Minderungsstrategien. Top fünf inländische Zeitungen im Jahr 2022

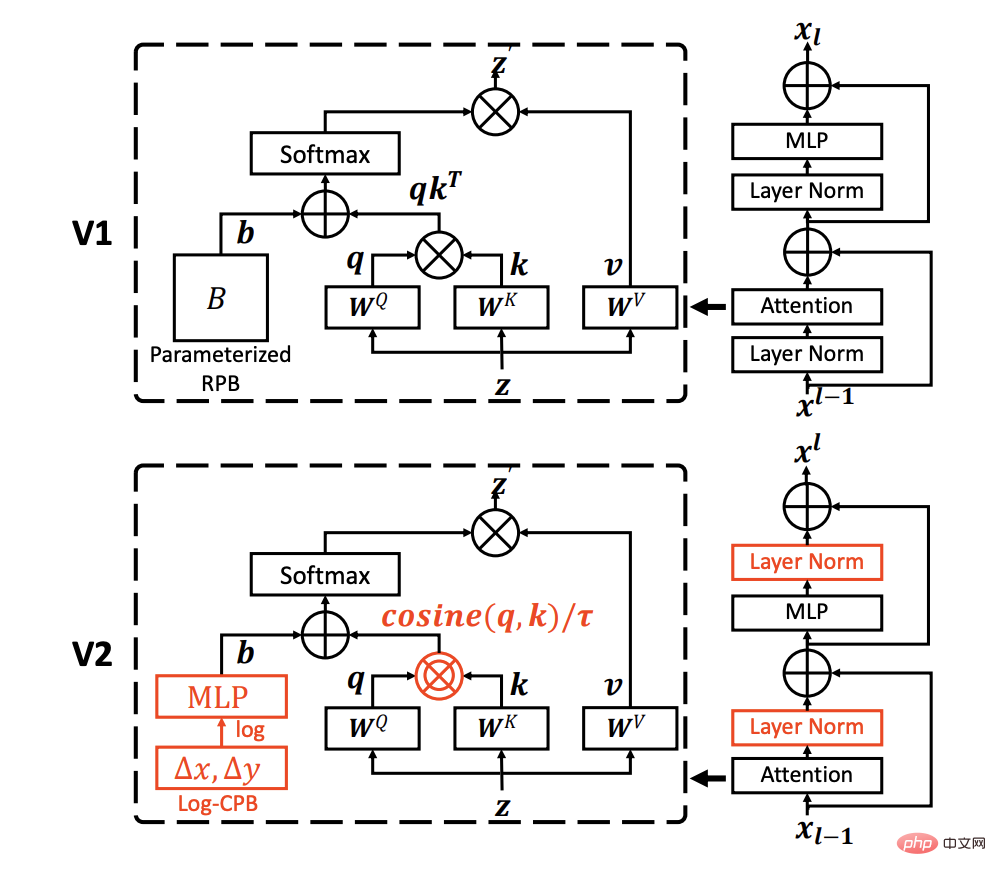

1. Swin Transformer V2: Skalierung von Kapazität und Auflösung

Papierlink: https://arxiv.org/pdf/2111.09883.pdf

Codelink: https://github.com/microsoft/Swin-Transformer

Zitate: 266

Es hat sich gezeigt, dass groß angelegte NLP-Modelle die Leistung von Sprachaufgaben ohne Anzeichen von Sättigung erheblich verbessern und gleichzeitig erstaunliche Wenig-Schuss-Fähigkeiten wie Menschen demonstrieren.

Dieser Artikel zielt darauf ab, groß angelegte Modelle in der Computer-Vision zu untersuchen und drei Hauptprobleme beim Training und der Anwendung groß angelegter Vision-Modelle zu lösen, darunter die Instabilität des Trainings, die Auflösungslücke zwischen Vortraining und Feinabstimmung sowie die Notwendigkeit für beschriftete Daten.

Die Forscher schlugen drei Haupttechniken vor:

1) Eine Residuen-Post-Normalisierungsmethode kombiniert mit Kosinus-Aufmerksamkeit, um die Stabilität des Trainings zu verbessern;

2) Eine logarithmische Methode zur kontinuierlichen Positionsverzerrung zur effektiven Verbesserung Übertragen Sie Modelle, die mit Bildern mit niedriger Auflösung vorab trainiert wurden, auf nachgelagerte Aufgaben mit Eingaben mit hoher Auflösung.

Durch diese Techniken haben wir erfolgreich ein Swin Transformer V2-Modell mit 3 Milliarden Parametern trainiert, das bisher größte dichte Sichtmodell, und es ermöglicht, es mit Bildern mit einer Auflösung von bis zu 1.536 x 1.536 zu trainieren.

Stellen Sie neue Leistungsrekorde bei 4 repräsentativen Sehaufgaben auf, darunter ImageNet-V2-Bildklassifizierung, COCO-Objekterkennung, semantische ADE20K-Segmentierung und Kinetics-400-Videoaktionsklassifizierung.

Gleichzeitig kann festgestellt werden, dass das Training viel effizienter ist als das Training im Vision-Modell auf Milliardenebene von Google und 40-mal weniger gekennzeichnete Daten und Trainingszeit verbraucht.

2. Ensemble unbeaufsichtigter Autoencoder und Gaußsches Mischungsmodell zur Erkennung von CyberangriffenFrühere Forschungen nutzten unüberwachtes maschinelles Lernen mit Dimensionsreduzierung zur Netzwerkerkennung, das sich auf die Robustheit bei der Erkennung hochdimensionaler und spärlicher Daten beschränkte.

Die meisten Methoden gehen normalerweise davon aus, dass die Parameter jeder Domäne homogen sind und eine spezifische Gaußsche Verteilung aufweisen, wobei der Robustheitstest der Datenschiefe ignoriert wird.

Link zum Papier: https://www.sciencedirect.com/science/article/pii/S0306457321003162 GMM) unbeaufsichtigter Ensemble-Autoencoder zur Anpassung an mehrere Domänen, ohne die Schiefe jeder Domäne zu berücksichtigen. Im latenten Raum des integrierten Autoencoders werden die aufmerksamkeitsbasierte latente Darstellung und die Merkmale des minimalen Fehlers der Rekonstruktion genutzt, und der Erwartungsmaximierungsalgorithmus (EM) wird verwendet, um die Probendichte im GMM zu schätzen Die geschätzte Probendichte überschreitet. Wenn während der Trainingsphase die Lernschwelle erreicht wird, wird die Probe als Ausreißer im Zusammenhang mit der Anomalie identifiziert. Abschließend werden der integrierte Autoencoder und GMM gemeinsam optimiert, um die Optimierung der Zielfunktion in ein Lagrange-Dualproblem umzuwandeln. Experimente, die an drei öffentlichen Datensätzen durchgeführt wurden, verifizieren die Leistung des vorgeschlagenen Modells und der ausgewählten Basislinie zur Anomalieerkennung. es ist deutlich wettbewerbsfähig.

Die Co-Autoren des Papiers sind Professor An Peng vom Ningbo Institute of Technology und Zhiyuan Wang von der Tongji-Universität. Professor An Peng ist derzeit stellvertretender Dekan der Fakultät für Elektronik und Informationstechnik des Ningbo Institute of Technology. Er studierte von 2000 bis 2009 an der Fakultät für Technische Physik der Tsinghua-Universität und erhielt einen Bachelor-Abschluss und einen Doktortitel in Ingenieurwissenschaften. CERN, National Pardo, Italien Gastwissenschaftler an der University of War und der Universität Heidelberg in Deutschland, Mitglied des Cognitive Computing and Systems Professional Committee der Chinese Automation Society, Mitglied des Cognitive Systems and Information Processing Professional Committee der Chinese Artificial Intelligence Society , und Mitglied des Jugendarbeitsausschusses der Chinese Command and Control Society; leitete und beteiligte sich an nationalen Schlüsselprojekten des Basic Research Development Plan (973 Plan), der National Natural Science Foundation of China, dem National Spark Program und vielen anderen wissenschaftlichen Forschungsprojekten.

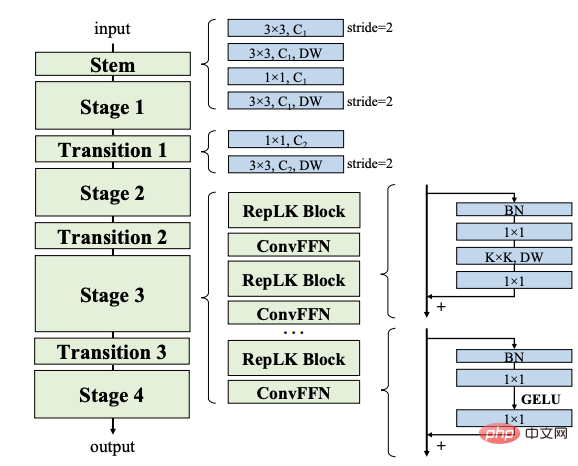

3. Skalieren Sie Ihre Kernel auf 31x31: Überarbeitung des großen Kernel-Designs in CNNs

Papierlink: https://arxiv.org/abs/2203.06717

Code-Link: https://github.com/megvii-research/RepLKNet

Zitate: 127

Der Artikel befasst sich mit dem Design großer Kerne in modernen Faltungs-Neuronalen Netzen (CNN).

Inspiriert durch die jüngsten Fortschritte bei Visual Transformers (ViTs) zeigt dieses Papier, dass die Verwendung mehrerer großer Faltungskerne anstelle einer Reihe kleiner Kerne ein leistungsfähigeres Paradigma sein könnte.

Die Forscher schlugen fünf Richtlinien vor, beispielsweise die Anwendung neu parametrisierter Faltungen mit großer Tiefe, um effiziente Hochleistungs-CNNs mit großem Kernel zu entwerfen.

Basierend auf diesen Richtlinien schlagen wir RepLKNet vor, eine reine CNN-Architektur mit einer Kernelgröße von 31x31. Im Gegensatz zum häufig verwendeten 3x3 reduziert RepLKNet die Leistungslücke zwischen CNNs und ViTs erheblich, z. B. vergleichbare Ergebnisse oder besser als Swin Transformer mit geringerer Latenz auf ImageNet und einigen typischen Downstream-Aufgaben.

RepLKNet zeigt auch eine gute Skalierbarkeit für Big Data und große Modelle und erreicht die höchste Genauigkeit von 87,8 % bei ImageNet, 56,0 % mIoU bei ADE20K, und modernste Technologie ist bei ähnlichen Modellgrößen sehr wettbewerbsfähig.

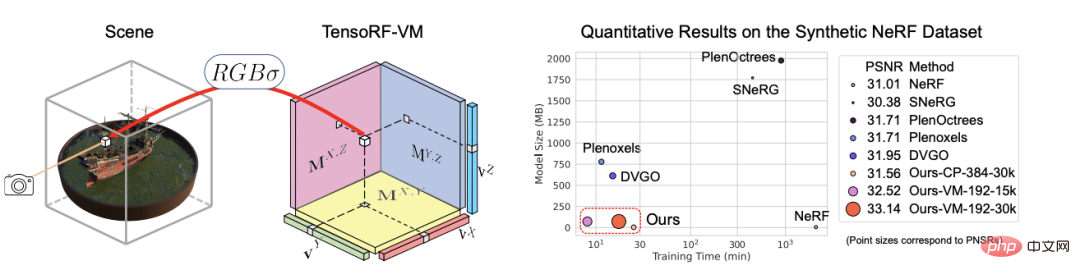

Die Studie zeigt außerdem, dass CNNs mit großem Kern im Vergleich zu CNNs mit kleinem Kern größere effektive Empfangsfelder und eine höhere Formverzerrung anstelle einer Texturverzerrung aufweisen. 4. TensoRF: Tensorial Radiance Fields

TensoRF wird im Artikel vorgeschlagen , Eine neue Methode zur Modellierung und Rekonstruktion von Strahlungsfeldern. Im Gegensatz zu NeRF, das ausschließlich MLP verwendet, modellieren die Forscher das Strahlungsfeld der Szene als 4D-Tensor, der ein dreidimensionales Voxelgitter mit Mehrkanalfunktionen pro Voxel darstellt. Die zentrale Idee besteht darin, die 4D-Szene zu zerlegen Tensor in mehrere kompakte Tensorkomponenten mit niedrigem Rang. Es ist erwiesen, dass die Anwendung der traditionellen CP-Zerlegung in diesem Rahmen, die Zerlegung von Tensoren in Rang-1-Komponenten mit kompakten Vektoren, zu einer besseren Leistung führt als gewöhnliches NeRF.

Um die Leistung weiter zu verbessern, führt das Papier auch eine neue Vektormatrix-Zerlegung (VM) ein, die die niedrigrangigen Einschränkungen der beiden Tensormodi lockert und die Tensoren in kompakte Vektoren und Matrixfaktoren zerlegt .

Zusätzlich zu einer besseren Rendering-Qualität führten frühere und gleichzeitige Arbeiten zur direkten Optimierung von Pro-Pixel-Funktionen zu einem erheblichen Speicherbedarf für dieses Modell im Vergleich zur CP- und VM-Zerlegung. Experimente haben gezeigt, dass TensoRF mit CP-Zerlegung im Vergleich zu NeRF eine schnelle Rekonstruktion (

Darüber hinaus verbessert TensoRF mit VM-Zerlegung die Rendering-Qualität weiter und übertrifft bisherige Methoden auf dem neuesten Stand der Technik, während gleichzeitig die Rekonstruktionszeit (5. 602

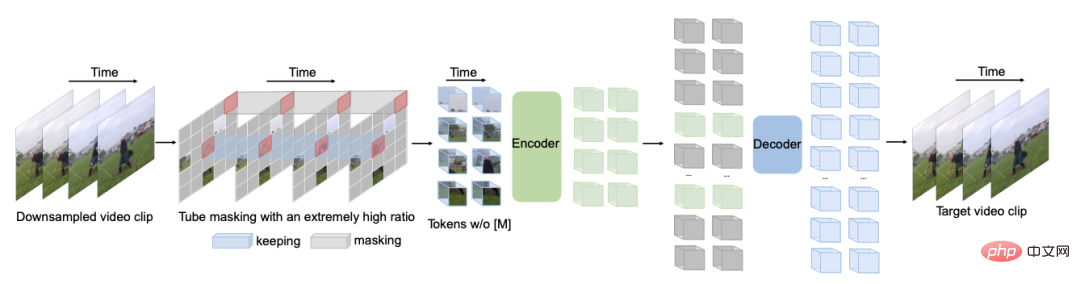

Zitate: 100

Um eine höhere Leistung bei relativ kleinen Datensätzen zu erzielen, was normalerweise der Fall ist erfordert ein Vortraining des Video-Transformers für zusätzliche große Datensätze. Dieser Artikel zeigt, dass der Video Masked Autoencoder (VideoMAE) ein dateneffizienter Lerner für selbstüberwachtes Video-Vortraining (SSVP) ist. Inspiriert durch das aktuelle ImageMAE schlagen Forscher eine maßgeschneiderte Videoröhre mit extrem hohem Maskenverhältnis vor. Dieses einfache Design macht die Videorekonstruktion zu einer anspruchsvolleren selbstüberwachten Aufgabe und fördert so die Extraktion effektiverer Videodarstellungen während dieses Vortrainingsprozesses.

Drei wichtige Erkenntnisse wurden zu SSVP gewonnen:

(1) Ein extrem hoher Anteil der Maskierungsrate (d. h. 90 % bis 95 %) kann immer noch zu einer günstigen Leistung von VideoMAE führen. Zeitlich redundante Videoinhalte führen zu höheren Maskierungsraten als Bilder.

(2) VideoMAE erreicht eine sehr hohe Leistung bei sehr kleinen Datensätzen (d. h. etwa 3k-4k-Videos), ohne dass zusätzliche Daten verwendet werden.

(3) VideoMAE zeigt, dass für SSVP die Datenqualität wichtiger ist als die Datenmenge.

Der Domänentransfer zwischen Pre-Training- und Zieldatensätzen ist ein wichtiges Thema.

Es ist erwähnenswert, dass VideoMAE mit gewöhnlichem ViT 87,4 % bei Kinetics-400, 75,4 % bei Something-Something V2, 91,3 % bei UCF101 und 62,6 % bei HMDB51 erreichen kann, ohne zusätzliche Daten zu verwenden.

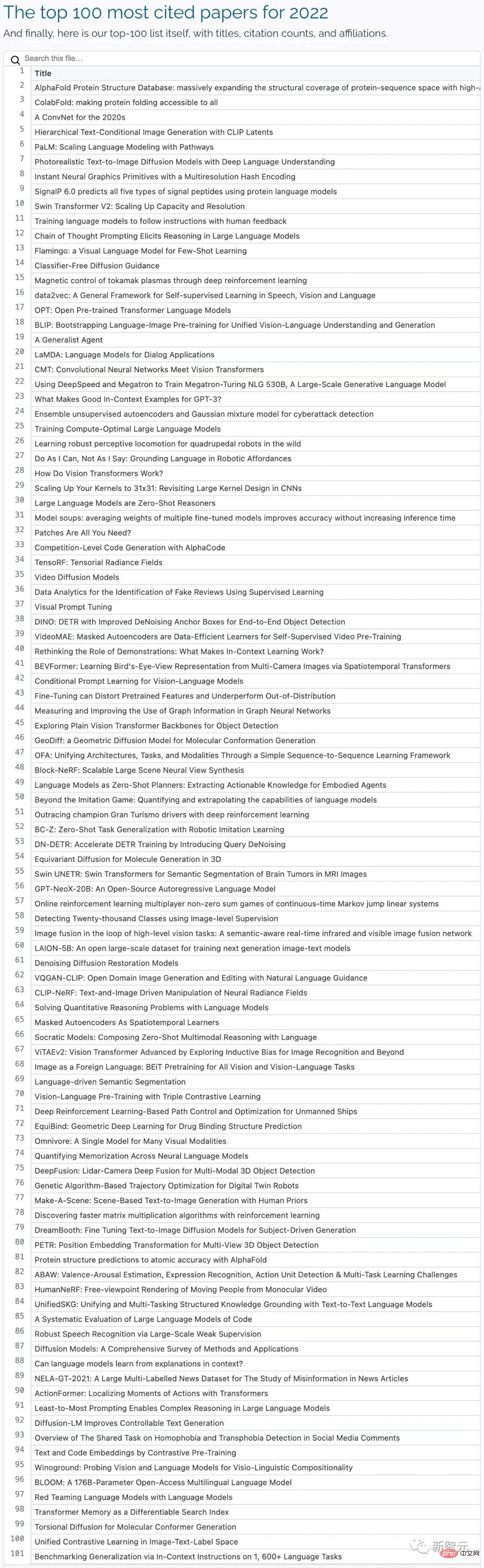

Vollständige Liste der 100 besten Artikel

Das obige ist der detaillierte Inhalt vonDie „Top 100 AI Papers' im Jahr 2022 werden veröffentlicht: Tsinghua belegt den zweiten Platz nach Google und das Ningbo Institute of Technology wird zum größten dunklen Pferd. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr