Heim >Technologie-Peripheriegeräte >KI >Die Effizienz übertrifft DALL·E 2 und Imagen, Googles neues Modell erreicht neue SOTA und kann auch PS in einem Satz verarbeiten

Die Effizienz übertrifft DALL·E 2 und Imagen, Googles neues Modell erreicht neue SOTA und kann auch PS in einem Satz verarbeiten

- 王林nach vorne

- 2023-04-11 13:49:031703Durchsuche

Zu Beginn des neuen Jahres hat Google AI wieder damit begonnen, an Modellen zur Text-Bild-Generierung zu arbeiten.

Dieses Mal erreichte ihr neues Modell Muse ein neues SOTA (derzeit bestes Niveau) im CC3M-Datensatz.

Und seine Effizienz ist weitaus höher als die des beliebten DALL·E 2 und Imagen (beides Diffusionsmodelle) und Parti (ein autoregressives Modell).

——Die Generierungszeit eines einzelnen Bildes mit einer Auflösung von 512 x 512 wird auf nur 1,3 Sekunden komprimiert.

In Bezug auf die Bildbearbeitung können Sie das Originalbild mit nur einem Textbefehl bearbeiten.

(Sieht so aus, als müssten Sie sich keine Gedanken mehr über das Erlernen von PS~ machen)

Wenn Sie einen präziseren Effekt wünschen, können Sie auch die Maskenposition auswählen und einen bestimmten Bereich bearbeiten. Ersetzen Sie beispielsweise die Gebäude im Hintergrund durch Heißluftballons.

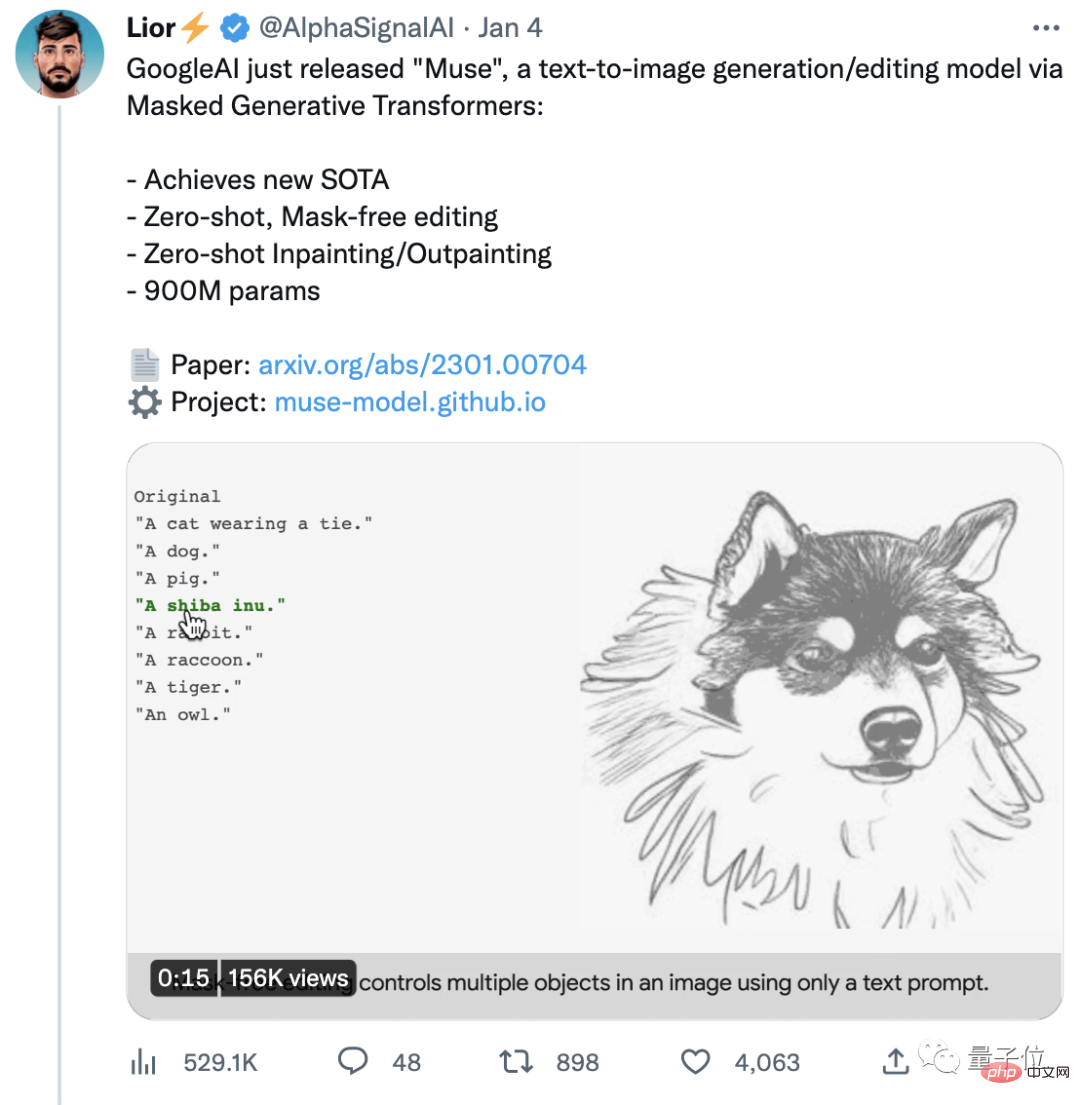

Muse erregte nach der offiziellen Ankündigung schnell große Aufmerksamkeit. Der Originalbeitrag hat bereits über 4.000 Likes erhalten.

Beim Anblick eines weiteren Meisterwerks von Google haben einige sogar begonnen, vorherzusagen:

Der Wettbewerb unter KI-Entwicklern ist jetzt sehr hart und es scheint, dass 2023 ein sehr aufregendes Jahr wird.

Effizienter als DALL·E 2 und Imagen

Zurück zum Muse, das gerade von Google veröffentlicht wurde.

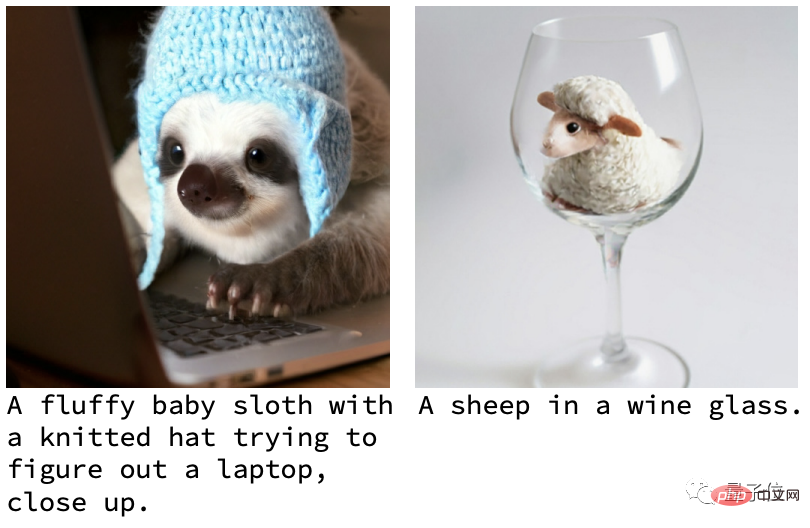

Was zunächst die Qualität der erzeugten Bilder betrifft, weisen die meisten Werke von Muse klare Bilder und natürliche Effekte auf.

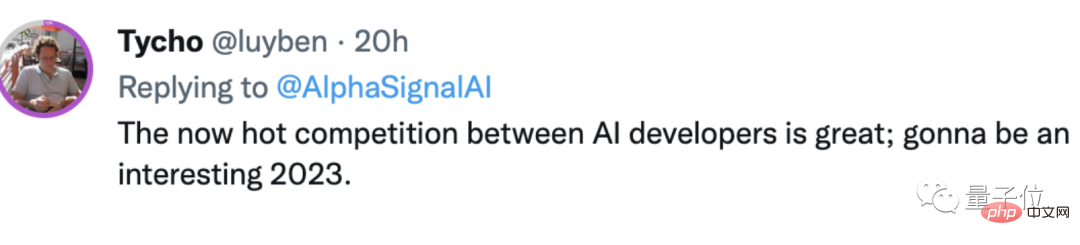

Schauen wir uns weitere Beispiele an, um ein Gefühl dafür zu bekommen~

Zum Beispiel bedient ein Faultierbaby mit Wollmütze einen Computer; ein anderes Beispiel ist ein Schaf in einem Weinglas:

Verschiedene Themen die normalerweise nicht mit acht Polen getroffen werden können. Sie koexistieren harmonisch in einem Bild und es gibt kein Gefühl von Dissonanz.

Wenn Sie der Meinung sind, dass dies nur die Grundfunktionen von AIGC sind, können Sie sich auch die Bearbeitungsfunktion von Muse ansehen.

Zum Beispiel Outfitwechsel mit einem Klick (Sie können auch das Geschlecht ändern):

Dies erfordert keine Maskierung und kann in einem Satz erfolgen.

Und wenn Sie eine Maske verwenden, können Sie 6 weitere Vorgänge ausführen, einschließlich des Wechselns des Hintergrunds mit einem Klick vom ursprünglichen Ort nach New York, Paris und dann nach San Francisco.

Sie können auch vom Meer nach London zum Blumenmeer fahren oder sogar zu den Saturnringen im Weltraum fliegen, um einen aufregenden Skateboard-Delfinsprung zu machen.

(Guter Kerl, man kann nicht nur ganz einfach in der Wolke reisen, sondern auch mit einem Klick in den Himmel fliegen...)

Der Effekt ist wirklich hervorragend. Welcher technische Support steckt also hinter Muse? Warum ist die Effizienz höher als bei DALL·E 2 und Imagen?

Ein wichtiger Grund ist, dass DALL·E 2 und Imagen während des Trainingsprozesses das gesamte gelernte Wissen in den Modellparametern speichern müssen.

Sie müssen also immer größere Modelle und immer mehr Trainingsdaten benötigen, um sich mehr Wissen anzueignen – und so „Better and Bigger“ miteinander zu verbinden.

Der Preis besteht darin, dass die Anzahl der Parameter enorm ist und auch die Effizienz beeinträchtigt wird.

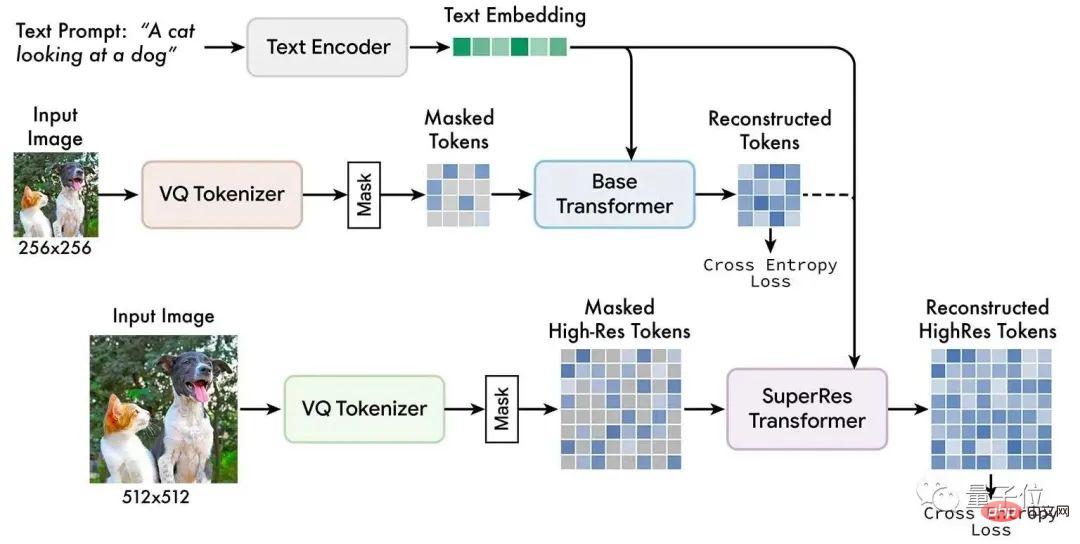

Nach Angaben des Google AI-Teams heißt die Hauptmethode, die sie verwenden: Maskierte Bildmodellierung.

Dies ist eine neue selbstüberwachte Vortrainingsmethode. Ihre Grundidee ist einfach:

Ein Teil des Eingabebildes wird zufällig ausgeblendet und dann durch Textaufgaben vor dem Training rekonstruiert.

Muse-Modelle werden auf diskret beschrifteten räumlichen Masken trainiert und mit Text kombiniert, der aus vorab trainierten großen Sprachmodellen extrahiert wurde, um zufällig maskierte Bildbeschriftungen vorherzusagen.

Von oben nach unten: vorab trainierter Textencoder, Basismodell, Superauflösungsmodell

Das Google-Team hat herausgefunden, dass die Verwendung vorab trainierter großer Sprachmodelle das Sprachverständnis der KI detaillierter und gründlicher machen kann.

In Bezug auf die Ausgabe können die erzeugten Bilder eine hohe Wiedergabetreue aufweisen, da die KI die räumliche Beziehung, die Haltung und andere Elemente von Objekten gut versteht.

Im Vergleich zu Pixelraumdiffusionsmodellen wie DALL·E 2 und Imagen verwendet Muse diskrete Token und hat weniger Sampling-Iterationen.

Darüber hinaus verwendet Muse im Vergleich zu autoregressiven Modellen wie Parti die parallele Dekodierung, was effizienter ist.

SOTA-Score bei FID

Wie bereits erwähnt, hat Muse nicht nur die Effizienz verbessert, sondern ist auch sehr gut bei der Erzeugung von Bildqualität.

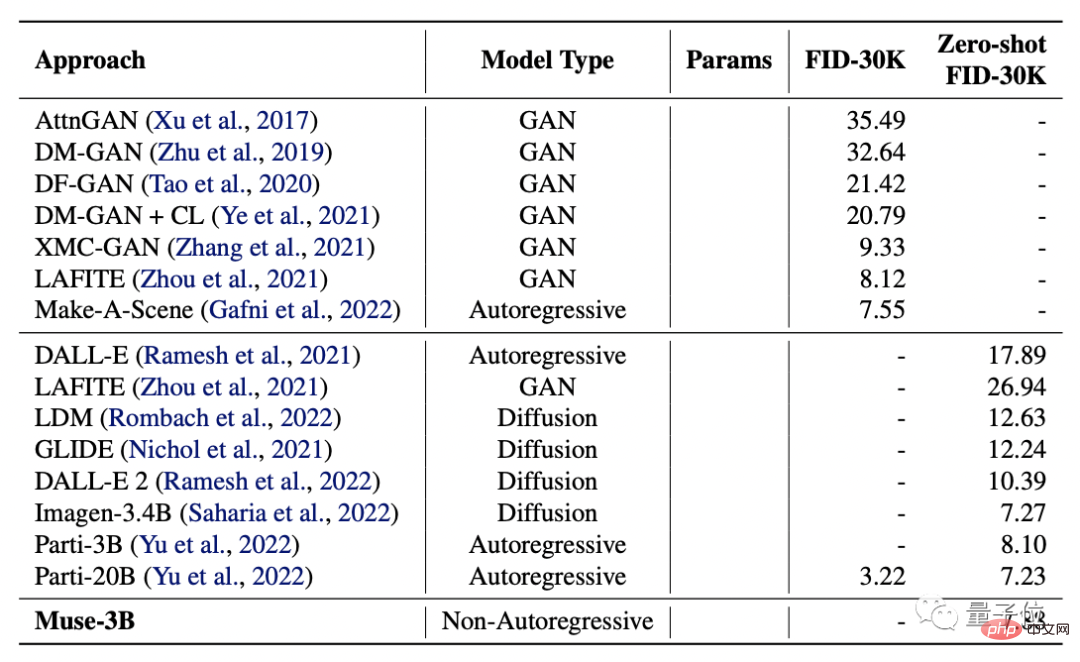

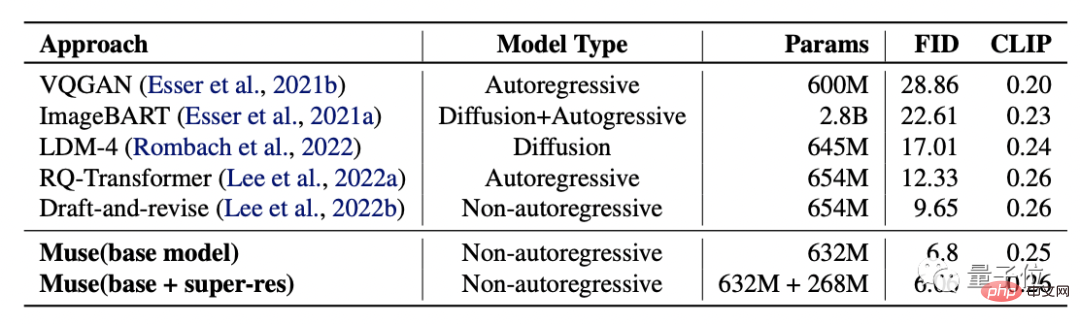

Die Forscher verglichen es mit DALL·E, LAFITE, LDM, GLIDE, DALL·E 2 sowie Googles eigenem Imagen und Parti und testeten deren FID- und CLIP-Scores.

(Der FID-Score wird verwendet, um die Qualität des generierten Bildes zu bewerten. Je niedriger der Score, desto höher die Qualität; der CLIP-Score stellt den Grad der Übereinstimmung zwischen Text und Bild dar. Je höher der Score, desto besser.)

Die Ergebnisse zeigen, dass das Muse-3B-Modell in COCO verifiziert wurde. Der zentralisierte Zero-Shot FID-30K erzielte einen Wert von 7,88 und lag damit an zweiter Stelle hinter den Modellen Imagen-3.4B und Parti-20B mit größeren Parametern.

Noch besser: Das Muse-900M-Modell erreichte einen neuen SOTA im CC3M-Datensatz mit einem FID-Score von 6,06, was auch bedeutet, dass der Übereinstimmungsgrad mit Text am höchsten ist.

Gleichzeitig liegt der CLIP-Score dieses Modells bei 0,26, was im gleichen Zeitraum ebenfalls den höchsten Wert erreicht hat.

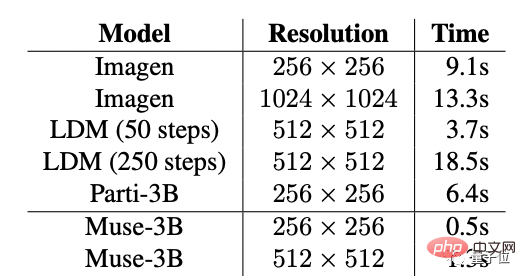

Um die Bildwiedergabeeffizienz von Muse weiter zu bestätigen, verglichen die Forscher außerdem die Einzelbilderzeugungszeit von Muse und anderen Modellen:

Muse erreichte die höchste Auflösung bei 256 x 256 und 512 x 512. Schnelle Geschwindigkeit: 0,5 s und 1,3 s.

Forschungsteam

Muses Forschungsteam kommt von Google und die beiden Co-Autoren sind Huiwen Chang und Han Zhang.

Huiwen Chang, jetzt leitende Forscherin bei Google.

Sie hat als Studentin an der Tsinghua University studiert und an der Princeton University promoviert. Sie hat Praktikumserfahrung bei Adobe, Facebook usw. gesammelt.

Han Zhang erhielt seinen Bachelor-Abschluss von der China Agricultural University, seinen Master-Abschluss von der Beijing University of Posts and Telecommunications und seinen Ph.D. in Informatik von der Rutgers University.

Seine Forschungsrichtungen sind Computer Vision, Deep Learning und medizinische Bildanalyse.

Es ist jedoch erwähnenswert, dass Muse noch nicht offiziell veröffentlicht wurde.

Einige Internetnutzer scherzten, dass Muse aufgrund des „Harnverhaltens“ von Google möglicherweise noch lange von der offiziellen Veröffentlichung entfernt sei, obwohl es sehr wohlriechend sein sollte – schließlich haben sie seit 18 Jahren keine KI mehr veröffentlicht.

Apropos, was haltet Ihr von der Wirkung von Muse?

Freust du dich auf die offizielle Veröffentlichung?

Portal:https://www.php.cn/link/854f1fb6f65734d9e49f708d6cd84ad6

Referenzlink: https://twitter.com / AlphaSignalAI/status/1610404589966180360

Das obige ist der detaillierte Inhalt vonDie Effizienz übertrifft DALL·E 2 und Imagen, Googles neues Modell erreicht neue SOTA und kann auch PS in einem Satz verarbeiten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr