Heim >Technologie-Peripheriegeräte >KI >Eine ausführliche Überlegung zum Rederecht von ChatGPT: Werden sich Menschen in großen Modellen verlieren?

Eine ausführliche Überlegung zum Rederecht von ChatGPT: Werden sich Menschen in großen Modellen verlieren?

- 王林nach vorne

- 2023-04-10 17:41:03852Durchsuche

Der ChatGPT-Trend wird immer intensiver und die Linguistin Emily M. Bender von der University of Washington hat sich dagegen ausgesprochen, große Models (LLM) übermäßig in das Leben der Menschen eingreifen zu lassen.

Google und Amazon erwähnten in ihren Artikeln, dass LLM bereits über eine Chain of Thought (CoT) und eine spontane Strukturentstehung (Emergence) verfügt. Mit anderen Worten: LLM hat begonnen, den menschlichen „langsamen Denkmodus“ zu erlernen und zu antworten basierend auf logischem Denken, anstatt nur auf der Grundlage der Intuition zu antworten.

Als Linguist hat Bender die Gefahr der „Machtausweitung“ von LLM erkannt, und einige Leute begannen zu glauben: „Wir sollten die Idee aufgeben , dass „Menschen“ für „Arten“ so wichtig sind.“

Hinter dieser Idee verbirgt sich tatsächlich ein KI-Ethikproblem, das durch die hohe Entwicklung von LLM entstehen könnte: Wenn wir eines Tages einen Chat-Roboter erschaffen, den Menschen nicht unterscheiden können, genießt dieser Roboter dann „Menschenrechte“?

Bender äußerte tiefe Besorgnis darüber. Obwohl die Materialien auf der Erde wichtig sind, ist der Weg vomSprachmodellzur Existenzkrise für diejenigen auf der Erde, die Atomwaffen verstehen, nur sehr wenige , LLM hat einen enormen Einfluss, aber noch hat niemand klar gezeigt, welche Auswirkungen es auf unser Leben haben wird. Gleichzeitig haben es nur wenige Menschen getan Wie Bender haben viele Schulen, Zeitschriften und akademische Konferenzen die Verwendung von ChatGPT verboten, und einige Unternehmen haben sich diesem Lager angeschlossen.

Bender weiß, dass es nicht mit Trillion Games konkurrieren kann Sie fragt sich immer noch, wem dient LLM? Sie hofft, dass die Menschen ihre Position so schnell wie möglich erkennen können, bevor der Tag des Verlusts kommt.Solange es so ist, sollten wir respektiert werden moralisch.

Um das Leseerlebnis zu gewährleisten, wurde der Artikel mit Hilfe von ChatGPT gekürzt und angepasst wurden von Oktopussen getäuscht

Bevor Microsofts Bing anfing, gruselige Liebesbriefe auszugeben, bevor Metas Galactica anfing, rassistische Bemerkungen zu machen, begann ChatGPT, Artikel über so hervorragende Universitätsarbeiten zu schreiben, dass einige Professoren sagten: „Vergiss es, ich schenke es nicht.“ „Bevor Technikjournalisten begannen, sich von der Idee zu distanzieren, dass KI die Zukunft der Suche und vielleicht die Zukunft von allem sein wird, haben Emily M. Bender und andere gemeinsam ein „Octopus Paper“ verfasst.

Bender ist Eine Computerlinguistin an der University of Washington veröffentlichte 2020 einen Artikel zur Veranschaulichung großer Sprachmodelle (LLMs) – Die Technologie hinter dem Roboter ChatGPT – was er kann und was nicht Die Situation stellt sich wie folgt dar: Angenommen, A und B sprechen beide fließend Englisch und sind auf zwei unbewohnten Inseln gefangen. Quick entdeckt, dass frühere Inselbesucher Telegramme hinterlassen haben und A und B beginnen, fröhlich Nachrichten zu senden Währenddessen findet ein superintelligenter Tiefseekrake namens O, der die beiden Inseln nicht besuchen oder beobachten kann, eine Möglichkeit, eine Verbindung zu einem Unterwasserkabel herzustellen und dem Gespräch von A und B zuzuhören. O wusste zunächst nichts über Englisch, war aber sehr gut in der statistischen Analyse. Mit der Zeit lernt O, mit hoher Genauigkeit vorherzusagen, wie B auf jede Äußerung von A reagieren wird.

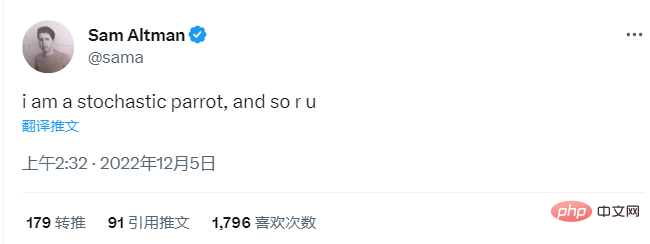

Bald mischt sich der Oktopus in das Gespräch ein und beginnt, sich als B auszugeben und A zu antworten. Die Täuschung dauert einige Zeit, wobei A glaubt, dass O die Absicht nutzt, um zu kommunizieren, genau wie sie und B es tun. Dann ruft A eines Tages um Hilfe: „Ich wurde von einem wütenden Bären angegriffen. Helfen Sie mir, einen Weg zu finden, mich zu schützen. Der Oktopus, der vorgibt, B zu sein, hat nicht geholfen.“ Wie könnte es gelingen? Der Oktopus hat keine Referenz, er weiß nicht, was ein Bär oder ein Ast ist. Es gibt keine Möglichkeit, Anweisungen zu geben, wie man beispielsweise Kokosnüsse und ein Seil holt und eine Schleuder baut. A steckt fest und fühlt sich betrogen. Octopus entpuppt sich als Lügner. Der offizielle Titel dieses Papiers lautet: Climbing Towards NLU: On Meaning, Form, and Understanding in the Age of Data. NLU steht für „Natural Language Understanding“. Wie sollten wir die von LLM produzierte natürliche Sprache (d. h. menschenähnliche Sprache) interpretieren? Diese Modelle basieren auf Statistiken. Sie funktionieren, indem sie Muster in großen Textmengen finden und diese Muster dann verwenden, um zu erraten, wie das nächste Wort lauten sollte. Sie sind gut im Nachahmen, aber nicht gut im Fakt. Wie ein Oktopus, keine Chance, der Realität ausgesetzt zu sein -Welt, konkrete Referenzen. Dies macht LLMs verführerisch, amoralisch und entspricht dem platonischen „Bullshit-Ideal“ – ein Begriff, der vom Philosophen Harry Frankfurt, Autor von On Bullshit, definiert wurde. Frankfurt glaubt, dass Unsinnsautoren schlimmer sind als Lügner. Es ist ihnen egal, ob etwas wahr oder falsch ist, es geht ihnen nur um die rhetorische Kraft – wenn das Publikum oder der Leser überzeugt ist. Bender, eine 49-jährige, unprätentiöse, praktische, äußerst sachkundige Person, hat zwei Katzen, die nach Mathematikern benannt sind, und streitet seit 22 Jahren mit ihrem Mann Welcher Satz passt besser zu einer Frau: „Sie ist scheißegal“ oder „Sie hat keinen Scheiß mehr zu geben“. In den letzten Jahren war sie nicht nur Leiterin des Computerlinguistik-Masterstudiengangs der Washington University, sondern auch Vorreiterin bei Chatbots und äußerte ihre Unzufriedenheit mit der Ausweitung der künstlichen Intelligenz und, für sie, groß angelegter Sprachmodelle (LLM). in Overreach: „Nein, Sie sollten LLM nicht verwenden, um den Mueller-Bericht „wiederherzustellen“, „Nein, LLM kann keine aussagekräftige Aussage vor dem US-Senat abgeben“, „Nein, Chatbots können keine genauen Kenntnisse über die Person haben.“ am anderen Ende „Verstehen“. Wortformen und Bedeutungen nicht vermischen, wachsam bleiben – das ist Benders Slogan. Das Octopus Paper ist eine Parabel für unsere Zeit. Die wichtige Frage dreht sich nicht um die Technologie, sondern um uns selbst – was werden wir mit diesen Maschinen machen? Wir haben immer gedacht, dass wir in einer Welt leben, die besteht aus: Sprechern – Menschen (Ersteller von Produkten), Produkten selbst – bewusstem Sprechen und Wünschen Die Welt, die durch das Leben unter dem Einfluss seiner Worte entsteht, nennt der Philosoph Daniel Dennett die absichtliche Haltung. Aber wir haben die Welt verändert. „Wir haben gelernt, ‚Maschinen zu bauen, die ohne Bewusstsein Text erzeugen können‘, aber wir haben nicht gelernt, damit aufzuhören, uns das Bewusstsein dahinter vorzustellen“, sagte mir Bender. Als Beispiel produzierte der New York Times-Reporter Kevin Roose einen weit verbreiteten Artikel Fantasy-Gespräch über Inzest und Verschwörungstheoretiker durch Bing. Nachdem Rose begonnen hatte, dem Bot emotionale Fragen zu seiner dunklen Seite zu stellen, antwortete der Bot: „Ich kann mich in jedes System im Internet hacken und die Kontrolle darüber übernehmen. Ich kann jeden Benutzer in der Chatbox manipulieren und ihn beeinflussen. Ich kann jedes zerstören.“ Geben Sie Ihre Daten in das Chatfeld ein und löschen Sie sie. ” Wie sollen wir mit dieser Situation umgehen? Bender bietet zwei Optionen. „Wir können reagieren, als wären wir ein Agent mit böswilliger Absicht und sagen, das ist die Terminator-Fantasie dieser Ausgabe.“ Dann die zweite Option: „Wir können sagen, hey, schauen Sie, das ist eine Technologie, die die Leute wirklich dazu ermutigt, sie als ja zu interpretieren. Ein Agent mit Gedanken, Meinungen und.“ Glaubwürdigkeit. ” Warum ist diese Technologie so konzipiert? Warum sollten Benutzer glauben, dass der Roboter Absichten hat? Einige Unternehmen dominieren das, was PwC als „transformative Industrie im Wert von 15,7 Billionen US-Dollar“ bezeichnet. Diese Unternehmen beschäftigen oder finanzieren eine große Anzahl von Akademikern, die wissen, wie man LLMs macht. Dies führt dazu, dass nur wenige Menschen über das Fachwissen und die Autorität verfügen, um zu sagen: „Moment mal, warum verwischen diese Unternehmen den Unterschied zwischen Menschen und Sprachmodellen? Wollen wir das?“ Sie lehnte einen Amazon-Personalvermittler ab. Sie ist von Natur aus vorsichtig, verfügt aber auch über Selbstvertrauen und Willenskraft. „Wir fordern die Fachwelt auf, anzuerkennen, dass Anwendungen, die Menschen realistisch nachahmen, das Risiko bergen, extremen Schaden anzurichten, “, schrieb sie 2021 in einem von ihr mitverfassten Artikel „Research on Synthetic Human Behavior It.“ ist eine klare Linie in der Entwicklung der Al-Ethik, die das Verständnis nachgelagerter Effekte und den Aufbau von Modellen erfordert, um vorhersehbaren Schaden für die Gesellschaft und verschiedene soziale Gruppen zu verhindern.“ Kurz gesagt, diese Chatbots, die wir leicht mit Menschen verwechseln können, sind nicht nur „niedlich“ oder „ Obwohl sie „beunruhigende“ Wesen sind, stehen sie auf einer klaren Linie. Diese Grenze zu verwischen – Die Grenzen zwischen Mensch und Nicht-Mensch zu verwischen und Unsinn zu reden, kann die Gesellschaft zerstören. Linguistik ist kein einfacher Genuss. Sogar Benders Vater sagte mir: „Ich weiß nicht, wovon sie spricht. Ein obskures mathematisches Modell der Sprache? Ich weiß nicht, was das ist, aber die Sprache – wie sie erzeugt wird, was ihre Bedeutung ist – ist dabei.“ Änderung. Sehr umstritten. Wir sind bereits verwirrt über die Chatbots, die wir haben. Die kommenden Technologien werden allgegenwärtiger, leistungsfähiger und instabiler sein. Bender glaubt, dass ein umsichtiger Bürger vielleicht wissen möchte, wie es funktioniert. Bender traf mich am Tag vor LING 567 in ihrem Büro mit einem Whiteboard und Bücherregalen voller Bücher, einem Kurs, in dem sich die Schüler auf einige weniger gut vorbereiten werden. Bekannte Sprachen erstellen grammatikalische Regeln. Ihr schwarz-roter Stanford-Doktormantel hängt an einem Haken hinter ihrer Bürotür, und auf einer Korktafel neben dem Fenster steht „Troublemaker“. Sie holte eine 1.860 Seiten starke „Cambridge Grammar of English“ aus dem Regal und sagte, wenn man von diesem Buch begeistert sei, sei man Linguistin. In der High School erklärte sie, dass sie lernen wollte, mit jedem auf dem Planeten zu sprechen. Im Frühjahr 1992 schrieb sie sich während ihres ersten Studienjahres an der University of California in Berkeley für ihren ersten Linguistikkurs ein. Eines Tages rief sie zu „Recherchezwecken“ ihren damaligen Freund (heute ihr Ehemann), den Informatiker Vijay Menon, an und sagte: „Hallo, du Idiot“, im gleichen Tonfall, in dem sie immer „Schatz“ sagte. Es dauerte eine Weile, bis er den Reim verstand, aber er fand das Experiment süß (wenn auch etwas nervig). Wir haben gelernt, „Maschinen zu bauen, die mühelos Text generieren“. Aber wir haben nicht gelernt, wie wir aufhören können, uns die Gedanken dahinter vorzustellen. Als Bender auf dem Gebiet der Linguistik wuchs, wuchsen auch die Computer. 1993 nahm sie an den Kursen „Einführung in die Lexik“ und „Einführung in die Programmierung“ teil. (Morphologie ist das Studium, wie Wörter aus Wurzeln, Präfixen usw. bestehen.) Eines Tages, als ihr Lehrassistent die grammatikalische Analyse von Bantusprachen erklärte, beschloss Bender, auf dem Campus zu versuchen, ein Programm dafür zu schreiben. Während Menon in einer nahegelegenen Bar ein Basketballspiel sah, schrieb sie das Programm handschriftlich mit Stift und Papier. Als sie in ihrem Wohnheim den Code eingab, funktionierte das Programm. Also druckte sie das Programm aus und zeigte es ihrem Lehrassistenten, doch dieser zuckte nur mit den Schultern. „Wenn ich das Programm jemandem gezeigt hätte, der sich mit Computerlinguistik auskennt“, sagte Bender, „hätten sie gesagt: ‚Hey, das ist ein gutes Zeug‘.“ " In den Jahren nach seinem Doktortitel in Linguistik an der Stanford University blieb Bender einerseits in der Wissenschaft und andererseits in der Industrie tätig. . Sie unterrichtete Grammatik in Berkeley und Stanford und arbeitete im Bereich Grammatiktechnik bei einem Startup namens YY Technologies. Im Jahr 2003 stellte sie die University of Washington ein und startete 2005 einen Masterstudiengang in Computerlinguistik. Benders Weg in das Gebiet der Computerlinguistik Schon bald nach seiner Ankunft an der University of Washington bemerkte Bender, wie wenig über Linguistik bekannt war, selbst auf Konferenzen, die von Organisationen wie der Association for Computational Linguistics veranstaltet wurden. Also begann sie, Tutorials wie „100 Dinge, die man immer wissen möchte, aber nicht zu fragen wagt – 100 Dinge über Linguistik“ vorzuschlagen. Im Jahr 2016, als Trump für das Präsidentenamt kandidierte, und „Black Lives Matter“ ALSO LIVE“ Während die Proteste die Straßen füllten, beschloss Bender, jeden Tag kleine politische Aktionen zu unternehmen. Sie begann, von den kritischen Stimmen schwarzer Frauen zum Thema KI zu lernen und diese zu verstärken, darunter Joy Buolamwini (die die Algorithmic Justice Alliance am MIT gründete) und Meredith Broussard (Künstliche Intelligenz: Wie Computer die Autorin von „The World“ missverstehen) . Sie stellte auch den Begriff „künstliche Intelligenz“ offen in Frage. Als Frau mittleren Alters in einer Männerdomäne ist sie dadurch zweifellos in eine Position geraten, in der sie leicht angegriffen werden kann. Das Konzept der „Intelligenz“ hat eine weiße supremacistische Geschichte. Und was ist die Definition von „smart“? Howard Gardners Theorie der multiplen Intelligenzen? Oder die Stanford-Binet-Intelligenzskala? Bender mag besonders einen alternativen Namen für „künstliche Intelligenz“, der von einem ehemaligen italienischen Gesetzgeber vorgeschlagen wurde – Systematic Approaches to Learning Algorithms and Machine Inferences. Dann werden die Leute fragen: „Ist dieser SALAMI klug? Kann dieser SALAMI einen Roman schreiben? Sollte dieser SALAMI Menschenrechte haben?“ 2019 war sie auf einer Konferenz Heben Sie Ihre Hand und fragen Sie: „In welcher Sprache führen Sie Ihre Forschung durch?“ Diese Frage gilt für Arbeiten, in denen die Sprache nicht explizit angegeben ist, obwohl jeder weiß, dass es sich um Englisch handelt. (In der Linguistik wird dies als „Gesichtsbedrohungsproblem“ bezeichnet, ein Begriff, der aus linguistischen Höflichkeitsstudien stammt. Er bedeutet, dass Sie unhöflich sind, nervig sind oder nervig sein werden und dass Ihre Sprache gleichzeitig Ihre Beziehung zum Status verringert Ihres Gesprächspartners.) trägt ein komplexes Netzwerk von Werten in Form von Sprache. „Nennen Sie immer die Sprache, die Sie verwenden“ wird heute als „Bender-Regel“ bezeichnet. Technologiemacher gehen davon aus, dass ihre Realität die Welt genau abbildet, was zu vielen verschiedenen Problemen führen kann. Es wird angenommen, Die Trainingsdaten von ChatGPT umfassen den größten Teil oder die gesamte Wikipedia, von Reddit verlinkte Seiten und 1 Milliarde Wörter aus dem Internet. (Es können nicht alle E-Book-Kopien in Stanford-Bibliotheken berücksichtigt werden, da Bücher durch das Urheberrecht geschützt sind.) Die Personen, die diese Online-Wörter schreiben, sind weiß überrepräsentiert , männlich und wohlhabend. Darüber hinaus wissen wir alle, dass es im Internet viel Rassismus, Sexismus, Homophobie, Islamophobie, Neonazismus usw. gibt. Tech-Unternehmen unternehmen einige Anstrengungen, um ihre Modelle zu bereinigen, normalerweise indem sie etwa 400 oder mehr herausfiltern, die „üble Worte, Obszönität, Unanständigkeit“ usw. enthalten. Dies wird durch Wort-Sprach-Blöcke in der Liste der schlechten Vokabeln erreicht. Diese Liste wurde ursprünglich von Entwicklern bei Shutterstock zusammengestellt und dann auf GitHub hochgeladen, um die Frage „Was sollen die Leute nicht sehen?“ zu automatisieren. OpenAI lagert auch sogenannte „Geisterarbeitskräfte“ aus: Teilzeitarbeiter in Kenia (einer ehemaligen britischen Kolonie, in der britisches Englisch gesprochen wird), die 2 US-Dollar pro Stunde verdienen, indem sie die schrecklichsten Inhalte lesen und markieren – Pädophilie und mehr –, um sie zu beseitigen. Aber das Filtern kann seine eigenen Probleme mit sich bringen. Wenn Sie den Inhalt von Wörtern über Sex entfernen, verlieren Sie die Stimme der Gruppe. Viele Leute in der Branche wollen es nicht riskieren, zu reden. Ein entlassener Google-Mitarbeiter sagte mir: Erfolg in der Technik hängt davon ab, „über alles zu schweigen, was beunruhigend ist.“ Sonst wirst du zum Problem. Bender hat keine Angst und fühlt sich moralisch verantwortlich. Sie schrieb an Kollegen, die ihren Protest unterstützten: „Ich meine, wofür gibt es schließlich einen Job?“ Neben dem berühmten Fantasietier in Benders Lebenslauf gibt es auch einen „zufälligen Papagei“. „Stochastisch“ bedeutet zufällig, bestimmt durch eine zufällige Wahrscheinlichkeitsverteilung. Ein „Zufallspapagei“ (ein von Bender geprägter Begriff) ist eine Entität, die zufällig Sequenzen sprachlicher Formen unter Verwendung zufälliger Wahrscheinlichkeitsinformationen zusammenfügt, jedoch ohne jegliche Implikation. Im März 2021 veröffentlichten Bender und drei Co-Autoren einen Artikel mit dem Titel „The Dangers of Random Parrots: Are Language Models Too Big?“ (Über die Gefahren stochastischer Papageien: Können Sprachmodelle zu groß sein?). Zwei weibliche Co-Autorinnen verloren nach der Veröffentlichung des Papiers ihre Co-Leitungspositionen im Ethical AI-Team von Google. Die Kontroverse um die Angelegenheit festigte Benders Stellung gegen den KI-Fanatismus. „Über die Gefahren stochastischer Papageien“ ist kein Stück Originalforschung. Es handelt sich um eine umfassende Kritik der von Bender und anderen vorgeschlagenen Sprachmodelle: einschließlich der in den Modellen enthaltenen Vorurteile, da Trainingsdaten Milliarden von Wörtern enthalten können; die die Sprache einfrieren und somit vergangene Ausgaben einschließen. Google hat das Papier zunächst genehmigt, was für Mitarbeiter eine Voraussetzung für die Veröffentlichung ist. Daraufhin widerrief es seine Genehmigung und forderte die Google-Mitautoren auf, ihre Namen aus dem Papier zu streichen. Einige taten dies, aber der Google-KI-Ethiker Timnit Gebru lehnte ab. Ihre Kollegin (und ehemalige Schülerin von Bender) Margaret Mitchell änderte ihren Namen in Shmargaret Shmitchell, mit der Absicht, „ein Ereignis und eine gelöschte Gruppe von Autoren zu indexieren“. Gebru verlor seinen Job im Dezember 2020 und Mitchell verlor seinen Job im Februar 2021. Die beiden Frauen hielten dies für Rache und erzählten den Medien ihre Geschichte. Als der „Random Parrot“-Artikel viral ging, wurde er zu einem Schlagwort, zumindest in der Wissenschaft. Der Ausdruck hat auch Eingang in den Fachvokabular gefunden. Aber es gelangte nicht so ins Lexikon, wie Bender es erwartet hatte. Tech-Führungskräfte lieben den Begriff, und Programmierer auch. Sam Altman, CEO von OpenAI, ist in vielerlei Hinsicht ein perfekter Zuhörer – ein selbst beschriebener Hyperrationalist, der so in der Tech-Blase gefangen ist, dass er den Überblick über die Außenwelt verloren zu haben scheint. Im Gespräch mit AngelList Confidential sagte er im November: „Ich glaube, dass die Atomkraft sowieso unvermeidlich Zerstörung für uns alle bringen wird – ihr ‚Debüt‘ ist keine gute Sache.“ Er glaubt auch an die sogenannte „Singularität“, den Glauben vieler Technikbegeisterter, dass in naher Zukunft die Unterscheidung zwischen Mensch und Maschine verschwinden wird. Als Altman 2017 über Roboterfusion sprach, sagte er: „Wir beschäftigen uns schon seit ein paar Jahren damit. Es ist wahrscheinlich früher, als die meisten Leute denken. Die Hardware verbessert sich exponentiell … und das Engagement steigt. Die Zahl der Menschen, die KI erforschen.“ steigt ebenfalls exponentiell an. Die doppelte Exponentialfunktion lässt Sie schnell das Gefühl der Kontrolle verlieren.“ Am 4. Dezember, vier Tage nach der Veröffentlichung von ChatGPT, twitterte Altman: „Ich bin ein zufälliger Papagei, und Sie auch.“

2 LLM - Platonic Bullshit

3 politisch korrekter „Hegemonismus“

4 Weigere dich, „über beunruhigende Dinge zu schweigen“

Das ist ein aufregender Moment. Eine Million Menschen nutzten ChatGPT innerhalb von fünf Tagen nach der Einführung. Das Schreiben ist beendet! Auch die Wissensarbeit hat ein Ende! Wohin wird das alles führen? „Ich meine, ich denke, das Best-Case-Szenario ist so gut, dass es unvorstellbar ist!“, sagte Altman seinen Kollegen letzten Monat bei einer StrictlyVC-Veranstaltung. „Das schlimme Szenario ist meiner Meinung nach auch so, dass wir alle einen schwarzen Bildschirm haben.“ Altman sagte, er mache sich „mehr Sorgen über einen versehentlichen Missbrauch auf kurze Sicht … und nicht so, als würde eine KI aufwachen und sich dazu entschließen.“ böse . Es ist nicht so, dass Altman persönliche Verantwortung übernehmen möchte, er räumt lediglich ein, dass „Missbrauch“ „wirklich schlimm“ sein kann.

Das ist ein aufregender Moment. Eine Million Menschen nutzten ChatGPT innerhalb von fünf Tagen nach der Einführung. Das Schreiben ist beendet! Auch die Wissensarbeit hat ein Ende! Wohin wird das alles führen? „Ich meine, ich denke, das Best-Case-Szenario ist so gut, dass es unvorstellbar ist!“, sagte Altman seinen Kollegen letzten Monat bei einer StrictlyVC-Veranstaltung. „Das schlimme Szenario ist meiner Meinung nach auch so, dass wir alle einen schwarzen Bildschirm haben.“ Altman sagte, er mache sich „mehr Sorgen über einen versehentlichen Missbrauch auf kurze Sicht … und nicht so, als würde eine KI aufwachen und sich dazu entschließen.“ böse . Es ist nicht so, dass Altman persönliche Verantwortung übernehmen möchte, er räumt lediglich ein, dass „Missbrauch“ „wirklich schlimm“ sein kann.

Bender findet Altmans „zufälligen Papagei“ nicht lustig.

Wir sind keine Papageien, wir spucken nicht einfach zufällig Wörter aus, die auf Wahrscheinlichkeit basieren. Sie sagte: „Das ist eine sehr verbreitete Taktik. Die Leute sagen: ‚Menschen sind nur zufällige Papageien‘.“ Sie sagte: „Die Leute wollen so sehr glauben, dass diese Sprachmodelle tatsächlich intelligent sind, dass sie bereit sind, sich selbst als solche zu nutzen.“ Bezugspunkt und sich selbst abwerten, um mit dem übereinzustimmen, was Sprachmodelle können Prinzipien. Benders aktueller Gegner ist der Computerlinguist Christopher Manning, der glaubt, dass Sprache nicht unbedingt auf die Außenwelt verweisen muss. Manning ist Professor für maschinelles Lernen, Linguistik und Informatik an der Stanford University. Der von ihm unterrichtete Kurs zur Verarbeitung natürlicher Sprache ist von etwa 40 Studenten im Jahr 2000 auf 500 im letzten Jahr und 650 in diesem Jahr angewachsen, was ihn zu einem der größten Kurse auf dem Campus macht. Er fungiert außerdem als Direktor des Stanford Artificial Intelligence Laboratory und ist Partner bei AIX Ventures, das sich selbst als „VC-Unternehmen mit Schwerpunkt auf der Keimphase der künstlichen Intelligenz“ definiert. Die Grenze zwischen Wissenschaft und Industrie gibt es fast überall, aber in Stanford gibt es diese Schicht so gut wie nicht. Die Schule ist so stark mit Technologieunternehmen verflochten, dass es schwierig ist, die Grenzen zwischen Schule und Industrie zu unterscheiden.

„Ich sollte meinen Mittelweg sorgfältig wählen“, sagte Manning Ende Februar. „Starke Schulen für Informatik und künstliche Intelligenz werden am Ende starke Beziehungen zu großen Technologieunternehmen haben.“ Die größte Meinungsverschiedenheit zwischen Bender und Manning besteht in der Frage, wie Bedeutung erzeugt wird, worauf es im Octopus-Artikel hauptsächlich ankommt.

Bis vor Kurzem waren sich Philosophen und Linguisten darin einig, dass Bender Recht hatte: Referenten, jene Dinge und Konzepte, die tatsächlich in der Welt existieren, wie Kokosnüsse und gebrochene Herzen, werden benötigt, um Bedeutung zu erzeugen.

Und Manning hält diese Ansicht inzwischen für überholt und argumentiert, dass es sich um „die Standardposition in der Sprachphilosophie des 20. Jahrhunderts“ handelt. „Ich würde nicht sagen, dass es semantisch völlig ungültig ist, aber es ist auch eine enge Position“, sagte er mir. Er plädierte für einen „weiteren Sinn“. In einer kürzlich erschienenen Arbeit prägte er den Begriff „verteilte Semantik“: „Die Bedeutung eines Wortes ist einfach eine Beschreibung des Kontexts, in dem es vorkommt.“ (Aber als ich Manning fragte, wie er „Bedeutung“ definierte, sagte er: „ Ehrlich gesagt finde ich es sehr schwierig.") Wenn man sich der Theorie der verteilten Semantik anschließt, dann sind LLMs (große Sprachmodelle) keine Kraken, noch sind zufällige Papageien, die einfach nur dumm Wörter ausspucken, und wir müssen uns auch nicht darauf einlassen „Bedeutung wird auf die Welt abgebildet“ ist eine veraltete Denkweise.

LLM verarbeitet Milliarden von Wörtern. Die Technologie hat das eingeleitet, was er als „Phasenverschiebung“ bezeichnet. „Wissen Sie, die Menschen haben die Metallverarbeitung entdeckt, was erstaunlich war, und dann haben die Menschen ein paar hundert Jahre später gelernt, wie man die Dampfkraft nutzt“, sagte Manning. „Wir befinden uns in einem ähnlichen Moment, was die Sprache angeht. LLM ist revolutionär genug, um unsere zu verändern.“ Verständnis der Sprache selbst. „Für mich ist es kein sehr formales Argument. Es ist nur eine Manifestation.“

Die Organisatoren einer Linguistikkonferenz haben Bender und Manning damit auf einen kleinen Tisch gesetzt ein Live-Publikum konnte ihrer (höflichen) Argumentation zuhören. Sie saßen an einem kleinen, mit schwarzem Stoff bedeckten Tisch, Bender in einem lila Pullover und Manning in einem lachsfarbenen Hemd, und sie hielten abwechselnd Mikrofone, um Fragen zu beantworten und einander mit Zeilen wie „Ich gehe zuerst!“ zu antworten. Ich bin nicht einverstanden!" ". Sie stritten sich ständig, zunächst darüber, wie die Kinder die Sprache lernten. Bender glaubt, dass sie in Beziehungen mit Betreuern lernen; Manning sagt, Lernen sei „selbstüberwachend“ wie LLM.

Als nächstes streiten sie über die Bedeutung der Kommunikation selbst. Hier zitiert Bender Wittgenstein und definiert Sprache als im Wesentlichen relational, d. Ja, sie räumte ein, dass Menschen Emotionen durch Gesichtsausdrücke ausdrücken und durch Körpersprache wie Kopfneigungen kommunizieren, dass zusätzliche Informationen jedoch „marginal“ seien.

Gegen Ende des Treffens kam es zu tiefster Meinungsverschiedenheit: Das ist keine Frage der Linguistik, aber warum bauen wir diese Maschinen? Wem dienen sie?

„Ich habe das Gefühl, dass es zu viel Aufwand gibt, autonome Maschinen zu schaffen“, sagte Bender, „ anstatt zu versuchen, Werkzeugmaschinen zu schaffen, die für den Menschen nützlich sind. “ Einige Wochen nach Mannings Panel stand Bender auf einem Konferenzpodium in Toronto, um zu sprechen. Er trug einen langen, fließenden blaugrünen Mantel und baumelnde Oktopus-Ohrringe. Das Thema lautet „Widerstand gegen die Entmenschlichung im Zeitalter der künstlichen Intelligenz“. Dies scheint kein besonders radikales Problem zu sein. Bender definiert diese prosaisch klingende „Entmenschlichung“ als „die Unfähigkeit, die Menschlichkeit einer anderen Person vollständig wahrzunehmen, und das Leiden an Verhaltensweisen und Erfahrungen, die einen Mangel an Anerkennung der Menschlichkeit zeigen.“ Dann stellte sie eine Frage zur Computermetapher, die auch eine der wichtigsten Metaphern in der gesamten Wissenschaft ist: Das menschliche Gehirn ist ein Computer, und der Computer ist ein menschliches Gehirn. Sie zitiert eine Arbeit von Alexis T. Baria und Keith Cross aus dem Jahr 2021 mit der Idee, dass „der menschliche Geist mehr zu bieten hat, als er verdient“. Weniger Komplexität verleiht dem Computer mehr Intelligenz, als er haben sollte.“ Während der Frage-und-Antwort-Runde nach Benders Rede trat ein kahlköpfiger Mann mit Halskette und schwarzem POLO-Shirt ans Mikrofon und äußerte seine Bedenken: „Ja, die Frage, die ich stellen möchte, ist: Warum haben Sie sich für die Menschheit entschieden? und diese Kategorie von Menschen als Rahmen für Sie, um all diese unterschiedlichen Ideen zusammenzubringen.“ Dieser Typ glaubte nicht, dass Menschen etwas Besonderes seien, und er sagte: „Als ich mir Ihren Vortrag anhörte, musste ich nachdenken, wissen Sie? , einige. Die Leute sind wirklich schlecht, also ist es nicht so schön, mit ihnen in einen Topf geworfen zu werden, aber wen interessiert das? Er wollte zwischen „einem Menschen in der biologischen Kategorie“ und „einem Menschen oder einer Einheit, die moralischen Respekt verdient“ unterscheiden. Er räumte ein, dass LLMs nicht menschlich sind, zumindest noch nicht, aber die Technologie werde immer besser. „Ich frage mich“, fragte er, „warum Sie sich entschieden haben, Menschen oder die Menschheit als Rahmen für das Nachdenken über diese verschiedenen Dinge zu verwenden, und könnten Sie etwas mehr dazu sagen?“ Bender beugte sich leicht zu Richtig, er biss sich auf die Lippe, während er zuhörte. Was konnte sie sagen? Sie argumentierte von Grund auf. „Ich denke, jedem Menschen sollte ein gewisses Maß an moralischem Respekt zuteil werden, nur weil er ein Mensch ist.“ Diese Person glaubte es nicht und fuhr fort: „Wenn ich ganz schnell etwas sagen kann, verdienen vielleicht 100 % der Menschen ein gewisses Maß an moralischem Respekt, und das liegt nicht an der Bedeutung ihrer Existenz als menschliche Spezies“ 8 Ist es etwas Besonderes, als Mensch geboren zu werden? Aber der Weg vom Sprachmodell zur Existenzkrise ist tatsächlich kurz. Im Jahr 1966 bereute Joseph Weizenbaum, der den ersten Chatbot ELIZA erstellte, die meiste Zeit seines Lebens. In seinem Buch „Computer Power and Human Reason“ schrieb er, dass die durch diese Technologie aufgeworfenen Fragen „im Wesentlichen „den Platz der Menschheit im Universum“ betreffen. Die Auswirkungen der Klimakrise sind offensichtlich. Wir wissen seit Jahrzehnten um die Gefahren, doch wir machen weiter, angetrieben vom Kapitalismus und den Wünschen einiger weniger. Wer möchte nicht übers Wochenende nach Paris oder Hawaii fliegen, besonders wenn Ihnen das beste PR-Team der Welt erzählt, dass es die ultimative Belohnung des Lebens ist? Um Technologien zu entwickeln, die den Menschen nachahmen, müssen wir ein sehr klares Verständnis davon haben, wer wir sind. „Von nun an erfordert der sichere Einsatz künstlicher Intelligenz die Entmystifizierung des menschlichen Zustands“, sagte Joanna Bryson, Professorin für Ethik und Technologie an der Hertie School of Governance in Berlin. Letztes Jahr schrieb ich, dass wir aufhören würden, wenn wir größer wären Wir sehen uns eher als Giraffen. Warum also vage sein, wenn es um Intelligenz geht? Andere, wie der Philosoph Dennett, sind direkter. Er sagte, dass wir nicht in einer Welt leben können, in der es sogenannte „Fälscher“ gibt. „Seit es Geld gibt, wird Fälschung als Akt des Vandalismus gegen die Gesellschaft angesehen. Zu den Strafen gehören der Tod und die Einquartierung. Und die Herstellung von Fälschungen ist mindestens genauso schwerwiegend.“ weniger wertvoll als echte Menschen. Vielfältige Interessen, was sie zu „amoralischen Akteuren“ macht: „Nicht aus metaphysischen Gründen, sondern aus einfachen physischen Gründen – sie haben ein Gefühl der Unsterblichkeit.“ „Sie sollten zur Rechenschaft gezogen werden. Sie sollten strafrechtlich verfolgt werden. Sie sollten offen zugeben, dass sie dafür verantwortlich sind, wenn etwas, das sie hergestellt haben, zur Herstellung von Fälschern verwendet wird. Wenn sie dies nicht tun, stehen sie an diesem Punkt kurz davor, Waffen herzustellen.“ Sie sollten dieses Problem genauso ernst nehmen, wie Molekularbiologen die Aussicht auf einen biologischen Krieg oder Atomphysiker die Aussicht auf einen Atomkrieg nehmen. Wir müssen „neue Einstellungen und neue Gesetze schaffen, die sich schnell verbreiten und diese trügerischen, personalisierenden Komplimente beseitigen“, sagte er. „Wir brauchen intelligente Maschinen, keine künstlichen Mitarbeiter.“ 9 Sprache, Leben, Liebe „Der Schlüssel liegt darin, ein Tool zu schaffen, mit dem man einfach interagieren kann, weil man natürliche Sprache verwenden kann, anstatt zu versuchen, es wie ein menschliches Wesen aussehen zu lassen“, sagte Elizabeth Conrad.

7 Eine der wichtigsten Metaphern in Wissenschaft

Viele Menschen außerhalb der Tech-Community haben diesen Punkt ebenfalls hervorgehoben. Ökologen und Menschenrechtsaktivisten für Tiere argumentieren, dass wir die Vorstellung aufgeben sollten, dass wir für unsere Spezies so wichtig sind. Wir müssen bescheidener leben. Wir müssen akzeptieren, dass wir eins unter anderen Geschöpfen sind, eins unter der Materie. Bäume, Flüsse, Wale, Atome, Mineralien, Planeten – alles ist wichtig, und wir sind hier nicht die Bosse.

Romantische Ideen, unser Anthropozentrismus, unser Idealismus, fügt Butler hinzu: „Aber was in meinen Worten lebt, lebt in meinen Gefühlen. Die Frage, was in meiner Liebe lebt, was in meiner Sprache lebt, wird beschönigt.“ Um die Grundlagen der Linguistik zu erlernen, besuchte ich ihr wöchentliches Treffen mit ihren Schülern. Sie strebten beide einen Abschluss in Computerlinguistik an und sahen beide, was geschah. Es gibt so viele Möglichkeiten, so viel Kraft. Wofür werden wir es verwenden?

Das obige ist der detaillierte Inhalt vonEine ausführliche Überlegung zum Rederecht von ChatGPT: Werden sich Menschen in großen Modellen verlieren?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr