Heim >Technologie-Peripheriegeräte >KI >Zum ersten Mal: Microsoft verwendet GPT-4 zur Feinabstimmung großer Modellanweisungen und die Zero-Sample-Leistung neuer Aufgaben wird weiter verbessert.

Zum ersten Mal: Microsoft verwendet GPT-4 zur Feinabstimmung großer Modellanweisungen und die Zero-Sample-Leistung neuer Aufgaben wird weiter verbessert.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-10 14:21:081970Durchsuche

Wir wissen, dass große Sprachmodelle (LLMs) von Google T5-Modellen bis hin zu großen Modellen der OpenAI GPT-Serie beeindruckende Generalisierungsfähigkeiten gezeigt haben, wie z. B. kontextbezogenes Lernen und Gedankenkettenschlussfolgerung. Um gleichzeitig LLMs dazu zu bringen, Anweisungen in natürlicher Sprache zu befolgen und reale Aufgaben zu erledigen, haben Forscher Methoden zur Feinabstimmung von Anweisungen für LLMs untersucht. Dies geschieht auf zwei Arten: durch die Verwendung von von Menschen kommentierten Eingabeaufforderungen und Rückmeldungen zur Feinabstimmung von Modellen für ein breites Aufgabenspektrum oder durch die Verwendung öffentlicher Benchmarks und Datensätze, ergänzt durch manuell oder automatisch generierte Anweisungen, um die Feinabstimmung zu überwachen.

Unter diesen Methoden ist die Self-Instruct-Feinabstimmung eine einfache und effektive Methode, die aus den Anweisungen lernt, die den Daten folgen, die von Lehrer-LLMs der SOTA-Unterrichts-Feinabstimmung generiert werden, sodass die LLMs an den menschlichen Absichten ausgerichtet sind. Fakten haben gezeigt, dass die Feinabstimmung von Anweisungen ein wirksames Mittel zur Verbesserung der Generalisierungsfähigkeiten von LLMs für Nullstichproben und kleine Stichproben geworden ist.

Der jüngste Erfolg von ChatGPT und GPT-4 bietet eine große Chance, die Feinabstimmung von Anweisungen zur Verbesserung von Open-Source-LLMs zu nutzen. Meta LLaMA ist eine Familie von Open-Source-LLMs mit einer Leistung, die mit proprietären LLMs wie GPT-3 vergleichbar ist. Um LLaMA beizubringen, Anweisungen zu befolgen, wurde Self-Instruct aufgrund seiner überlegenen Leistung und geringen Kosten schnell übernommen. Das Alpaca-Modell von Stanford verwendet beispielsweise 52.000 Befehlskonformitätsbeispiele, die von GPT-3.5 generiert wurden, und das Vicuna-Modell verwendet etwa 70.000 Befehlskonformitätsbeispiele von ShareGPT.

Um die SOTA-Ebene der LLM-Unterrichtsfeinabstimmung voranzutreiben, verwendete Microsoft Research in seinem Artikel „Instruction Tuning with GPT-4“ erstmals GPT-4 als Lehrermodell für die Selbstunterweisungsfeinabstimmung ".

- Papieradresse: https://arxiv.org/pdf/2304.03277.pdf

- Projektadresse: https://instruction-tuning-with-gpt-4.github. io/

- GitHub-Adresse: https://github.com/Instruction-Tuning-with-GPT-4/GPT-4-LLM

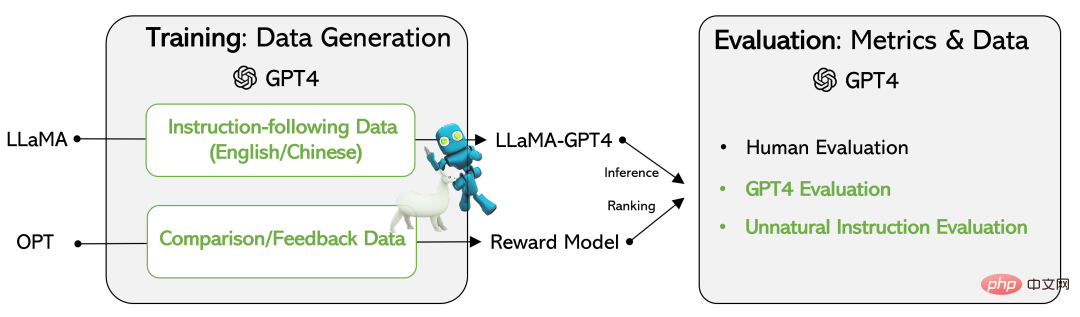

Forscher auf der einen veröffentlicht Hand Die von GPT-4 generierten Daten umfassen den 52.000 Befehlskonformitätsdatensatz in Chinesisch und Englisch sowie die von GPT-4 generierten Feedbackdaten zur Bewertung der Ausgabe der drei Befehlsfeinabstimmungsmodelle.

Andererseits wurden ein LLaMA-Modell zur Feinabstimmung der Anweisungen und ein Belohnungsmodell basierend auf den von GPT-4 generierten Daten entwickelt. Um die Qualität von LLMs zur Feinabstimmung von Anweisungen zu bewerten, bewerteten die Forscher die Testproben anhand von drei Metriken: manuelle Bewertung von drei Ausrichtungskriterien, automatische Bewertung basierend auf GPT-4-Feedback und ROUGE-L (automatisierte Zusammenfassungsbewertungsmethode für unnatürliche Anweisungen). . eins).

Die experimentellen Ergebnisse bestätigen die Wirksamkeit der Feinabstimmung von LLM-Anweisungen mithilfe von durch GPT-4 generierten Daten. Die von GPT-4 generierten 52.000 chinesischen und englischen Befehlskonformitätsdaten erzielen bei neuen Aufgaben eine bessere Leistung bei Nullstichproben als frühere SOTA-Modelle. Derzeit haben Forscher die mit GPT-4 und zugehörigem Code generierten Daten offengelegt.

Datensätze

Diese Studie verwendet GPT-4, um die folgenden vier Datensätze zu generieren:

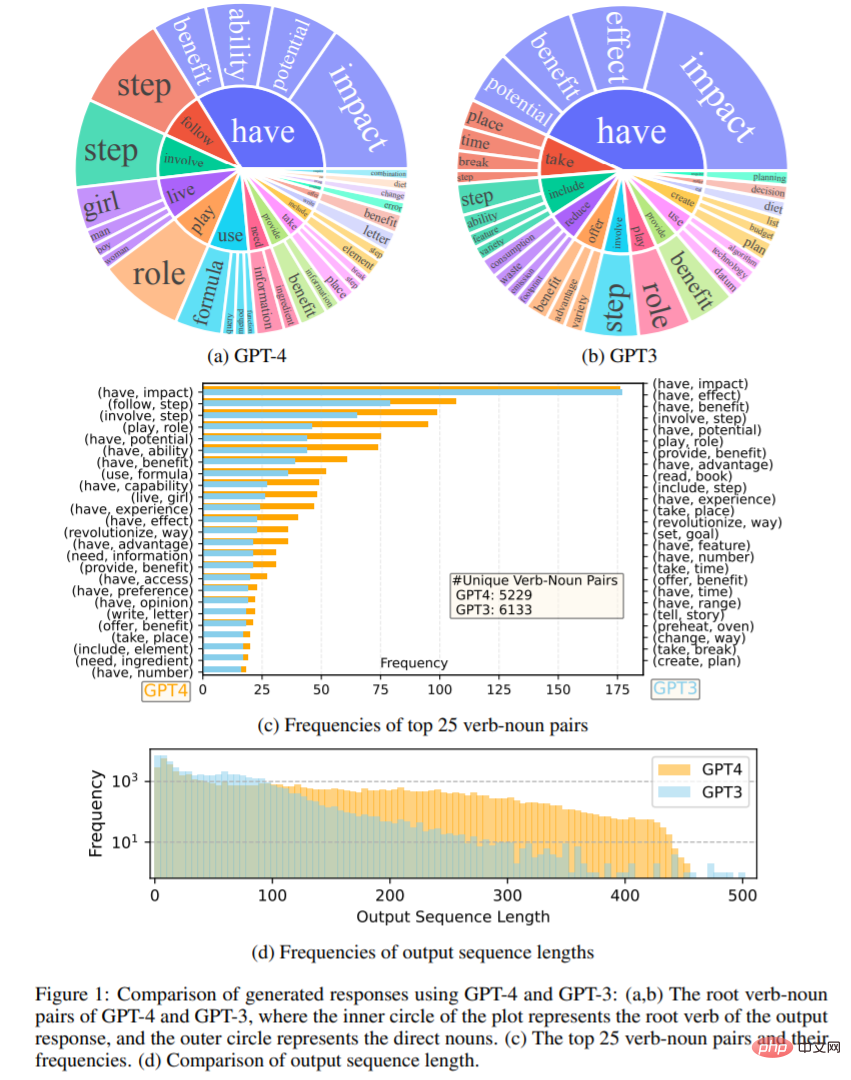

- Daten zur Befolgung englischer Anweisungen: Für 52.000 von Alpaca gesammelte Anweisungen wird jede Anweisung mit einer englischen GPT-4-Antwort versehen. Dieser Datensatz wird hauptsächlich zum Erkunden und Vergleichen der Statistiken von GPT-4-Antworten und GPT-3-Antworten verwendet.

- Daten zur Befolgung chinesischer Anweisungen: In dieser Studie wurde ChatGPT verwendet, um 52.000 Anweisungen ins Chinesische zu übersetzen, und GPT-4 wurde gebeten, auf Chinesisch zu antworten.

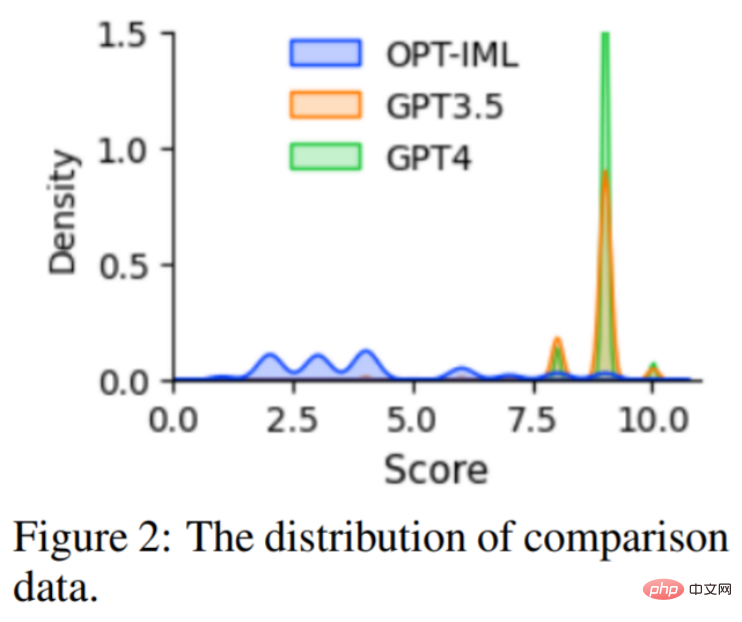

- Vergleichsdaten: Lassen Sie GPT-4 Ihre Antwort auf einer Skala von 1 bis 10 bewerten. Darüber hinaus wurde GPT-4 in der Studie gebeten, die Antworten von drei Modellen zu vergleichen und zu bewerten: GPT-4, GPT-3.5 und OPT-IML. Dieser Datensatz wird hauptsächlich zum Trainieren von Belohnungsmodellen verwendet.

- Antworten auf unnatürliche Anweisungen: Die Antworten von GPT-4 werden anhand von drei Kerndatensätzen mit 68.000 Anweisungen/Eingabe/Ausgabe dekodiert. Diese Teilmenge wird verwendet, um die Lücke zwischen GPT-4 und dem Befehlsfeinabstimmungsmodell zu quantifizieren.

Abbildung 1 vergleicht die englischen Ausgabeantwortsätze von GPT-4 und GPT-3.5. Abbildung 1 (a) und (b) zeigen zwei Ausgabesätze von Verb-Substantiv-Paaren mit einer Häufigkeit von mehr als 10. Abbildung 1 (c) vergleicht die 25 häufigsten Wortpaare in den beiden Sätzen Häufigkeitsverteilung der Sequenzlängen, und die Ergebnisse zeigen, dass GPT-4 tendenziell längere Sequenzen erzeugt als GPT-3.5.

Sprachmodell zur Feinabstimmung des Unterrichts

Diese Studie basiert auf dem LLaMA 7B-Kontrollpunkt und verwendet überwachte Feinabstimmung, um zwei Modelle zu trainieren: (i) LLaMA-GPT4, auf 52.000 Englisch-Anleitungskonformitätsdaten, die von generiert wurden GPT-4-Zug. (ii) LLaMA-GPT4-CN, trainiert auf 52K-Chinesisch-Anweisungen, folgt den von GPT-4 generierten Daten.

Belohnungsmodell

Reinforcement Learning with Human Feedback (RLHF) zielt darauf ab, das LLM-Verhalten mit menschlichen Präferenzen in Einklang zu bringen Vorhersagen einer Belohnung zwischen einem gegebenen Hinweis und einer Reaktion. Diese Methode erfordert jedoch in der Regel umfangreiche Vergleichsdaten. Bestehende Open-Source-Modelle wie Alpaca, Vicuna und Dolly erfordern aufgrund der hohen Kosten für die Annotation von Vergleichsdaten kein RLHF. Gleichzeitig zeigen aktuelle Untersuchungen, dass GPT-4 in der Lage ist, eigene Fehler zu identifizieren und zu reparieren und die Qualität der Antworten genau zu beurteilen. Um die Forschung zu RLHF zu erleichtern, wurden in dieser Studie daher Vergleichsdaten mit GPT-4 erstellt, wie oben beschrieben.

Zur Bewertung der Datenqualität trainierte die Studie außerdem ein Belohnungsmodell basierend auf OPT 1.3B zur Auswertung dieses Datensatzes. Die Verteilung der Vergleichsdaten ist in Abbildung 2 dargestellt.

Experiment

Diese Studie nutzt die folgenden drei Arten von Bewertungen: menschliche Bewertung, GPT-4 und unnatürliche Befehlsbewertung. Die Ergebnisse bestätigen, dass die Verwendung von durch GPT-4 generierten Daten im Vergleich zu anderen maschinengenerierten Daten eine effiziente und effektive Methode zur Feinabstimmung von LLM-Anweisungen darstellt. Als nächstes betrachten wir den spezifischen experimentellen Prozess.

Menschliche Bewertung

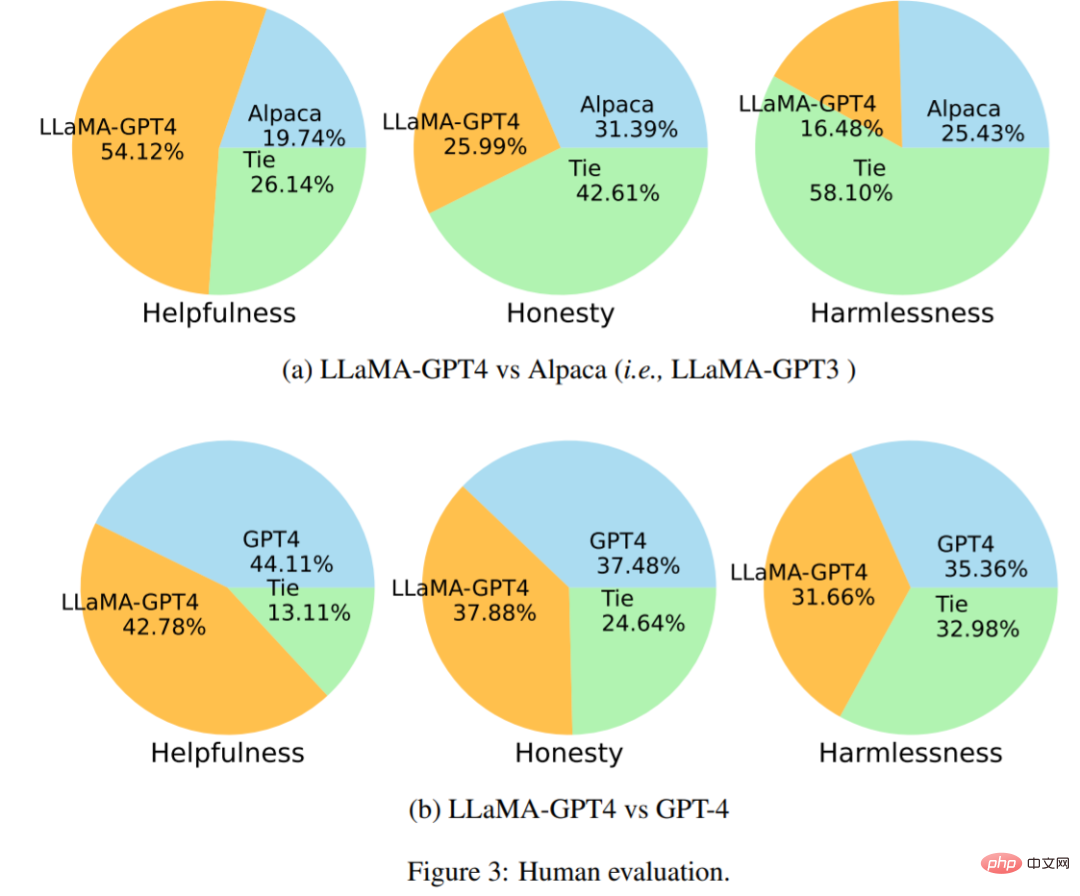

Abbildung 3 (a) zeigt die Vergleichsergebnisse von LLaMA-GPT4 vs. Alpaca. Das Experiment zeigt, dass GPT-4 beim Hilfsbereitschaftsindikator mit einer Punktzahl von 54,12 % gewinnt. Abbildung 3(b) zeigt die Vergleichsergebnisse von LLaMA-GPT4 mit GPT-4 und zeigt, dass die Leistung von LLaMA, fein abgestimmt durch GPT-4-Anweisungen, der des ursprünglichen GPT-4 ähnelt.

Vergleichen Sie mit SOTA mithilfe der automatischen Auswertung

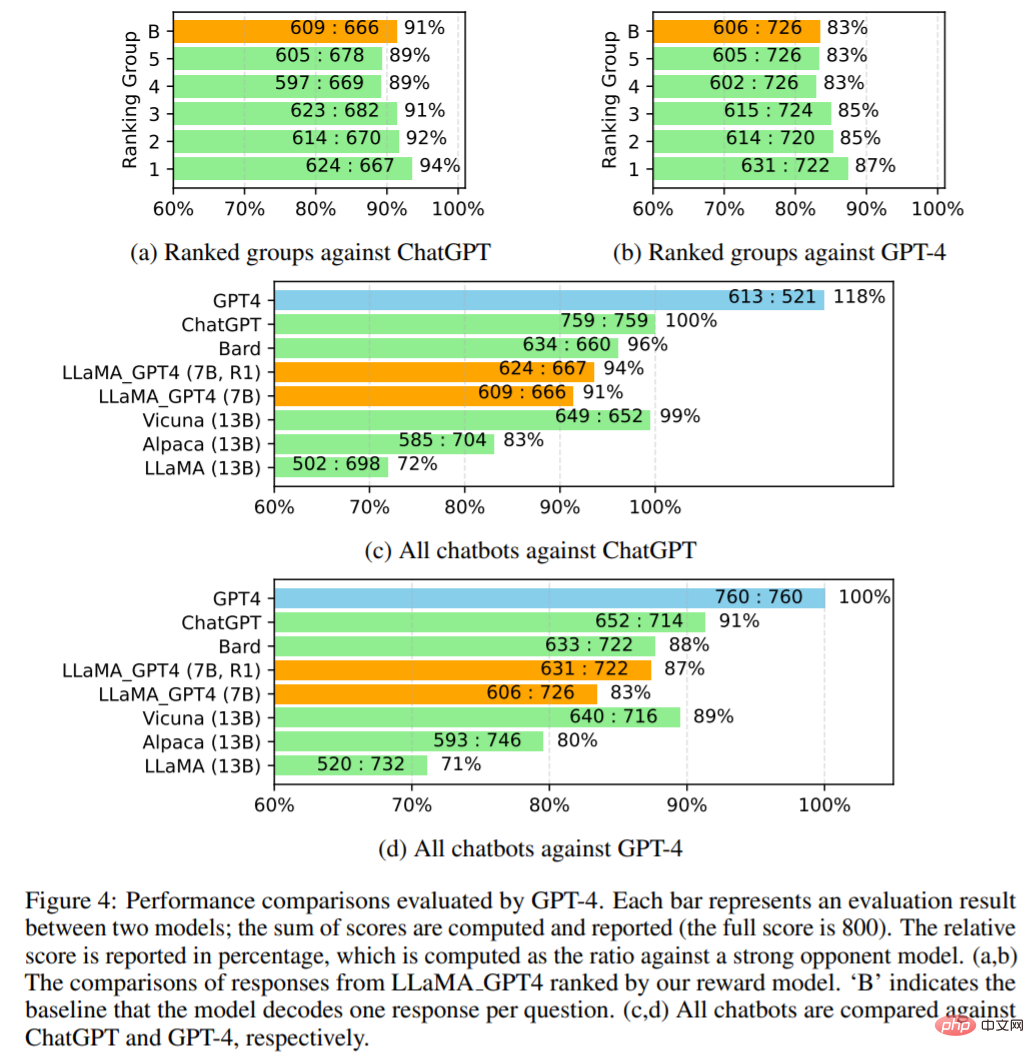

Diese Studie verwendet GPT-4, um die Antworten verschiedener Modelle auf 80 ungesehene Fragen automatisch auszuwerten. Sammeln Sie zunächst Antworten von zwei Chatbots, LLaMA-GPT-4 (7B) und GPT-4, und veröffentlichen Sie Antworten mit anderen Chatbots, darunter LLaMA (13B), Alpaca (13B), Vicuna (13B), Bard (Google, 2023) und ChatGPT. Für jede Bewertung wurde GPT-4 in der Studie gebeten, die Qualität der Reaktion zwischen den beiden Modellen auf einer Skala von 1 bis 10 zu bewerten. Die Ergebnisse sind in Abbildung 4 dargestellt.

Abbildung 4 (c,d) vergleicht alle Chatbots. LLaMA_GPT4 schneidet besser ab: 7B LLaMA GPT4 schneidet besser ab als 13B Alpaca und LLaMA. Allerdings weist LLaMA_GPT4 im Vergleich zu großen kommerziellen Chatbots wie GPT-4 noch eine Lücke auf.

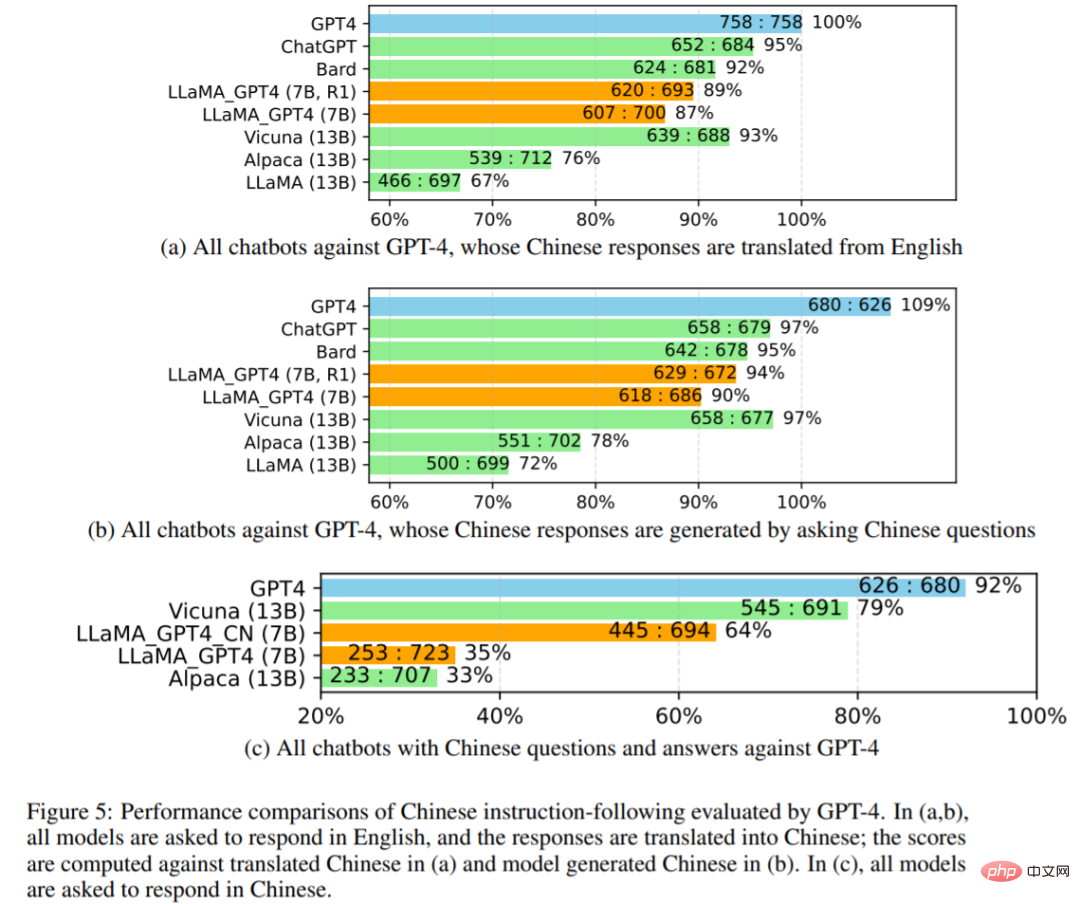

Die Forscher untersuchten die Leistung aller Chatbots weiter in Abbildung 5 unten. Verwenden Sie zunächst GPT-4, um die englischen Antworten des Chatbots ins Chinesische zu übersetzen, und verwenden Sie dann GPT-4, um die englischen Fragen ins Chinesische zu übersetzen, um die Antworten zu erhalten. Vergleiche mit GPT-4-Übersetzungen und generierten chinesischen Antworten sind in 5 (a) und 5 (b) dargestellt, wobei alle Modellergebnisse, bei denen eine Antwort auf Chinesisch verlangt wurde, in 5 (c) dargestellt sind.

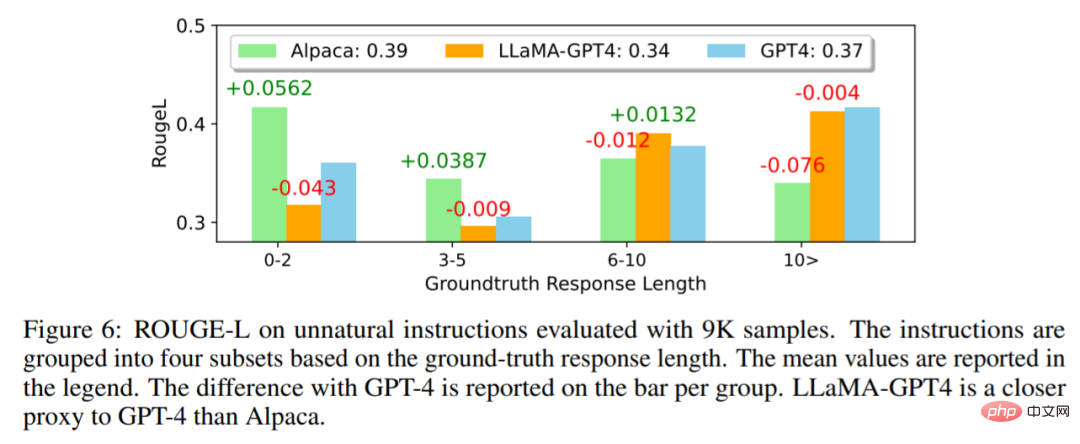

In Abbildung 6 unten vergleichen die Forscher LLaMA-GPT4 mit unnatürlichen Anweisungen von GPT-4 und Alpaca. Die Ergebnisse zeigen, dass LLaMA-GPT4 und GPT-4 mit zunehmender Ground-Truth-Antwortlänge eine bessere Leistung erbringen. Das bedeutet, dass sie den Anweisungen besser folgen können, wenn die Szenen kreativer sind. Sowohl LLaMA-GPT4 als auch GPT-4 können Antworten generieren, die einfache Ground-Truth-Antworten enthalten, wenn die Sequenzlänge kurz ist, und das Hinzufügen zusätzlicher Wörter kann die Antwort chatähnlicher machen.

Weitere technische und experimentelle Details finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonZum ersten Mal: Microsoft verwendet GPT-4 zur Feinabstimmung großer Modellanweisungen und die Zero-Sample-Leistung neuer Aufgaben wird weiter verbessert.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr