Heim >Technologie-Peripheriegeräte >KI >Nach mehr als 300 Spielen in vier Minuten brachte Google seinem Roboter das Tischtennisspielen bei

Nach mehr als 300 Spielen in vier Minuten brachte Google seinem Roboter das Tischtennisspielen bei

- 王林nach vorne

- 2023-04-10 09:11:031704Durchsuche

Lassen Sie einen Tischtennis-Enthusiasten gegen einen Roboter spielen. Angesichts des Entwicklungstrends von Robotern ist es wirklich schwer zu sagen, wer gewinnen und wer verlieren wird.

Der Roboter verfügt über geschickte Manövrierfähigkeit, flexible Beinbewegungen und ausgezeichnete Greiffähigkeiten ... und wurde häufig bei verschiedenen anspruchsvollen Aufgaben eingesetzt. Doch wie funktionieren Roboter bei Aufgaben, die eine enge Interaktion mit Menschen erfordern? Nehmen wir als Beispiel Tischtennis. Dies erfordert ein hohes Maß an Zusammenarbeit beider Parteien und der Ball bewegt sich sehr schnell, was eine große Herausforderung für den Algorithmus darstellt.

Beim Tischtennis stehen Geschwindigkeit und Genauigkeit an erster Stelle, was hohe Anforderungen an Lernalgorithmen stellt. Gleichzeitig weist dieser Sport zwei Hauptmerkmale auf: hochstrukturiert (mit einer festen, vorhersehbaren Umgebung) und Zusammenarbeit mit mehreren Agenten (Roboter können mit Menschen oder anderen Robotern kämpfen), was ihn zu einem idealen Ort zum Studium der Mensch-Computer-Interaktion macht Verstärkungslernen. Eine ideale experimentelle Plattform für Probleme.

Das Robotik-Forschungsteam von Google hat eine solche Plattform aufgebaut, um die Probleme zu untersuchen, mit denen Roboter beim Lernen in dynamischen und interaktiven Umgebungen mit mehreren Personen konfrontiert sind. Zu diesem Zweck hat Google auch einen speziellen Blog geschrieben, um die beiden von ihnen untersuchten Projekte Iterative-Sim2Real (i-S2R) und GoalsEye vorzustellen. i-S2R ermöglichte es dem Bot, über 300 Spiele mit menschlichen Spielern zu spielen, während GoalsEye es dem Bot ermöglichte, einige nützliche Strategien (torbedingte Strategien) von Amateuren zu lernen.

i-S2R-Strategie ermöglicht es Robotern, gegen Menschen zu kämpfen, obwohl die Haltehaltung des Roboters nicht sehr professionell aussieht, wird er keinen Ball verpassen:

Du kommst und ich gehe, es ist ziemlich gut Es fühlt sich an, als würde ein hochwertiger Ball gespielt.

Die GoalsEye-Strategie kann den Ball an die vorgesehene Position auf dem Tisch zurückbringen, genau so, als würde man ihn dorthin schlagen, wohin man zeigt:

i-S2R: Verwendung des Simulators, um mit Menschen zusammenzuarbeiten, um Spiele zu spielen

In diesem Projekt sollen Roboter lernen, mit Menschen zu kooperieren, also möglichst lange mit Menschen zu kämpfen. Da das Training direkt gegen menschliche Spieler mühsam und zeitaufwändig ist, hat Google einen auf Simulationen basierenden Ansatz gewählt. Dies stellt jedoch ein neues Problem dar. Für simulationsbasierte Methoden ist es schwierig, menschliches Verhalten, Interaktionsaufgaben im geschlossenen Regelkreis usw. genau zu simulieren.

In i-S2R hat Google ein Modell vorgeschlagen, das menschliches Verhalten bei Mensch-Computer-Interaktionsaufgaben lernen kann, und es auf der Roboter-Tischtennisplattform instanziiert. Google hat ein System entwickelt, das mit menschlichen Amateurspielern bis zu 340 Schlagwürfe erzielen kann (siehe unten).

Mensch und Roboter kämpfen 4 Minuten lang, bis zu 340 Mal hin und her am Anfang nicht genug Eine gute Bot-Strategie ist ohne die Erhebung hochwertiger Daten darüber, wie Menschen mit Bots interagieren, unmöglich. Aber ohne ein menschliches Verhaltensmodell kann die Roboterstrategie nicht von Anfang an ermittelt werden. Dieses Problem ist etwas kompliziert, etwa was zuerst kam, das Huhn oder das Ei. Ein Ansatz besteht darin, Roboterrichtlinien direkt in der realen Welt zu trainieren. Dies ist jedoch oft langsam, kostspielig und stellt sicherheitsrelevante Herausforderungen dar, die durch die Beteiligung von Menschen noch verschärft werden.

Wie in der Abbildung unten dargestellt, verwendet i-S2R ein einfaches menschliches Verhaltensmodell als ungefähren Ausgangspunkt und wechselt zwischen Simulationstraining und realem Einsatz. In jeder Iteration werden menschliche Verhaltensmodelle und Strategien angepasst.

i-S2R-Methode

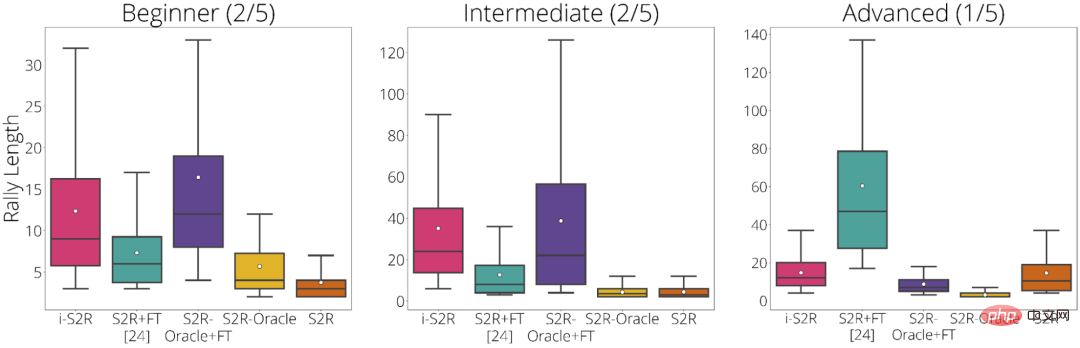

Google schlüsselt die Ergebnisse des Experiments nach Spielertyp auf: Anfänger (40 % der Spieler), Mittelstufe (40 % der Spieler) und Fortgeschrittene (20 % der Spieler)) . Den experimentellen Ergebnissen zufolge schneidet i-S2R sowohl für Anfänger als auch für fortgeschrittene Spieler (80 % der Spieler) deutlich besser ab als S2R+FT (Sim-to-Real plus Feinabstimmung).

i-S2R-Ergebnisse nach Spielertyp

GoalsEye: Genau dort treffen, wo Sie wollen

In GoalsEye hat Google auch eine Methode demonstriert, die verwendete Techniken des Verhaltensklonens kombiniert, um präzises Targeting zu erlernen Strategien.

Hier konzentriert sich Google auf die Genauigkeit des Tischtennis. Sie hoffen, dass der Roboter den Ball genau an jede vorgesehene Position auf dem Tisch zurückbringen kann, wie im Bild unten gezeigt. Um die folgenden Effekte zu erzielen, verwendeten sie außerdem LFP (Learning from Play) und GCSL (Goal-Conditioned Supervised Learning).

Die GoalsEye-Strategie zielt auf einen Kreis mit einem Durchmesser von 20 cm (links). Ein menschlicher Spieler kann auf dasselbe Ziel zielen (rechts)

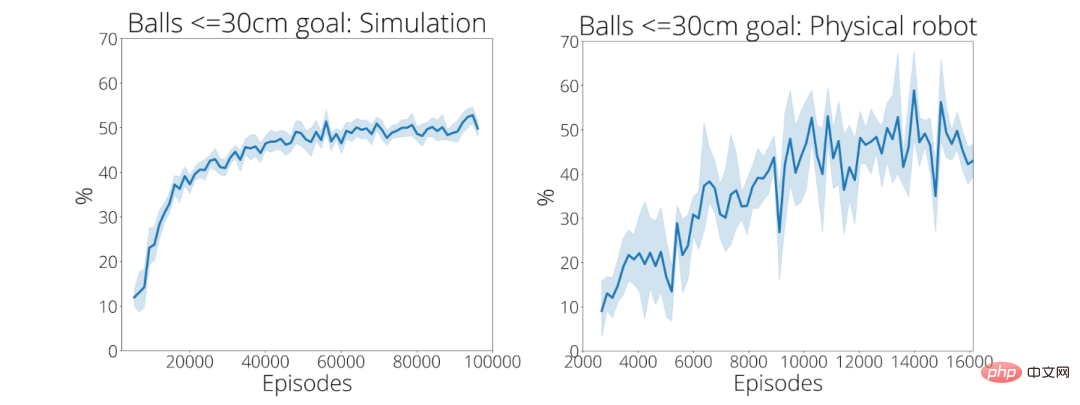

In den ersten 2.480 Demos traf die Trainingsstrategie von Google in nur 9 % der Fälle ein kreisförmiges Ziel mit einem Radius von 30 cm genau. Nach rund 13.500 Vorführungen stieg die Treffergenauigkeit des Balls auf 43 Prozent (unten rechts).

Eine weitere Einführung in diese beiden Projekte finden Sie unter folgendem Link:

- Iterative-Sim2Real Homepage: https://sites.google.com/view/is2r

- GoalsEye-Homepage: https://sites.google.com/view/goals-eye

Das obige ist der detaillierte Inhalt vonNach mehr als 300 Spielen in vier Minuten brachte Google seinem Roboter das Tischtennisspielen bei. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr