Heim >Technologie-Peripheriegeräte >KI >Marcus veröffentlichte einen Artikel, in dem er LeCun kritisierte: Deep Learning allein kann keine menschenähnliche Intelligenz erreichen

Marcus veröffentlichte einen Artikel, in dem er LeCun kritisierte: Deep Learning allein kann keine menschenähnliche Intelligenz erreichen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-09 23:01:141147Durchsuche

Im März dieses Jahres sorgte Gary Marcus für Aufsehen in der akademischen Gemeinschaft der künstlichen Intelligenz, nachdem er die Idee vorschlug, dass „Deep Learning an eine Wand gestoßen ist“.

Damals konnten selbst die drei Giganten des Deep Learning nicht stillstehen. Zunächst widerlegte Geoffrey Hinton diese Ansicht in einem Podcast.

Im Juni schrieb Yann LeCun einen Artikel als Antwort darauf und wies darauf hin, dass man vorübergehende Schwierigkeiten nicht so behandeln sollte, als würde man gegen eine Wand stoßen.

Jetzt hat Marcus im US-amerikanischen NOEMA-Magazin einen Artikel mit dem Titel „Deep Learning Alone Isn’t Getting Us To Human-Like AI“ veröffentlicht.

Ebenso hat er seine Ansicht immer noch nicht geändert – Deep Learning allein kann keine menschenähnliche Intelligenz erreichen.

und schlug vor, dass sich die aktuelle Forschung zur künstlichen Intelligenz hauptsächlich auf Deep Learning konzentriert und es an der Zeit ist, dies zu überdenken.

In den letzten 70 Jahren war die grundlegendste Debatte im Bereich der künstlichen Intelligenz: ob künstliche Intelligenzsysteme auf „symbolischen Operationen“ oder auf gehirnähnlichen „neuronalen Netzwerk“-Systemen aufgebaut werden sollten.

Tatsächlich gibt es hier noch eine dritte Möglichkeit: Hybridmodelle – die das Deep Learning neuronaler Netze mit den leistungsstarken Abstraktionsfähigkeiten symbolischer Operationen kombinieren.

LeCuns kürzlich im NOEMA-Magazin veröffentlichter Artikel „What AI Can Tell Us About Intelligence“ befasste sich ebenfalls mit diesem Thema, aber Marcus wies darauf hin, dass sein Artikel klar schien, aber offensichtliche Mängel aufwies, nämlich die Logik der Vergangenheit und die Zukunft.

Am Anfang des Artikels lehnen sie das Hybridmodell ab, doch am Ende des Artikels wird die Existenz von Hybridmodellen anerkannt und als möglicher Weg nach vorne erwähnt.

Hybrides Modell aus neuronalem Netzwerk und symbolischen Operationen

Marcus wies darauf hin, dass der Hauptpunkt von LeCun und Browning darin besteht, dass „ein Modell nicht hybrid ist, wenn es symbolische Operationen lernt.“

Aber das Problem des maschinellen Lernens ist ein Entwicklungsproblem (wie ist das System entstanden?)

Und wie das System funktioniert, sobald es entwickelt ist, ist ein Rechenproblem (z. B. funktioniert es?). einen Mechanismus verwenden oder nicht? Zwei Mechanismen?), das heißt: „Jedes System, das sowohl Symbole als auch neuronale Netze verwendet, ist ein Hybridmodell.“

Vielleicht wollen sie wirklich sagen, dass künstliche Intelligenz eher ein erlernter Hybrid als ein geborener Hybrid ist. Aber ein Hybrid des Lernens ist immer noch ein Hybrid.

Und Marcus‘ Standpunkt ist, dass „symbolische Operationen selbst angeboren sind, oder es gibt etwas anderes, das angeboren ist, was indirekt zur Entstehung symbolischer Operationen beiträgt.“

Unser Forschungsschwerpunkt sollte also darauf liegen, wie man dieses Medium entdeckt, das indirekt symbolische Operationen fördert.

Die Hypothese lautet: Solange wir herausfinden können, welches Medium es dem System ermöglicht, den Punkt zu erreichen, an dem es symbolische Abstraktionen lernen kann, können wir Systeme aufbauen, die das gesamte Wissen der Welt nutzen.

Als nächstes zitierte Marcus Klassiker und durchkämmte die Geschichte der Debatten über symbolische Manipulation und neuronale Netze im Bereich der künstlichen Intelligenz.

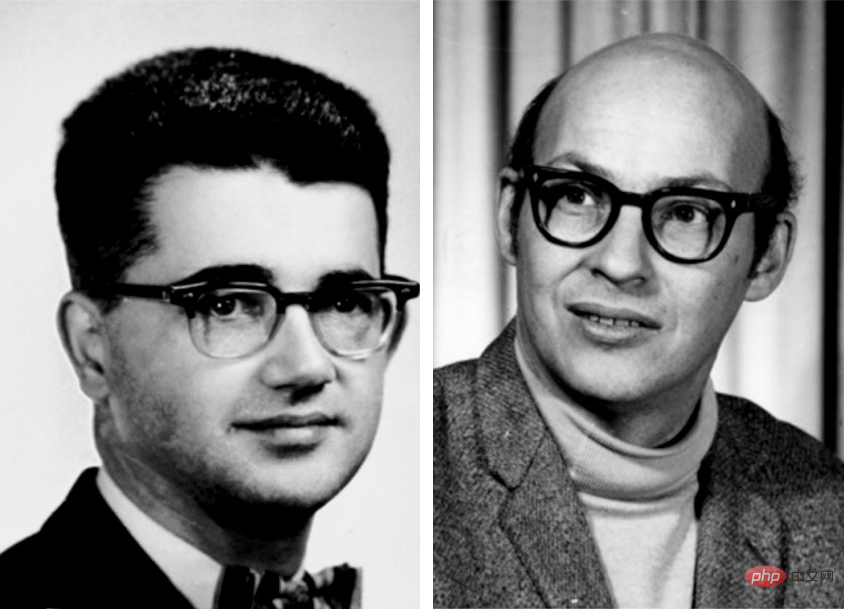

Frühe Pioniere der künstlichen Intelligenz wie Marvin Minsky und John McCarthy glaubten, dass symbolische Manipulation der einzig vernünftige Weg nach vorne sei.

Und der Neuronale-Netzwerk-Pionier Frank Rosenblatt glaubt, dass KI auf der Grundlage einer Struktur, in der neuronale Knoten digitale Eingaben überlagern und verarbeiten, möglicherweise eine bessere Leistung erbringt.

Tatsächlich schließen sich diese beiden Möglichkeiten nicht gegenseitig aus.

Das von der KI verwendete neuronale Netzwerk ist kein buchstäbliches biologisches Neuronennetzwerk, sondern ein vereinfachtes digitales Modell verfügt über einige Eigenschaften des menschlichen Gehirns, jedoch mit minimaler Komplexität.

Grundsätzlich können diese abstrakten Symbole auf viele verschiedene Arten verbunden werden, von denen einige logische und symbolische Operationen direkt implementieren können. „A Logical Calculus of the Ideas Inmanent in Nervous Activity“, veröffentlicht von Warren S. McCulloch und Walter Pitts im Jahr 1943 , erkennt diese Möglichkeit eindeutig an. Andere sind Frank Rosenblatt in den 1950er Jahren sowie David Rumelhart und Jay McClelland in den 1980er Jahren, die neuronale Netze als Alternativen zu symbolischen Operationen vorschlugen. Auch Geoffrey Hinton unterstützt diese Position grundsätzlich.

Dann rief Marcus nacheinander Turing-Award-Gewinner wie LeCun, Hinton und Yoshua Bengio an.

Ich meine, es spielt keine Rolle, was ich gesagt habe, andere große Jungs haben es gesagt!

Im Jahr 2015 schrieben LeCun, Bengio und Hinton eine Arbeit im Manifest-Stil über Deep Learning in der Natur.

Der Artikel endet mit einem Angriff auf Symbole und argumentiert, dass „neue Paradigmen erforderlich sind, um die Operationen auf großen Vektoren basierend auf Regular zu ersetzen.“ symbolische Ausdrucksoperationen“. Tatsächlich war Hinton so überzeugt, dass Symbole eine Sackgasse seien, dass er im selben Jahr an der Stanford University einen Vortrag mit dem Titel „Das Symbol des Äthers“ hielt und das Symbol mit einem der größten Fehler in der Geschichte der Wissenschaft verglich. In den 1980er Jahren brachten zwei seiner ehemaligen Mitarbeiter, Rumelhart und McClelland, ähnliche Argumente vor. In einem berühmten Buch argumentierte er, dass Symbole nicht „die Essenz menschlicher Berechnungen“ seien, was eine große Debatte auslöste.

Marcus sagte, als er 2018 einen Artikel zur Verteidigung der Symbolmanipulation schrieb, wies LeCun ihn ohne Begründung zurück es auf Twitter als „größtenteils falsch“.

Dann sagte er, zwei berühmte Experten auf dem Gebiet des Deep Learning äußerte auch seine Unterstützung für hybride KI.

Nach LeCuns und Brownings neuer Sichtweise ist symbolische Manipulation tatsächlich entscheidend, wie Marcus und Steven Pinker seit 1988 vorschlagen.

Marcus beschuldigte Lecun dann: „Ich habe Ihren Standpunkt schon vor Jahrzehnten vertreten, und Ihre Forschung liegt Jahrzehnte zurück.“

Und nicht nur ich, auch andere große Jungs denken so.

Der Rest des Artikels von LeCun und Browning lässt sich grob in drei Teile unterteilen: 1. Falsche Charakterisierung meiner Position 2 . Bemühungen, den Anwendungsbereich hybrider Modelle einzuschränken. 3. Symbolische Manipulation kann eher erlernt als angeboren sein. Als nächstes widerlegte Marcus die Ansichten in LeCuns Artikel: #🎜🎜 #Sagten LeCun und Browning „Marcus hat gesagt, wenn man überhaupt keine symbolische Manipulation hat, wird man sie nie haben.“ Tatsächlich habe ich in meinem 2001 erschienenen Buch „Algebraic Thinking“ ausdrücklich zugegeben, dass wir nicht sicher sind, ob symbolische Operationen mit angeborenem Denken zusammenhängen . Sie kritisierten meine Aussage, dass „Deep Learning keine weiteren Fortschritte machen kann“, und mein eigentlicher Punkt ist nicht, dass DL darauf Einfluss hat Bei jedem Problem wird es keine weiteren Fortschritte geben, aber Deep Learning selbst ist für bestimmte Aufgaben wie Komposition und Argumentation das falsche Werkzeug. In ähnlicher Weise verleumdeten sie mich, indem sie sagten, dass es im System symbolische Argumente gibt oder nicht (1 oder 0). Das ist einfach Unsinn. Es ist wahr, dass DALL-E keine Symbole zum Denken verwendet, aber das bedeutet nicht, dass irgendein System symbolisches Denken enthält muss Oder nicht. Zumindest bereits mit dem System MYCIN in den 1970er Jahren gab es ein rein symbolisches System, das verschiedene quantitative Überlegungen durchführen konnte. Kann die Fähigkeit zur Symbolmanipulation erlernt und nicht von Anfang an aufgebaut werden? Die Antwort ist ja. Marcus sagte, dass frühere Experimente zwar nicht garantieren konnten, dass die Fähigkeit, Symbole zu bedienen, angeboren war, sie aber fast mit diesem identisch war Der Standpunkt ist derselbe. Sie stellen eine Herausforderung für jede Lerntheorie dar, die auf großen Erfahrungsmengen beruht. und bringen Sie folgende 2 Hauptargumente vor: 1. Lernbarkeit wurde 2001 in The Algebraic Mind veröffentlicht Marcus zeigt, dass bestimmte Systeme in der Lage sind, symbolische Operationen zu lernen. Ein System mit einigen integrierten Ausgangspunkten wird die Welt effektiver verstehen als eine reine leere Tafel. Tatsächlich ist sogar LeCuns berühmtestes Werk „On Convolutional Neural Networks“ ein gutes Beispiel: Integrierte Einschränkungen beim Wie Neuronale Netze lernen und verbessern so die Effizienz erheblich. Wenn symbolische Operationen gut integriert sind, können sogar noch größere Gewinne erzielt werden. 2. Menschliche Säuglinge zeigen eine gewisse Fähigkeit, Symbole zu manipulieren #🎜🎜 # Darüber hinaus hat die Forschung gezeigt, dass Bienen beispielsweise die Sonnenazimutfunktion auf Lichtverhältnisse übertragen können, die sie noch nie zuvor gesehen haben.

Was rätselhaft ist, ist, dass LeCun, nachdem er Einwände gegen die angeborene Natur von Symboloperationen erhoben hatte, keine starken Beweise lieferte, um diese symbolische Manipulation zu beweisen wird gelernt. Wenn ein Ziegenbaby kurz nach der Geburt einen Hügel hinunterklettern kann, warum können dann neu entstehende neuronale Netze nicht sofort integriert werden? ? Wie wäre es mit einer kleinen symbolischen Manipulation?

Gleichzeitig haben LeCun und Browning nicht spezifiziert, wie die bekannten spezifischen Probleme beim Sprachverständnis und -schlussfolgern gelöst werden können, da der intrinsische Mechanismus der symbolischen Manipulation fehlt. Sie geben nur eine schwache Verallgemeinerung: Da Deep Learning das Problem von 1 bis N überwunden hat, sollten wir zuversichtlich sein, dass es das N+1-Problem überwinden kann. Die Leute sollten sich fragen, ob Deep Learning an seine Grenzen gestoßen ist. Angesichts der kontinuierlichen schrittweisen Verbesserungen der Missionen, die kürzlich in DALL-E 2, Gato und PaLM zu sehen waren, scheint es ratsam, momentane Schwierigkeiten nicht mit „Mauern“ zu verwechseln. Das unvermeidliche Scheitern von Deep Learning wurde bereits vorhergesagt, aber es lohnt sich nicht, darauf zu wetten. Optimismus ist eine Sache, aber man muss die Realität klar sehen. Deep Learning steht im Prinzip vor einigen spezifischen Herausforderungen, vor allem in Bezug auf Kompositionalität, Systematisierung und Sprachverständnis, die sich alle um Generalisierung und „verteilten Transfer“ drehen. Jetzt erkennt jeder, dass die Verteilungsmigration die Achillesferse aktueller neuronaler Netze ist. Natürlich hat Deep Learning Fortschritte gemacht, aber bei diesen grundlegenden Problemen wurden keine großen Fortschritte erzielt. Aus Sicht von Marcus ist die Situation, in der symbolische Operationen angeboren sein können, ungefähr die gleiche wie in der Vergangenheit: 1. Das aktuelle System, 20 Jahre nach der Entstehung des „algebraischen Denkens“ Selbst angesichts umfangreicher Datensätze und Schulungen ist es immer noch unmöglich, symbolische Operationen (z. B. Multiplikation) zuverlässig zu extrahieren. 2. Das Beispiel menschlicher Säuglinge zeigt, dass sie vor dem Erhalt einer formalen Bildung die Fähigkeit besitzen, komplexe Aspekte der natürlichen Sprache und des logischen Denkens zu verallgemeinern. 3. Eine kleine innere symbolische Bedeutung kann die Lerneffizienz erheblich verbessern. Ein Teil der Leistungsfähigkeit von AlphaFold 2 beruht auf sorgfältig konstruierten angeborenen Darstellungen der Molekularbiologie. Kurz gesagt, die Welt lässt sich grob in drei Klassen einteilen: Eins ist ein System mit Symbolmanipulationsgeräten, die vollständig in der Fabrik installiert sind. Das zweite ist, dass dem System mit angeborenem Lerngerät symbolische Operationen fehlen, es aber mit den richtigen Daten und der richtigen Trainingsumgebung über genügend Fähigkeiten verfügt, diese zu erhalten. Das dritte System ist selbst bei ausreichender Schulung nicht in der Lage, einen vollständigen Symbolmanipulationsmechanismus zu erhalten. Aktuelle Deep-Learning-Systeme scheinen in die dritte Kategorie zu fallen: keine symbolischen Manipulationsmechanismen am Anfang und keine zuverlässigen symbolischen Manipulationsmechanismen im Prozess. Derzeit hat das Verständnis der Ursprünge symbolischer Manipulation für uns oberste Priorität. Selbst die eifrigsten Befürworter neuronaler Netze erkennen mittlerweile die Bedeutung symbolischer Operationen für die Verwirklichung von KI. Und genau darauf hat sich die Neurosemiotik-Community konzentriert: Wie können datengesteuertes Lernen und symbolische Darstellung in einer einzigen, leistungsfähigeren Intelligenz harmonieren?

Das obige ist der detaillierte Inhalt vonMarcus veröffentlichte einen Artikel, in dem er LeCun kritisierte: Deep Learning allein kann keine menschenähnliche Intelligenz erreichen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr