Heim >Technologie-Peripheriegeräte >KI >Dieses Modell beschäftigte den ehemaligen Tesla-KI-Direktor Andrej Karpathy drei Tage lang!

Dieses Modell beschäftigte den ehemaligen Tesla-KI-Direktor Andrej Karpathy drei Tage lang!

- 王林nach vorne

- 2023-04-09 16:51:03925Durchsuche

Kürzlich hat ein KI-Forscher und Digitalkünstler namens Xander Steenbrugge ein sehr schockierendes Video „Journey Across Time“ hochgeladen.

Die große Entwicklung des Lebens auf der Erde, angefangen vom Urmeer über antike Eidechsen, Dinosaurier, Säugetiere bis hin zu Affen, Orang-Utans, Menschenaffen, Homo Sapiens ... und schließlich erschien die zukünftige Welt in der Science-Fiction.

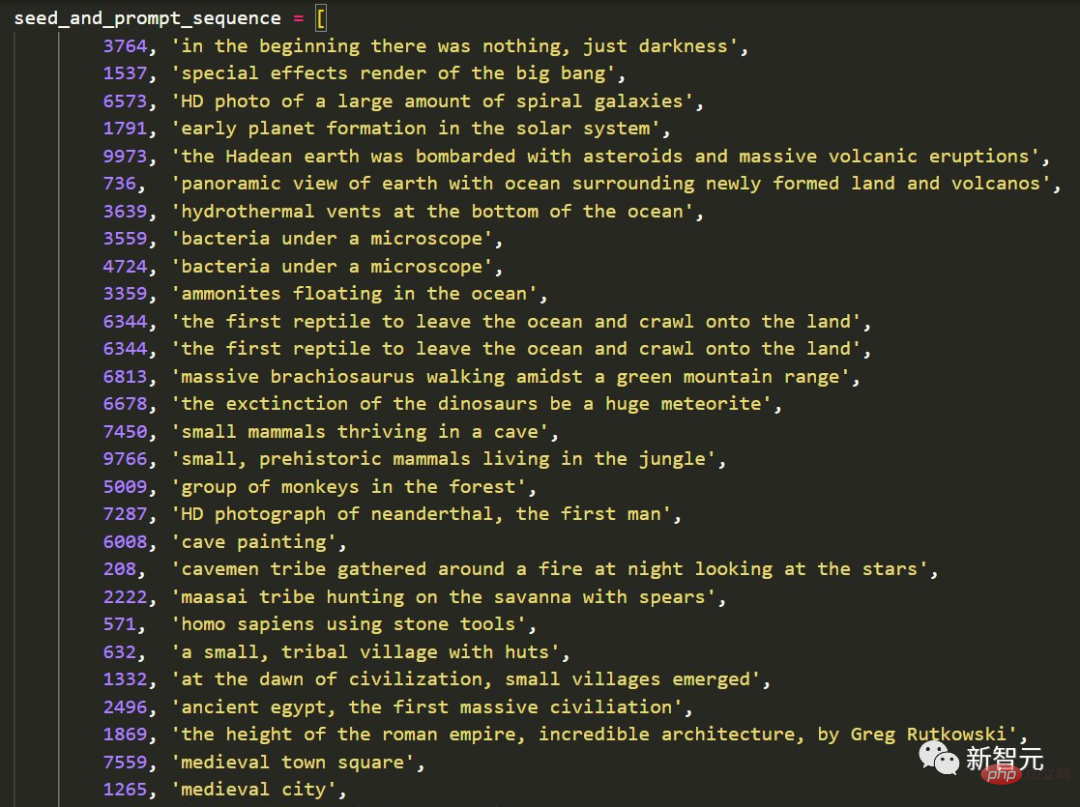

Und auch Steenbrugge kommentierte begeistert: „Wir überschreiten eine Schwelle, an der es bei der generativen KI nicht mehr nur um neuartige Ästhetik geht, sondern sie sich zu einem erstaunlichen Werkzeug zum Aufbau kraftvoller, menschenzentrierter Erzählungen entwickelt hat.“ Steenbrugge sagte, das Video habe 36 aufeinanderfolgende Sätze verwendet. Um die bestmögliche Reihenfolge zu finden, probierte er über tausend verschiedene Hints und Seeds aus und wandte viele „Hint Engineering“-Techniken auf den Code an, um herauszufinden, was funktionierte und was nicht.

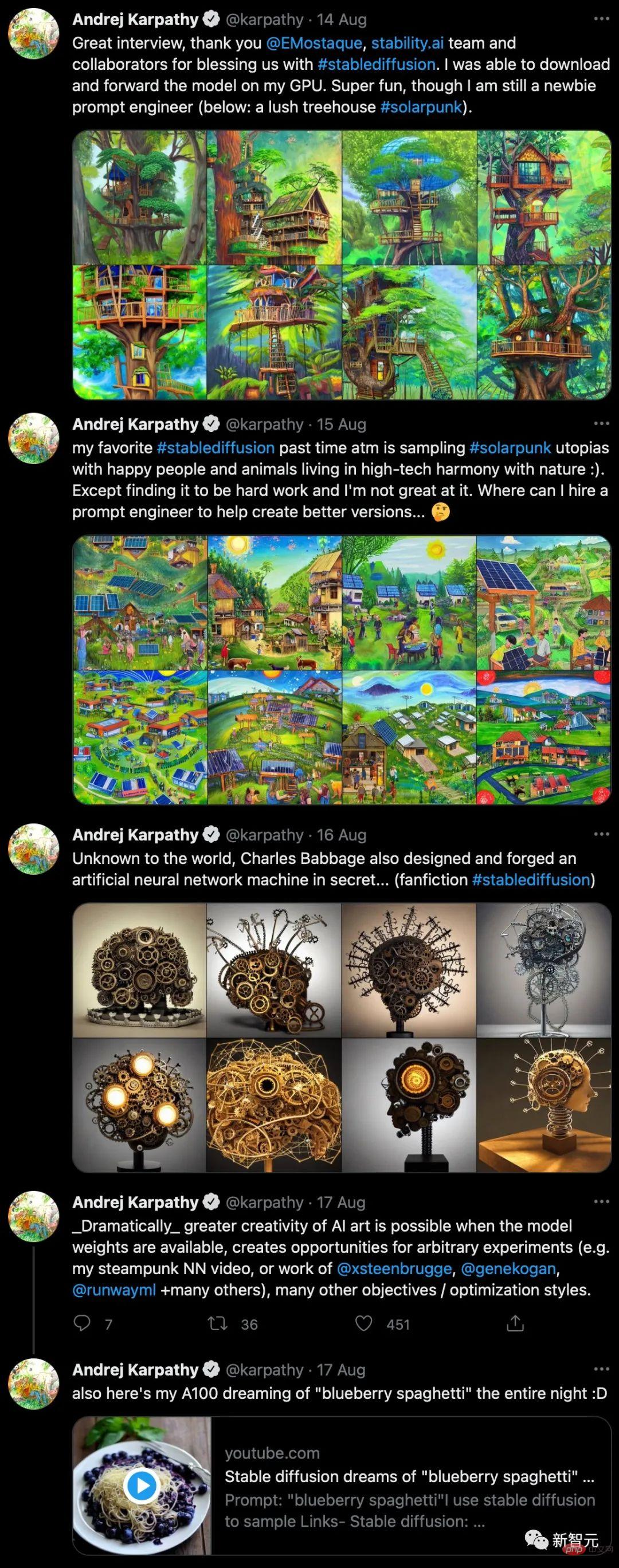

Der ehemalige Tesla AI Senior Director Andrej Karpathy war nach der Lektüre so schockiert, dass er nicht anders konnte, als es auszuprobieren.

„Eine surreale Steampunk-Maschine mit neuronalem Netzwerk, in Form eines Gehirns, auf einer Basis platziert und mit Neuronen aus Zahnrädern bedeckt.“ Nach der Eingabe dieses Textes entstand auch sein Meisterwerk.

2-minütiges Video (~1 Stunde gerendert auf A100), erzeugt durch reibungslose Interpolation zwischen Modellen mit zufälliger Rauscheingabe.

Dieses Modell namens Stable Diffusion verwendet eine Methode der „Interpolation“ zwischen den Bedeutungen zweier Sätze. Die Einfügung ist eher eine semantische als eine visuelle Lücke und verändert daher die Art und Weise, wie die Geschichte erzählt wird, dramatisch.

Und dies ist erst der Anfang der Revolution bei der Erstellung digitaler Inhalte, die durch generative künstliche Intelligenz vorangetrieben wird.

Stabile Verbreitung: Ein Meilenstein für Open-Source-Modelle

Seit Anfang 2021 entwickelt sich künstliche Intelligenz, die aus Textbeschreibungen Bilder generieren kann, rasant. Damals zeigte OpenAI beeindruckende Ergebnisse mit DALL-E 1 und CLIP.

Im Jahr 2022 veröffentlichte OpenAI das beeindruckende DALL-E 2, Google demonstrierte Imagen und Parti, Midjourney startete eine öffentliche Beta und von Craiyon erstellte KI-Bilder wurden über verschiedene soziale Medien verbreitet.

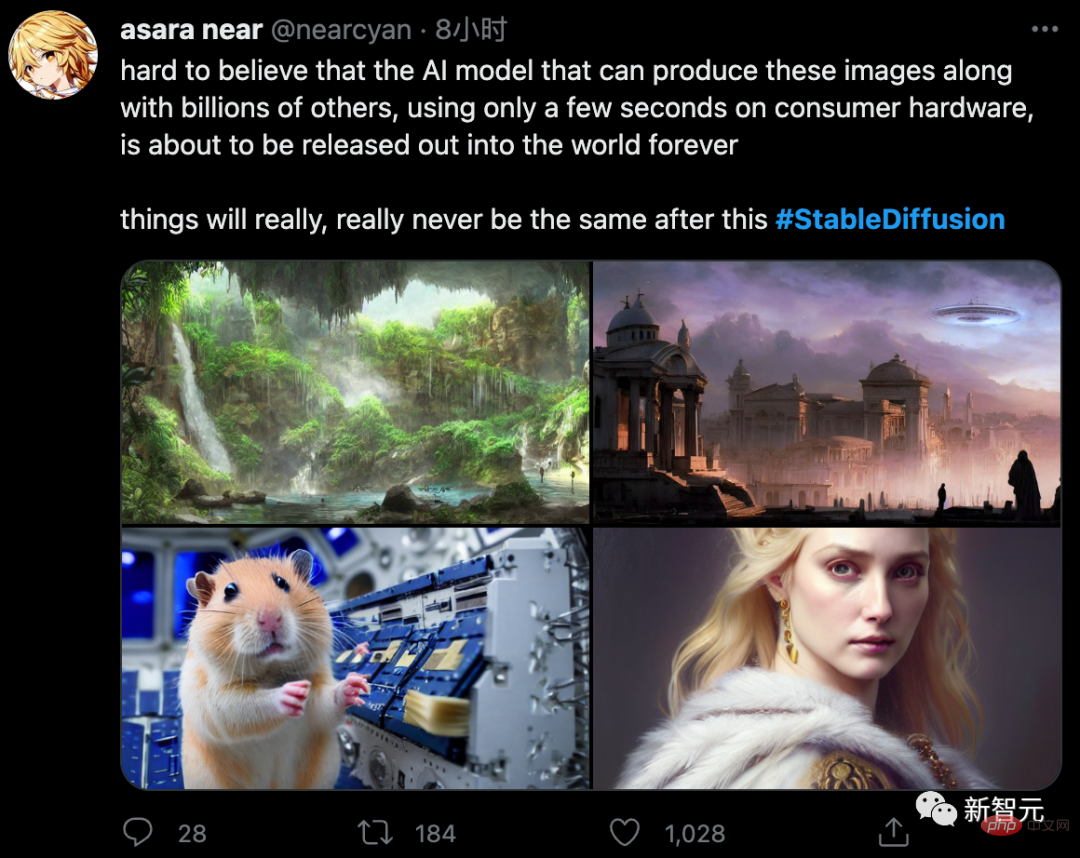

Und vor Kurzem hat Stability AI ein brandneues Modell veröffentlicht – Stable Diffusion.

Im Gegensatz zu DALL-E 2 kann Stable Diffusion jedoch eine Vielzahl bemerkenswerter Figuren hervorbringen, die von OpenAI verboten sind.

Obwohl Systeme wie Midjourney, Pixelz.ai usw. dies auch können, ist die Qualität, die sie erzeugen, bei weitem nicht mit Stable Diffusion vergleichbar und sie sind nicht Open Source.

Jetzt laden wir unseren alten Freund Musk ein, sich in Sekundenschnelle in „Black Widow“ (Scarlett Johansson) zu verwandeln.

Offenbar hofft Stability AI als Hauptentwickler, dass mehr als ein Unternehmen oder Team Varianten von Stable Diffusion trainieren kann.

Sie sind beispielsweise ein Forscher, der nicht über eine enorme GPU-Rechenleistung verfügt. Keine Sorge, Stable Diffusion wird bald auf einer Grafikkarte mit nur 5,1 GB VRAM laufen können.

Ein weiteres Beispiel: Wenn Sie ein Fan sind, der normalerweise ein MacBook mit Apple M1-Chip verwendet, kann Stable Diffusion auch ausgeführt werden. Die Zeit für die Bilderzeugung ändert sich jedoch von einigen Sekunden auf einige Minuten.

Es scheint, als ob multimodale Modelle den Weg einschlagen, den große Sprachmodelle zuvor eingeschlagen haben: weg von einem einzigen Anbieter und hin zur breiten Verfügbarkeit zahlreicher Alternativen über Open Source.

Darüber hinaus untersucht Runway bereits, wie die Text-zu-Video-Bearbeitung auf Basis von Stable Diffusion implementiert werden kann.

Mit einem Wort, lassen Sie den Tennisplatz in einen Strand verwandeln

Egal, ob es blitzt und donnert oder der Wind sonnig ist;

Nichts kann mich davon abhalten, Tennis zu spielen...

Berechnungen nutzen, um grundlegende KI-Open-Source-Lösungen zu beschleunigen

Berechnungen nutzen, um grundlegende KI-Open-Source-Lösungen zu beschleunigen

Nach der Testphase wird Stable Diffusion kostenlos sein und der Code und die trainierten Modelle werden offen veröffentlicht Quelle. Es wird auch eine gehostete Version mit einer Weboberfläche geben, über die Benutzer das System testen können.

Stable Diffusion ist das Ergebnis einer Zusammenarbeit zwischen Forschern von Stability AI, RunwayML, LMU München, EleutherAI und LAION. EleutherAI ist berühmt für seine Open-Source-Sprachmodelle GPT-J-6B und GPT-NeoX-20B usw.Die gemeinnützige Organisation LAION (Open Network for Large-scale Artificial Intelligence) stellte den Open-Source-Datensatz LAION 5B für Trainingsdaten zur Verfügung, den das Team während der ersten Testphase basierend auf menschlichem Feedback gefiltert hat, um das endgültige LAION zu erstellen -Ästhetischer Trainingsdatensatz.

Patrick Esser von Runway und Robin Rombach von der LMU München leiteten das Projekt, dessen Forschung in der CompVis-Gruppe der Universität Heidelberg den Grundstein für dieses Projekt legte. An der Universität Heidelberg haben sie das weit verbreitete VQGAN und Latent Diffusion entwickelt. Diese beiden Modelle ermöglichen in Verbindung mit den Ergebnissen von OpenAI und Google Brain eine stabile Verbreitung.

Stability AI wurde 2020 gegründet und der Investor dahinter ist der Mathematiker und Informatiker Emad Mostaque. Er war als Analyst bei verschiedenen Hedgefonds tätig.

Mit Stability AI und seinem Privatvermögen hofft Mostaque, eine Open-Source-KI-Forschungsgemeinschaft aufzubauen. Sein Startup hat bereits die Erstellung des Datensatzes „LAION 5B“ unterstützt. Um die Modelle von Stable Diffusion zu trainieren, stellte Stability AI Server mit 4.000 Nvidia A100-GPUs bereit.

„Niemand außer unseren 75 Mitarbeitern hat Entscheidungsbefugnis – weder Milliardäre, große Fonds noch Regierungen, wir sind völlig unabhängig“, sagte Mostaque. „Wir planen, unsere Computer zu nutzen, um die Open Source grundlegender künstlicher Intelligenz zu beschleunigen.“

Die Internetnutzer werden verrückt

Zusätzlich zu den beiden Videos am Anfang verwendeten einige Internetnutzer auch Stable Diffusion, um eine alternde Animation zu erstellen.

Er sagte, dass das Ändern eines Wortes in einem langen Prompt während der Produktion eine subtilere Wirkung hatte als in einem kurzen Prompt. Darüber hinaus funktioniert die Verwendung von Beschreibungen wie „alt“, „mittleres Alter“ oder „jung“ oft besser als die Angabe eines bestimmten Alters wie 10, 40 oder 80.

Darüber hinaus gibt es eine Vielzahl verträumter Standbilder.

„Lover“

„Lion“

Leyendecker und „Dark Soul“ geschrieben von Maxence

„Cyber Peking Opera“

Easter Egg

Easter Egg

Erleben Sie den Missbrauch von Andrej Karpathy, dem ehemaligen Vision-Direktor für künstliche Intelligenz und autonomes Fahren von Tesla.

Nachdem er sich das vom Meister erstellte Video angesehen hatte, war Karpathy sehr aufgeregt.

Die nach einer Operationswelle erzielten Ergebnisse werden sich in einer kleinen Kindergartenklasse nicht fehl am Platz anfühlen. Desperate Karpathy sagte, er wolle einen „Prompt-Ingenieur“ einstellen, der für ihn etwas erschafft. Endlich kam Karpathy endlich zur Besinnung und schuf neue Werke, mit denen er sehr zufrieden war – Steampunk-Maschine mit künstlichem neuronalen Netzwerk und Blaubeernudeln.

Das obige ist der detaillierte Inhalt vonDieses Modell beschäftigte den ehemaligen Tesla-KI-Direktor Andrej Karpathy drei Tage lang!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr