Heim >Technologie-Peripheriegeräte >KI >Die zweite Generation der Meta-Digital-Leute ist da! Verabschieden Sie sich von VR-Headsets, wischen Sie einfach mit dem iPhone

Die zweite Generation der Meta-Digital-Leute ist da! Verabschieden Sie sich von VR-Headsets, wischen Sie einfach mit dem iPhone

- 王林nach vorne

- 2023-04-09 14:21:061409Durchsuche

Metas realistischer digitaler Mensch 2.0 hat sich erneut weiterentwickelt und kann jetzt mit dem iPhone generiert werden. Nehmen Sie einfach Ihr Telefon heraus und scannen Sie es!

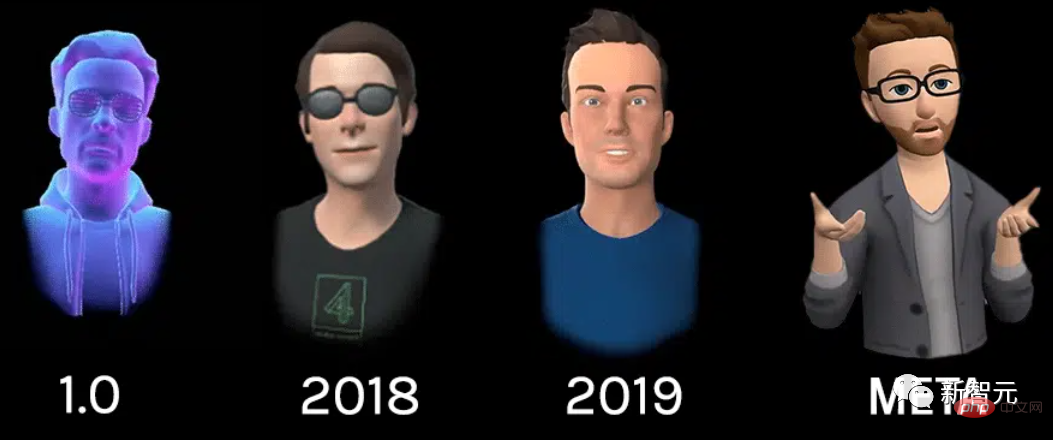

Bereits im März 2019 demonstrierte Facebook auf der Veranstaltung das digitale Menschenbild der ersten Generation (Codec Avatar 1.0). Die erste Generation digitaler Menschen wurde mithilfe mehrerer neuronaler Netze und eines speziellen Aufnahmegeräts mit 132 Kameras erzeugt.

Einmal generiert, 5 Kameras auf dem VR-Headset-Gerät. Jedes Auge bietet zwei Innenansichten und drei Außenansichten unterhalb des Gesichts. Wie unten.

Seitdem hat Facebook den Realismus dieser virtuellen Bilder kontinuierlich verbessert, indem beispielsweise ausschließlich Mikrofone und Eye-Tracking-Technologie verwendet wurden, um realistischere Bilder zu erzielen. Im August 2020 wurde daraus schließlich Codec Avatar Version 2.0. Die größte Verbesserung von Version 2.0 gegenüber Version 1.0 besteht darin, dass die Kamera keine Gesichter mehr scannen und verfolgen muss, sondern nur noch Augenbewegungen verfolgen muss.

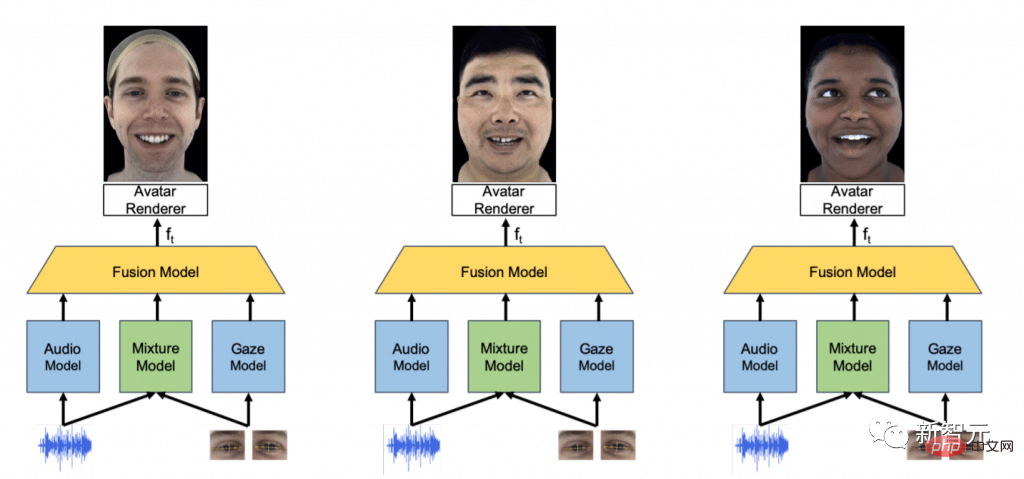

Das neue neuronale Netzwerk verbindet die Eye-Tracking-Daten des VR-Headsets mit dem Audio-Feed vom Mikrofon, um auf die wahrscheinlichen Gesichtsausdrücke des Trägers zu schließen. Die Daten des Tonmodells und des Augenbewegungsmodells werden an das Hybridmodell zurückgeführt, und dann gibt der Renderer durch die Berechnung und Verarbeitung des Fusionsmodells das Avatar-Bild aus.

Im Mai dieses Jahres gab das Team außerdem bekannt, dass die Version 2.0 von Avatar vollständig „völlig realistische“ Effekte erzielt hat. „Ich würde sagen, eine der großen Herausforderungen des nächsten Jahrzehnts besteht darin, ob wir Avatar-Interaktionen aus der Ferne erreichen können, die nicht von persönlichen Interaktionen zu unterscheiden sind“, sagte Sheikh, einer der Projektleiter.

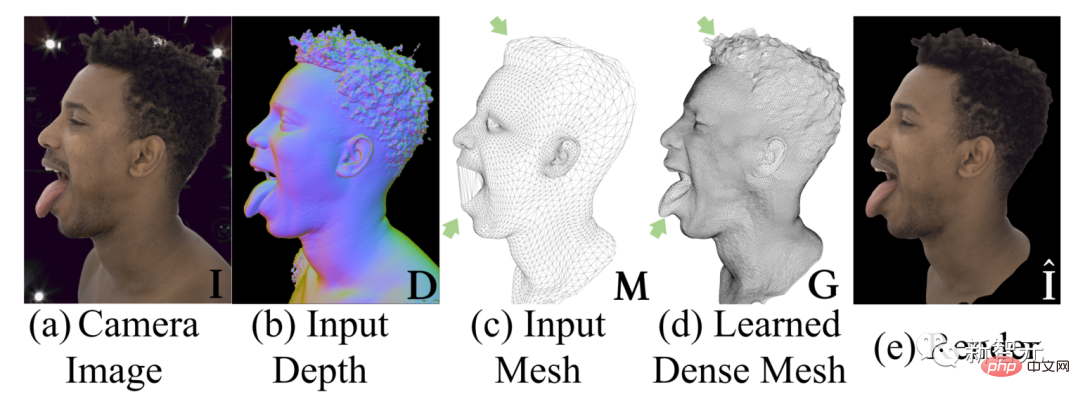

Sehen Sie sich den Vergleich oben an, a ist ein Foto einer realen Person und e ist eine virtuelle Person, die durch das endgültige Rendering generiert wurde. Keine Sorge, das Obige ist das Vergleichsergebnis im Experiment. In tatsächlichen Anwendungsszenarien sieht das aktuelle Bild des virtuellen Meta-Menschen so aus.

Sogar das „realistischste“ Bild ganz rechts ist immer noch ein Cartoon-Bild, was wahrscheinlich etwas weit von „völlig realistisch“ entfernt ist, aber Meta spricht von zehn Jahren, schauen Sie sich das an Angesichts des Demobildes ist die Hoffnung, dieses Ziel zu erreichen, immer noch nicht gering.

Darüber hinaus spiegelt sich der Fortschritt der virtuellen menschlichen Technologie nicht nur in der Richtung des Realismus wider. Es besteht keine Notwendigkeit, weiterhin einen Weg zu verfolgen, sondern auch andere Richtungen auszuprobieren. Zum Beispiel das VR-Headset abnehmen?

Früher erforderte die Generierung eines separaten Codec-Avatars ein spezielles Aufnahmegerät namens „MUGSY“, das über 171 hochauflösende Kameras verfügte, wie im Bild oben gezeigt.

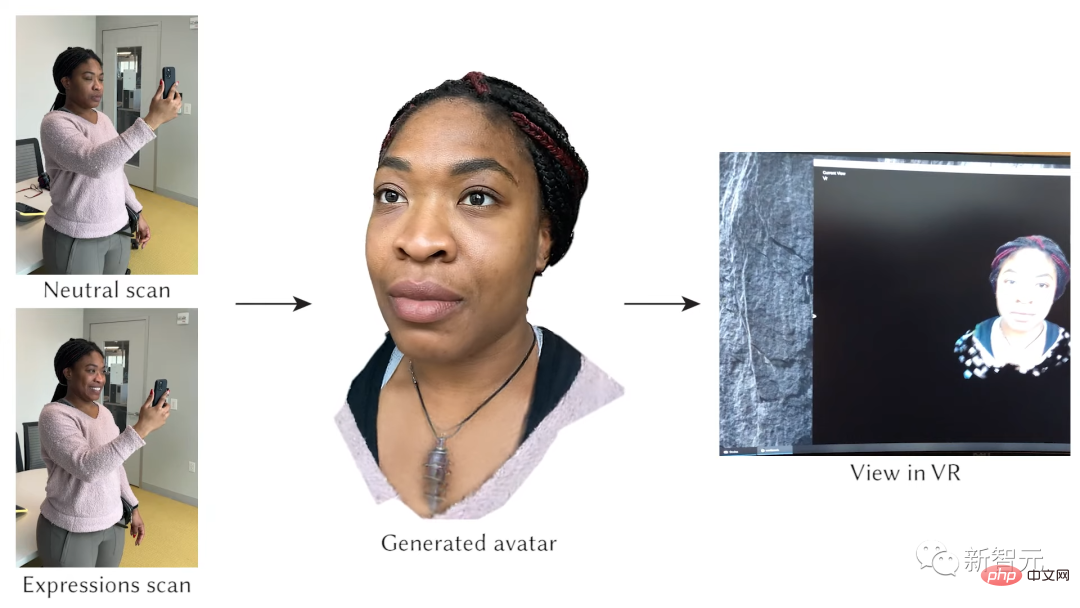

Meta sagt jetzt, dass Sie dieses Ding nicht mitbringen müssen, sondern nur ein iPhone! Solange ein Smartphone mit einem nach vorne gerichteten Tiefensensor (z. B. ein iPhone mit FaceID-Funktion) direkt scannen kann (genauer gesagt Dutzende von Scans), kann ein realistischer virtueller menschlicher Avatar generiert werden.

Halten Sie zunächst Ihr Gesicht ausdruckslos, scannen Sie es einmal und machen Sie dann verschiedene Ausdrücke. Bis zu 65 verschiedene Ausdrücke werden unterstützt.

Meta gab an, dass das Scannen des Gesichtsausdrucks mit einem Mobiltelefon durchschnittlich etwa 3 bis 4 Minuten dauert. Dies erfordert natürlich die Unterstützung von Rechenleistung. Der endgültig generierte realistische virtuelle menschliche Avatar dauert auf einer Maschine mit vier High-End-GPUs etwa 6 Stunden. Wenn diese Technologie in Produkten verwendet wird, werden diese Berechnungen natürlich an die Cloud-GPU übergeben, ohne dass der Benutzer eigene Rechenressourcen benötigt.

Warum lässt sich also etwas, für das früher 100 Kameras erforderlich waren, mit nur einem Mobiltelefon erledigen? Das Geheimnis ist ein allgemeines Modell namens Hypernetwork. Dies ist ein neuronales Netzwerk, das die Gewichte eines anderen neuronalen Netzwerks generiert. Im obigen Beispiel geht es darum, einen Codec-Avatar für eine bestimmte Person zu generieren hat nur 90 Kameras.

Obwohl andere Forscher Porträts gezeigt haben, die durch Scannen mit Smartphones generiert wurden, gab Meta an, dass die generierten Ergebnisse SOTA-Niveau sind.  Allerdings kommt das aktuelle System mit Brillen und langen Haaren immer noch nicht zurecht. Und es kann nur zum Kopf gelangen, nicht zu anderen Körperteilen.

Allerdings kommt das aktuelle System mit Brillen und langen Haaren immer noch nicht zurecht. Und es kann nur zum Kopf gelangen, nicht zu anderen Körperteilen.

Natürlich hat Meta noch einen langen Weg vor sich, bis dieses Maß an Wiedergabetreue erreicht ist. Metas Porträts haben jetzt einen Cartoon-Stil. Und dieser Sinn für Realismus nahm mit der Zeit langsam ab. Jetzt ist dieses Bild möglicherweise besser für Leute geeignet, die Quest 2 zum Spielen von Horizon Worlds verwenden.

Codec Avatar könnte jedoch letztendlich nur eine eigenständige Option sein und nicht das cartoonartige Upgrade, das es jetzt ist. Zuckerberg, CEO von Meta, beschrieb die Zukunft folgendermaßen: Sie können ein expressionistisches Porträt verwenden, um gewöhnliche Spiele zu spielen, und ein realistischeres Porträt, um an Arbeitstreffen teilzunehmen usw.

Im April dieses Jahres sagte Yaser Sheikh, der für das Codec Avatar-Team verantwortlich ist: „Es ist unmöglich vorherzusagen, wie lange es dauern wird, bis Codec Avatar zum Einsatz kommt.“ Er hat es jedoch geschafft Es ist klar, dass er glaubt, dass das Projekt große Fortschritte gemacht hat.

Das obige ist der detaillierte Inhalt vonDie zweite Generation der Meta-Digital-Leute ist da! Verabschieden Sie sich von VR-Headsets, wischen Sie einfach mit dem iPhone. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr