Heim >Technologie-Peripheriegeräte >KI >Es ist wirklich so glatt: NeuralHDHair, eine neue 3D-Haarmodellierungsmethode, gemeinsam entwickelt von der Zhejiang-Universität, der ETH Zürich und CityU

Es ist wirklich so glatt: NeuralHDHair, eine neue 3D-Haarmodellierungsmethode, gemeinsam entwickelt von der Zhejiang-Universität, der ETH Zürich und CityU

- WBOYnach vorne

- 2023-04-09 12:31:091297Durchsuche

In den letzten Jahren ist die Branche der virtuellen digitalen Menschen explodiert und alle Gesellschaftsschichten bringen ihre eigenen digitalen Menschenbilder auf den Markt. Es besteht kein Zweifel, dass hochauflösende 3D-Haarmodelle den Realismus virtueller digitaler Menschen deutlich verbessern können. Im Gegensatz zu anderen Teilen des menschlichen Körpers ist das Beschreiben und Extrahieren der Haarstruktur aufgrund der äußerst komplexen Beschaffenheit der ineinander verschlungenen Haarstruktur eine größere Herausforderung, was es äußerst schwierig macht, ein hochauflösendes 3D-Haarmodell aus nur einer einzigen Ansicht zu rekonstruieren. Im Allgemeinen lösen bestehende Methoden dieses Problem in zwei Schritten: Zuerst wird ein 3D-Orientierungsfeld basierend auf der aus dem Eingabebild extrahierten 2D-Orientierungskarte geschätzt und dann Haarsträhnen basierend auf dem 3D-Orientierungsfeld synthetisiert. Allerdings weist dieser Mechanismus in der Praxis noch einige Probleme auf.

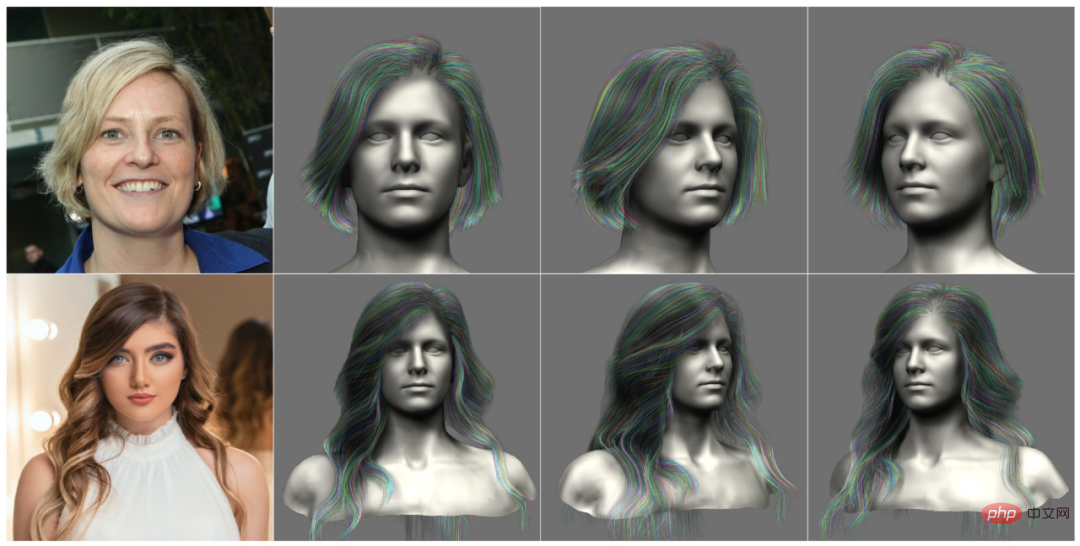

Basierend auf praktischen Beobachtungen suchen Forscher nach einer vollautomatischen und effizienten Methode zur Modellierung von Haarmodellen, die ein 3D-Haarmodell aus einem einzigen Bild mit feinkörnigen Merkmalen rekonstruieren kann (Abbildung 1) und gleichzeitig eine hohe Auflösung zeigt Grad an Flexibilität, wie zum Beispiel die Rekonstruktion eines Haarmodells, die nur einen Vorwärtsdurchlauf des Netzwerks erfordert.

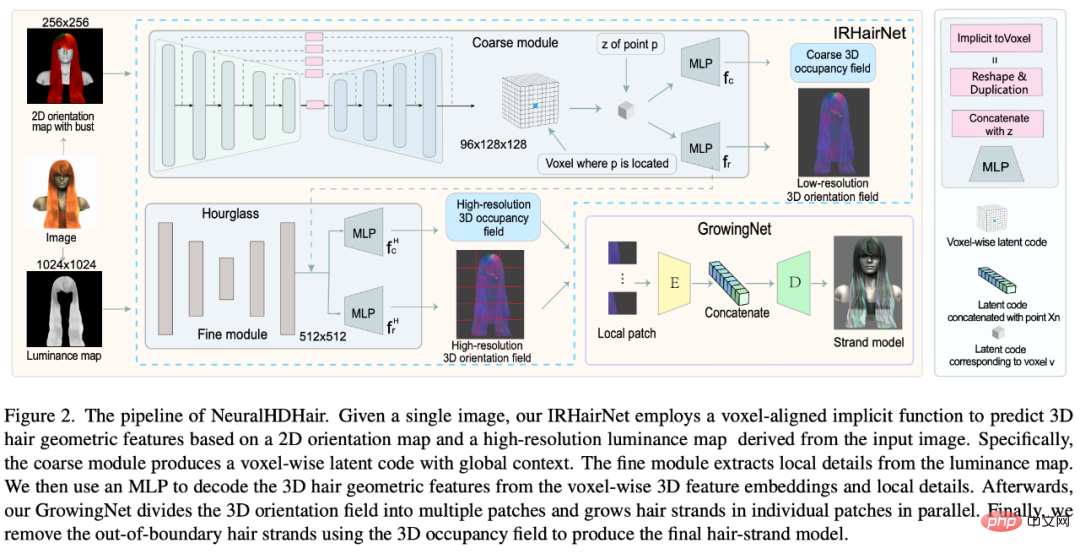

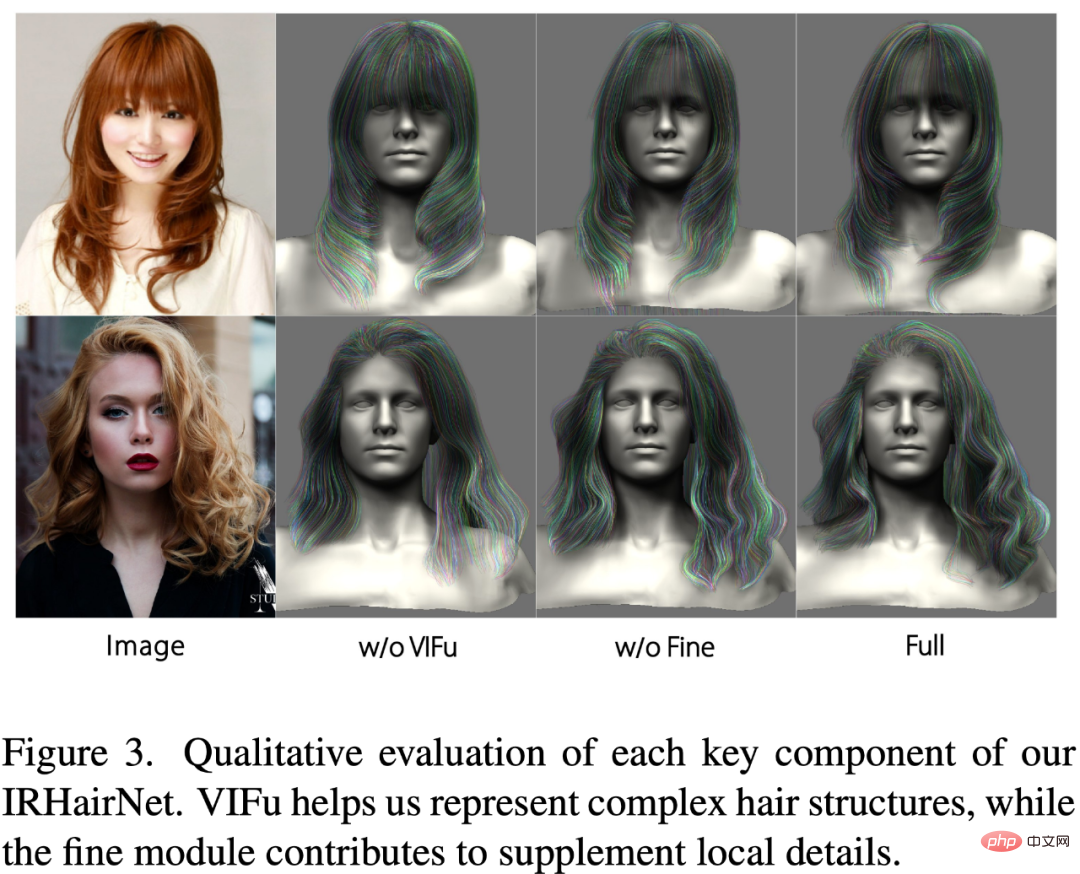

Um diese Probleme zu lösen, haben Forscher der Zhejiang-Universität, der ETH Zürich, der Schweiz und der City University of Hong gearbeitet Kong schlug vor, dass IRHairNet eine Grob-zu-Fein-Strategie implementiert, um 3D-Orientierungsfelder mit hoher Wiedergabetreue zu erzeugen. Konkret führten sie eine neuartige voxelausgerichtete implizite Funktion (VIFu) ein, um Informationen aus der 2D-Orientierungskarte des groben Moduls zu extrahieren. Um gleichzeitig die in der 2D-Richtungskarte verlorenen lokalen Details auszugleichen, extrahierten die Forscher mithilfe der hochauflösenden Helligkeitskarte lokale Merkmale und kombinierten sie mit den globalen Merkmalen im Feinmodul für High-Fidelity-Haare Styling.

Um Haarmodelle aus 3D-Richtungsfeldern effektiv zu synthetisieren, führten Forscher GrowingNet ein, eine Haarwuchsmethode, die auf Deep Learning unter Verwendung lokaler impliziter Gitterdarstellung basiert. Dies basiert auf einer zentralen Beobachtung: Obwohl sich die Geometrie und die Wachstumsrichtung von Haaren global unterscheiden, weisen sie auf bestimmten lokalen Skalen ähnliche Eigenschaften auf. Daher kann für jeden lokalen 3D-Orientierungsfleck ein latenter Code auf hoher Ebene extrahiert werden, und dann wird eine neuronale implizite Funktion (ein Decoder) trainiert, um auf der Grundlage dieses latenten Codes Haarsträhnen darin wachsen zu lassen. Nach jedem Wachstumsschritt wird ein neues lokales Pflaster mittig am Ende der Haarsträhne verwendet, um das Wachstum fortzusetzen. Nach dem Training kann es auf 3D-orientierte Felder mit beliebiger Auflösung angewendet werden.

Paper: https://arxiv.org/pdf/2205.04175.pdf

IRHairNet und GrowingNet bilden den NeuralHDHair-Kern . Zu den Hauptbeiträgen dieser Forschung gehören insbesondere:

- Einführung eines neuartigen vollautomatischen monokularen Haarmodellierungsrahmens, dessen Leistung deutlich besser ist als bestehende SOTA-Methoden; ein neuronales Netzwerk zur Modellierung grober bis feiner Haare (IRHairNet), das eine neuartige voxelausgerichtete implizite Funktion und eine Helligkeitskarte verwendet, um lokale Details einer hochwertigen Haarmodellierung anzureichern;# 🎜🎜# schlägt ein neues Haarwachstum vor Netzwerk (GrowingNet), das auf lokalen impliziten Funktionen basiert und Haarmodelle jeder Auflösung effizient generieren kann. Dieses Netzwerk ist um eine Größenordnung schneller als frühere Methoden.

Methode

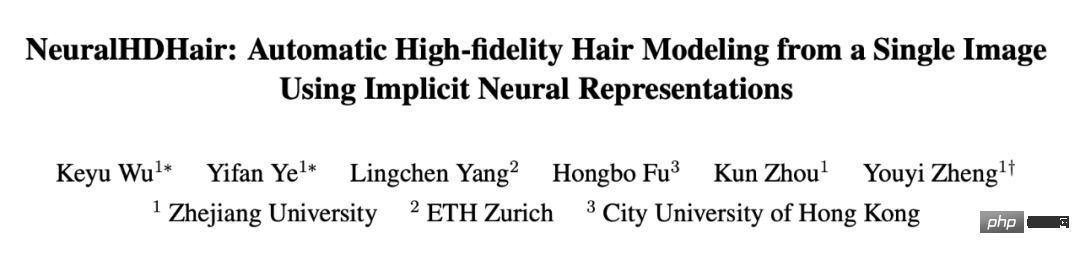

Abbildung 2 zeigt die Pipeline von NeuralHDHair. Für ein Porträtbild wird zunächst seine 2D-Ausrichtungskarte berechnet und seine Helligkeitskarte extrahiert. Darüber hinaus werden sie automatisch an demselben Brust-Referenzmodell ausgerichtet, um Brusttiefenkarten zu erhalten. Diese drei Diagramme werden dann an IRHairNet zurückgemeldet.

IRHairNet wurde entwickelt, um hochauflösende 3D-Haargeometriemerkmale aus einem einzigen Bild zu generieren. Die Eingabe in dieses Netzwerk besteht aus einer 2D-Orientierungskarte, einer Helligkeitskarte und einer angepassten Halblängen-Tiefenkarte, die aus dem Eingabeporträtbild erhalten werden. Die Ausgabe ist ein 3D-Orientierungsfeld, in dem jedes Voxel eine lokale Wachstumsrichtung enthält, und ein 3D-Belegungsfeld, in dem jedes Voxel darstellt, ob eine Haarsträhne passiert ist (1) oder nicht (0).

- GrowingNet wurde entwickelt, um effizient ein vollständiges Haarmodell aus dem von IRHairNet geschätzten 3D-Orientierungsfeld und 3D-Belegungsfeld zu generieren, wobei das 3D-Belegungsfeld zur Begrenzung des Haarwachstumsbereichs verwendet wird.

Experiment

In diesem Teil bewertet der Forscher die Wirksamkeit und Notwendigkeit jeder Algorithmuskomponente durch Ablationsstudien (Abschnitt 4.1) und dann Vergleichen Sie unsere Methode mit der aktuellen SOTA (Abschnitt 4.2). Einzelheiten zur Implementierung und weitere experimentelle Ergebnisse finden Sie im Zusatzmaterial. Ablationsexperiment

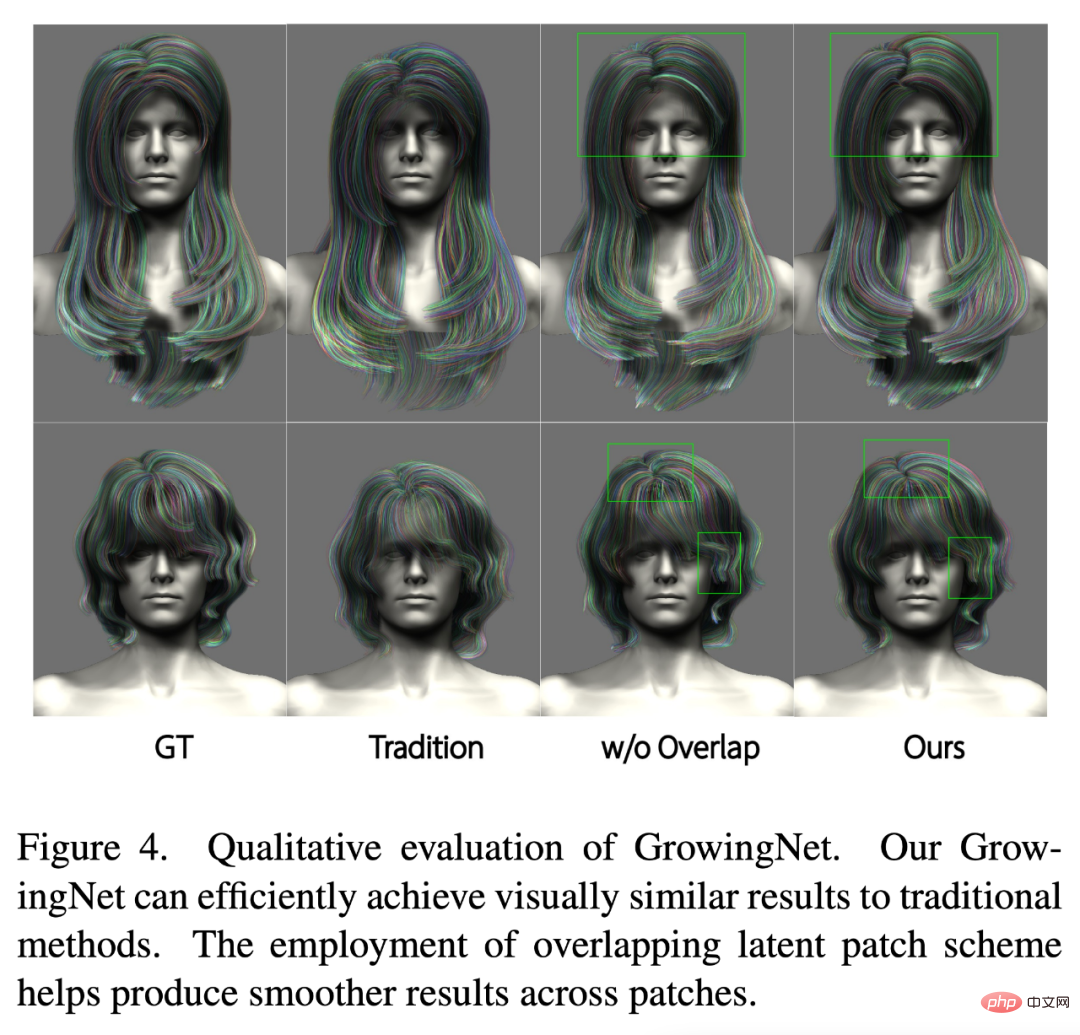

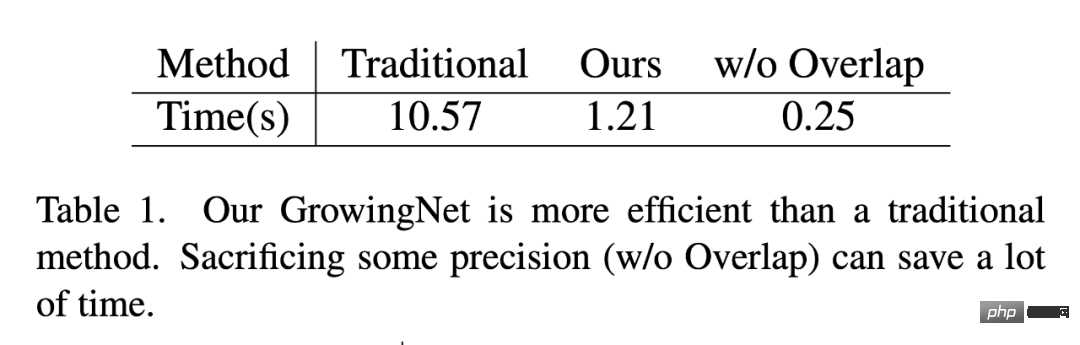

Die Forscher bewerteten die Genauigkeit und Leistung von GrowingNet aus qualitativer und quantitativer Effizienzperspektive . Zunächst werden drei Versuchsreihen mit synthetischen Daten durchgeführt: 1) traditioneller Haarwachstumsalgorithmus, 2) GrowingNet ohne überlappende potenzielle Patch-Schemata, 3) das vollständige Modell dieses Artikels.

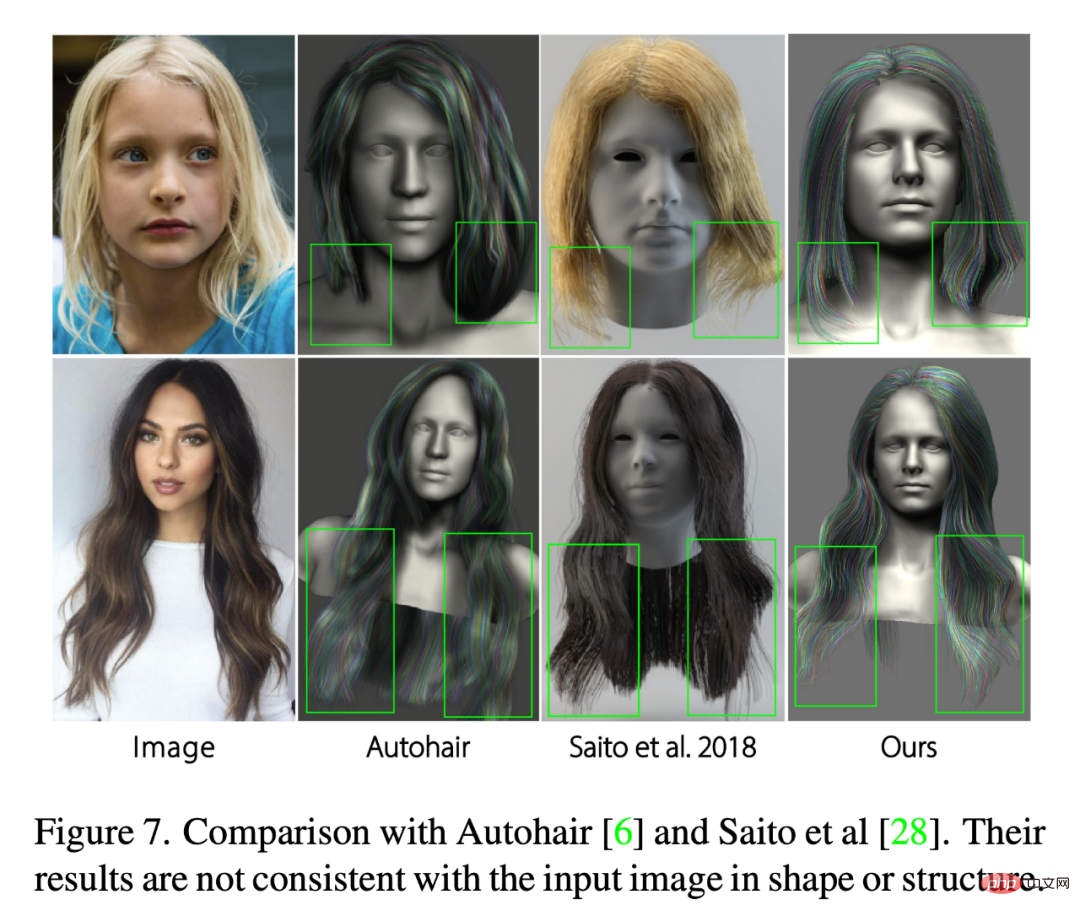

Wie in Abbildung 4 und Tabelle 1 gezeigt, bietet GrowingNet in diesem Artikel im Vergleich zum herkömmlichen Haarwuchsalgorithmus offensichtliche Vorteile im Zeitaufwand bei gleichbleibender Wachstumsleistung in Bezug auf die visuelle Qualität. Wenn man außerdem die dritte und vierte Spalte in Abbildung 4 vergleicht, erkennt man, dass die Haarsträhnen an der Patch-Grenze diskontinuierlich sein können, wenn es kein überlappendes potenzielles Patch-Schema gibt, was bei der Wachstumsrichtung der Haare ein Problem darstellt Stränge verändern sich drastisch. Es ist noch ernster. Es ist jedoch anzumerken, dass diese Lösung die Effizienz auf Kosten einer geringfügigen Verringerung der Genauigkeit erheblich verbessert. Die Verbesserung der Effizienz ist für ihre praktische und effiziente Anwendung bei der Digitalisierung des menschlichen Körpers von großer Bedeutung. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜##Vergleich mit SOTA -Methode#🎜🎜 ## 🎜 🎜#Um die Leistung von NeuralHDHair zu bewerten, verglichen die Forscher es mit einigen SOTA-Methoden [6, 28, 30, 36, 40]. Unter anderem basiert Autohair auf einem datengesteuerten Ansatz für die Haarsynthese, während HairNet [40] den Haarwachstumsprozess ignoriert, um eine durchgängige Haarmodellierung zu erreichen. Im Gegensatz dazu implementieren [28,36] eine zweistufige Strategie, indem sie zunächst ein 3D-Orientierungsfeld schätzen und dann daraus Haarsträhnen synthetisieren. PIFuHD [30] ist eine monokulare hochauflösende 3D-Modellierungsmethode, die auf einer Grob-zu-Fein-Strategie basiert und für die 3D-Haarmodellierung verwendet werden kann.

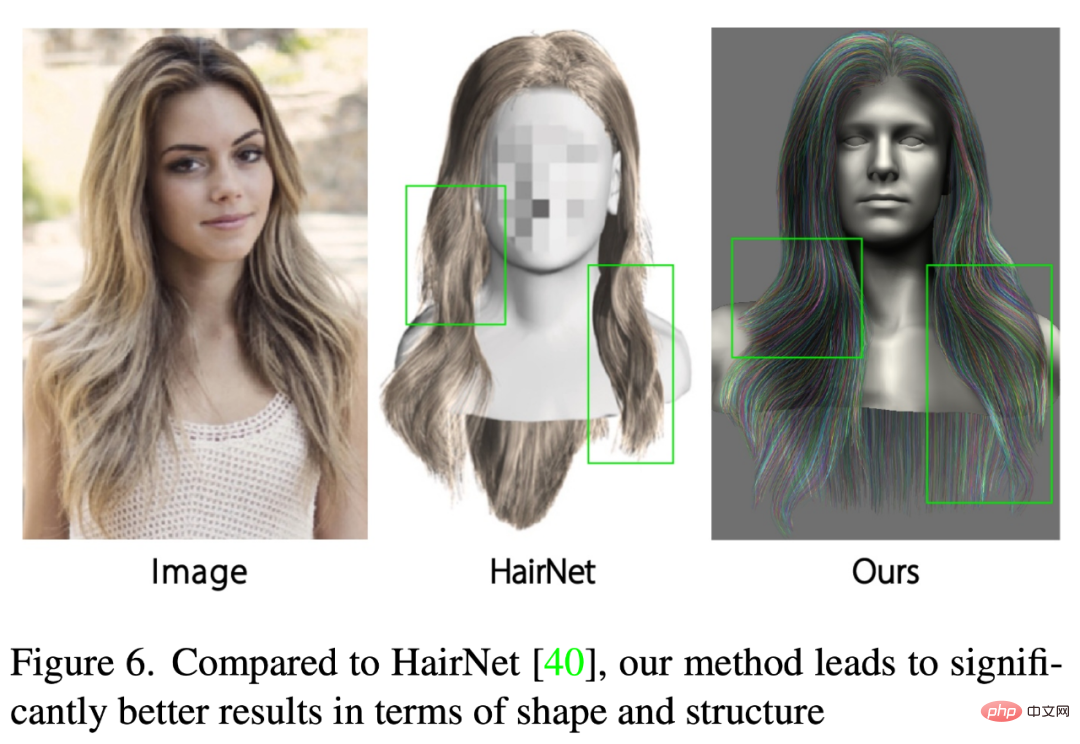

Wie in Abbildung 6 gezeigt, sehen die Ergebnisse von HairNet unbefriedigend aus, aber die lokalen Details und sogar die Gesamtform stimmen nicht mit den Haaren im Eingabebild überein. Dies liegt daran, dass die Methode Haare auf einfache und grobe Weise synthetisiert und ungeordnete Haarsträhnen direkt aus einem einzigen Bild wiederherstellt.

# 🎜🎜#

# 🎜 🎜#

Das obige ist der detaillierte Inhalt vonEs ist wirklich so glatt: NeuralHDHair, eine neue 3D-Haarmodellierungsmethode, gemeinsam entwickelt von der Zhejiang-Universität, der ETH Zürich und CityU. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr