Heim >Technologie-Peripheriegeräte >KI >Eine systematische Überprüfung des Deep Reinforcement Learning vor dem Training sowie Online- und Offline-Forschung ist ausreichend.

Eine systematische Überprüfung des Deep Reinforcement Learning vor dem Training sowie Online- und Offline-Forschung ist ausreichend.

- 王林nach vorne

- 2023-04-09 11:31:031833Durchsuche

In den letzten Jahren hat sich das Reinforcement Learning (RL) rasant weiterentwickelt, angetrieben durch Deep Learning. Verschiedene Durchbrüche in den Bereichen von Spielen bis hin zur Robotik haben das Interesse der Menschen am Entwurf komplexer und umfangreicher RL-Algorithmen und -Systeme geweckt. . Allerdings ermöglicht die bestehende RL-Forschung im Allgemeinen, dass Agenten bei neuen Aufgaben von Grund auf lernen, was es schwierig macht, vorab erworbenes Vorwissen zur Unterstützung der Entscheidungsfindung zu nutzen, was zu einem hohen Rechenaufwand führt.

Im Bereich des überwachten Lernens hat sich das Pre-Training-Paradigma als wirksame Möglichkeit erwiesen, übertragbares Vorwissen durch Vortraining an großen Datensätzen zu erlangen Das Netzwerkmodell kann sich schnell an verschiedene nachgelagerte Aufgaben anpassen. Ähnliche Ideen wurden auch im RL ausprobiert, insbesondere in der jüngsten Forschung zu „generalistischen“ Agenten [1, 2], was die Leute fragen lässt, ob so etwas wie GPT-3 [3] auch im vortrainierten RL-Bereich geboren werden kann Modell.

Die Anwendung von Pre-Training im RL-Bereich steht jedoch vor vielen Herausforderungen, wie zum Beispiel den erheblichen Unterschieden zwischen Upstream- und Downstream-Aufgaben, wie man Pre-Training effizient erhält und nutzt -Trainingsdaten. Probleme wie die effektive Übertragung von Vorkenntnissen behindern die erfolgreiche Anwendung von Pre-Training-Paradigmen in RL. Gleichzeitig gibt es große Unterschiede in den experimentellen Einstellungen und Methoden, die in früheren Studien berücksichtigt wurden, was es für Forscher schwierig macht, geeignete Modelle vor dem Training in realen Szenarien zu entwerfen.

Um die Entwicklung der Vorausbildung im Bereich RL und mögliche zukünftige Entwicklungsrichtungen zu klären, Forscher aus Shanghai Jiao Die Tong University und Tencent haben einen Artikel „Übersicht“ geschrieben, in dem bestehende RL-Unterteilungsmethoden vor dem Training unter verschiedenen Bedingungen und zu lösenden Problemen diskutiert werden .

Papieradresse: https://arxiv.org/pdf/2211.03959.pdf#🎜 🎜#

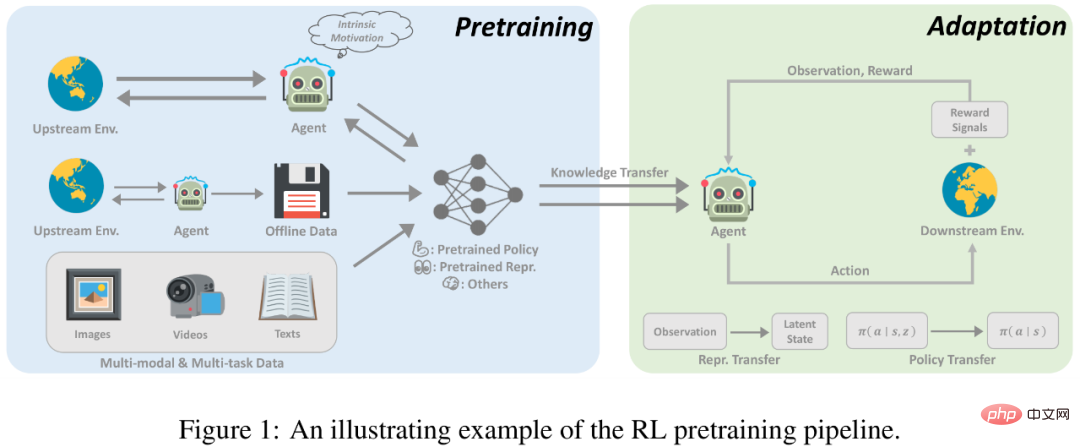

Einführung in das RL-VortrainingReinforcement Learning (RL) bietet eine allgemeine mathematische Form für die sequentielle Entscheidungsfindung. Durch RL-Algorithmen und tiefe neuronale Netze haben Agenten, die auf datengesteuerte Weise gelernt haben und bestimmte Belohnungsfunktionen optimieren, in verschiedenen Anwendungen in verschiedenen Bereichen eine Leistung erzielt, die über die menschliche Leistung hinausgeht. Obwohl sich RL bei der Lösung spezifischer Aufgaben als wirksam erwiesen hat, sind Stichprobeneffizienz und Generalisierungsfähigkeit immer noch zwei Haupthindernisse, die die Anwendung von RL in der realen Welt behindern. In der RL-Forschung besteht ein Standardparadigma darin, dass ein Agent aus den von ihm selbst oder anderen gesammelten Erfahrungen lernt und ein neuronales Netzwerk durch zufällige Initialisierung für eine einzelne Aufgabe optimiert. Im Gegensatz dazu ist für den Menschen das Vorwissen über die Welt eine große Hilfe bei der Entscheidungsfindung. Wenn die Aufgabe mit zuvor gesehenen Aufgaben zusammenhängt, neigen Menschen dazu, bereits erlerntes Wissen wiederzuverwenden, um sich schnell an neue Aufgaben anzupassen, ohne von Grund auf lernen zu müssen. Daher weisen RL-Agenten im Vergleich zu Menschen eine geringe Dateneffizienz auf und neigen zu einer Überanpassung. Jüngste Fortschritte in anderen Bereichen des maschinellen Lernens befürworten jedoch aktiv die Nutzung von Vorkenntnissen, die durch umfangreiche Vorschulungen erworben wurden. Durch maßstabsgetreues Training mit einer breiten Palette von Daten können große Fundamentmodelle schnell an eine Vielzahl nachgelagerter Aufgaben angepasst werden. Dieses Pre-Training-Finetuning-Paradigma hat sich in Bereichen wie Computer Vision und Verarbeitung natürlicher Sprache als wirksam erwiesen. Allerdings hatte das Vortraining keine nennenswerten Auswirkungen auf den RL-Bereich. Obwohl dieser Ansatz vielversprechend ist, steht die Gestaltung von Prinzipien für ein groß angelegtes RL-Vortraining vor vielen Herausforderungen. 1) Vielfalt der Domänen und Aufgaben; 2) begrenzte Datenquellen; 3) schnelle Anpassung an die Schwierigkeit, nachgelagerte Aufgaben zu lösen; Diese Faktoren ergeben sich aus den inhärenten Merkmalen von RL und erfordern eine besondere Berücksichtigung durch Forscher.

Das Vortraining hat großes Potenzial für RL, und diese Studie kann als Ausgangspunkt für diejenigen dienen, die sich für diese Richtung interessieren. In diesem Artikel versuchen Forscher, eine systematische Überprüfung bestehender Pre-Training-Arbeiten zum Deep Reinforcement Learning durchzuführen.

In den letzten Jahren hat das Pre-Training für tiefes Verstärkungslernen mehrere Durchbrüche erlebt. Erstens wurde auf AlphaGo ein auf Expertendemonstrationen basierendes Vortraining verwendet, das überwachtes Lernen nutzt, um die von Experten ergriffenen Maßnahmen vorherzusagen. Im Streben nach weniger überwachtem, groß angelegtem Vortraining ist der Bereich des unbeaufsichtigten RL schnell gewachsen, der es Agenten ermöglicht, aus Interaktionen mit der Umgebung ohne Belohnungssignale zu lernen. Darüber hinaus hat die rasante Entwicklung des Offline-Lernens zur Verstärkung (Offline-RL) Forscher dazu veranlasst, weiter darüber nachzudenken, wie unbeschriftete und suboptimale Offline-Daten für das Vortraining verwendet werden können. Schließlich ebnen Offline-Trainingsmethoden, die auf Multitasking- und multimodalen Daten basieren, den Weg für ein allgemeines Pre-Training-Paradigma.

Online-Vortraining

Der Erfolg von RL in der Vergangenheit wurde durch dichte und gut gestaltete Belohnungsfunktionen erreicht . Traditionelle RL-Paradigmen, die in vielen Bereichen große Fortschritte gemacht haben, stehen bei der Skalierung auf ein groß angelegtes Vortraining vor zwei großen Herausforderungen. Erstens sind RL-Agenten leicht überfittet, und es ist für Agenten, die vorab mit komplexen Aufgabenbelohnungen trainiert wurden, schwierig, bei Aufgaben, die sie noch nie zuvor gesehen haben, eine gute Leistung zu erzielen. Zudem ist die Gestaltung von Belohnungsfunktionen meist sehr aufwendig und erfordert viel Expertenwissen, was in der Praxis zweifellos eine große Herausforderung darstellt.

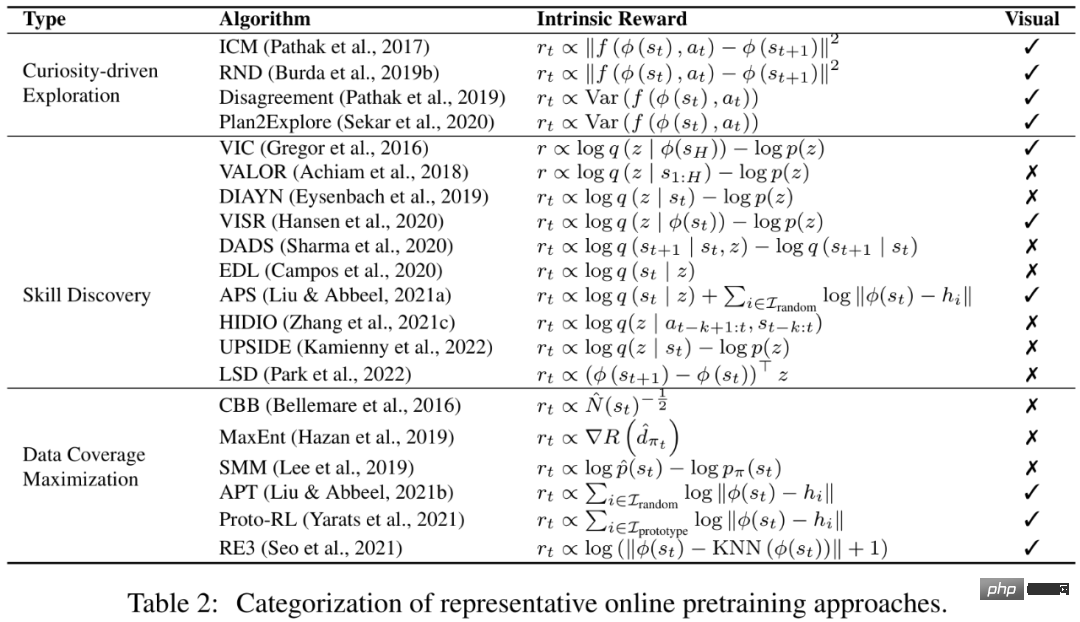

Online-Vortraining ohne Belohnungssignale könnte eine verfügbare Lösung für das Erlernen allgemeiner Vorkenntnisse und überwachter Signale ohne menschliches Eingreifen werden. Ziel des Online-Vortrainings ist der Erwerb von Vorkenntnissen durch Interaktion mit der Umwelt ohne menschliche Aufsicht. In der Vortrainingsphase darf der Agent über einen längeren Zeitraum mit der Umgebung interagieren, kann jedoch keine extrinsischen Belohnungen erhalten. Diese Lösung, auch als unüberwachtes RL bekannt, wurde in den letzten Jahren von Forschern aktiv untersucht.

Um einen Agenten zu motivieren, sich Vorwissen aus der Umgebung ohne jegliches Aufsichtssignal anzueignen, besteht eine ausgereifte Methode darin, intrinsische Belohnungen für den Agenten zu entwerfen (intrinsische Belohnung). Ermutigung der Agenten, Belohnungsmechanismen entsprechend zu gestalten, indem sie vielfältige Erfahrungen sammeln oder übertragbare Fähigkeiten beherrschen. Frühere Untersuchungen haben gezeigt, dass sich Agenten durch Online-Vorschulung mit intrinsischen Belohnungen und Standard-RL-Algorithmen schnell an nachgelagerte Aufgaben anpassen können.

Offline-Vortraining

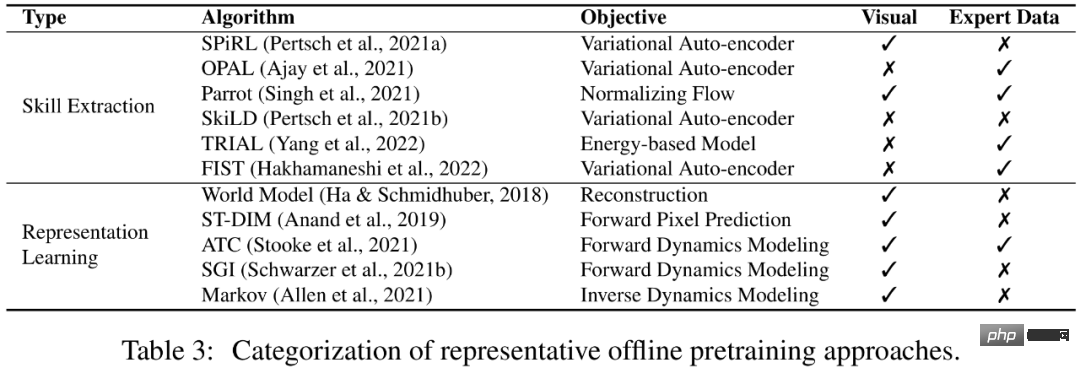

Obwohl das Online-Vortraining ohne menschliche Aufsicht durchgeführt wird Es können gute Vortrainingsergebnisse erzielt werden, für groß angelegte Anwendungen ist das Online-Vortraining jedoch immer noch begrenzt. Schließlich schließen sich die Online-Interaktion und die Notwendigkeit, anhand großer und vielfältiger Datensätze zu trainieren, in gewisser Weise aus. Um dieses Problem zu lösen, hofft man oft, die Datenerfassungs- und Vortrainingsverbindungen zu entkoppeln und historische Daten, die von anderen Agenten oder Menschen gesammelt wurden, direkt für das Vortraining zu nutzen.

Eine praktikable Lösung ist Offline-Reinforcement Learning. Der Zweck des Offline-Lernens zur Verstärkung besteht darin, aus Offline-Daten eine belohnungsmaximierende RL-Richtlinie zu erhalten. Eine grundlegende Herausforderung ist das Problem der Verteilungsverschiebung, also des Unterschieds in der Verteilung zwischen den Trainingsdaten und den beim Testen gesehenen Daten. Bestehende Offline-Lernmethoden zur Verstärkung konzentrieren sich auf die Lösung dieser Herausforderung durch die Verwendung von Funktionsnäherung. Richtlinieneinschränkungsmethoden erfordern beispielsweise ausdrücklich, dass die erlernte Richtlinie das Ergreifen von Aktionen vermeidet, die im Datensatz nicht sichtbar sind, und Wertregulierungsmethoden mildern das Problem der Überschätzung der Wertfunktion, indem sie die Wertfunktion an eine Art Untergrenze anpassen. Allerdings bleibt die Frage, ob offline trainierte Strategien auf neue Umgebungen übertragen werden können, die in Offline-Datensätzen nicht zu finden sind, noch nicht ausreichend erforscht.

Vielleicht können wir das Lernen von RL-Richtlinien vermeiden und stattdessen Offline-Daten verwenden, um Vorwissen zu lernen, das für die Konvergenzgeschwindigkeit oder die endgültige Leistung nachgelagerter Aufgaben von Vorteil ist. Noch interessanter ist, dass unser Modell, wenn es Offline-Daten ohne menschliche Aufsicht nutzen kann, das Potenzial hat, von riesigen Datenmengen zu profitieren. In diesem Artikel bezeichnen Forscher diese Einstellung als Offline-Vortraining, und der Agent kann wichtige Informationen (z. B. gute Darstellung und Verhaltenspriors) aus Offline-Daten extrahieren.

Auf dem Weg zu einem universellen Agenten

In einer einzigen Umgebung und einer einzigen Modalität Die Trainingsmethoden konzentrieren sich hauptsächlich auf die oben genannten Online-Vortrainings- und Offline-Vortrainingseinstellungen, und in letzter Zeit ist das Interesse an der Entwicklung eines einzigen allgemeinen Entscheidungsmodells (z. B. Gato [1] und Multigame) gestiegen DT [2]), wodurch dasselbe Modell Aufgaben unterschiedlicher Modalitäten in unterschiedlichen Umgebungen bewältigen kann. Um Agenten in die Lage zu versetzen, aus einer Vielzahl von Aufgaben mit offenem Ende zu lernen und sich an diese anzupassen, hofft die Forschung, große Mengen an Vorwissen in verschiedenen Formen, wie etwa visueller Wahrnehmung und Sprachverständnis, zu nutzen. Noch wichtiger: Wenn es Forschern gelingt, eine Brücke zwischen RL und maschinellem Lernen in anderen Bereichen zu schlagen und frühere erfolgreiche Erfahrungen zu kombinieren, können sie möglicherweise ein allgemeines Agentenmodell erstellen, das verschiedene Aufgaben erledigen kann.

Das obige ist der detaillierte Inhalt vonEine systematische Überprüfung des Deep Reinforcement Learning vor dem Training sowie Online- und Offline-Forschung ist ausreichend.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr