Heim >Technologie-Peripheriegeräte >KI >Richard Sutton: Erfahrung sind die ultimativen Daten der KI, vier Stufen, die zur Entwicklung echter KI führen

Richard Sutton: Erfahrung sind die ultimativen Daten der KI, vier Stufen, die zur Entwicklung echter KI führen

- PHPznach vorne

- 2023-04-09 10:01:021317Durchsuche

# 🎜 🎜#Einführung: Die Entwicklung starker künstlicher Intelligenz war in den letzten Jahren ein Thema, das Anlass zur Sorge gab. Viele Forscher konzentrieren sich darauf, die KI aus der Wahrnehmung und dem Verhalten des Menschen lernen zu lassen und nicht nur aus einfach etikettierten Daten. Unter anderem ist die Frage, wie man die von Menschen gesammelten Alltagserfahrungen nutzen kann, um künstliche Intelligenz zu inspirieren und aufzubauen, die sich an verschiedene Umgebungen anpassen und mit der Außenwelt interagieren kann, in einigen Bereichen zu einer neuen Forschungsmethode geworden.

Richard Sutton, bekannt als Vater des Reinforcement Learning, schlug kürzlich die Idee vor, Erfahrungen zu nutzen, um die Entwicklung von KI zu inspirieren. Er unterteilte den Prozess der KI von der Nutzung von Daten bis zur Nutzung von Erfahrungen in vier Entwicklungsstufen und schlug die Entwicklungsrichtung für den Aufbau echter KI (Real AI) in der Zukunft vor. Am 31. Mai 2022 hielt Richard Sutton auf der Beijing Intelligence Conference 2022 eine Grundsatzrede mit dem Titel „Die zunehmende Rolle sensomotorischer Erfahrung in der KI“, in der er den Einsatz von Erfahrungsmethoden anregte der KI-Entwicklung werden zusammengefasst und prospektiert.

Sprecherprofil: Richard Richard Sutton , einer der Begründer des modernen rechnergestützten Verstärkungslernens, ist ein herausragender Forschungswissenschaftler bei DeepMind, Professor am Department of Computing Science der University of Alberta und Professor an der Royal Society, der Royal Society of Canada, der Association for die Förderung der künstlichen Intelligenz und Al-Forscher am Berta Machine Intelligence Institute (AMII) und CIFAR.

01 Hintergrund: Die Bedeutung von Erfahrung für die Entwicklung von Intelligenz

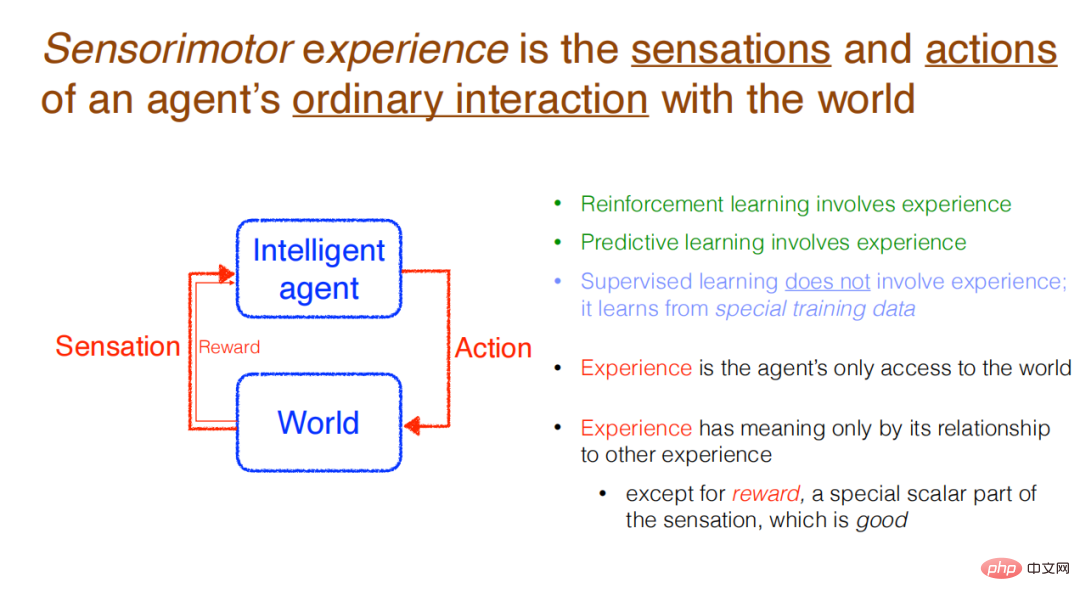

# 🎜🎜 #Sutton glaubt, dass ein intelligenter Agent mit der Außenwelt interagiert, Aktionen an sie sendet und Wahrnehmungen (Feedback) empfängt. Diese Art der erfahrungsbezogenen Interaktion ist die normale Art der Wahrnehmung beim verstärkenden Lernen. Dies ist auch der normale Ansatz, der verwendet wird, wenn ein Agent versuchen soll, die Außenwelt vorherzusagen. Allerdings ist dieser Ansatz beim überwachten Lernen, der derzeit am weitesten verbreiteten Art des maschinellen Lernens, unüblich. Maschinelles Lernen beinhaltet keine gewöhnliche Erfahrung (gewöhnliche Erfahrung), und das Modell lernt nicht aus speziellen Trainingsdaten, die sich von gewöhnlichen Erfahrungen unterscheiden. Tatsächlich lernen überwachte Lernsysteme zur Laufzeit überhaupt nicht.

Erfahrung sind also interaktive (mitgebrachte) Daten und eine Möglichkeit, mit der Außenwelt zu kommunizieren. Erfahrung hat keine Bedeutung, es sei denn, sie steht im Zusammenhang mit anderen Erfahrungen. Eine Ausnahme gibt es natürlich: Belohnungen, die über spezielle Signale ausgedrückt werden. Belohnungen stellen gute Ziele dar, und der Agent hofft sicherlich, die Belohnungen zu maximieren.

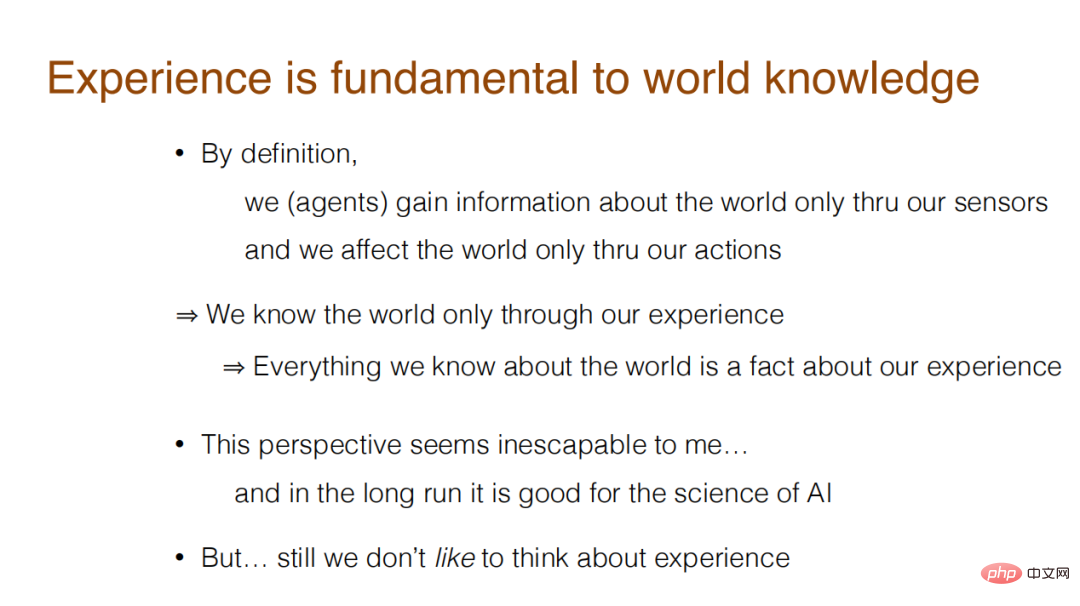

In seiner Rede stellte Sutton eine Kernfrage: Was kann letztendlich Intelligenz erklären? Handelt es sich um objektive oder erfahrungsbezogene Begriffe? Ersteres umfasst Dinge wie Zustände, Ziele, Menschen, Orte, Beziehungen, Räume, Handlungen und Entfernungen in der Außenwelt, die nicht im Agenten vorhanden sind, während Letzteres Dinge innerhalb des Agenten wie Wahrnehmung, Handlungen, Belohnungen, Zeit umfasst Schritte usw. Sutton ist der Ansicht, dass Forscher bei der Kommunikation und beim Verfassen von Arbeiten zwar normalerweise an objektive Konzepte denken, den Erfahrungen, die durch die Interaktion zwischen Agenten und der Außenwelt entstehen, jetzt jedoch mehr Aufmerksamkeit geschenkt werden sollte.

Um die Bedeutung von Erfahrung für intelligente Agenten weiter zu verdeutlichen, Richard Sutton schlug vor, dass die Erfahrung mit der schrittweisen Wertschätzung vier Phasen durchlaufen hat. Dies sind: Agentenschaft, Belohnung, Erfahrungszustand und prädiktives Wissen. Nach diesen vier Entwicklungsphasen sammelt die KI nach und nach Erfahrungen und wird praktischer, erlernbarer und einfacher zu erweitern.

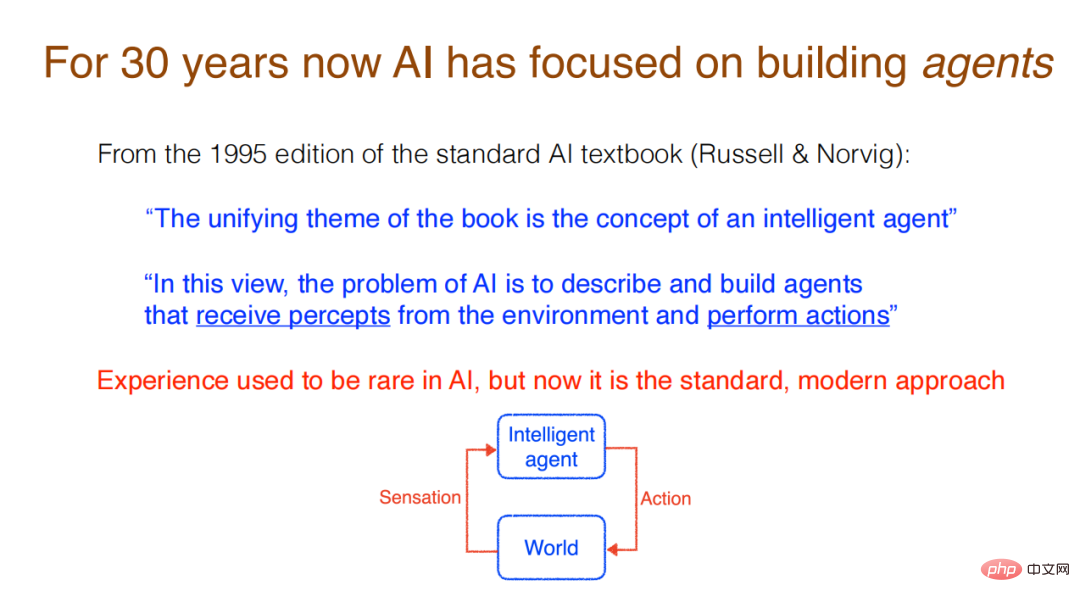

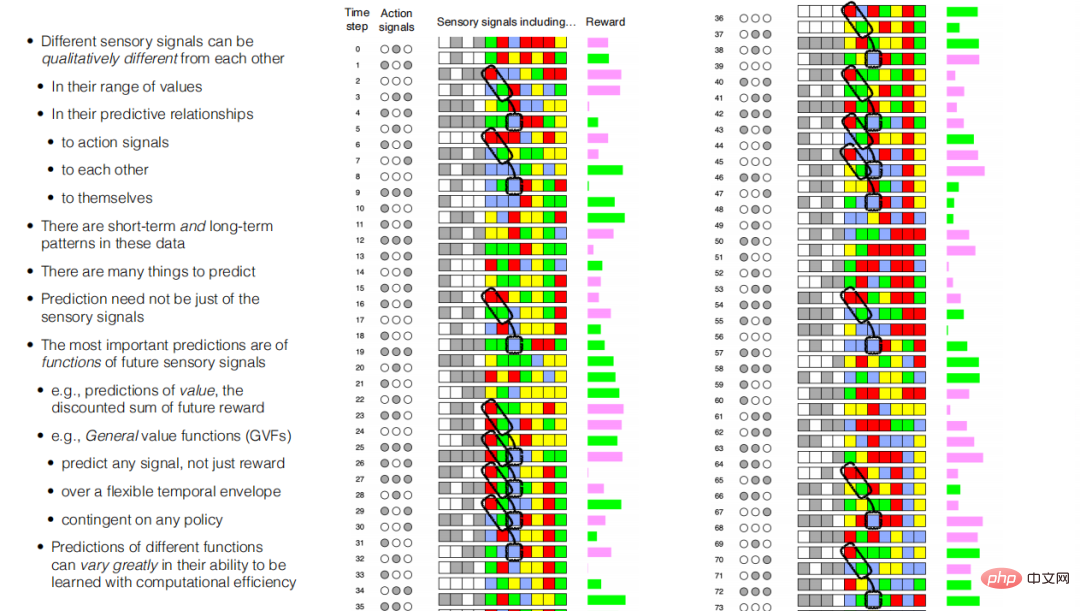

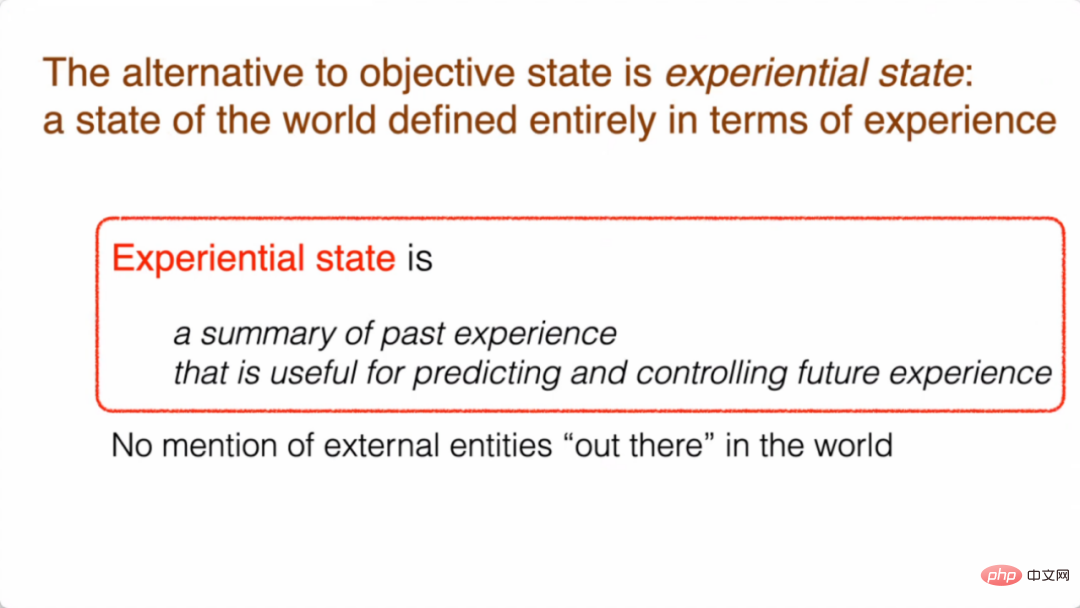

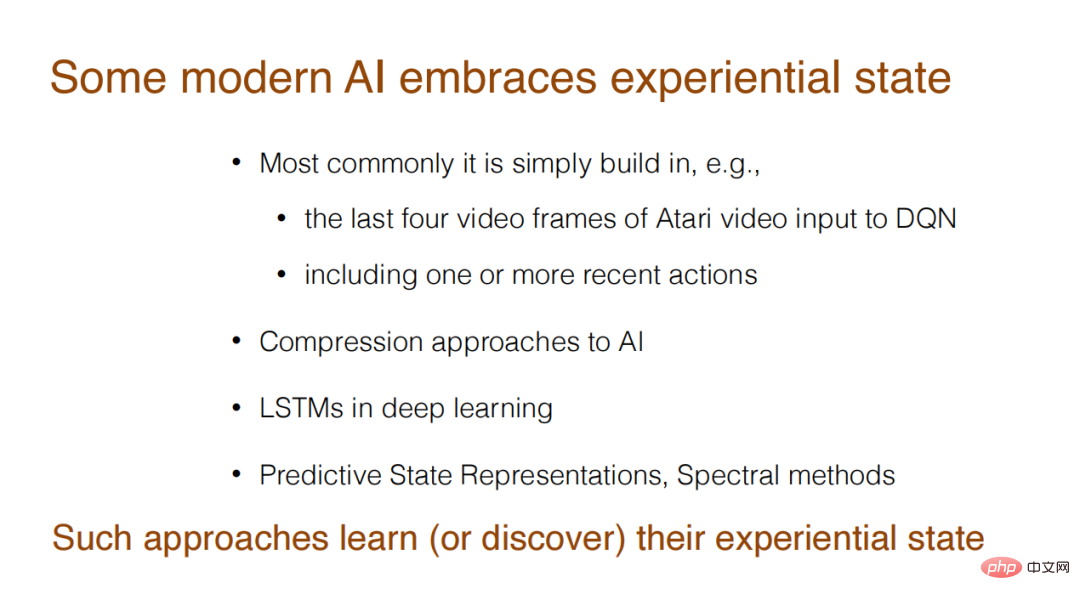

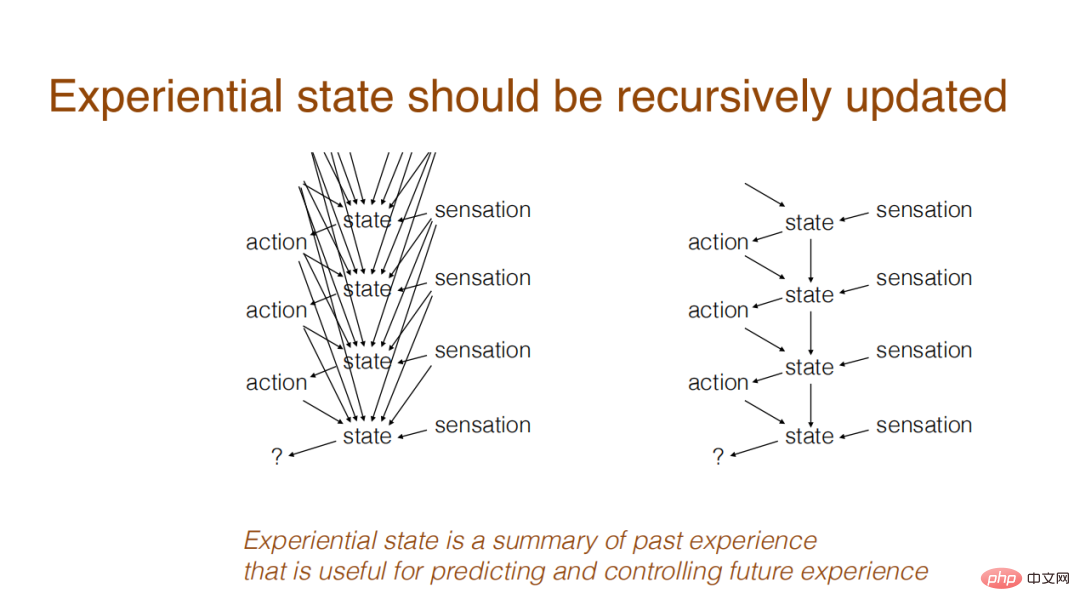

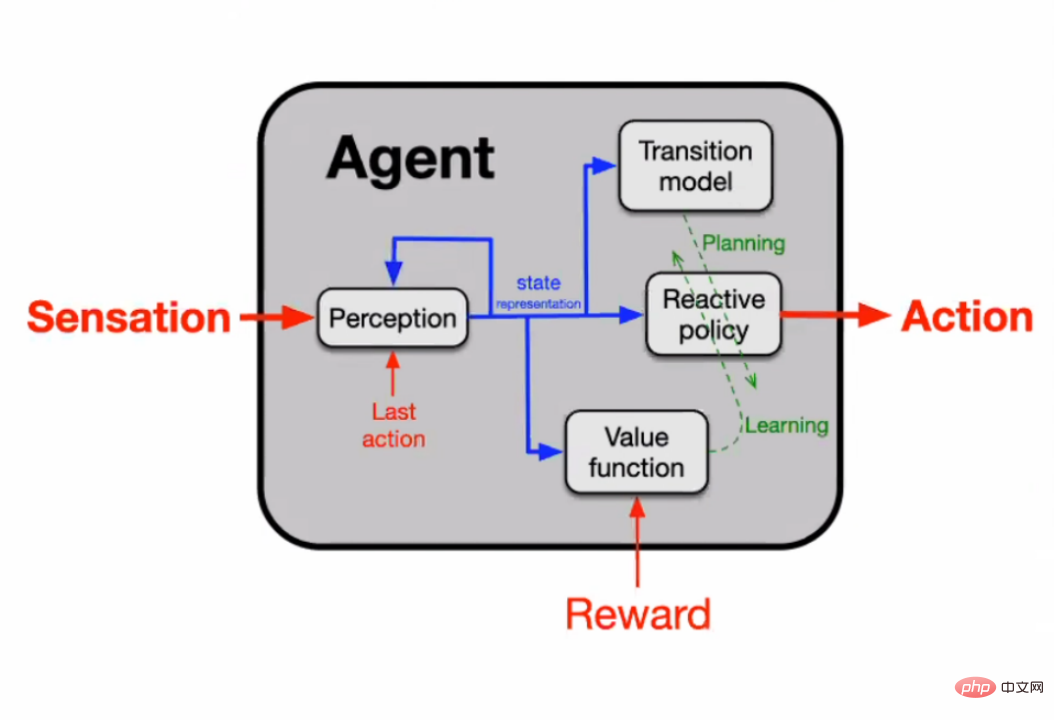

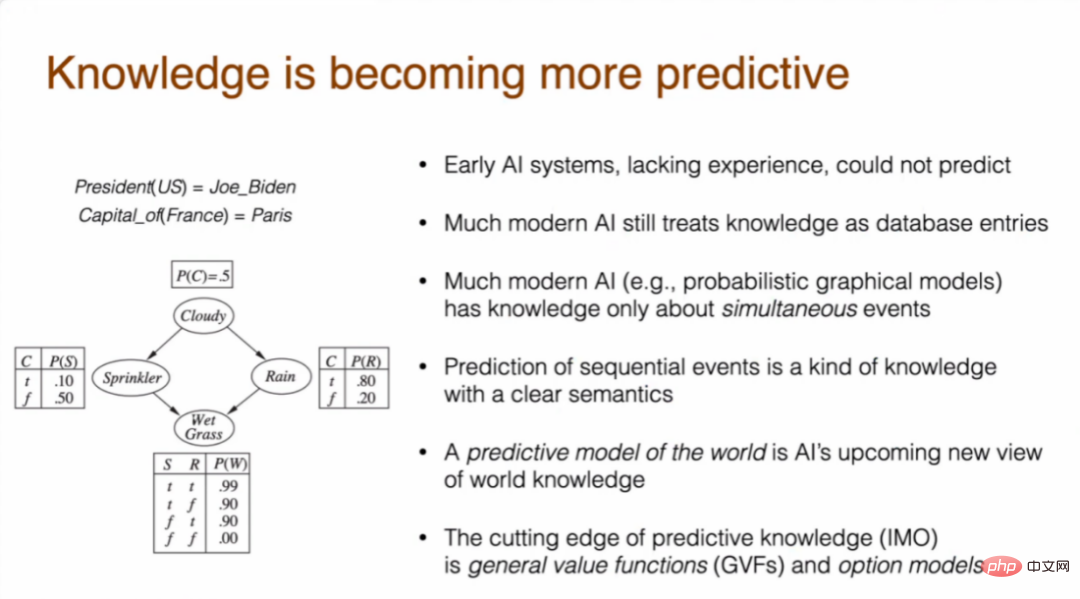

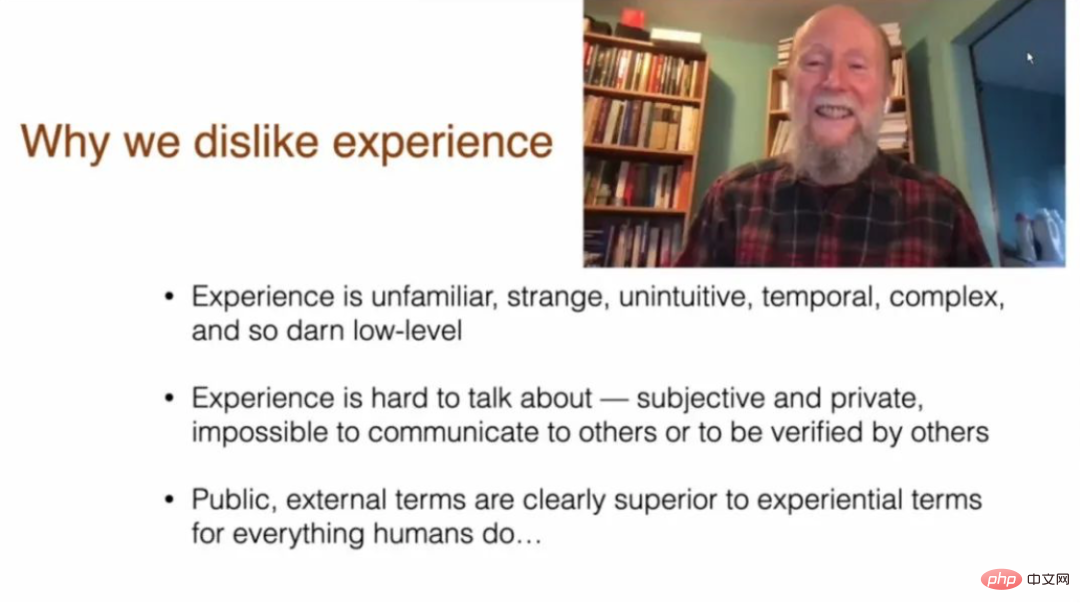

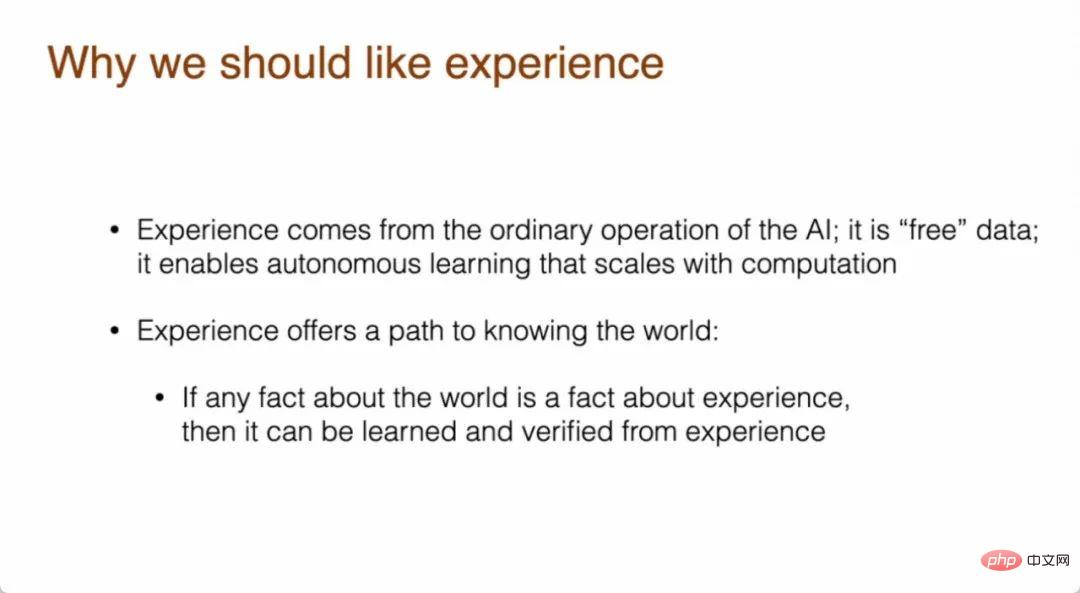

Wenn Sie den entsprechenden Zielzustand erreichen möchten, besteht die Lösung in einer Abfolge von Aktionen, um sicherzustellen, dass die KI vom Startzustand aus den Zielzustand erreichen kann. Dabei gibt es keine Wahrnehmung und kein Handeln, denn die gesamte Außenwelt ist bekannt, determiniert und abgeschlossen, es bedarf also keiner KI zum Wahrnehmen und Handeln. Forscher wissen, was passieren wird, also müssen sie nur einen Plan zur Lösung des Problems erstellen und den Menschen wissen lassen, dass dies das Problem lösen wird. In den letzten 30 Jahren der Entwicklung konzentrierte sich die Forschung im Bereich der künstlichen Intelligenz auf die Entwicklung intelligenter Agenten. Diese Verschiebung lässt sich daran erkennen, dass Standardlehrbücher zur künstlichen Intelligenz das Konzept des Agenten als Grundlage verwenden. In der Version von „Artificial Intelligence: A Modern Approach“ aus dem Jahr 1995 wurde beispielsweise erwähnt, dass das einheitliche Thema des gesamten Buches darin besteht, das Konzept des intelligenten Agenten einzuführen. Aus dieser Perspektive besteht das Problem der KI darin, intelligente Agenten zu beschreiben und zu konstruieren, Erkenntnisse aus der Umgebung zu gewinnen und Maßnahmen zu ergreifen. Während sich die Forschung weiterentwickelt, besteht der moderne Standardansatz darin, einen Agenten zu entwickeln, der mit der Außenwelt interagieren kann. Sutton glaubt, dass KI aus dieser Perspektive betrachtet werden kann. 2. Belohnung Belohnung gilt derzeit als relativ ausreichende Hypothese – Intelligenz und die damit verbundenen Fähigkeiten können als Ergebnis des Dienstes zur Maximierung von Belohnungen verstanden werden. Es heißt also, dass die Belohnung für den Agenten ausreicht. Sutton glaubt jedoch, dass diese Idee in Frage gestellt werden muss. Belohnungen reichen nicht aus, um Intelligenz zu erlangen. Die Belohnung ist nur eine Zahl, ein Skalar, was nicht ausreicht, um das Ziel der Intelligenz zu erklären. Ein Ziel, das von außerhalb des Geistes kommt und in einer einzigen Zahl ausgedrückt wird, erscheint zu klein, zu reduzierend, sogar zu erniedrigend. Menschen stellen sich gerne größere Ziele vor, wie zum Beispiel für ihre Familien zu sorgen, die Welt zu retten, den Weltfrieden zu schaffen und die Welt zu einem besseren Ort zu machen. Menschliche Ziele sind wichtiger als die Maximierung von Glück und Komfort. So wie Forscher herausfanden, dass Belohnungen kein guter Weg sind, um Ziele zu erreichen, entdeckten Forscher auch die Vorteile, Ziele durch Belohnungen zu erreichen. Belohnungen schaffen zu kleine Ziele, innerhalb derer die Menschen aber Fortschritte machen können – Ziele können gut, klar definiert und leicht zu erlernen sein. Dies ist eher eine Herausforderung für die Zielbildung durch Erfahrung. Sutton glaubt, dass es schwierig ist, sich vorzustellen, Ziele vollständig durch Erfahrung zu erreichen. Wenn wir auf die Geschichte zurückblicken, können wir erkennen, dass KI ursprünglich und auch heute noch nicht an Belohnungen interessiert war. Unabhängig davon, ob es sich um ein frühes Problemlösungssystem oder die neueste Version des aktuellen KI-Lehrbuchs handelt, wird das Ziel immer noch als der Weltzustand (Weltstaat) definiert, der erreicht werden muss, und nicht als empirisch (Definition). Ein solches Ziel kann immer noch ein spezifischer Satz von „Bausteinen“ sein und nicht ein wahrgenommenes Ergebnis, das erreicht werden soll. Natürlich gibt es in den neuesten Lehrbüchern bereits Kapitel, in denen das verstärkende Lernen erwähnt wird und erwähnt wird, dass diese KIs einen Belohnungsmechanismus verwenden. Darüber hinaus sind Belohnungen bereits eine gängige Praxis im Prozess der Zielbildung und können mithilfe von Markov-Entscheidungsprozessen erreicht werden. Für Forscher (wie Yann LeCun), die Belohnungen dafür kritisieren, dass sie Ziele nicht angemessen erreichen, sind Belohnungen bereits das Sahnehäubchen auf dem Intelligenzkuchen und sehr wichtig. In den nächsten beiden Phasen wird Sutton vorstellen, wie man die Außenwelt aus der Perspektive der Erfahrung versteht, aber vorher wird er zunächst vorstellen, worauf sich Erfahrung bezieht. In diesem Fall listete Sutton vier typische Muster auf: 1. Das letzte Stück der Aktion ist dasselbe wie das folgende Wahrnehmungssignal. Wenn die Aktion zu einem bestimmten Zeitpunkt weiß ist, ist das erste wahrgenommene Signal danach ebenfalls weiß, und das Gleiche gilt für Grau. 2. Wenn ein roter Pixel erscheint, ist der nächste Zeitschritt ein grüner Pixel. Nach der Erweiterung des Datenbereichs kann festgestellt werden, dass nach dem Erscheinen roter und grüner Pixel nacheinander in jedem zweiten Zeitschritt blaue Pixel erscheinen. 3. Die letzten drei Datenspalten erscheinen oft mit einer langen Liste derselben Farbe, die unverändert bleibt. Sobald eine Farbe beginnt, bleibt sie über mehrere Zeiträume bestehen und bildet schließlich Streifen. Zum Beispiel eine lange Reihe aus Rot, Grün, Blau usw. 4. Wenn die von der KI vorhergesagten spezifischen sensorischen Daten angezeigt werden, können sie oft nicht sofort beobachtet werden, daher wird diesen Daten ein Rückgabewert (Return) hinzugefügt, der angibt, dass das Paar kommen wird Vorhersage von Belohnungen. Der grüne Streifen in der Box zeigt an, dass die nachfolgende Belohnung eher grün als rot sein wird. Dies stellt die aktuelle Vorhersage der Belohnung dar. Der spezielle schattierte Bereich stellt die Wartefunktion dar. Im schattierten Bereich der Wartefunktion befinden sich grüne und rote Streifen. Dabei gewichten die Forscher frühere Renditen durch farbige Belohnungen stärker. Wenn Sie den Rückgabewert über die Zeit verschieben, können Sie die entsprechende Änderung in Farbe und Wert zwischen dem vorhergesagten Ergebnis und der tatsächlichen Belohnung sehen. Dieser Rückgabewert ist eine Vorhersage – er kann aus Erfahrung gelernt werden. Sutton glaubt, dass dieser Rückgabewert nicht unbedingt aus bereits eingetretenen Ereignissen gelernt wird, sondern aus dem Zeitdifferenzsignal. Das wichtigste Signal ist die Wertfunktion. In diesem Fall ist der Rückgabewert tatsächlich eine Wertfunktion, die die Summe zukünftiger Belohnungen darstellt. Wenn Sie eine allgemeine Form einer komplexen Funktion wünschen, die sich auf zukünftige Werte beziehen kann, können Sie eine Methode namens General Value Functions (GVFs) verwenden. Die allgemeine Wertfunktion umfasst verschiedene Signale, nicht nur Belohnungen; sie kann in jeder Zeithüllkurvenform vorliegen, nicht nur exponentiell. Die allgemeine Wertfunktion kann auch die Strategie jeder Warteschlange umfassen und eine sehr große Anzahl und ein breites Spektrum von Dingen vorhersagen. Sutton glaubt natürlich, dass die Schwierigkeit, Vorhersagen durch Berechnung zu treffen, von der Form des vorherzusagenden Objekts abhängt. Wenn eine allgemeine Wertfunktion zur Vorhersage verwendet wird, muss die Ausdrucksform des vorhergesagten Objekts in einer Form gestaltet werden, die leicht zu erlernen ist und eine hohe Recheneffizienz erfordert. Wenn es um das Wort „Staat“ geht, erwähnen viele Forscher den Weltzustand, der ein Wort unter dem objektiven Konzept ist. Staat bezieht sich auf eine symbolische Beschreibung (Reflexion) der objektiven Welt, die der Situation der Welt selbst entsprechen kann. Zum Beispiel für die Positionsinformation von Bausteinen (C liegt auf A) usw. In jüngster Zeit haben einige Forscher (wie Judea Pearl) probabilistische grafische Modelle vorgeschlagen, die die Wahrscheinlichkeitsverteilung von Weltstaaten darstellen. Einige Ereignisse, wie zum Beispiel „Es regnet draußen, ist das Gras nass?“, bestehen wahrscheinliche Beziehungen zwischen diesen Ereignissen. Ein weiterer Zustand ist der Glaubenszustand (Belief State). In diesem Konzept ist der Zustand eine Wahrscheinlichkeitsverteilung, die den Zustand der diskreten Welt und die entsprechende Methode darstellt, die als POMDPs bekannt ist ( Teilweise beobachtbare Markov-Entscheidungsprozesse) – es gibt versteckte Zustandsvariablen, von denen ein Teil beobachtbar ist und die mithilfe von Markov-Entscheidungsprozessen modelliert werden können. Die oben genannten Methoden sind allesamt objektive Zustände und weit von der Erfahrung entfernt. Es sind die Methoden, mit denen Forscher ursprünglich versucht haben, den Zustand der Welt zu beschreiben. Der Unterschied ist der Erfahrungsstand. Sutton glaubt, dass sich der empirische Zustand auf den Zustand der gesamten Welt bezieht, der auf der Grundlage von Erfahrungen definiert wird. Der Erfahrungszustand ist die Zusammenfassung vergangener Erfahrungen und kann die Erfahrungen vorhersagen und steuern, die in der Zukunft erzielt werden. Diese Methode, vergangene Erfahrungen zu konstruieren und die Zukunft vorherzusagen, findet ihren Niederschlag in der Forschung. Im Atari-Spiel beispielsweise, einer der Aufgaben des verstärkenden Lernens, werden Forscher die letzten vier Videobilder verwenden, um einen Erfahrungszustand zu konstruieren und dann nachfolgende Verhaltensweisen vorherzusagen. Man kann sich einige Methoden in LSTM-Netzwerken auch so vorstellen, dass sie Vorhersagen auf der Grundlage eines bestimmten empirischen Zustands treffen. Rückblickend auf den Erfahrungsstatus kann dieser rekursiv aktualisiert werden. Der Erfahrungszustand ist eine Funktion der Zusammenfassung dessen, was in der Vergangenheit passiert ist. Da die KI jeden Moment auf den Erfahrungszustand zugreifen muss, um das nächste Ereignis vorherzusagen, erfolgt die Aktualisierung des Erfahrungszustands rekursiv: nur der Erfahrungszustand des vorherigen Augenblicks Der Erlebnisstatus im letzten Moment ist eine Zusammenfassung aller Ereignisse, die in der Vergangenheit stattgefunden haben. Im nächsten Moment wird nur auf den Erfahrungszustand in diesem Moment zugegriffen, und dieser Erfahrungszustand ist auch eine Zusammenfassung aller Ereignisse, die in der Vergangenheit stattgefunden haben. Die folgende Abbildung zeigt den Konstruktionsprozess des Erfahrungsstatus des Agenten. Darunter zeigen die roten Pfeile die grundlegenden Arbeitssignale des Agenten an, darunter: Gefühl, Aktion, Belohnung usw. Der blaue Pfeil markiert die Richtung des Erfahrungszustands (Repräsentation), der von der Wahrnehmung ausgegeben wird und für die Aktualisierung ihres Erfahrungszustands bei jedem Zeitschritt verantwortlich ist. Der aktualisierte Status wird verwendet, um Maßnahmen zu planen oder andere Aktualisierungen vorzunehmen. Wissen wie „Joe Biden ist der Präsident der Vereinigten Staaten“, „Der Eiffelturm steht in Paris“ usw. sind alles, worum es geht die äußere objektive Welt Eine Beschreibung, die nicht empirisch ist. Wissen wie „Es wird erwartet, dass man X Stunden braucht, um etwas zu erledigen“ ist jedoch empirisches Wissen. Es gibt einen großen Unterschied zwischen empirischem Wissen und objektivem Wissen, was auch eine Herausforderung für die KI-Forschung darstellt. Frühere KI-Forschung neigte dazu, Wissen als objektiven Gegenstand zu behandeln, obwohl einige neuere Forschungen das Problem aus einer empirischen Perspektive betrachteten. Frühe KI-Systeme hatten keine Erfahrung und konnten daher keine Vorhersagen treffen. Modernere KI behandelt Wissen als eine objektive Existenz. Das fortgeschrittenere Modell ist das probabilistische grafische Modell, aber in vielen Fällen untersucht es die Wahrscheinlichkeit zwischen zwei Dingen, die gleichzeitig passieren, und die Vorhersage sollte sich an einer Reihe von Sequenzereignissen orientieren. Vorhersage basierend auf Sequenzereignissen ist Wissen mit klaren semantischen Eigenschaften. Wenn vorhergesagt wird, dass etwas passiert, kann die KI die Vorhersage mit dem tatsächlichen Ergebnis vergleichen. Diese Art von Vorhersagemodell kann als eine neue Art von Weltwissen betrachtet werden, nämlich als Vorhersagewissen. Unter den prädiktiven Erkenntnissen sind nach Ansicht von Sutton die Allgemeine Wertfunktion und das Optionsmodell die modernsten. Sutton unterteilt das Weltwissen in zwei Kategorien: Die eine ist das Wissen über den Weltzustand und die andere das Wissen über den Weltzustandsübergang. Ein Beispiel für Wissen über Weltzustandsübergänge ist ein Weltvorhersagemodell. Das Weltvorhersagemodell ist hier keine primäre Form des Markov-Entscheidungsprozesses oder der Differenzgleichung. Es kann ein abstrakter Zustand sein, der aus dem empirischen Zustand extrahiert werden kann. Da die Vorhersage auf dem gesamten Verhalten basiert, kann der Agent im Auswahlmodell auch entscheiden, eine bestimmte Strategie zu stoppen und eine bestimmte Bedingung zu beenden. Manchmal ist es mithilfe eines Melodieübertragungsmodells möglich, den Zustand nach der Ausführung einer Aktion vorherzusagen. Am Beispiel des täglichen Lebens: Angenommen, jemand möchte in die Stadt gehen, wird er/sie eine Vorhersage über die Entfernung und die Zeit bis zum Stadtzentrum treffen. Für Verhaltensweisen, die einen bestimmten Schwellenwert überschreiten (z. B. 10 Minuten zu Fuß in die Stadt gehen). ), werden weitere Vorhersagen getroffen, z. B. Müdigkeit usw. Mit diesem Modell, das Verhalten erweitern kann, kann auch der Umfang des dargestellten Wissens sehr groß sein. Sie können beispielsweise den Zustand der Welt anhand eines Verhaltens vorhersagen und dann das nächste Verhalten anhand des Zustands vorhersagen ... und so weiter. Den Entwicklungsprozess der Erfahrung in der KI-Forschung zusammenfassend sagte Sutton, dass Erfahrung die Grundlage des Weltwissens ist. Menschen verstehen und beeinflussen die Welt durch Wahrnehmung und Handeln . Informationen, die einzige Möglichkeit, Maßnahmen zu ergreifen, und etwas, ohne das Menschen nicht leben können. Da Erfahrung zu subjektiv und persönlich ist, denken und äußern Menschen leider immer noch nicht gern in Erfahrungsbegriffen. Erfahrung ist für den Menschen zu fremd, kontraintuitiv, flüchtig und komplex. Auch Erfahrungen sind subjektiv und privat und es ist nahezu unmöglich, mit anderen zu kommunizieren oder sie zu überprüfen. Sutton glaubt, dass Erfahrung aus folgenden Gründen für KI sehr wichtig ist. Erstens stammen Erfahrungen aus dem täglichen Betriebsprozess der KI, und der Erwerb dieser Erfahrungen erfolgt kostenlos und automatisch. Gleichzeitig werden im Bereich der KI große Datenmengen für Berechnungen verwendet, sodass Erfahrung einen Weg zum Verständnis der Welt bietet. Wenn eine Tatsache auf der Welt empirisch ist, kann die KI ihr Verständnis der Welt aus Erfahrung und Erfahrung erlernen auf Erfahrungen aufbauen, um dies zu überprüfen. Zusammenfassend glaubt Sutton, dass die Entwicklungsgeschichte der KI in der Vergangenheit liegt 70 Jahre, KI legt nach und nach Wert auf Erfahrung – Erfahrung sammeln, Ziele auf der Grundlage von Erfahrung setzen und Status und Wissen auf der Grundlage von Erfahrung erlangen. Auf jeder Stufe wird empirische Forschung, die dem Menschen unbekannter ist, immer wichtiger und hat den Vorteil, fundiert, erlernbar und skalierbar zu sein. # 🎜 🎜# 03. Wie KI in Zukunft Erfahrungen nutzen wird02. Die Geschichte der Erfahrung in der Entwicklung von KI

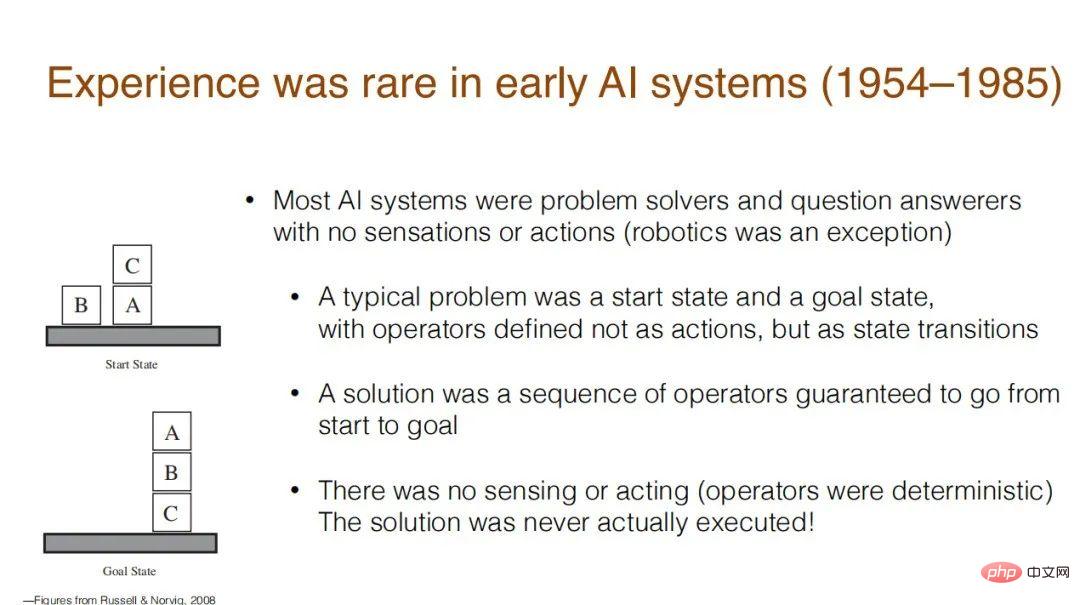

1. Agententum bedeutet Erfahrung (KI) zu haben/zu erwerben. Es überrascht vielleicht, dass die frühen KI-Systeme überhaupt keine Erfahrung hatten. In den frühen Stadien der Entwicklung der künstlichen Intelligenz (1954–1985) wurden die meisten KI-Systeme nur zur Lösung von Problemen oder zur Beantwortung von Fragen eingesetzt. Sie hatten keine Wahrnehmung und konnten nicht handeln. Eine Ausnahme bilden Roboter, aber herkömmliche Systeme haben nur einen Startzustand und einen Zielzustand, wie die gestapelten Bausteine im Bild unten.

Belohnung beschreibt das Ziel der KI in Form von Erfahrung. Dies ist auch eine wirksame Methode, die derzeit vorgeschlagen wird, um alle Ziele der KI zu erreichen. Dies ist auch die von Sutton und seinen Mitarbeitern vorgeschlagene Methode.

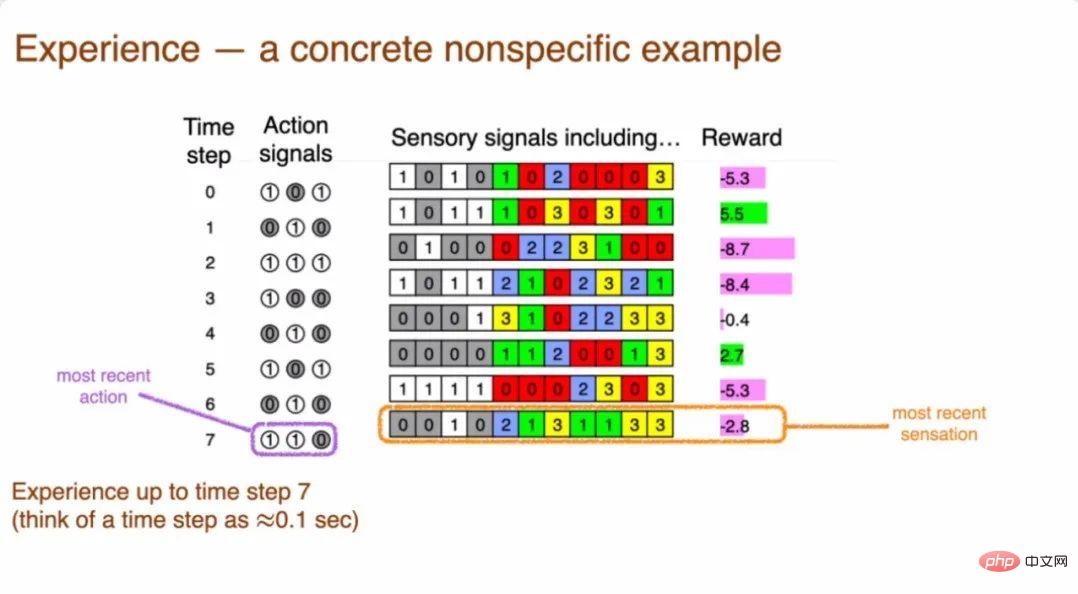

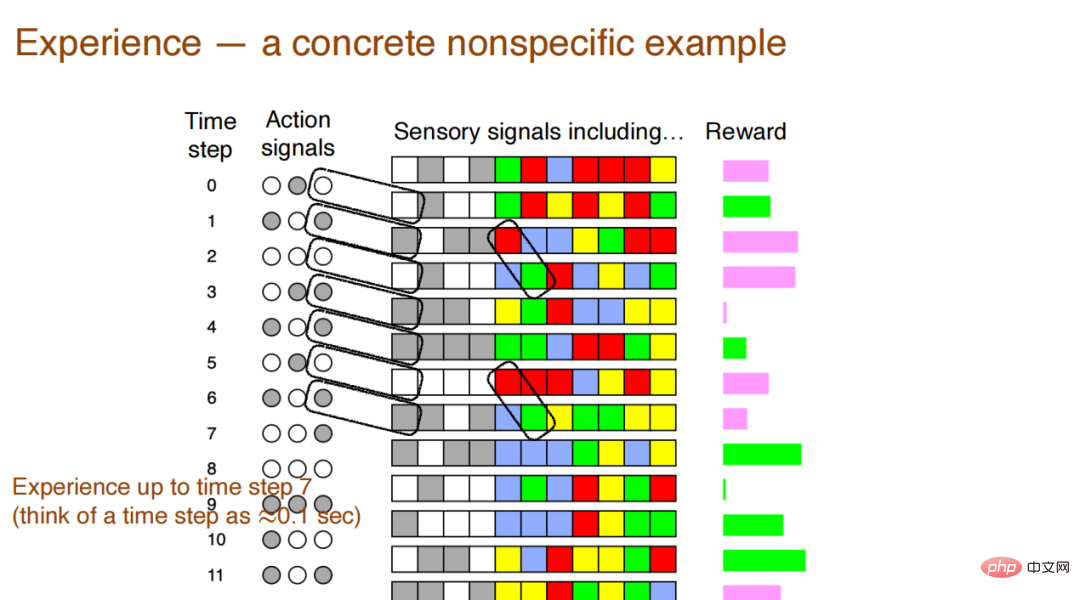

3. Zwischenspiel: Was ist Erfahrung? Wie in der Sequenz (nicht reale Daten) in der folgenden Abbildung gezeigt, wird das System zu Beginn des Zeitschritts empfangen das Wahrnehmungssignal sowie Signale und Aktionen werden ebenfalls angegeben. Ein wahrgenommenes Signal kann also einige Aktionen auslösen, und diese Aktionen können das nächste wahrgenommene Signal auslösen. Das System muss jederzeit auf aktuelle Aktionen und aktuelle Signale achten, damit es entscheiden kann, was als nächstes passieren wird und wie es zu tun ist.

4. Erfahrungszustand

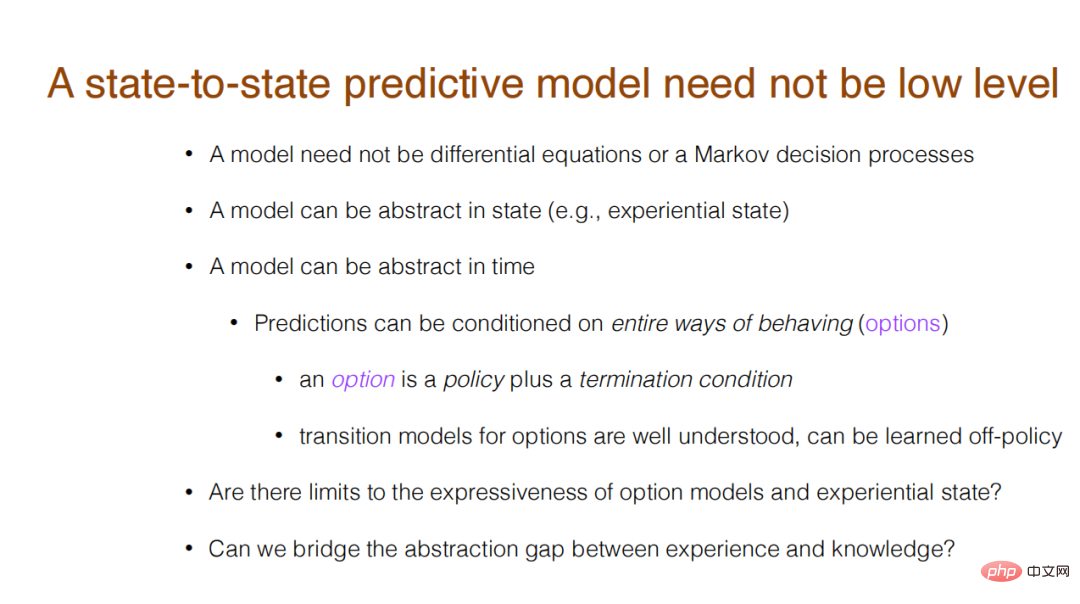

5. Prädiktives Wissen

Sutton glaubt, dass die KI derzeit die dritte Stufe von noch nicht abgeschlossen hat Viertens: Dieser Trend wird immer weiter voranschreiten. Sutton glaubt, dass es ein gangbarer Weg zu echter KI ist, alles der Erfahrung zuzuschreiben. Auch wenn dies sehr anspruchsvoll ist, ist dies die Aufgabe, Datenflüsse zu verstehen und Intelligenz zu erlangen. Schließlich verdichtete Sutton die vier Phasen der Fokussierung auf sensomotorische Erfahrungen weiter und formulierte einen Slogan:

Sutton glaubt, dass die KI derzeit die dritte Stufe von noch nicht abgeschlossen hat Viertens: Dieser Trend wird immer weiter voranschreiten. Sutton glaubt, dass es ein gangbarer Weg zu echter KI ist, alles der Erfahrung zuzuschreiben. Auch wenn dies sehr anspruchsvoll ist, ist dies die Aufgabe, Datenflüsse zu verstehen und Intelligenz zu erlangen. Schließlich verdichtete Sutton die vier Phasen der Fokussierung auf sensomotorische Erfahrungen weiter und formulierte einen Slogan: „Daten treiben künstliche Intelligenz an, und Erfahrung sind die ultimativen Daten. Wenn durch Machen.“ Durch die gute Nutzung der Erfahrung können wir die Entwicklung künstlicher Intelligenz schneller und effektiver vorantreiben.

Das obige ist der detaillierte Inhalt vonRichard Sutton: Erfahrung sind die ultimativen Daten der KI, vier Stufen, die zur Entwicklung echter KI führen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Selbst unerfahrene Entwickler können schnell mit der Entwicklung von Anwendungen beginnen. Microsoft hat angekündigt, dass AI Builder Azure OpenAI GPT integrieren wird.

- China Telecom veranstaltete das 3. IoT-Seminar des Wissenschafts- und Technologiefestivals, um gemeinsam ein neues Ökosystem von IoT-Terminal-Betriebssystemen aufzubauen

- Upgrade der Google AI-Funktion: Benutzer können Bilder direkt über Textaufforderungen generieren

- Call for Papers |. CVPR 2024 Workshop |. Der erste virtuelle Mensch für Robotik und autonomes Fahren

- Ich habe ChatGPT zugunsten dieser überlegenen Alternative aufgegeben: 3 Gründe dafür