Heim >Technologie-Peripheriegeräte >KI >Nutzen Sie die Kraft des Universums, um Daten zu verarbeiten! „Physische Netze' übertreffen tiefe neuronale Netze bei weitem

Nutzen Sie die Kraft des Universums, um Daten zu verarbeiten! „Physische Netze' übertreffen tiefe neuronale Netze bei weitem

- PHPznach vorne

- 2023-04-09 09:01:111293Durchsuche

Dieser Artikel wurde von Lei Feng.com reproduziert. Wenn Sie einen Nachdruck benötigen, besuchen Sie bitte die offizielle Website von Lei Feng.com, um eine Genehmigung zu beantragen.

In einer schallisolierten Kiste liegt eines der schlimmsten neuronalen Netze der Welt. Nachdem das neuronale Netzwerk ein Bild der Zahl 6 gesehen hat, hält es einen Moment inne und zeigt dann die erkannte Zahl an: 0.

Peter McMahon, ein Physiker und Ingenieur an der Cornell University, der die Entwicklung dieses neuronalen Netzwerks leitete, sagte mit einem verlegenen Lächeln, dass das daran lag, dass die handgeschriebenen Zahlen so schlampig aussahen. Logan Wright, ein Postdoktorand vom NTT Institute, der McMahons Labor besucht, sagte, das Gerät gebe normalerweise die richtige Antwort, räumte jedoch ein, dass Fehler häufig seien. Trotz seiner mittelmäßigen Leistung war dieses neuronale Netzwerk eine bahnbrechende Forschung. Die Forscher drehten die Kiste um und enthüllten keinen Computerchip, sondern ein Mikrofon, das in Richtung einer am Lautsprecher befestigten Titanplatte geneigt war.

Im Gegensatz zu neuronalen Netzen, die in der digitalen Welt der Nullen und Einsen arbeiten, arbeitet dieses Gerät nach dem Prinzip des Klangs. Als Wright ein Bild mit einer Zahl vorgelegt wurde, wurden die Pixel des Bildes in Audio umgewandelt und ein Lautsprecher versetzte die Titanplatte in Schwingungen, wodurch das Labor mit einem schwachen zwitschernden Geräusch erfüllt wurde. Mit anderen Worten: Es ist das Metallecho, das den „Lesevorgang“ durchführt, nicht die Software, die auf dem Siliziumchip läuft.

Der Erfolg dieses Geräts ist unglaublich, selbst für seine Designer. „Was auch immer die Rolle des vibrierenden Metalls ist, es sollte nichts mit der Klassifizierung handgeschriebener Ziffern zu tun haben“, sagte McMahon. Im Januar dieses Jahres veröffentlichte das Forschungsteam der Cornell University in der Zeitschrift Nature einen Artikel mit dem Titel „It is „Deep“. physikalische neuronale Netze, trainiert mit Backpropagation“.

Die Einführung des Artikels in die Rohlesefähigkeiten des Geräts gibt McMahon und anderen Hoffnung, dass das Gerät mit vielen Verbesserungen die Datenverarbeitung revolutionieren könnte.

Link zum Papier: https://www.nature.com/articles/s41586-021-04223-6In Bezug auf traditionelles maschinelles Lernen haben Informatiker herausgefunden, dass die Neuronen umso größer sind Netzwerk, desto besser. Aus genauen Gründen lesen Sie bitte den Artikel im Bild unten. Dieser Artikel mit dem Titel „Informatiker beweisen, warum größere neuronale Netze besser sind“ beweist: Wenn Sie möchten, dass das Netzwerk zuverlässig ist und seine Trainingsdaten berücksichtigt, ist eine Überparametrisierung nicht nur gültig , muss aber durchgesetzt werden.

Artikeladresse: https://www.quantamagazine.org/computer-scientists-prove-why-bigger-neural-networks-do-better-20220210/Füllen Sie weitere Informationen in ein Neuronal ein Netzwerk Mehr künstliche Neuronen (Knoten, die Werte speichern) könnten seine Fähigkeit, den Unterschied zwischen einem Dackel und einem Dalmatiner zu erkennen, verbessern und es ihm ermöglichen, unzählige andere Mustererkennungsaufgaben erfolgreich abzuschließen.

Wirklich große neuronale Netze können das Schreiben von Arbeiten (wie GPT-3 von OpenAI), das Zeichnen von Illustrationen (wie DALL·E, DALL·E2 von OpenAI und Imagen von Google) und mehr erledigen, über die man nur schwer nachdenken kann . Mit mehr Rechenleistung werden größere Leistungen möglich. Diese Möglichkeit fördert Bemühungen zur Entwicklung leistungsfähigerer und effizienterer Rechenmethoden. McMahon und eine Gruppe gleichgesinnter Physiker verfolgen einen unkonventionellen Ansatz: Lassen Sie das Universum die Daten für uns verarbeiten.

McMahon sagte: „Viele physikalische Systeme sind von Natur aus in der Lage, bestimmte Berechnungen effizienter oder schneller durchzuführen als Computer. Er nannte das Beispiel eines Windkanals: Wenn Ingenieure ein Flugzeug entwerfen, digitalisieren sie möglicherweise die Baupläne und verbringen dann Stunden damit.“ ein Supercomputer, der die Luftströmung um einen Flugzeugflügel simuliert. Alternativ könnten sie das Flugzeug in einen Windkanal stellen, um zu sehen, ob es fliegen kann. Aus rechnerischer Sicht können Windkanäle die Wechselwirkung eines Flugzeugflügels mit der Luft sofort „berechnen“.

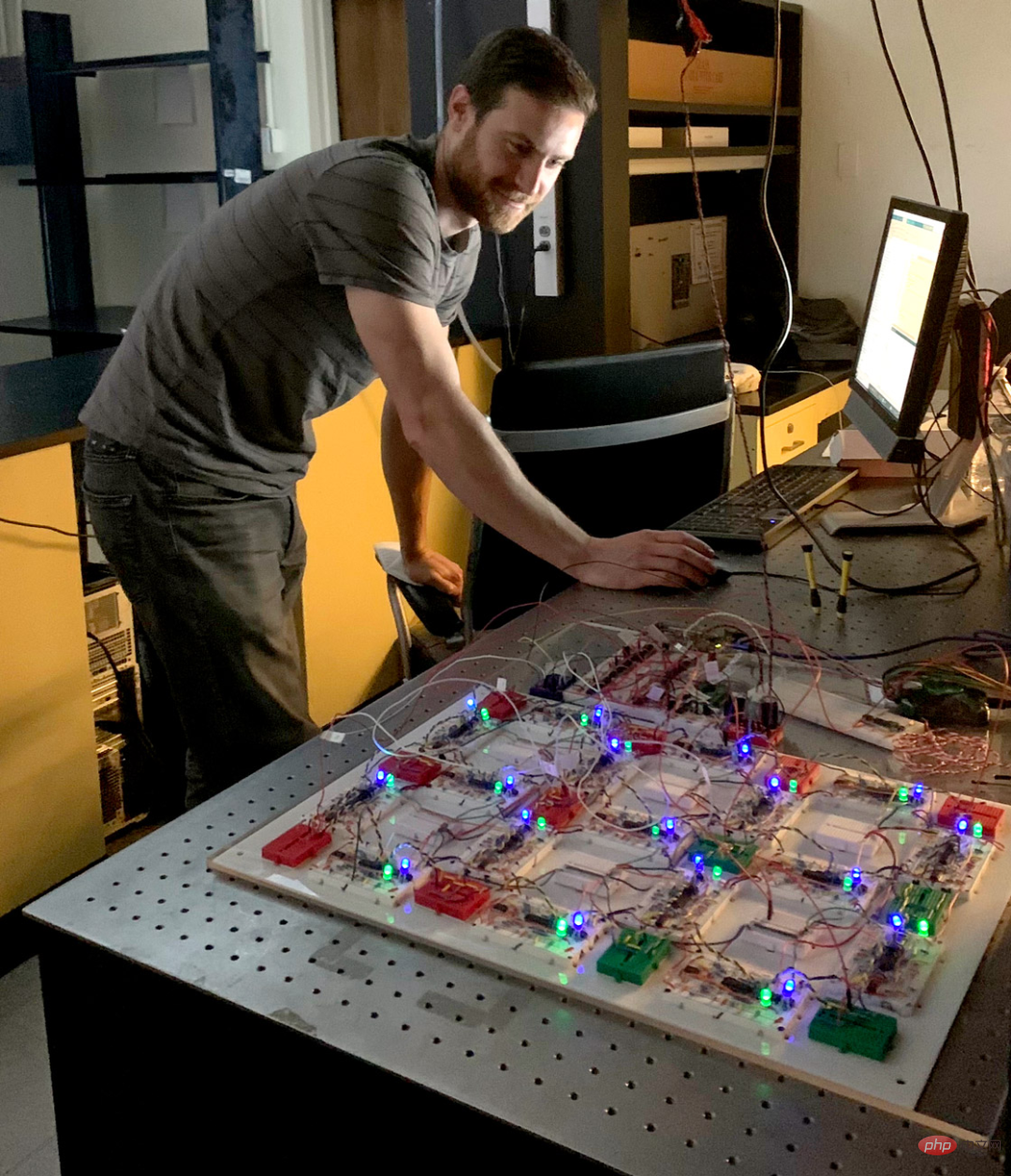

Bildunterschrift: Die Teammitglieder der Cornell University, Peter McMahon und Tatsuhiro Onodera, schreiben Programme für verschiedene physische Systeme, um Lernaufgaben zu erledigen.

Fotoquelle: Dave BurbankDer Windkanal kann Aerodynamik simulieren und ist eine Maschine mit einer bestimmten Funktion.

Forscher wie McMahon arbeiten an einem Gerät, das alles lernen kann – ein System, das sein Verhalten durch Versuch und Irrtum anpassen kann, um sich neue Fähigkeiten anzueignen, etwa das Klassifizieren handgeschriebener Ziffern oder das Unterscheiden zwischen einem Vokal und einem anderen Vokal und andere Fähigkeiten.

Die neuesten Forschungsergebnisse zeigen, dass physikalische Systeme wie Lichtwellen, Supraleiternetzwerke und Elektronenverzweigungsströme alle erlernt werden können. „Wir erfinden nicht nur die Hardware neu, wir erfinden das gesamte Computerparadigma neu“, sagt Benjamin Scellier, Mathematiker an der ETH Zürich in der Schweiz, der an der Entwicklung eines neuen Physik-Lernalgorithmus beteiligt war.

1 Denken lernen

Lernen ist ein äußerst einzigartiger Prozess. Vor zehn Jahren war das Gehirn das einzige System, das lernen konnte. Es ist die Struktur des Gehirns, die Informatiker zum Teil dazu inspiriert hat, tiefe neuronale Netze zu entwerfen, das derzeit beliebteste Modell für künstliches Lernen. Ein tiefes neuronales Netzwerk ist ein Computerprogramm, das durch Übung lernt.

Ein tiefes neuronales Netzwerk kann als Gitter betrachtet werden: Die zum Speichern von Werten verwendeten Knotenschichten werden Neuronen genannt, und Neuronen sind über Linien mit Neuronen in benachbarten Schichten verbunden, die auch „Synapsen“ genannt werden. Ursprünglich handelt es sich bei diesen Synapsen lediglich um Zufallszahlen, die „Gewichte“ genannt werden. Wenn Sie möchten, dass das Netzwerk 4 liest, können Sie die erste Neuronenschicht das Originalbild von 4 darstellen lassen und den Schatten jedes Pixels als Wert im entsprechenden Neuron speichern.

Dann „denkt“ das Netzwerk, bewegt sich Schicht für Schicht und füllt die nächste Neuronenschicht mit Neuronenwerten multipliziert mit synaptischen Gewichten. Das Neuron mit dem größten Wert in der letzten Schicht ist die Antwort des neuronalen Netzwerks. Wenn es sich beispielsweise um das zweite Neuron handelt, geht das Netzwerk davon aus, dass es 2 gesehen hat. Um dem Netzwerk beizubringen, intelligentere Schätzungen anzustellen, arbeitet der Lernalgorithmus umgekehrt. Nach jedem Versuch wird die Differenz zwischen der Vermutung und der richtigen Antwort berechnet (in unserem Fall wird diese Differenz durch einen hohen Wert im vierten Neuron der letzten Schicht und einen niedrigen Wert an anderer Stelle dargestellt).

Der Algorithmus arbeitet sich dann Schicht für Schicht durch das Netzwerk zurück und berechnet, wie die Gewichte angepasst werden müssen, damit der Wert des endgültigen Neurons je nach Bedarf steigt oder fällt. Dieser Prozess wird Backpropagation genannt und ist der Kern des Deep Learning. Durch wiederholtes Erraten und Anpassen leitet die Backpropagation die Gewichte auf eine Reihe von Zahlen, die über eine von einem Bild initiierte Kaskade von Multiplikationen ausgegeben werden.

Quelle: Quanta Magazine Merrill ShermanAber im Vergleich zum Denken des Gehirns scheint digitales Lernen in künstlichen neuronalen Netzen sehr ineffizient zu sein. Mit weniger als 2.000 Kalorien pro Tag kann ein menschliches Kind in nur wenigen Jahren sprechen, lesen, Spiele spielen und mehr lernen. Unter solchen begrenzten Energiebedingungen kann es tausend Jahre dauern, bis das neuronale GPT-3-Netzwerk, das in der Lage ist, sich fließend zu unterhalten, das Chatten lernt.

Aus Sicht eines Physikers versucht ein großes digitales neuronales Netzwerk einfach zu viel zu rechnen. Die größten neuronalen Netze von heute müssen mehr als 500 Milliarden Zahlen aufzeichnen und manipulieren. Diese erstaunliche Zahl stammt aus dem unten abgebildeten Papier „Pathways Language Model (PaLM): Scaling to 540 Billion Parameters for Breakthrough Performance)“:

Link zum Papier: https://ai.googleblog.com/2022 /04/pathways-lingual-model-palm-scaling-to.htmlGleichzeitig liegen die allgegenwärtigen Aufgaben des Universums weit außerhalb der Grenzen der mageren Rechenleistung eines Computers. In einem Raum können Billionen von Luftmolekülen herumschwirren.

Für eine vollwertige Kollisionssimulation ist dies die Anzahl der sich bewegenden Objekte, die der Computer nicht im Auge behalten kann, die Luft selbst jedoch in jedem Moment problemlos ihr eigenes Verhalten bestimmt. Unsere aktuelle Herausforderung besteht darin, ein physikalisches System aufzubauen, das die beiden für die künstliche Intelligenz erforderlichen Prozesse auf natürliche Weise abschließen kann – das „Denken“, das zur Klassifizierung von Bildern erforderlich ist, und das „Denken“, das zur korrekten Klassifizierung solcher Bilder erforderlich ist.

Ein System, das diese beiden Aufgaben beherrscht, nutzt tatsächlich die mathematische Kraft des Universums und führt nicht nur mathematische Berechnungen durch. „Wir haben nie so etwas wie 3,532 mal 1,567 berechnet“, sagte Scellier. „Das System berechnet, aber implizit, indem es den Gesetzen der Physik folgt.“

2 Denkteil

McMahon und Co-Wissenschaftler haben Fortschritte beim „Denk“-Teil des Puzzles gemacht. In den Monaten vor der COVID-19-Pandemie richtete McMahon sein Labor an der Cornell University ein und grübelte über eine seltsame Entdeckung. Im Laufe der Jahre sind die leistungsstärksten neuronalen Netze für die Bilderkennung immer tiefer geworden. Das heißt, ein Netzwerk mit mehr Ebenen ist besser darin, eine Reihe von Pixeln zu nehmen und ihnen eine Bezeichnung wie „Pudel“ zu geben.

Dieser Trend inspirierte Mathematiker, die Transformation neuronaler Netze (von Pixeln zu „Pudeln“) zu untersuchen. Im Jahr 2017 veröffentlichten mehrere Gruppen einen Artikel mit dem Titel „Residual Neural Networks“. dass das Verhalten eines neuronalen Netzwerks eine ungefähre Version einer glatten mathematischen Funktion ist.

Papieradresse: https://arxiv.org/abs/1709.03698In der Mathematik wandelt eine Funktion eine Eingabe (normalerweise einen x-Wert) in eine Ausgabe (den y-Wert der) um Kurve an dieser Stelle oder hoch). In bestimmten Arten von neuronalen Netzen funktionieren mehr Schichten besser, da die Funktion weniger gezackt ist und näher an einer idealen Kurve liegt. Die Forschung brachte McMahon zum Nachdenken.

Vielleicht kann man mit einem sich reibungslos verändernden physischen System die Blockade digitaler Methoden umgehen. Der Trick besteht darin, einen Weg zu finden, ein komplexes System zu zähmen – indem man sein Verhalten durch Training anpasst. McMahon und seine Mitarbeiter entschieden sich für Titanplatten für ein solches System, weil ihre vielen Vibrationsmodi eingehende Geräusche auf komplexe Weise mischen.

Damit die Platte wie ein neuronales Netzwerk funktioniert, haben sie einen Ton eingespeist, der das Eingabebild kodierte (z. B. eine handgeschriebene 6) und einen weiteren Ton, der die synaptischen Gewichte darstellte. Die Schallspitzen und -täler müssen zum richtigen Zeitpunkt auf die Titanplatte treffen, damit das Gerät die Töne kombinieren und eine Antwort geben kann – zum Beispiel stellt ein neuer Ton, der innerhalb von sechs Millisekunden am lautesten ist, eine Klassifizierung von „6“ dar.

Bildunterschrift: Ein Forschungsteam der Cornell University trainierte drei verschiedene physikalische Systeme, um handgeschriebene Zahlen zu „lesen“: von links nach rechts eine vibrierende Titanplatte, einen Kristall und einen elektronischen Schaltkreis. Quelle: Das linke Bild und das mittlere Bild wurden von Rob Kurcoba von der Cornell University aufgenommen; das rechte Bild wurde von Charlie Wood vom Quanta Magazine aufgenommen. Das Team implementierte sein Schema auch in einem optischen System – bei dem das Eingabebild und die Gewichte in zwei von einem Kristall gemischten Strahlen kodiert werden – und in einer elektronischen Schaltung, die die Eingabe auf ähnliche Weise umwandeln kann.

Im Prinzip könnte dies jedes System mit byzantinischem Verhalten tun, aber die Forscher glauben, dass optische Systeme besonders vielversprechend sind. Kristalle mischen Licht nicht nur extrem schnell, sondern Licht enthält auch umfangreiche Daten über die Welt. McMahon stellt sich vor, dass Miniaturversionen seiner optischen neuronalen Netze eines Tages als Augen selbstfahrender Autos dienen werden, Stoppschilder und Fußgänger erkennen und die Informationen dann in die Computerchips des Autos einspeisen können, ähnlich wie unsere Netzhäute grundlegende Sehfunktionen erfüllen Eingehendes Licht wird gleich behandelt.

Die Achillesferse dieser Systeme besteht jedoch darin, dass ihre Schulung eine Rückkehr in die digitale Welt erfordert. Bei der Rückausbreitung wird ein neuronales Netzwerk umgekehrt betrieben, aber Filme und Kristalle können Ton und Licht nicht einfach auflösen. Daher erstellte das Team ein digitales Modell jedes physischen Systems. Indem sie diese Modelle auf einem Laptop invertieren, können sie mithilfe des Backpropagation-Algorithmus berechnen, wie die Gewichte angepasst werden müssen, um genaue Antworten zu erhalten.

Durch dieses Training lernte diese Titanplatte, handschriftliche Zahlen mit einer Genauigkeit von 87 % zu klassifizieren. Die Genauigkeit der Schaltung und des Lasers im Bild oben erreicht 93 % bzw. 97 %. Die Ergebnisse zeigen, dass „nicht nur normale neuronale Netze durch Backpropagation trainiert werden können“, sagt die Physikerin Julie Grollier vom französischen Zentrum für wissenschaftliche Forschung (CNRS). Das Board macht Computer noch nicht annähernd so effizient wie das Gehirn und das Gerät erreicht nicht einmal annähernd die Geschwindigkeit digitaler neuronaler Netze. Aber McMahon findet sein Gerät erstaunlich, weil es beweist, dass Menschen mit mehr als nur ihrem Gehirn oder Computerchips denken können. „Jedes physische System kann ein neuronales Netzwerk sein.“

Er sagte.3 Lernteil

Ein weiteres schwieriges Problem ist – wie man ein System dazu bringt, völlig autonom zu lernen. Florian Marquardt, Physiker am Max-Planck-Institut für Lichtwissenschaften in Deutschland, glaubt, dass eine Möglichkeit darin besteht, eine Maschine zu bauen, die rückwärts läuft. Letztes Jahr schlugen er und ein Mitarbeiter in der Physiksimulation „Self-learning Machines based on Hamiltonian Echo Backpropagation“ einen Backpropagation-Algorithmus vor, der auf einem solchen System ausgeführt werden kann.

Papieradresse: https://arxiv.org/abs/2103.04992

Papieradresse: https://arxiv.org/abs/2103.04992

Um zu beweisen, dass dies machbar ist, haben sie mithilfe digitaler Technologie ein Lasergerät simuliert, das dem McMahon-Gerät ähnelt, das es sein wird Das Gewicht des Tons wird in einer Lichtwelle kodiert und mit einer anderen Eingangswelle gemischt (Kodierung, z. B. ein Bild). Sie bringen die Ausgabe näher an die richtige Antwort und verwenden optische Komponenten, um die Wellen aufzubrechen und so den Prozess umzukehren. „Die Magie ist“, sagte Marquardt, „wenn man das Gerät mit demselben Eingang noch einmal ausprobiert, ist der Ausgang tendenziell näher an der gewünschten Stelle.“ Als nächstes arbeiten sie mit Experimentatoren zusammen, um ein solches Gerät zu bauen ein System. Da sich andere Forscher jedoch auf Systeme konzentrieren, die im Reverse-Modus laufen, sind die Möglichkeiten eingeschränkt, weshalb sie die Backpropagation vollständig hinter sich gelassen haben.

Weil sie wussten, dass die Art und Weise, wie das Gehirn lernt, keine standardmäßige Backpropagation ist, wurde ihre Forschung nicht getroffen, sondern ging weiter. „Das Gehirn verbreitet sich nicht zurück“, sagte Scellier. Wenn Neuron A mit Neuron B kommuniziert, erfolgt die Ausbreitung in eine Richtung Bildunterschrift: CNRS-Physikerin Julie Grollier hat einen Physik-Lernalgorithmus implementiert, der als vielversprechende Alternative zur Backpropagation gilt. Bildquelle: Christophe CaudroyIm Jahr 2017 entwickelten Scellier und Yoshua Bengio, ein Informatiker an der Universität Montreal, eine einseitige Lernmethode namens Balanced Propagation. Wir können die Funktionsweise folgendermaßen verstehen: Stellen Sie sich ein Netzwerk aus Pfeilen wie Neuronen vor, deren Richtungen 0 oder 1 darstellen und die durch Federn, die als synaptische Gewichte fungieren, in einem Gitter verbunden sind. Je lockerer die Feder, desto schwieriger wird es für die Verbindungspfeile, sich auszurichten. Drehen Sie zunächst die Pfeilreihe ganz links, um die Pixel der handgeschriebenen Ziffern widerzuspiegeln, drehen Sie dann die anderen Pfeile, während Sie die Pfeilreihe ganz links unverändert lassen, und lassen Sie zu, dass sich diese Störung über die Federn ausbreitet. Wenn das Umblättern aufhört, gibt der Pfeil ganz rechts die Antwort. Der Punkt ist, dass wir keine Pfeile umdrehen müssen, um dieses System zu trainieren. Stattdessen können wir am unteren Rand des Netzwerks einen weiteren Satz Pfeile verbinden, der die richtige Antwort anzeigt. Diese richtigen Pfeile führen dazu, dass der obere Satz Pfeile umkippt und das gesamte Gitter in einen neuen Gleichgewichtszustand eintritt. Vergleichen Sie abschließend die neue Richtung des Pfeils mit der alten Richtung und ziehen Sie jede Feder entsprechend fest oder lockern Sie sie. Nach vielen Experimenten erlangten die Federn intelligentere Spannungen, was Scellier und Bengio gezeigt hat, was einer Rückausbreitung gleichkommt. „Die Leute dachten, es könne keinen Zusammenhang zwischen physikalischen neuronalen Netzen und Backpropagation geben“, sagte Grollier. „Das hat sich kürzlich geändert, was sehr aufregend ist.“ Die ursprüngliche Arbeit zur ausgewogenen Ausbreitung war ausschließlich theoretisch. Doch in einem kommenden Artikel beschreiben Grollier und der CNRS-Physiker Jérémie Laydevant die Ausführung des Algorithmus auf einer von D-Wave gebauten Quanten-Annealing-Maschine. Das Gerät verfügt über ein Netzwerk aus Tausenden interagierenden Supraleitern, die wie durch Federn verbundene Pfeile funktionieren und auf natürliche Weise berechnen, wie sich die „Feder“ aktualisieren soll. Das System kann diese synaptischen Gewichte jedoch nicht automatisch aktualisieren. 4 „Wir konnten den Kreis für ein kleines System schließen“, sagte Sam Dillavou, ein Physiker an der University of Pennsylvania. Wenn ein Schaltkreis Daten empfängt und ein Ergebnis „errät“, beginnt ein anderer identischer Schaltkreis mit der richtigen Antwort und integriert diese in sein Verhalten. Schließlich vergleicht die Elektronik, die jedes Widerstandspaar verbindet, automatisch deren Werte und passt sie für eine „intelligentere“ Konfiguration an. Die Gruppe beschrieb ihren Grundschaltkreis letzten Sommer in einem Vorabdruck (siehe unten) mit dem Titel „Demonstration von dezentralisiertem, physikgesteuertem Lernen“. Der Artikel zeigt, dass dieser Schaltkreis lernen kann, drei Arten von Blumen mit einer Genauigkeit von 95 % zu unterscheiden. . Und jetzt arbeiten sie an einem schnelleren und leistungsstärkeren Gerät. Papieradresse: https://arxiv.org/abs/2108.00275 Selbst dieses Upgrade kann die fortschrittlichsten Siliziumchips nicht schlagen. Die Physiker, die diese Systeme bauen, vermuten jedoch, dass digitale neuronale Netze, so leistungsfähig sie heute auch erscheinen, im Vergleich zu analogen Netzen irgendwann langsam und unzureichend erscheinen werden. Digitale neuronale Netze können nur bis zu einem bestimmten Punkt skaliert werden, bevor sie in der Überberechnung stecken bleiben, aber größere physische Netze müssen einfach sie selbst sein. „Dies ist ein sehr großes, schnell wachsendes und sich ständig veränderndes Gebiet, und ich bin fest davon überzeugt, dass einige sehr leistungsstarke Computer nach diesen Prinzipien gebaut werden“, sagte Dillavou. Um einen bestimmten Eingang zu klassifizieren, wandelt diese Schaltung die Daten in Spannungen um, die an mehrere Knoten angelegt werden. Elektrischer Strom fließt durch den Stromkreis und sucht nach dem Weg, der am wenigsten Energie verbraucht, und ändert die Spannung, während sie sich stabilisiert. Die Antwort besteht darin, die Spannung am Ausgangsknoten anzugeben. Die Innovation dieser Idee liegt im anspruchsvollen Lernschritt, für den sie ein Schema entwickelt haben, das der ausgewogenen Ausbreitung ähnelt und als gekoppeltes Lernen bezeichnet wird.

Das obige ist der detaillierte Inhalt vonNutzen Sie die Kraft des Universums, um Daten zu verarbeiten! „Physische Netze' übertreffen tiefe neuronale Netze bei weitem. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr