Heim >Technologie-Peripheriegeräte >KI >Der kooperative Konfrontations-Benchmark von StarCraft II übertrifft SOTA, die neue Transformer-Architektur löst das Problem des Verstärkungslernens mit mehreren Agenten

Der kooperative Konfrontations-Benchmark von StarCraft II übertrifft SOTA, die neue Transformer-Architektur löst das Problem des Verstärkungslernens mit mehreren Agenten

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-09 08:31:081186Durchsuche

Multi-Agent Reinforcement Learning (MARL) ist ein herausforderndes Problem, das nicht nur die Ermittlung der Richtung der Richtlinienverbesserung für jeden Agenten erfordert, sondern auch die Kombination der Richtlinienaktualisierungen einzelner Agenten erfordert, um die Gesamtleistung zu verbessern. Vor kurzem wurde dieses Problem zunächst gelöst, und einige Forscher haben die CTDE-Methode (Centralized Training Decentralised Execution) eingeführt, die es dem Agenten ermöglicht, während der Trainingsphase auf globale Informationen zuzugreifen. Allerdings können diese Methoden nicht die gesamte Komplexität von Multi-Agenten-Interaktionen abdecken.

Tatsächlich haben sich einige dieser Methoden als Fehlschläge erwiesen. Um dieses Problem zu lösen, schlug jemand den Multiagenten-Dominanzzerlegungssatz vor. Auf dieser Grundlage werden die HATRPO- und HAPPO-Algorithmen abgeleitet. Diese Ansätze unterliegen jedoch Einschränkungen, da sie immer noch auf sorgfältig ausgearbeiteten Maximierungszielen beruhen.

In den letzten Jahren haben Sequenzmodelle (SM) erhebliche Fortschritte im Bereich der Verarbeitung natürlicher Sprache (NLP) gemacht. Beispielsweise schneiden die GPT-Serie und BERT bei einem breiten Spektrum nachgelagerter Aufgaben gut ab und erzielen eine starke Leistung bei Generalisierungsaufgaben kleiner Stichproben.

Da Sequenzmodelle natürlich zu den Sequenzeigenschaften der Sprache passen, können sie für Sprachaufgaben verwendet werden. Sequenzmethoden sind jedoch nicht auf NLP-Aufgaben beschränkt, sondern eine weithin anwendbares allgemeines Modell. Beispielsweise kann man beim Computer Vision (CV) ein Bild in Teilbilder aufteilen und sie in einer Reihenfolge anordnen, als wären sie Token in einer NLP-Aufgabe. Die bekannteren neueren Modelle wie Flamingo, DALL-E, GATO usw. haben alle den Schatten der Sequenzmethode.

Mit dem Aufkommen von Netzwerkarchitekturen wie Transformer hat die Sequenzmodellierungstechnologie auch große Aufmerksamkeit in der RL-Community auf sich gezogen, die eine Reihe von Offline-RL auf Basis von Transformer gefördert hat Entwicklung der Transformatorarchitektur. Diese Methoden zeigen großes Potenzial bei der Lösung einiger der grundlegendsten RL-Trainingsprobleme.

Trotz des bemerkenswerten Erfolgs dieser Methoden war keine von ihnen darauf ausgelegt, den schwierigsten (und für MARL einzigartigen) Aspekt von Multiagentensystemen zu modellieren – die Interaktion zwischen Agenten. Wenn wir einfach allen Agenten eine Transformer-Richtlinie geben und sie individuell schulen, ist dies immer noch keine Garantie dafür, dass sich die gemeinsame MARL-Leistung verbessert. Obwohl eine große Anzahl leistungsstarker Sequenzmodelle verfügbar ist, nutzt MARL die Leistung von Sequenzmodellen nicht wirklich aus.

Wie verwende ich Sequenzmodelle zur Lösung von MARL-Problemen? Forscher der Shanghai Jiao Tong University, des Digital Brain Lab und der Oxford University haben eine neue Multi-Agent-Transformer-Architektur (MAT, Multi-Agent Transformer) vorgeschlagen, die kollaborative MARL-Probleme effektiv in Sequenzmodellprobleme umwandeln kann Beobachtungssequenz des Agenten zur optimalen Aktionssequenz des Agenten.

Ziel dieses Artikels ist es, eine Brücke zwischen MARL und SM zu schlagen, um die Modellierungsfähigkeiten moderner Sequenzmodelle für MARL freizuschalten. Der Kern von MAT ist die Encoder-Decoder-Architektur, die den Multi-Agenten-Vorteilszerlegungssatz verwendet, um das Problem der gemeinsamen Strategiesuche in einen sequentiellen Entscheidungsprozess umzuwandeln, sodass das Multiagentenproblem eine lineare Zeitkomplexität aufweist, und zwar größtenteils Wichtig ist, dass dadurch eine monotone Leistungsverbesserung von MAT gewährleistet wird. Im Gegensatz zu früheren Techniken wie Decision Transformer, die vorab gesammelte Offline-Daten erfordern, wird MAT auf strategische Online-Weise durch Online-Versuch und Irrtum aus der Umgebung trainiert.

- Papier Adresse :https://arxiv.org/pdf/2205.14953.pdf

- Projekthomepage: https://sites.google.com /view/multi-agent-transformer

Um MAT zu überprüfen, verwendeten Forscher StarCraftII, Multi-Agent MuJoCo und Dexterous Hands Manipulation Es wurden umfangreiche Experimente mit dem Google Research Football-Benchmark durchgeführt. Die Ergebnisse zeigen, dass MAT im Vergleich zu starken Baselines wie MAPPO und HAPPO eine bessere Leistung und Dateneffizienz aufweist. Darüber hinaus hat diese Studie auch bewiesen, dass MAT unabhängig von der Anzahl der Agenten bei unbekannten Aufgaben eine bessere Leistung erbringt, aber man kann sagen, dass es sich um einen hervorragenden Lerner für kleine Stichproben handelt.

Hintergrundwissen

In diesem Abschnitt stellt der Forscher zunächst die kollaborative MARL-Problemformel und den Multi-Agent-Vorteilszerlegungssatz vor Der Grundstein dieses Artikels. Anschließend überprüfen sie bestehende MAT-bezogene MARL-Methoden, was schließlich zu Transformer führt.

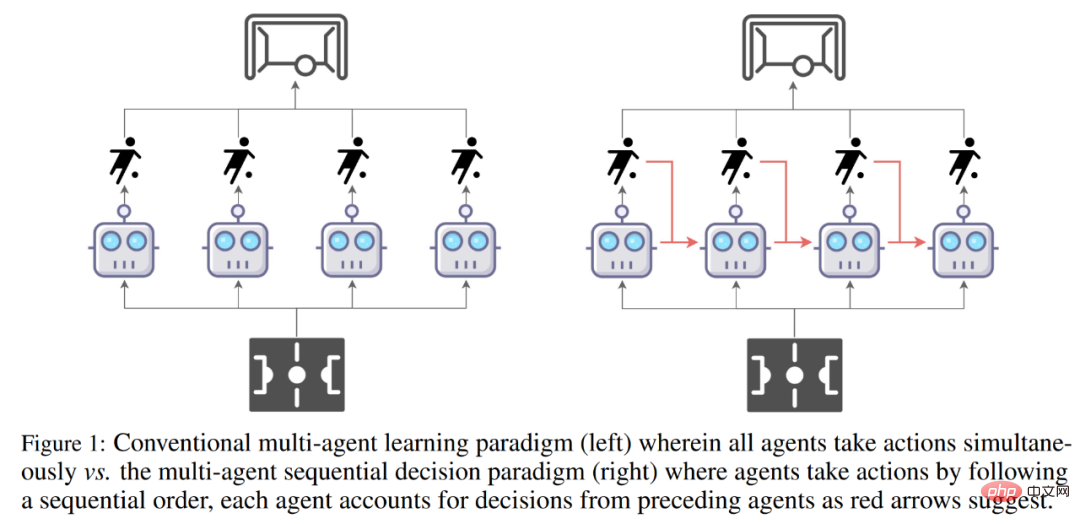

Vergleich des traditionellen Multi-Agenten-Lernparadigmas (links) und des Multi-Agenten-Sequenzentscheidungsparadigmas (rechts).

Problemformel

Kollaborative MARL-Probleme bestehen normalerweise aus diskreten, teilweise beobachtbaren Markov-Entscheidungsprozessen (Dec-POMDPs) #🎜 🎜# zum Modeln.

zum Modeln.

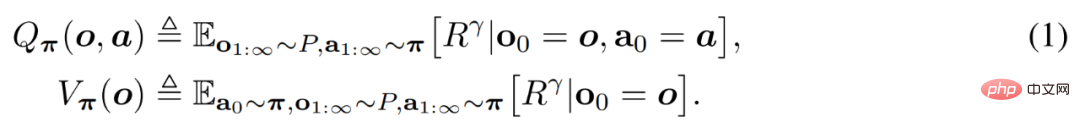

Der Agent bewertet Aktionen und Beobachtungen anhand der Werte Q_π(o, a) und V_π(o), wie folgt definiert.

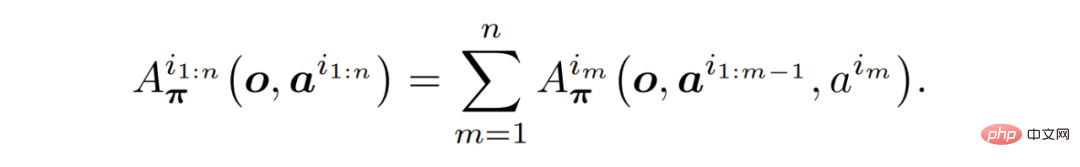

Satz 1 (Multiagenten-Dominanzzerlegung): Sei i_1:n die Anordnung der Agenten. Die folgende Formel gilt immer ohne weitere Annahmen.

Wichtig ist, dass Satz 1 eine Intuition für die Auswahl inkrementeller Verbesserungsmaßnahmen bietet.

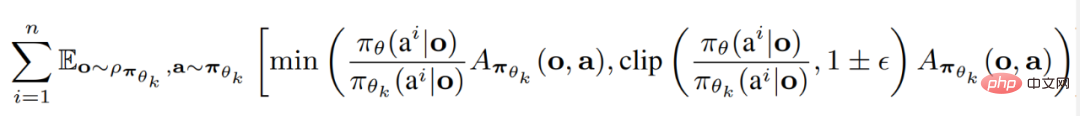

Bestehende MARL-MethodenDie Forscher fassten die aktuellen beiden SOTA MARL-Algorithmen zusammen, die beide auf Proximal Policy Optimization (PPO) basieren. PPO ist eine RL-Methode, die für ihre Einfachheit und Leistungsstabilität bekannt ist.

Multi-Agent-Proximal-Richtlinienoptimierung (MAPPO) ist die erste und einfachste Methode, PPO auf MARL anzuwenden.

Heterogeneous Agent Proximal Policy Optimization (HAPPO) ist einer der aktuellen SOTA-Algorithmen, der Theorem voll ausnutzen kann (1) Um ein Multi-Agent-Trust-Domain-Lernen mit monotoner Lifting-Garantie zu erreichen.

Transformermodell #🎜 🎜 #

Basierend auf den in Theorem (1) beschriebenen Sequenzeigenschaften und dem Prinzip hinter HAPPO ist es nun intuitiv, die Verwendung des Transformer-Modells zur Implementierung des Vertrauensdomänenlernens mit mehreren Agenten in Betracht zu ziehen. Durch die Behandlung eines Agententeams als Sequenz ermöglicht die Transformer-Architektur die Modellierung von Agententeams mit variabler Anzahl und Art und vermeidet gleichzeitig die Mängel von MAPPO/HAPPO.Multi-Agent-Transformer

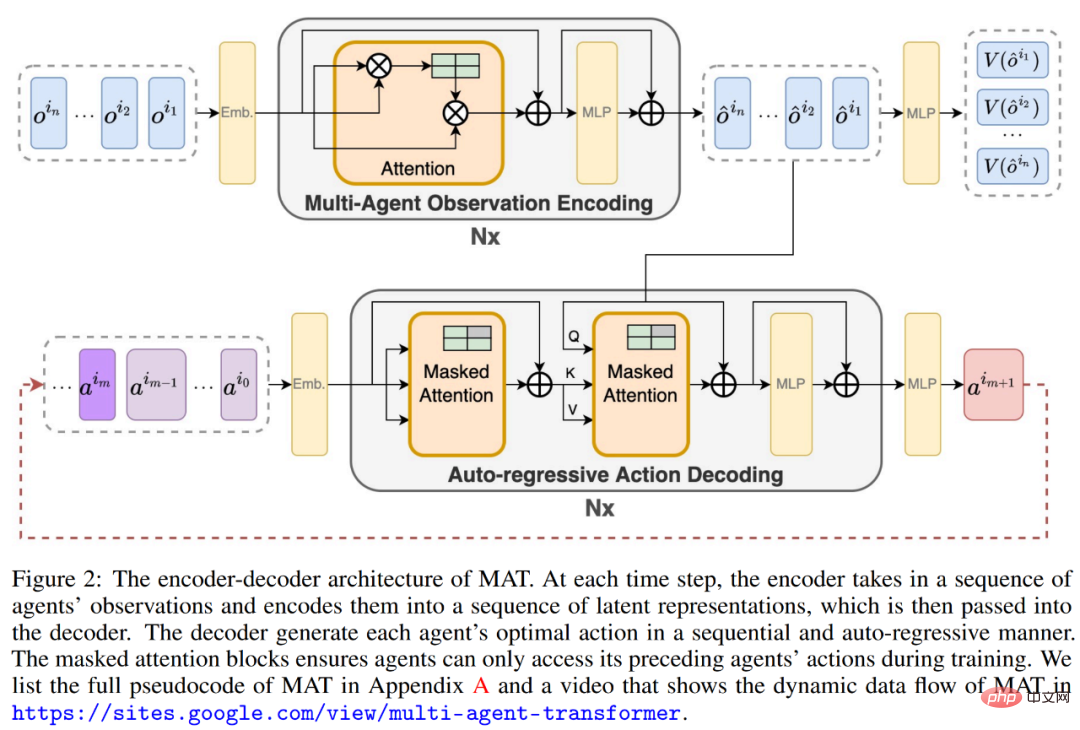

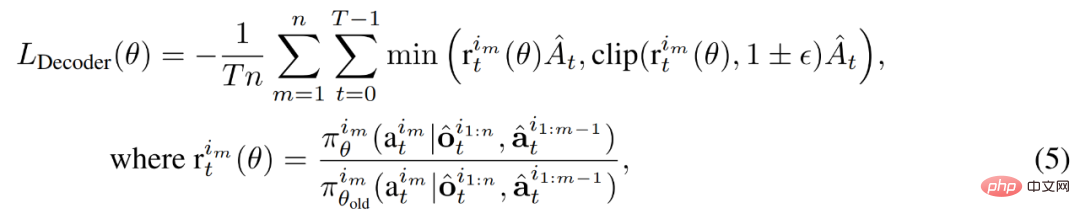

Um das Sequenzmodellierungsparadigma von MARL zu realisieren, ist die von den Forschern bereitgestellte Lösung der Multi-Agent Transformator (MAT). Die Idee, die Transformer-Architektur anzuwenden, beruht auf der Tatsache, dass der Agent die Beziehung zwischen der Eingabe der Sequenz (o^i_1, ..., o^i_n) und der Ausgabe der Aktionssequenz (a^i_1, . ., a^i_n) Mapping ist eine Sequenzmodellierungsaufgabe ähnlich der maschinellen Übersetzung. Wie Satz (1) vermeidet, hängt die Aktion a^i_m von den vorherigen Entscheidungen aller Agenten a^i_1:m−1 ab.Daher enthält MAT, wie in Abbildung (2) unten gezeigt, einen Encoder zum Erlernen der gemeinsamen Beobachtungsdarstellung und eine autoregressive Methode für jede Intelligenz-Decoder für Körperausgabeaktionen.

Die Parameter des Decoders werden durch θ dargestellt, wodurch die gemeinsame Aktion a^i_0:m−1, m = {1, . (wobei a^i_0 ein beliebiges Symbol ist, das den Beginn der Dekodierung angibt) wird an die Dekodierungsblocksequenz übergeben. Entscheidend ist, dass jeder Decodierungsblock über einen maskierten Selbstaufmerksamkeitsmechanismus verfügt. Um den Decoder zu trainieren, minimieren wir das zugeschnittene PPO-Ziel wie folgt.

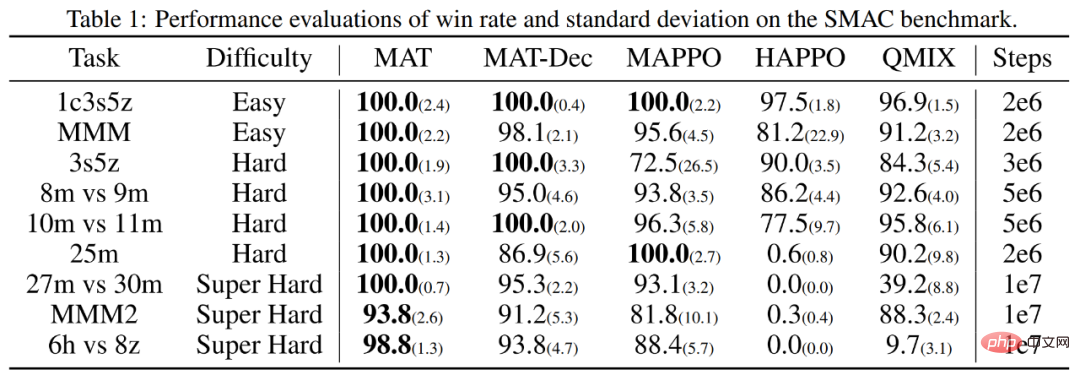

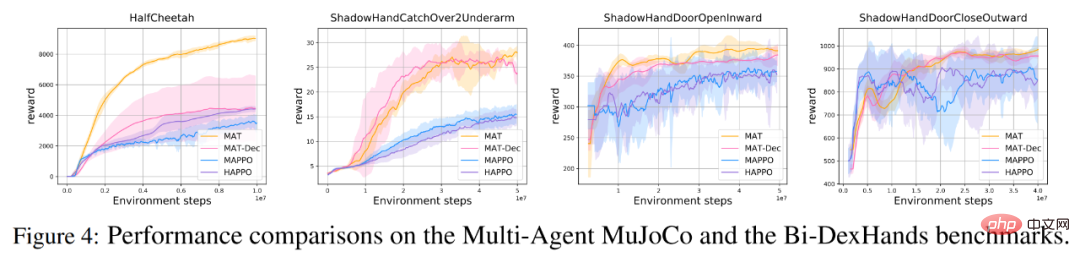

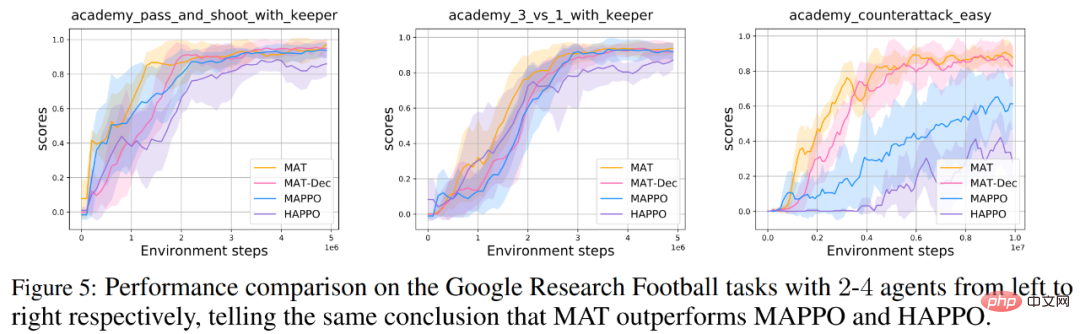

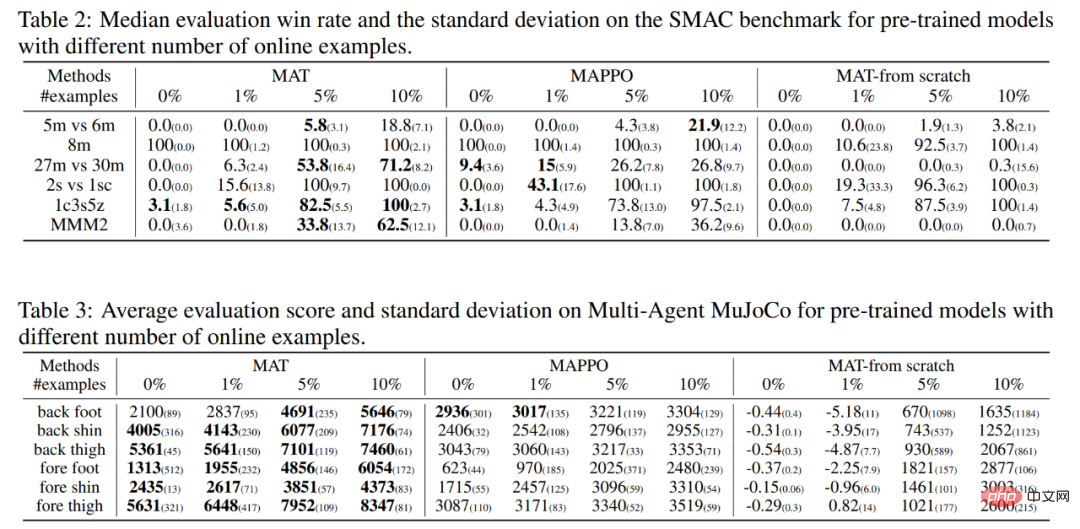

Um zu bewerten, ob MAT die Erwartungen erfüllt, führten die Forscher Experimente mit dem StarCraft II Multi-Agent Challenge (SMAC)-Benchmark (MAPPO weist eine überlegene Leistung auf) und dem Multi-Agent-MuJoCo-Benchmark (HAPPO) durch on MAT wurde oben mit der SOTA-Leistung getestet. Darüber hinaus führten die Forscher auch erweiterte MAT-Tests zur bimanuellen Fingerhandmanipulation (Bi-DexHands) und Google Research Football-Benchmarks durch. Ersteres bietet eine Reihe herausfordernder Zweihandaufgaben und Letzteres bietet eine Reihe kooperativer Szenarios innerhalb eines Fußballspiels. Da das Transformer-Modell in der Regel eine starke Generalisierungsleistung bei kleinen Stichprobenaufgaben zeigt, glauben die Forscher schließlich, dass MAT auch bei unbekannten MARL-Aufgaben über ähnlich starke Generalisierungsfähigkeiten verfügen kann. Daher entwarfen sie Zero-Shot- und Small-Shot-Experimente für SMAC- und Multi-Agent-MuJoCo-Aufgaben. Wie in Tabelle 1 und Abbildung 4 unten gezeigt, übertrifft MAT bei SMAC-, Multi-Agent-MuJoCo- und Bi-DexHands-Benchmarks MAPPO und HAPPO bei fast allen Aufgaben deutlich. Dies zeigt seine leistungsstarke Konstruktion Fähigkeit zu homogenen und heterogenen Agentenaufgaben. Darüber hinaus erreicht MAT auch eine bessere Leistung als MAT-Dec, was auf die Bedeutung der Decoder-Architektur im MAT-Design hinweist. Ähnliche Leistungsergebnisse erzielten die Forscher auch beim Google Research Football-Benchmark, wie in Abbildung 5 unten dargestellt. Die Zero-Shot- und Few-Shot-Ergebnisse für jeden Algorithmus sind in den Tabellen 2 und 3 zusammengefasst, wobei fett gedruckte Zahlen die beste Leistung angeben. Die Forscher lieferten auch die Leistung von MAT unter denselben Datenbedingungen, die wie die Kontrollgruppe von Grund auf trainiert wurden. Wie in der folgenden Tabelle gezeigt, erzielt MAT die meisten der besten Ergebnisse, was die starke Generalisierungsleistung des Wenig-Schuss-Lernens von MAT zeigt.

Experimentelle Ergebnisse

Leistung beim kollaborativen MARL-Benchmark

MAT für Few-Shot-Lernen

Das obige ist der detaillierte Inhalt vonDer kooperative Konfrontations-Benchmark von StarCraft II übertrifft SOTA, die neue Transformer-Architektur löst das Problem des Verstärkungslernens mit mehreren Agenten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr