Heim >Technologie-Peripheriegeräte >KI >Vergleich von acht wichtigen prädiktiven Analysetools

Vergleich von acht wichtigen prädiktiven Analysetools

- PHPznach vorne

- 2023-04-08 23:01:114218Durchsuche

Was sind Predictive-Analytics-Tools?

Predictive-Analytics-Tools verbinden künstliche Intelligenz und Geschäftsberichte. Zu diesen Tools gehören ausgefeilte Pipelines zum Sammeln von Daten aus dem gesamten Unternehmen, das Hinzufügen von Ebenen statistischer Analysen und maschinellem Lernen, um Vorhersagen über die Zukunft zu treffen, und das Destillieren dieser Erkenntnisse in nützliche Zusammenfassungen, auf die Geschäftsanwender reagieren können.

Die Qualität von Vorhersagen hängt in erster Linie von den Daten ab, die in das System eingehen – der alte Slogan aus der Mainframe-Ära „Garbage in, Garbage out“ gilt auch heute noch. Aber es gibt noch tiefere Herausforderungen, da Predictive-Analytics-Software die Momente, in denen sich die Welt verändern wird, nicht vorhersagen kann und die Zukunft nur schwach mit der Vergangenheit verknüpft ist. Diese Tools, die hauptsächlich auf der Erkennung von Mustern basieren, werden immer ausgefeilter.

Die Verwendung eines speziellen Predictive-Analytics-Tools ist im Vergleich dazu, ein Tool von Grund auf neu zu schreiben, oft relativ einfach. Die meisten Tools bieten eine visuelle Programmierschnittstelle, die es Benutzern ermöglicht, eine Vielzahl von für die Datenanalyse optimierten Symbolen per Drag-and-Drop zu verschieben und so den Benutzern zu helfen, die Programmierung zu verstehen und wie ein Programmierer zu denken, und diese Tools können tatsächlich per Mausklick komplexe Vorhersagen generieren.

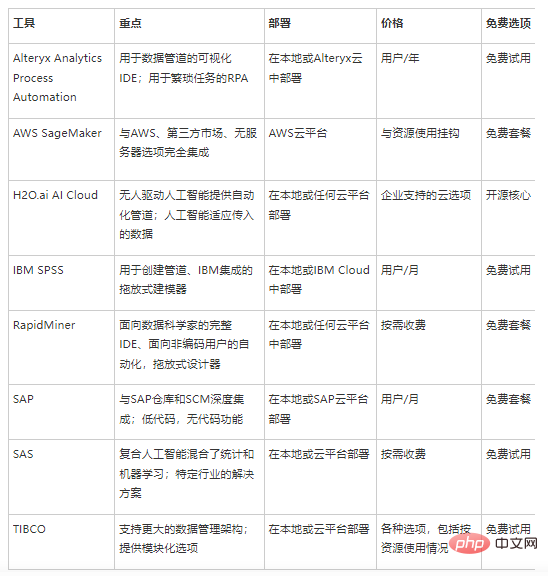

Ausgezeichneter Vergleich der Predictive Analytics-Tools

Alteryx Analytics Process Automation

Das Ziel der Alteryx Analytics Process Automation (APA)-Plattform besteht darin, Sie beim Aufbau von Pipelines zu unterstützen, die Ihre Daten bereinigen, bevor die besten Data Science- und Machine-Learning-Algorithmen angewendet werden . Ein hoher Automatisierungsgrad ermöglicht den Einsatz dieser Modelle in der Produktion, um einen stetigen Strom an Erkenntnissen und Vorhersagen zu generieren. Die visuelle IDE bietet über 300 Optionen, die zu einer komplexen Pipeline kombiniert werden können. Eine der Stärken von APA ist die tiefe Integration mit anderen Datenquellen wie Geodatenbanken oder demografischen Daten, um die Qualität Ihrer eigenen Datensätze zu verbessern.

Wichtige Punkte:

- Dies ist eine großartige Lösung für Datenwissenschaftler, die ihnen dabei hilft, die Erfassung komplexer Datenquellen zu automatisieren, um mehrere Ergebnisse zu generieren.

- Für die Bereitstellung vor Ort oder in der Alteryx Cloud.

- Enthält eine Reihe von RPA-Tools (Robotic Process Automation) für Aufgaben wie Texterkennung oder Bildverarbeitung.

- Ziel ist es, mehrere Kunden zu bedienen, die Daten möglicherweise als Dashboard, Tabellenkalkulation oder eine andere benutzerdefinierte Plattformansicht anzeigen möchten.

- Tools wie Designer beginnen bei 5.195 $ pro Benutzer und Jahr. Zusätzliche Gebühren werden vom Verkaufsteam festgelegt. Kostenlose Testversion und Open-Source-Optionen verfügbar.

AWS SageMaker

Als Amazons primäre Plattform für künstliche Intelligenz lässt sich AWS SageMaker gut in den Rest des AWS-Portfolios integrieren, um Benutzern dabei zu helfen, eine der primären Datenquellen des Cloud-Anbieters – die Daten von Amazon – zu analysieren und sie dann für die Ausführung in einer eigenen Instanz bereitzustellen oder als Teil einer serverlosen Lambda-Funktion. SageMaker ist eine Full-Service-Plattform mit Datenvorbereitungstools wie Data Wrangler, einer mit Jupyter-Notebooks erstellten Präsentationsebene und einer Automatisierungsoption namens Autopilot. Visualisierungstools helfen Benutzern, auf einen Blick zu verstehen, was vor sich geht.

Wichtige Punkte:

- Vollständig in viele Teile des AWS-Ökosystems integriert, was es zu einer hervorragenden Wahl für AWS-basierte Vorgänge macht.

- Serverlose Bereitstellungsoptionen ermöglichen eine Skalierung der Kosten mit der Nutzung.

- Marktplatz zur Förderung der Zusammenarbeit mit anderen SageMaker Benutzer kaufen und verkaufen Modelle und Algorithmen;

- Integration mit einer Vielzahl von AWS-Datenbanken, Datenseen und anderen Datenspeicheroptionen, um die Arbeit mit großen Datenmengen zu vereinfachen

- Die Preise hängen normalerweise von der Größe der unterstützenden Computerressourcen ab Berechnung, mit großzügigen kostenlosen Stufen, die Experimente ermöglichen.

H2O.ai AI Cloud

Exzellente Algorithmen der künstlichen Intelligenz in produktive Erkenntnisse zu übersetzen, ist das Hauptziel von H2O.ai AI Cloud. Seine „menschengesteuerte KI“ bietet eine automatisierte Pipeline zur Aufnahme von Daten und zur Untersuchung ihrer wichtigsten Merkmale. Eine Reihe von Open-Source- und proprietären Feature-Engineering-Tools helfen dabei, Algorithmen auf die wichtigsten Teile Ihrer Daten zu konzentrieren. Die Ergebnisse werden in einem Dashboard oder einer Sammlung automatisierter grafischer Visualisierungen angezeigt.

Wichtige Punkte:

- Konzentrieren Sie sich auf Probleme, bei denen KI am besten für komplexe Lösungen geeignet ist, die sich an eingehende Daten anpassen müssen.

- Die Tools reichen von AI Cloud zum Erstellen großer datengesteuerter Pipelines bis hin zur Unterstützung von Desktop-Benutzern bei der Erstellung in Echtzeit Dashboards Open Source Wave basierend auf Python;

- Laufen vor Ort oder auf einer beliebigen Cloud-Plattform;

- Die Kernplattform ist vollständig Open Source;

IBM SPSS

Statistiker verwenden seit Jahrzehnten IBMs SPSS. Die neueste Version enthält Optionen zur Integration neuer Methoden wie maschinelles Lernen, Textanalyse oder andere Algorithmen der künstlichen Intelligenz. Statistikpakete konzentrieren sich auf die numerische Interpretation auftretender Ereignisse. SPSS Modeler ist ein Drag-and-Drop-Tool zum Erstellen von Datenpipelines, um umsetzbare Erkenntnisse zu gewinnen.

Wichtige Punkte:

- Ideal für große Legacy-Unternehmen mit großen Datenströmen;

- Integrationen mit anderen IBM-Tools wie Watson Studio;

- Die Preise beginnen bei 499 $ pro Benutzer und Monat, es sind zahlreiche kostenlose Testversionen verfügbar.

RapidMiner

Die Tools von RapidMiner werden immer zuerst den Datenwissenschaftlern an vorderster Front zur Verfügung gestellt. Das Kernprodukt ist eine vollständige visuelle IDE zum Experimentieren mit verschiedenen Datenflüssen, um die besten Erkenntnisse zu gewinnen. Die Produktlinie umfasst jetzt mehr Automatisierungslösungen, die den Prozess über eine einfachere Benutzeroberfläche und eine Reihe von Tools zur Datenbereinigung und Suche nach den besten Modellierungslösungen für mehr Menschen im Unternehmen zugänglich machen. Diese können dann in der Produktionslinie eingesetzt werden. Darüber hinaus erweitert das Unternehmen seine Cloud-Angebote um einen Hub für künstliche Intelligenz, der die Einführung vereinfachen soll.

Wichtige Punkte:

- Ideal für Datenwissenschaftler, die direkt mit Daten arbeiten und die Erkundung vorantreiben;

- Sorgen Sie für Transparenz für Benutzer, die die Gründe für Vorhersagen verstehen müssen.

- Verwenden Sie den Jupyter-Notebook-gesteuerten Artificial Intelligence Hub (AI Hub). ) um KI-Wissenschaftler und die Zusammenarbeit zwischen Benutzern zu fördern;

- Umfangreiches kostenloses Kontingent von RapidMiner Studio für frühe Testversionen und Bildungsprogramme;

- Preismodelle auf Anfrage für große Projekte und Produktionsbereitstellungen verfügbar .

- SAP

Jeder, der in der Fertigungsindustrie arbeitet, sollte sich mit SAP-Software auskennen. Seine Datenbank kann Waren in verschiedenen Phasen der Lieferkette verfolgen. Zu diesem Zweck haben sie viel in die Entwicklung eines großartigen Tools für prädiktive Analysen investiert, das es Unternehmen ermöglicht, fundiertere Entscheidungen darüber zu treffen, was als nächstes passieren könnte. Das Tool basiert stark auf Business Intelligence und Reporting und behandelt Prognosen lediglich als eine weitere Spalte in der Analysepräsentation. Informationen aus der Vergangenheit dienen als Grundlage für Entscheidungen über die Zukunft, vor allem mithilfe einer Sammlung hochautomatisierter maschineller Lernroutinen. Sie müssen kein KI-Programmierer sein, um es auszuführen. Tatsächlich haben sie auch an der Entwicklung sogenannter „Konversationsanalyse“-Tools gearbeitet, die jedem Manager, der Fragen in menschlicher Sprache stellt, nützliche Erkenntnisse liefern können.

Wichtige Punkte:

Ideal für Stacks, die bereits auf eine tiefe Integration mit SAP-Lager- und Supply-Chain-Management-Software angewiesen sind.- Entwickelt mit einer Low-Code- und No-Code-Strategie, um Analysen für alle zugänglich zu machen regelmäßiger Business-Intelligence-Prozess, um Konsistenz und Einfachheit zu gewährleisten;

- Benutzer können Einblicke in die Art und Weise gewinnen, wie KI Entscheidungen trifft, indem sie nach dem Kontext hinter Vorhersagen fragen.

- Der kostenlose Plan ermöglicht Experimente. Der Grundpreis beginnt bei 36 $ pro Benutzer und Monat.

- SAS

- Als eines der ältesten Softwarepakete für Statistik und Business Intelligence ist SAS im Laufe der Zeit immer leistungsfähiger geworden. Unternehmen, die Vorhersagen benötigen, können zukunftsgerichtete Berichte erstellen, die auf einer beliebigen Kombination aus Statistiken und maschinellen Lernalgorithmen basieren, was SAS als „zusammengesetzte KI“ bezeichnet. Die Produktlinie ist in Tools für die grundlegende Erkundung unterteilt, beispielsweise visuelles Data Mining oder visuelle Vorhersage. Es gibt auch branchenspezifische Tools, wie zum Beispiel Anti-Geldwäsche-Software, die darauf ausgelegt ist, potenzielle Compliance-Probleme vorherzusagen.

Highlights:

Umfangreiches Toolset, das für bestimmte Branchen optimiert wurde (z. B. Bankwesen); Eine perfekte Kombination aus traditioneller Statistik und modernem maschinellem Lernen;- Entwickelt für lokale und cloudbasierte Bereitstellungen; Die Preise hängen stark von der Produktauswahl und der Verwendung ab.

- TIBCO

- Nachdem die Daten von verschiedenen integrierten Tools gesammelt wurden, kann die prädiktive Analyse von TIBCO mit der Generierung von Vorhersagen beginnen. Data Science Studio wurde entwickelt, um Teams die gemeinsame Erstellung von Low-Code- und No-Code-Analysen zu ermöglichen. Für bestimmte Datensätze sind gezieltere Optionen verfügbar. TIBCO Streaming ist beispielsweise für die Erstellung von Echtzeitentscheidungen aus einer Abfolge von Ereignissen optimiert. Spotfire erstellt Dashboards durch die Integration standortbasierter Daten mit historischen Ergebnissen. Diese Tools arbeiten mit der robusteren Produktlinie des Unternehmens zusammen, um die Datenerfassung, -integration und -speicherung besser zu unterstützen.

- Wichtige Punkte:

- Produkte bieten unabhängige Preise für eine Vielzahl unterschiedlicher Cloud-Plattform- und On-Premises-Optionspläne. „schlüsselfertige“ AWS-Instanzen beginnen bei 99 Cent pro Stunde.

- Originallink:

- https://www.cio.com/article/193743/top-tools-for-predictive-analytics.html

Das obige ist der detaillierte Inhalt vonVergleich von acht wichtigen prädiktiven Analysetools. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr