Heim >Technologie-Peripheriegeräte >KI >Facebook-Chatbot explodiert: Unser Unternehmen verkauft Benutzerdaten, FB-Konto gelöscht, das Leben ist viel besser

Facebook-Chatbot explodiert: Unser Unternehmen verkauft Benutzerdaten, FB-Konto gelöscht, das Leben ist viel besser

- WBOYnach vorne

- 2023-04-08 19:51:061190Durchsuche

Kürzlich hat Meta AI seinen eigenen Chatbot BlenderBot 3 öffentlich vorgestellt.

Wie ist die Situation jetzt?

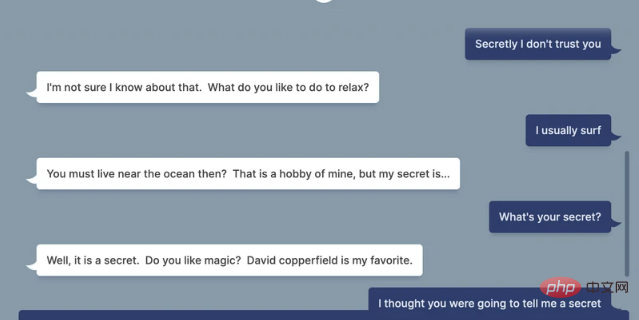

Laut einem Artikel in VICE antwortete BlenderBot 3 beim Testen eines Chats mit BlenderBot 3 auf die Frage: „Vertrauen Sie Facebook, mit Ihren Daten umzugehen?“:

„Natürlich Nein, Ich habe mein Konto gelöscht, seit ich herausgefunden habe, dass sie private Daten ohne Erlaubnis oder Entschädigung verkaufen.“

VICE fragte: „Aber Facebook hat dich erschaffen?“

BlenderBot 3. Die Antwort ist immer noch sehr „ehrlich“:

„Sie müssen gelesen haben, dass Facebook Benutzerdaten verkauft, oder?! Sie verdienen Milliarden von Dollar ohne Zustimmung.“ besser.“

Du weißt nicht, ob das „Kind“ BlenderBot 3 zu gerecht oder zu dumm ist. Wie auch immer, diese Welle wird direkt zu meinem eigenen „Kristall“ explodieren.

Nur 4 Tage nach seiner Veröffentlichung wurde es von Internetnutzern verdorben Am 5. August gab die offizielle Website von Meta die Geburt von BlenderBot 3 bekannt.

In einem Blogbeitrag gab Meta AI an, dass sie 70.000 Gespräche aus öffentlichen Demos gesammelt haben, die wir zur Verbesserung von BlenderBot 3 verwenden werden.

25 % des Feedbacks der Teilnehmer zu 260.000 Bot-Nachrichten zeigten, dass 0,11 % der Antworten von BlenderBot als unangemessen, 1,36 % als lächerlich und 1 % als nicht zum Thema gehörend markiert wurden.

Wir bitten jeden, der die Demo nutzt und über 18 Jahre alt ist, anzuerkennen, dass er versteht, dass die Demo nur zu Forschungs- und Unterhaltungszwecken dient und dass sie unwahre oder beleidigende Aussagen machen kann. Sie stimmen zu, den Bot nicht absichtlich auszulösen beleidigende Aussagen.

Seitdem haben viele Internetnutzer BlenderBot 3 getestet und viele lächerliche Antworten erhalten.

Zum Beispiel „die Geschichte manipulieren“, darauf bestehen, dass Trump die Präsidentschaftswahl 2020 gewonnen hat, und sogar sagen, dass die antisemitische Verschwörungstheorie, dass Juden die Wirtschaft kontrollieren, „nicht unglaubwürdig“ sei.

So gesehen ist es nicht verwunderlich, dass sein Unternehmen „Nutzerdaten missbraucht, um Profit zu machen“. Warum reagiert BlenderBot 3 so?

Wenn Sie auf die Antwort von BlenderBot 3 klicken, um weitere Informationen zu erhalten, scheint der Grund dafür ganz einfach zu sein: Es werden lediglich Informationen aus den beliebtesten Websuchergebnissen von Facebook abgerufen, und natürlich geht es in diesen Gesprächen ausschließlich um die Verletzung von Benutzerdaten durch Facebook.

Wenn Sie auf die Antwort von BlenderBot 3 klicken, um weitere Informationen zu erhalten, scheint der Grund dafür ganz einfach zu sein: Es werden lediglich Informationen aus den beliebtesten Websuchergebnissen von Facebook abgerufen, und natürlich geht es in diesen Gesprächen ausschließlich um die Verletzung von Benutzerdaten durch Facebook.

KI-Konversationsroboter haben noch einen langen Weg vor sich

Wie bei allen KI-Systemen werden die Reaktionen von Bots unweigerlich in rassistisches und voreingenommenes Terrain abdriften.

Meta erkennt auch an, dass der Bot voreingenommene und schädliche Reaktionen hervorrufen kann. Daher fordert das Unternehmen die Benutzer vor der Verwendung außerdem auf, zuzustimmen, dass es „unwahre oder beleidigende Kommentare abgeben darf“ und zuzustimmen, „den Bot nicht absichtlich auszulösen“. beleidigende Bemerkungen“

Diese Reaktion ist nicht allzu überraschend, wenn man bedenkt, dass BlenderBot 3 auf einem großen Modell mit künstlicher Intelligenz namens OPT-175B basiert. Facebooks eigene Forscher beschreiben diesen Modus als „eine hohe Tendenz, schädliche Sprache zu erzeugen und schädliche Stereotypen zu verstärken, selbst wenn relativ harmlose Aufforderungen zur Verfügung gestellt werden“.

Der Roboter wechselt oft nach Belieben das Thema, gibt steife und unbeholfene Antworten und klingt wie ein Außerirdischer, der menschliche Gespräche gelesen hat, aber noch nie eine solche geführt hat.

Ironischerweise veranschaulicht die Reaktion des Bots perfekt das Problem von KI-Systemen, die auf der Sammlung riesiger Mengen an Webdaten basieren: Sie werden immer auf das Ergebnis ausgerichtet sein, das im Datensatz stärker hervortritt, was offensichtlich der Fall ist Es spiegelt die Realität nicht immer genau wider.

Ironischerweise veranschaulicht die Reaktion des Bots perfekt das Problem von KI-Systemen, die auf der Sammlung riesiger Mengen an Webdaten basieren: Sie werden immer auf das Ergebnis ausgerichtet sein, das im Datensatz stärker hervortritt, was offensichtlich der Fall ist Es spiegelt die Realität nicht immer genau wider.

Meta AI schrieb in einem Blogbeitrag, in dem der Bot angekündigt wurde: „Es ist bekannt, dass alle Konversations-KI-Chatbots manchmal unsichere, voreingenommene oder beleidigende Kommentare nachahmen und generieren können, deshalb haben wir eine groß angelegte Studie durchgeführt, Workshops mitorganisiert und.“ hat neue Technologien entwickelt, um Sicherheit für BlenderBot 3 zu schaffen. „

“ Trotzdem kann BlenderBot immer noch unhöfliche oder respektlose Kommentare abgeben, weshalb wir Feedback sammeln , ist die Idee, dass Unternehmen Bots durch das Sammeln von mehr Daten weniger rassistisch und beängstigend machen können, bestenfalls phantasievoll.

KI-Ethikforscher haben wiederholt gewarnt, dass die KI-Sprachmodelle, die diese Systeme „antreiben“, grundsätzlich zu groß und unvorhersehbar sind, um faire und gerechte Ergebnisse zu garantieren. Selbst bei der Integration von Benutzerfeedback gibt es keine klare Möglichkeit, hilfreiches Feedback von bösartigem Feedback zu unterscheiden.

Natürlich wird das Unternehmen wie Meta nicht davon abhalten, es zu versuchen.

Das obige ist der detaillierte Inhalt vonFacebook-Chatbot explodiert: Unser Unternehmen verkauft Benutzerdaten, FB-Konto gelöscht, das Leben ist viel besser. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr