Heim >Technologie-Peripheriegeräte >KI >Datensätze und Fahrwahrnehmung bei sich wiederholenden und herausfordernden Wetterbedingungen

Datensätze und Fahrwahrnehmung bei sich wiederholenden und herausfordernden Wetterbedingungen

- 王林nach vorne

- 2023-04-08 19:11:081470Durchsuche

arXiv-Artikel „Ithaca365: Dataset and Driving Perception under Repeated and Challenging Weather Conditions“, hochgeladen am 1. August 22, Arbeit von den Universitäten Cornell und Ohio State.

In den letzten Jahren haben sich die Wahrnehmungsfähigkeiten autonomer Fahrzeuge durch den Einsatz großräumiger Datensätze verbessert, die häufig an bestimmten Orten und bei guten Wetterbedingungen gesammelt werden. Um jedoch hohe Sicherheitsanforderungen zu erfüllen, müssen diese Sensorsysteme unter verschiedenen Wetterbedingungen, einschließlich Schnee- und Regenbedingungen, robust funktionieren.

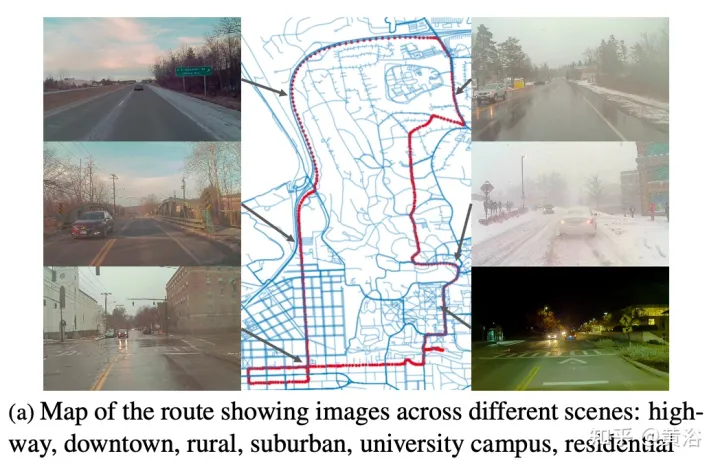

Dieser Artikel schlägt einen Datensatz vor, um mithilfe eines neuen Datenerfassungsprozesses ein robustes autonomes Fahren zu erreichen, d. h. in verschiedenen Szenarien (Stadt, Autobahn, ländliches Gebiet, Campus), Wetter (Schnee, Regen, Sonne), Zeit (Tag). (Nacht) ) und Verkehrsbedingungen (Fußgänger, Radfahrer und Autos) wurden die Daten entlang einer 15 km langen Strecke wiederholt aufgezeichnet.

Dieser Datensatz umfasst Bilder und Punktwolken von Kameras und Lidar-Sensoren sowie hochpräzises GPS/INS, um eine Korrespondenz über Routen hinweg herzustellen. Der Datensatz umfasst Straßen- und Objektanmerkungen, lokale Verdeckungen und 3D-Begrenzungsrahmen, die mit amodalen Masken erfasst wurden.

Wiederholte Pfade eröffnen neue Forschungsrichtungen für die Zielerkennung, kontinuierliches Lernen und die Erkennung von Anomalien.

Ithaca365-Link: Ein neuer Datensatz, der robustes autonomes Fahren über einen neuartigen Datenerfassungsprozess ermöglicht.

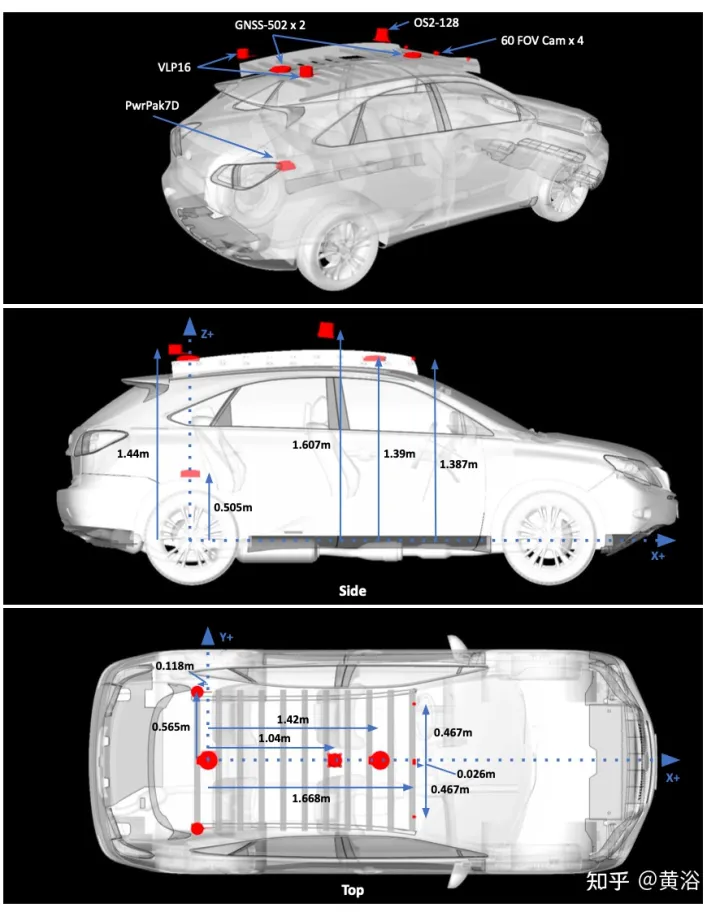

Bild ist die Sensorkonfiguration für die Datenerfassung:

Bild a zeigt die Roadmap mit Aufnahmen an mehreren Standorten. Die Fahrten sollten zu unterschiedlichen Tageszeiten, auch nachts, Daten sammeln. Zeichnen Sie starke Schneeverhältnisse vor und nach der Straßenräumung auf.

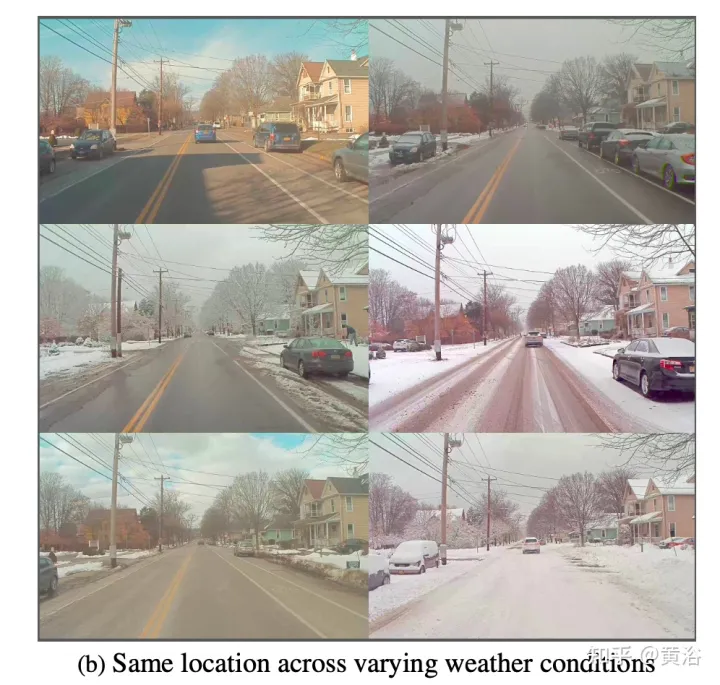

Ein wesentliches Merkmal des Datensatzes ist, dass dieselben Orte unter unterschiedlichen Bedingungen beobachtet werden können; ein Beispiel ist in Abbildung b dargestellt.

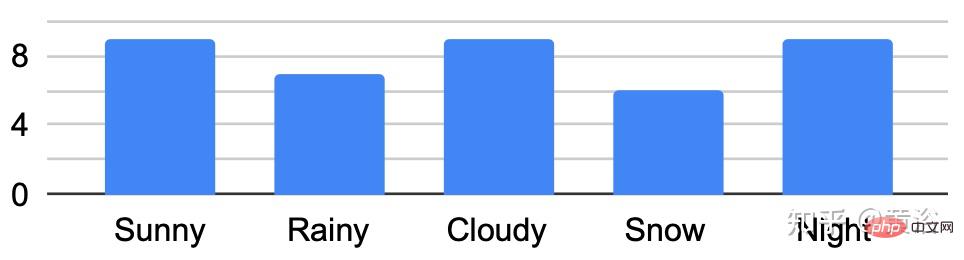

Die Abbildung zeigt die Durchquerungsanalyse unter verschiedenen Bedingungen:

Entwickeln Sie ein benutzerdefiniertes Beschriftungstool zum Erhalten nichtmodaler Masken von Straßen und Zielen. Verwenden Sie für Straßenmarkierungen unter unterschiedlichen Umgebungsbedingungen, z. B. schneebedeckten Straßen, wiederholte Durchquerungen derselben Route. Konkret wandelt die aus GPS-Lage- und LIDAR-Daten erstellte Punktwolken-Straßenkarte die Straßenbezeichnung „gutes Wetter“ in „schlechtes Wetter“ um.

Routen/Daten sind in 76 Intervalle unterteilt. Projizieren Sie die Punktwolke in BEV und beschriften Sie die Straße mit dem Polygon-Annotator. Sobald die Straße in BEV markiert ist (wodurch eine 2D-Straßengrenze generiert wird), wird das Polygon unter Verwendung eines Schwellenwerts von 1,5 m durchschnittlicher Höhe in kleinere 150 m² große Polygone zerlegt und eine ebene Anpassung an den Punkten innerhalb des Polygons durchgeführt Grenze zur Bestimmung der Straßenhöhe.

Passen Sie mithilfe von RANSAC und einem Regressor eine Ebene an diese Punkte an. Berechnen Sie dann die Höhe jedes Punkts entlang der Grenze anhand der geschätzten Grundebene. Projizieren Sie die Straßenpunkte in das Bild und erstellen Sie eine Tiefenmaske, um die nichtmodale Beschriftung der Straße zu erhalten. Durch den Abgleich von Standorten mit markierten Karten mit GPS und die Optimierung von Routen mit ICP kann die Bodenebene auf bestimmte Standorte auf neuen Sammelrouten projiziert werden.

Eine abschließende Überprüfung der ICP-Lösung durch Überprüfung, ob die durchschnittliche projizierte Ground-Truth-Maske der Straßenmarkierung mit allen anderen Ground-Truth-Masken am selben Standort übereinstimmt. Andernfalls werden die Abfragestandortdaten nicht abgerufen.

Amodale Ziele werden mit Scale AI für sechs Vordergrundzielkategorien gekennzeichnet: Autos, Busse, Lastwagen (einschließlich Fracht, Feuerwehrautos, Pickups, Krankenwagen), Fußgänger, Radfahrer und Motorradfahrer.

Dieses Etikettierungsparadigma besteht aus drei Hauptkomponenten: Zuerst werden sichtbare Instanzen eines Objekts identifiziert, dann werden verdeckte Instanzsegmentierungsmasken abgeleitet und schließlich wird die Okklusionsreihenfolge jedes Objekts markiert. Die Markierung erfolgt in der Kameraansicht ganz links nach vorne. Folgt den gleichen Standards wie KINS („Amodale Instanzsegmentierung mit Kins-Datensatz“. CVPR, 2019).

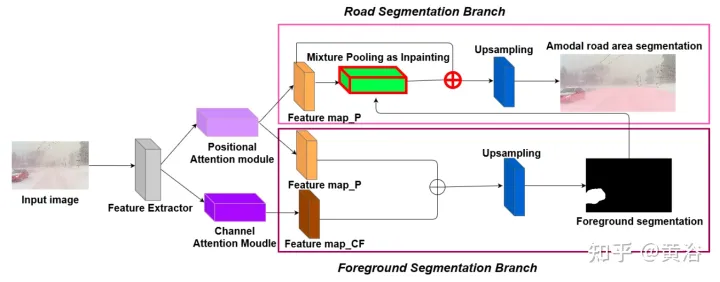

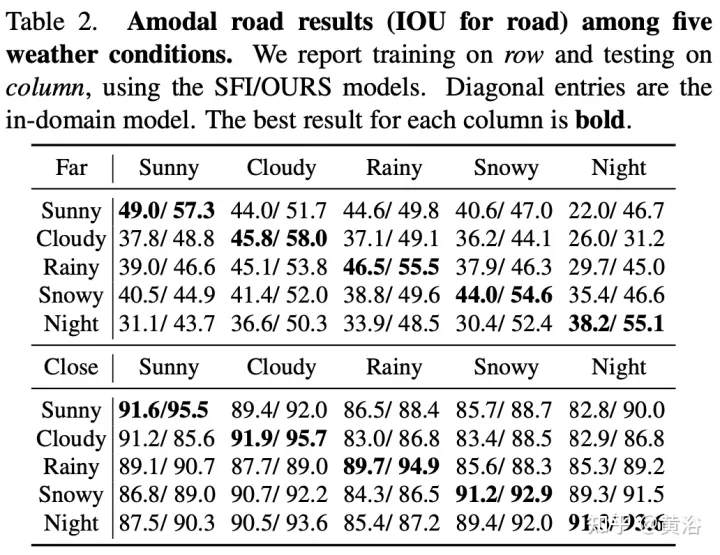

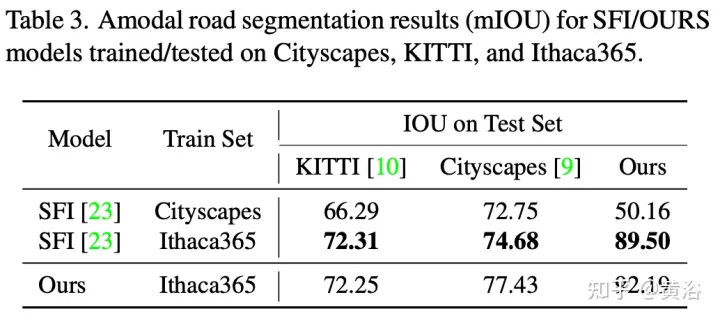

Um die Umweltvielfalt und die amodale Qualität des Datensatzes zu demonstrieren, wurden zwei Basisnetzwerke trainiert und getestet, um amodale Straßen auf Pixelebene zu identifizieren, die auch dann funktionieren, wenn die Straßen mit Schnee oder Autos bedeckt sind. Das erste Basisnetzwerk ist Semantic Foreground Inpainting (SFI). Die zweite Baseline, wie in der Abbildung dargestellt, nutzt die folgenden drei Innovationen, um den SFI zu verbessern.

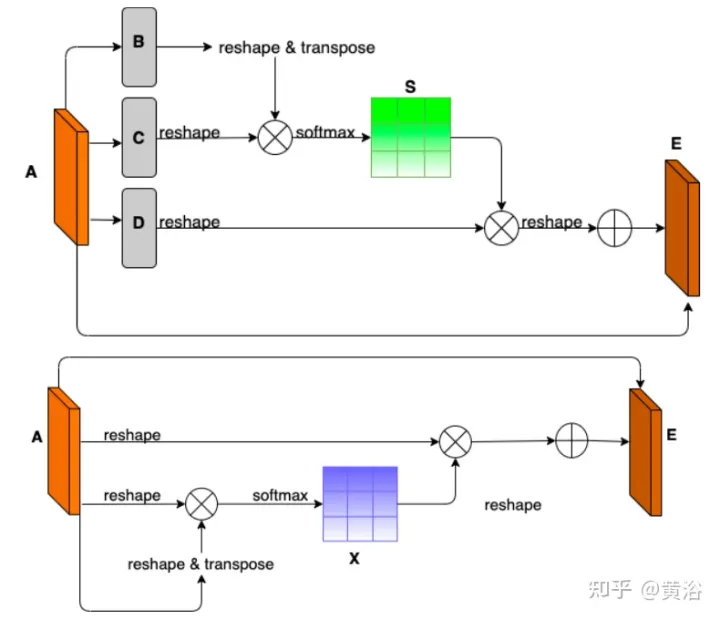

- Position und Kanal Hinweis: Da die amodale Segmentierung hauptsächlich auf das Unsichtbare schließen lässt, ist der Kontext ein sehr wichtiger Anhaltspunkt. DAN („Dual Attention Network for Scene Segmentation“, CVPR’2019) stellt zwei Innovationen vor, um zwei unterschiedliche Hintergründe zu erfassen. Das Position Attention Module (PAM) verwendet Pixelfunktionen, um sich auf andere Pixel des Bildes zu konzentrieren und tatsächlich den Kontext von anderen Teilen des Bildes zu erfassen. Das Channel Attention Module (CAM) verwendet einen ähnlichen Aufmerksamkeitsmechanismus, um Kanalinformationen effizient zu aggregieren. Hier werden diese beiden Module auf den Backbone-Feature-Extraktor angewendet. Kombination von CAM und PAM zur besseren Lokalisierung feiner Maskengrenzen. Die endgültige Vordergrundinstanzmaske wird durch eine Upsampling-Ebene erhalten.

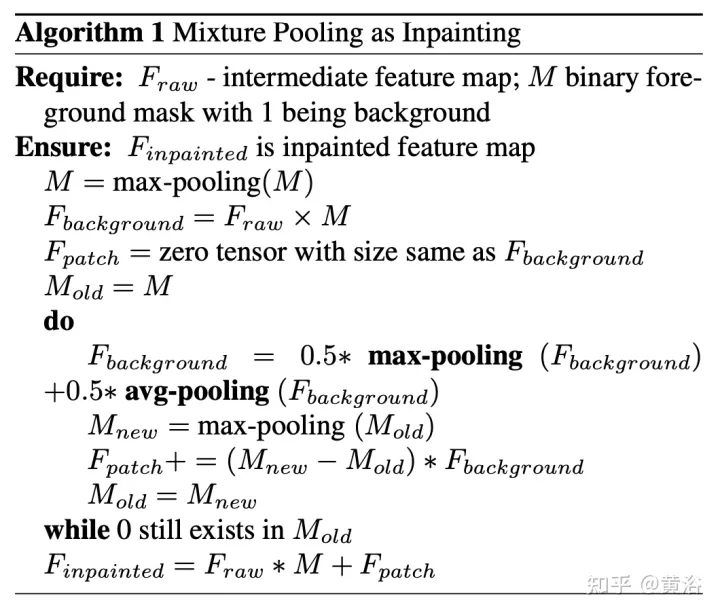

- Hybrides Pooling als Inpainting: Maximales Pooling wird als Inpainting-Vorgang verwendet, um überlappende Vordergrund-Features durch nahegelegene Hintergrund-Features zu ersetzen und so nichtmodale Straßen-Features wiederherzustellen. Da Hintergrundfunktionen jedoch normalerweise gleichmäßig verteilt sind, reagiert der Max-Pooling-Vorgang sehr empfindlich auf zusätzliches Rauschen. Im Gegensatz dazu verringern durchschnittliche Pooling-Vorgänge den Lärm auf natürliche Weise. Zu diesem Zweck werden durchschnittliches Pooling und maximales Pooling zum Patchen kombiniert, was als Mixture Pooling bezeichnet wird.

- Summenoperation: Vor der letzten Upsampling-Schicht werden die Features aus dem Hybrid-Pooling-Modul nicht direkt übergeben, sondern die restlichen Links aus der Ausgabe des PAM-Moduls werden einbezogen. Durch die gemeinsame Optimierung zweier Feature-Maps im Straßensegmentierungszweig kann das PAM-Modul auch Hintergrundfeatures von verdeckten Bereichen lernen. Dies kann zu einer genaueren Wiederherstellung von Hintergrundfunktionen führen.

Das Bild zeigt das Architekturdiagramm von PAM und CAM:

Der Algorithmus-Pseudocode für das Patchen durch Hybrid-Pooling lautet wie folgt:

Der Trainings- und Testcode für die nichtmodale Straßensegmentierung lautet wie folgt folgt: https://github.com/coolgrasshopper/amodal_road_segmentation

Die experimentellen Ergebnisse sind wie folgt:

Das obige ist der detaillierte Inhalt vonDatensätze und Fahrwahrnehmung bei sich wiederholenden und herausfordernden Wetterbedingungen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr