Heim >Technologie-Peripheriegeräte >KI >Das neueste Bildgenerierungstool von Meta ist so beliebt, dass es Träume in die Realität umsetzen kann!

Das neueste Bildgenerierungstool von Meta ist so beliebt, dass es Träume in die Realität umsetzen kann!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-08 17:11:041438Durchsuche

Die KI kann sehr gut zeichnen.

Vor Kurzem hat Meta auch einen KI-„Maler“ entwickelt – Make-A-Scene.

Denken Sie immer noch, dass es so einfach ist, nur Text zu verwenden, um Bilder zu erstellen?

Sie müssen wissen, dass es manchmal „umkippen“ kann, wenn man sich nur auf Textbeschreibungen verlässt, wie zum Beispiel die „Künstler“-Parti, die Google vor einiger Zeit ins Leben gerufen hat.

„Ein Teller ohne Banane und ein Glas ohne Orangensaft daneben.“

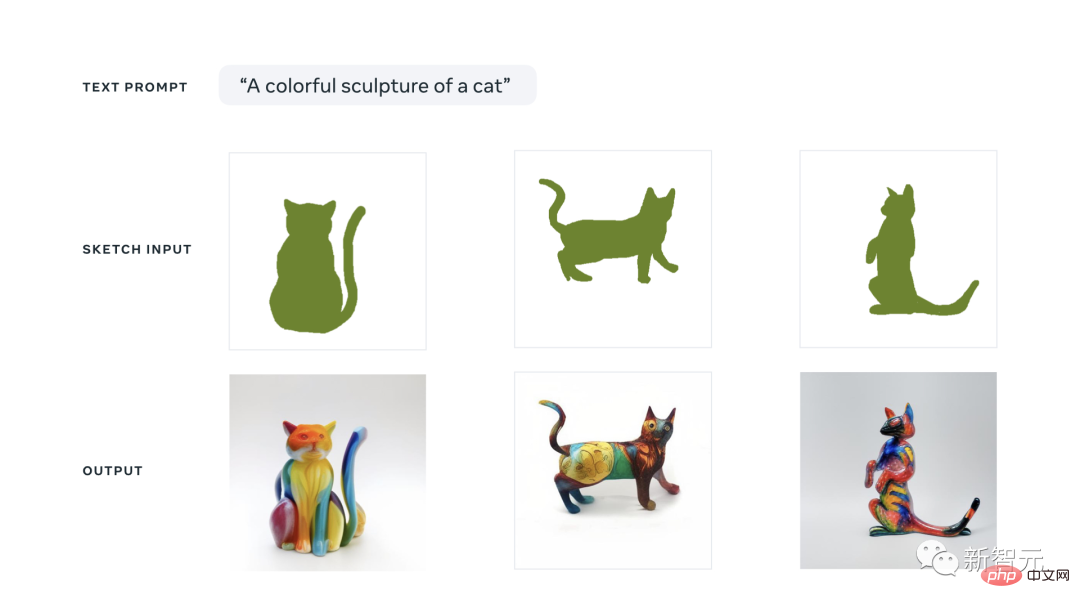

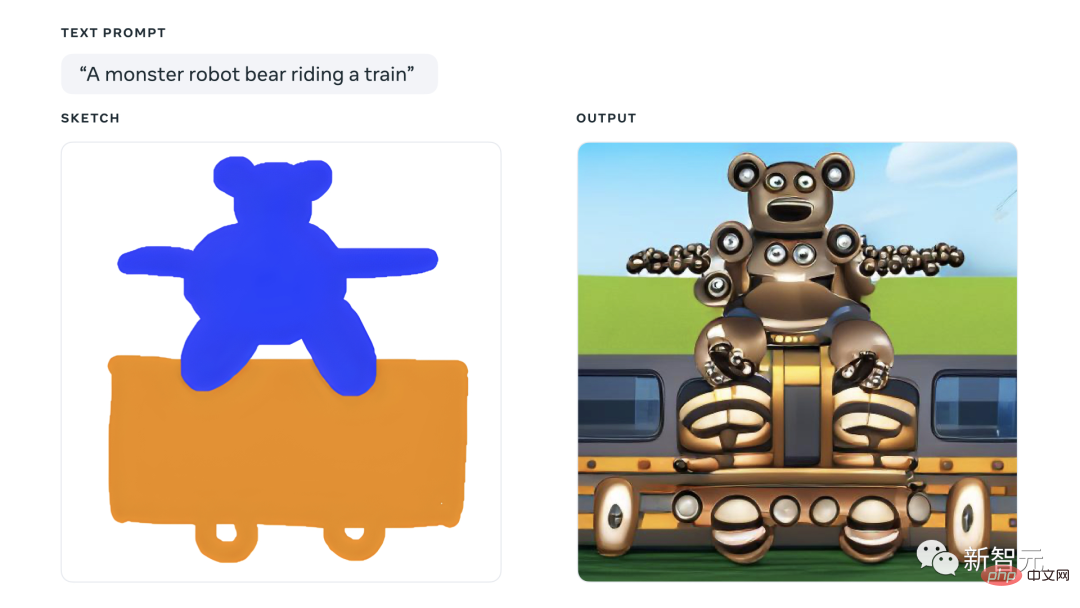

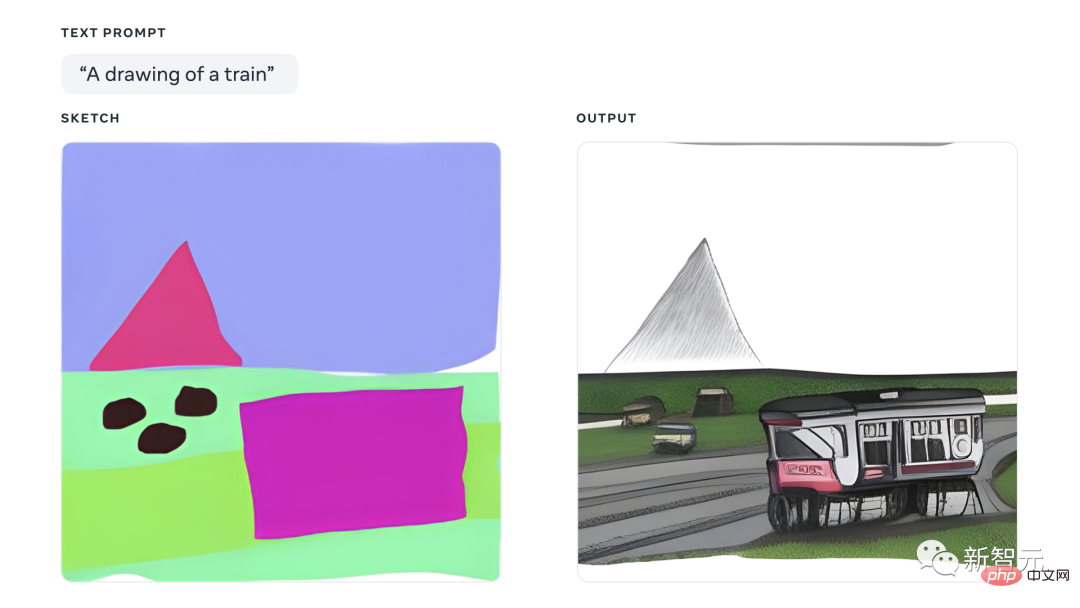

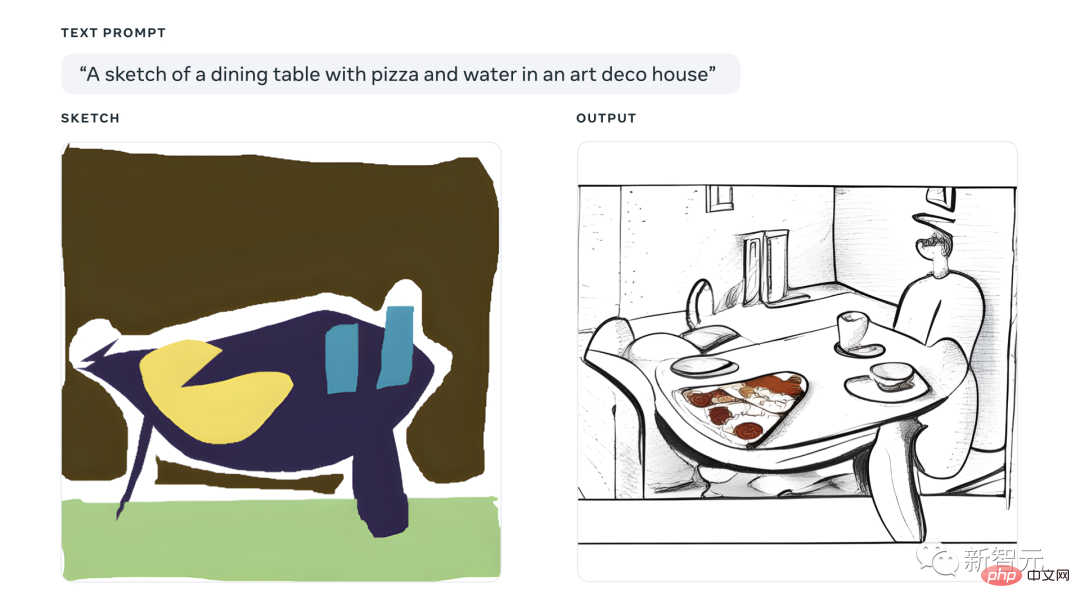

Dieses Mal kann Make-A-Scene durch eine Textbeschreibung und eine Skizze das generieren, was Sie möchten.

Sie haben das letzte Wort über oben und unten, links und rechts, Größe, Form und andere Elemente der Komposition.

Sogar LeCun ist herausgekommen, um für seine eigenen Produkte zu werben, der Schlüssel liegt in der „Kontrollbarkeit“!

Make-A-Scene ist so großartig, schauen wir uns das gemeinsam an.

Metas Zauberstift Ma Liang

Alles reden ohne Übung, falsche Tricks!

Sehen wir uns an, wie Menschen Make-A-Scene nutzen, um ihre Fantasie zu verwirklichen.

Das Forschungsteam wird eine Make-A-Scene-Demonstrationssitzung mit bekannten Künstlern der künstlichen Intelligenz durchführen.

Das Künstlerteam verfügt über eine starke Besetzung, darunter Sofia Crespo, Scott Eaton, Alexander Reben, Refik Anadol usw. Diese Meister verfügen über Erfahrungen aus erster Hand in der Anwendung generativer künstlicher Intelligenz.

Das Forschungs- und Entwicklungsteam ermöglicht es diesen Künstlern, Make-A-Scene als Teil des kreativen Prozesses zu nutzen und während der Nutzung Feedback zu geben.

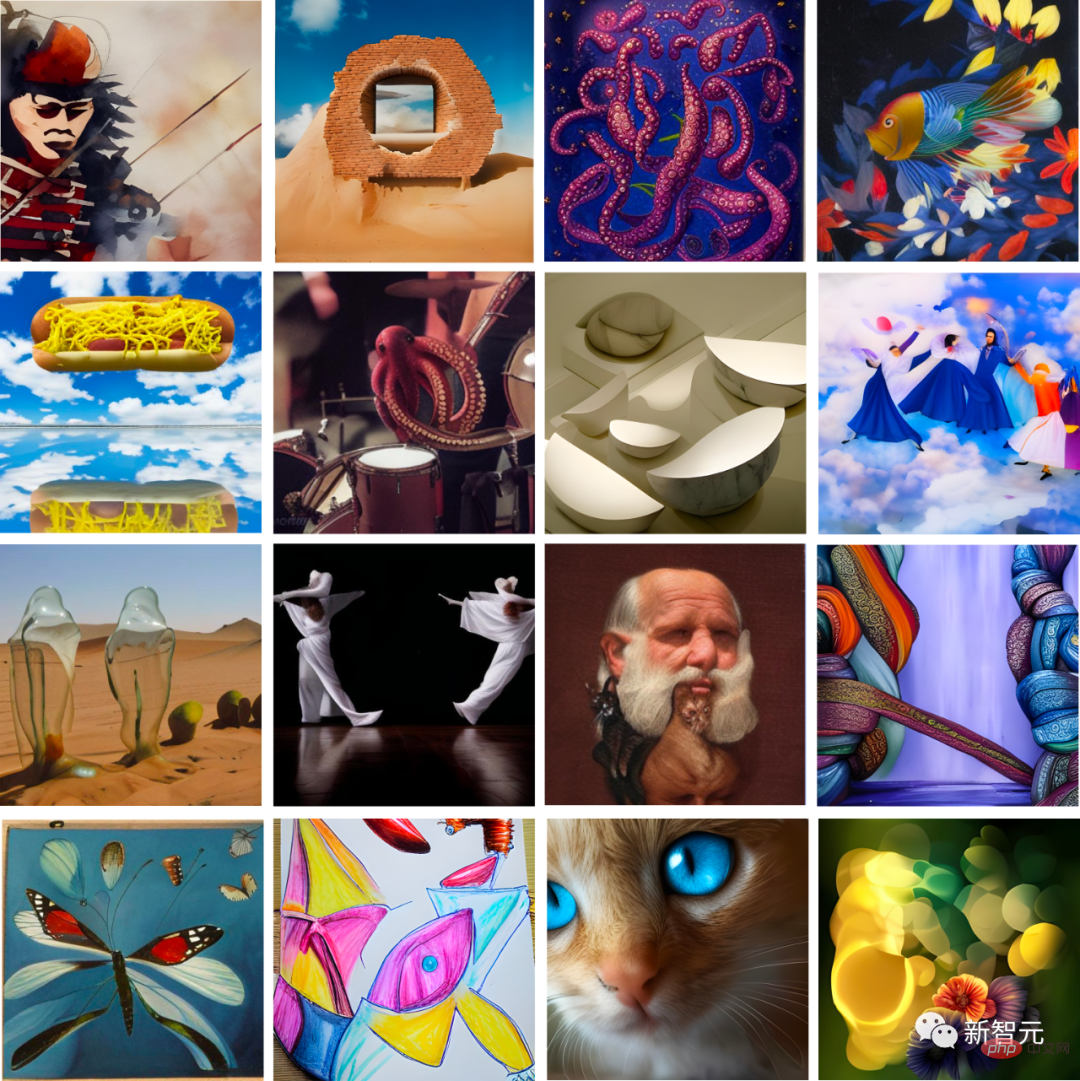

Als nächstes wollen wir die Werke bewundern, die die Meister mit Make-A-Scene geschaffen haben.

Zum Beispiel ist Sofia Crespo eine Künstlerin, die sich auf die Schnittstelle von Natur und Technologie konzentriert. Sie liebte es, sich künstliche Lebensformen vorzustellen, die es nie gab, und nutzte daher die Zeichen- und Texteingabefunktionen von Make-A-Scene, um brandneue „Hybridkreaturen“ zu erschaffen.

Zum Beispiel blütenförmige Quallen.

Crespo nutzt seine kostenlosen Zeichenfunktionen, um schnell neue Ideen umzusetzen. Sie sagte, dass Make-A-Scene Künstlern helfen wird, ihre Kreativität besser zum Ausdruck zu bringen und es Künstlern ermöglichen wird, über eine intuitivere Benutzeroberfläche zu zeichnen.

(Blumenqualle)

Scott Eaton ist ein Künstler, Pädagoge und kreativer Technologe, der die Beziehung zwischen zeitgenössischen Realitäten und Technologie untersucht.

Er nutzte Make-A-Scene als Möglichkeit, eine Szene zu komponieren und dabei Veränderungen in der Szene durch verschiedene Hinweise zu erforschen, beispielsweise durch die Verwendung von Themen wie „sinkende und verfallende Wolkenkratzer in der Wüste“, um die Klimakrise hervorzuheben.

(Wolkenkratzer in der Wüste)

Alexander Reben ist Künstler, Forscher und Robotiker.

Er glaubt, dass es wirklich hilfreich sein wird, seine künstlerischen Absichten zum Ausdruck zu bringen, wenn er mehr Kontrolle über den Output hat. Er integriert diese Werkzeuge in seine fortlaufende Serie.

Für den Medienkünstler und Regisseur Refik Anadol ist dieses Tool eine Möglichkeit, die Entwicklung der Vorstellungskraft zu fördern und unbekannte Gebiete besser zu erkunden.

Tatsächlich ist dieses Prototyping-Tool nicht nur für Menschen gedacht, die sich für Kunst interessieren.

Das Forschungsteam glaubt, dass Make-A-Scene jedem helfen kann, sich besser auszudrücken, auch solchen mit geringem künstlerischen Talent.

Zunächst stellte das Forschungsteam den Mitarbeitern der Meida Company teilweise Nutzungsrechte zur Verfügung. Sie testen und geben Feedback zu ihren Erfahrungen mit Make-A-Scene.

Meda-Projektmanager Andy Boyatzis nutzt Make-A-Scene, um mit seinen Zwei- und Vierjährigen Kunst zu schaffen. Mit spielerischen Zeichnungen erwecken sie ihre Ideen und Fantasie zum Leben.

Das Folgende ist ihre Arbeit~

Eine bunte Skulpturenkatze~ Ist das nicht süß? Aber diese Farbe ist tatsächlich ein bisschen unerträglich anzusehen, wie ein Kind, das einen großen Klumpen Plastilin zusammenknetet.

Ein Monsterbär fährt mit einem Zug. Im Ernst, Menschen mit Kryptophobie sollten sich fernhalten. Der Redakteur sprang sofort nach oben, nachdem er dieses Bild gelesen hatte. Schauen Sie sich diese seltsamen Arme an, einen Körper wie ein Gesicht, Räder wie Augäpfel ...

Ein Berggipfel. Ehrlich gesagt ist dieses Bild ziemlich künstlerisch. Aber haben Sie das Gefühl, dass die Berge in der Ferne und der kleine Zug in der Nähe überhaupt nicht den gleichen Stil haben?

Technologie dahinter

Obwohl aktuelle Methoden eine anständige Konvertierung zwischen Text- und Bilddomänen ermöglichen, weisen sie immer noch einige Schlüsselprobleme auf, die nicht gut gelöst sind: Steuerbarkeit, menschliche Wahrnehmung, Bildqualität.

Die Methode dieses Modells verbessert bis zu einem gewissen Grad die Strukturkonsistenz und Bildqualität.

Die gesamte Szene besteht aus drei komplementären semantischen Segmentierungsgruppen (Panorama, Mensch und Gesicht).

Durch die Kombination der drei extrahierten semantischen Segmentierungsgruppen lernt das Netzwerk, das Layout und die Bedingungen der Semantik zu generieren, um das endgültige Bild zu generieren.

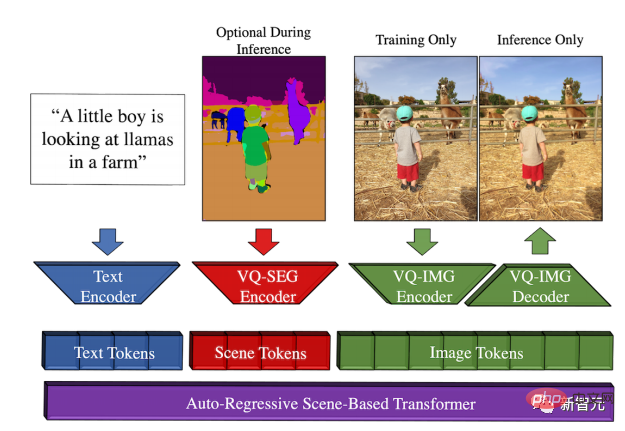

Um den Token-Raum der Szene zu erstellen, haben die Autoren „VQ-SEG“ übernommen, eine Verbesserung gegenüber „VQ-VAE“.

In dieser Implementierung sind der Ein- und Ausgang von „VQ-SEG“ m-Kanäle. Zusätzliche Kanäle sind Karten von Kanten, die verschiedene Klassen und Instanzen trennen. Randkanäle sorgen für die Trennung benachbarter Instanzen derselben Klasse und heben seltene Klassen von hoher Bedeutung hervor.

Da beim Training des „VQ-SEG“-Netzwerks jeder Gesichtsteil eine relativ kleine Anzahl von Pixeln im Szenenraum einnimmt, führt dies zur Rekonstruktion der Gesichtsteile (wie Augen, Nase, Lippen, Augenbrauen) im Szene Die semantische Segmentierung wird häufig reduziert.

In diesem Zusammenhang versuchten die Autoren, den gewichteten binären Kreuzentropie-Gesichtsverlust basierend auf der segmentierten Gesichtsteilklassifizierung zu verwenden, um die Bedeutung des Gesichtsteils hervorzuheben. Darüber hinaus werden die Kanten der Gesichtsteile auch als Teil der oben erwähnten semantischen Segmentierungskantenkarte verwendet.

Die Autoren verwenden anstelle eines dedizierten Gesichtseinbettungsnetzwerks ein vorab trainiertes VGG-Netzwerk, das auf dem ImageNet-Datensatz trainiert wurde, und führen einen Feature-Matching-Verlust ein, der den Wahrnehmungsunterschied zwischen dem rekonstruierten Bild und dem realen Bild darstellt.

Durch die Verwendung von Feature Matching und das Hinzufügen zusätzlicher Upsampling- und Downsampling-Layer zum Encoder und Decoder in VQ-IMG kann die Auflösung des Ausgabebildes von 256×256 erhöht werden.

Ich glaube, jeder kennt Transformer. Was ist also ein szenenbasierter Transformer?

Es basiert auf einem autoregressiven Transformer mit drei unabhängigen und kontinuierlichen Token-Räumen, nämlich Text, Szene und Bild.

Die Token-Sequenz besteht aus einem vom BPE-Encoder codierten Text-Token, einem von VQ-SEG codierten Szenen-Token und einem von VQ-IMG codierten oder decodierten Bild-Token.

Vor dem Training des szenenbasierten Transformers entspricht jede codierte Token-Sequenz einem [Text, Szene, Bild]-Tupel, das mit dem entsprechenden Encoder extrahiert wird.

Darüber hinaus haben die Autoren auch das klassifikatorfreie Bootstrapping übernommen, bei dem es sich um den Prozess der Weiterleitung bedingungsloser Proben zu bedingten Proben handelt.

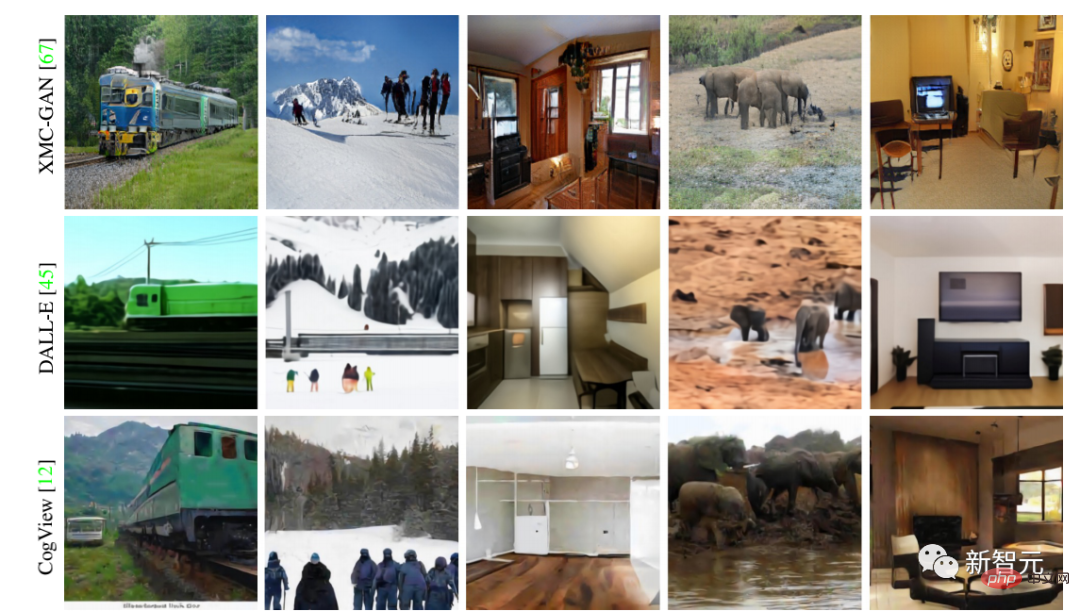

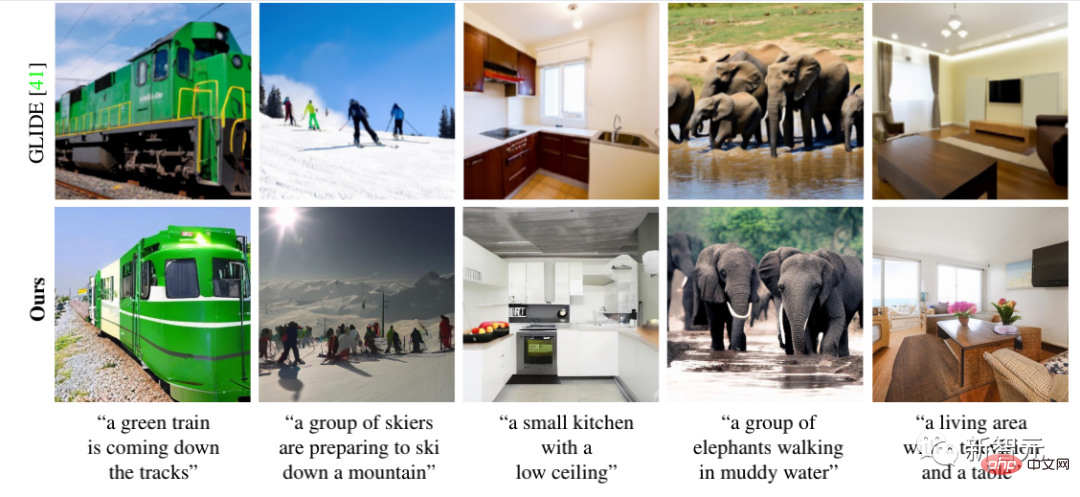

Dieses Modell erzielt SOTA-Ergebnisse. Werfen wir einen detaillierten Blick auf den Vergleich mit der vorherigen Methode

Jetzt haben die Forscher Make-A-Scene auch in ein Super-Resolution-Netzwerk integriert, das Bilder mit einer Auflösung von 2048 x 2048 erzeugen kann, was der vierfachen Auflösung entspricht.

ist wie folgt:

Tatsächlich lernt Make-A-Scene wie andere generative KI-Modelle die Beziehung zwischen Vision und Text durch Training an Millionen von Beispielbildern.

Es ist unbestreitbar, dass sich in den Trainingsdaten widergespiegelte Verzerrungen auf die Ausgabe dieser Modelle auswirken.

Wie die Forscher betonten, gibt es bei Make-A-Scene noch viel zu verbessern.

Das obige ist der detaillierte Inhalt vonDas neueste Bildgenerierungstool von Meta ist so beliebt, dass es Träume in die Realität umsetzen kann!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr