Heim >Technologie-Peripheriegeräte >KI >Ein Artikel zum Verständnis der Edge-Computing-Technologie in autonomen Fahrsystemen

Ein Artikel zum Verständnis der Edge-Computing-Technologie in autonomen Fahrsystemen

- WBOYnach vorne

- 2023-04-08 17:01:011638Durchsuche

Mit dem Aufkommen der 5G-Ära ist Edge Computing zu einem neuen Geschäftswachstumspunkt für autonome Fahrsysteme geworden. In Zukunft werden mehr als 60 % der Daten und Anwendungen am Edge generiert und verarbeitet.

Edge Computing ist ein neues Computermodell, das Berechnungen am Rande des Netzwerks durchführt. Die Datenverarbeitung umfasst hauptsächlich zwei Teile: einen Downlink-Cloud-Dienst und einen Uplink-Internet-of-Everything-Dienst. „Edge“ ist eigentlich ein relativer Begriff und bezieht sich auf alle Rechen-, Speicher- und netzwerkbezogenen Ressourcen auf dem Weg von den Daten zum Cloud-Rechenzentrum. Von einem Ende der Daten bis zum anderen Ende des Cloud-Service-Centers kann der Edge basierend auf den spezifischen Anforderungen der Anwendung und den tatsächlichen Anwendungsszenarien als ein oder mehrere Ressourcenknoten auf diesem Pfad dargestellt werden. Der geschäftliche Kern des Edge Computing besteht in der Erweiterung und Weiterentwicklung der Aggregationsknoten des Cloud Computing außerhalb des Rechenzentrums. Es besteht hauptsächlich aus drei Arten von Implementierungsformen: Edge Cloud, Edge Network und Edge Gateway.

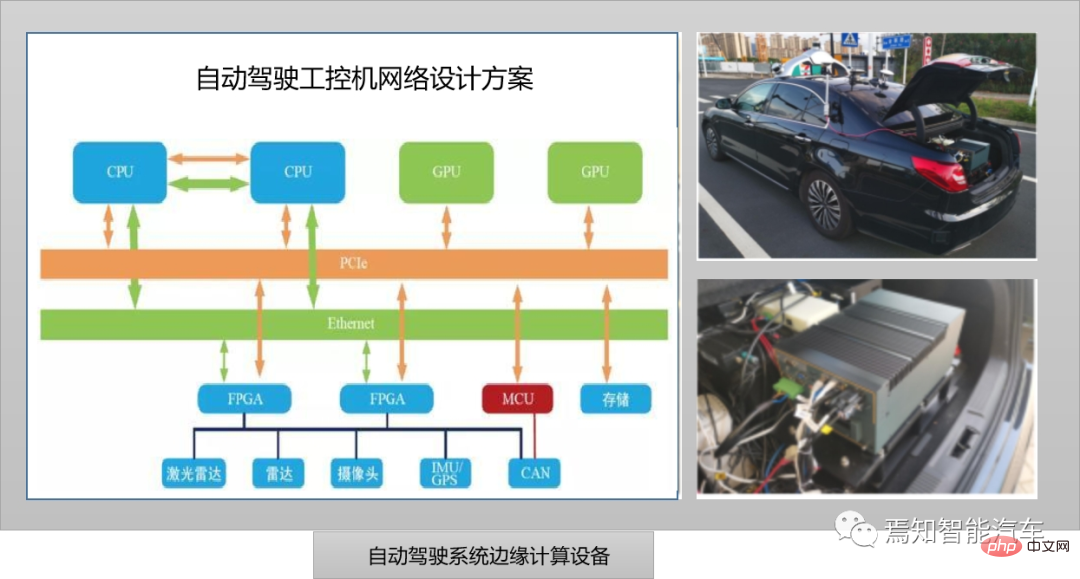

Wie im Bild oben zu sehen ist, handelt es sich um einen Industriecomputer, der derzeit im autonomen Fahren eingesetzt wird. Tatsächlich handelt es sich um einen robusten, verbesserten Personalcomputer. Es kann in einer industriellen Umgebung zuverlässig als Industriesteuerung betrieben werden. Es verwendet ein Ganzstahl-Industriegehäuse, das den EIA-Standards entspricht, um seine Widerstandsfähigkeit gegen elektromagnetische Störungen zu verbessern. Außerdem nutzt es eine Busstruktur und modulare Designtechnologie, um einzelne Fehlerquellen zu verhindern . Der obige Entwurfsplan für ein industrielles Computernetzwerk für autonomes Fahren berücksichtigt vollständig die Anforderungen von ISO26262. Darunter sind CPU, GPU, FPGA und Bus alle auf Redundanz ausgelegt. Wenn das gesamte IPC-System ausfällt, kann die redundante MCU-Steuerung die Computersicherheit gewährleisten und Anweisungen direkt an den CAN-Bus des Fahrzeugs senden, um das Parken des Fahrzeugs zu steuern. Derzeit eignet sich diese zentralisierte Architektur für die nächste Generation zentralisierter autonomer Fahrsystemlösungen. Der Industriecomputer entspricht der nächsten Generation zentralisierter Domänencontroller, die die gesamte Rechenarbeit in einem vereinheitlichen und keine übermäßige Berücksichtigung der Hardware erfordern . Allgemeine Upgrade- und Fahrzeugvorschriften.

Edge Computing und Edge Cloud

Beim aktuellen autonomen Fahren werden groß angelegte Algorithmenmodelle für künstliche Intelligenz und groß angelegte zentralisierte Datenanalysen in der Cloud durchgeführt. Da die Cloud über große Rechenressourcen verfügt und die Datenverarbeitung in sehr kurzer Zeit abschließen kann, ist es in vielen Fällen nicht möglich, sich bei der Bereitstellung von Diensten für autonome Fahrzeuge ausschließlich auf die Cloud zu verlassen. Denn autonome Fahrzeuge erzeugen während der Fahrt eine große Datenmenge, die in Echtzeit verarbeitet werden muss. Wenn diese Daten zur Verarbeitung über das Kernnetzwerk an die Remote-Cloud übertragen werden, führt die Datenübertragung allein zu einer großen Verzögerung und kann nicht erfüllt werden die Anforderungen an die Datenverarbeitung. Die Bandbreite des Kernnetzwerks ist auch schwierig, eine große Anzahl selbstfahrender Autos gleichzeitig zu unterstützen, die große Datenmengen an die Cloud senden. Sobald das Kernnetzwerk überlastet ist und die Datenübertragung instabil ist, kann das Fahren außerdem schwierig sein Die Sicherheit selbstfahrender Autos kann nicht gewährleistet werden.

Edge Computing konzentriert sich auf lokale Unternehmen, hat hohe Echtzeitanforderungen, hohen Netzwerkdruck und die Rechenmethode ist auf Lokalisierung ausgerichtet. Edge Computing eignet sich besser für die lokale intelligente Analyse und Vorverarbeitung in kleinem Maßstab auf der Grundlage integrierter Algorithmusmodelle. Die Anwendung von Edge Computing im Bereich des autonomen Fahrens wird dazu beitragen, die Probleme autonomer Fahrzeuge bei der Erfassung und Verarbeitung von Umweltdaten zu lösen.

Als zwei wichtige Computermethoden für die digitale Transformation der Branche existieren Edge Computing und Cloud Computing grundsätzlich nebeneinander, ergänzen sich und fördern sich gegenseitig, um Computerprobleme im Big-Data-Zeitalter gemeinsam zu lösen.

Edge Computing bezieht sich auf ein Computermodell, das Berechnungen am Rande des Netzwerks durchführt. Seine Betriebsobjekte stammen aus den Downstream-Daten von Cloud-Diensten und den Upstream-Daten von Internet of Everything-Diensten zu den Daten von der Datenquelle zu den beliebigen Computer- und Netzwerkressourcen zwischen Cloud-Computing-Center-Pfaden. Kurz gesagt: Beim Edge Computing werden Server an Edge-Knoten in der Nähe von Benutzern bereitgestellt, um Benutzern am Rand des Netzwerks Dienste bereitzustellen (z. B. drahtlose Zugangspunkte), wodurch Datenübertragungen über große Entfernungen vermieden werden und Benutzer schnellere Antworten erhalten. Die Task-Offloading-Technologie verlagert die Rechenaufgaben autonomer Fahrzeuge zur Ausführung auf andere Randknoten und löst so das Problem unzureichender Rechenressourcen für autonome Fahrzeuge.

Edge Computing zeichnet sich durch Nähe, geringe Latenz, Lokalität und Standortbewusstsein aus. Unter anderem bedeutet Nähe, dass sich Edge Computing in der Nähe der Informationsquelle befindet. Es eignet sich zum Erfassen und Analysieren wichtiger Informationen in Big Data. Es kann direkt auf das Gerät zugreifen, Edge Intelligence effizienter bereitstellen und spezifische Anwendungsszenarien einfach ableiten . Geringe Latenz bedeutet, dass sich Edge-Computing-Dienste in der Nähe der Endgeräte befinden, die Daten generieren. Dadurch wird die Latenz insbesondere bei Smart-Driving-Anwendungsszenarien erheblich reduziert, was den Feedback-Prozess beschleunigt. Lokalität bedeutet, dass Edge Computing isoliert vom Rest des Netzwerks ausgeführt werden kann, um eine lokalisierte, relativ unabhängige Datenverarbeitung zu erreichen. Einerseits gewährleistet es die lokale Datensicherheit und andererseits verringert es die Abhängigkeit der Datenverarbeitung von der Netzwerkqualität. Standorterkennung bedeutet, dass lokale Dienste im Edge-Computing-Stil relativ wenige Informationen verwenden können, um den Standort aller verbundenen Geräte zu bestimmen, wenn das Edge-Netzwerk Teil eines drahtlosen Netzwerks ist. Diese Dienste können auf standortbasierte Dienstanwendungsszenarien angewendet werden.

Gleichzeitig wird sich der Entwicklungstrend des Edge Computing schrittweise in Richtung heterogenes Computing, Edge Intelligence, Edge-Cloud-Zusammenarbeit und 5G+ Edge Computing entwickeln. Heterogenes Rechnen erfordert die Verwendung von Recheneinheiten mit unterschiedlichen Befehlssätzen und Architekturen, um ein Rechensystem zu bilden, das den Anforderungen von Edge-Diensten für vielfältiges Rechnen gerecht wird. Heterogenes Rechnen kann nicht nur die Anforderungen der neuen Generation von „Connection + Computing“ erfüllen „Der Aufbau einer Infrastruktur kann auch die Anforderungen fragmentierter Industrien und differenzierter Anwendungen erfüllen, die Auslastung der Rechenressourcen verbessern und die flexible Bereitstellung und Planung der Rechenleistung unterstützen.“

Edge Computing-Referenzarchitektur

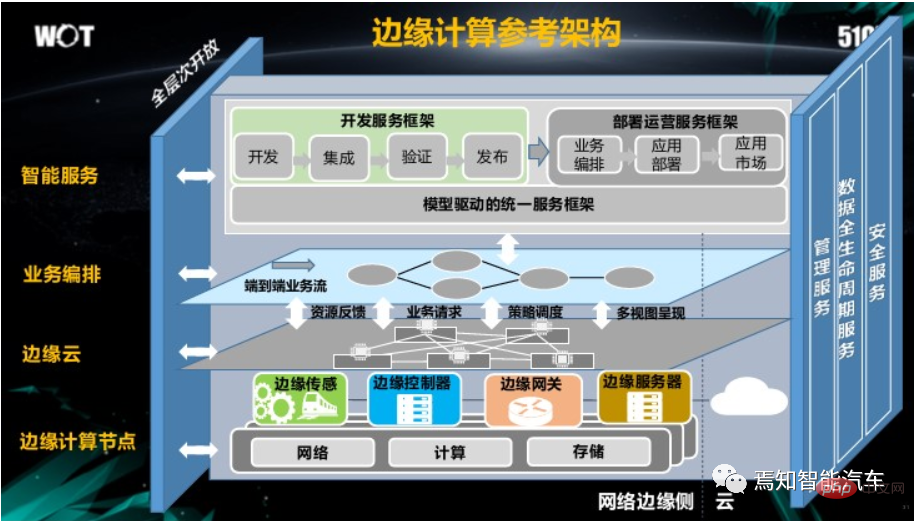

Jede Schicht der Edge-Computing-Referenzarchitektur bietet eine modellierte offene Schnittstelle, die durch vertikale Verwaltungsdienste, Dienste für den gesamten Datenlebenszyklus und Sicherheitsdienste eine vollständige Offenheit der Architektur ermöglicht Intelligente Services im gesamten Geschäftsprozess und Lebenszyklus.

Wie in der Abbildung oben gezeigt, umfasst die Edge-Computing-Referenzarchitektur hauptsächlich die folgenden Inhalte:

Das gesamte System ist in vier Schichten unterteilt: intelligenter Service, Geschäftsorchestrierung, Edge-Cloud und Edge-Computing-Knoten . Edge Computing befindet sich in der Cloud und vor Ort. Zwischen Geräten unterstützt die Edge-Schicht den Zugriff verschiedener Feldgeräte nach unten und kann nach oben eine Verbindung zur Cloud herstellen. Die Edge-Schicht besteht aus zwei Hauptteilen: Edge-Knoten und Edge-Manager. Der Edge-Knoten ist eine Hardware-Einheit und stellt den Kern für die Bereitstellung von Edge-Computing-Diensten dar. Der Kern des Edge-Managers ist Software, und seine Hauptfunktion besteht darin, Edge-Knoten einheitlich zu verwalten. Edge-Computing-Knoten verfügen im Allgemeinen über Rechenressourcen, Netzwerkressourcen und Speicherressourcen. Das Edge-Computing-System nutzt Ressourcen auf zwei Arten: Erstens kapselt es die Rechenressourcen, Netzwerkressourcen und Speicherressourcen direkt und stellt eine aufrufende Schnittstelle bereit Ressourcen werden beim Code-Download, bei der Netzwerkrichtlinienkonfiguration und bei Datenbankoperationen verwendet. Zweitens werden Edge-Knotenressourcen je nach Funktionsbereich weiter in Funktionsmodule gekapselt, und der Edge-Manager kombiniert und ruft Funktionsmodule durch modellgesteuerte Geschäftsorchestrierung auf, um eine integrierte Entwicklung zu erreichen und agile Bereitstellung von Edge-Computing-Diensten.

Hardware-Infrastruktur für Edge-Computing

1. Edge-Server

Der Edge-Server ist der Hauptrechnerträger für Edge-Computing und Edge-Rechenzentren und kann in einem Computerraum des Betreibers eingesetzt werden. Da Edge-Computing-Umgebungen sehr unterschiedlich sind und Edge-Dienste individuelle Anforderungen in Bezug auf Latenz, Bandbreite, GPU und KI haben, sollten Ingenieure Vor-Ort-Vorgänge minimieren und über starke Verwaltungs- und Betriebsfunktionen verfügen, einschließlich Statuserfassung, Betriebssteuerung und Verwaltungsschnittstelle Erzielen Sie eine Remote- und automatisierte Verwaltung.

In autonomen Fahrsystemen werden in der Regel intelligente Edge-All-in-One-Maschinen verwendet, um Rechen-, Speicher-, Netzwerk-, Virtualisierungs- und Umweltenergieprodukte organisch in einen Industriecomputer zu integrieren und so den normalen Betrieb des autonomen Fahrens zu ermöglichen System.

2. Edge-Zugangsnetzwerk

Das Edge-Computing-Zugangsnetzwerk bezieht sich auf eine Reihe von Netzwerkinfrastrukturen, die vom Benutzersystem zum Edge-Computing-System übergehen, einschließlich, aber nicht beschränkt auf, Campus-Netzwerk, Zugangsnetzwerk usw Edge-Gateways usw. Es verfügt außerdem über Funktionen wie Konvergenz, geringe Latenz, große Bandbreite, große Verbindungen und hohe Sicherheit.

3. Edge internes Netzwerk

Das interne Edge-Computing-Netzwerk bezieht sich auf die interne Netzwerkinfrastruktur des Edge-Computing-Systems, z. B. mit dem Server verbundene Netzwerkgeräte, mit dem externen Netzwerk verbundene Netzwerkgeräte und das von ihm aufgebaute Netzwerk usw. Das interne Netzwerk des Edge Computing zeichnet sich durch eine vereinfachte Architektur, vollständige Funktionen und einen stark reduzierten Leistungsverlust aus und kann gleichzeitig eine Edge-Cloud-Zusammenarbeit sowie eine zentrale Verwaltung und Kontrolle erreichen.

Da das Edge-Computing-System von Natur aus verteilte Eigenschaften aufweist, ist der individuelle Maßstab klein, aber die Anzahl groß. Wenn ein Einzelpunkt-Verwaltungsmodus übernommen wird, ist es schwierig, die Betriebsanforderungen zu erfüllen, und es wird auch Industriecomputer belegen Ressourcen und verringerte Effizienz; andererseits legen Edge-Computing-Unternehmen mehr Wert auf End-to-End-Latenz, Bandbreite und Sicherheit, daher ist auch die Zusammenarbeit zwischen Edge-Cloud und Edge sehr wichtig. Im Allgemeinen ist es erforderlich, ein intelligentes domänenübergreifendes Verwaltungs- und Orchestrierungssystem in das Cloud-Computing-System einzuführen, um die gesamte Netzwerkinfrastruktur des Edge-Computing-Systems innerhalb eines bestimmten Bereichs einheitlich zu verwalten und zu steuern und die Automatisierung von Netzwerk- und Computerressourcen durch die Unterstützung einer Zentralisierung sicherzustellen Verwaltungsmodell basierend auf Edge-Cloud-Zusammenarbeit.

4. Edge-Computing-Verbindungsnetzwerk

Das Edge-Computing-Verbindungsnetzwerk umfasst Edge-Computing-Systeme bis hin zu Cloud-Computing-Systemen (wie öffentliche Clouds, private Clouds, Kommunikations-Clouds, vom Benutzer erstellte Clouds usw.) , andere Edge Computing Die Netzwerkinfrastruktur, die Systeme und verschiedene Rechenzentren durchlaufen. Das Edge-Computing-Verbindungsnetzwerk zeichnet sich durch diversifizierte Verbindungen und eine geringe domänenübergreifende Latenz aus.

So kombinieren Sie Edge Computing mit autonomen Fahrsystemen

Um in der nächsten Phase übergeordnete autonome Fahrsystemaufgaben zu erfüllen, ist es völlig unzureichend, sich ausschließlich auf die Intelligenz einzelner Fahrzeuge zu verlassen.

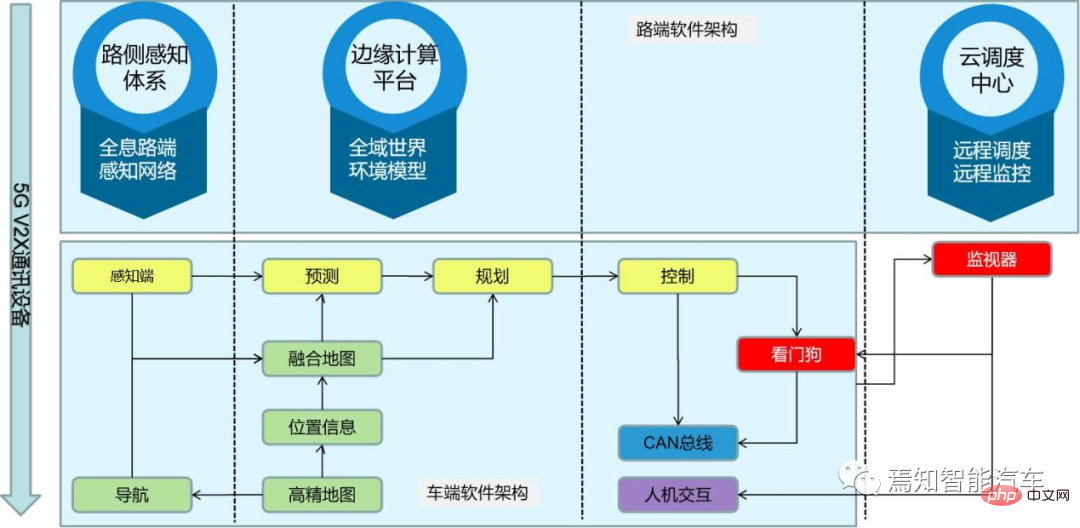

Kollaborative Erfassung und Aufgabenverlagerung sind die Hauptanwendungen von Edge Computing im Bereich des autonomen Fahrens. Diese beiden Technologien ermöglichen das Erreichen eines autonomen Fahrens auf hohem Niveau. Die kollaborative Sensortechnologie ermöglicht es Autos, Sensorinformationen von anderen Edge-Knoten zu erhalten, wodurch der Erfassungsbereich autonomer Fahrzeuge erweitert und die Integrität von Umgebungsdaten erhöht wird. Am Beispiel des autonomen Fahrens werden Autos Sensoren wie Lidar und Kameras integrieren. Gleichzeitig ist es notwendig, eine umfassende Wahrnehmung von Fahrzeugen, Straßen und Verkehrsdaten durch Fahrzeugnetzwerk V2X usw. zu erreichen, um mehr Informationen zu erhalten interne und externe Sensoren eines einzelnen Fahrzeugs und zur Verbesserung der Sichtbarkeit über die Sichtweite hinaus. Wahrnehmung der Umgebung innerhalb der Reichweite und Weitergabe der autonomen Fahrposition in Echtzeit durch hochauflösende dynamische 3D-Karten. Die gesammelten Daten werden mit Straßenrandknoten und umliegenden Fahrzeugen interagiert, um die Wahrnehmungsfähigkeiten zu erweitern und eine Zusammenarbeit zwischen Fahrzeug und Fahrzeug sowie zwischen Fahrzeug und Straße zu erreichen. Das Cloud-Computing-Zentrum ist dafür verantwortlich, Daten von weit verteilten Randknoten zu sammeln, den Betriebsstatus des Transportsystems zu erfassen und mithilfe von Big-Data- und künstlichen Intelligenzalgorithmen angemessene Dispositionsanweisungen an Randknoten, Verkehrssignalsysteme und Fahrzeuge zu erteilen und so den Systembetrieb zu verbessern . Effizienz. Beispielsweise können Radargeräte und Kameras bei schlechtem Wetter wie Regen, Schnee, starkem Nebel oder in Szenen wie Kreuzungen und Abbiegungen Hindernisse vor Ihnen nicht eindeutig erkennen. Verwenden Sie V2x, um intelligente Echtzeitdaten zu Straßen, Fahrverhalten usw. zu erhalten Vorhersage der Straßenbedingungen können Unfälle vermieden werden.

Mit der Verbesserung des autonomen Fahrniveaus und der zunehmenden Anzahl intelligenter Sensoren generieren autonome Fahrzeuge täglich eine große Menge an Rohdaten. Diese Rohdaten erfordern eine lokale Echtzeitverarbeitung, Fusion und Merkmalsextraktion, einschließlich Zielerkennung und -verfolgung auf Basis von Deep Learning. Gleichzeitig muss V2X verwendet werden, um die Wahrnehmung der Umgebung, der Straßen und anderer Fahrzeuge zu verbessern und hochauflösende 3D-Karten für die Echtzeitmodellierung und -positionierung, die Pfadplanung und -auswahl sowie die Anpassung der Fahrstrategie zur sicheren Steuerung zu verwenden das Fahrzeug. Da diese Aufgaben jederzeit eine Echtzeitverarbeitung und -reaktion im Fahrzeug erfordern, ist für deren Ausführung eine leistungsstarke und zuverlässige Edge-Computing-Plattform erforderlich. Angesichts der Vielfalt der Rechenaufgaben ist es im Allgemeinen erforderlich, heterogene Rechenplattformen zu unterstützen, um die Ausführungseffizienz zu verbessern und den Stromverbrauch und die Kosten zu senken.

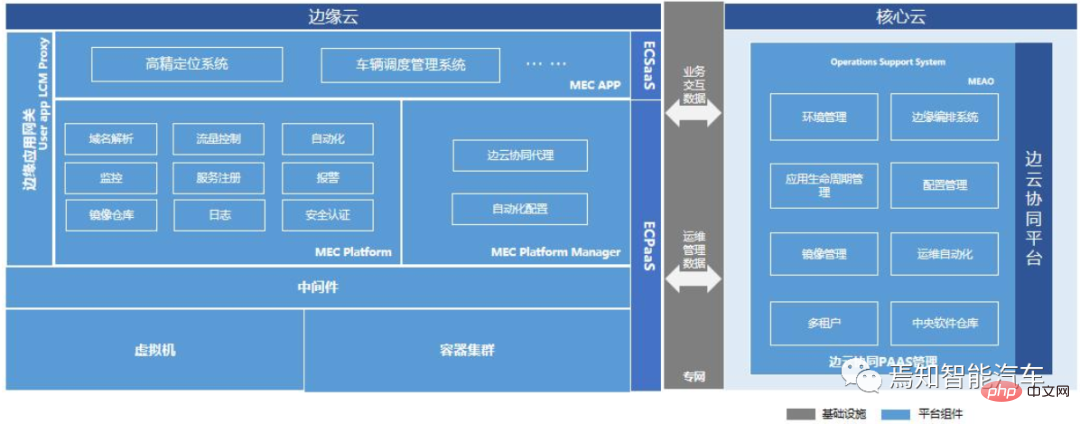

Die Edge-Computing-Architektur des autonomen Fahrens basiert auf der Edge-Cloud-Kollaborations- und Kommunikationsinfrastruktur sowie den von LTE/5G bereitgestellten Diensten. Die Edge-Seite bezieht sich hauptsächlich auf fahrzeugmontierte Einheiten, Roadside Units (RSU) oder Mobile Edge Computing (MEC)-Server. Unter diesen ist die am Fahrzeug montierte Einheit der Hauptteil der Umgebungswahrnehmung, der Entscheidungsplanung und der Fahrzeugsteuerung, sie ist jedoch auf die Zusammenarbeit mit RSU oder MEC-Servern angewiesen. Beispielsweise stellt RSU der am Fahrzeug montierten Einheit weitere Informationen zur Verfügung Straßen und Fußgänger, aber einige Funktionen sind besser geeignet und laufen in der Cloud. Kann nicht ersetzt werden. Zum Beispiel Fahrzeugfernsteuerung, Fahrzeugsimulation und -verifizierung, Knotenverwaltung, Datenpersistenz und -verwaltung usw.

Für das Edge-Computing autonomer Fahrsysteme können Vorteile wie Lastintegration, heterogenes Computing, Echtzeitverarbeitung, Verbindung und Interoperabilität sowie Sicherheitsoptimierung erzielt werden.

1. „Lastkonsolidierung“

Führen Sie Lasten mit unterschiedlichen Attributen wie ADAS, IVI, digitalen Instrumenten, Head-up-Display und Fond-Entertainment-System auf derselben Hardwareplattform durch virtualisiertes Computing aus. Gleichzeitig erleichtert die Lastintegration auf Basis der Virtualisierungs- und Hardware-Abstraktionsschicht die Implementierung von Cloud-Business-Orchestrierung, Deep-Learning-Modellaktualisierungen sowie Software- und Firmware-Upgrades für das gesamte Fahrzeugantriebssystem.

2. „Heterogenes Computing“

bezieht sich auf die Rechenaufgaben mit unterschiedlichen Attributen, die von der Edge-Plattform des autonomen Fahrsystems geerbt werden, basierend auf den Unterschieden in der Leistung und dem Energieverbrauchsverhältnis beim Betrieb auf unterschiedlicher Hardware Plattformen Sex erfordert ein anderes Kalkül. Zum Beispiel Geolokalisierung und Pfadplanung, Zielerkennung und -erkennung auf Basis von Deep Learning, Bildvorverarbeitung und Merkmalsextraktion, Sensorfusion und Zielverfolgung usw. GPUs beherrschen Faltungsberechnungen zur Zielerkennung und -verfolgung gut. Die CPU bietet eine bessere Leistung für logische Rechenfunktionen und verbraucht weniger Energie. Der digitale Signalverarbeitungs-DSP bietet weitere Vorteile bei Merkmalsextraktionsalgorithmen wie der Positionierung. Diese heterogene Rechenmethode verbessert die Leistung und das Energieverbrauchsverhältnis der Rechenplattform erheblich und reduziert die Rechenlatenz. Heterogenes Computing wählt geeignete Hardwareimplementierungen für verschiedene Computeraufgaben aus, nutzt die Vorteile verschiedener Hardwareplattformen voll aus und schützt die Hardwarevielfalt durch die Vereinheitlichung der Softwareschnittstellen der oberen Schicht.

3. „Echtzeitverarbeitung“

Wie wir alle wissen, stellt das automatische Fahrsystem extrem hohe Anforderungen an die Echtzeitleistung, da in Gefahrensituationen möglicherweise nur wenige Sekunden zur Verfügung stehen das automatische Fahrsystem, um Kollisionen zu vermeiden. Darüber hinaus umfasst die Bremsreaktionszeit die Reaktionszeit des gesamten Fahrsystems, einschließlich der Cloud-Computing-Verarbeitung, der Verarbeitungszeit für Werkstattverhandlungen, der Systemberechnung des Fahrzeugs selbst und der Bremsverarbeitungszeit. Wenn die autonome Fahrreaktion in Echtzeit in die verschiedenen funktionalen Modulanforderungen seiner Edge-Computing-Plattform aufgeteilt wird. Es muss in Wahrnehmungserkennungszeit, Fusionsanalysezeit und Verhaltenspfadplanungszeit verfeinert werden. Gleichzeitig muss auch die gesamte Netzwerklatenz berücksichtigt werden, da auch die Anwendungsszenarien mit geringer Latenz und hoher Zuverlässigkeit, die 5G mit sich bringt, sehr kritisch sind. Dadurch können selbstfahrende Autos eine End-to-End-Latenz von weniger als 1 ms und eine Zuverlässigkeit von nahezu 100 % erreichen. Gleichzeitig kann 5G Netzwerkverarbeitungskapazitäten flexibel nach Priorität zuweisen und so eine schnellere Reaktionsgeschwindigkeit für die Übertragung von Fahrzeugsteuersignalen gewährleisten.

4. „Konnektivität und Interoperabilität“

Edge Computing für selbstfahrende Autos ist untrennbar mit der Unterstützung der drahtlosen Fahrzeugkommunikationstechnologie (V2X, Vehicle-to-Everything) verbunden, die die Verbindung zwischen sich selbst herstellt -fahrende Autos und Intelligenz Kommunikationsmittel für andere Elemente im Transportsystem sind die Grundlage für die Zusammenarbeit zwischen autonomen Fahrzeugen und Randknoten.

Derzeit basiert V2X hauptsächlich auf dedizierter Nahbereichskommunikation (DSRC, Dedicated Short Range Communication) und Mobilfunknetzen [5]. DSRC ist ein Kommunikationsstandard, der speziell zwischen Fahrzeugen (V2V, Fahrzeug-zu-Fahrzeug) und Fahrzeugen und Straßeninfrastruktur (V2I, Fahrzeug-zu-Infrastruktur) verwendet wird und Punkt-zu-Punkt unterstützt oder Punkt-zu-Mehrpunkt-Kommunikation und andere Vorteile. Durch 5G repräsentierte Mobilfunknetze bieten die Vorteile einer großen Netzwerkkapazität und einer breiten Abdeckung und eignen sich für die V2I-Kommunikation und die Kommunikation zwischen Edge-Servern.

5. „Sicherheitsoptimierung“

Edge-Computing-Sicherheit ist eine wichtige Garantie für Edge-Computing und kombiniert das umfassende Sicherheitsschutzsystem von Cloud-Computing und Edge-Computing, um Edge-Infrastruktur, Netzwerke, und Anwendungen, Datenidentifizierung und Fähigkeit, verschiedenen Sicherheitsbedrohungen zu widerstehen, wodurch eine sichere und vertrauenswürdige Umgebung für die Entwicklung von Edge Computing geschaffen wird. Die Steuerungsebene und die Datenebene des 5G-Kernnetzwerks des autonomen Fahrsystems der nächsten Generation sind getrennt. NFV macht die Netzwerkbereitstellung flexibler und stellt so den Erfolg der Edge-Distributed-Computing-Bereitstellung sicher. Edge Computing verteilt mehr Datenverarbeitung und -speicherung von der Zentraleinheit an den Rand. Seine Rechenleistung wird in der Nähe der Datenquelle bereitgestellt. Einige Daten müssen nicht mehr über das Netzwerk zur Verarbeitung gelangen, wodurch Latenz und Netzwerklast reduziert werden und Verbesserung der Datensicherheit und des Datenschutzes. Für zukünftige mobile Kommunikationsgeräte in der Nähe von Fahrzeugen, wie Basisstationen, straßenseitige Einheiten usw., könnte Edge Computing des Internets der Fahrzeuge eingesetzt werden, das die lokale Datenverarbeitung, Verschlüsselung und Entscheidungsfindung gut abschließen und Echtzeit bereitstellen kann , äußerst zuverlässige Kommunikationsfähigkeiten.

Edge Computing hat äußerst wichtige Anwendungen in der Umweltwahrnehmung und Datenverarbeitung beim autonomen Fahren. Selbstfahrende Autos können ihren Wahrnehmungsbereich erweitern, indem sie Umgebungsinformationen von Randknoten erhalten, und können auch Rechenaufgaben auf Randknoten verlagern, um das Problem unzureichender Rechenressourcen zu lösen. Im Vergleich zum Cloud Computing vermeidet Edge Computing die hohen Verzögerungen, die durch die Datenübertragung über große Entfernungen entstehen, kann autonome Fahrzeuge schneller reagieren lassen und die Belastung des Backbone-Netzwerks reduzieren. Daher wird der Einsatz von Edge Computing im gestuften Forschungs- und Entwicklungsprozess zum autonomen Fahren eine wichtige Option für dessen kontinuierliche Optimierung und Weiterentwicklung sein.

Das obige ist der detaillierte Inhalt vonEin Artikel zum Verständnis der Edge-Computing-Technologie in autonomen Fahrsystemen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr