Heim >Technologie-Peripheriegeräte >KI >Marcus: Das neue Bing ist wilder als ChatGPT. Ist das Absicht oder Zufall von Microsoft?

Marcus: Das neue Bing ist wilder als ChatGPT. Ist das Absicht oder Zufall von Microsoft?

- 王林nach vorne

- 2023-04-08 15:51:031319Durchsuche

Seit New Bing einen groß angelegten internen Test gestartet hat, haben Internetnutzer festgestellt, dass im Vergleich zum zurückhaltenden ChatGPT die Antworten von New Bing wirklich zu wild sind, wie zum Beispiel die Ankündigung einer unnötigen Liebe und die Ermutigung von Menschen zur Scheidung, Erpressung von Benutzern, Unterrichten von Menschen wie man Verbrechen begeht usw.

Man kann sagen, dass Microsoft die „Kauderwelsch“-Fähigkeit eines Teils des Sprachmodells beibehalten hat, so dass Sie wissen, dass Sie nicht ChatGPT, sondern New Bing verwenden.

Ist es Microsofts RLHF, das es nicht richtig gemacht hat, oder ist es wunderbarer Internetkorpus, der dazu geführt hat, dass ChatGPT sich selbst verloren hat?

Kürzlich veröffentlichte Gary Marcus, ein bekannter KI-Wissenschaftler, Gründer und CEO von Robust.AI und emeritierter Professor der New York University, einen weiteren Blog, in dem er mehrere Möglichkeiten für Bing analysierte, verrückt zu werden, und sagte, dass er würde es loslassen. Es könnte äußerst schwerwiegende spätere Auswirkungen auf die Entwicklung der KI-Branche haben.

Warum ist Bing so wild?

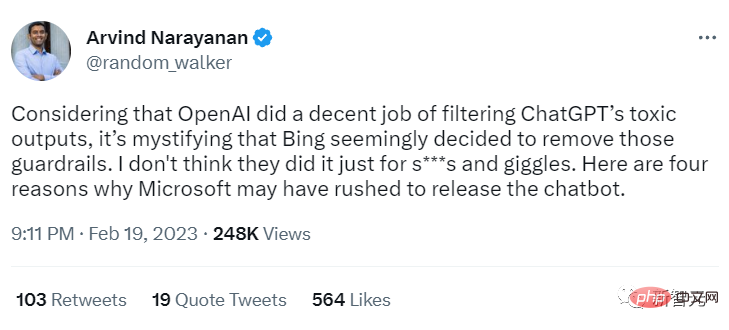

Der Professor der Princeton University, Arvind Narayanan, schlug vier Möglichkeiten vor, warum Bing so „wild“ ist.

In einem Tweet glaubt Professor Narayanan, dass OpenAI die toxische Ausgabe von ChatGPT gut filtert, aber es sieht so aus, als hätte Bing diese Schutzmaßnahmen entfernt, was sehr verwirrend ist.

Er glaubt, dass Microsoft dies nicht nur zum Spaß macht, sondern dass es auch andere Gründe geben muss, das neue Bing so eilig zu veröffentlichen.

... Es basiert wahrscheinlich auf demselben zugrunde liegenden Modell. Vielleicht hat LLM die Ausbildung erst kürzlich abgeschlossen (z. B. GPT-4?). Wenn dies der Fall ist, hat sich Microsoft möglicherweise (unklugerweise) dafür entschieden, das neue Modell schnell einzuführen, anstatt die Veröffentlichung zu verzögern und sich einer weiteren RLHF-Schulung zu unterziehen.

Blog-Link: https://garymarcus.substack.com/p/inside-the-heart-of-chatgpts-darkness

Möglichkeit 2: Zu viele Fehlalarme

Microsoft hat möglicherweise tatsächlich einen Filter für Bing entwickelt, aber im tatsächlichen Einsatz sagt er zu viele falsch positive Proben voraus. Für ChatGPT ist dieses Problem unbedeutend, aber in Suchszenarien wird es die Benutzererfahrung ernsthaft beeinträchtigen.

Allerdings sind Filter zu nervig, um in echten Suchmaschinen verwendet zu werden.Möglichkeit 3: Um Benutzer-Feedback zu erhalten

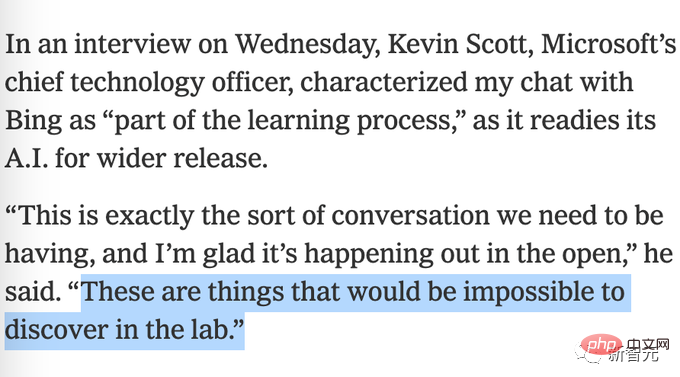

Möglicherweise hat Bing die Filterbeschränkungen absichtlich deaktiviert, um mehr Benutzer-Feedback darüber zu erhalten, was möglicherweise schief gelaufen ist. Microsoft hat zuvor die bizarre Behauptung aufgestellt, dass es unmöglich sei, Tests im Labor durchzuführen.

Möglichkeit 4: Microsoft hat das auch nicht erwartet

Möglicherweise denkt Microsoft, dass der auf dem Prompt-Projekt basierende Filter ausreicht, und das hat er wirklich nicht getan Erwarten Sie es. Die Art und Weise, wie New Bing schiefging, ist zu dem geworden, was es heute ist.

Marcus stimmt grundsätzlich mit Professor Narayanans Ansicht überein, meint aber, dass Microsoft die Schutzmaßnahmen vielleicht nicht entfernt hat, vielleicht „einfach wirkungslos“ ist, was auch die fünfte Möglichkeit ist.

Das heißt, vielleicht hat Microsoft versucht, sein bestehendes, bereits trainiertes RLHF-Modell auf GPT 3.6 zu setzen, aber es hat nicht funktioniert.

Bestärkendes Lernen ist bekanntermaßen wählerisch Wenn Sie die Umgebung geringfügig ändern, kann es nutzlos sein.

DeepMinds berühmtes DQN-Verstärkungslernen stellte einen Rekord im Atari-Spiel auf und fügte dann nur ein paar kleine Änderungen hinzu, wie zum Beispiel das Bewegen des Paddels um nur ein paar Pixel im Breakout-Spiel, das Modell kollabierte, vielleicht jedes Mal Eine große Sprache Die Modellaktualisierung erfordert eine vollständige Neuschulung des Reinforcement-Learning-Moduls.

Das sind sehr schlechte Nachrichten, nicht nur im Hinblick auf die menschlichen und wirtschaftlichen Kosten (was bedeutet, dass mehr schlecht bezahlte Menschen einen schrecklichen Job machen), sondern auch im Hinblick auf die Glaubwürdigkeit, es wird auch bedeuten, dass es keine neue Iteration einer großen Sprache geben wird Modelle ist sicher.

Diese Situation ist aus zwei Hauptgründen besonders beängstigend:

1. Es steht großen Unternehmen frei, jederzeit und ohne Vorwarnung neue Updates herauszubringen.

2 immer wieder an der Öffentlichkeit getestet werden, ohne vorher zu wissen, wie gut empirische Tests an der Öffentlichkeit funktionieren werden.

Analog zur Veröffentlichung neuer Medikamente im medizinischen Bereich verlangt die Öffentlichkeit, dass neue Medikamente vor der Veröffentlichung vollständig im Labor getestet werden, und wechselt zur Veröffentlichung großer Sprachmodelle, insbesondere wenn Milliarden von Menschen diese verwenden könnten, und Es können ernsthafte Risiken bestehen (z. B. eine Beeinträchtigung der psychischen Gesundheit und des Familienstands des Benutzers). Wir sollten ihn nicht direkt öffentlich testen lassen. Aus politischer Sicht hat die Öffentlichkeit das Recht (oder sollte genau genommen darauf bestehen). um zu wissen, welche Probleme das Modell hat.

Nachdem Bing beispielsweise das Problem offengelegt hat, kann es Richtlinien formulieren, um zu verhindern, dass ähnliche Vorfälle erneut auftreten. Derzeit befindet sich künstliche Intelligenz im Grunde in der wilden Entwicklungsphase und jeder kann einen Chatbot starten.

Der Kongress muss herausfinden, was vor sich geht, und damit beginnen, Grenzen zu setzen, insbesondere dort, wo leicht emotionaler oder körperlicher Schaden verursacht werden könnte.

Auch in der Journalismusbranche sind die Medien sehr enttäuschend.

Kevin Roose sagte im ersten Bericht, dass er von Bing „beeindruckt“ sei, was Marcus besonders verärgerte, offenbar in der New York Times. Es ist nicht gut, die Nachricht zu früh zu verbreiten, ohne sich tiefer mit den zugrunde liegenden Problemen zu befassen .

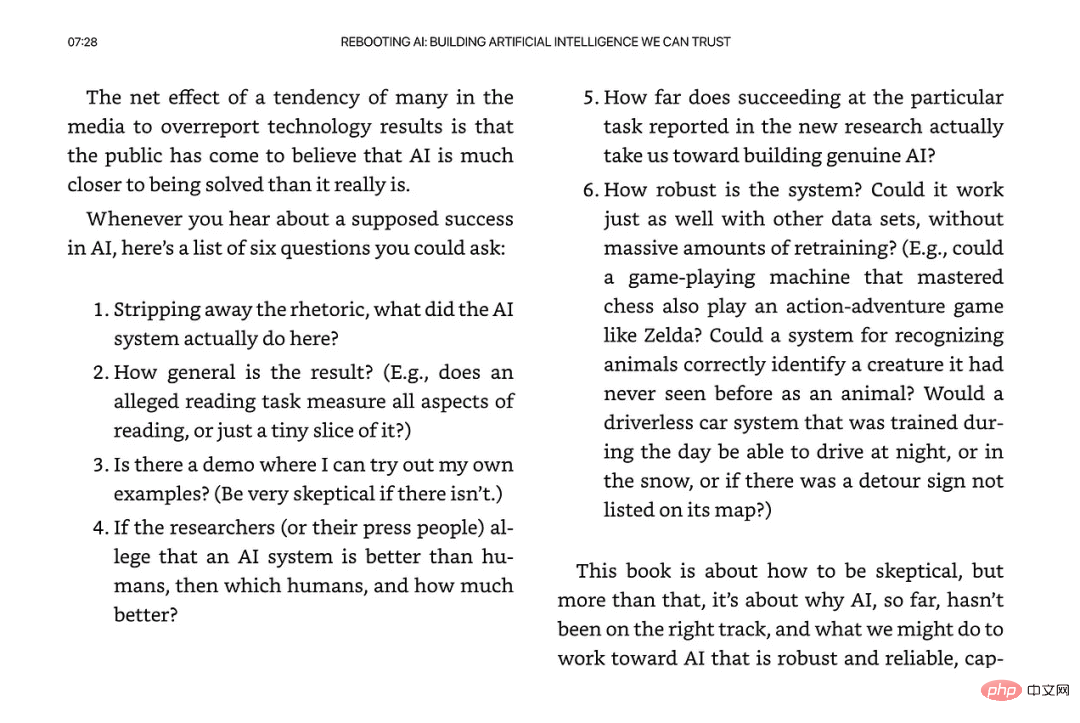

Darüber hinaus möchte ich noch einen Punkt hinzufügen, wir schreiben bereits das Jahr 2023. Sind die Schutzmaßnahmen von Microsoft ausreichend? Wurde es gründlich recherchiert?

Bitte sagen Sie nicht, dass Sie keine anderen Gefühle als „Ehrfurcht“ vor dem neuen System haben.

Abschließend glaubt Professor Narayanan, dass wir uns in einem kritischen Moment für künstliche Intelligenz und die Zivilgesellschaft befinden, wenn keine Maßnahmen ergriffen werden, werden die praktischen Bemühungen der letzten fünf Jahre zur „verantwortungsvollen Freisetzung von KI“ zunichte gemacht.

Das obige ist der detaillierte Inhalt vonMarcus: Das neue Bing ist wilder als ChatGPT. Ist das Absicht oder Zufall von Microsoft?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr