Heim >Technologie-Peripheriegeräte >KI >Unverzichtbare Datenwissenschaft: 10 wichtige Konzepte + die Bedeutung von 22 Diagrammen

Unverzichtbare Datenwissenschaft: 10 wichtige Konzepte + die Bedeutung von 22 Diagrammen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-08 14:41:081198Durchsuche

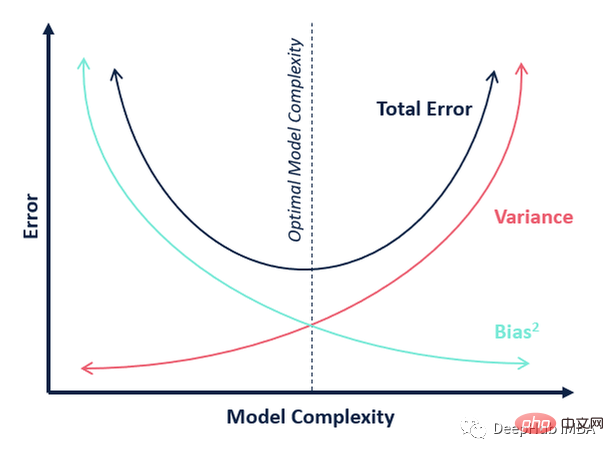

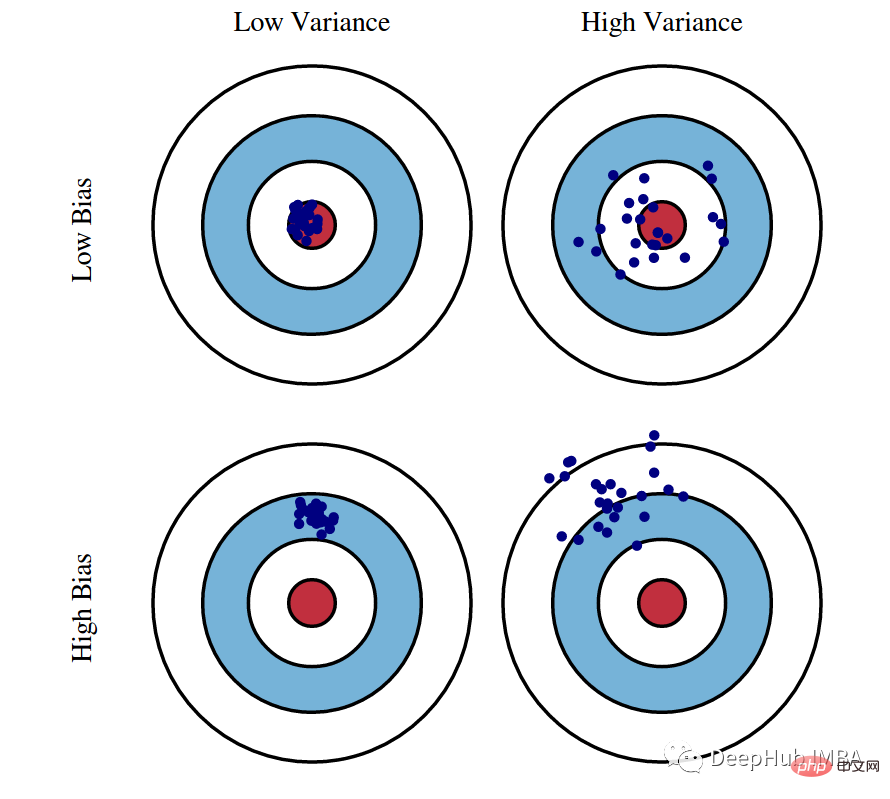

01 Bias-Varianz-Kompromiss

Dies ist ein Konzept, das immer einen hohen Stellenwert unter den wichtigsten Theorien des maschinellen Lernens einnimmt. Fast alle Algorithmen im maschinellen Lernen (einschließlich Deep Learning) streben danach, das richtige Gleichgewicht zwischen Bias und Varianz zu finden, und dieses Diagramm erklärt deutlich den Gegensatz zwischen beiden.

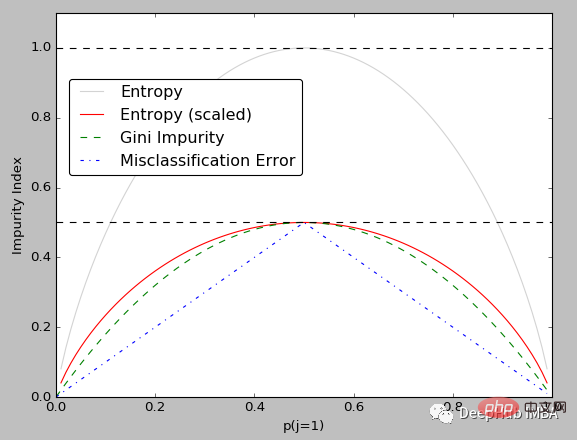

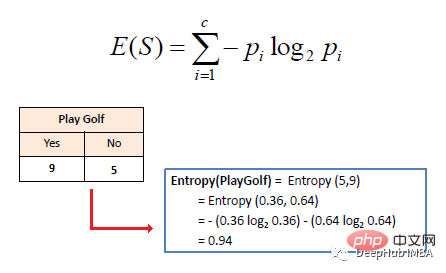

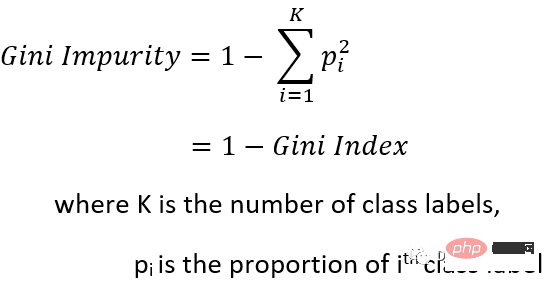

02 Gini-Unreinheit und Entropie

Gini (ein Maß für mangelnde Homogenität) und Entropie (ein Maß für Zufälligkeit) sind beide Maße für Knotenunreinheit in Entscheidungsbäumen.

Für diese beiden Konzepte ist es wichtiger, die Beziehung zwischen ihnen zu verstehen, um in einem bestimmten Szenario den richtigen Indikator auswählen zu können.

Gini-Verunreinigung (Koeffizient) ist normalerweise einfacher zu berechnen als Entropie (da Entropie logarithmische Berechnungen beinhaltet).

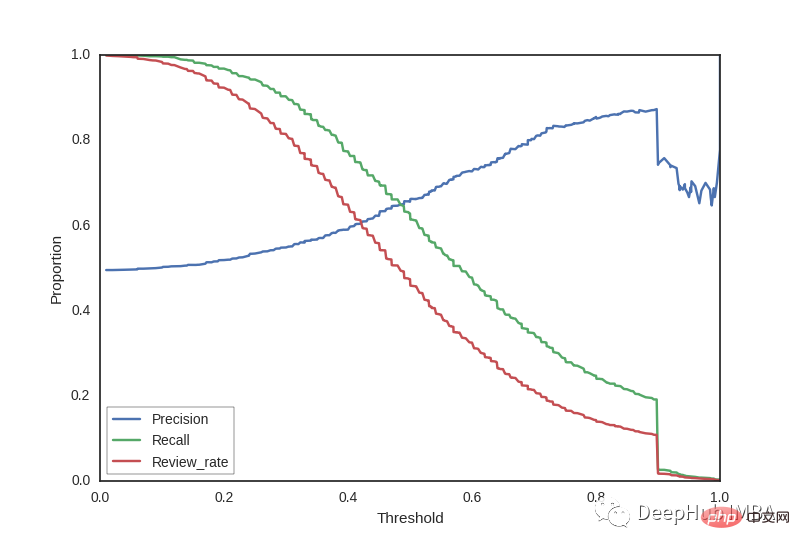

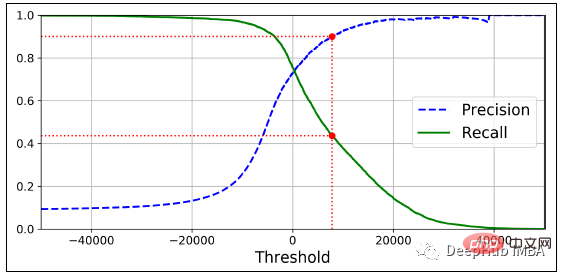

03 Präzision vs. Recall-Kurve

Die Präzisions-Recall-Kurve zeigt den Kompromiss zwischen Präzision und Recall für verschiedene Schwellenwerte. Ein großer Bereich unter der Kurve stellt einen hohen Rückruf und eine hohe Präzision dar, wobei eine hohe Präzision mit niedrigen Fehlalarmraten und ein hoher Rückruf mit niedrigen Fehlalarmraten zusammenhängt.

Es hilft uns, den richtigen Schwellenwert entsprechend unseren Bedürfnissen zu wählen. Wenn es beispielsweise unser Ziel ist, Fehler vom Typ 1 zu reduzieren, müssen wir eine hohe Präzision wählen, während wir, wenn unser Ziel darin besteht, Fehler vom Typ 2 zu minimieren, einen Schwellenwert wählen sollten, der den Rückruf hoch macht.

- Der Genauigkeitsnenner ist eine Variable: d. h. falsch positive Ergebnisse (als positiv eingestufte negative Proben) ändern sich jedes Mal.

- Der Recall-Nenner ist eine Konstante: Er stellt die Gesamtzahl der wahren Werte dar und bleibt daher immer gleich.

Deshalb hat Precision im Bild unten eine Welle am Ende, während Recall immer flach bleibt.

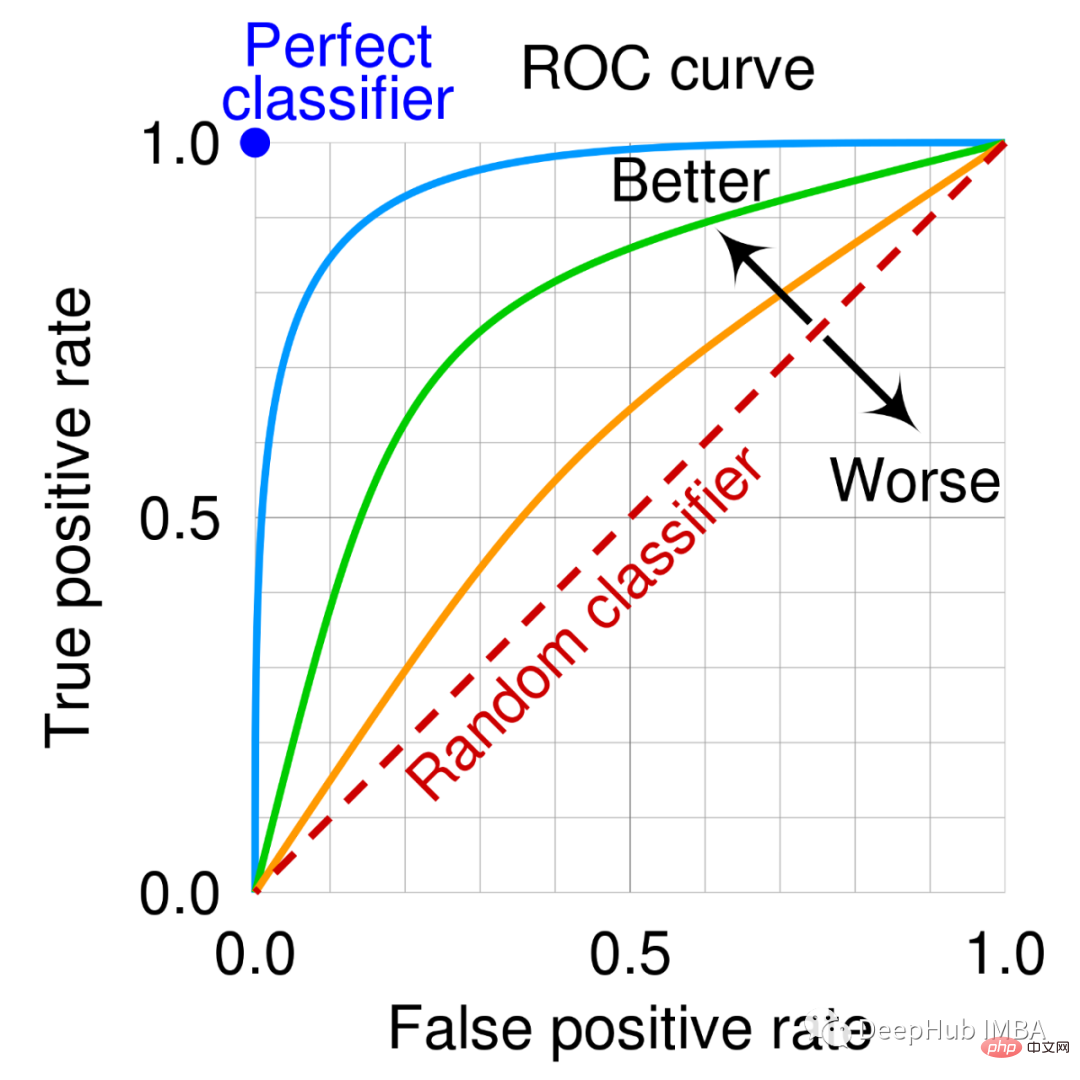

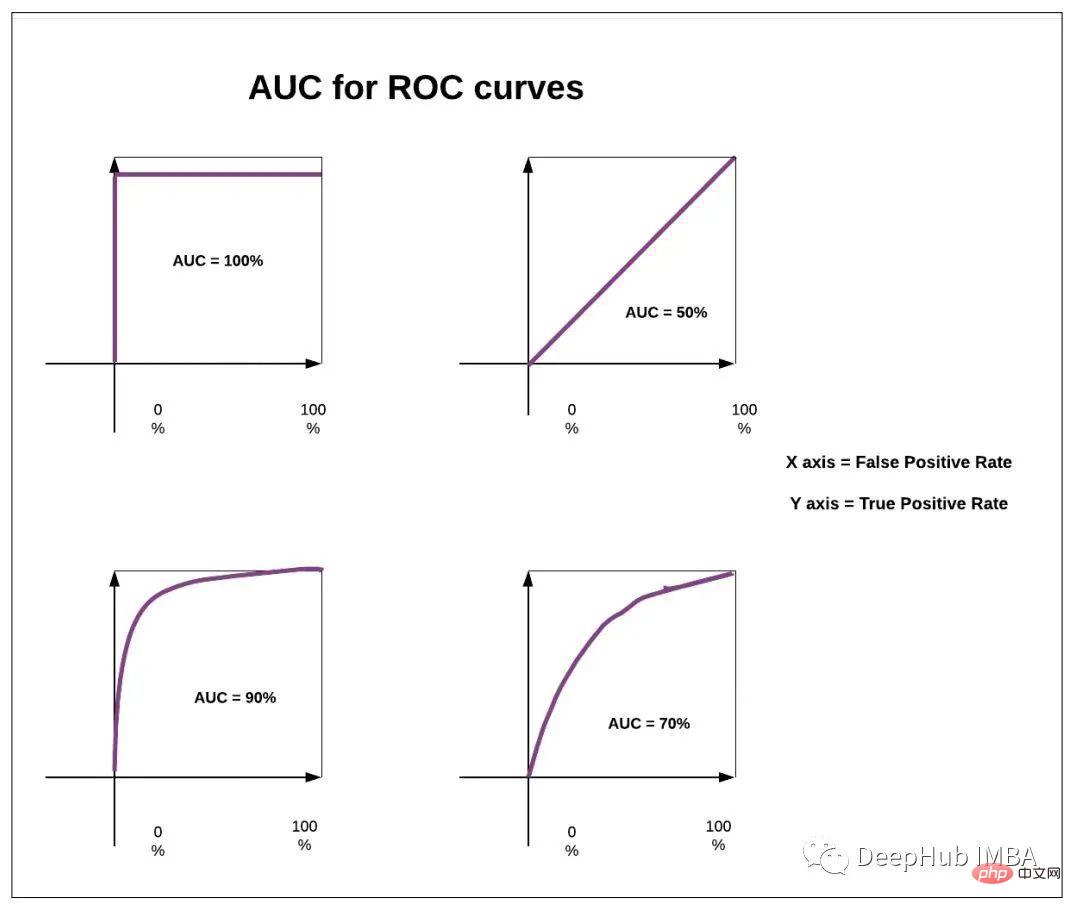

04 ROC-Kurve

Eine ROC-Kurve ist ein Diagramm, das die Leistung eines Klassifizierungsmodells bei allen Klassifizierungsschwellenwerten zeigt.

Diese Kurve stellt zwei Parameter dar:

真阳性率<br>误报率

Die Fläche unter dieser Kurve (AUC genannt) kann auch als Leistungsmetrik verwendet werden. Je höher die AUC, desto besser das Modell.

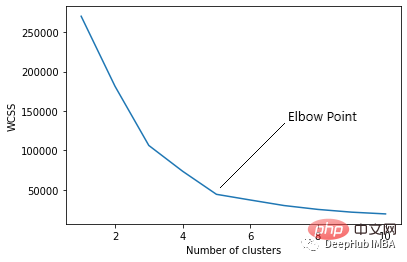

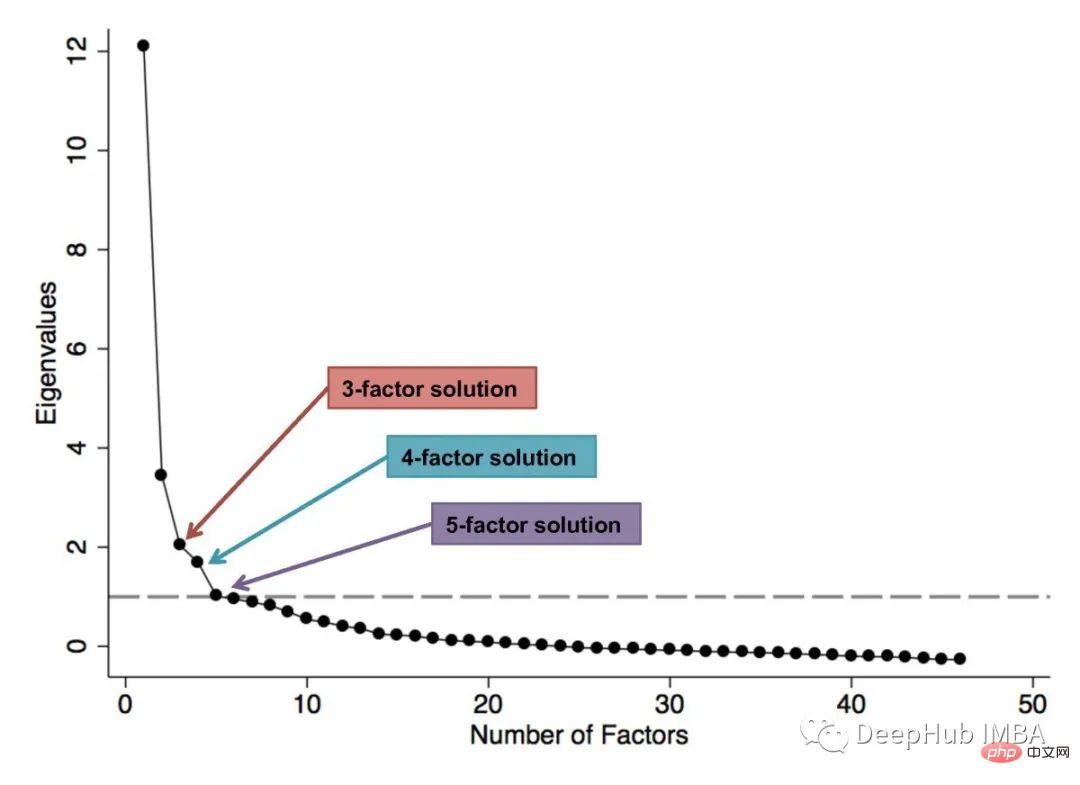

05 弯头曲线

用于K-means算法中最优簇数的选择。WCSS(簇内平方和)是给定簇中每个点与质心之间的平方距离之和。当我们用 K(簇数)值绘制 WCSS 时,该图看起来像一个肘部(弯头)。

随着聚类数量的增加,WCSS 值将开始下降。K = 1时WCSS值最大

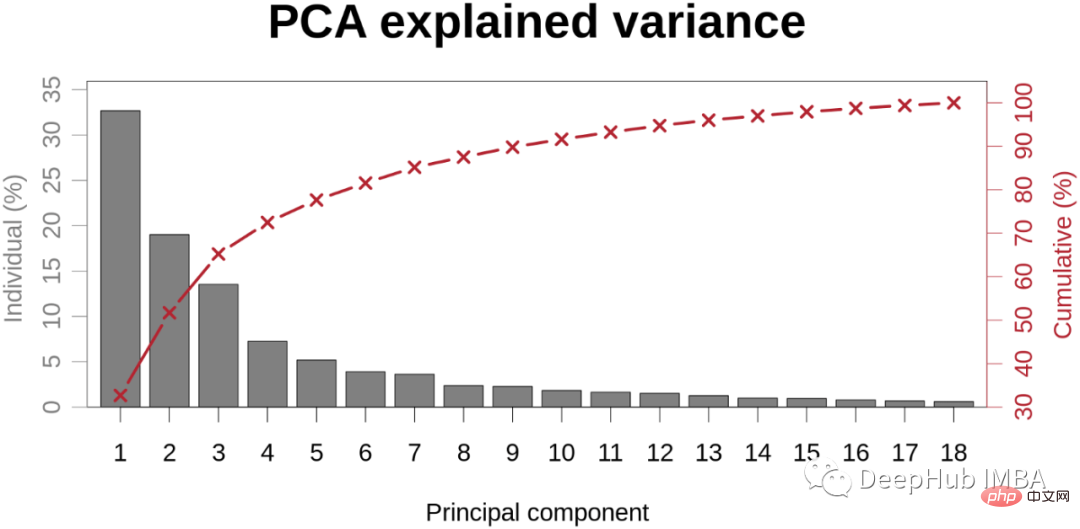

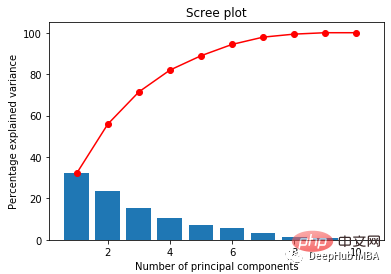

06三块地块

它帮助我们在对高维数据执行主成分分析后,可视化每个主成分解释的变异百分比。为了选择正确数量的主成分来考虑我们的模型,我们通常会绘制此图并选择能够为我们提供足够好的总体方差百分比的值。

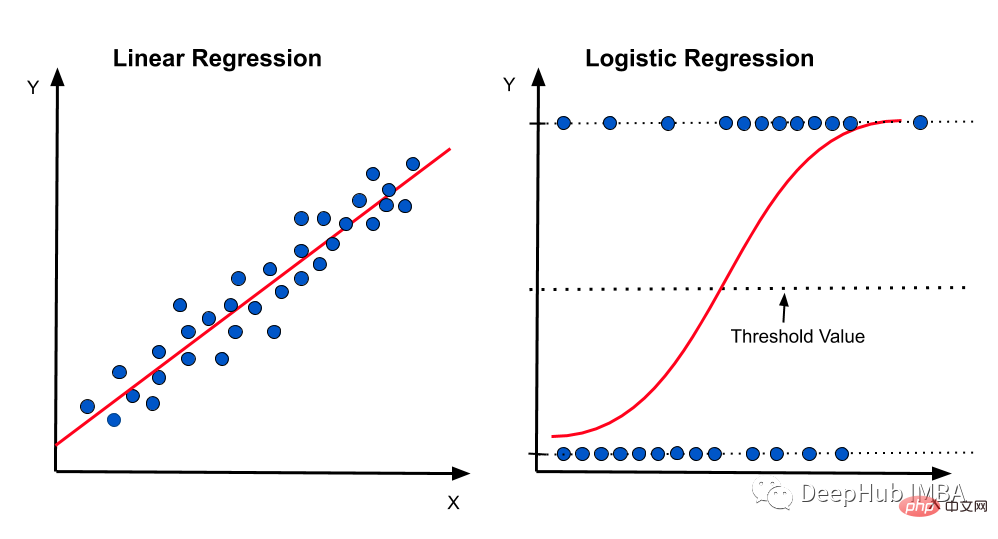

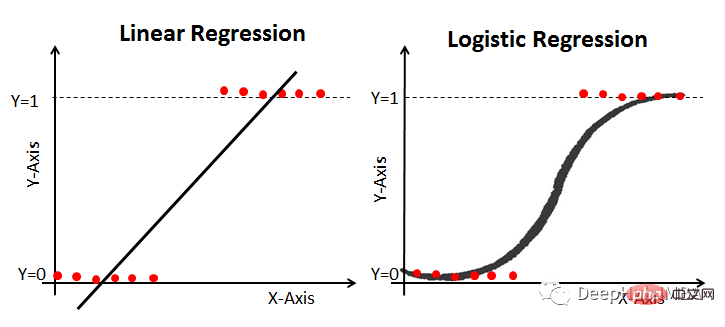

07线性和逻辑回归曲线

对于线性可分数据,我们可以进行线性回归或逻辑回归,二者都可以作为决策边界曲线/线。但是,在逻辑回归的情况下,由于通常只有 2 个类别,因此具有线性直线决策边界可能不起作用,在一条直线上值从低到高非常均匀地上升,因为它不够陡峭在值突然上升后会得到很多临界的高值或者低值,最终会错误分类。因此,"边界"区域,即概率从高到低转变的区域并不真正存在。所以一般情况下会应用 sigmoid 变换将其转换为 sigmoid 曲线,该曲线在极端情况下是平滑的,在中间几乎是线性的。

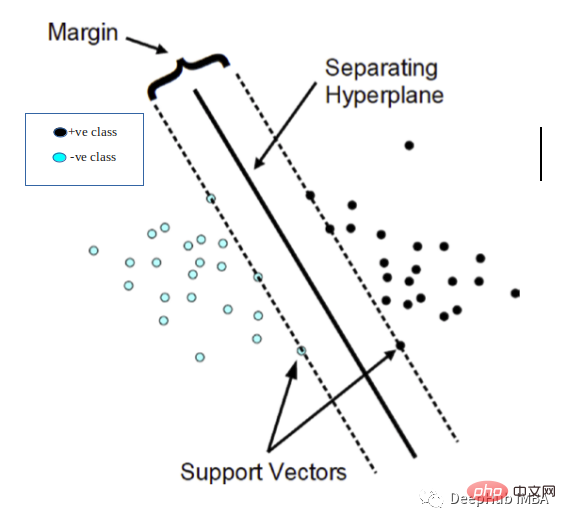

08支持向量机(几何理解)

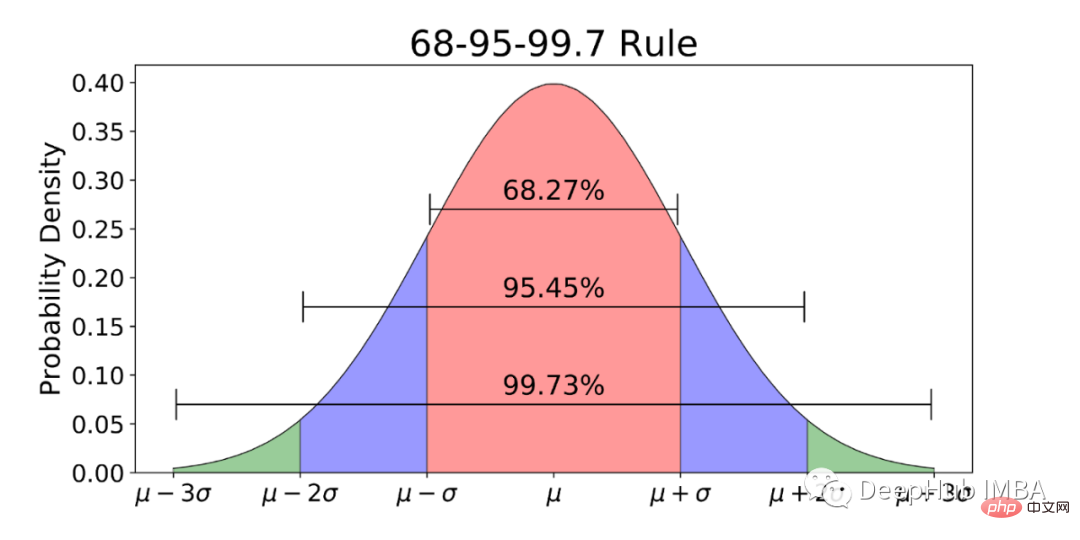

09标准正态分布规则(z-分布)

均值为0,标准差为1的特殊正态分布。

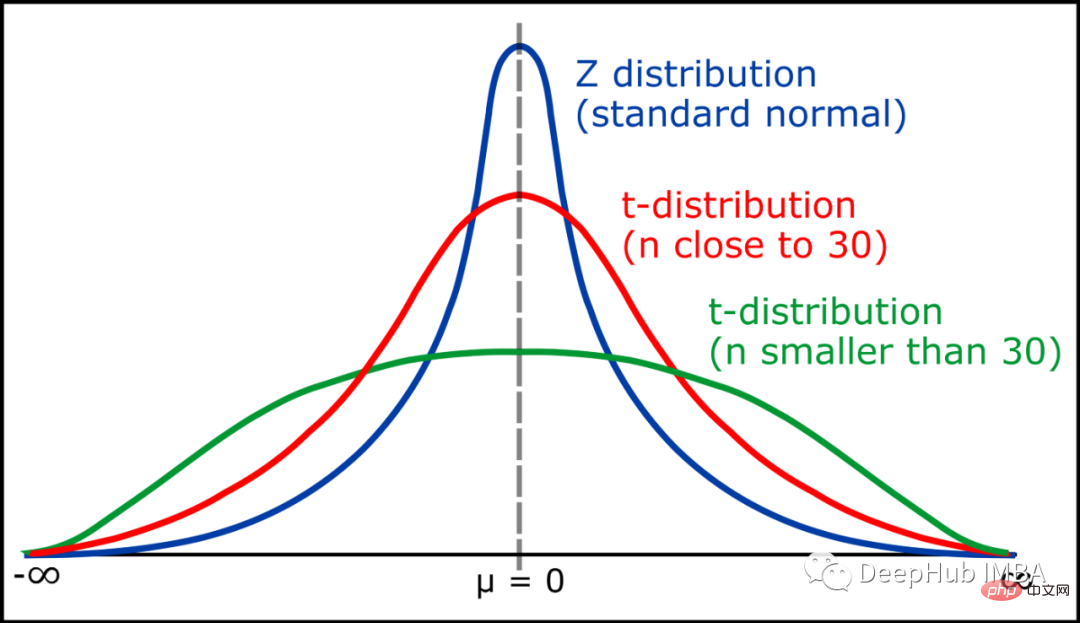

经验法则指出,按照正态分布观察到的数据中有 99.7% 位于平均值的 3 个标准差以内。根据该规则,68% 的数据在一个标准差内,95% 在两个标准差内,99.7% 在三个标准差内。10学生T分布T 分布(也称为学生 T 分布)是一系列分布,看起来几乎与正态分布曲线相同,只是更短和更宽/更胖。当我们有较小的样本时,我们使用 T分布而不是正态分布。样本量越大,t 分布越像正态分布。事实上,在 30 个样本之后,T 分布几乎与正态分布完全一样。

Zusammenfassung

Möglicherweise stoßen wir auf viele kleine, aber entscheidende Konzepte, die die Grundlage dafür bilden, dass wir eine Entscheidung treffen oder das richtige Modell auswählen. Die in diesem Artikel erwähnten wichtigen Konzepte können durch entsprechende Diagramme dargestellt werden, und wir müssen ihre Bedeutung kennen, wenn wir sie zum ersten Mal sehen. Wenn Sie die oben genannten Konzepte beherrschen, können Sie versuchen, sie im Folgenden zu erklären Bild stellt dar:

Das obige ist der detaillierte Inhalt vonUnverzichtbare Datenwissenschaft: 10 wichtige Konzepte + die Bedeutung von 22 Diagrammen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr