Heim >Technologie-Peripheriegeräte >KI >Das Google-Team bringt neuen Transformer auf den Markt, um die Panorama-Segmentierungslösung zu optimieren

Das Google-Team bringt neuen Transformer auf den Markt, um die Panorama-Segmentierungslösung zu optimieren

- PHPznach vorne

- 2023-04-08 13:41:031511Durchsuche

Kürzlich hat das Google AI-Team eine End-to-End-Lösung für die Panoramasegmentierung mit Mask Transformer vorgeschlagen, inspiriert von Transformer und DETR.

Der vollständige Name ist eine End-to-End-Lösung für die panoptische Segmentierung mit Maskentransformatoren, die hauptsächlich zur Generierung von Erweiterungen der Segmentierungs-MaskTransformer-Architektur verwendet wird.

Die Lösung verwendet einen Pixelpfad (bestehend aus einem Faltungs-Neuronalen Netzwerk oder einem visuellen Transformer) zum Extrahieren von Pixelmerkmalen, einen Speicherpfad (bestehend aus einem Transformer-Decodermodul) zum Extrahieren von Speichermerkmalen und einen Dual-Path-Transformer für die Verbindung zwischen Pixelfunktionen und interaktiven Speicherfunktionen.

Allerdings wurde der Dual-Path-Transformer mit Kreuzaufmerksamkeit ursprünglich für Sprachaufgaben entwickelt, deren Eingabesequenz aus Hunderten von Wörtern besteht.

Bei Sehaufgaben, insbesondere bei Segmentierungsproblemen, besteht die Eingabesequenz aus Zehntausenden von Pixeln, was nicht nur darauf hinweist, dass die Größe der Eingabeskala viel größer ist, sondern im Vergleich zu Sprachwörtern auch eine niedrigere Einbettungsebene darstellt.

Panoramasegmentierung ist ein Computer-Vision-Problem, das heute in vielen Anwendungen eine Kernaufgabe darstellt.

Es ist in zwei Teile unterteilt: semantische Segmentierung und Instanzsegmentierung.

Semantische Segmentierung ist so, als würde man jedem Pixel im Bild semantische Bezeichnungen zuweisen, z. B. „Person“ und „Himmel“.

Instanzsegmentierung identifiziert und segmentiert nur zählbare Objekte im Diagramm, wie zum Beispiel „Fußgänger“ und „Autos“, und unterteilt sie weiter in mehrere Unteraufgaben.

Jede Unteraufgabe wird einzeln bearbeitet, und es werden zusätzliche Module angewendet, um die Ergebnisse jeder Unteraufgabenphase zusammenzuführen.

Dieser Prozess ist nicht nur komplex, sondern führt auch viele künstlich gestaltete Prioritäten ein, wenn es um die Bearbeitung von Teilaufgaben und die Integration der Ergebnisse verschiedener Teilaufgaben geht.

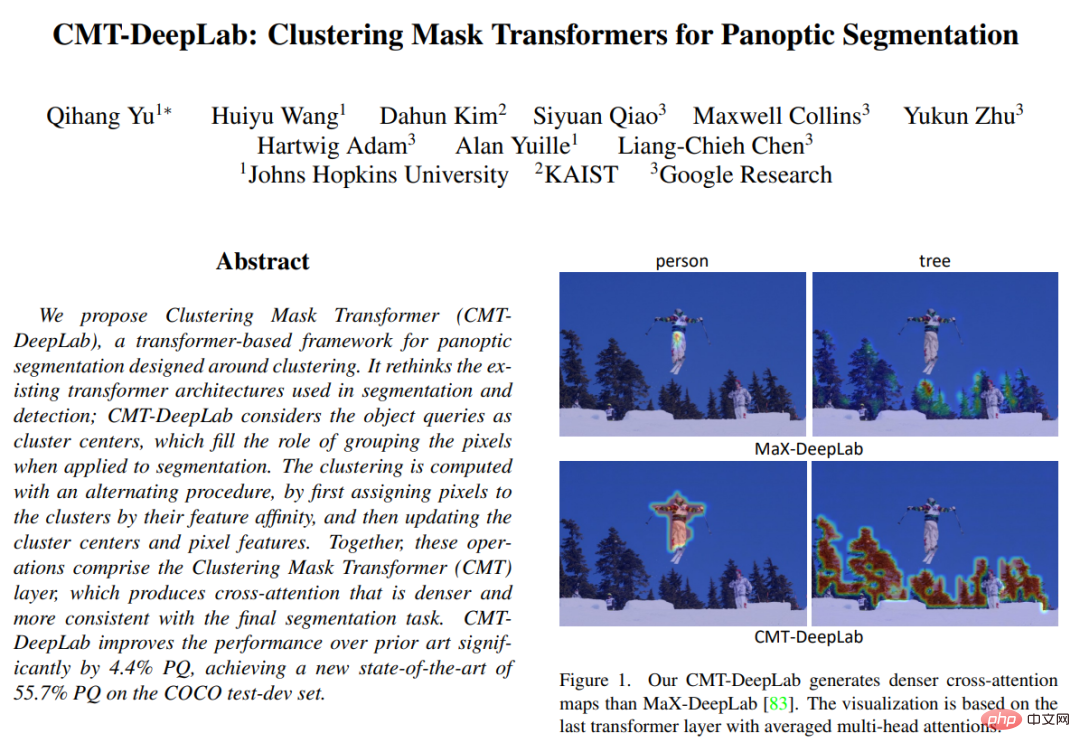

In „CMT-DeepLab: Clustering Mask Transformers for Panoptic Segmentation“, veröffentlicht auf der CVPR 2022, schlägt der Artikel vor, Queraufmerksamkeit aus der Perspektive des Clusterings (d. h. der Umwandlung derselben semantischen Bezeichnungen in gruppierte Pixel) neu zu interpretieren und neu zu gestalten zusammen), um Sehaufgaben besser gerecht zu werden.

CMT-DeepLab baut auf der vorherigen hochmodernen Methode MaX-DeepLab auf und verwendet eine Pixel-Clustering-Methode, um Kreuzaufmerksamkeit durchzuführen, was zu dichteren und vernünftigeren Aufmerksamkeitskarten führt.

kMaX-DeepLab gestaltet die Kreuzaufmerksamkeit weiter neu, um eher einem K-Means-Clustering-Algorithmus zu ähneln, mit einfachen Änderungen an der Aktivierungsfunktion.

Struktureller Überblick

Forscher werden aus der Perspektive des Clusterings neu interpretieren, anstatt die Kreuzaufmerksamkeit ohne Modifikation direkt auf visuelle Aufgaben anzuwenden.

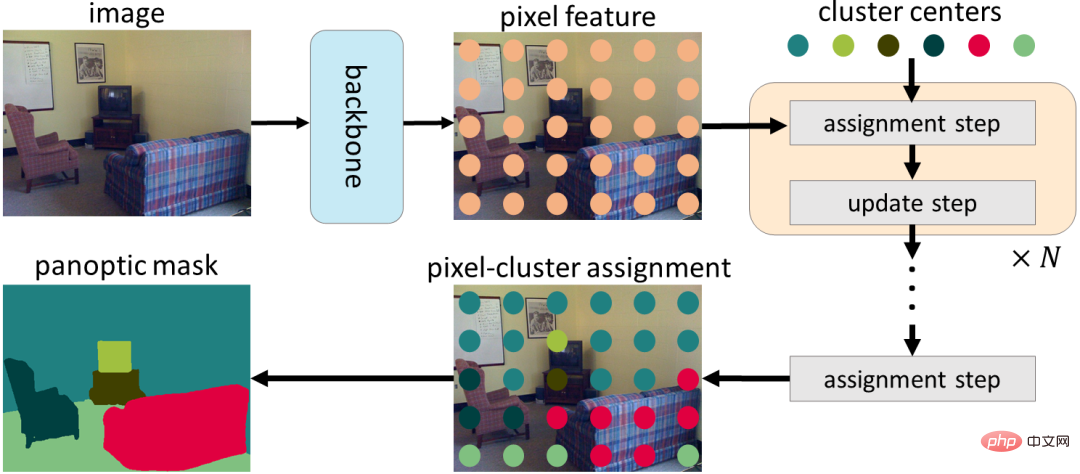

Konkret stellen sie fest, dass Objektabfragen von Mask Transformer als Clusterzentren betrachtet werden können (mit dem Ziel, Pixel mit derselben semantischen Bezeichnung zu gruppieren).

Der Prozess der gegenseitigen Aufmerksamkeit ähnelt dem K-Means-Clustering-Algorithmus, (1) einem iterativen Prozess der Zuweisung von Pixeln zu Clusterzentren, wobei mehrere Pixel einem einzelnen Clusterzentrum zugewiesen werden können und einige Clusterzentren möglicherweise nicht vorhanden sind zugewiesene Pixel, und (2) die Clusterzentren werden durch Mittelung der Pixel aktualisiert, die demselben Clusterzentrum zugewiesen sind; wenn keine zugewiesenen Pixel vorhanden sind, werden die Clusterzentren nicht aktualisiert).

In CMT-DeepLab und kMaX-DeepLab formulieren wir die gegenseitige Aufmerksamkeit aus einer Clustering-Perspektive neu, einschließlich iterativer Clusterzuweisungs- und Clusteraktualisierungsschritte.

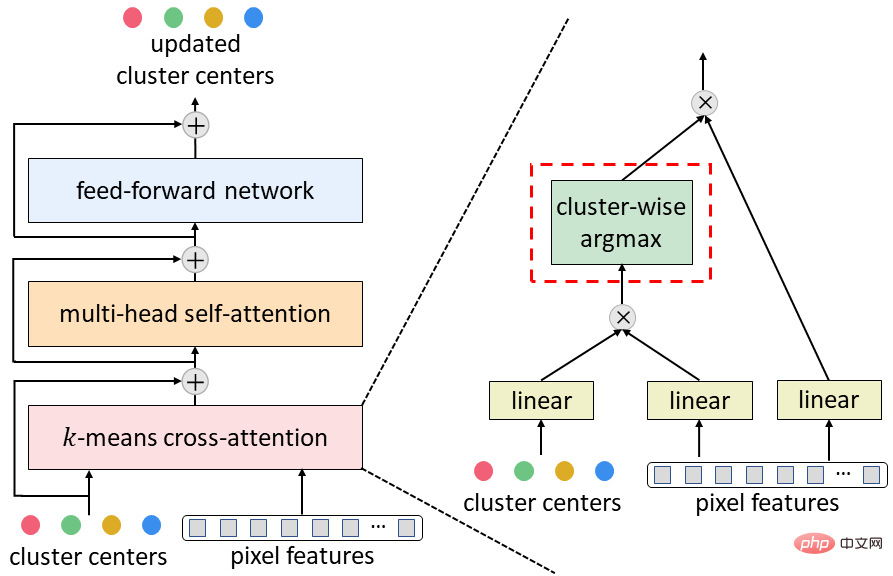

Angesichts der Popularität des k-means-Clustering-Algorithmus in CMT-DeepLab Sie haben die Queraufmerksamkeit so umgestaltet, dass die räumliche Aspekt-Softmax-Operation (d. h. die Softmax-Operation, die entlang der räumlichen Auflösung des Bildes angewendet wird) tatsächlich die Clusterzentren dem Gegenteil zuordnet, Pixel entlang der Cluster-Zentralanwendung.

In kMaX-DeepLab vereinfachen wir räumliches Softmax weiter zu Cluster-Argmax (d. h. wenden Argmax-Operationen entlang der Clustermitte an).

Sie weisen darauf hin, dass die argmax-Operation dieselbe ist wie die harte Zuweisung (d. h. ein Pixel wird nur einem Cluster zugewiesen), die im k-means-Clustering-Algorithmus verwendet wird.

Die Rekonstruktion der Kreuzaufmerksamkeit von MaskTransformer aus einer Clustering-Perspektive verbessert die Segmentierungsleistung erheblich und vereinfacht die komplexe MaskTransformer-Pipeline, um sie besser interpretierbar zu machen.

Zuerst wird eine Encoder-Decoder-Struktur verwendet, um Pixelmerkmale aus dem Eingabebild zu extrahieren. Die Pixel werden dann mithilfe einer Reihe von Clusterzentren gruppiert, die basierend auf Clusterzuweisungen weiter aktualisiert werden. Schließlich werden die Clusterzuweisungs- und Aktualisierungsschritte iterativ durchgeführt, und die letzte Zuweisung kann direkt als Segmentierungsvorhersage verwendet werden.

Um den typischen MaskTransformer-Decoder (bestehend aus Kreuzaufmerksamkeit, Mehrkopf-Selbstaufmerksamkeit und Feed-Forward-Netzwerk) in die oben vorgeschlagene k-Mittel-Kreuzaufmerksamkeit umzuwandeln, nur räumlich gesehen Softmax Ersetzt durch den maximalen Parameter des Clustermodus.

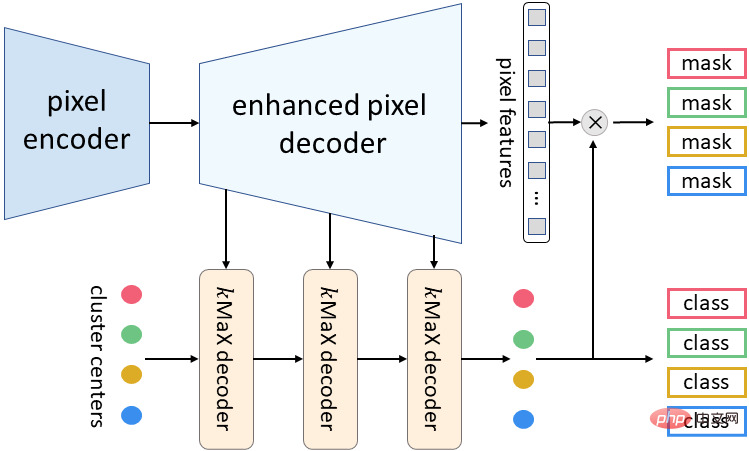

Die diesmal vorgeschlagene Metaarchitektur von kMaX-DeepLab besteht aus drei Komponenten: Pixel-Encoder, erweiterter Pixel-Decoder und kMaX-Decoder.

Pixel-Encoder ist das Rückgrat jedes Netzwerks und wird zum Extrahieren von Bildfunktionen verwendet.

Der erweiterte Pixeldecoder umfasst einen Transformer-Encoder zur Verbesserung der Pixelfunktionen und eine Upsampling-Ebene zur Generierung von Funktionen mit höherer Auflösung.

Eine Reihe von kMaX-Decodern wandelt Clusterzentren in (1) Maskeneinbettungsvektoren um, die mit Pixelmerkmalen multipliziert werden, um vorhergesagte Masken zu generieren, und (2) Klassenvorhersagen für jede Maske.

Meta-Architektur von kMaX-DeepLab

Forschungsergebnisse

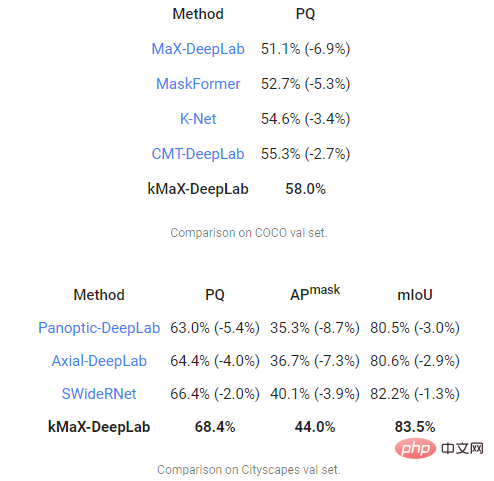

Schließlich verwendete das Forschungsteam die Metrik Panorama Quality (PQ), um CMT-DeepLab und kMaX-DeepLab zu bewerten und MaX-DeepLab mit anderen State-of-the-Art-Modellen zu vergleichen -moderne Methoden.

Unter anderem erzielte CMT-DeepLab eine deutliche Leistungsverbesserung, während kMaX-DeepLab die Modifikation nicht nur vereinfachte, sondern auch weiter verbesserte. Der PQ für den COCO-Val-Satz betrug 58,0 %, der PQ betrug 68,4 % und der Maskendurchschnitt Die Genauigkeit betrug 44,0 % (AP), 83,5 % durchschnittlicher Schnittpunkt über der Union (mIoU) im Cityscapes-Validierungssatz, ohne Testzeiterweiterung oder Verwendung externer Datensätze.

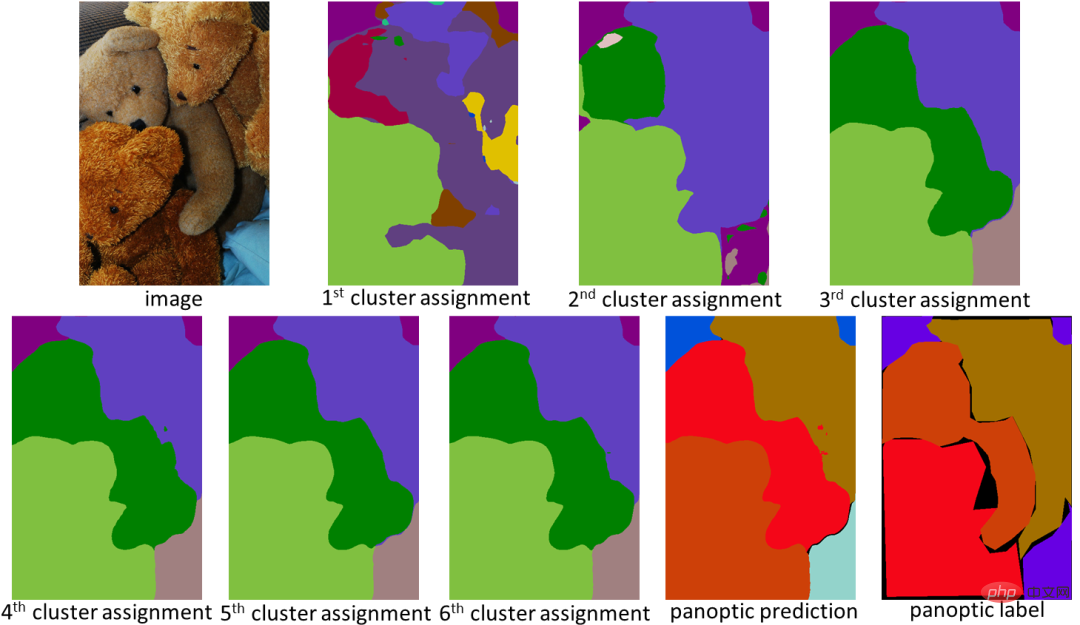

KMaX-DeepLab wurde unter dem Gesichtspunkt des Clusterings entwickelt und bietet nicht nur eine höhere Leistung, sondern kann auch die Aufmerksamkeitskarte besser visualisieren, um ihren Arbeitsmechanismus zu verstehen.

Im folgenden Beispiel führt kMaX-DeepLab iterativ Clusterzuweisungen und -aktualisierungen durch und verbessert so schrittweise die Maskenqualität.

Die Aufmerksamkeitskarte von kMaX-DeepLab kann direkt als Panoramasegmentierung visualisiert werden, wodurch der Modellarbeitsmechanismus vernünftiger wird.

Mit einfachen Modifikationen rekonstruieren CMT-DeepLab und kMaX-DeepLab die gegenseitige Aufmerksamkeit, um sie eher einem Clustering-Algorithmus zu ähneln.

Damit erreicht das vorgeschlagene Modell eine Leistung auf dem neuesten Stand der Technik bei COCO- und Cityscapes-Datensätzen.

Das Forschungsteam gab an, dass es hofft, dass die Open-Source-Version von kMaX-DeepLab in der DeepLab2-Bibliothek zur zukünftigen Forschung zum Design einer visuellen Transformer-Architektur beitragen wird.

Das obige ist der detaillierte Inhalt vonDas Google-Team bringt neuen Transformer auf den Markt, um die Panorama-Segmentierungslösung zu optimieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr