Heim >Technologie-Peripheriegeräte >KI >Anwendung und Erforschung der Branchensuche basierend auf einem vorab trainierten Sprachmodell

Anwendung und Erforschung der Branchensuche basierend auf einem vorab trainierten Sprachmodell

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-08 11:31:111846Durchsuche

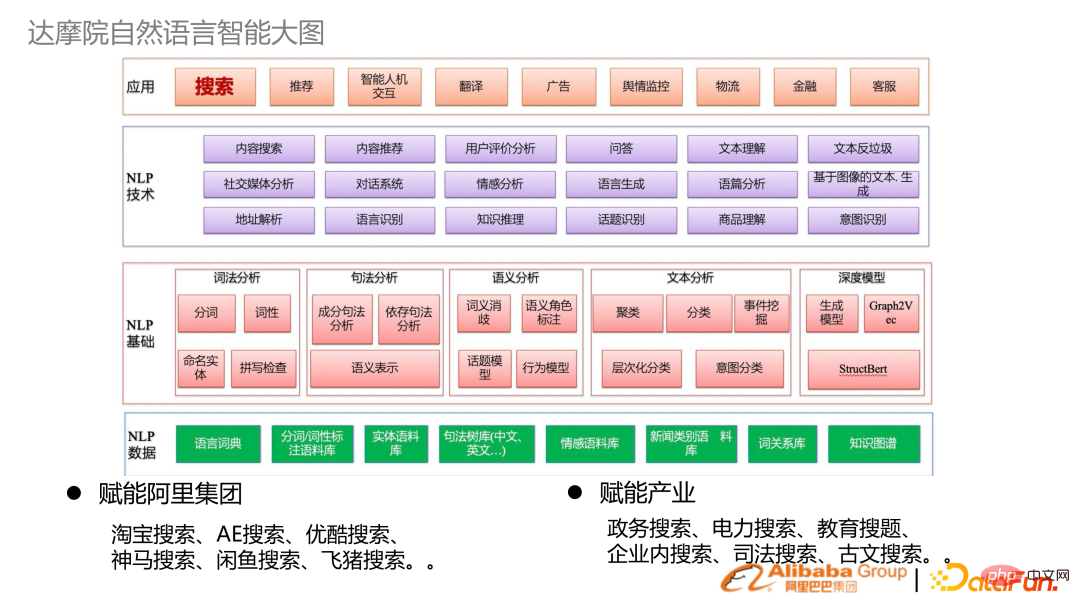

1. Hintergrund der Branchensuche 1. Gesamtbild der natürlichen Sprachintelligenz der DAMO Academy von unten Es umfasst:

NLP-Daten, NLP-Grundlexikon, syntaktische Semantik, Analysetechnologie und NLP-Technologie der oberen Ebene

Branchenanwendung: Neben der Grundlagenforschung unterstützt die DAMO Academy auch Alibaba Group und kombiniert mit Alibaba Cloud, um Branchen zu stärken. Viele Branchenszenarien für Empowerment werden gesucht.

- Die Natur der Suche im Industrie- und Verbraucher-Internet ist dieselbe: Benutzer haben Informationsbeschaffungsbedürfnisse und verfügen gleichzeitig über Informationsressourcen Bibliotheken, über Suchmaschinen Überbrücken Sie die beiden.

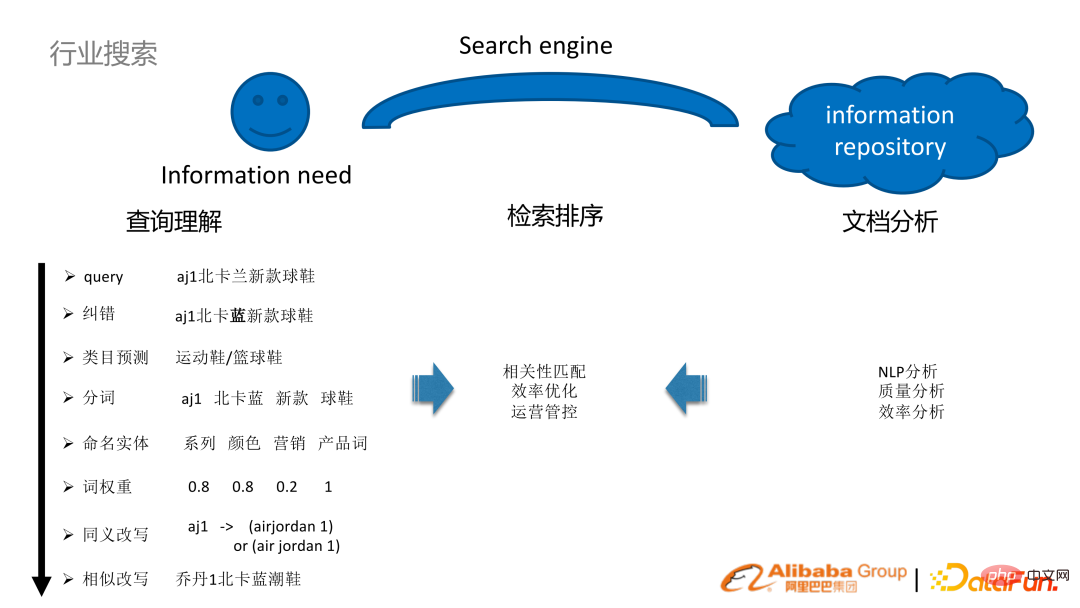

Nehmen Sie als Beispiel das E-Commerce-Szenario. Beispielsweise sucht ein Benutzer in einem E-Commerce-Shop nach aj1 North Carolina Blue New Sneakers. Um die Abfrage eines solchen Benutzers besser zu verstehen, müssen eine Reihe von Aufgaben ausgeführt werden:

Analyse des Abfrageverständnisses: NLP-Fehlerkorrektur, Vorhersage der Wortsegmentierungskategorie, Wortgewichtung der Entitätserkennung, Umschreiben der Abfrage und andere Technologien

(offline) Dokumentenanalyse: NLP-Analyse, Qualitäts- und Effizienzanalyse

Abrufen und Sortieren: Durch die Analyse von Abfragen und Dokumentanalysen, kombiniert mit einigen Abruf- und Sortiermechanismen der Suchmaschine selbst , ist es möglich, das Ziel zu erreichen, beides zu verbinden. 3. Links zur Branchensuche

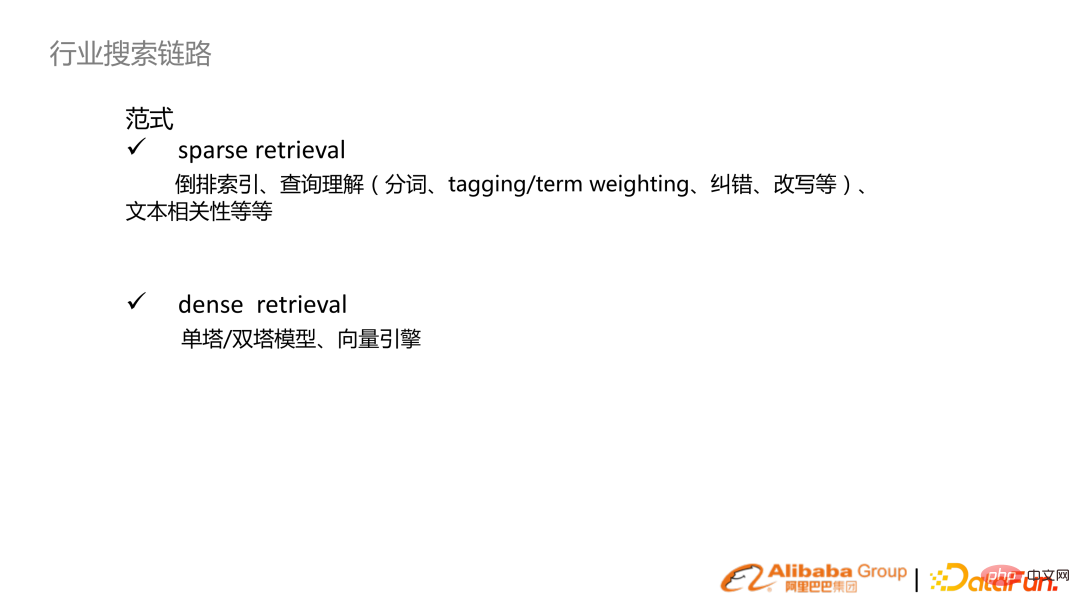

- Sparse Retrieval: Traditionell wortbasiert oder wortbasiert, um einen invertierten Index zu erstellen und darauf basierend eine Reihe von Funktionen für das Abfrageverständnis aufzubauen, einschließlich einiger Textrelevanzsortierung usw.;

- dichtes Abrufen: Mit dem Aufkommen vorab trainierter Sprachmodelle werden Einzelturm- und Doppelturmmodelle basierend auf der vorab trainierten Basis implementiert und dann mit Vektor-Engines kombiniert, um Suchmechanismen einzurichten.

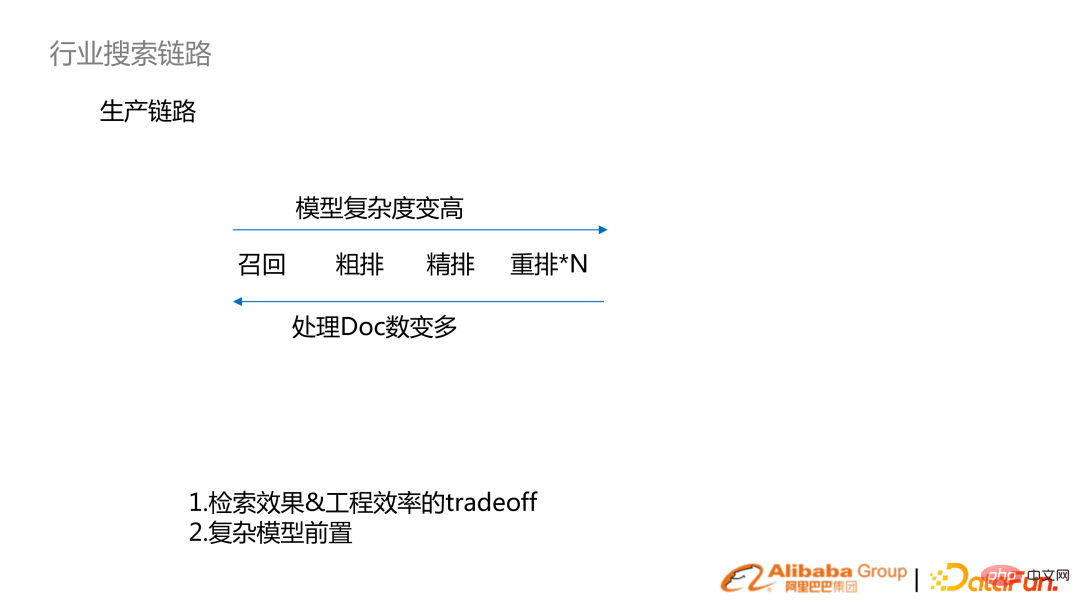

Im Allgemeinen ist die Suche in eine solche linkartige Unterteilung unterteilt: Abrufen, Sortieren (Grobsortierung, Feinsortierung, Neuordnung).

Rückrufphase:

- Keyword-Erinnerung an traditionelles Sparse-Retrieval

- dichtes Retrieval-Vektor-Recall, personalisiertes Retrieval

- Grobe Sortierstufe: Verwenden Sie den Textrelevanz-Score (statisch) für die Filterung

- Feinplanung Stufe: Relativ komplexe und relevante Modelle, die mit dem Business Efficiency Model (LTR) kombiniert werden können

Von links nach rechts werden die Modellkomplexität und die Effektgenauigkeit höher. Von rechts nach links nimmt die Anzahl der verarbeiteten Dokumente zu. Nehmen Sie als Beispiel den Taobao-E-Commerce, z. B. Rückruf (Milliarden), vorläufiges Ranking (Hunderttausende), feines Ranking (Hunderter, Tausender) und Neuordnung (Zehner).

Die Suche nach Produktionsverknüpfungen ist ein System, bei dem Abrufeffekt und technische Effizienz einen Kompromiss eingehen. Mit zunehmender Rechenleistung werden komplexe Modelle ersetzt. Beispielsweise gelangen Modelle, die zuvor fein sortiert wurden, nun nach und nach in die Phase der Grobsortierung oder sogar des Rückrufs. 🎞

Relevanz: NDCG, MRR. Conversion-Effizienz: Klickrate, Conversion-Rate Branchenszenarien Es ist sehr groß. Hier ist es in Verbraucher-Internetsuche und industrielle Internetsuche unterteilt:

Relevanz: NDCG, MRR. Conversion-Effizienz: Klickrate, Conversion-Rate Branchenszenarien Es ist sehr groß. Hier ist es in Verbraucher-Internetsuche und industrielle Internetsuche unterteilt:

Benutzergruppen und UV

- : Verbraucher-Internetsuche UV ist sehr groß und richtet sich an das industrielle Internet Mitarbeiter in Regierung und Unternehmen.

- Suchverfolgungsindikatoren

- : Bei der Nutzung des Internets streben wir nicht nur nach durchsuchbaren und genauen Suchanfragen, sondern auch nach hohen Konversionsraten. Im industriellen Internet geht es eher um die Notwendigkeit des Informationsabgleichs, also konzentrieren Sie sich auf Erinnerung und Relevanz.

- Anforderungen an technische Systeme: Die QPS-Anforderungen für Verbraucher im Internet werden sehr hoch sein und es wird sich eine große Menge an Benutzerverhalten ansammeln, was eine Echtzeit-Protokollanalyse und ein Echtzeit-Modelltraining erfordert. Die Anforderungen an das industrielle Internet werden geringer sein.

Algorithmusrichtung

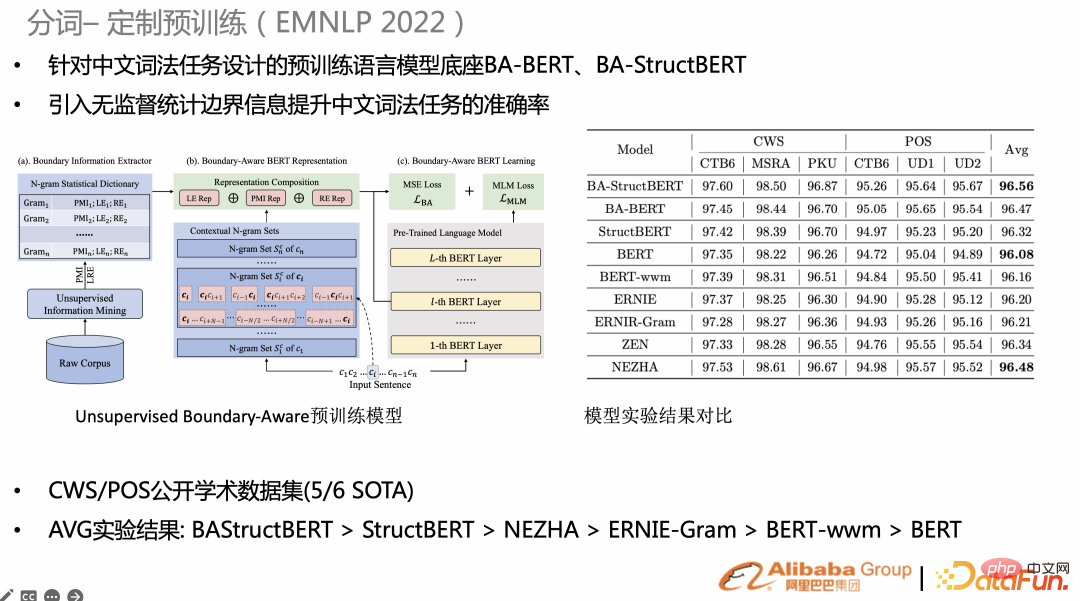

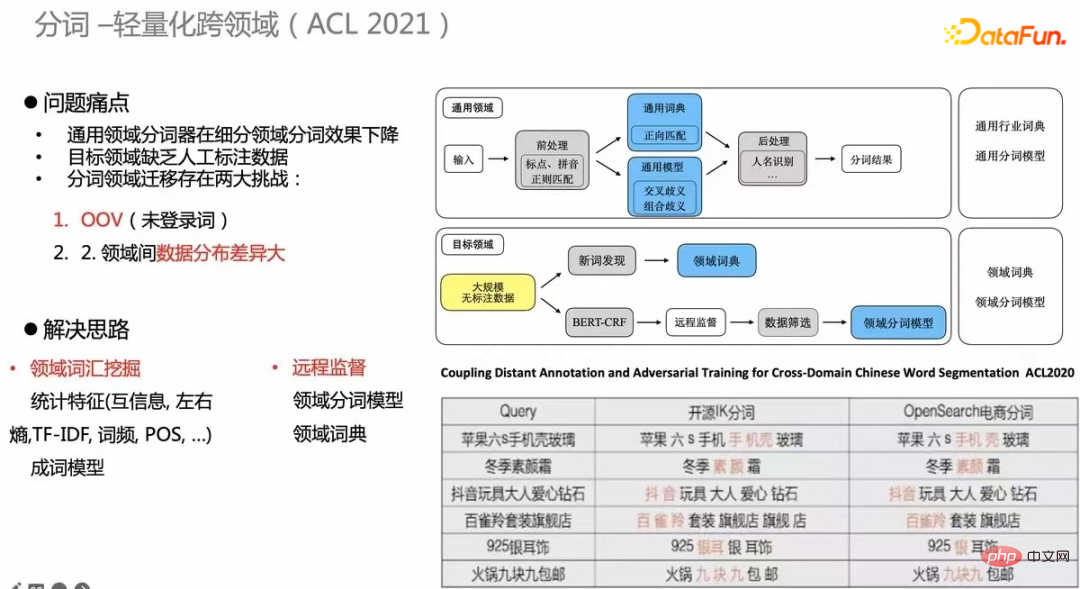

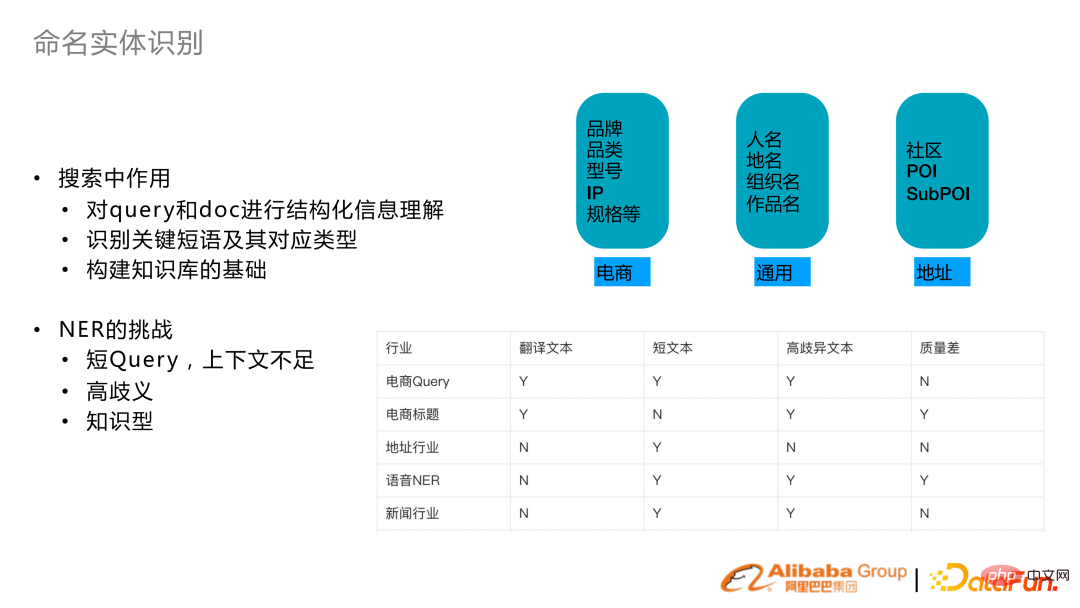

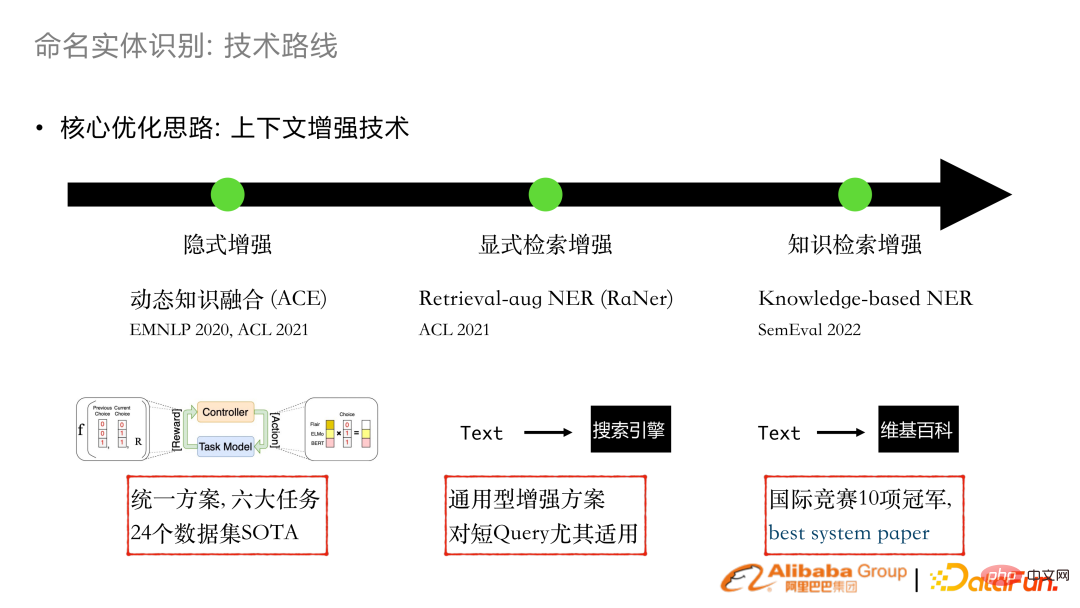

: Das Verbraucher-Internet wird größere Vorteile aus der Offline-, Nearline- und Online-Massenanalyse und -Modellierung des Benutzerverhaltens ziehen. Das Benutzerverhalten des industriellen Internets ist spärlich, daher wird dem Verständnis von Inhalten wie NLP oder visuellem Verständnis mehr Aufmerksamkeit geschenkt. Zu den Forschungsrichtungen gehören ressourcenschonendes Lernen und Transferlernen. 2. Forschung zu verwandten Technologien Seine Basis ist das vorab trainierte Sprachmodellsystem Alicemind, das auch Dokumentanalyse, Abfrageverständnis, Korrelation usw. durchführt. AliceMind ist ein hierarchisches Sprachmodellsystem vor dem Training, das von der DAMO Academy entwickelt wurde. Enthält allgemeine Vorschulungsmodelle, mehrsprachig, multimodal, Dialog usw. und ist die Grundlage für alle NLP-Aufgaben. Die Wortsegmentierung (atomare Fähigkeit) der Suche bestimmt die Granularität des Abrufindex und hängt auch mit der nachfolgenden Relevanz und der BM25-Granularität zusammen. Wenn Sie bei aufgabenspezifischen Aufgaben einige Vorschulungen anpassen, ist der Effekt besser als bei allgemeinen Vorschulungen. Jüngste Forschungen hoffen beispielsweise, unbeaufsichtigte statistische Informationen zu den nativen BERT-Vortrainingsaufgaben hinzuzufügen, wie z. B. statistische Wörter, Gram-Granularität oder Grenzentropie, und dann dem Vortraining MSE-Verluste hinzuzufügen. Auf CWS/POS und NER (rechtes Bild) haben viele Aufgaben SOTA erreicht. Eine weitere Forschung ist bereichsübergreifend. Die Kosten für die Kennzeichnung von Daten und die Erstellung von Überwachungsaufgaben sind jedes Mal sehr hoch. Daher ist es erforderlich, einen domänenübergreifenden, unbeaufsichtigten Wortsegmentierungsmechanismus aufzubauen. Die Tabelle in der unteren rechten Ecke ist ein Beispiel. Die Qualität der E-Commerce-Wortsegmentierung wurde im Vergleich zur Open-Source-Wortsegmentierung erheblich verbessert. Diese Methode wurde auch für ACL2020 veröffentlicht. 3. Erkennung benannter Entitäten Gleichzeitig basiert die Konstruktion des Suchwissensgraphen auch auf der NER-Funktion. hat die Einbettung der impliziten Verbesserungsarbeitskombination in den Jahren 2020 und 2021 durchgeführt. Durch die dynamische Integration vorhandener Wortextraktoren oder GLUE-Darstellungen kann es für viele Geschäftsaufgaben implementiert werden, um SOTA zu erreichen. Im Jahr 2021 werden wir eine explizite Retrieval-Verbesserung entwickeln, und der Kontext eines Textstücks wird durch die Suchmaschine erweitert und in die Transformer-Struktur integriert. Diese Arbeit wurde in ACL 2021 veröffentlicht.

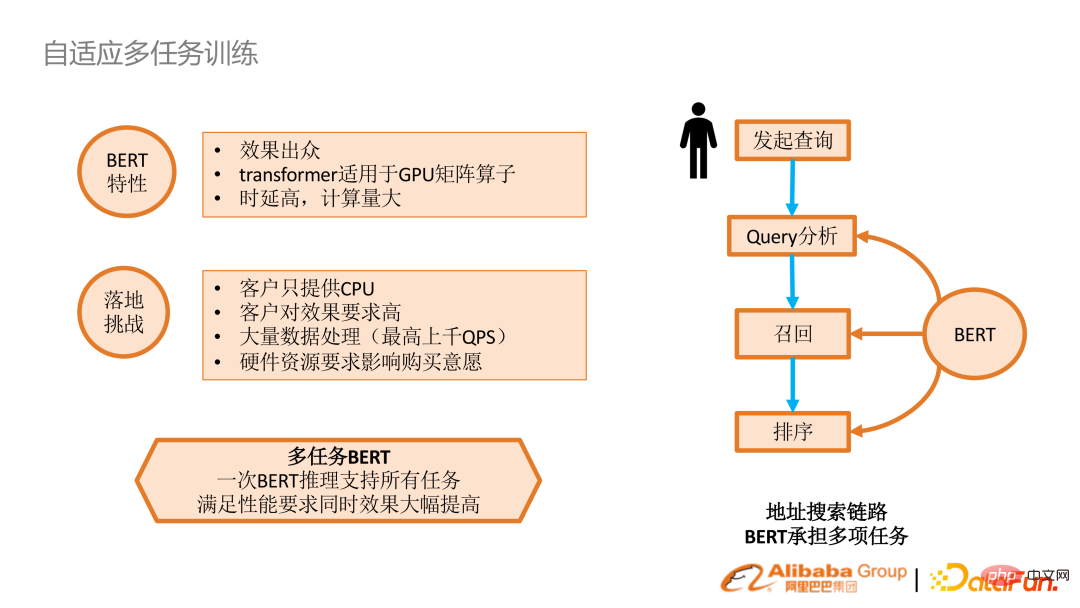

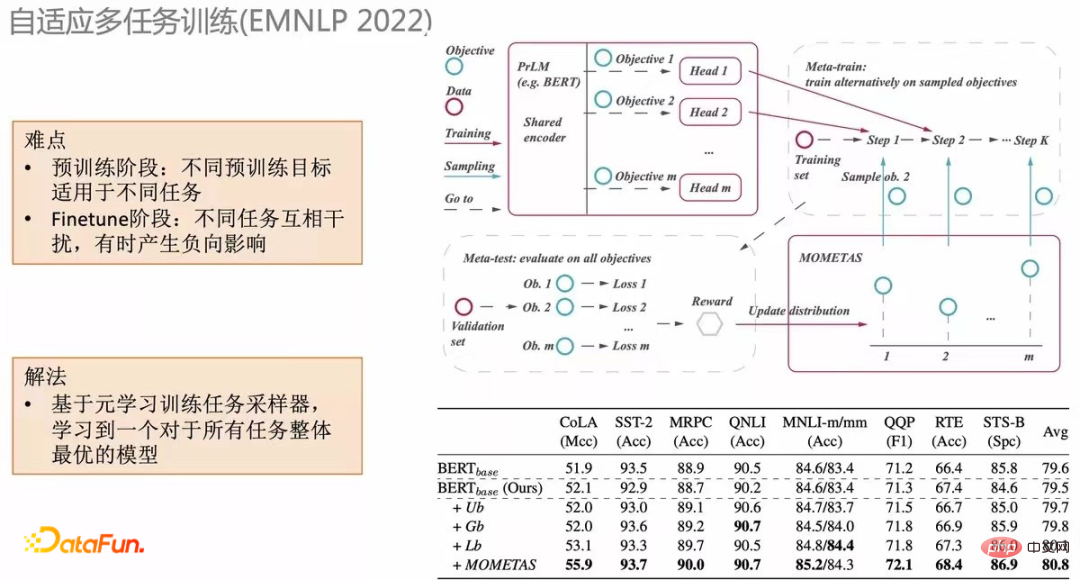

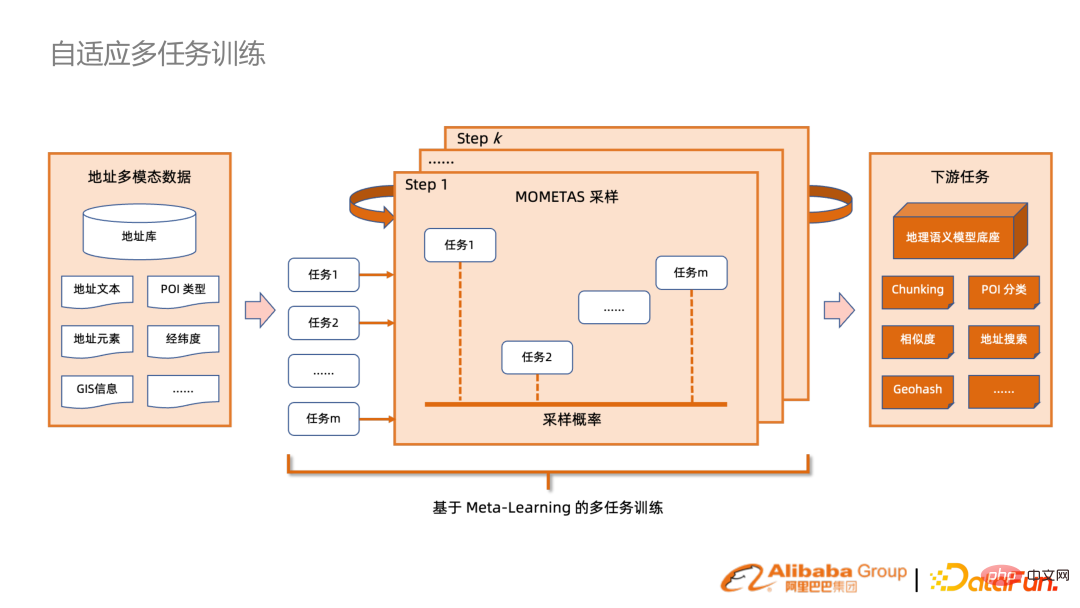

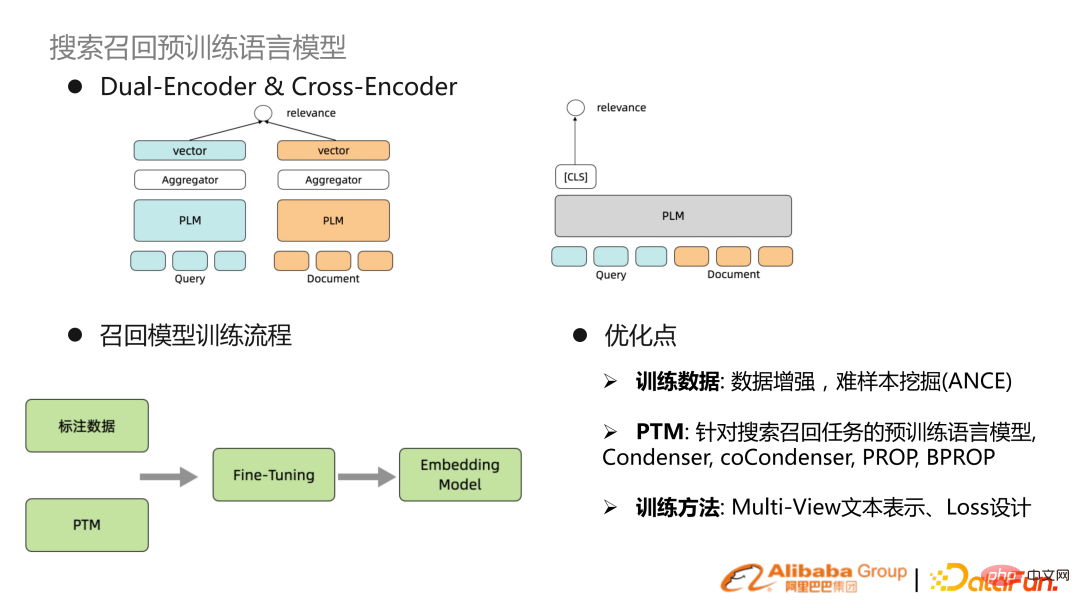

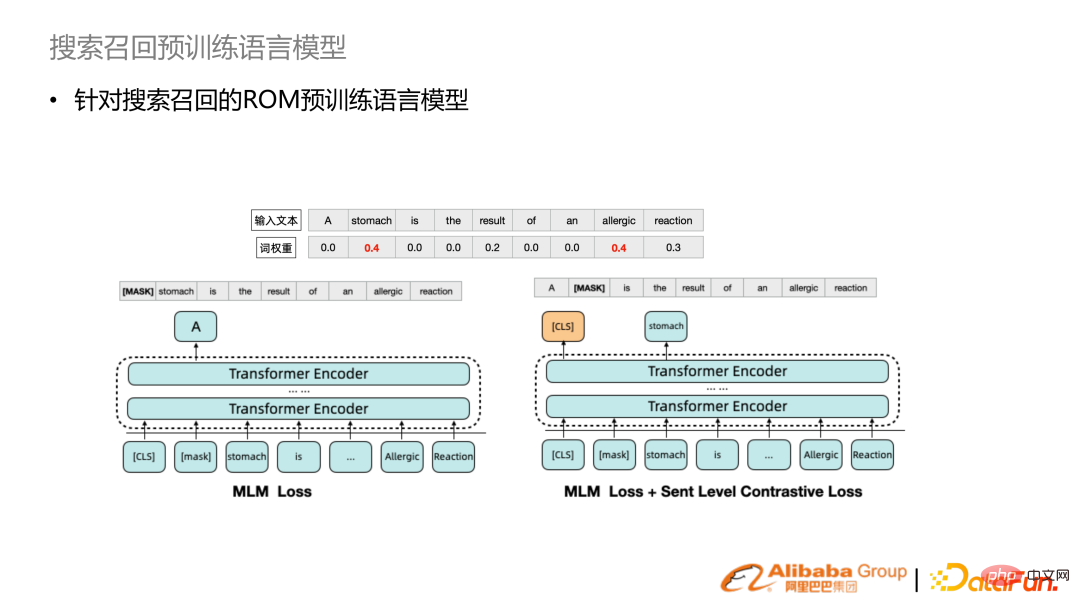

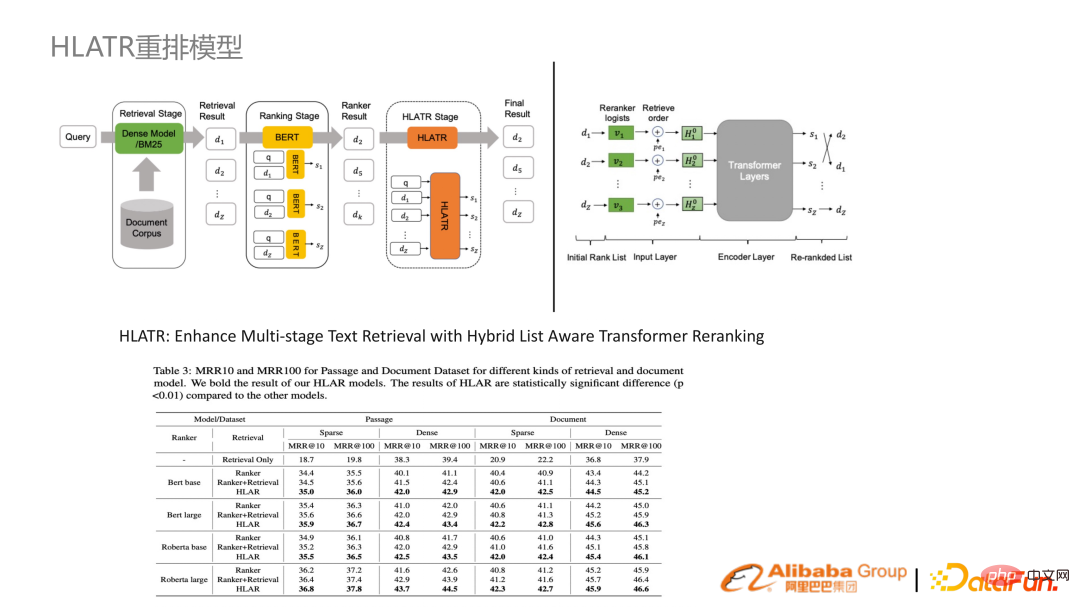

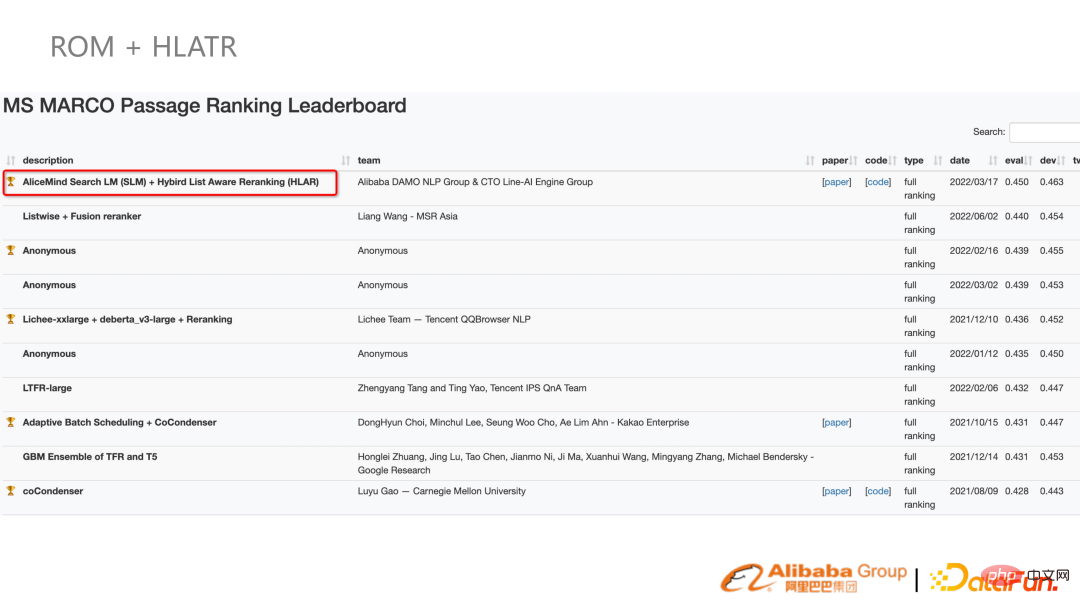

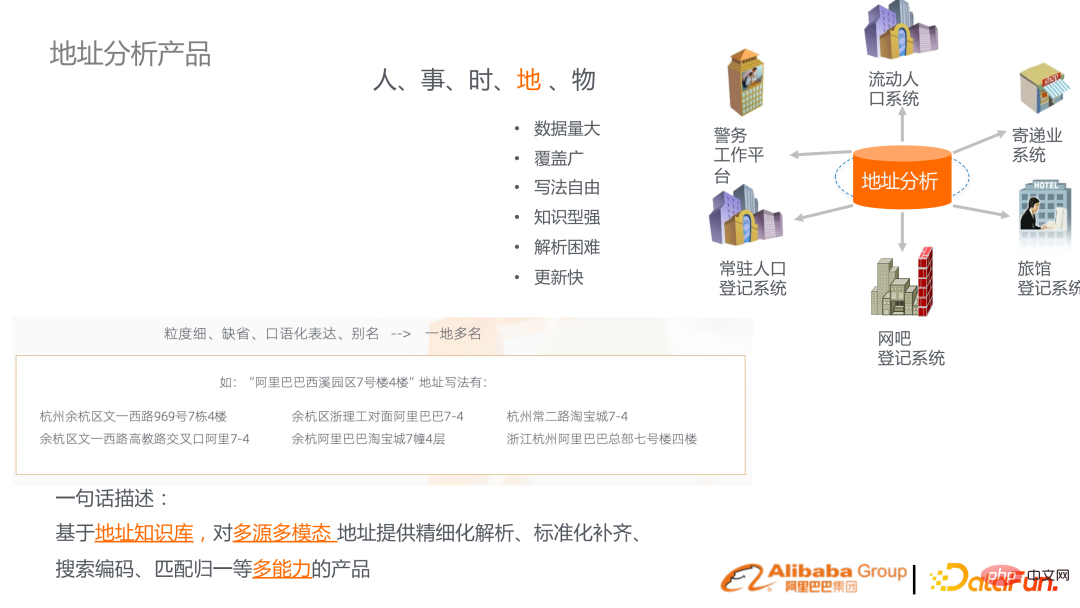

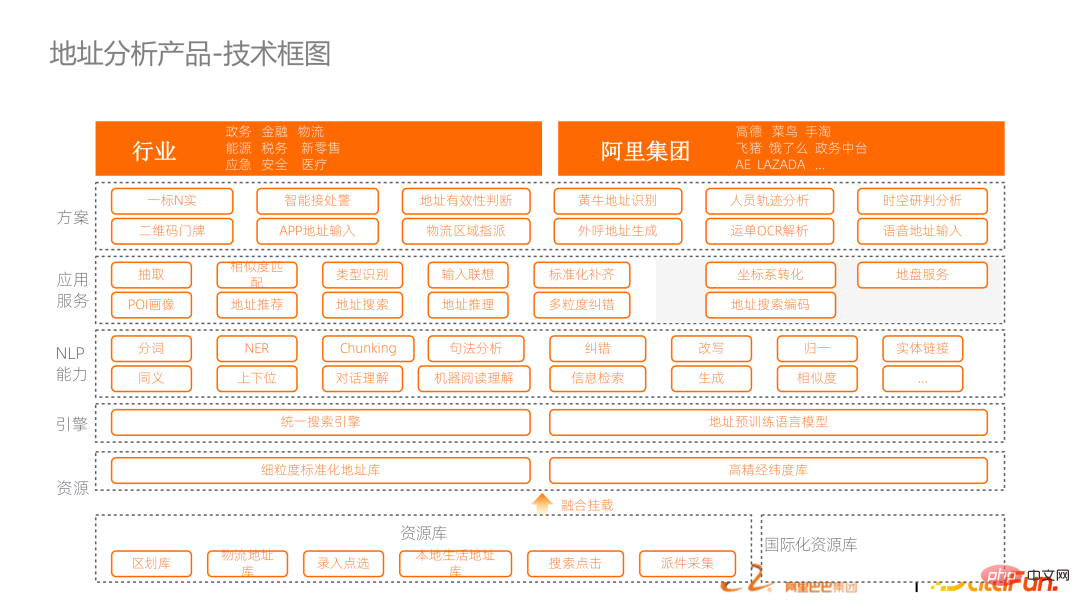

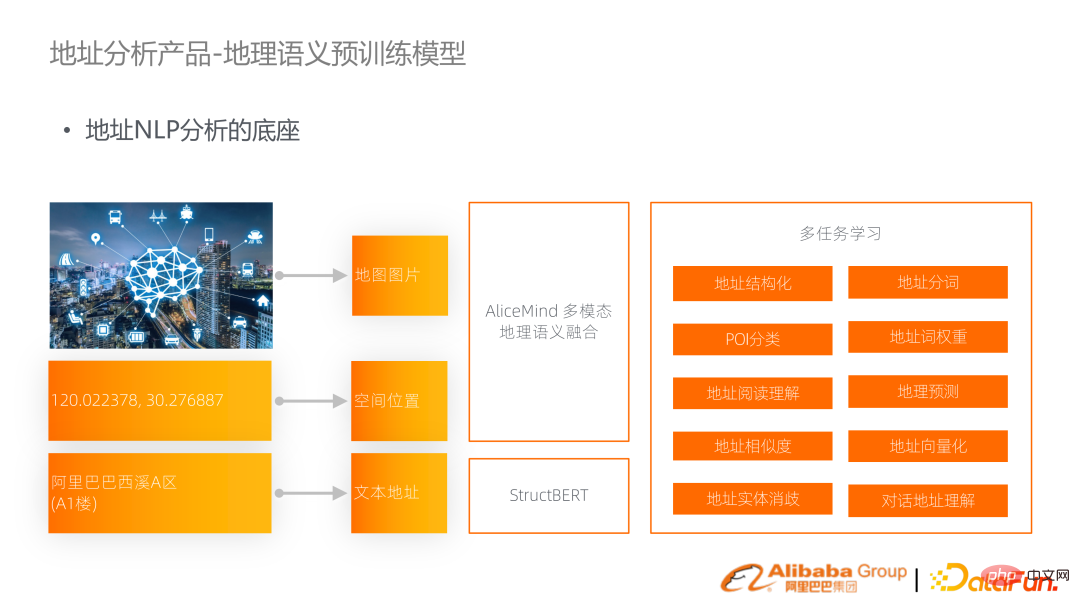

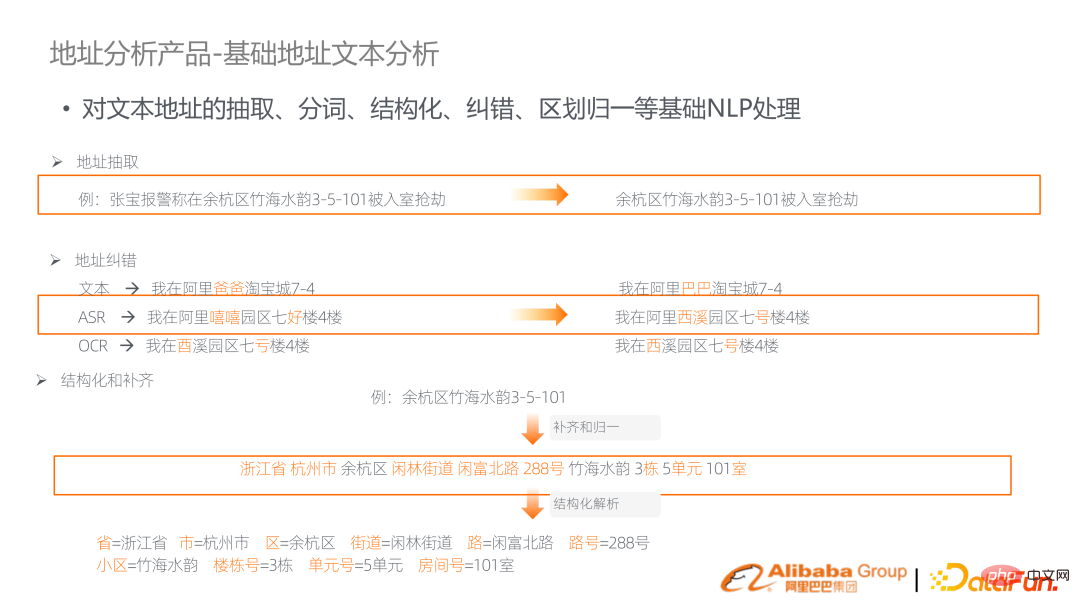

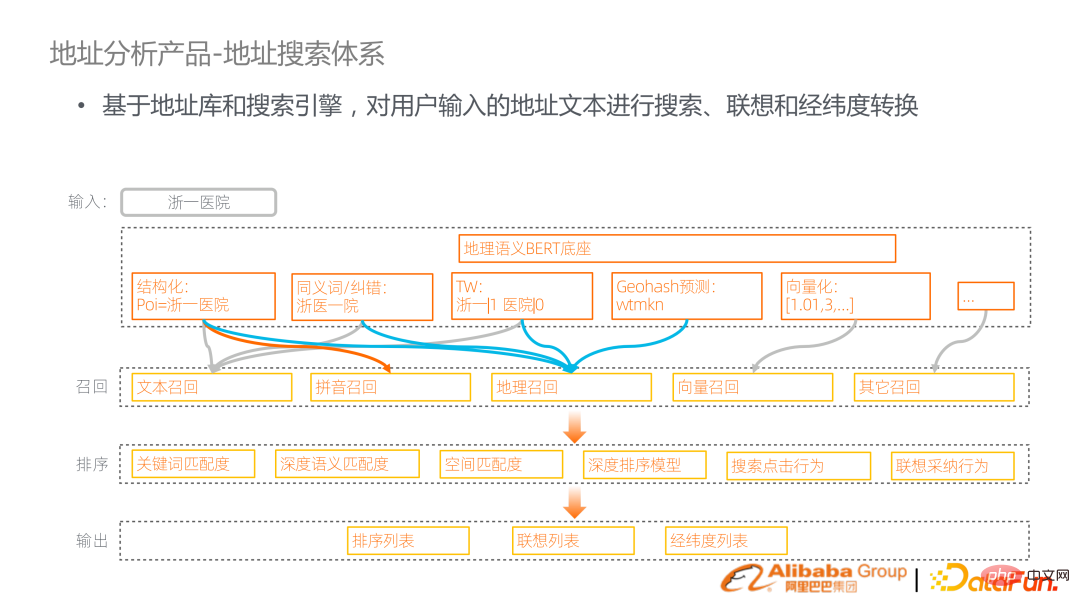

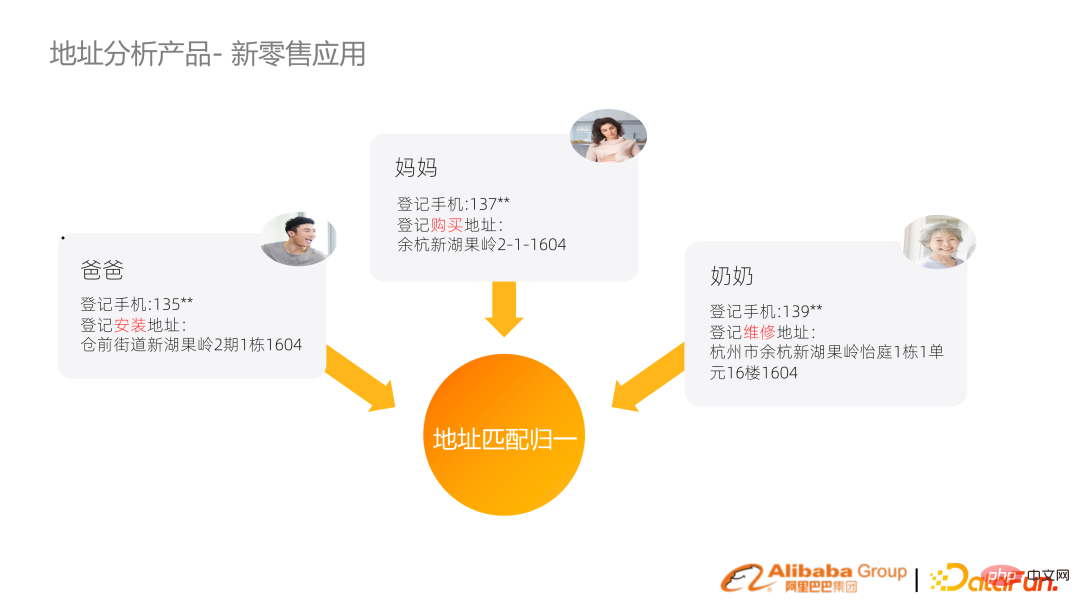

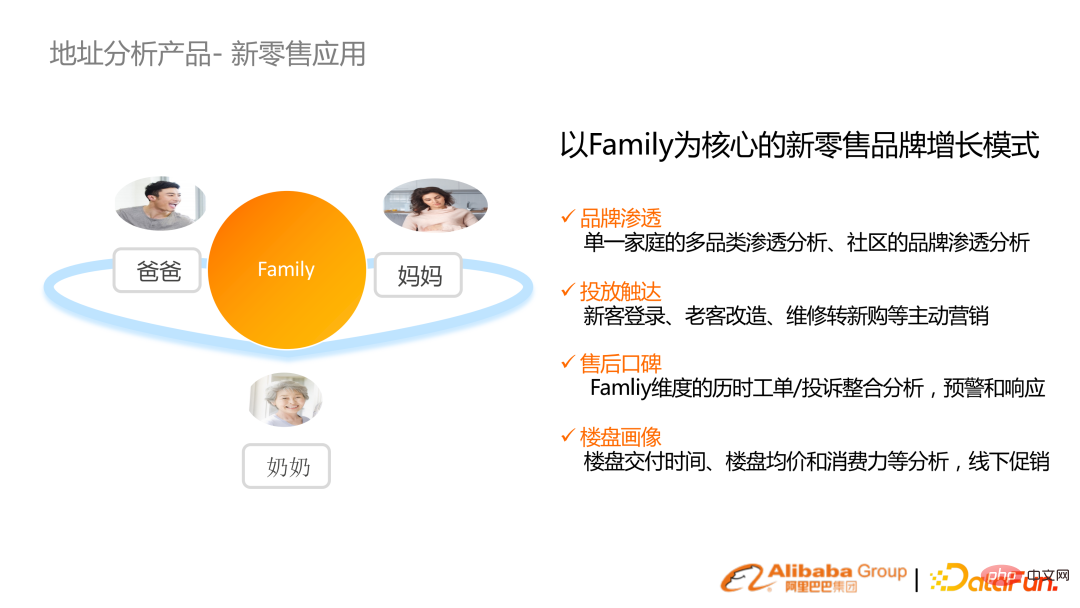

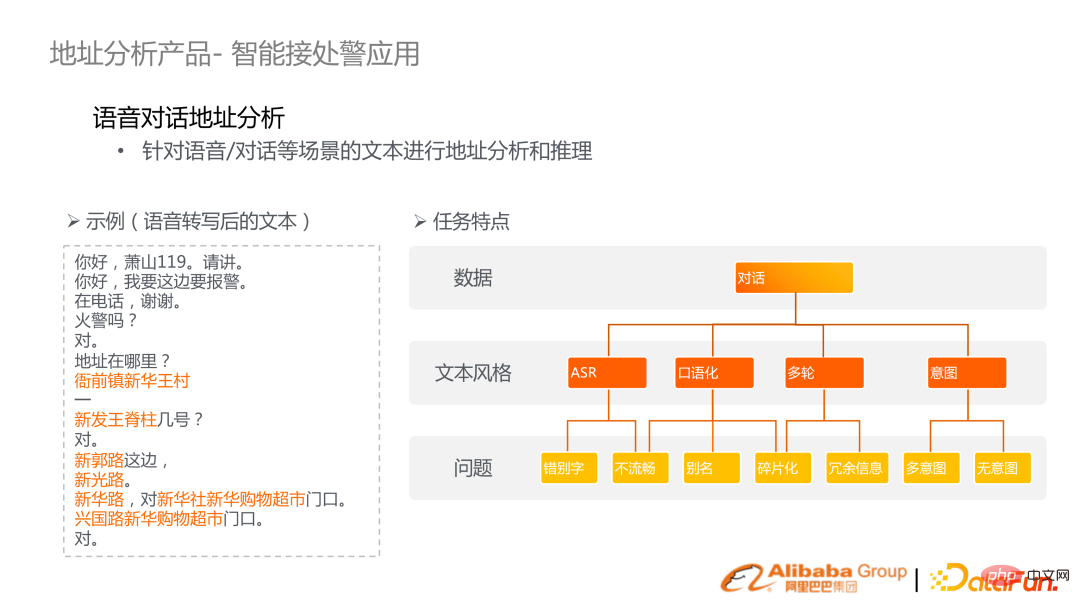

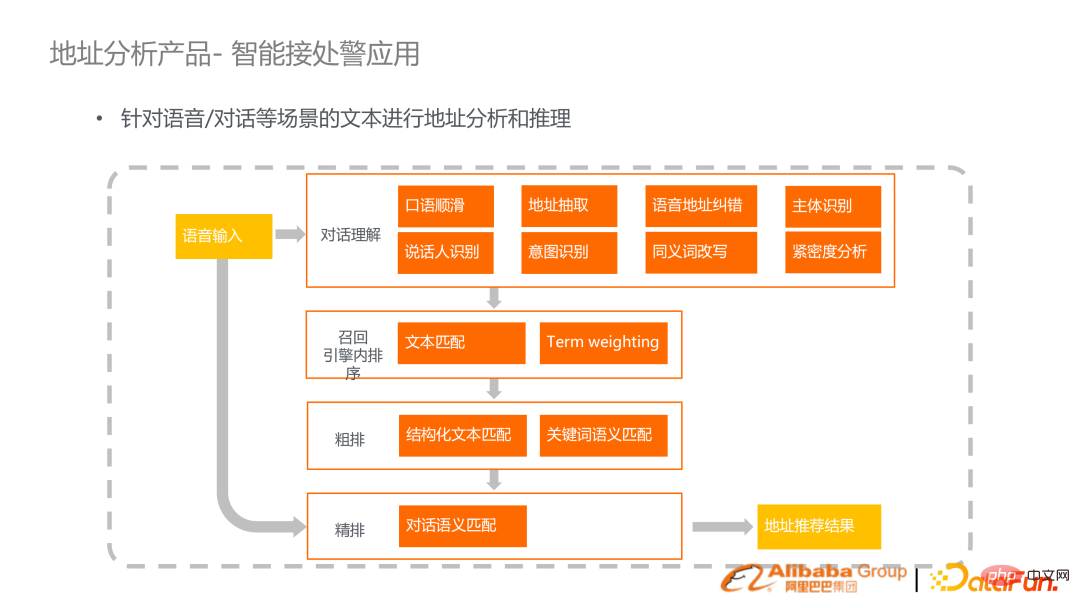

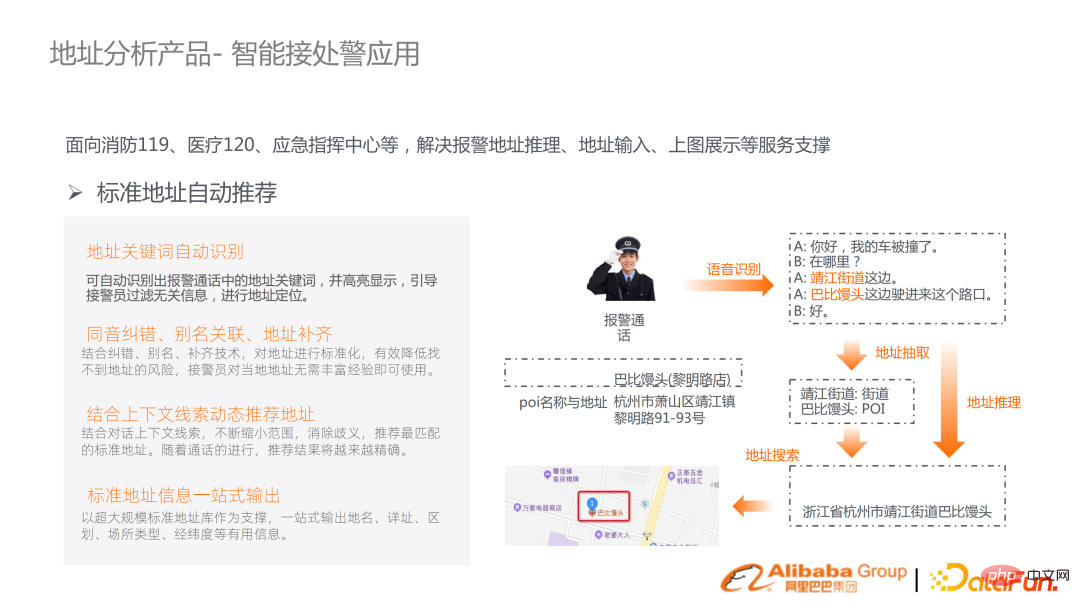

Abrufverbesserung: Zusätzlich zum Eingabesatz selbst wird zusätzlicher Kontext abgerufen und mit der Eingabe verknüpft, kombiniert mit dem Verlust von KL, um das Lernen zu erleichtern. Erhalten Sie SOTA in vielen Open-Source-Datensätzen. BERT selbst ist sehr effektiv, aber es gibt nur wenige GPU-Cluster in der tatsächlichen Produktion, und jede Aufgabe muss erledigt werden, was viel Inferenzleistung kostet. Wir überlegen, ob wir die Inferenz nur einmal durchführen und dann jede Aufgabe nach dem Encoder anpassen können, um bessere Ergebnisse zu erzielen. Eine intuitive Möglichkeit besteht darin, NLP-Abfrageanalyseaufgaben über das Metaaufgaben-Framework zu integrieren. Aber die traditionelle Metaaufgabe ist eine gleichmäßig abgetastete Verteilung. Wir schlagen MOMETAS vor, eine adaptive, auf Meta-Lernen basierende Methode, die die Stichprobe selbst an verschiedene Aufgaben anpasst. Beim Lernen mehrerer Aufgaben verwenden wir regelmäßig Validierungsdaten zum Testen, um die Auswirkungen des Lernens verschiedener Aufgaben zu sehen. Die Belohnung wiederum orientiert sich an der Auswahl früherer Schulungen. (Tabelle unten) Die Kombination dieses Mechanismus bei vielen Aufgaben bringt viele Verbesserungen im Vergleich zu UB (gleichmäßige Verteilung). Wenden Sie den oben genannten Mechanismus auf Suchszenarien in vielen Branchen an. Der Vorteil besteht darin, dass BERT nur einmal codiert und gespeichert wird und in vielen nachgelagerten Aufgaben direkt wiederverwendet werden kann, was die Leistung erheblich verbessern kann. Das gängige Trainingsparadigma ist ein überwachtes Signal und ein vorab trainiertes Modell Durch Feinabstimmung der Einbettung erhalten, charakterisiert Abfrage und Dokument. Die jüngsten Optimierungswege sind hauptsächlich Datenverbesserung oder schwieriges Beispiel-Mining, und der andere Weg ist die Optimierung vorab trainierter Sprachmodelle. Natives BERT ist keine besonders gut geeignete Textdarstellung für die Suche, daher gibt es vorab trainierte Sprachmodelle für die Suche nach Textdarstellungen. Weitere Optimierungen liegen in der Mehransicht-Textdarstellung und dem speziellen Verlustdesign. Im Vergleich zur Zufallsstichprobe von nativem BERT kombinieren wir Suchwortgewichte, um Wörter mit höherer Wortgewichtung zu erhöhen, um die Stichprobenwahrscheinlichkeit zu erhöhen, und die erlernten Darstellungen eignen sich besser für den Suchrückruf. Darüber hinaus wird vergleichendes Lernen auf Satzebene hinzugefügt. Durch die Kombination dieser beiden Mechanismen wird ein vorab trainiertes Sprachmodell von ROM vorgeschlagen. Machen Sie Experimente bei MS MARCO und vergleichen Sie die bisherigen Methoden, um die besten Ergebnisse zu erzielen. Auch bei tatsächlichen Szenensuchaufgaben kann es große Verbesserungen bringen. Gleichzeitig nahm dieses Modell auch an MS-Rankings teil. Zusätzlich zur ROM-Recall-Phase wird in der Feinranking- und Reranking-Phase eine Reihe listbewusster Transformer-Rerankings vorgeschlagen, die eine Feinabstimmung vieler Kategorien ermöglichen Die Ergebnisse des Transformers werden durch den Transformer, der stark verbessert wurde, organisch zusammengeführt. Kombiniert man die beiden Lösungen ROM und HLATR, sind die Ergebnisse von März bis jetzt (Juli) immer noch SOTA. Das von der DAMO Academy entwickelte Adressanalyseprodukt basiert auf der Tatsache, dass es in verschiedenen Branchen viele Korrespondenzadressen gibt. Chinesische Korrespondenzadressen weisen viele Merkmale auf, beispielsweise viele Standardausdrücke in umgangssprachlichen Ausdrücken. Gleichzeitig ist die Adresse selbst eine Person oder Sache und eine wichtige Entitätseinheit, die viele Entitäten in der objektiven Welt verbindet. Auf dieser Grundlage wurde daher ein Satz von Adresswissensgraphen erstellt, um Parsing, Vervollständigung, Suche und Adressanalyse zu ermöglichen. Dies ist das technische Blockdiagramm des Produkts. Von unten nach oben umfasst es die Erstellung des Adresswissensdiagramms und des vorab trainierten Sprachmodells für Adressen, einschließlich eines suchmaschinenbasierten Frameworks zum Verbinden des gesamten Links. Die oben genannten Benchmark-Funktionen werden in Form von APIs bereitgestellt und in Branchenlösungen verpackt. Einer der wichtigeren Punkte dieser Technologie ist das vorab trainierte Sprachmodell der geografischen Semantik. Eine Adresse wird im Text als Zeichenfolge dargestellt, tatsächlich wird sie jedoch häufig als Längen- und Breitengrad im Raum dargestellt, und auf der Karte befinden sich entsprechende Bilder. Daher werden die Informationen dieser drei Modalitäten organisch in ein multimodales geosemantisches Sprachmodell integriert, um die Aufgaben vor Ort zu unterstützen. Wie oben erwähnt, sind viele grundlegende Fähigkeiten im Zusammenhang mit Adressen erforderlich, wie z. B. Wortsegmentierung, Fehlerkorrektur, Strukturierung und andere Analysen. Die Kernverbindung besteht darin, sie zu überbrücken, indem das geografische Sprachmodell vor dem Training überbrückt, grundlegende Aufgaben angesprochen und Suchmaschinen ausgelöst werden. Wenn Sie beispielsweise nach Zhejiang No. 1 Hospital suchen, können Sie eine Strukturierung, Synonymkorrektur, Begriffsgewichtung, Vektorisierung und Geohash-Vorhersage durchführen. Machen Sie einen Rückruf basierend auf den Analyseergebnissen. Bei diesem Link handelt es sich um einen Standardsuchlink, der Textrückrufe, Pinyin-Rückrufe und Vektorrückrufe durchführt und auch geografische Rückrufe hinzufügt. Auf den Rückruf folgt eine mehrstufige Sortierung, einschließlich der Fusion multigranularer Merkmale. Die intuitive Anwendung des Adresssuchsystems besteht darin, die Adresse in die Vorschlagsszene einzugeben oder in der Amap-Karte zu suchen, die einem Punkt im Raum zugeordnet werden muss. Als nächstes stellen wir zwei relativ industrielle Anwendungslösungen vor. Die erste ist die neue Familien-ID für den Einzelhandel. Die Kernanforderung ist die Aufrechterhaltung eines Kundenverwaltungssystems. Allerdings sind die Benutzerinformationen in den einzelnen Systemen nicht miteinander verbunden und eine effektive Integration ist nicht möglich. Zum Beispiel verkauft ein Markenhersteller eine Klimaanlage und die Familie registriert aufgrund von Kauf, Installation und Wartung verschiedene Adressen und Mobiltelefonnummern, aber die entsprechenden Adressen sind tatsächlich dieselbe Adresse. Die etablierte Technologie zur Normalisierung der Adresssuche normalisiert Adressen mit unterschiedlichen Darstellungen, generiert Fingerabdrücke und aggregiert verschiedene Benutzer-IDs im Familienkonzept. Durch das Konzept der Familienzusammenführung können bessere Penetrationsanalysen, Werbeplatzierungen und andere Marketingaktivitäten im neuen Einzelhandel erreicht werden. Ein weiteres Anwendungsszenario sind 119, 129, Notrufe und andere intelligente Alarmempfangsanwendungen. Da es um die Sicherheit von Personen und Eigentum der Menschen geht, zählt jede Sekunde. Wir hoffen, diese Effizienz durch die Kombination von Spracherkennungs- und textsemantischen Verständnistechnologien zu verbessern. (Beispiel links) Die Szene weist viele Merkmale auf, wie Tippfehler, Unflüssigkeit, Umgangssprache und andere Probleme bei der ASR-Transkription. Ziel ist es, anhand einer automatisierten Sprachtranskriptionsanalyse den Ort eines Alarms abzuleiten. Wir haben eine komplette Systemlösung vorgeschlagen, einschließlich Dialogverständnis, reibungsloser Korrektur gesprochener Sprache, Absichtserkennung und einer Kombination aus einer Reihe von Suchvorgängen von der Erinnerung bis zur Grobsuche Auswahl- und Feinauswahlmechanismus zur letztendlichen Umsetzung der Adressempfehlung. Die Verbindung ist relativ ausgereift und wurde in Brandschutzsystemen in Hunderten von Städten in China implementiert. Feuerwehrleute identifizieren bestimmte Standorte anhand von Alarmgesprächen, kombinieren Empfehlungen, Abgleiche und Adresszäune, um die spezifischen Standorte zu bestimmen und entsprechende Alarme auszusenden. 2. Fragen zur Suche nach Bildungsfotos

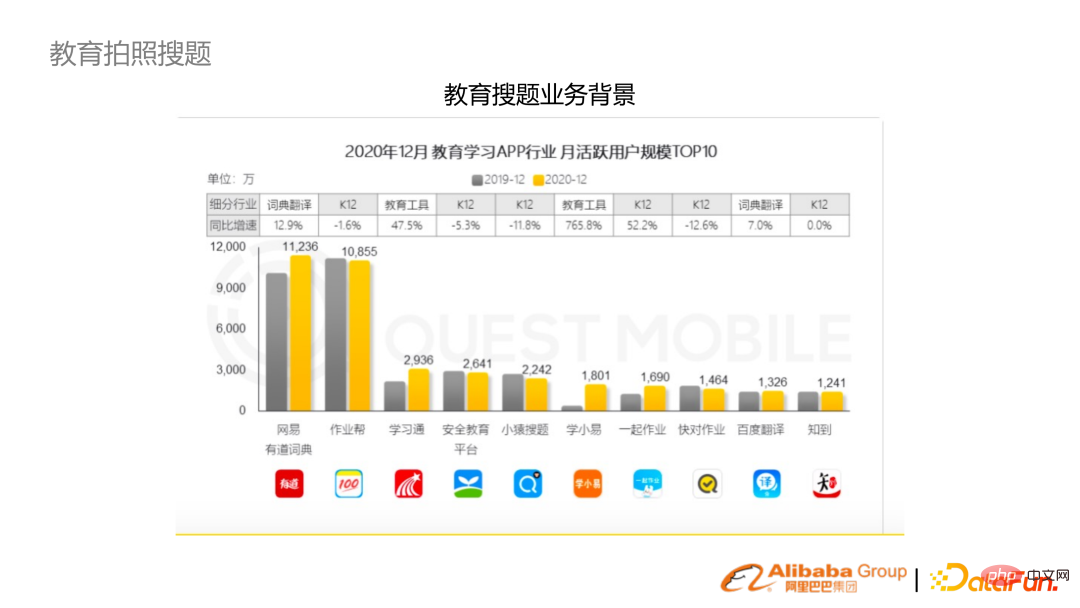

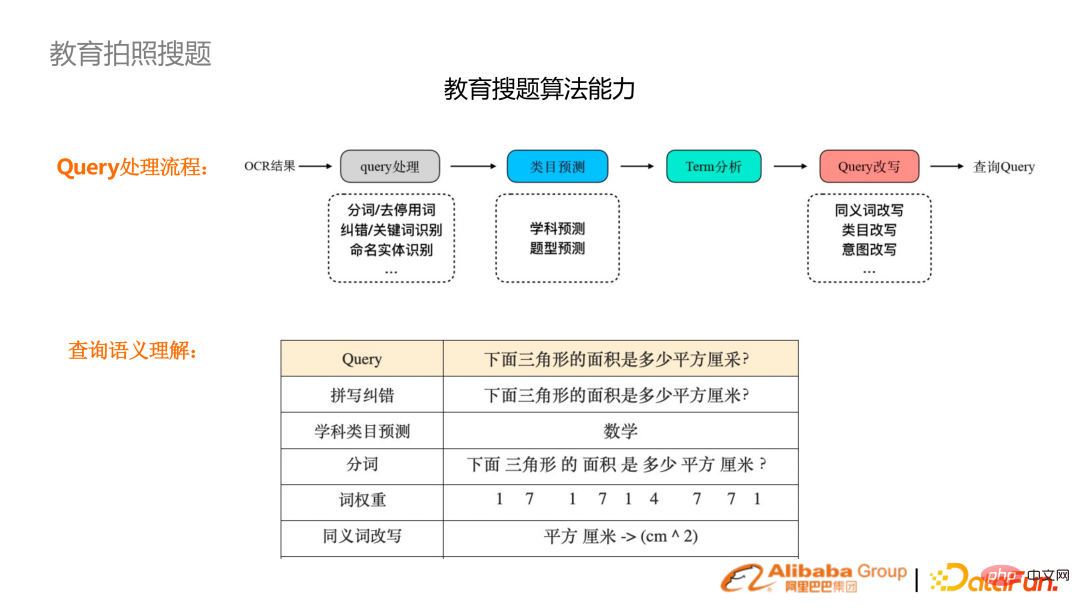

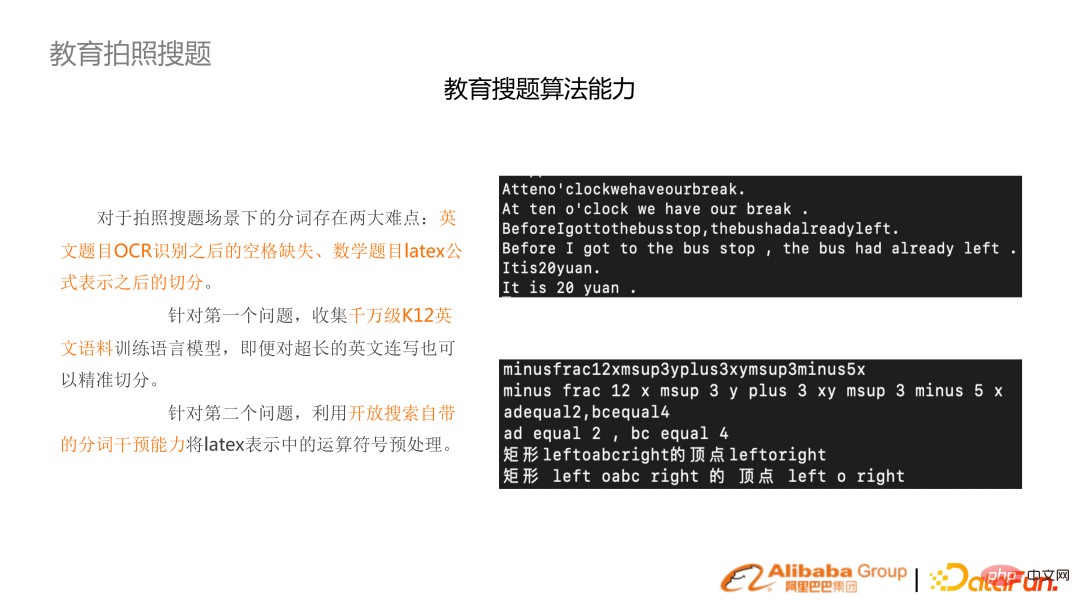

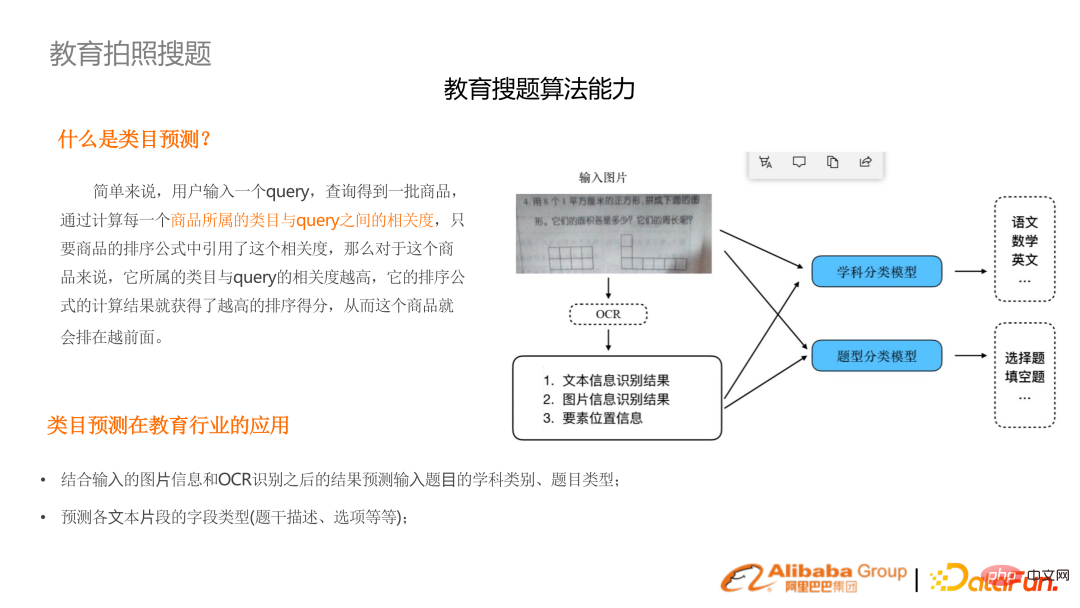

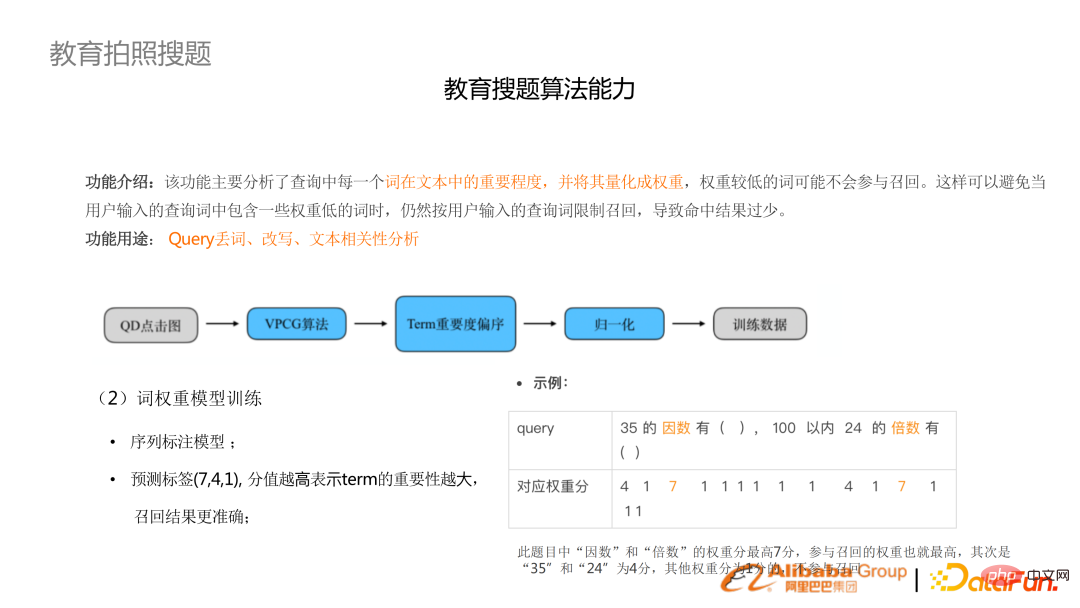

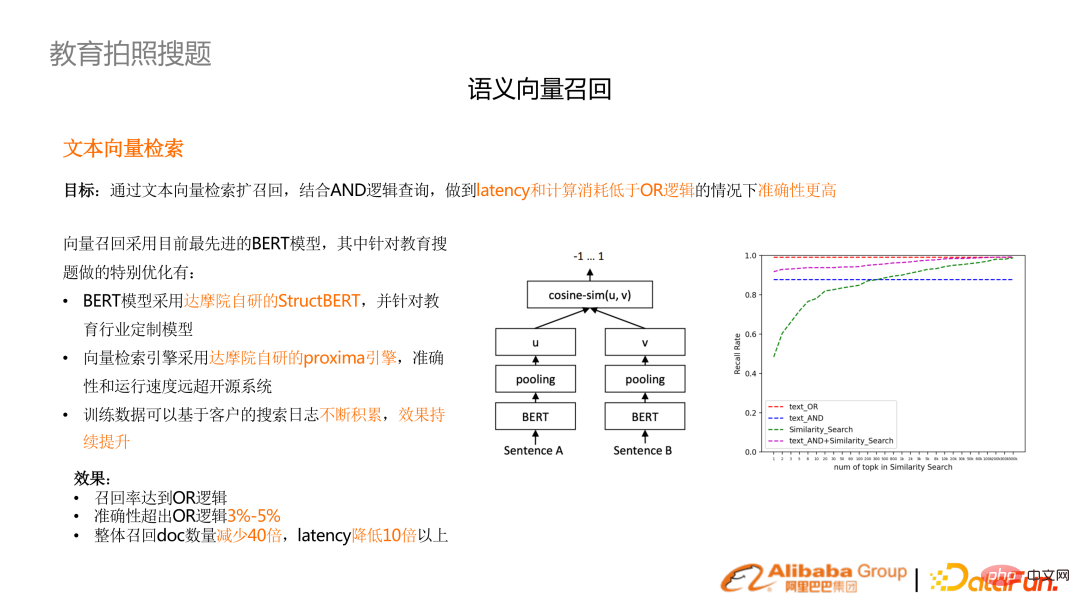

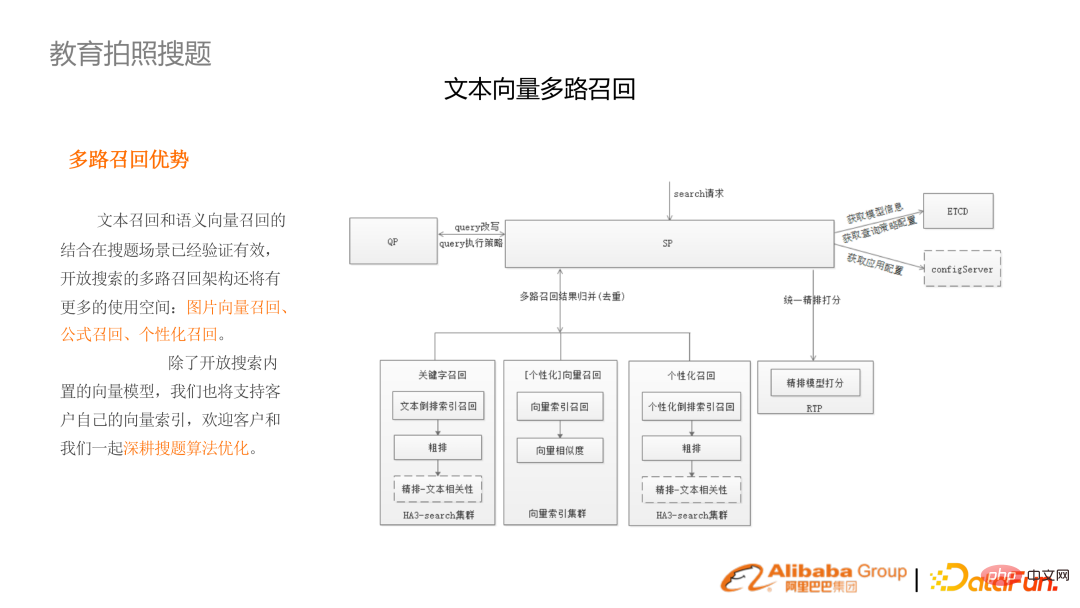

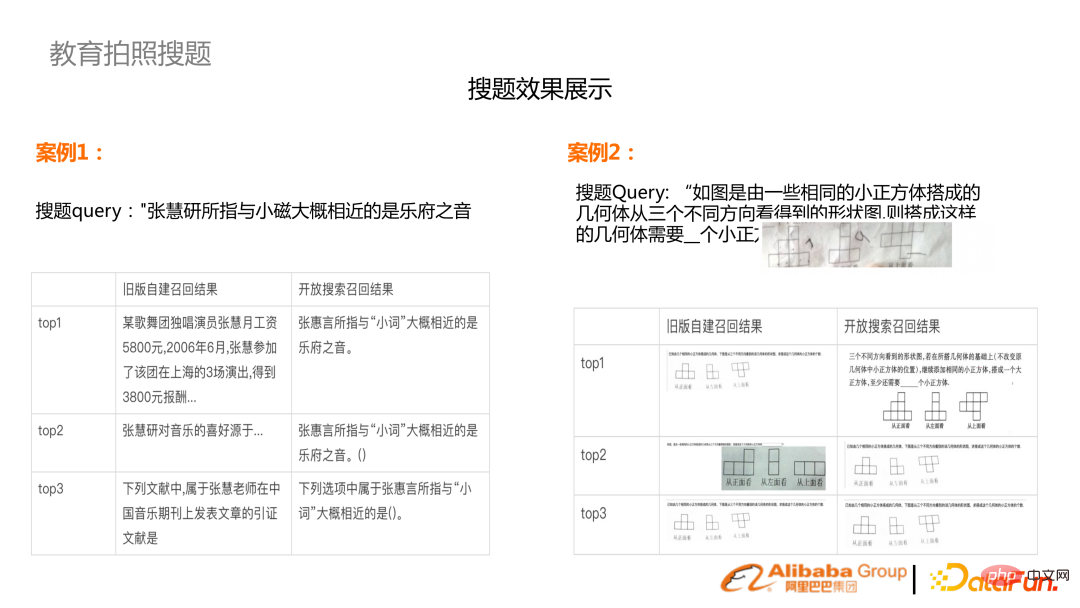

Nach dem Aufnehmen eines Fotos mit einem Mobiltelefon und der OCR-Erkennung werden beispielsweise eine Reihe von Aufgaben wie Rechtschreibkorrektur, Betreffvorhersage, Wortsegmentierung und Wortgewichtung durchgeführt, um das Abrufen zu erleichtern. Da OCR keine Leerzeichen im Englischen erkennt, wurde eine Reihe von K12-Englisch-Vortrainingsalgorithmusmodellen trainiert, um Englisch zu segmentieren. Gleichzeitig sind die Themen und Fragetypen unbekannt und müssen im Voraus vorhergesagt werden. Nutzen Sie Multimodalität, um Bilder und Text zum Zweck des Absichtsverständnisses zu kombinieren. Bei der Suche nach Fotos handelt es sich in der Regel um kürzere Suchanfragen, während es sich bei Fragen zur Fotosuche häufig um vollständige Fragen handelt. Viele Wörter in der Frage sind unwichtig, und es ist notwendig, eine Wortgewichtsanalyse durchzuführen, unwichtige Wörter zu verwerfen oder sie zu sortieren, um sie herabzustufen. Der offensichtlichste Optimierungseffekt in der Fotosuchszene ist der Vektorrückruf. Aufgrund der Leistungsanforderungen ist es schwierig, den ODER-Rückrufmechanismus zu verwenden, und die entsprechende Funktion besteht darin, dass es relativ wenige Rückrufe gibt. Um den Rückruf zu verbessern, müssen Sie mehr redundante Module wie Termgewichtung und Fehlerkorrektur durchführen. (Rechtes Bild) Der Mehrkanal-Rückrufeffekt durch Text plus Vektor übertrifft den der reinen ODER-Logik und die Latenz wird um das Zehnfache reduziert. Fotosuchlinks umfassen Bildvektorabruf, Formelabruf und personalisierten Abruf. Geben Sie zwei Beispiele an. Das erste ist das OCR-Ergebnis des Klartextes (linke Spalte). Das alte Ergebnis basiert auf dem ES-Ergebnis (einfacher OR-Rückruf) und dem Ergebnis von BM25 (rechte Spalte). verbessert. Die zweite Möglichkeit besteht darin, Bilder aufzunehmen, die Grafiken enthalten, die mit einem Bildabruf in mehreren Kanälen kombiniert werden müssen. 3. Einheitliche Suche in der Power-Wissensdatenbank Ressourcen. Nicht nur in der Elektrizitätswirtschaft haben auch andere Branchen ähnliche Anforderungen. Die Suche ist hier nicht mehr eine enge Suche, sondern umfasst auch die KI der Vorverarbeitung von Dokumenten und den Aufbau von Wissensgraphen sowie die Möglichkeit, Q&A nachträglich zu überbrücken. Das Obige ist ein schematisches Diagramm zur Erstellung einer Reihe institutioneller Standardtexte in der Wissensdatenbank für elektrische Energie, von der Strukturierung über den Abruf bis zur Anwendung. 1. AliceMind-System

2. Wortsegmentierung

Die Suche nach NER bringt auch einige Herausforderungen mit sich. Der Hauptgrund dafür ist, dass Abfragen oft relativ kurz sind und es an Kontext mangelt. Beispielsweise ist die Abfrageentität im E-Commerce höchst mehrdeutig und sachkundig. Daher besteht die Kernoptimierungsidee von NER in den letzten Jahren darin, die Darstellung von NER durch Kontext oder die Einführung von Wissen zu verbessern.

Basierend auf dieser Arbeit haben wir an der mehrsprachigen NER-Bewertung SemEval 2022 teilgenommen und 10 Meisterschaften sowie die beste Systemarbeit gewonnen.

Basierend auf dieser Arbeit haben wir an der mehrsprachigen NER-Bewertung SemEval 2022 teilgenommen und 10 Meisterschaften sowie die beste Systemarbeit gewonnen. 4. Adaptives Multitasking-Training

5. Vorab trainiertes Sprachmodell suchen und abrufen

6. HLATR-Reranking-Modell

3. Branchensuchanwendung

1. Adressanalyseprodukt

Die Fotosuchfrage verfügt über mehrere Funktionen, eine schrittweise aktualisierte Fragendatenbank und eine große Benutzerbasis. Darüber hinaus sind die Fachgebiete verschiedener Disziplinen und Altersgruppen sehr kompetent. Gleichzeitig handelt es sich um einen multimodalen Algorithmus mit einer Reihe von Verknüpfungen von der OCR bis zum anschließenden semantischen Verständnis und der Suche.

Die Fotosuchfrage verfügt über mehrere Funktionen, eine schrittweise aktualisierte Fragendatenbank und eine große Benutzerbasis. Darüber hinaus sind die Fachgebiete verschiedener Disziplinen und Altersgruppen sehr kompetent. Gleichzeitig handelt es sich um einen multimodalen Algorithmus mit einer Reihe von Verknüpfungen von der OCR bis zum anschließenden semantischen Verständnis und der Suche.  In den letzten Jahren wurde ein kompletter Satz von Verknüpfungen von Algorithmen zu Systemen für die Fotosammlung erstellt.

In den letzten Jahren wurde ein kompletter Satz von Verknüpfungen von Algorithmen zu Systemen für die Fotosammlung erstellt.

Das obige ist der detaillierte Inhalt vonAnwendung und Erforschung der Branchensuche basierend auf einem vorab trainierten Sprachmodell. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr