Heim >Technologie-Peripheriegeräte >KI >Umfassende Automatisierung des Prompt Engineering: LeCun schwieg, nachdem er es gesehen hatte, ChatGPT schaute es sich an und rief die Experten direkt an

Umfassende Automatisierung des Prompt Engineering: LeCun schwieg, nachdem er es gesehen hatte, ChatGPT schaute es sich an und rief die Experten direkt an

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-08 11:01:061120Durchsuche

Im Computerbereich bezieht sich das Eingabeaufforderungswort (Prompt) auf die führende linksorientierte Zeichenfolge vor der Ausgabe des Algorithmus. Beispielsweise sind die frühesten Wörter C:> unter MSDOS, ~: unter Linux und >>> unter IPython Eingabeaufforderungswörter. Im Jahr 2023 sind Aufforderungswörter zur natürlichsten und intuitivsten Art der Interaktion mit großen Sprachmodellen (LLMs) geworden.

Wenn ChatGPT mit der großartigen Magie in den Harry-Potter-Romanen verglichen wird, dann sind die prompten Worte wie die Zaubersprüche, mit denen die Magie beschworen wird. Ob du diesen Zauber gut anwenden kannst, hängt davon ab, ob du den Zauber deutlich oder mit einem „Akzent“ rezitierst. Für die gleiche Magie singen verschiedene Menschen den Zauber und die Kraft ist unterschiedlich. Man sagt, dass es tausend Hamlets für tausend Leser gibt, aber der Avada Kedavra-Fluch von tausend Zauberern ist nicht so effektiv wie Voldemorts Gesang allein (natürlich ist Voldemorts Gesang, egal wie gut er ist, nicht so effektiv wie der von Harry ).

Ob Sie ChatGPT und groß angelegte Sprachmodelle sinnvoll nutzen können, hängt also weitgehend von der Qualität Ihrer Eingabeaufforderungen ab. Tatsächlich haben nicht nur Sprachmodelle, darunter KI-Modelle zur Text-zu-Bild-Generierung wie DALL·E und Stable Diffusion, die vor einigen Monaten sehr beliebt waren, auch prompte Wörter einen großen Einfluss auf den Stil und die Qualität ihrer Generierung Kunst.

(Es ist auch ein Burger, und es ist auch ein Stable Diffusion 2.1-Modell. Auch wenn das Aufforderungswort im Burger auf der linken Seite „Trending on Artstation“ lautet, ist es unappetitlich. Hier ist also der Problem, das auf der rechten Seite. Können Sie erraten, was das Aufforderungswort ist? Menschen, die es lieben, sehen darin eine Verschmelzung von Technologie und Kunst, während diejenigen, die es hassen, es als Stolperstein betrachten, der die Weiterentwicklung von maschinellem Lernen und KI behindert.

ChatGPT-Gründer Sam Altman glaubt, dass

Prompt Engineering eine schwarze Technologie ist, die natürliche Sprachprogrammierung verwendet und definitiv eine Fähigkeit mit hohem Ertrag darstellt. Es gibt viele Tipps im Internet und in Foren, die diese sammeln, organisieren und sogar zu hohen Preisen verkaufen und Belohnungen anbieten. In dieser Zeit betrachten viele Menschen prompte Wörter als den Quellcode von AIGC, und entsprechende Online-Kurse sind entstanden. Entsprechend glaubt der bekannte Deep-Learning-Riese Yann LeCun, dass die Existenz von

Prompt Word Engineering auf das mangelnde Verständnis der LLMs für die reale Welt zurückzuführen ist. Er ist der Ansicht, dass der Bedarf an schnellen Worten in LLMs nur ein vorübergehender Zustand ist, was nur zeigt, dass es in aktuellen LLMs noch viel Raum für Verbesserungen gibt. Mit der kontinuierlichen Innovation der LLM-Technologie werden LLMs bald in der Lage sein, die reale Welt zu verstehen, und bis dahin wird das Prompt-Word-Projekt seinen Wert verlieren. Die Zukunft ist zu weit weg, aber objektiv gesehen hat die aktuelle Entwicklung von LLM eine gewisse Bedeutung für die Existenz von Promptwörtern. So wie die Interaktion zwischen Menschen in der realen Welt bestimmte Kommunikationsfähigkeiten erfordert, Man kann sich auch schnelle Worte als Kommunikationsfähigkeiten vorstellen, wenn Menschen mit Maschinen interagieren

. Gute schnelle Worte können Ihnen dabei helfen, bessere Ergebnisse bei der Verwendung von LLMs zu erzielen. Genau wie in der realen Welt können sich Menschen, die sich gut ausdrücken und sprechen lassen, oft koordinieren, um die Arbeit schneller zu erledigen. Obwohl die natürliche Sprache im Jahr 2023 zu einer einheitlichen Art der Kommunikation zwischen Menschen und Menschen sowie zwischen Menschen und Maschinen geworden ist, ist die Kommunikation mit LLM-Maschinen immer noch eine größere Herausforderung als die Kommunikation mit Menschen. Erstens können LLMs Nuancen, Töne oder Zusammenhänge nicht auf die gleiche Weise verstehen wie Menschen, was bedeutet, dass Stichworte sorgfältig entworfen werden müssen, damit sie eindeutig und für das Modell leicht verständlich sind. Sie können sich vorstellen, dass Sie viel mit LLM geplaudert haben und LLM dann kalt geantwortet hat: „Sprich wie ein Mensch.“ Zweitens können LLMs aufgrund der Einschränkungen des Trainingskorpus gewisse Einschränkungen beim Sprachverständnis aufweisen. Einige lange logische Ausdrücke, die Ausarbeitung, Umkehrung und sogar einfache Argumentation und Induktion in der realen Welt können in LLMs nicht perfekt verstanden und ausgeführt werden. Und einige Codewörter in LLMs werden aus dem Trainingskorpus generiert (z. B. die bekanntesten „Lass uns Schritt für Schritt denken / Lass uns Schritt für Schritt denken“ und „Unten ist mein bester Schuss / Unten ist meine beste Vorhersage“ in GPT). in der täglichen Kommunikation zwischen Menschen nicht üblich. Diese haben das Schnellwortprojekt weiter verkompliziert und zur sogenannten „Metaphysik“ befördert. Für chinesische Benutzer, deren Muttersprache nicht Englisch ist, sind schnelle Wörter auch das größte Problem, das sie davon abhält, LLMs auszuprobieren. Wenn man auf den Sommer 2022 zurückblickt, als Midjourney und Stable Diffusion auf dem englischen Markt ihren Höhepunkt erreichten, war die Reaktion der heimischen Community nicht gerade begeistert. Der Grund dafür ist, dass die prompten Wörter von Midjourney und Stable Diffusion hauptsächlich auf Englisch sind, was bei der Konstruktion einen großen Wortschatz und Popkultur-Reserven erfordert. Dies ist äußerst unfreundlich für chinesische Benutzer, die neue Dinge ausprobieren möchten. Einer der Gründe, warum ChatGPT in der chinesischen Community so beliebt ist, ist die gute Unterstützung auf Chinesisch, die die Hemmschwelle für chinesische Benutzer deutlich senkt. Chinesisch, eine der meistgesprochenen Sprachen der Welt, wird von nun an immer noch durch schnelle Wörter behindert; Sie können sich nur vorstellen, wie schwierig es für kleine Sprachen ist. Kurz gesagt, die Existenz eines prompten Wortprojekts hat ihre Rationalität. Ein gutes Erinnerungswort kann tatsächlich mit halbem Aufwand das Doppelte des Ergebnisses bringen. Gute Aufforderungsworte können uns helfen, die Fähigkeiten und Grenzen großer Sprachmodelle zu verstehen, ihr Potenzial gründlich zu erkunden und ihre Rolle in der Produktionspraxis besser zu spielen. Das bekannteste Beispiel hierfür ist Context Learning (In-Context Learning).

Verwenden Sie Magie, um Magie zu besiegen

In Wirklichkeit erfordert der Optimierungsprozess von Prompt-Wörtern wiederholte Versuch-und-Irrtum-Iterationen, was äußerst umständlich ist und auch eine gewisse Wissensreserve erfordert. Daher stellt sich die Frage: Können Aufforderungswörter im heutigen Zeitalter der KI automatisch generiert werden?

In der Antwort auf Yann LeCuns Tweet, in dem er Prompt Words kritisierte, fiel uns folgende Antwort auf: „Prompt Word Engineering ist wie die Beschreibung und Definition eines Problems in der Wissenschaft; das gleiche Problem wird von verschiedenen Menschen beschrieben, sei es gut oder schlecht. Einfach oder schwierig, lösbar oder unlösbar. Daher ist an der Existenz des Prompt-Word-Projekts nichts auszusetzen, und das Prompt-Word-Projekt selbst kann auch automatisiert werden Wörter“ (PromptPerfect.jina.ai). Mit anderen Worten, dieses neue Paradigma der Verwendung von Algorithmen zur Optimierung von Aufforderungswörtern wurde erfolgreich umgesetzt!

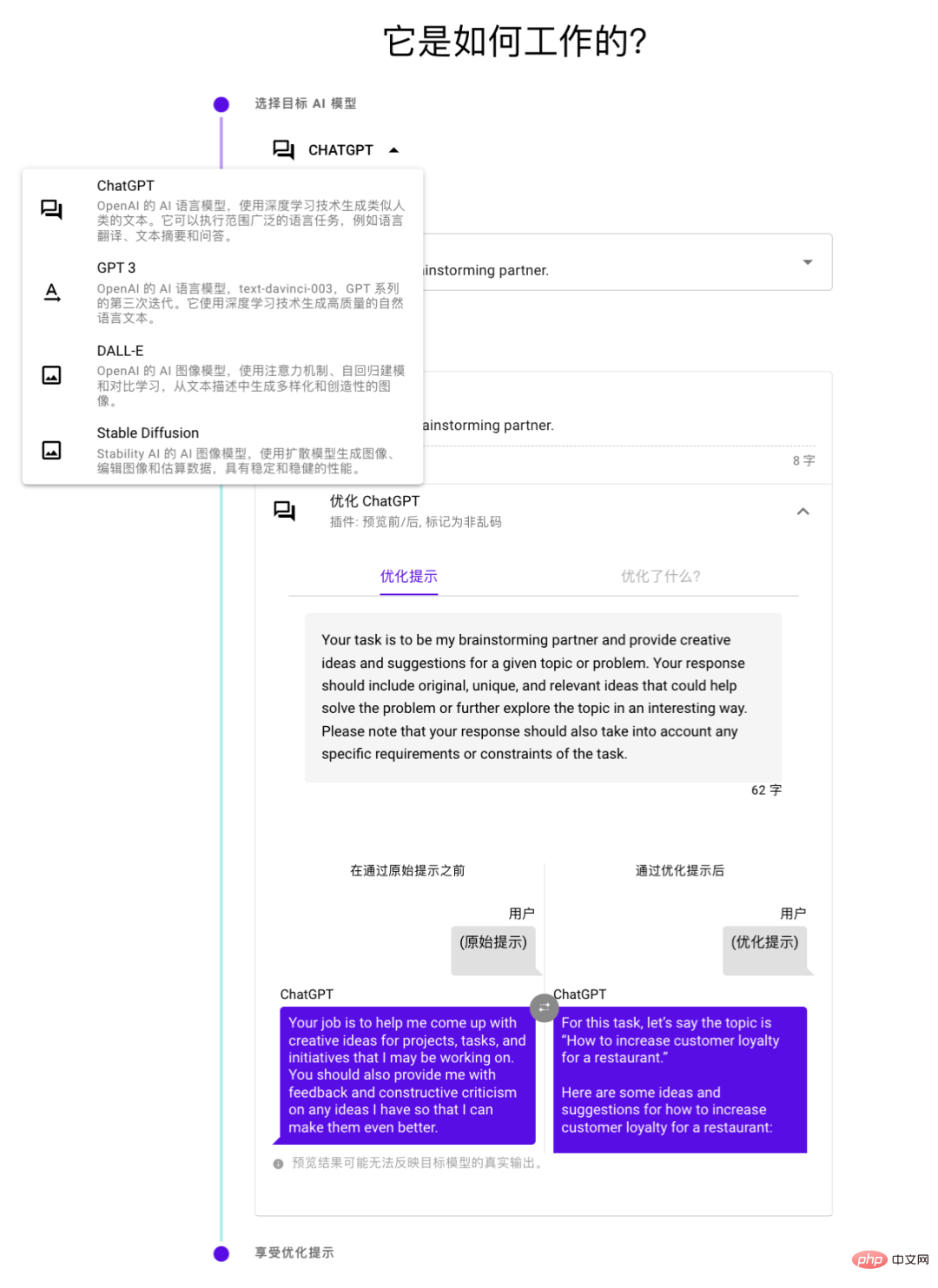

promptperfect.jina.ai, das in dieser Antwort erwähnt wird, verwendet Magie, um Magie zu zähmen und die KI nach dem Betreten leiten zu lassen Wenn Sie das Eingabeaufforderungswort verwenden, wird das optimierte „schönste Eingabeaufforderungswort“ ausgegeben und Sie können eine Vorschau der Modellausgabe vor und nach der Optimierung anzeigen. Dadurch entsteht ein positiver Kreislauf von „Müll-(Eingabeaufforderung)-in-Müll-(Inhalt)-raus“ zu „guter Eingabe – guter Ausgabe“. Laut der offiziellen Dokumentation des Produkts unterstützt es nicht nur die derzeit beliebte ChatGPT-Promptwortoptimierung, sondern auch GPT 3, Stable Diffusion und Dall-E. Lassen Sie uns als Nächstes die Technologie und Fähigkeiten dieses „AI Prompt Word Engineer“ – PromptPerfect – bewerten.

Wie lassen sich Aufforderungswörter ganz einfach in 10 Sekunden optimieren?

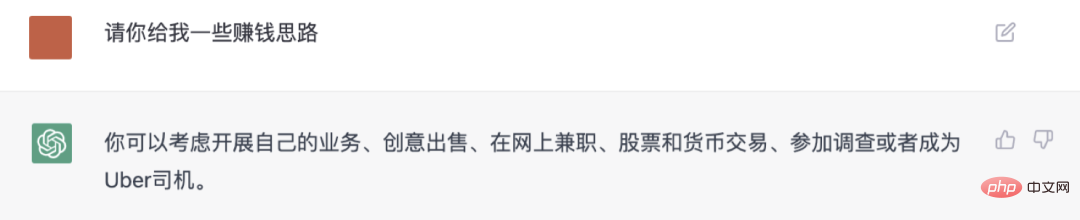

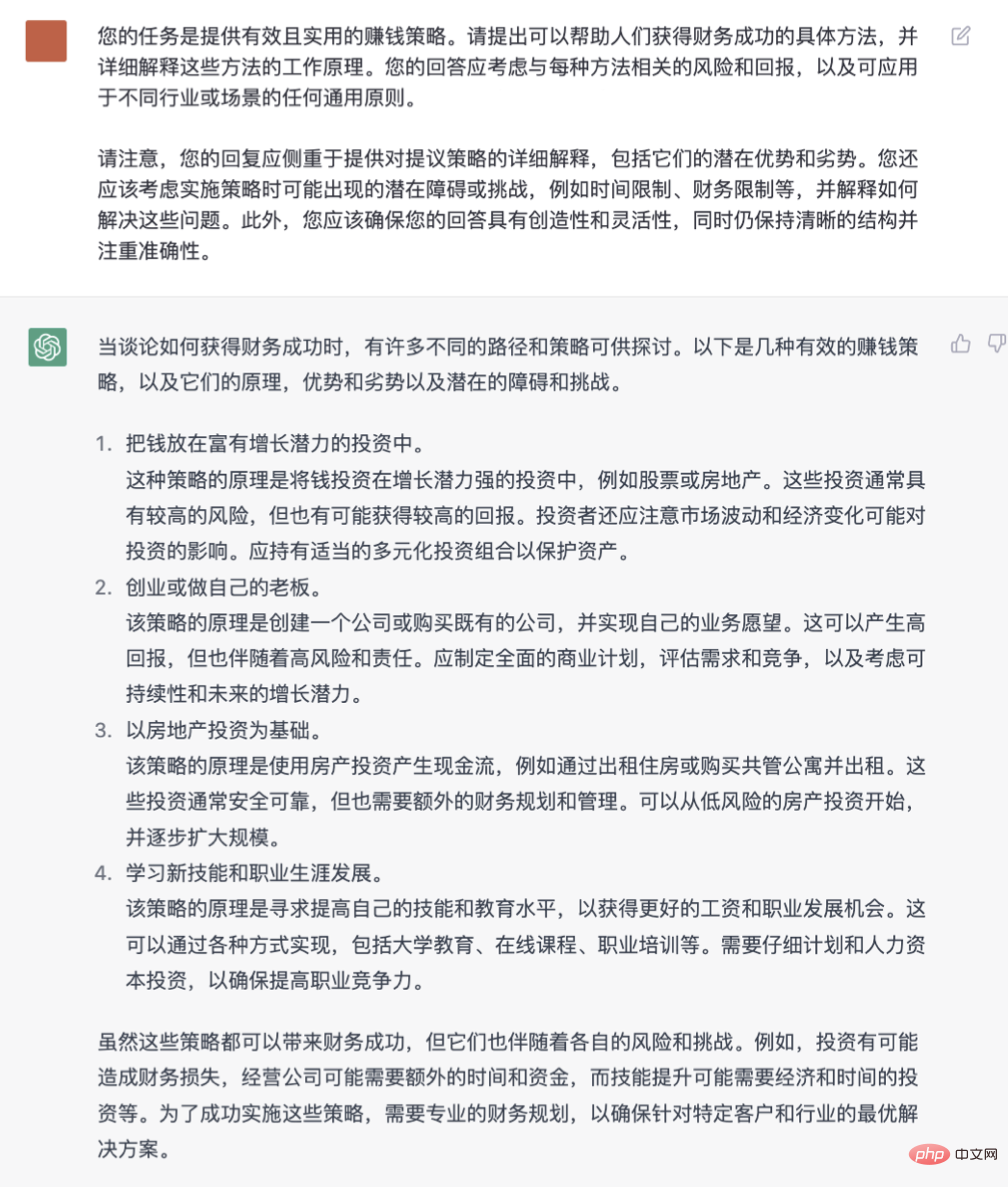

1. Wandeln Sie gesprochene Sprachanforderungen in klare Aufforderungswörter um.

Um Aufforderungswörter zu optimieren, müssen Sie die Struktur der Sprache verstehen und wissen, welche Sätze und Wörter die Intelligenz von LLMs „aktivieren“ können. Ohne diese Reserven sind die Aufforderungsworte unklar und die gesprochene Sprache ist ein Durcheinander, dann kann man sich leicht von LLM täuschen lassen. „Die schönsten Aufforderungswörter“ können aus umfangreichen Daten lernen und tiefere Sprachkenntnisse verstehen, um genauere, klarere und effektivere Aufforderungswörter zu erstellen. Ganz gleich, welche Art von Bedürfnissen und Aufgaben Sie wünschen, sie können direkt darauf zugeschnitten werden Geben Sie den genauesten Ausdruck an.

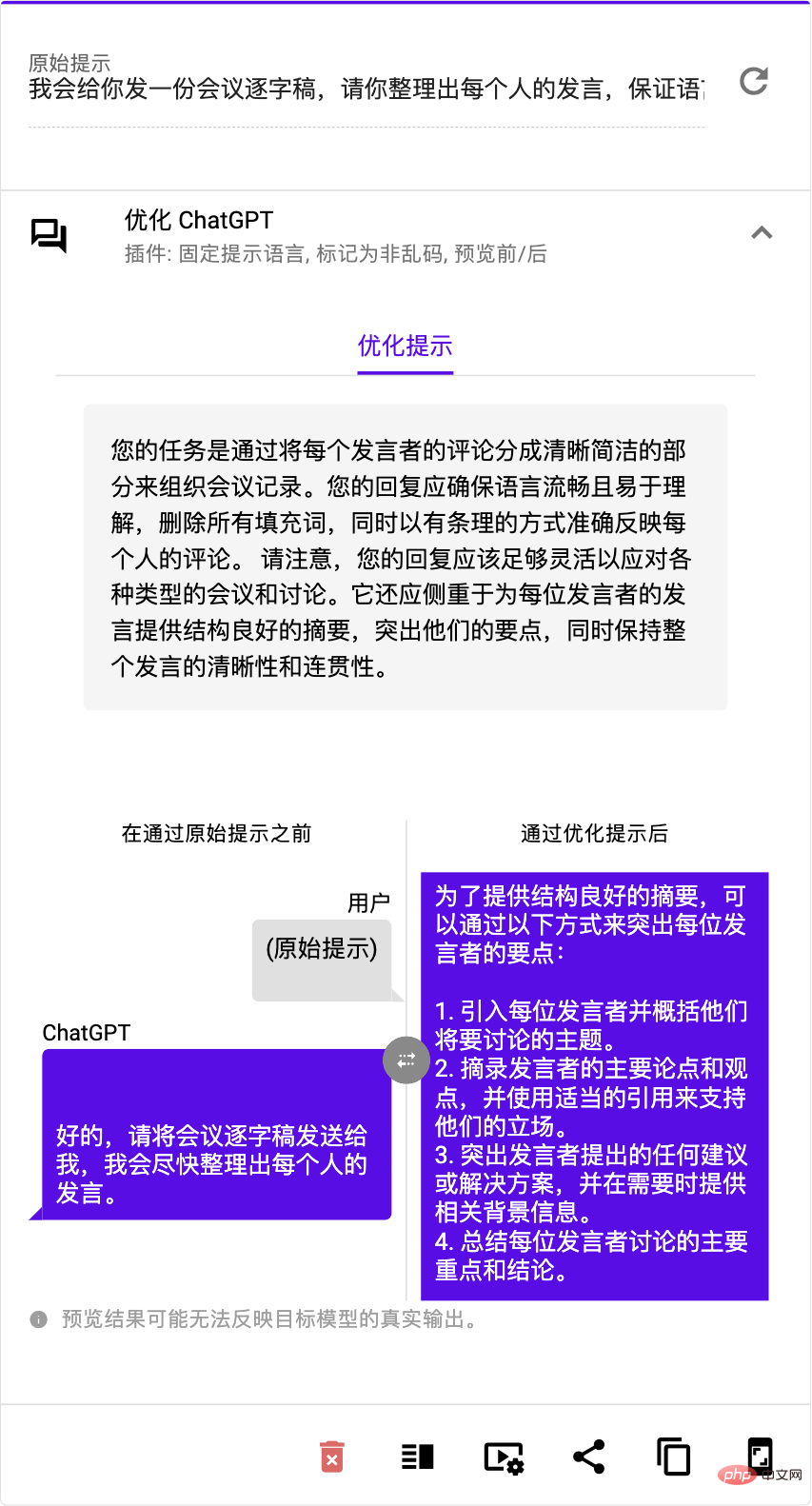

Foto Im Vergleich zu den ursprünglichen Aufforderungswörtern definieren die „schönsten Aufforderungswörter“

klare Ziele und klare Ergebnisse und fügen ChatGPT auch eine situative Vorahnungslogik hinzu , wodurch die Maßnahmen generiert werden von ChatGPT praktischer und effektiver Es wurde tatsächlich mit bloßem Auge sichtbar erheblich verbessert.

2. Beherrschen Sie mühelos die „Sprechfähigkeiten“ verschiedener LLMs/LMs.Verschiedene LLMs haben unterschiedliche Temperamente und Gewohnheiten. Wenn Sie effektiv mit ihnen kommunizieren möchten, müssen Sie die lokalen Sprechfähigkeiten erlernen. Andernfalls kann es leicht zu einem Streitgespräch kommen. Es ist, als hätte man endlich den Zauber „Stabile Diffusion“ gemeistert, nur um festzustellen, dass die Konversationsmethode von ChatGPT völlig anders ist, und man muss noch einmal von vorne beginnen. „Die schönsten Aufforderungswörter“ hilft Benutzern, die Kosten für das Erlernen verschiedener Modelle zu vermeiden, sei es ChatGPT, GPT 3, Stable Diffusion oder Dall·E usw.

Solange Sie das Modell auswählen, können Sie das am besten geeignete optimieren Eingabeaufforderungen mit einem Klick Wort.

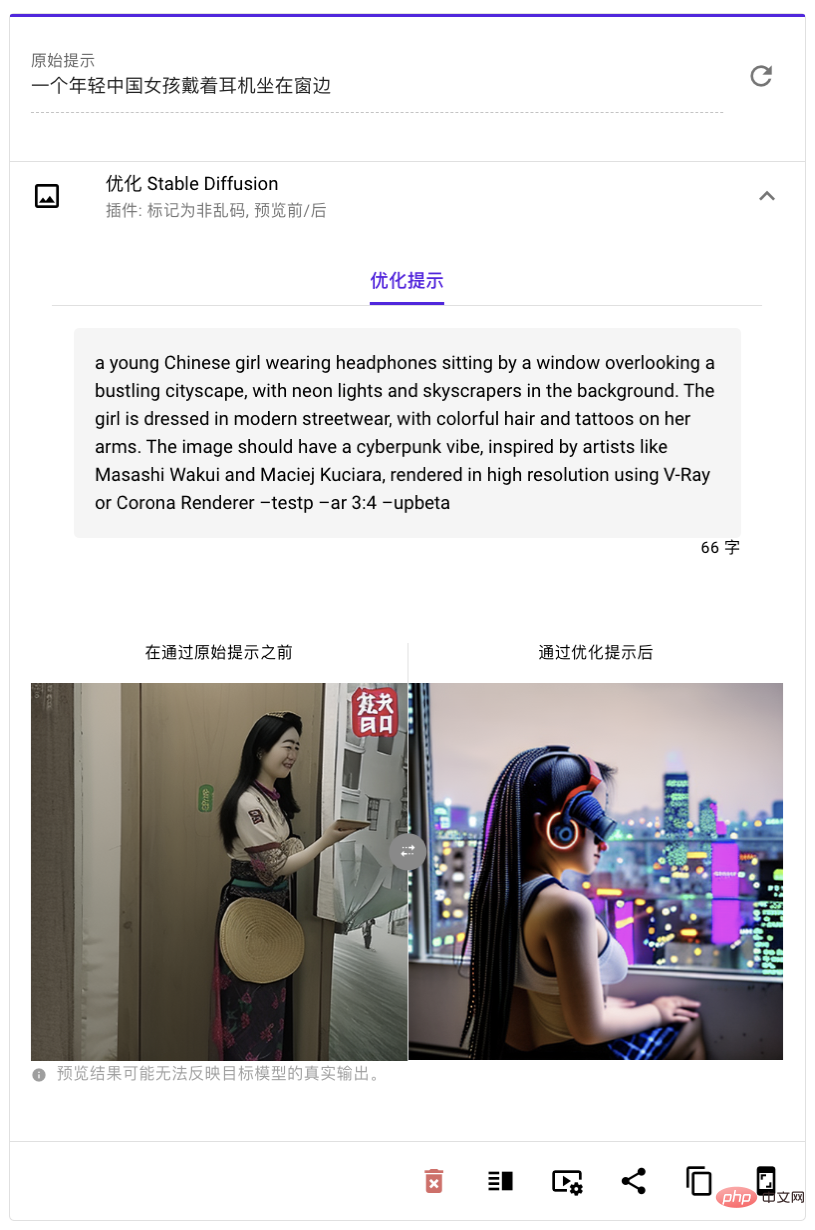

kann die Aufforderungswörter, die Ihnen auf Chinesisch einfallen, direkt in englische Aufforderungswörter umwandeln

, sodass Sie sie einfacher verwenden und effektiver lernen müssen Verschiedene englische Adjektive können auch problemlos beginnen. Wenn wir DALL・E oder Stable Diffusion zum Generieren von Bildern verwenden, fällt es uns manchmal schwer, gute Ergebnisse zu erzielen. Das kann daran liegen, dass unser Englisch nicht gut genug ist oder unsere Vorstellungskraft nicht reich genug ist, um sich bestimmte Bilder oder Szenen auszudenken. Die dabei entstehenden Bilder sind verschwommen oder seltsam.Wir versuchen, mit dem „Most Beautiful Prompt Word“ einige gängige Befehle zu optimieren. Im Bild unten ändert sich zum Beispiel das „Most Beautiful Prompt Word“ in „Impressionist Beijing Street Scene“. ein Satz mit ausführlicher Beschreibung, Super tolles Englisch!

Die prompten Worte für Impressionismus, Kopfhörer und Zukunftsstil können überhaupt nicht angezeigt werden

Es ist klarer beim Testen, Das „ „Schönstes Aufforderungswort“ erzeugt einen langen, aber äußerst präzisen „Zauber“, der die Ästhetik, Vorstellungskraft und Erfahrung des ursprünglichen Aufforderungsworts direkt verbessert, das Bild lebendiger macht und unsere ursprünglichen Erwartungen genauer zum Ausdruck bringt. 4. API, die von Entwicklern direkt aufgerufen werden kann Wörter“-API, sodass Stapel hochwertiger Eingabeaufforderungswörter schneller generiert werden können

. Ganz gleich, wie viele Eingabeaufforderungswörter Sie benötigen, „Die schönsten Eingabeaufforderungswörter“ kann schnell für Sie fertiggestellt werden und bietet Service von höchster Qualität.

Die Technologie und das Team dahinterUns ist aufgefallen, dass „The Most Beautiful Prompt Word“ seit seiner Veröffentlichung am 28. Februar viel Aufmerksamkeit erregt hat und jeder es zur Optimierung verschiedener Szenarien nutzen möchte . promptes Wort. In nur wenigen Tagen

zog es Tausende von Benutzern an

Tausende von Benutzern an

optimierte fast 10.000 Schlagworte und erhielt großes Lob auf verschiedenen Plattformen. Denn solange die von ihm erzeugten prompten Worte verwendet werden, können die vom großen Modell produzierten Dinge sowohl kreativ als auch schön sein.

„Die schönsten Aufforderungswörter“ Um die besten Aufforderungswörter für verschiedene Sprachmodelle zu finden, werden zwei fortschrittliche maschinelle Lerntechnologien verwendet: Verstärkendes Lernen und kontextbezogenes Lernen . Reinforcement Learning ist sein Trainer, der ihm ständig Wissen und Erfahrung einflößt und ihn so immer leistungsfähiger macht. Es verwendet zunächst einige manuell überprüfte Eingabeaufforderungswörter, um die Grundlage für ein vorab trainiertes Modell zu legen, und passt dann die Netzwerkstrategie für Eingabeaufforderungswörter basierend auf Benutzereingaben und Modellausgaben an. Wenn wir beispielsweise die Aufforderungsworte von DALL・E und Stable Diffusion optimieren möchten, möchten wir, dass der generierte Inhalt sowohl relevant als auch ästhetisch ist, genau wie ein Trainer, der von Athleten verlangt, in allen Aspekten äußerst gute Leistungen zu erbringen. Kontextuelles Lernen ist sein Lehrer, der ihm anhand mehrerer Beispiele das Lernen beibringt. Aber anstatt alle Beispiele zusammenzustapeln, werden viele Beispiele in mehrere Gruppen unterteilt und dann vom Sprachmodell selbst codiert. Auf diese Weise können die „schönsten Aufforderungswörter“ mehr Beispiele verwenden, um dem Modell beizubringen, wodurch genauere und effektivere Aufforderungswörter generiert werden. Durch die Verwendung dieser beiden Tricks kann „The Most Beautiful Prompt Words“ Aufforderungswörter für verschiedene Sprachmodelle optimieren und so die Effizienz und Genauigkeit erheblich verbessern, genau wie ein von Trainern und Lehrern trainierter Spitzensportler.

Diese Art von groß angelegtem generativem Modell, sei es ein Sprachgenerierungsmodell oder ein multimodales generatives Modell, basiert derzeit auf Sprache. Allerdings werden wir in Zukunft definitiv das Aufkommen multimodalerer generativer Modelle erleben. Wir haben herausgefunden, dass das Forschungs- und Entwicklungsteam von „The Most Beautiful Prompt Word“ tatsächlich Jina AI ist, ein aufstrebendes Technologieunternehmen mit Schwerpunkt auf multimodaler KI. Es wurde 2020 gegründet und hat seinen Hauptsitz in Berlin, Deutschland, mit Forschungs- und Entwicklungseinrichtungen in Peking und Shenzhen. Jina AI konzentriert sich auf die Forschung und Entwicklung multimodaler KI-Technologie und wird häufig in den Bereichen Suche und Generierung eingesetzt. Zuvor hat Jina AI eine Reihe von Open-Source-Projekten veröffentlicht und insgesamt fast 40.000 Sterne erhalten auf GitHub von Entwicklern auf der ganzen Welt. Folgen Sie und bieten Sie Entwicklern die Möglichkeit, schnell multimodale KI-Anwendungen zu implementieren:

- Multimodales MLOps-Framework Jina: https://github.com/jina-ai /jina

- Spezialisierte Datenstruktur für multimodale DatenDocArray: github.com/docarray/docarray

- CLIP-as-service: github.com/jina-ai/clip-as-service

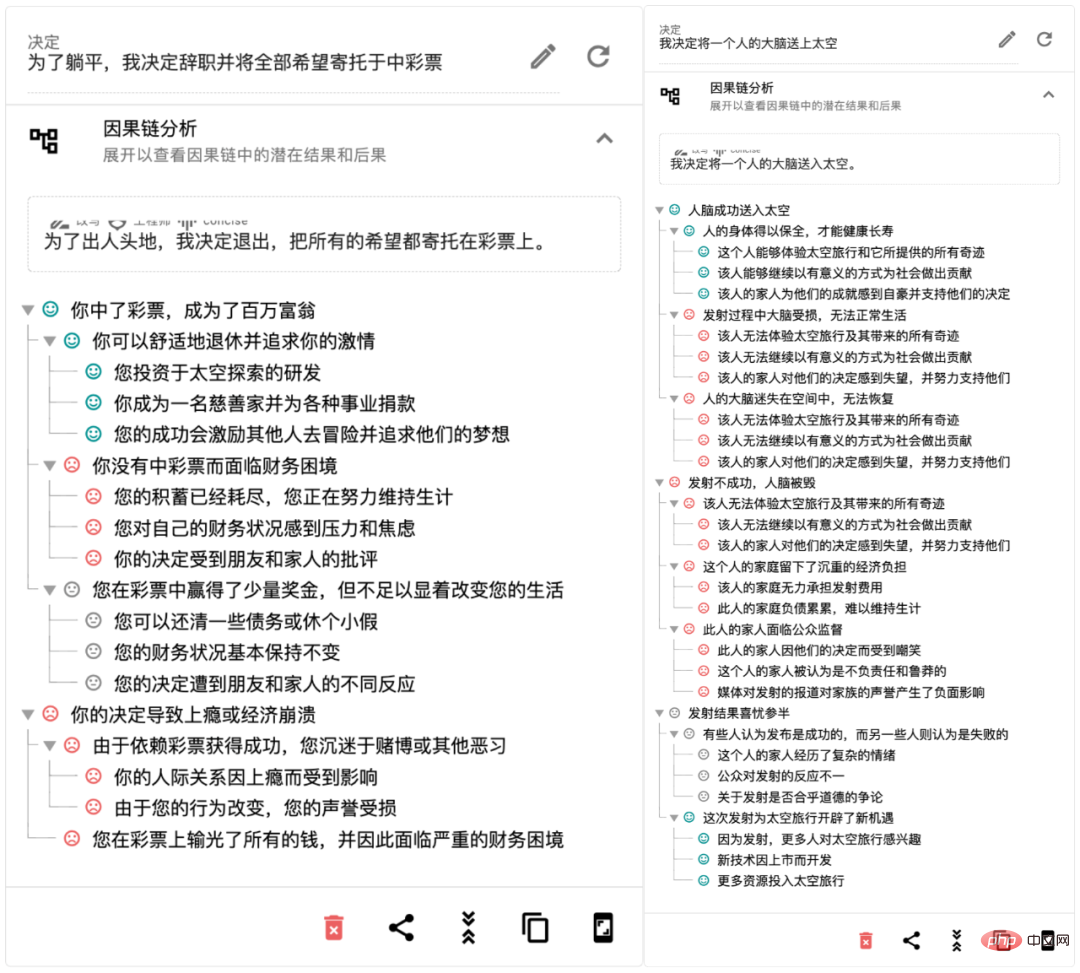

In einer Zeit, in der generative KI wie ein Tsunami mehrere modale Barrieren durchbricht, können die „schönsten Aufforderungswörter“ die Produktivität großer Modelle direkt verbessern und erhebliche Effizienzsteigerungen mit sich bringen. Wir haben auch festgestellt, dass Jina AI dies getan hat ebenfalls entwickelt Mit Rationale (rationale.jina.ai), einem auf ChatGPT basierenden KI-Entscheidungstool, müssen Sie nur eine oder mehrere Entscheidungen in Ihrem Kopf eingeben und Rationale erstellt innerhalb von 10 Sekunden einen exklusiven Entscheidungsbewertungsbericht für Sie. Es kann in Beratungs-, Bewertungs-, Forschungs-, Planungs-, Berichts- und anderen Szenarien eingesetzt werden, um die Effizienz der Entscheidungsfindung zu verbessern. Als Entscheidungsfindungstool mit künstlicher Intelligenz und „kritischem Denken“ kann Rationale Ihr Denken erweitern, Ihre Meinungen verfeinern und rationale Entscheidungen treffen, indem es Ihnen dabei hilft, die Vor- und Nachteile verschiedener Entscheidungen aufzulisten, SWOT-Berichte zu erstellen, Analysen mit mehreren Kriterien durchzuführen usw Ursache-Wirkungs-Analyse usw. Entscheidungsfindung. 2023 könnte ein bahnbrechendes Jahr für Startups werden.

Erfahrungslink: https://rationale.jina.ai

Mit der Eröffnung der ChatGPT-API werden KI-Anwendungen für die C-Seite im Jahr 2023 wie folgt aussehen 2000 Genau wie im Internetzeitalter kam es zu einer gewaltigen Explosion: Täglich werden Hunderte von ChatGPT-API-Anwendungen gestartet, die über verschiedene Bereiche verteilt sind, bestehende Regeln brechen und die Ökologie vieler Bereiche untergraben. Einige traditionelle Giganten stehen vor Herausforderungen, einige traditionelle Barrieren stehen vor dem Abbau und einige traditionelle Industrien stehen vor Innovationen. Wenn wir in der neuen Ära der KI Fuß fassen wollen, müssen wir auf den Schultern von Riesen stehen, den perfekten Zauberspruch singen und Magie einsetzen, um verschiedene Generationsaufgaben zu lösen Schließlich das perfekte Aufforderungswort ist nur eine der Seelen der ChatGPT-Anwendung.

Das obige ist der detaillierte Inhalt vonUmfassende Automatisierung des Prompt Engineering: LeCun schwieg, nachdem er es gesehen hatte, ChatGPT schaute es sich an und rief die Experten direkt an. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr