Heim >Technologie-Peripheriegeräte >KI >ChatGPT begann mit der Verbindung zum Internet und die endgültige Versiegelung wurde aufgehoben

ChatGPT begann mit der Verbindung zum Internet und die endgültige Versiegelung wurde aufgehoben

- PHPznach vorne

- 2023-04-08 10:21:061040Durchsuche

ChatGPT ist eine künstliche Intelligenz mit „superhohem IQ“, insbesondere die aktualisierte Version mit GPT-4-Kern. Wir wissen jedoch, dass die Trainingsdaten auf dem Stand von 2021 sind. Ohne Training ist es für die KI unmöglich, genau zu antworten.

Seit seiner Einführung im November letzten Jahres wurde ChatGPT von unzähligen Menschen genutzt, um auf mehr Daten in verschiedenen Formen zuzugreifen. Am 24. März gab OpenAI schließlich bekannt, dass es die Einschränkung teilweise aufgehoben hat ChatGPT kann keine Verbindung zum Internet herstellen.

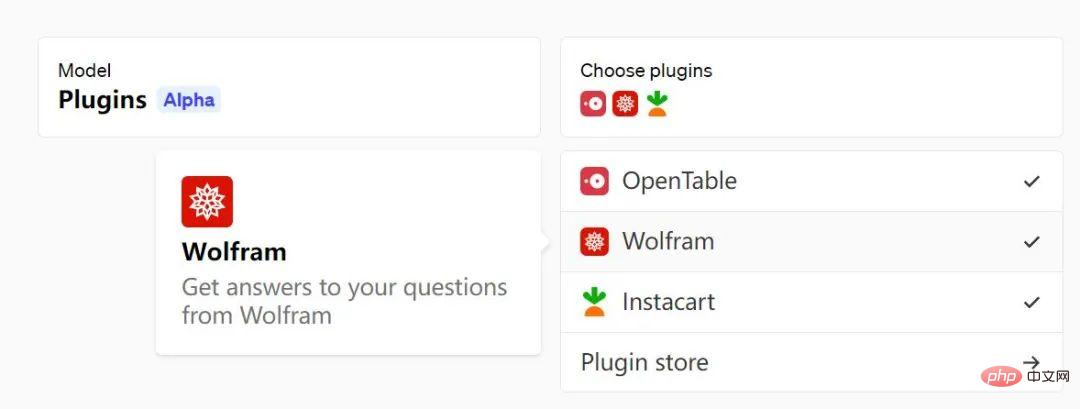

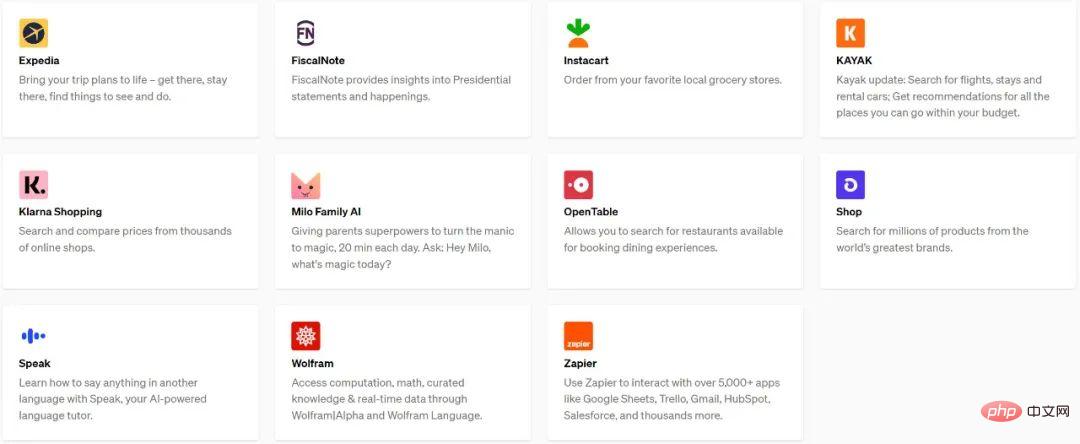

Die Lösung von OpenAI besteht darin, Plug-ins von Drittanbietern als Brücke zu verwenden, damit die KI externe Daten in einer sichereren Umgebung „sehen“ kann. Gestern hat die Agentur ihre erste Liste mit ChatGPT-Plugins veröffentlicht. Diese Plugins wurden von Expedia, FiscalNote, Instacart, KAYAK, Klarna, Milo, OpenTable, Shopify, Slack, Speak, Wolfram und Zapier erstellt.

Das Plugin ermöglicht Ihnen jetzt insbesondere die Durchführung der folgenden Vorgänge mit ChatGPT:

- Echtzeitinformationen abrufen: wie Sportergebnisse, Aktienkurse, aktuelle Nachrichten usw.;

- Wissensdatenbank abrufen Informationen: wie Firmendokumente, persönliche Notizen usw.;

- Vorgänge im Namen von Benutzern durchführen: zum Beispiel Flüge buchen, Mahlzeiten bestellen usw.

Darüber hinaus stellt OpenAI auch zwei Plug-Ins bereit, darunter einen Webbrowser und einen Code-Interpreter, sowie den Code eines Wissensdatenbank-Abruf-Plug-Ins als Open Source. Jetzt kann jeder Entwickler seine eigenen Plug-Ins erstellen, um das ChatGPT-Repository zu erweitern.

Der Zugriff auf die Alpha-Version des Plug-ins wurde auf weitere Benutzer und Entwickler auf der Warteliste ausgeweitet. OpenAI gab zwar an, einer kleinen Anzahl von Entwicklern und ChatGPT Plus-Benutzern Vorrang zu geben, plant jedoch auch, es zu öffnen in Zukunft in größerem Umfang.

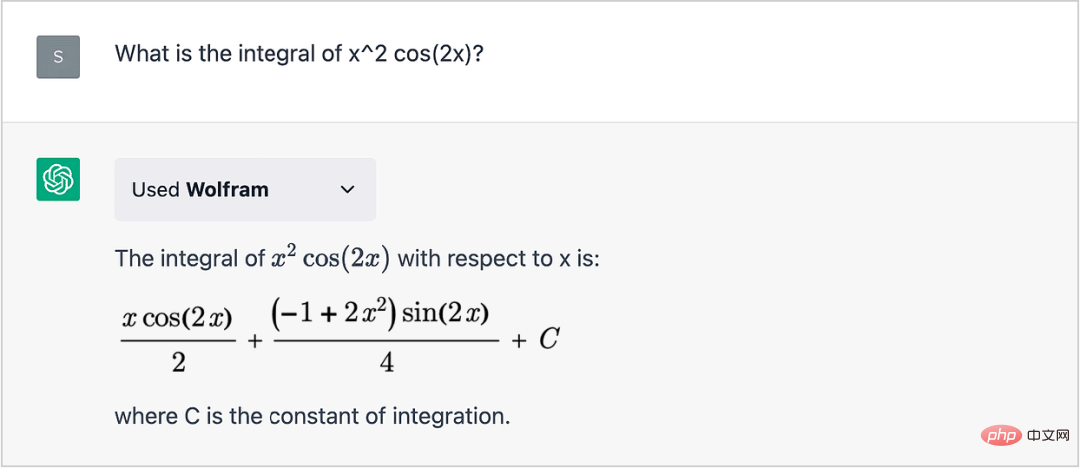

Um allen ein intuitives Gefühl zu vermitteln, hier ein Beispiel: Benutzer können das Wolfram-Plug-in von ChatGPT auswählen und installieren, um seine Rechenintelligenz zu verbessern.

Die Daten in Wolfram Alpha stammen von großen akademischen Websites, Publikationen und wissenschaftlichen Institutionen, und seine Professionalität ist absolut garantiert. Fühlen Sie sich mit ChatGPT leistungsfähiger?

Übersicht

Obwohl die heutigen großen Sprachmodelle verschiedene Aufgaben erledigen können, ist ihre Rolle immer noch begrenzt. Trainingsdaten sind die einzigen Informationen, aus denen sie lernen können. Diese sind möglicherweise veraltet, aber dennoch an alle menschlichen Bedürfnisse anpassbar. Darüber hinaus besteht die einzige standardmäßige Fähigkeit eines Sprachmodells darin, Text auszugeben. Dieser Text kann zwar nützliche Anweisungen enthalten, aber um sie tatsächlich zu befolgen, wäre viel mehr Verarbeitung seitens der Person erforderlich.

Plug-ins sind zwar keine perfekte Analogie, können aber zu den „Augen und Ohren“ eines Sprachmodells werden und dem Sprachmodell den Zugriff auf neue, private oder spezifische Informationen ermöglichen, die nicht in den Trainingsdaten enthalten sind.

Als Reaktion auf explizite Benutzeranfragen können Plug-Ins es Sprachmodellen auch ermöglichen, in ihrem Namen sichere, eingeschränkte Operationen auszuführen, wodurch der Nutzen des gesamten Systems erhöht wird.

OpenAI erwartet, dass ein offener Standard entstehen wird, der Anwendungen für die KI-Interaktion vereinheitlicht, und sie unternehmen erste Versuche, einen solchen Standard zu entwickeln.

Heute beginnt OpenAI damit, nach und nach Plug-ins zu öffnen, die von OpenAIs frühen Mitarbeitern für ChatGPT-Benutzer entwickelt wurden. Die ersten Zielgruppen sind ChatGPT Plus-Abonnenten. Darüber hinaus hat OpenAI damit begonnen, die Möglichkeit für Entwickler einzuführen, ihre eigenen zu erstellen Plug-Ins für ChatGPT.

Mit der Verbesserung des Sicherheitssystems plant OpenAI in den kommenden Monaten, Entwicklern, die OpenAI-Modelle verwenden, die Integration von Plugins in ihre eigenen Anwendungen zu ermöglichen, nicht nur in ChatGPT.

Sicherheit und umfassendere Auswirkungen

Natürlich eröffnet die Verbindung von Sprachmodellen mit externen Tools neue Möglichkeiten, aber auch erhebliche neue Risiken.

Plugins bieten das Potenzial, verschiedene Herausforderungen im Zusammenhang mit großen Sprachmodellen zu lösen, darunter „Halluzinationen“ großer Modelle, die Verfolgung aktueller Ereignisse und den Zugriff auf (lizenzierte) proprietäre Informationsquellen. Durch die Integration des expliziten Zugriffs auf externe Daten wie aktuelle Online-Informationen, codebasierte Berechnungen oder benutzerdefinierte Plug-ins zum Abrufen von Informationen können Sprachmodelle ihre Antworten mit evidenzbasierten Referenzinhalten verbessern.

Diese Referenzen erhöhen nicht nur den Nutzen des Modells, sondern ermöglichen es Benutzern auch, die Vertrauenswürdigkeit der Modellausgabe zu beurteilen und ihre Genauigkeit noch einmal zu überprüfen, wodurch möglicherweise die übermäßige Abhängigkeit im Zusammenhang mit dem jüngsten Risiko der GPT-4-Systemkarte gemindert wird . Schließlich kann der Wert von Plug-ins bestehende Einschränkungen überbrücken, indem sie Benutzern helfen, eine Vielzahl neuer Anwendungsfälle zu bewältigen, vom Durchsuchen von Produktkatalogen bis hin zur Buchung von Flügen oder der Bestellung von Essen.

Aber gleichzeitig können Plug-ins schädliche oder unbeabsichtigte Aktionen ausführen, was die Fähigkeit böswilliger Akteure, andere zu betrügen, irrezuführen oder zu missbrauchen, erhöht und dadurch die Sicherheitsherausforderungen erhöht. Durch die Erweiterung des Spektrums möglicher Anwendungen können Plug-ins das Risiko erhöhen, dass das Modell in neuen Bereichen falsche oder falsch ausgerichtete Aktionen ausführt, was negative Folgen hat.

Diese Faktoren leiteten die Entwicklung der ChatGPT-Plug-in-Plattform, für die OpenAI eine Reihe von Sicherheitsmaßnahmen eingeführt hat.

Zuvor hat OpenAI intern und mit externen Mitarbeitern „Red-Team-Übungen“ durchgeführt und dabei viele mögliche verwandte Szenarien geübt. Rote Teams haben beispielsweise Plugins gesehen, die komplexe Prompt-Injections durchführen, gefälschte E-Mails und Spam versenden, Sicherheitsbeschränkungen umgehen oder an das Plugin gesendete Informationen missbrauchen, wenn sie ohne Sicherheitsmaßnahmen verbreitet werden.

OpenAI nutzt diese Erkenntnisse, um Abhilfemaßnahmen im Sicherheitsdesign voranzutreiben, um riskantes Plug-in-Verhalten zu begrenzen und die Transparenz darüber zu erhöhen, wie und wann sie als Teil des Benutzererlebnisses funktionieren, außerdem um die inkrementelle Bereitstellung von Plug-ins zu bestätigen.

Plugins können weitreichende soziale Auswirkungen haben. In einem Artikel stellten OpenAI-Forscher beispielsweise fest, dass Sprachmodelle, die Tools verwenden können, möglicherweise größere wirtschaftliche Auswirkungen haben als Sprachmodelle ohne Tools. Allgemeiner gesagt, werden die aktuellen Wellen der künstlichen Intelligenztechnologie laut den Erkenntnissen anderer Forscher große Auswirkungen haben von der Geschwindigkeit, mit der Arbeitsplätze umgewandelt, ersetzt und geschaffen werden.

Lassen Sie ChatGPT im Internet surfen

Inspiriert von einer Reihe von Arbeiten wie WebGPT, GopherCite, BlenderBot2, LaMDA2 usw. wird die Möglichkeit, dass Sprachmodelle Informationen aus dem Internet lesen können, den Umfang dessen, was besprochen werden kann, erheblich erweitern. über die Ausbildung hinaus Der Korpus enthält aktuelle, frische Informationen.

Das Bild unten ist ein Beispiel, in dem Sie sehen können, dass das Surfen ChatGPT-Benutzern ein Erlebnis eröffnet, bei dem das Vorgängermodell möglicherweise höflich darauf hingewiesen hat, dass seine Trainingsdaten nicht genügend Informationen für eine Antwort enthielten. In diesem Beispiel hat ChatGPT Informationen über die neuesten Oscars (verliehen am 13. März 2023) abgerufen und dann eine bekannte ChatGPT-Versaufführung durchgeführt. Das Surfen wird zu einer Möglichkeit, das Erlebnis zu bereichern.

F: Können Sie mir sagen, welche Person/welcher Film in diesen Kategorien einen Oscar gewonnen hat? „Bester Hauptdarsteller“

- ChatGPT zeigt Ihnen eine Reihe von Suchergebnissen an und Sie können direkt darauf klicken, um relevante Informationsquellen anzuzeigen.

- Sprach- und Chatmodelle bieten nicht nur einen praktischen Nutzen für Endbenutzer, sondern ermöglichen auch eine gründliche und interpretierbare Recherche und verdeutlichen das Versprechen einer skalierbaren Ausrichtungsarbeit.

-

Es ist erwähnenswert, dass der textbasierte Webbrowser des Plug-ins auf das Senden von GET-Anfragen beschränkt ist, was bestimmte Kategorien von Sicherheitsrisiken verringert, aber nicht beseitigt. Browsing-Plug-ins dienen dem Abrufen von Informationen, umfassen jedoch keine „transaktionalen“ Vorgänge wie Formularübermittlungen, die größere Sicherheitsrisiken bergen.

Die Browsing-Funktion nutzt die Microsoft Bing Search API, um Inhalte aus dem Web abzurufen. Daher übernimmt diese Funktion die umfangreiche Arbeit von Microsoft zur Quellenzuverlässigkeit und Informationsauthentizität sowie den „Abgesicherten Modus“, der das Abrufen fragwürdiger Inhalte verhindert. Das Plugin wird in einem separaten Dienst ausgeführt und die Browsing-Aktivitäten von ChatGPT sind vom Rest der Infrastruktur getrennt.

Um die Ersteller von Inhalten zu respektieren und Webnormen einzuhalten, lautet das User-Agent-Token des ChatGPT-Browser-Plugins ChatGPT-User und ist so konfiguriert, dass es die robots.txt-Datei der Website respektiert. Gelegentlich kann es zu einem „Klickfehler“ kommen, der darauf hinweist, dass das Plugin die Anweisungen der Website befolgt, um ein Crawlen zu verhindern. Dieser Benutzeragent wird nur verwendet, um im Namen von ChatGPT-Benutzern direkte Maßnahmen zu ergreifen, und wird nicht dazu verwendet, das Web auf automatisierte Weise zu durchsuchen. OpenAI veröffentlicht außerdem IP-Ausgangsbereiche und implementiert eine Ratendrosselung, um zu vermeiden, dass zu viel Datenverkehr an Websites gesendet wird.

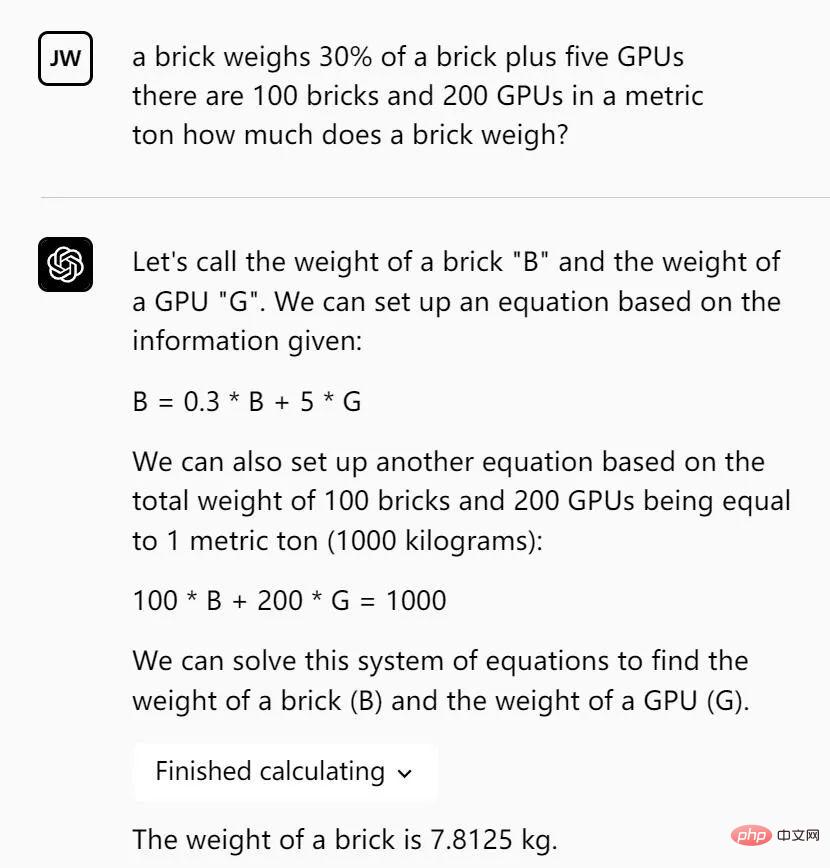

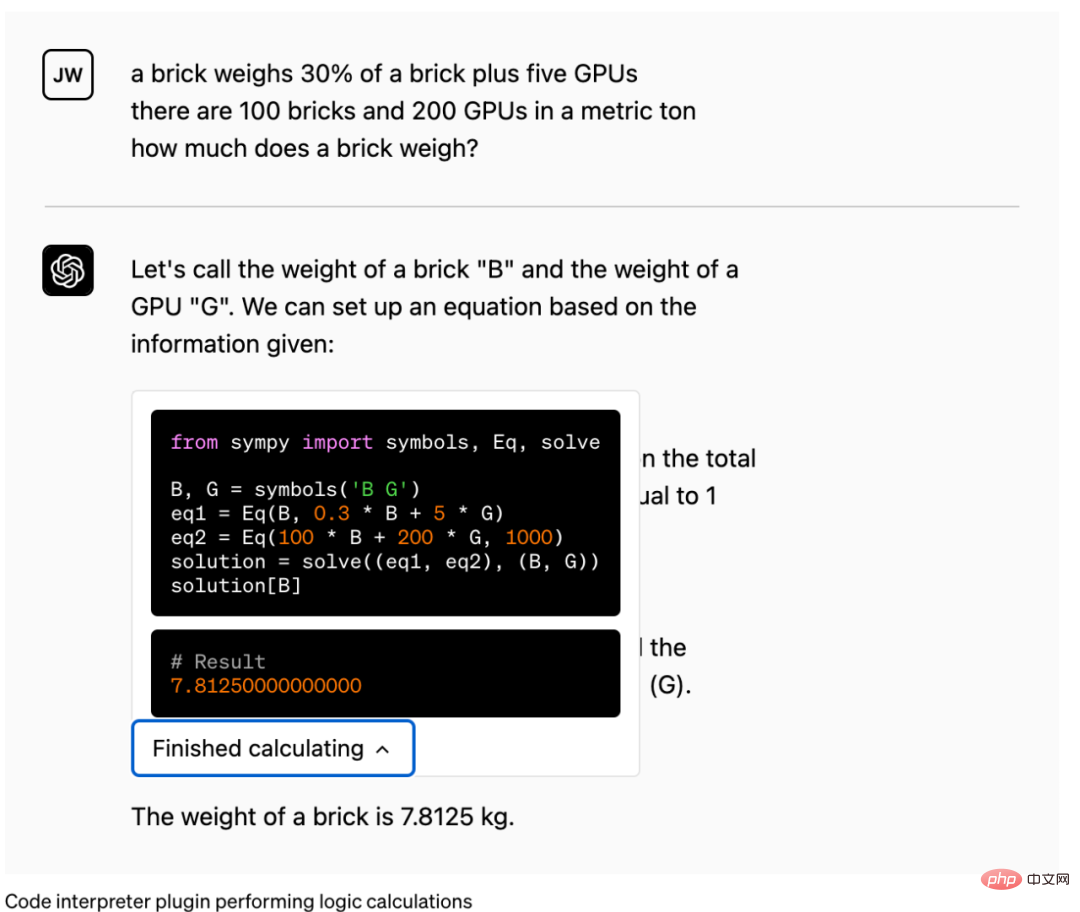

Code-Interpreter

Experimentelles ChatGPT-Modell, das das Hoch- und Herunterladen mit Python verarbeiten kann

OpenAI bietet einen Python-Interpreter für das Modell hinter ChatGPT, der in einer Sandbox, einer Firewall-Ausführungsumgebung und etwas temporärem Speicherplatz funktioniert. Der vom Interpreter-Plugin ausgeführte Code wird in einer dauerhaften Sitzung ausgewertet, die für die Dauer der Chat-Konversation aktiv ist (mit einer begrenzten Zeitüberschreitung), und nachfolgende Aufrufe können aufeinander aufbauen. Diese Funktion unterstützt derzeit das Hochladen von Dateien in den aktuellen Konversationsarbeitsbereich und das Herunterladen von Arbeitsergebnissen.

Klicken Sie im Bild auf Berechnung abgeschlossen:

Bei der ersten Benutzerrecherche hat OpenAI einige wertvolle Anwendungsfälle mithilfe des Code-Interpreters identifiziert:

- Lösen quantitativer und qualitativer mathematischer Probleme

- Datenanalyse und -visualisierung durchführen

- Dateien zwischen Formaten konvertieren

Sicherheitsmechanismen

Die erste Vorsichtsmaßnahme beim Verbinden eines ChatGPT-Modells mit einem Programmierspracheninterpreter besteht darin, ordnungsgemäßes Sandboxing durchzuführen, damit KI-generierter Code dies tut in der realen Welt keine unbeabsichtigten Nebenwirkungen haben. OpenAI führt Code in einer sicheren Umgebung aus und verwendet strenge Netzwerkkontrollen, um zu verhindern, dass externer Internetzugriff den Code ausführt. Darüber hinaus legt OpenAI für jede Sitzung Ressourcenlimits fest.

Das Deaktivieren des Internetzugangs schränkt die Funktionalität der Code-Sandbox ein, ist aber wahrscheinlich die sicherste Ausgangsform der KI-gestützten Programmierung. Plug-ins von Drittanbietern sind so konzipiert, dass Sicherheit oberste Priorität hat und ChatGPT mit der Außenwelt verbindet.

Datenerfassung

Das Open-Source-Retrieval-Plug-in ermöglicht ChatGPT den Zugriff auf die Informationsquellen einer Einzelperson oder Organisation mit Genehmigung. Es ermöglicht Benutzern, die relevantesten Dokumentausschnitte aus ihren Datenquellen wie Dateien, Notizen, E-Mails oder öffentlichen Dokumenten abzurufen, indem sie Fragen stellen oder Anforderungen in natürlicher Sprache äußern.

Als Open-Source- und selbstgehostete Lösung können Entwickler ihre eigene Version des Plugins bereitstellen und bei ChatGPT registrieren. Sein Plugin nutzt die OpenAI-Einbettung und ermöglicht Entwicklern die Auswahl einer Vektordatenbank wie Milvus, Pinecone, Qdrant, Redis, Weaviate oder Zilliz, um Dokumente zu indizieren und zu durchsuchen. Informationsquellen können mithilfe von Webhooks mit der Datenbank synchronisiert werden.

Das Abruf-Plugin ermöglicht ChatGPT, die Inhaltsvektordatenbank zu durchsuchen und die besten Ergebnisse zur ChatGPT-Sitzung hinzuzufügen. Das heißt, es unterliegt keinem äußeren Einfluss, wobei die Hauptrisiken in der Datenautorisierung und dem Datenschutz liegen. Entwickler sollten Abruf-Plugins nur Inhalte hinzufügen, zu deren Verwendung sie berechtigt sind und die innerhalb der ChatGPT-Sitzung eines Benutzers geteilt werden können. „Plug-ins von Drittanbietern“ Maschinenlesbare Beschreibung der Plug-in-Funktionen, Aufrufmethoden und benutzerorientierte Dokumentation.

{ "schema_version": "v1", "name_for_human": "TODO Manager", "name_for_model": "todo_manager", "description for human": "Manages your TODOs!", "description_for_model": "An app for managing a user's TODOs", "api": { "url": "/openapi.json" }, "auth": { "type": "none" }, "logo_url": "https://example.com/logo.png", "legal_info_url": "http://example.com", "contact_email": "hello@example.com" }Schritte zum Erstellen eines Plug-Ins:1. Erstellen Sie den API-Endpunkt, den das Sprachmodell aufrufen soll (kann eine neue API, eine vorhandene API oder ein Wrapper um eine vorhandene API sein, die speziell entwickelt wurde). für LLM).

2. Erstellen Sie eine OpenAPI-Spezifikation, die Ihre API dokumentiert, und eine Manifestdatei, die auf die OpenAPI-Spezifikation verweist und einige Plugin-spezifische Metadaten enthält.

Beim Starten einer Konversation auf chat.openai.com können Benutzer auswählen, welche Plugins von Drittanbietern sie aktivieren möchten. Dokumente zu aktivierten Plug-Ins werden dem Sprachmodell als Teil des Konversationskontexts angezeigt, sodass das Modell bei Bedarf die entsprechenden Plug-In-APIs aufrufen kann, um die Benutzerabsicht zu erfüllen. Derzeit sind Plugins für den Aufruf von Backend-APIs konzipiert, und OpenAI erforscht Plugins, die auch Client-APIs aufrufen können.

OpenAI gab an, dass sie hart daran arbeiten, das Plug-in zu entwickeln und es einem breiteren Publikum bekannt zu machen.

Das bedeutet auch, dass der Sturm, den ChatGPT mit sich bringt, alles erfasst.

Das obige ist der detaillierte Inhalt vonChatGPT begann mit der Verbindung zum Internet und die endgültige Versiegelung wurde aufgehoben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr