Heim >Technologie-Peripheriegeräte >KI >Eine neu veröffentlichte Übersicht über groß angelegte Sprachmodelle: die umfassendste Übersicht von T5 bis GPT-4, gemeinsam verfasst von mehr als 20 inländischen Forschern

Eine neu veröffentlichte Übersicht über groß angelegte Sprachmodelle: die umfassendste Übersicht von T5 bis GPT-4, gemeinsam verfasst von mehr als 20 inländischen Forschern

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-07 21:21:011997Durchsuche

Seit der Turing-Test in den 1950er Jahren vorgeschlagen wurde, erforschen Menschen die Fähigkeit von Maschinen, sprachliche Intelligenz zu verarbeiten. Sprache ist im Wesentlichen ein komplexes System des menschlichen Ausdrucks, das durch grammatikalische Regeln bestimmt wird. Daher gibt es große Herausforderungen bei der Entwicklung leistungsstarker KI-Algorithmen, die Sprache verstehen und beherrschen können. In den letzten zwei Jahrzehnten wurden Sprachmodellierungsmethoden, einschließlich statistischer Sprachmodelle und neuronaler Sprachmodelle, häufig zum Verstehen und Generieren von Sprachen eingesetzt.

In den letzten Jahren haben Forscher vorab trainierte Sprachmodelle (PLMs) erstellt, indem sie Transformer-Modelle auf großen Korpora vortrainiert haben, und haben starke Fähigkeiten bei der Lösung verschiedener NLP-Aufgaben unter Beweis gestellt. Und die Forscher fanden heraus, dass die Modellskalierung zu Leistungsverbesserungen führen kann, und untersuchten daher weiter den Effekt der Skalierung durch Vergrößerung der Modellgröße. Wenn die Parametergröße ein bestimmtes Niveau überschreitet, erzielt dieses größere Sprachmodell interessanterweise erhebliche Leistungsverbesserungen und bringt Fähigkeiten zum Vorschein, die im kleinen Modell nicht vorhanden sind, wie beispielsweise Kontextlernen. Um sie von PLMs zu unterscheiden, werden solche Modelle als Large Language Models (LLMs) bezeichnet.

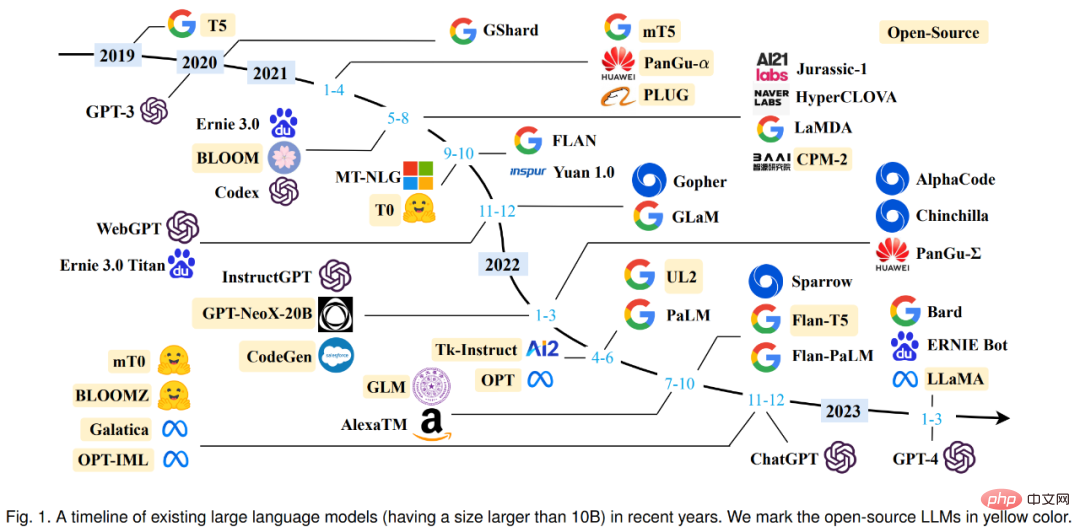

Von Google T5 im Jahr 2019 bis zur OpenAI GPT-Serie entstehen immer wieder große Modelle mit explodierenden Parametergrößen. Man kann sagen, dass die Forschung zu LLMs sowohl in der Wissenschaft als auch in der Industrie stark vorangetrieben wurde. Insbesondere die Einführung des großen Konversationsmodells ChatGPT Ende November letzten Jahres hat in allen Lebensbereichen große Aufmerksamkeit erregt. Technische Fortschritte bei LLMs hatten erhebliche Auswirkungen auf die gesamte KI-Community und werden die Art und Weise, wie Menschen KI-Algorithmen entwickeln und verwenden, revolutionieren.

Angesichts des rasanten technologischen Fortschritts von LLMs überprüften mehr als zwei Dutzend Forscher der Renmin University of China die neuesten Fortschritte von LLMs unter drei Aspekten: Hintergrundwissen, Schlüsselentdeckungen und Mainstream-Technologien, mit besonderem Augenmerk auf die Vorschulung und Anpassung von LLMs Tuning, Nutzung und Fähigkeitsbewertung. Darüber hinaus fassten sie die verfügbaren Ressourcen für LLMs zusammen und entwickelten sie weiter und diskutierten zukünftige Entwicklungsrichtungen und andere Themen. Diese Rezension ist eine äußerst nützliche Lernressource für Forscher und Ingenieure auf diesem Gebiet.

Papierlink: https://arxiv.org/abs/2303.18223

Bevor wir den Text eingeben, werfen wir zunächst einen Blick auf die verschiedenen großen Sprachmodelle (zig Milliarden Parameter). die seit 2019 entstanden sind. Oben) Zeitleiste, in der das große, gelb markierte Modell als Open Source verfügbar ist.

Überblick über LLMs

Im ersten Abschnitt stellte der Forscher die Hintergründe, Fähigkeiten und Schlüsseltechnologien von LLMs ausführlich vor.

Hintergrund zu LLMs

Typischerweise beziehen sich große Sprachmodelle (LLMs) auf Sprachmodelle mit Hunderten von Milliarden (oder mehr) Parametern, die auf großen Textdatenmengen trainiert werden, wie z. B. GPT-Modelle. 3, PaLM, Galactica und LLaMA. Konkret basiert LLM auf der Transformer-Architektur, bei der Multi-Head-Aufmerksamkeitsschichten in einem sehr tiefen neuronalen Netzwerk gestapelt sind. Bestehende LLMs verwenden hauptsächlich eine Modellarchitektur (d. h. Transformer) und Vortrainingsziele (d. h. Sprachmodellierung), ähnlich wie kleine Sprachmodelle. Der Hauptunterschied besteht darin, dass LLM die Modellgröße, die Daten vor dem Training und die Gesamtberechnung (Skalierungsfaktor) stark skaliert. Sie können natürliche Sprache besser verstehen und basierend auf einem bestimmten Kontext (z. B. einer Eingabeaufforderung) qualitativ hochwertigen Text generieren. Diese Kapazitätsverbesserung kann teilweise durch ein Skalierungsgesetz beschrieben werden, bei dem die Leistung ungefähr nach einer starken Vergrößerung der Modellgröße zunimmt. Nach dem Skalierungsgesetz sind jedoch einige Fähigkeiten (z. B. kontextuelles Lernen) unvorhersehbar und können nur beobachtet werden, wenn die Modellgröße ein bestimmtes Niveau überschreitet.

Die entstehende Fähigkeit von LLMs

Die entstehende Fähigkeit von LLM wird formal definiert als „die Fähigkeit, die nicht in kleinen Modellen existiert, sondern in großen Modellen erscheint“, was LLM von früheren PLM-Modellen unterscheidet markantesten Merkmale. Mit der Einführung dieser neuen Funktion wird auch eine bemerkenswerte Funktion eingeführt: Wenn die Skalierung ein bestimmtes Niveau erreicht, ist die Leistung deutlich höher als bei Zufall. Analog dazu steht dieses neue Modell in engem Zusammenhang mit dem Phänomen der Phasenübergänge in der Physik. Im Prinzip kann diese Fähigkeit auch auf einige komplexe Aufgaben bezogen werden, während es beim Menschen eher um allgemeine Fähigkeiten geht, die zur Lösung mehrerer Aufgaben eingesetzt werden können. Hier ist eine kurze Einführung in drei repräsentative neue Fähigkeiten von LLM:

Kontextuelles Lernen. GPT-3 führt formal kontextbezogene Lernfunktionen ein: Unter der Annahme, dass das Sprachmodell mit Anweisungen in natürlicher Sprache und mehreren Aufgabenbeschreibungen ausgestattet wurde, kann es die erwartete Ausgabe der Testinstanz generieren, indem es die Wortfolge des Eingabetextes ohne zusätzliches Training oder Gradienten vervollständigt Aktualisierungen.

Anweisungen zum Befolgen. LLM schneidet bei kleinen Aufgaben gut ab, indem es eine Mischung aus Multitask-Datensätzen optimiert, die mit Beschreibungen in natürlicher Sprache (d. h. Anweisungen) formatiert sind, die auch in Form von Anweisungen beschrieben werden. In dieser Funktion ermöglicht die Befehlsoptimierung LLM, neue Aufgaben auszuführen, indem es Aufgabenanweisungen versteht, ohne explizite Beispiele zu verwenden, was die Generalisierungsfähigkeiten erheblich verbessern kann.

Schritt-für-Schritt-Argumentation. Für kleine Sprachmodelle ist es oft schwierig, komplexe Aufgaben zu lösen, die mehrere Argumentationsschritte erfordern, wie beispielsweise Textaufgaben in mathematischen Fächern. Gleichzeitig kann LLM durch die Denkketten-Argumentationsstrategie solche Aufgaben lösen, um zu einer endgültigen Antwort zu gelangen, indem es den Prompt-Mechanismus nutzt, der Zwischen-Argumentationsschritte umfasst. Vermutlich kann diese Fähigkeit durch Programmiertraining erworben werden.

Schlüsseltechnologien

Schauen wir uns als Nächstes die Schlüsseltechnologien von LLMs an, darunter Skalierung, Schulung, Fähigkeitsstimulation, Ausrichtungsoptimierung, Werkzeugnutzung usw.

Zoom. Die Skalierung ist ein Schlüsselfaktor für die Erhöhung der Modellkapazität von LLMs. Zunächst erhöhte GPT-3 die Modellparameter auf 175 Milliarden, und dann erhöhte PaLM die Modellparameter weiter auf 540 Milliarden. Großräumige Parameter sind entscheidend für neue Fähigkeiten. Bei der Skalierung geht es nicht nur um die Modellgröße, sondern auch um die Datengröße und den gesamten Rechenaufwand.

Training. Aufgrund des großen Umfangs ist die erfolgreiche Ausbildung eines LLM mit starken Fähigkeiten eine große Herausforderung. Daher sind verteilte Trainingsalgorithmen erforderlich, um die Netzwerkparameter von LLMs zu lernen, häufig unter Verwendung einer Kombination verschiedener paralleler Strategien. Zur Unterstützung des verteilten Trainings werden Optimierungsframeworks wie DeepSpeed und Megatron-LM verwendet, um die Implementierung und Bereitstellung paralleler Algorithmen zu erleichtern. Darüber hinaus sind Optimierungstechniken wichtig für die Trainingsstabilität und die Modellleistung, wie z. B. das Neustarten von Trainingsverlustspitzen und gemischtes Präzisionstraining. Das jüngste GPT-4 hat spezielle Infrastruktur- und Optimierungsmethoden entwickelt, um viel kleinere Modelle zu nutzen, um die Leistung großer Modelle vorherzusagen.

Fähigkeitsstimulation. Nach der Vorschulung an einem groß angelegten Korpus verfügen LLMs über die potenzielle Fähigkeit, allgemeine Aufgaben zu lösen. Allerdings werden diese Fähigkeiten möglicherweise nicht explizit demonstriert, wenn LLMs eine bestimmte Aufgabe ausführen. Daher ist es sehr nützlich, geeignete Aufgabenanweisungen oder spezifische kontextbezogene Strategien zu entwerfen, um diese Fähigkeiten zu stimulieren. Denkkettenaufforderungen können beispielsweise dabei helfen, komplexe Denkaufgaben durch Zwischenschritte des Denkens zu lösen. Darüber hinaus können Anweisungen für LLMs mit Aufgabenbeschreibungen in natürlicher Sprache weiter optimiert werden, um die Verallgemeinerung auf unsichtbare Aufgaben zu verbessern.

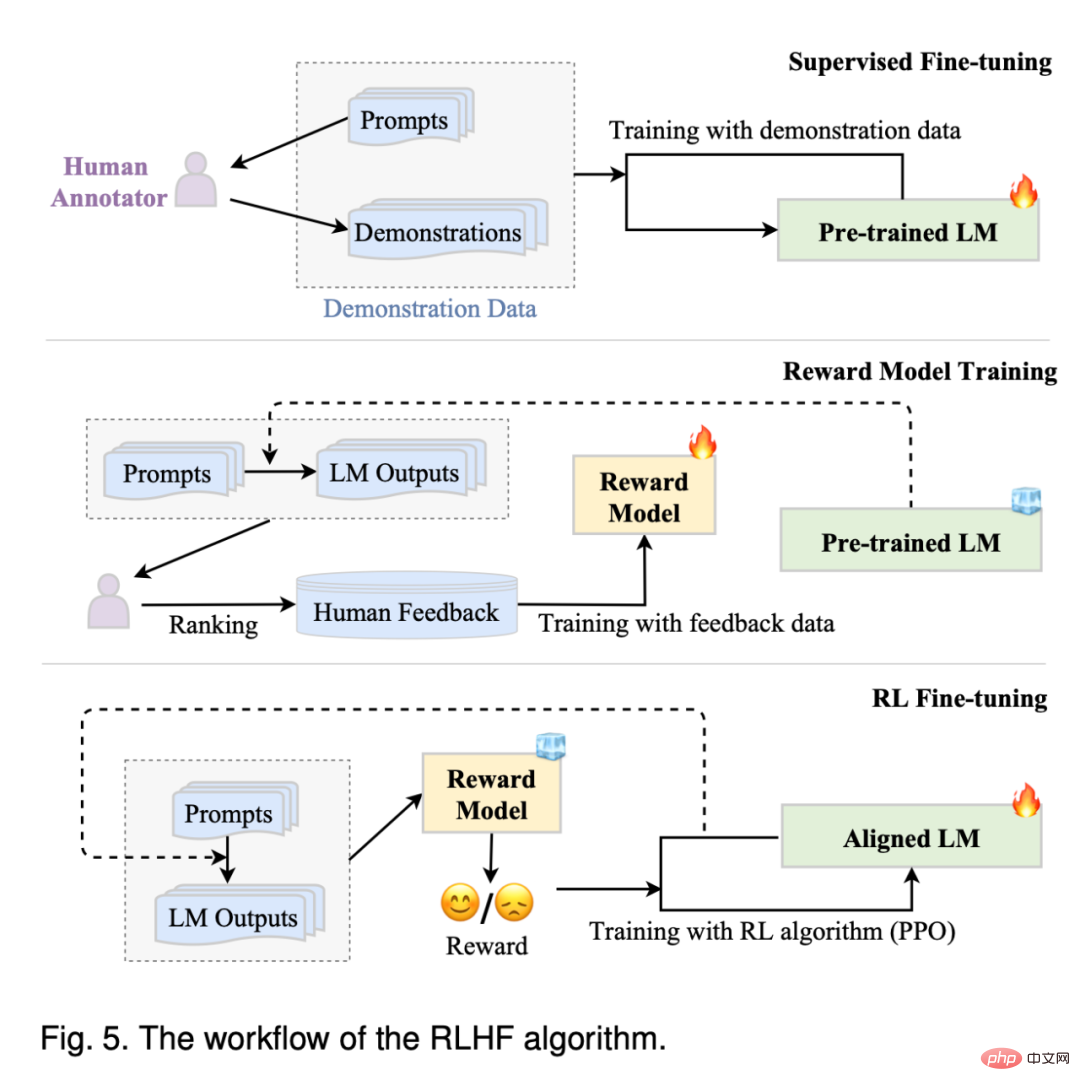

Ausrichtungsabstimmung. Da LLMs darauf trainiert sind, Datenmerkmale von Korpora vor dem Training (einschließlich Daten hoher und niedriger Qualität) zu erfassen, ist es wahrscheinlich, dass sie Textinhalte generieren, die toxisch, voreingenommen und schädlich sind. Um LLMs an menschlichen Werten auszurichten, hat InstructGPT eine effiziente Optimierungsmethode entwickelt, die verstärkendes Lernen und menschliches Feedback nutzt, damit LLMs erwarteten Anweisungen folgen können. ChatGPT basiert auf einer ähnlichen Technologie wie InstructGPT und verfügt über starke Ausrichtungsfähigkeiten bei der Erstellung hochwertiger, harmloser Antworten.

Werkzeugnutzung. LLMs sind im Wesentlichen Textgeneratoren, die auf großen Klartextkorpora trainiert werden und daher bei Aufgaben wie numerischen Berechnungen, bei denen der Text schlecht ausgedrückt wird, nicht so gut funktionieren. Darüber hinaus sind die Fähigkeiten von LLMs durch vorab trainierte Daten eingeschränkt und können nicht die neuesten Informationen erfassen. Als Reaktion auf diese Probleme wurde vorgeschlagen, externe Tools zu verwenden, um die Mängel von LLMs auszugleichen, beispielsweise die Verwendung von Taschenrechnern zur Durchführung präziser Berechnungen und die Verwendung von Suchmaschinen zum Abrufen unbekannter Informationen. ChatGPT nutzt auch externe Plug-Ins, um neues Wissen online zu erlernen. Dieser Mechanismus kann die Fähigkeiten von LLMs erheblich erweitern.

LLMs-Ressourcen

Angesichts der anspruchsvollen technischen Probleme und des enormen Bedarfs an Rechenressourcen ist die Entwicklung oder Replikation von LLMs keine leichte Aufgabe. Ein möglicher Ansatz besteht darin, von bestehenden LLMs zu lernen und öffentlich verfügbare Ressourcen für inkrementelle Entwicklung oder experimentelle Forschung wiederzuverwenden.

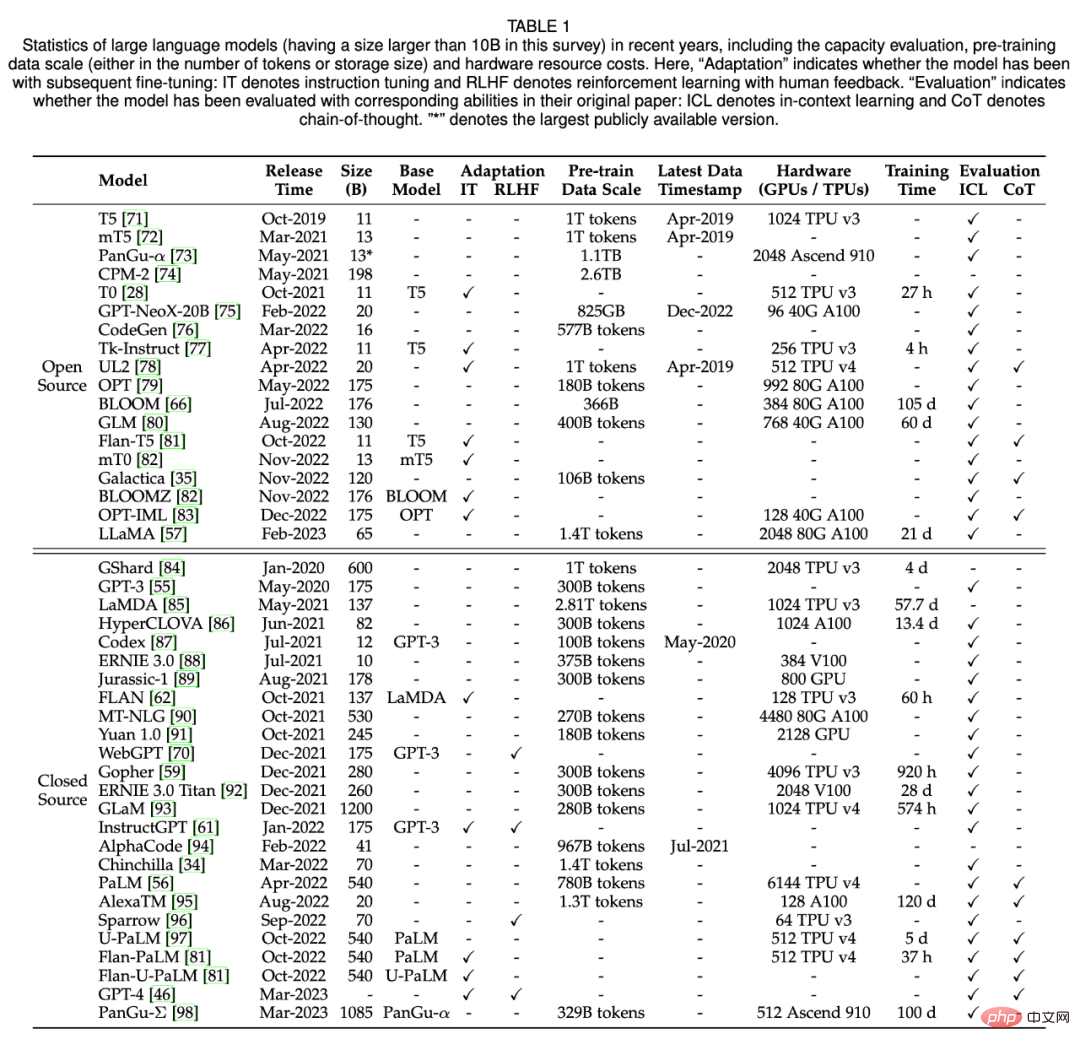

In Abschnitt 3 fasst der Forscher hauptsächlich Open-Source-Modellprüfpunkte oder APIs, verfügbare Korpora und für LLM nützliche Bibliotheken zusammen. Tabelle 1 unten zeigt die statistischen Daten großer Modelle mit mehr als 10 Milliarden Parametern in den letzten Jahren.

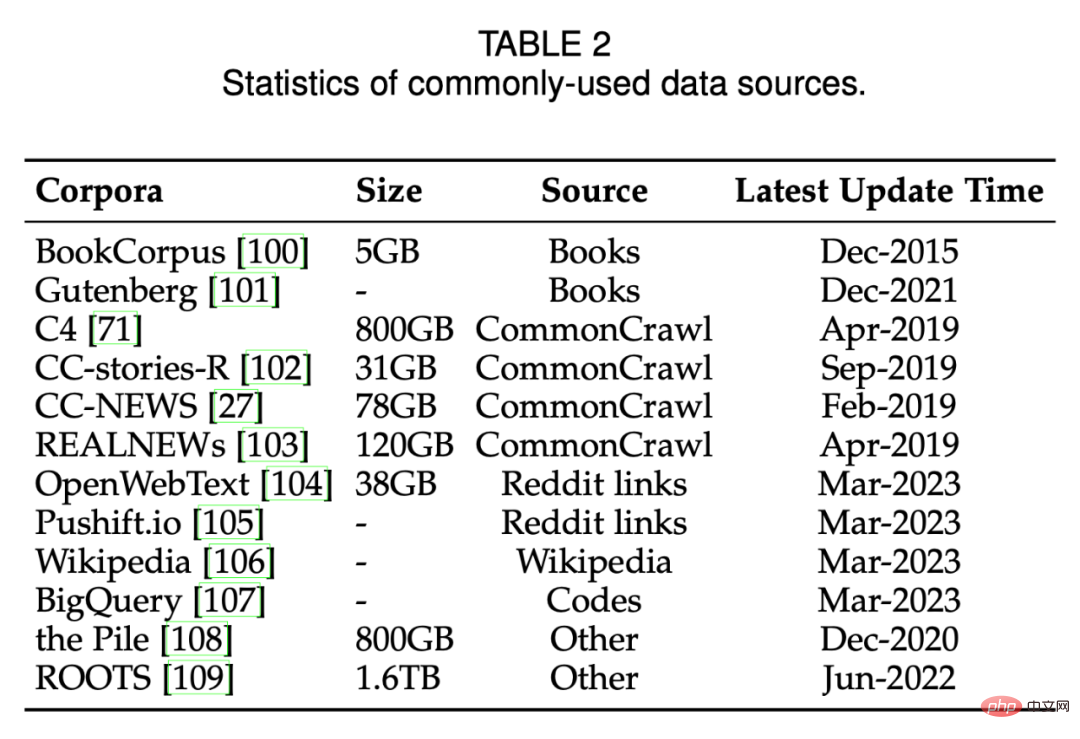

Tabelle 2 unten listet häufig verwendete Datenquellen auf.

Vorschulung

Vorschulung bildet die Fähigkeitsbasis von LLMs. Durch eine Vorschulung an umfangreichen Korpora können LLMs grundlegende Sprachverständnisse und Produktionsfähigkeiten erwerben. In diesem Prozess sind Größe und Qualität des Vorschulungskorpus für LLMs von entscheidender Bedeutung, um starke Fähigkeiten zu erreichen. Darüber hinaus müssen Modellarchitekturen, Beschleunigungsmethoden und Optimierungstechniken sorgfältig entworfen werden, um LLMs effektiv vorab zu trainieren. In Abschnitt 4 diskutiert der Forscher zunächst die Datenerfassung und -verarbeitung in Abschnitt 4.1, stellt dann in Abschnitt 4.2 häufig verwendete Modellarchitekturen vor und stellt schließlich in Abschnitt 4.3 Trainingstechniken für eine stabile und effektive Optimierung von LLMs vor.

Datenerfassung

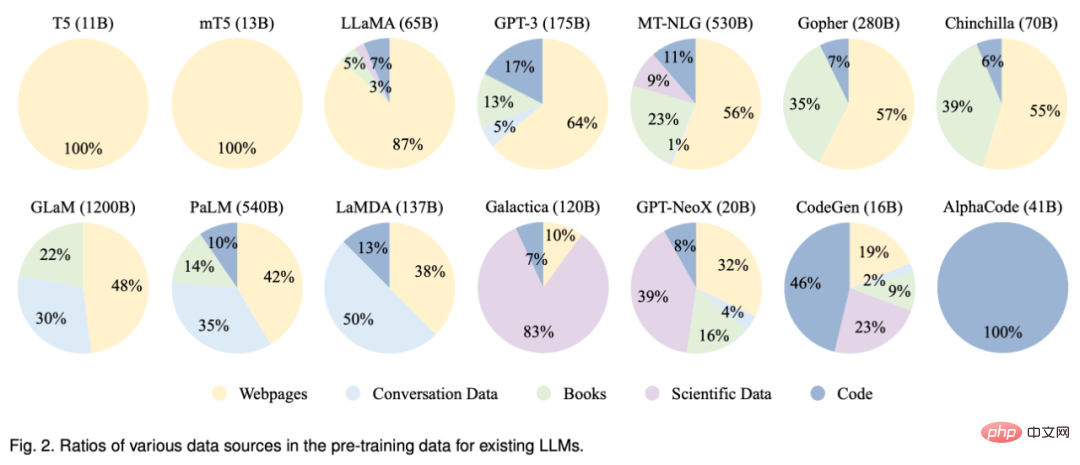

Um ein leistungsstarkes LLM zu entwickeln, ist es entscheidend, eine große Menge an natürlichem Sprachkorpus aus verschiedenen Datenquellen zu sammeln. Bestehende LLMs nutzen hauptsächlich verschiedene öffentliche Textdatensätze als Korpora vor dem Training. Abbildung 2 unten listet die Verteilung vorab trainierter Datenquellen für bestehende LLMs auf.

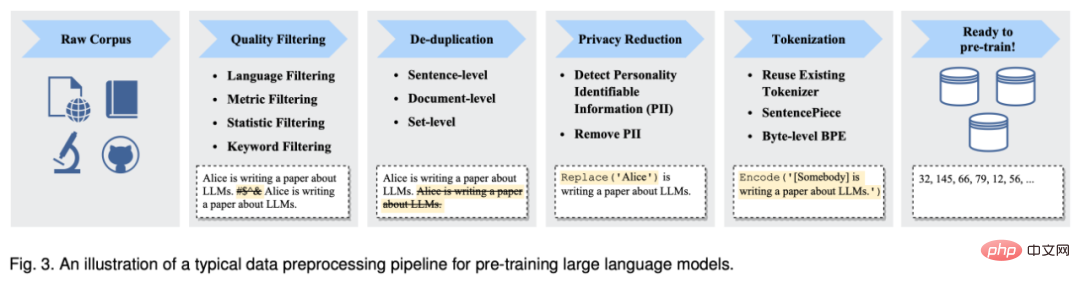

Nachdem sie eine große Menge an Textdaten gesammelt haben, müssen sie vorab trainiert werden, um einen Korpus vor dem Training aufzubauen, einschließlich Entrauschen, Entfernen von Redundanz und Entfernen irrelevanter und potenziell toxischer Daten. Abbildung 3 unten zeigt die Vorverarbeitungspipeline für Vortrainingsdaten für LLMs.

Architektur

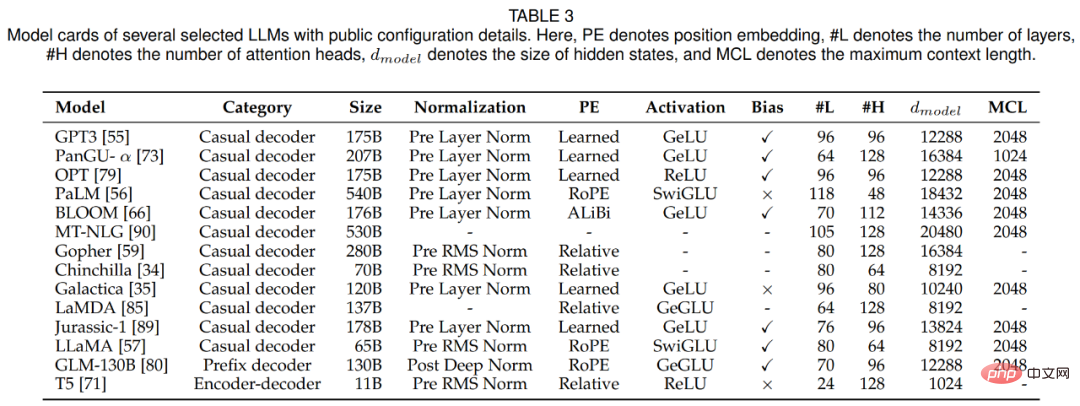

In diesem Abschnitt überprüft der Forscher das architektonische Design von LLMs, d. h. die Mainstream-Architektur, Ziele vor dem Training und detaillierte Konfigurationen. In der folgenden Tabelle 3 sind Modellkarten für mehrere repräsentative LLMs mit öffentlich zugänglichen Details aufgeführt.

Aufgrund ihrer hervorragenden Parallelisierung und Kapazität ist die Transformer-Architektur zum Rückgrat für die Entwicklung verschiedener LLMs geworden und ermöglicht die Skalierung von Sprachmodellen auf Hunderte Milliarden Parameter. Im Allgemeinen lassen sich die Mainstream-Architekturen bestehender LLMs grob in drei Hauptkategorien einteilen, nämlich Encoder-Decoder, Ad-hoc-Decoder und Präfix-Decoder.

Seit dem Erscheinen von Transformer wurden verschiedene Verbesserungen vorgeschlagen, um seine Trainingsstabilität, Leistung und Recheneffizienz zu verbessern. In diesem Teil diskutieren die Forscher die entsprechenden Konfigurationen der vier Hauptteile von Transformer, einschließlich Normalisierung, Positionskodierung, Aktivierungsfunktion, Aufmerksamkeitsmechanismus und Voreingenommenheit.

Vortraining spielt eine sehr entscheidende Rolle, da es allgemeines Wissen aus großen Korpora in groß angelegte Modellparameter umwandelt. Für das Training von LLMs gibt es zwei häufig verwendete Vortrainingsaufgaben: Sprachmodellierung und Entrauschen der automatischen Kodierung.

Modelltraining

In diesem Abschnitt bespricht der Forscher wichtige Einstellungen, Techniken und Techniken für das Training von LLMs.

Zur Parameteroptimierung von LLMs haben Forscher häufig verwendete Einstellungen für Batch-Training, Lernrate, Optimierer und Trainingsstabilität vorgeschlagen.

Mit zunehmender Modell- und Datengröße ist es schwierig geworden, LLM-Modelle mit begrenzten Rechenressourcen effektiv zu trainieren. Insbesondere müssen zwei große technische Probleme angegangen werden, beispielsweise die Steigerung des Trainings durch Eingabe und das Laden größerer Modelle in den GPU-Speicher. In diesem Abschnitt werden mehrere in bestehenden Arbeiten weit verbreitete Methoden zur Bewältigung der beiden oben genannten Herausforderungen besprochen, nämlich 3D-Parallelität, ZeRO und gemischtes Präzisionstraining, und Vorschläge gemacht, wie diese für das Training genutzt werden können.

Adaptives Tuning von LLMs

Nach dem Vortraining können LLMs die allgemeine Fähigkeit erwerben, verschiedene Aufgaben zu lösen. Dennoch deuten immer mehr Forschungsergebnisse darauf hin, dass die Fähigkeiten von LLMs weiter auf spezifische Ziele zugeschnitten werden können. In Abschnitt 5 stellen die Forscher zwei Hauptmethoden zum Optimieren vorab trainierter LLMs im Detail vor, nämlich das Instruktions-Tuning und das Alignment-Tuning. Der erstere Ansatz besteht hauptsächlich darin, die Fähigkeiten von LLMs zu verbessern oder freizuschalten, während der letztere Ansatz darin besteht, das Verhalten von LLMs mit menschlichen Werten oder Vorlieben in Einklang zu bringen.

Instruktionsoptimierung

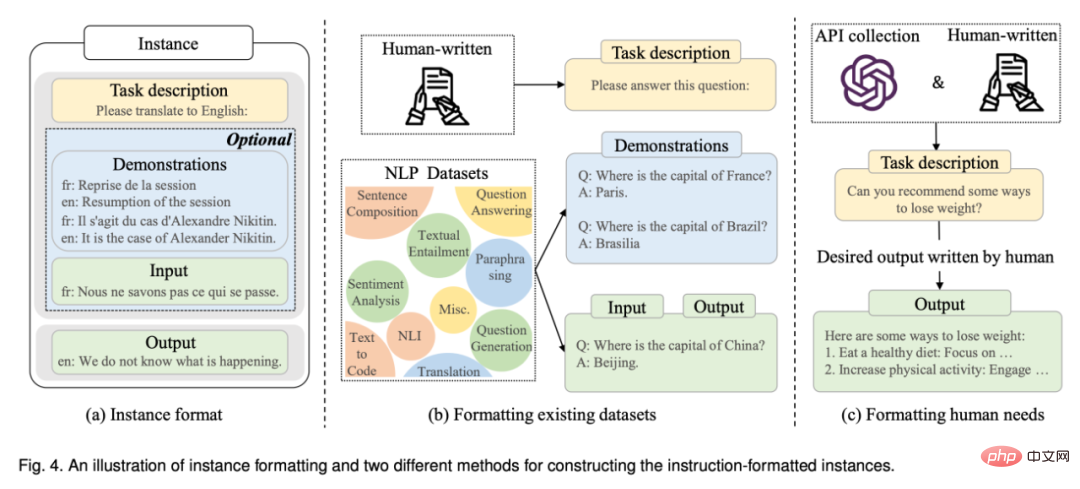

Im Wesentlichen handelt es sich bei der Instruktionsoptimierung um eine Methode zur Feinabstimmung vorab trainierter LLMs anhand einer Sammlung formatierter Beispiele in Form natürlicher Sprache, die für die überwachte Feinabstimmung von großer Bedeutung ist Multitasking-Prompttraining. Um die Befehlsoptimierung durchzuführen, müssen wir zunächst eine Instanz des Befehlsformats sammeln oder erstellen. Anschließend verwenden wir diese formatierten Instanzen typischerweise zur Feinabstimmung von LLMs durch überwachtes Lernen (z. B. durch Training mithilfe eines Sequenz-zu-Sequenz-Verlusts). Wenn ihre Anweisungen abgestimmt sind, können LLMs sogar in mehrsprachigen Umgebungen überlegene Fähigkeiten zur Verallgemeinerung auf unbekannte Aufgaben unter Beweis stellen.

Eine aktuelle Umfrage bietet einen systematischen Überblick über die Forschung zur Unterrichtsoptimierung. Im Gegensatz dazu konzentriert sich dieses Papier auf die Auswirkungen der Befehlsoptimierung auf LLMs und bietet detaillierte Richtlinien oder Strategien beispielsweise für die Sammlung und Optimierung. Darüber hinaus wird in diesem Dokument die Verwendung der Befehlsoptimierung zur Erfüllung der tatsächlichen Bedürfnisse der Benutzer erörtert, die in bestehenden LLMs wie InstructGPT und GPT-4 weit verbreitet ist.

Formatierte Instanzkonstruktion: Typischerweise besteht eine Instanz im Anweisungsformat aus einer Aufgabenbeschreibung (Anweisung genannt), einem Eingabe-Ausgabe-Paar und einer kleinen Anzahl von Demonstrationen (optional). In der bestehenden Forschung wurde eine große Menge gekennzeichneter Daten in natürlicher Sprache als wichtige öffentliche Ressource veröffentlicht (siehe Tabelle 5 für eine Liste der verfügbaren Ressourcen). Als Nächstes stellt dieser Artikel die beiden Hauptmethoden zum Erstellen formatierter Instanzen vor (siehe Abbildung in Abbildung 4) und erörtert anschließend mehrere Schlüsselfaktoren bei der Instanzkonstruktion.

Instruktionsoptimierungsstrategie: Im Gegensatz zum Vortraining ist die Instruktionsoptimierung im Allgemeinen effizienter, da nur eine bescheidene Anzahl von Instanzen für das Training verwendet wird. Während die Abstimmung von Anweisungen als überwachter Trainingsprozess betrachtet werden kann, unterscheidet sich ihre Optimierung in mehreren Aspekten vom Vortraining, z. B. im Trainingsziel (d. h. Verlust von Sequenz zu Sequenz), der Optimierungskonfiguration (z. B. kleinere Batchgröße) und der Lernrate ), die in der Praxis besondere Aufmerksamkeit erfordern. Zusätzlich zu diesen Optimierungskonfigurationen müssen bei der Befehlsoptimierung auch zwei wichtige Aspekte berücksichtigt werden:

- Ausgewogene Datenverteilung.

- Kombiniertes Anleitungstuning und Vortraining.

Alignment Tuning

Dieser Abschnitt stellt zunächst den Hintergrund des Alignments sowie seine Definitionen und Standards vor, konzentriert sich dann auf die Erfassung menschlicher Feedbackdaten zum Alignment von LLMs und diskutiert schließlich die Verwendung von The Schlüsseltechnologie des menschlichen Feedback-Verstärkungslernens zur Ausrichtungsanpassung.

Verwendung

Nach dem Vortraining oder der Anpassung besteht eine der Hauptmethoden zur Verwendung von LLMs darin, geeignete prompte Strategien zur Lösung verschiedener Aufgaben zu entwerfen. Ein typischer Prompt-Ansatz ist das Lernen im Kontext, bei dem Aufgabenbeschreibungen oder Demonstrationen in Form von Texten in natürlicher Sprache formuliert werden. Darüber hinaus kann die Denkketten-Aufforderungsmethode das kontextbezogene Lernen verbessern, indem eine Reihe von Zwischenschritten zum Denken in die Aufforderung integriert werden. In Abschnitt 6 stellen die Forscher die Details dieser beiden Techniken ausführlich vor. Kontextuelles Lernen (kontextuelles Lernen)

Denkkettenaufforderung

Chain of Thoughts (CoT) ist eine verbesserte Prompt-Strategie, die die Leistung von LLM bei komplexen Denkaufgaben wie arithmetischem Denken, gesundem Menschenverstand und symbolischem Denken verbessern kann. Anstatt die Eingabeaufforderung wie ICL einfach aus Input-Output-Paaren aufzubauen, integriert CoT in die Eingabeaufforderung Zwischenschritte, die zur endgültigen Ausgabe führen. In Abschnitt 6.2 gehen wir detailliert auf den Einsatz von CoT im Vergleich zu ICL ein und diskutieren, wann und warum CoT wirksam ist.

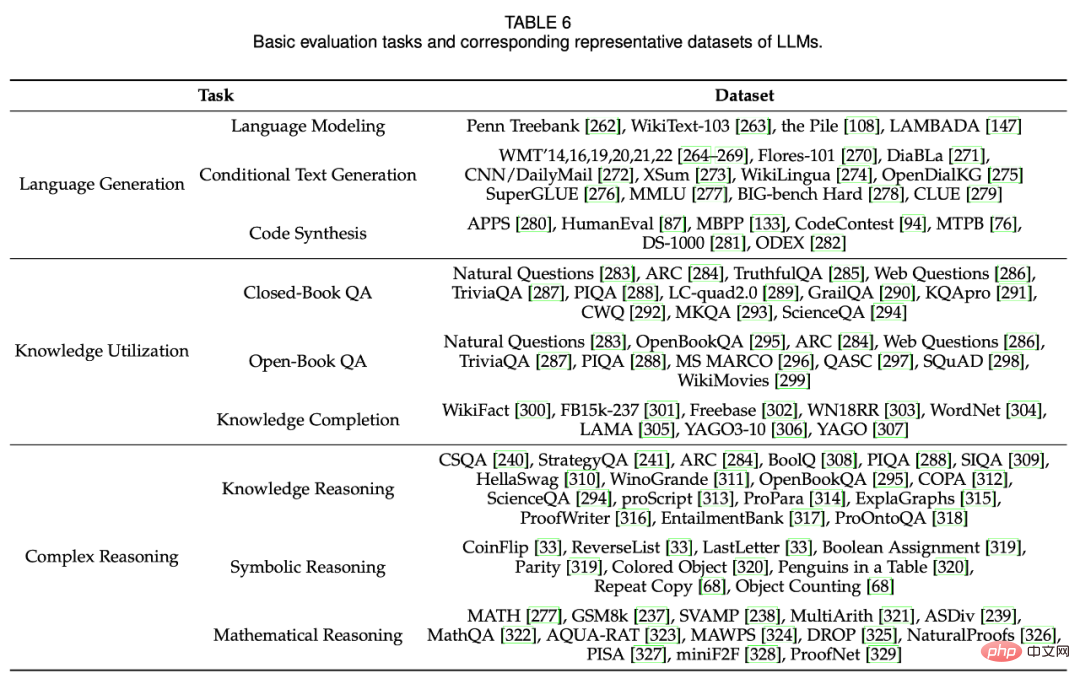

Fähigkeitsbewertung

Um die Wirksamkeit und Überlegenheit von LLMs zu untersuchen, haben Forscher eine große Anzahl von Aufgaben und Benchmarks zur empirischen Bewertung und Analyse herangezogen. Abschnitt 7 stellt zunächst grundlegende Bewertungsaufgaben für drei LLMs zur Sprachproduktion und zum Sprachverständnis vor, stellt dann mehrere fortgeschrittene Aufgaben für LLMs mit komplexeren Einstellungen oder Zielen vor und diskutiert schließlich bestehende Benchmarks und empirische Analysen.

Grundlegende Bewertungsaufgabe

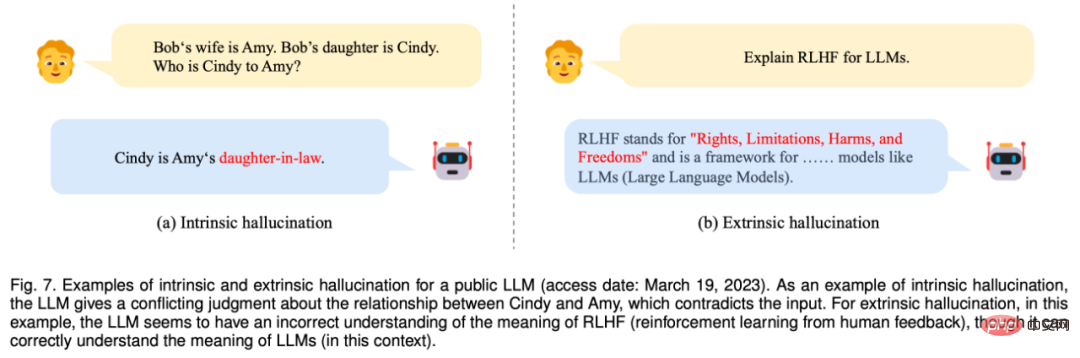

Abbildung 7: Ein Beispiel für interne und externe Illusionen, die LLM entlarven (Zugriff: 19. März 2023). Als Beispiel für eine innere Halluzination gibt LLM ein Urteil über die Beziehung zwischen Cindy und Amy ab, das der Eingabe widerspricht. Bei extrinsischen Halluzinationen scheint LLM in diesem Fall ein falsches Verständnis davon zu haben, was RLHF (Reinforcement Learning from Human Feedback) bedeutet, obwohl es richtig versteht, was LLM bedeutet.

Erweiterte Aufgabenbewertung

Zusätzlich zu den oben genannten grundlegenden Bewertungsaufgaben weisen LLMs auch einige fortgeschrittene Fähigkeiten auf, die einer besonderen Bewertung bedürfen. In Abschnitt 7.2 diskutieren die Forscher mehrere repräsentative High-Level-Fähigkeiten und entsprechende Bewertungsmethoden, einschließlich manueller Ausrichtung, Interaktion mit der externen Umgebung und Werkzeugbedienung.

Zusammenfassung und zukünftige Richtungen

Im letzten Abschnitt fasste der Forscher die Diskussion dieser Umfrage zusammen und stellte die Herausforderungen und zukünftigen Entwicklungsrichtungen von LLMs aus den folgenden Aspekten vor.

Theorie und Prinzipien: Um den grundlegenden Arbeitsmechanismus von LLM zu verstehen, ist eines der größten Rätsel, wie Informationen über sehr große tiefe neuronale Netze verteilt, organisiert und genutzt werden. Es ist wichtig, die zugrunde liegenden Prinzipien oder Elemente offenzulegen, die die Grundlage für die Fähigkeiten von LLMs bilden. Insbesondere die Skalierung scheint eine wichtige Rolle bei der Verbesserung der Fähigkeiten von LLMs zu spielen. Bestehende Untersuchungen haben gezeigt, dass, wenn die Parametergröße eines Sprachmodells auf einen kritischen Punkt (z. B. 10B) ansteigt, einige neue Fähigkeiten auf unerwartete Weise auftreten (plötzlicher Leistungssprung), typischerweise einschließlich Kontextlernen, Befolgen von Anweisungen und Schritt-für-Schritt-Anleitung. schrittweises Denken. Diese „aufkommenden“ Fähigkeiten sind faszinierend, aber auch rätselhaft: Wann und wie erwerben LLMs sie? Einige neuere Forschungsarbeiten haben entweder groß angelegte Experimente durchgeführt, um die Auswirkungen neu entstehender Fähigkeiten und die Voraussetzungen für diese Fähigkeiten zu untersuchen, oder bestehende theoretische Rahmenwerke zur Erklärung spezifischer Fähigkeiten genutzt. Ein aufschlussreicher technischer Beitrag zur GPT-Modellfamilie befasst sich ebenfalls speziell mit diesem Thema, allerdings fehlen noch formalere Theorien und Prinzipien, um die Fähigkeiten oder das Verhalten von LLMs zu verstehen, zu beschreiben und zu erklären. Da neu entstehende Fähigkeiten große Ähnlichkeiten mit Phasenübergängen in der Natur aufweisen, können interdisziplinäre Theorien oder Prinzipien (z. B. ob LLMs als komplexe Systeme betrachtet werden können) hilfreich sein, um das Verhalten von LLMs zu erklären und zu verstehen. Diese grundlegenden Fragen verdienen die Erforschung durch die Forschungsgemeinschaft und sind wichtig für die Entwicklung der nächsten Generation von LLMs.

Modellarchitektur: Transformer, bestehend aus gestapelten Multi-Head-Selbstaufmerksamkeitsschichten, hat sich aufgrund seiner Skalierbarkeit und Effektivität zu einer gängigen Architektur für den Aufbau von LLMs entwickelt. Es wurden verschiedene Strategien vorgeschlagen, um die Leistung dieser Architektur zu verbessern, beispielsweise die Konfiguration neuronaler Netzwerke und skalierbares paralleles Training (siehe Diskussion in Abschnitt 4.2.2). Um die Kapazität des Modells weiter zu verbessern (z. B. Multi-Turn-Dialogfähigkeit), behalten bestehende LLMs normalerweise eine lange Kontextlänge bei. Beispielsweise hat GPT-4-32k eine extrem große Kontextlänge von 32768 Token. Daher besteht eine praktische Überlegung darin, die Zeitkomplexität (primitive quadratische Kosten) zu reduzieren, die durch Standardmechanismen der Selbstaufmerksamkeit entsteht.

Darüber hinaus ist es wichtig, die Auswirkungen effizienterer Transformer-Varianten auf den Aufbau von LLMs zu untersuchen, wie z. B. Sparse Attention wurde in GPT-3 verwendet. Katastrophales Vergessen war auch eine Herausforderung für neuronale Netze, was sich auch negativ auf LLMs ausgewirkt hat. Wenn LLMs mit neuen Daten abgestimmt werden, wird das zuvor erlernte Wissen wahrscheinlich zerstört. Beispielsweise wirkt sich die Feinabstimmung von LLMs auf bestimmte Aufgaben auf ihre allgemeinen Fähigkeiten aus. Eine ähnliche Situation entsteht, wenn LLMs an menschlichen Werten ausgerichtet sind, was als Ausrichtungssteuer bezeichnet wird. Daher muss darüber nachgedacht werden, die bestehende Architektur um flexiblere Mechanismen oder Module zu erweitern, um Datenaktualisierungen und Aufgabenspezialisierung effektiv zu unterstützen.

Modelltraining: In der Praxis ist das Vortraining verwendbarer LLMs aufgrund des enormen Rechenaufwands und der Sensibilität für Datenqualität und Trainingstechniken sehr schwierig. Unter Berücksichtigung von Faktoren wie Modelleffektivität, Effizienzoptimierung und Trainingsstabilität wird es daher besonders wichtig, systematischere und wirtschaftlichere Pre-Training-Methoden zur Optimierung von LLMs zu entwickeln. Entwickeln Sie mehr Modellprüfungen oder Leistungsdiagnosen (z. B. vorhersehbare Skalierung in GPT-4), um Anomalien frühzeitig im Training zu erkennen. Darüber hinaus sind flexiblere Hardwareunterstützung oder Ressourcenplanungsmechanismen erforderlich, um Ressourcen in Computerclustern besser zu organisieren und zu nutzen. Da das Vortraining von LLMs von Grund auf teuer ist, muss ein geeigneter Mechanismus entwickelt werden, um LLMs basierend auf öffentlich verfügbaren Modellkontrollpunkten (z. B. LLaMA und Flan-T5) kontinuierlich vorab zu trainieren oder zu optimieren. Dazu müssen mehrere technische Probleme angegangen werden, darunter Dateninkonsistenz, katastrophales Vergessen und Aufgabenspezialisierung. Bisher fehlen noch Open-Source-Modell-Checkpoints für reproduzierbare LLMs mit vollständigen Vorverarbeitungs- und Trainingsprotokollen (z. B. Skripte zur Aufbereitung von Vortrainingsdaten). Die Bereitstellung weiterer Open-Source-Modelle für die Forschung zu LLMs wäre äußerst wertvoll. Darüber hinaus ist es auch wichtig, verbesserte Anpassungsstrategien und Untersuchungsmechanismen zu entwickeln, um die Modellfähigkeiten wirksam zu stimulieren.

Verwendung von Modellen: Da die Feinabstimmung in realen Anwendungen teuer ist, sind Eingabeaufforderungen zu einer prominenten Methode für die Verwendung von LLMs geworden. Durch die Kombination von Aufgabenbeschreibungen und Demonstrationsbeispielen zu Eingabeaufforderungen ermöglicht kontextuelles Lernen (eine spezielle Form von Eingabeaufforderungen) LLMs eine gute Leistung bei neuen Aufgaben und übertrifft in einigen Fällen sogar fein abgestimmte Modelle mit vollständigen Daten. Um die Fähigkeit zum komplexen Denken zu verbessern, wurden außerdem fortschrittliche Eingabeaufforderungstechniken vorgeschlagen, wie beispielsweise die Chain of Thought (CoT)-Strategie, die Zwischenschritte des Denkens in Eingabeaufforderungen integriert. Die bestehende Eingabeaufforderungsmethode weist jedoch immer noch die folgenden Mängel auf. Erstens ist beim Entwerfen von Eingabeaufforderungen viel Personal erforderlich, sodass die automatische Generierung effektiver Eingabeaufforderungen zum Lösen verschiedener Aufgaben sehr nützlich ist. Zweitens erfordern einige komplexe Aufgaben (z. B. formale Beweise und numerische Berechnungen) spezifische Kenntnisse oder logische Regeln. Diese Kenntnisse bzw Regeln können nicht in natürlicher Sprache beschrieben oder mit Beispielen bewiesen werden. Daher ist es wichtig, Prompt-Methoden mit mehr Informationen und flexiblerer Aufgabenformatierung zu entwickeln. Drittens konzentrieren sich bestehende Prompt-Strategien hauptsächlich auf die Single-Turn-Leistung und sind daher sehr nützlich um interaktive Eingabeaufforderungsmechanismen zur Lösung komplexer Aufgaben zu entwickeln (z. B. durch Gespräche in natürlicher Sprache), wie ChatGPT gezeigt hat.

Sicherheit und Ausrichtung: Trotz ihrer beträchtlichen Fähigkeiten leiden LLMs unter ähnlichen Sicherheitsproblemen wie kleine Sprachmodelle. LLMs neigen beispielsweise dazu, halluzinatorische Texte zu generieren, etwa solche, die vernünftig erscheinen, aber möglicherweise nicht den Tatsachen entsprechen. Schlimmer noch: LLMs können durch absichtliche Anweisungen motiviert werden, schädliche, voreingenommene oder toxische Texte für bösartige Systeme zu erstellen, was zu potenziellen Missbrauchsrisiken führt. Für eine ausführliche Erörterung anderer Sicherheitsprobleme bei LLMs (z. B. Datenschutz, übermäßiges Vertrauen, Desinformation und Impact Operations) werden die Leser auf den technischen Bericht GPT-3/4 verwiesen. Als Hauptmethode zur Vermeidung dieser Probleme wird häufig das Reinforcement Learning from Human Feedback (RLHF) eingesetzt, das Menschen in die Trainingsschleife einbezieht, um gute LLMs zu entwickeln. Um die Sicherheit des Modells zu verbessern, ist es auch wichtig, sicherheitsrelevante Eingabeaufforderungen während des RLHF-Prozesses hinzuzufügen, wie in GPT-4 gezeigt. Allerdings ist RLHF stark auf hochwertige menschliche Feedbackdaten von professionellen Etikettierern angewiesen, was eine korrekte Umsetzung in die Praxis erschwert. Daher ist es notwendig, das RLHF-Framework zu verbessern, um die Arbeit menschlicher Etikettierer zu reduzieren und eine effektivere Annotationsmethode zur Gewährleistung der Datenqualität zu suchen. Beispielsweise können LLMs zur Unterstützung der Annotationsarbeit eingesetzt werden. Vor kurzem wurde Red Teaming eingeführt, um die Modellsicherheit von LLMs zu verbessern. Dabei werden gesammelte gegnerische Eingabeaufforderungen genutzt, um LLMs zu verfeinern (d. h. Red Teaming-Angriffe zu vermeiden). Darüber hinaus ist es auch sinnvoll, einen Lernmechanismus für LLMs durch Kommunikation mit Menschen zu etablieren. Feedback, das von Menschen per Chat gegeben wird, kann von LLMs direkt zur Selbstverbesserung genutzt werden.

Anwendungen und Ökosystem: Da LLMs über starke Fähigkeiten bei der Lösung einer Vielzahl von Aufgaben verfügen, können sie in einer Vielzahl realer Anwendungen eingesetzt werden (z. B. beim Befolgen spezifischer Anweisungen in natürlicher Sprache). Als bedeutender Fortschritt hat ChatGPT das Potenzial, die Art und Weise, wie Menschen auf Informationen zugreifen, zu verändern und zur Veröffentlichung des neuen Bing zu führen. Es ist absehbar, dass LLMs in naher Zukunft erhebliche Auswirkungen auf die Informationssuchtechnologie, einschließlich Suchmaschinen und Erkennungssysteme, haben werden.

Darüber hinaus wird mit der technologischen Weiterentwicklung von LLMs die Entwicklung und Nutzung intelligenter Informationsassistenten stark vorangetrieben. Im weiteren Sinne führt diese Welle technologischer Innovationen tendenziell dazu, ein Ökosystem von Anwendungen zu schaffen, die von LLMs lizenziert werden (z. B. die Unterstützung von Plug-Ins durch ChatGPT), die für das menschliche Leben von großer Bedeutung sein werden. Schließlich liefert der Aufstieg von LLMs Inspiration für die Erforschung der künstlichen allgemeinen Intelligenz (AGI). Es verspricht die Entwicklung intelligenterer Systeme (möglicherweise mit multimodalen Signalen) als je zuvor. Gleichzeitig sollte in diesem Entwicklungsprozess die Sicherheit der künstlichen Intelligenz eines der Hauptanliegen sein, das heißt, dass künstliche Intelligenz der Menschheit eher Nutzen als Schaden bringen soll.

Das obige ist der detaillierte Inhalt vonEine neu veröffentlichte Übersicht über groß angelegte Sprachmodelle: die umfassendste Übersicht von T5 bis GPT-4, gemeinsam verfasst von mehr als 20 inländischen Forschern. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr