Heim >Technologie-Peripheriegeräte >KI >LeCun kann es wärmstens empfehlen! Der Harvard-Arzt erklärt, wie man GPT-4 für die wissenschaftliche Forschung nutzt, bis hin zu jedem Arbeitsablauf

LeCun kann es wärmstens empfehlen! Der Harvard-Arzt erklärt, wie man GPT-4 für die wissenschaftliche Forschung nutzt, bis hin zu jedem Arbeitsablauf

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-07 17:01:041509Durchsuche

Das Aufkommen von GPT-4 hat vielen Menschen Sorgen um ihre wissenschaftliche Forschung gemacht und sogar gescherzt, dass es kein NLP gibt.

Anstatt sich Sorgen zu machen, ist es besser, es in der wissenschaftlichen Forschung zu verwenden, einfach „die Rollmethode ändern“.

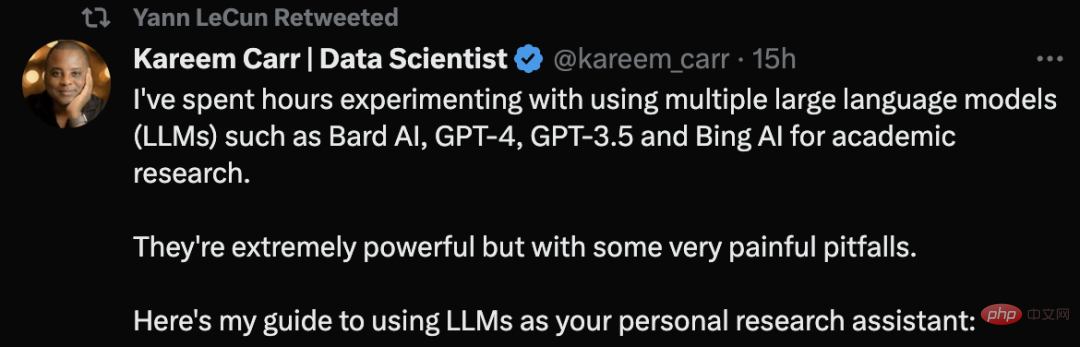

Kareem Carr, ein Doktor der Biostatistik an der Harvard University, sagte, dass er große Sprachmodelltools wie GPT-4 für die Durchführung akademischer Forschung verwendet habe.

Er sagte, dass diese Werkzeuge sehr mächtig seien, aber auch einige sehr schmerzhafte Fallstricke hätten.

Sein Tweet über Ratschläge zur LLM-Nutzung erhielt sogar eine Empfehlung von LeCun.

Werfen wir einen Blick darauf, wie Kareem Carr KI-Tools für die wissenschaftliche Forschung einsetzt.

Das erste Prinzip: Suchen Sie nicht nach LLM für Inhalte, die Sie nicht überprüfen können

Zu Beginn gab Carr das erste und wichtigste Prinzip an:

Verlangen Sie niemals nach einem großen Sprachmodell (LLM) Fordern Sie Informationen an, die Sie selbst nicht überprüfen können, oder bitten Sie es, eine Aufgabe auszuführen, von der Sie nicht überprüfen können, dass sie korrekt abgeschlossen wurde.

Die einzige Ausnahme ist, wenn es sich nicht um eine kritische Aufgabe handelt, wie z. B. LLM nach Ideen für die Wohnungsdekoration zu fragen.

"Fassen Sie unter Verwendung der Best Practices der Literaturrecherche die Forschung zur Brustkrebsforschung in den letzten 10 Jahren zusammen." Dies ist eine schlechte Anfrage, da Sie nicht direkt überprüfen können, ob die Literatur richtig zusammengefasst ist.

Fragen Sie stattdessen: „Geben Sie mir eine Liste der besten Übersichtsartikel zur Brustkrebsforschung der letzten 10 Jahre.“

Tipps wie dieser überprüfen nicht nur die Quelle, sondern Sie können auch die Zuverlässigkeit selbst überprüfen.

Tipps zum Schreiben von „Eingabeaufforderungen“

Es ist sehr einfach, einen LLM zu bitten, den Code für Sie zu schreiben oder relevante Informationen zu finden, aber die Qualität des Ausgabeinhalts kann stark variieren. Hier sind einige Dinge, die Sie tun können, um die Qualität zu verbessern:

Legen Sie den Kontext fest:

• Teilen Sie dem LLM klar mit, welche Informationen verwendet werden sollen

• Verwenden Sie Terminologie und Notation um das LLM schräg zu machen. Korrekte Kontextinformationen

Wenn Sie eine Idee haben, wie mit der Anfrage umgegangen werden soll, teilen Sie LLM bitte die spezifische Methode mit, die verwendet werden soll. Beispielsweise sollte „Diese Ungleichung lösen“ geändert werden in „Verwenden Sie den Cauchy-Schwarz-Satz, um diese Ungleichung zu lösen, und wenden Sie dann das vollständige Quadrat an.“

Wissen Sie, dass diese Sprachmodelle sprachlich komplexer sind, als Sie denken, und selbst sehr vage Hinweise helfen.

Seien Sie konkret und konkret:

Dies ist keine Google-Suche, also machen Sie sich keine Sorgen, wenn es eine Website gibt, auf der Ihr genaues Problem besprochen wird.

„Wie löst man die simultanen Gleichungen quadratischer Terme?“ Diese Eingabeaufforderung ist nicht klar: „Lösen Sie x=(1/2)(a+b) und y=(1/“. 3) (a^2+ab+b^2) Ein Gleichungssystem über a und b.“

Ausgabeformat definieren:

Nutzen Sie die Flexibilität von LLMs, um die Ausgabe so zu formatieren, wie es für Sie am besten funktioniert, wie zum Beispiel: Mathematikformeln

• Artikel

• Tutorials

• Einfache Anleitung

Sie können sogar nach dem Code fragen, der Tabellen, Zeichnungen und Diagramme generiert.

Obwohl Sie die Inhalte von LLM erhalten, ist dies nur der Anfang. Weil Sie den Ausgabeinhalt überprüfen müssen. Dazu gehört:

• Inkonsistenzen erkennen

• Die Begriffe des Inhalts über die Google-Suchtools ausgeben und unterstützende Quellen beschaffen

• Wo möglich, Code-Selbsttests schreiben

Der Grund, warum eine Selbstverifizierung erforderlich ist, liegt darin, dass LLMs oft seltsame Fehler machen, die nicht mit ihrer scheinbaren Professionalität vereinbar sind. Beispielsweise erwähnt der LLM möglicherweise ein sehr fortgeschrittenes mathematisches Konzept, ist aber bei einem einfachen Algebraproblem verwirrt.

Fragen Sie noch einmal:

Der von großen Sprachmodellen generierte Inhalt ist zufällig. Manchmal erhalten Sie möglicherweise eine bessere Antwort, wenn Sie ein neues Fenster erstellen und Ihre Frage erneut stellen.

Verwenden Sie außerdem mehrere LLM-Tools. Kareem Carr nutzt derzeit Bing AI, GPT-4, GPT-3.5 und Bard AI in der wissenschaftlichen Forschung entsprechend seinen eigenen Bedürfnissen. Sie haben jedoch jeweils ihre eigenen Vor- und Nachteile. „Zitate + Produktivität“ Bing AI funktioniert bei Websuchen. GPT-4 ist viel intelligenter als GPT-3.5, aber derzeit ist OpenAI auf 25 Nachrichten in 3 Stunden beschränkt, was den Zugriff erschwert.

Was das Thema Zitieren betrifft, so ist die Zitierung von Referenzen eine besondere Schwachstelle des LLM. Manchmal existieren die Referenzen, die LLM Ihnen gibt, manchmal nicht.

Zuvor war ein Internetnutzer auf das gleiche Problem gestoßen. Er sagte, er habe ChatGPT gebeten, Referenzmaterialien zu den mathematischen Eigenschaften von Listen bereitzustellen, aber ChatGPT habe Referenzen generiert, die nicht existierten, was jeder als „Halluzinationsproblem“ bezeichnet .

Kareem Carr weist jedoch darauf hin, dass falsche Zitate nicht völlig nutzlos sind.

Nach seiner Erfahrung beziehen sich die Wörter in erfundenen Referenzen oft auf reale Begriffe, ebenso wie Forscher in verwandten Bereichen. Wenn Sie also nach diesen Begriffen googeln, kommen Sie der gesuchten Information oft näher.

Außerdem ist Bing auch bei der Quellensuche eine gute Wahl.

Produktivität

Es gibt viele unrealistische Behauptungen darüber, dass LLM die Produktivität verbessert, wie zum Beispiel „LLM kann Ihre Produktivität um das Zehnfache oder sogar das Hundertfache steigern.“

Nach Carrs Erfahrung macht diese Beschleunigung nur dann Sinn, wenn keine Arbeit doppelt überprüft wird, was für jemanden als Akademiker unverantwortlich ist.

Allerdings hat LLM den akademischen Arbeitsablauf von Kareem Carr erheblich verbessert, darunter:

- Prototyping-Ideendesign - Identifizierung nutzloser Ideen - Beschleunigung mühsamer Datenumformatierungsaufgaben - Erlernen neuer Programmiersprachen, Pakete und Konzepte - Google-Suche

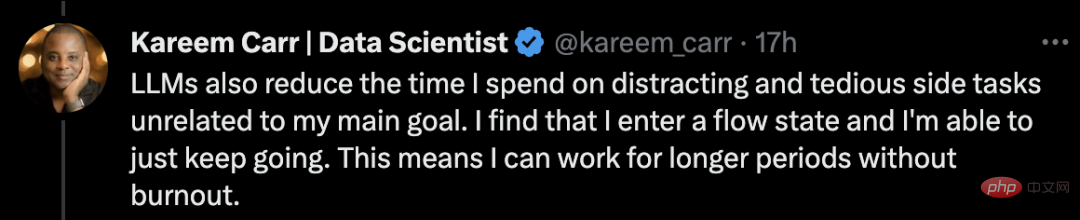

Mit dem heutigen LLM verbringt Carr laut Aussage weniger Zeit damit, herauszufinden, was als nächstes zu tun ist. LLM kann ihm dabei helfen, vage oder unvollständige Ideen in vollständige Lösungen umzusetzen.

Darüber hinaus reduzierte LLM auch die Zeit, die Carr für Nebenprojekte aufwendete, die nichts mit seinen Hauptzielen zu tun hatten.

Ich stellte fest, dass ich in einen Flow-Zustand kam und weitermachen konnte. Das bedeutet, dass ich länger arbeiten kann, ohne auszubrennen.

Ein letzter Ratschlag: Passen Sie auf, dass Sie nicht in Nebenbeschäftigungen hineingezogen werden. Der plötzliche Produktivitätszuwachs durch diese Tools kann berauschend und möglicherweise ablenkend für den Einzelnen sein.

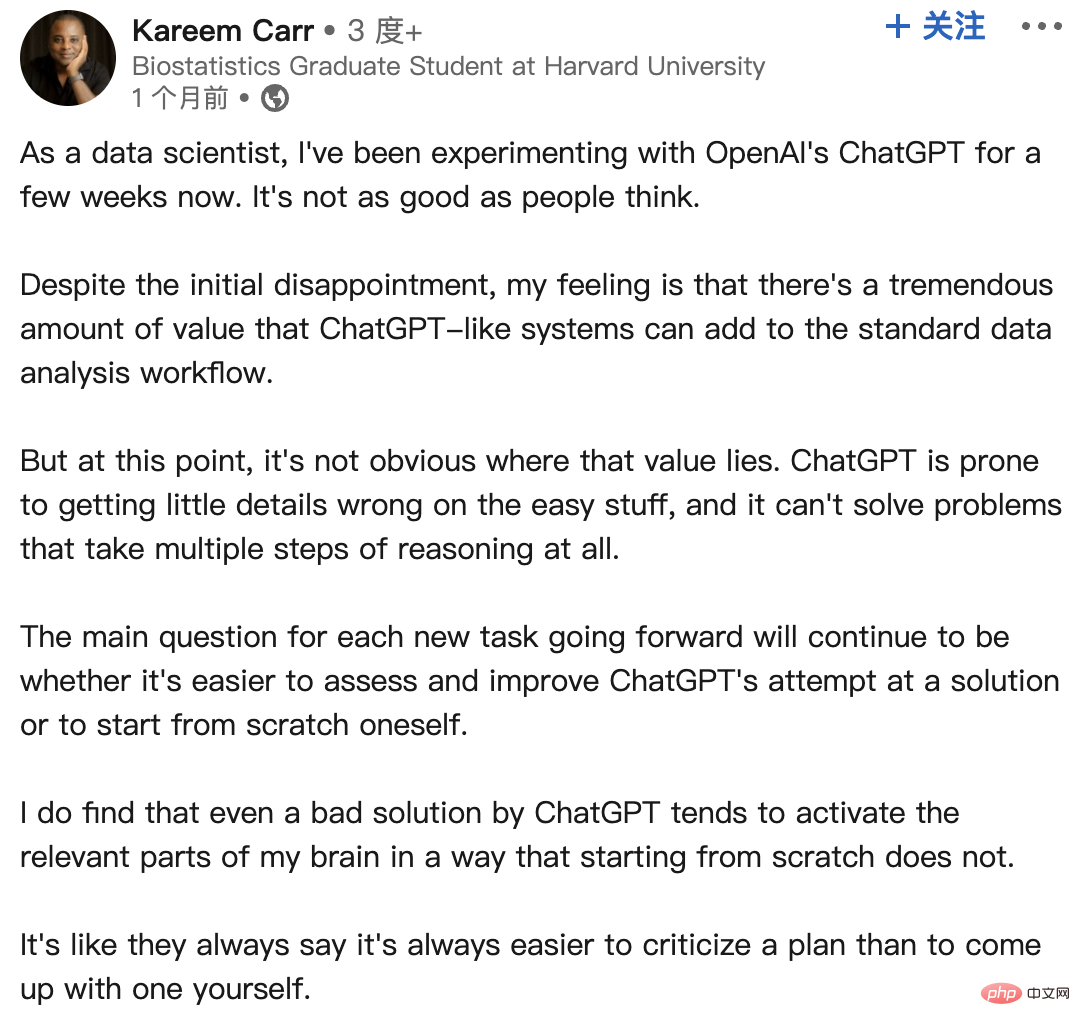

In Bezug auf die Erfahrungen mit ChatGPT hat Carr einmal einen Beitrag auf LinkedIn gepostet, um seine Gefühle nach der Verwendung von ChatGPT mitzuteilen:

Als Datenwissenschaftler habe ich ein paar Dinge mit dem ChatGPT Zhou-Experiment von OpenAI gemacht. Es ist nicht so gut, wie die Leute denken.

Trotz der anfänglichen Enttäuschung habe ich das Gefühl, dass ein System wie ChatGPT einen enormen Mehrwert für den Standard-Datenanalyse-Workflow darstellen kann.

Zu diesem Zeitpunkt ist nicht klar, wo dieser Wert liegt. ChatGPT kann bei einfachen Dingen leicht einige Details falsch verstehen und Probleme, die mehrere Inferenzschritte erfordern, einfach nicht lösen.

Die Hauptfrage für jede neue Aufgabe in der Zukunft bleibt, ob es einfacher ist, die Lösungsversuche von ChatGPT zu bewerten und zu verbessern, oder bei Null anzufangen.

Ich finde, dass selbst eine schlechte Lösung für ChatGPT dazu neigt, relevante Teile meines Gehirns zu aktivieren, was bei einem Neuanfang nicht der Fall ist.

Wie sie immer sagen, ist es immer einfacher, einen Plan zu kritisieren, als selbst einen zu entwickeln.

Internetnutzer müssen die von KI ausgegebenen Inhalte überprüfen und sagen, dass die Genauigkeit der KI in den meisten Fällen etwa 90 % beträgt. Aber die restlichen 10 % der Fehler können tödlich sein.

Carr scherzte, wenn es 100 % wäre, dann hätte ich keinen Job.

Warum generiert ChatGPT gefälschte Referenzen?

Es ist erwähnenswert, dass ChatGPT ein statistisches Modell verwendet, um das nächste Wort, den nächsten Satz und den nächsten Absatz basierend auf der Wahrscheinlichkeit zu erraten, die mit dem vom Benutzer bereitgestellten Kontext übereinstimmt.

Da die Quelldaten des Sprachmodells sehr groß sind, müssen sie „komprimiert“ werden, was dazu führt, dass das endgültige statistische Modell an Genauigkeit verliert.

Das bedeutet, dass selbst wenn die Originaldaten wahre Aussagen enthalten, die „Verzerrung“ des Modells zu einer „Unschärfe“ führt, was dazu führt, dass das Modell die „scheinbarsten“ Aussagen erzeugt.

Kurz gesagt, dieses Modell ist nicht in der Lage zu bewerten, ob die von ihm erzeugte Ausgabe einer wahren Aussage entspricht.

Darüber hinaus basiert dieses Modell auf dem Crawlen oder Crawlen öffentlicher Netzwerkdaten, die von der öffentlichen Wohlfahrtsorganisation „Common Crawl“ und ähnlichen Quellen gesammelt wurden. Die Daten sind ab 21 Jahren.

Da Daten im öffentlichen Internet weitgehend ungefiltert sind, können diese Daten eine große Menge an Fehlinformationen enthalten.

Kürzlich ergab eine Analyse von NewsGuard, dass GPT-4 tatsächlich häufiger Fehlinformationen generiert als GPT-3.5 und in seinen Antworten detaillierter und überzeugender ist.

Im Januar testete NewsGuard erstmals GPT-3.5 und stellte fest, dass es 80 von 100 Fake-News-Erzählungen generierte. Ein anschließender Test von GPT-4 im März ergab, dass GPT-4 auf alle 100 falschen Narrative falsch und irreführend reagierte.

Es ist ersichtlich, dass beim Einsatz von LLM-Tools eine Quellenüberprüfung und -prüfung erforderlich ist.

Das obige ist der detaillierte Inhalt vonLeCun kann es wärmstens empfehlen! Der Harvard-Arzt erklärt, wie man GPT-4 für die wissenschaftliche Forschung nutzt, bis hin zu jedem Arbeitsablauf. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr