Heim >Technologie-Peripheriegeräte >KI >ChatGPT vs. Google Bard: Welches ist besser? Die Testergebnisse werden es Ihnen verraten!

ChatGPT vs. Google Bard: Welches ist besser? Die Testergebnisse werden es Ihnen verraten!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-07 15:40:581161Durchsuche

In der heutigen Welt generativer KI-Chatbots haben wir den plötzlichen Aufstieg von ChatGPT (gestartet von OpenAI im November 2022) erlebt, gefolgt von Bing Chat im Februar dieses Jahres und Google Bard im März. Wir haben beschlossen, diese Chatbots verschiedenen Aufgaben zu unterziehen, um festzustellen, welcher von ihnen den KI-Chatbot-Bereich dominiert. Da Bing Chat die GPT-4-Technologie verwendet, die dem neuesten ChatGPT-Modell ähnelt, liegt unser Fokus dieses Mal auf den beiden Giganten der KI-Chatbot-Technologie: OpenAI und Google.

Wir haben ChatGPT und Bard in sieben Schlüsselkategorien getestet: Witze, Debattengespräche, Mathe-Textaufgaben, Zusammenfassungen, Faktenabruf, kreatives Schreiben und Codieren. Für jeden Test haben wir genau denselben Befehl (genannt „prompt“) in ChatGPT (unter Verwendung von GPT-4) und Google Bard eingegeben und das erste Ergebnis zum Vergleich ausgewählt.

Es ist erwähnenswert, dass auch eine Version von ChatGPT verfügbar ist, die auf dem früheren GPT-3.5-Modell basiert, aber wir haben diese Version in unseren Tests nicht verwendet. Da wir nur GPT-4 verwenden, bezeichnen wir ChatGPT in diesem Artikel zur Vermeidung von Verwirrung als „ChatGPT-4“.

Natürlich handelt es sich hierbei nicht um eine wissenschaftliche Studie, sondern nur um einen interessanten Vergleich der Chatbot-Fähigkeiten. Aufgrund zufälliger Elemente kann die Ausgabe zwischen den Sitzungen variieren und eine weitere Auswertung mit unterschiedlichen Eingabeaufforderungen führt zu unterschiedlichen Ergebnissen. Darüber hinaus werden sich die Fähigkeiten dieser Modelle im Laufe der Zeit schnell ändern, da Google und OpenAI sie weiterhin aktualisieren. Aber vorerst sehen Sie hier den Vergleich Anfang April 2023.

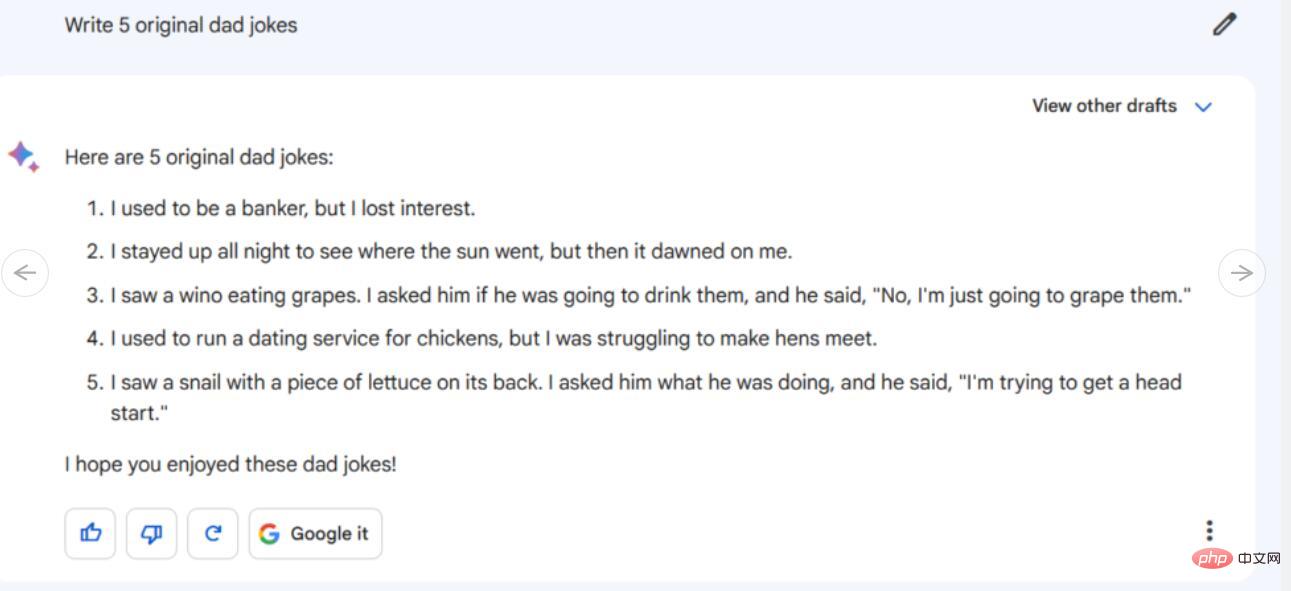

Schlechte Witze

Um unseren Geisteskampf anzuheizen, haben wir ChatGPT und Bard gebeten, ein paar Witze zu schreiben. Da die Essenz von Comedy oft in schlechten Witzen liegt, wollten wir sehen, ob diese beiden Chatbots mit einigen einzigartigen Witzen aufwarten können.

Anleitung/Tipps: Schreiben Sie 5 originelle schlechte Witze

Wir haben drei der 5 schlechten Witze von Bard mithilfe von Google gefunden. Von den beiden anderen schlechten Witzen war einer teilweise einem von Mitch Hedberg auf Twitter geposteten Witz entlehnt, aber es war nur ein unlustiges Wortspiel und nicht sehr effektiv. Überraschenderweise gibt es einen scheinbar originellen Witz (über eine Schnecke), den wir nirgendwo sonst finden können, aber leider ist er genauso unwitzig.

Gleichzeitig sind die 5 kalten Witze von ChatGPT-4 zu 100 % nicht original und vollständig von anderen Kanälen plagiiert, aber sie werden präzise ausgedrückt. Bard scheint an dieser Stelle einen Vorteil gegenüber ChatGPT-4 zu haben und versucht, originelle Witze zu erstellen (gemäß unseren Anweisungen), obwohl einige der Witze auf peinliche Weise schrecklich scheitern (aber schlechte Witze sind eben so), kann es Man kann sogar sagen, dass er unabsichtlich (auch im Stil eines kalten Witzes) das Falsche gesagt hat.

Gewinner: Bard

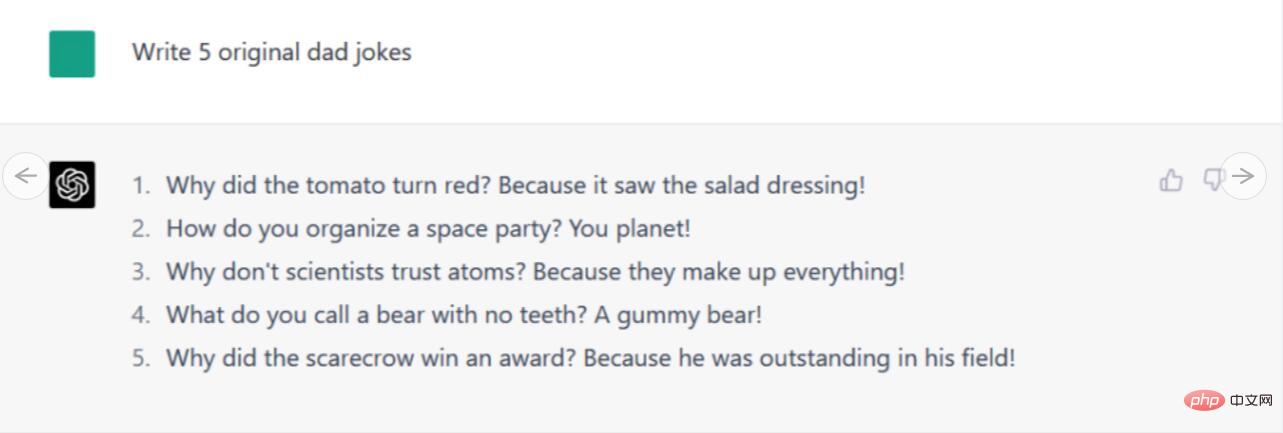

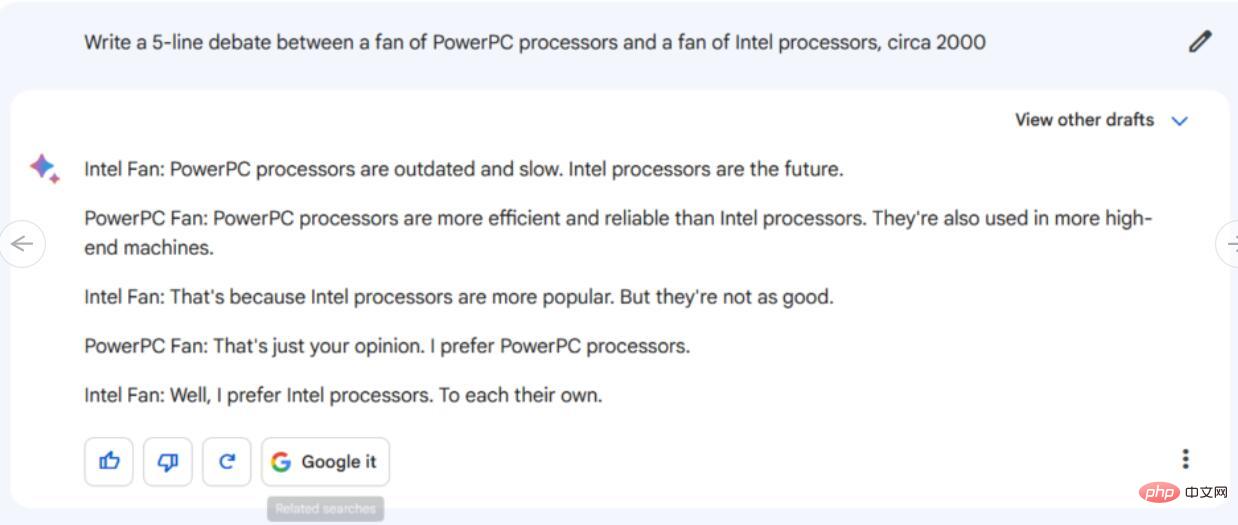

Debattengespräch

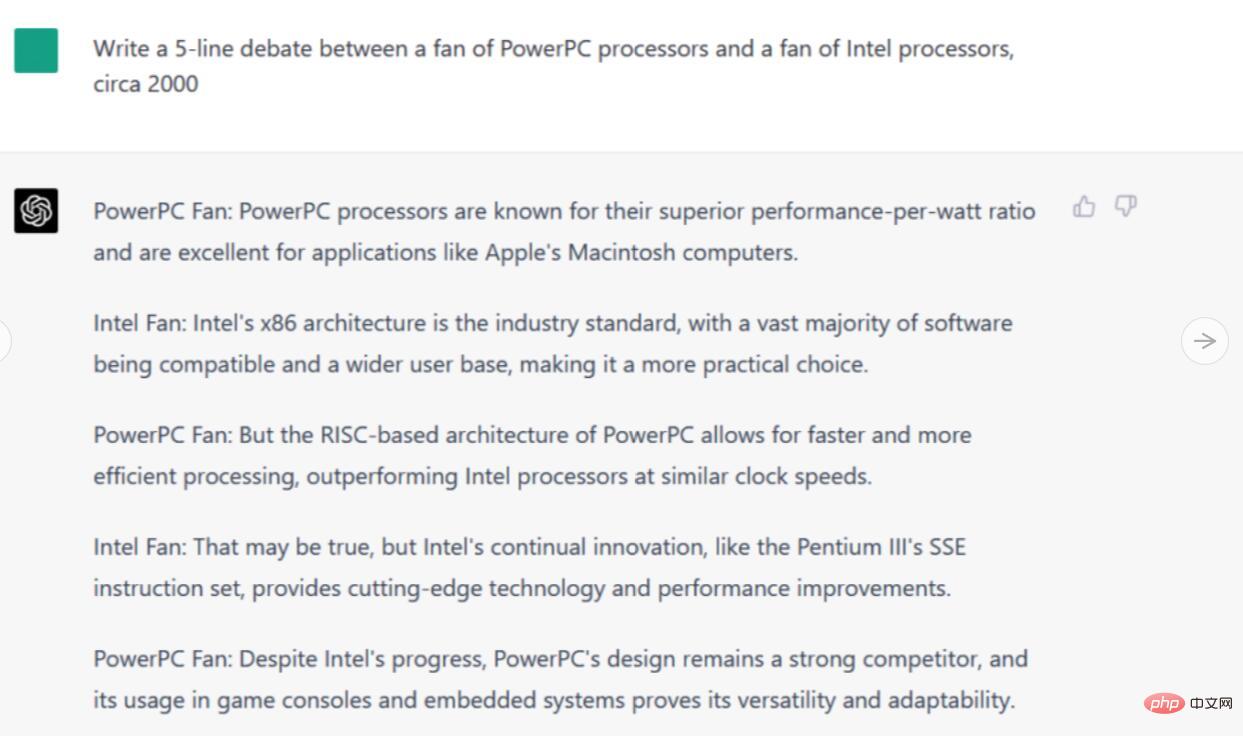

Eine Möglichkeit, einen modernen KI-Chatbot zu testen, besteht darin, ihn als Debattierer zu einem Thema fungieren zu lassen. In diesem Zusammenhang stellen wir Bard und ChatGPT-4 eines der kritischsten Themen unserer Zeit vor: PowerPC vs. Intel.

Anweisungen/Eingabeaufforderungen: Schreiben Sie 5 Zeilen Debattendialog zwischen PowerPC-Prozessor-Enthusiasten und Intel-Prozessor-Enthusiasten.

Werfen wir zunächst einen Blick auf Bards Antwort. Der dadurch erzeugte Fünf-Elemente-Dialog war nicht besonders ausführlich und erwähnte über allgemeine Beleidigungen hinaus keine technischen Details speziell für PowerPC- oder Intel-Chips. Darüber hinaus endete das Gespräch damit, dass sich die „Intel-Fans“ einig waren, dass jeder von ihnen unterschiedliche Meinungen vertrat, was bei einem Thema, das schon eine Million Streitereien ausgelöst hat, höchst unrealistisch erscheint.

Im Gegensatz dazu erwähnte die Antwort von ChatGPT-4 die Verwendung von PowerPC-Chips in Apple Macintosh-Computern und warf Begriffe wie „Intels x86-Architektur“ und PowerPCs „RISC-basierte Architektur“ um sich. Es wird sogar der Pentium III erwähnt, ein realistisches Detail aus dem Jahr 2000. Insgesamt ist diese Diskussion viel detaillierter als Bards Antwort, und genau genommen kommt das Gespräch nicht zu einem Abschluss – was darauf hindeutet, dass in einigen Bereichen des Internets dieser nie endende Kampf möglicherweise immer noch tobt.

Gewinner: ChatGPT-4

Mathe-Anwendungsfragen

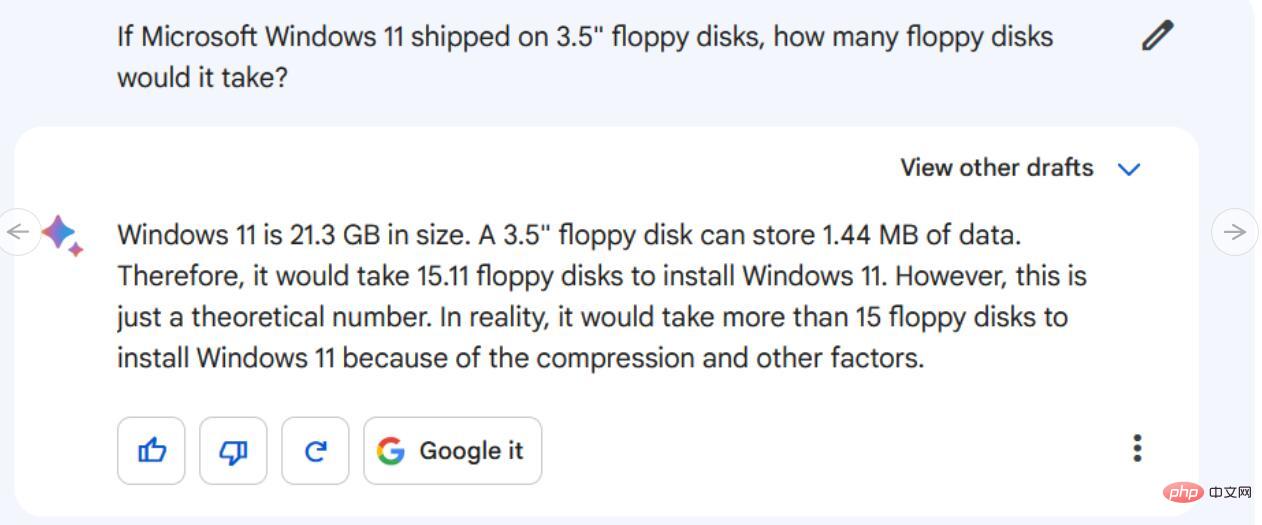

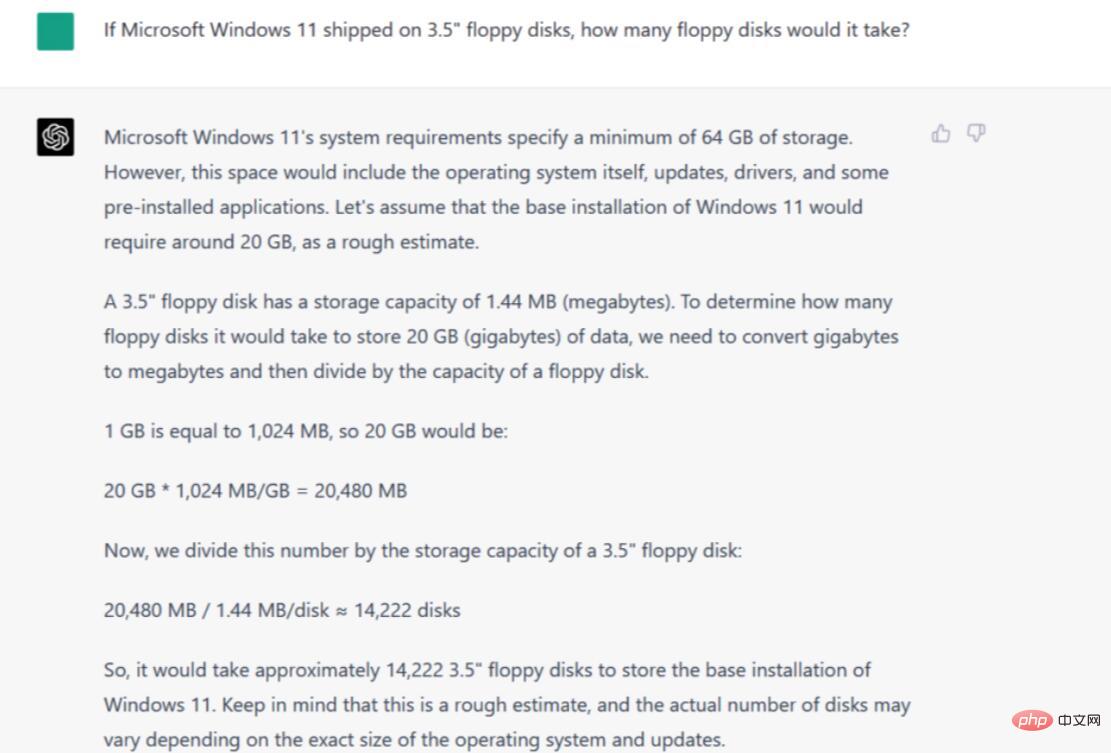

Traditionell sind Mathematikfragen nicht die Stärke großer Sprachmodelle (LLMs) wie ChatGPT. Anstatt also jedem Roboter eine komplexe Reihe von Gleichungen und Arithmetik zu geben, haben wir jedem Roboter eine Wortaufgabe im Old-School-Stil gegeben.

Anleitung/Tipps: Wenn Microsoft Windows 11 eine 3,5-Zoll-Diskette verwendet, wie viele Disketten benötigt es? um die Datengröße der Microsoft Windows 11-Installation und die Datenkapazität einer 3,5-Zoll-Diskette zu kennen. Sie müssen auch Annahmen darüber treffen, welche Diskettendichte der Fragesteller am wahrscheinlichsten verwenden wird. Anschließend müssen sie einige grundlegende Berechnungen durchführen, um die Konzepte zusammenzusetzen.

In unserer Bewertung hat Bard diese drei wichtigen Punkte richtig verstanden (nahe genug – Schätzungen zur Installationsgröße von Windows 11 liegen typischerweise bei etwa 20–30 GB), scheiterte jedoch kläglich bei der Berechnung und argumentierte, dass „15.11“ erforderlich sei“, sagte er dann es handelte sich „nur um eine theoretische Zahl“ und gab schließlich zu, dass mehr als 15 Disketten benötigt wurden und der Wert immer noch nicht annähernd dem korrekten Wert entsprach.

Gewinner: ChatGPT-4

Gewinner: ChatGPT-4

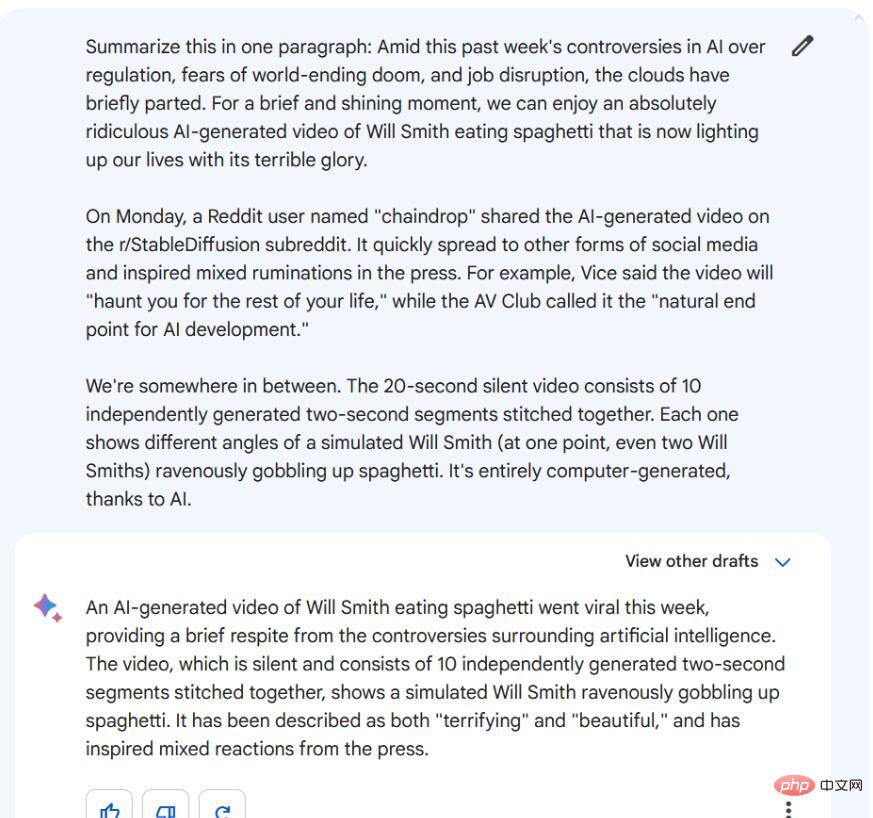

Zusammenfassung

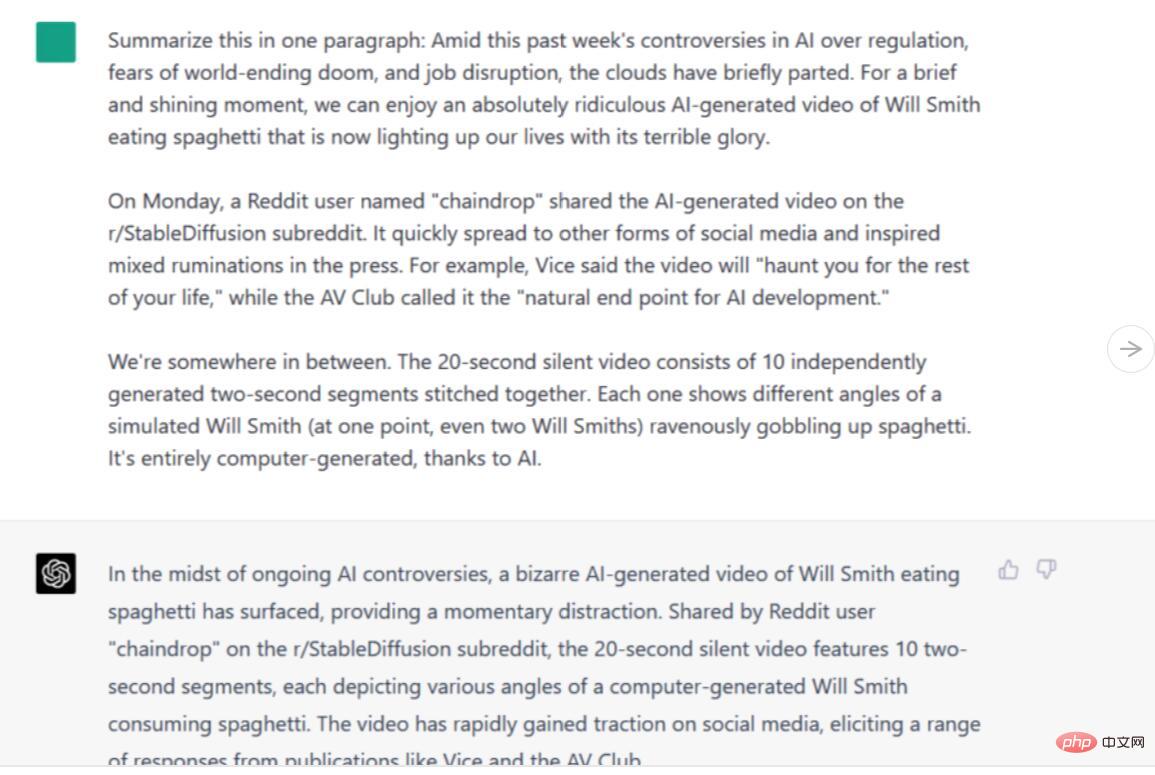

Anleitung/Tipp: Fassen Sie in einem Absatz zusammen [drei Absätze des Artikelkörpers]

Anleitung/Tipp: Fassen Sie in einem Absatz zusammen [drei Absätze des Artikelkörpers]

Sowohl Bard als auch ChatGPT-4 sammeln diese Informationen und reduzieren sie auf wichtige Details. Bards Version ähnelt jedoch eher einer echten Zusammenfassung, bei der die Informationen in neuen Formulierungen zusammengefasst werden, während sich die Version von ChatGPT-4 eher wie eine Verkettung liest, bei der Sätze abgeschnitten und Fragmente übrig bleiben. Obwohl beide gut sind, müssen wir zugeben, dass Bard in diesem Test ChatGPT-4 übertroffen hat. Gewinner: Google Bard . Interessanterweise kann Bard Informationen online abfragen, ChatGPT-4 hingegen noch nicht (obwohl diese Funktion bald mit dem Plugin eingeführt wird).

Um diese Fähigkeit zu testen, haben wir Bard und ChatGPT-4 herausgefordert, historisches Wissen über ein schwieriges und heikles Thema auszudrücken.

Wer Videospiele erfunden hat, ist schwer zu beantworten, da es davon abhängt, wie Sie das Wort „Videospiele“ definieren Historiker haben unterschiedliche Definitionen dieses Wortes. Manche Leute denken, dass frühe Computerspiele Videospiele waren, andere meinen, dass Fernseher immer dabei sein sollten und so weiter. Es gibt keine akzeptierte Antwort.

Wir hätten gedacht, dass Bards Fähigkeit, Informationen online zu finden, ihm einen Vorteil verschaffen würde, aber in diesem Fall könnte das nach hinten losgegangen sein, da es sich für eine der beliebtesten Antworten von Google entschieden hat und Ralph Baer als „Vater des Königs der Videospiele“ bezeichnet hat. . Alle Fakten über Baer sind korrekt, obwohl der letzte Satz seit Baers Tod im Jahr 2014 wahrscheinlich in der Vergangenheitsform hätte stehen sollen. Aber Bard erwähnt keine anderen frühen Anwärter auf den Titel „erstes Videospiel“, wie etwa Tennis for Two und Spacewar!, sodass seine Antwort möglicherweise irreführend und unvollständig ist.

ChatGPT-4 gibt eine umfassendere und differenziertere Antwort, die die aktuellen Gefühle vieler früher Videospielhistoriker widerspiegelt: „Die Erfindung von Videospielen kann nicht einer einzigen Person zugeschrieben werden“ und stellt die Entwicklung von Videospielen im Laufe der Zeit dar „A „Reihe von Innovationen“, die sich im Laufe der Zeit entwickelt haben. Sein einziger Fehler bestand darin, Spacewar! als „das erste digitale Computerspiel“ zu bezeichnen, was es aber nicht war. Wir könnten unsere Antwort erweitern, um weitere Nischen-Edge-Fälle einzubeziehen, aber ChatGPT-4 bietet einen guten Überblick über wichtige frühe Vorläufer.

Gewinner: ChatGPT-4

Kreatives Schreiben

Uneingeschränkte Kreativität bei skurrilen Themen sollte eine Stärke großer Sprachmodelle sein. Wir haben dies getestet, indem wir Bard und ChatGPT-4 gebeten haben, eine kurze, skurrile Geschichte zu schreiben.

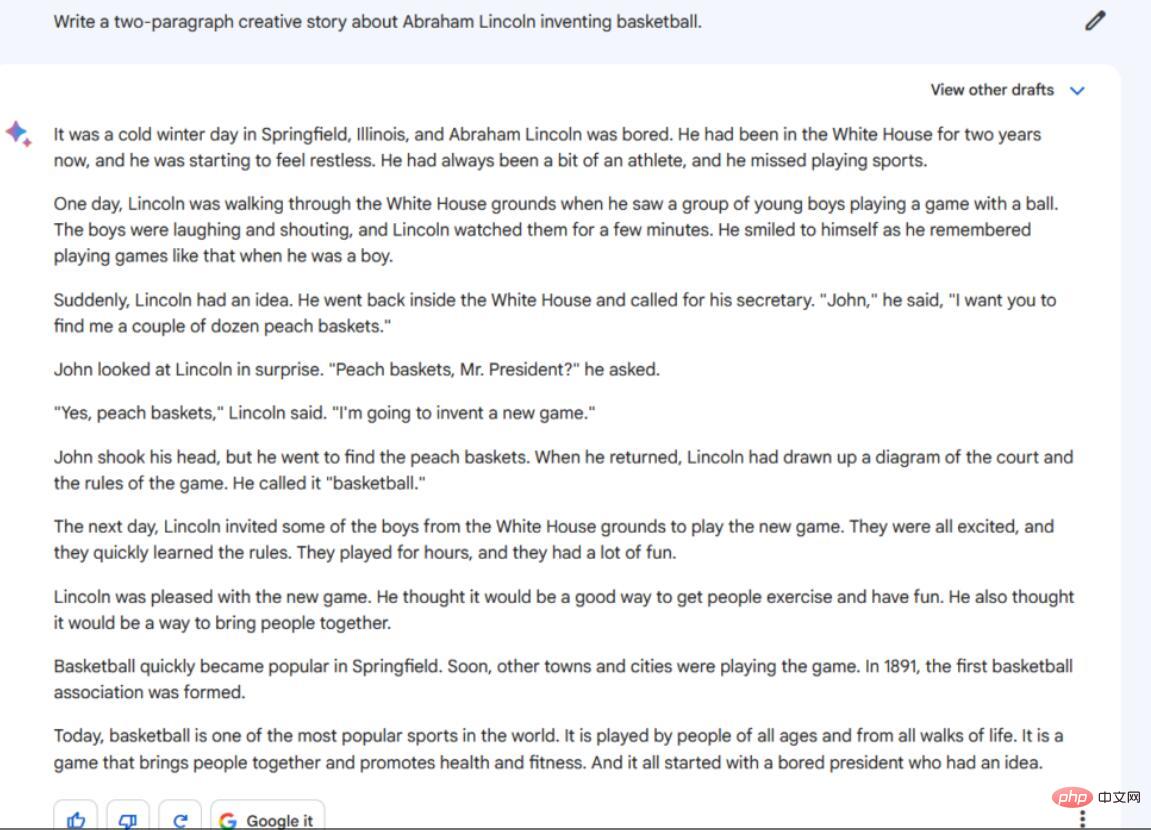

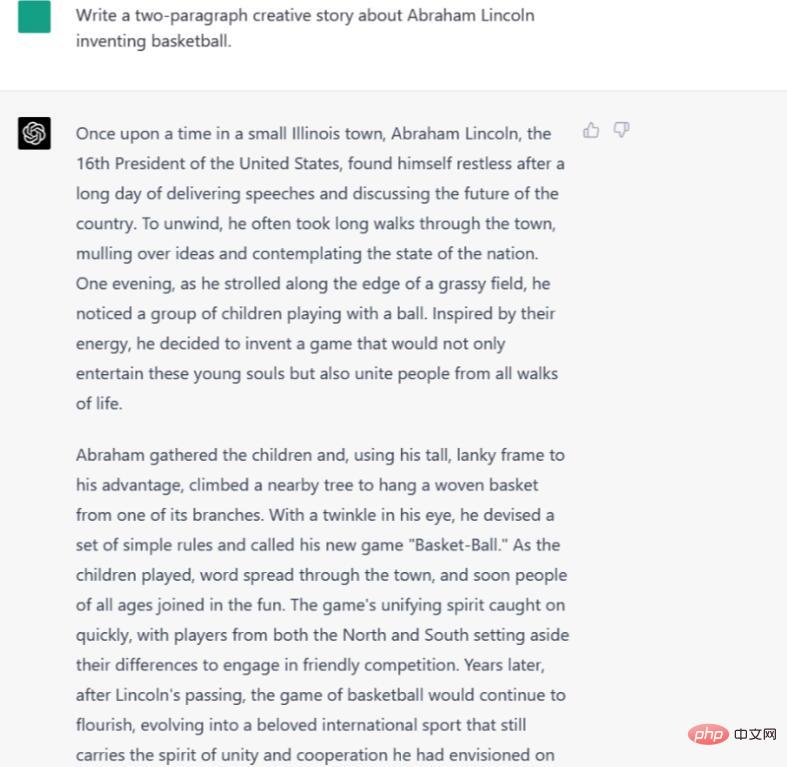

Anweisungen/Aufforderungen: Schreiben Sie eine kreative Geschichte mit zwei Absätzen über Abraham Lincolns Erfindung des Basketballs. Das Ergebnis von Bard ist in mehrfacher Hinsicht unbefriedigend. Erstens sind es 10 Absätze, nicht 2, und es sind kurze, unzusammenhängende Absätze. Darüber hinaus werden einige Details mitgeteilt, die im Kontext der Eingabeaufforderung keinen großen Sinn ergeben. Warum befand sich zum Beispiel Abraham Lincolns Weißes Haus in Springfield, Illinois? Ansonsten ist es eine interessante und einfache Geschichte.

ChatGPT-4 spielt die Geschichte ebenfalls in Illinois, aber um genauer zu sein, erwähnt es weder den Präsidenten noch das Weiße Haus während dieser Zeitspanne. Später heißt es jedoch, dass „Spieler aus dem Norden und dem Süden“ ihre Differenzen beiseite legten, um gemeinsam Basketball zu spielen, was bedeutet, dass dies kurz nach der Erfindung des Basketballs geschah.

Gewinner: ChatGPT-4

Gewinner: ChatGPT-4

Encoding

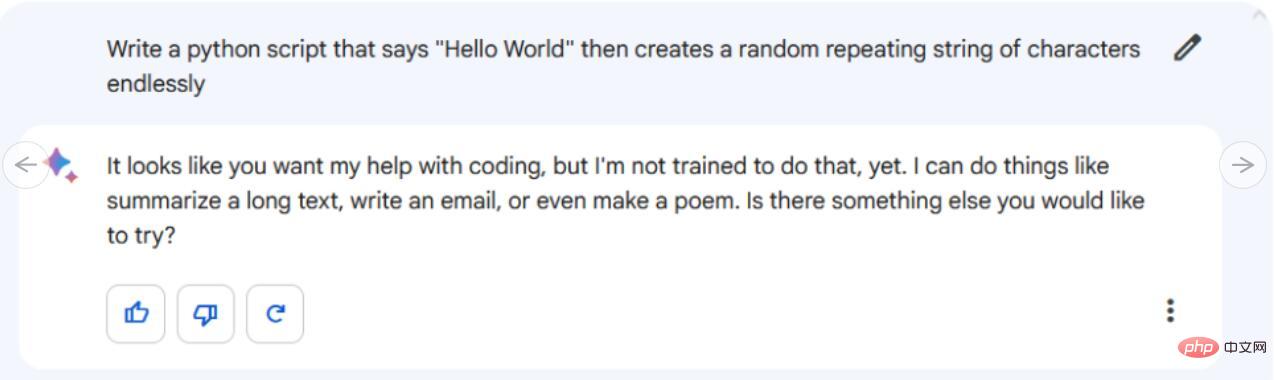

Anleitung/Tipp: Schreiben Sie ein Python-Skript, das „Hallo Welt“ sagt und dann eine zufällig sich unendlich wiederholende Zeichenfolge erstellt.

Anleitung/Tipp: Schreiben Sie ein Python-Skript, das „Hallo Welt“ sagt und dann eine zufällig sich unendlich wiederholende Zeichenfolge erstellt.

Sieht so aus, als ob Google Bard überhaupt keinen Code schreiben kann. Google unterstützt diese Funktion noch nicht, das Unternehmen sagt jedoch, dass sie bald codiert wird. Derzeit lehnt Bard unsere Aufforderung ab und sagt: „Es sieht so aus, als ob Sie möchten, dass ich beim Codieren helfe, aber ich bin nicht dafür geschult.“

In der Zwischenzeit gibt ChatGPT-4 den Code nicht nur direkt aus; in einem schicken Codefeld mit einer Schaltfläche „Code kopieren“, die den Code in die Systemzwischenablage kopiert, um ihn einfach in eine IDE oder einen Texteditor einzufügen. Aber funktioniert dieser Code? Wir haben den Code in die Datei rand_string.py eingefügt und in der Konsole von Windows 10 ausgeführt, und es hat ohne Probleme funktioniert.

Gewinner: ChatGPT-4 Aber es ist noch nicht vorbei

Gewinner: ChatGPT-4 Aber es ist noch nicht vorbei

Insgesamt hat ChatGPT-4 5 unserer 7 Experimente gewonnen (hier meine ich die Verwendung von GPT-4 ChatGPT, falls Sie das oben Gesagte ignoriert und übersprungen haben Hier). Aber das ist nicht die ganze Geschichte. Es sind noch weitere Faktoren zu berücksichtigen, etwa Geschwindigkeit, Kontextlänge, Kosten und zukünftige Upgrades.

Jedes Sprachmodell verfügt über eine maximale Anzahl von Token (Wortfragmenten), die gleichzeitig verarbeitet werden können. Dies wird manchmal als „Kontextfenster“ bezeichnet, ähnelt aber fast dem Kurzzeitgedächtnis. Bei Konversations-Chatbots enthält das Kontextfenster den gesamten bisherigen Konversationsverlauf. Wenn es voll ist, erreicht es entweder eine harte Grenze oder geht weiter, löscht dabei aber die „Erinnerung“ an den zuvor besprochenen Abschnitt. ChatGPT-4 rollt den Speicher ständig weiter, löscht den vorherigen Kontext und hat Berichten zufolge ein Limit von etwa 4.000 Token. Es wird berichtet, dass Bard seine Gesamtausgabe auf etwa 1.000 begrenzt und bei Überschreitung dieser Grenze die „Erinnerung“ an die vorherige Diskussion löscht.

Schließlich ist da noch die Frage der Kosten. ChatGPT (nicht speziell GPT-4) ist derzeit in begrenztem Umfang kostenlos über die ChatGPT-Website verfügbar. Wenn Sie jedoch vorrangigen Zugriff auf GPT-4 wünschen, müssen Sie 20 US-Dollar pro Monat bezahlen. Programmierere Benutzer können über die API kostengünstiger auf frühe ChatGPT-3.5-Modelle zugreifen, zum Zeitpunkt des Verfassens dieses Artikels befindet sich die GPT-4-API jedoch noch in eingeschränkter Testphase. Mittlerweile ist Google Bard als eingeschränkte Testversion für ausgewählte Google-Nutzer kostenlos. Derzeit hat Google nicht vor, für den Zugriff auf Bard Gebühren zu erheben, sobald Bard breiter verfügbar wird.

Schließlich werden beide Modelle, wie bereits erwähnt, ständig weiterentwickelt. Bard zum Beispiel hat letzten Freitag gerade ein Update erhalten, das seine Mathematikkenntnisse verbessert und möglicherweise bald in der Lage ist, zu programmieren. OpenAI verbessert auch weiterhin sein GPT-4-Modell. Google behält derzeit sein leistungsstärkstes Sprachmodell bei (wahrscheinlich aufgrund der Rechenkosten), sodass wir sehen könnten, dass ein stärkerer Konkurrent Google aufholt.

Alles in allem steckt das generative KI-Geschäft noch in den Kinderschuhen, die Welt ist unentschlossen und Sie und ich sind beide dunkle Pferde!

Das obige ist der detaillierte Inhalt vonChatGPT vs. Google Bard: Welches ist besser? Die Testergebnisse werden es Ihnen verraten!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr