Heim >Technologie-Peripheriegeräte >KI >Optimierung von Machine-Learning-Bereitstellungen: Tipps und Tricks

Optimierung von Machine-Learning-Bereitstellungen: Tipps und Tricks

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-04 12:35:011237Durchsuche

Machine-Learning-Modelle sind nur dann effektiv, wenn sie in einer Produktionsumgebung eingesetzt werden. Hier wird der Einsatz von Machine-Learning unverzichtbar.

Maschinelles Lernen ist zu einem integralen Bestandteil vieler Branchen geworden, vom Gesundheitswesen bis zum Finanzwesen und mehr. Es gibt uns die Werkzeuge an die Hand, die wir brauchen, um aussagekräftige Erkenntnisse zu gewinnen und bessere Entscheidungen zu treffen. Allerdings sind selbst die genauesten und am besten trainierten Modelle für maschinelles Lernen nutzlos, wenn sie nicht in einer Produktionsumgebung eingesetzt werden. Hier kommt die Bereitstellung von Modellen für maschinelles Lernen ins Spiel.

Die Bereitstellung von Modellen für maschinelles Lernen kann selbst für erfahrene Ingenieure eine entmutigende Aufgabe sein. Von der Auswahl der richtigen Bereitstellungsplattform bis hin zur Sicherstellung, dass Ihr Modell für die Produktion optimiert ist, müssen viele Herausforderungen bewältigt werden. Aber keine Angst: In diesem Artikel lernen Sie fortgeschrittene Tipps und Techniken kennen, die Ihnen helfen, den Bereitstellungsprozess Ihres Machine-Learning-Modells zu optimieren und häufige Fallstricke zu vermeiden.

Wählen Sie die richtige Bereitstellungsplattform

Wenn es um die Bereitstellung von Modellen für maschinelles Lernen geht, stehen viele verschiedene Plattformen zur Auswahl. Die richtige Plattform für Ihr Projekt hängt von einer Vielzahl von Faktoren ab, darunter Ihrem Budget, der Größe und Komplexität Ihres Modells sowie den spezifischen Anforderungen Ihrer Bereitstellungsumgebung.

Einige beliebte Bereitstellungsplattformen sind Amazon Web Services (AWS), Microsoft Azure und Google Cloud Platform (GCP). Jede dieser Plattformen bietet eine breite Palette von Tools und Diensten, die Sie bei der Bereitstellung und Verwaltung Ihrer Modelle für maschinelles Lernen unterstützen.

Ein wichtiger Gesichtspunkt bei der Auswahl einer Bereitstellungsplattform ist der Grad der Kontrolle, den Sie über Ihre Bereitstellungsumgebung haben. Einige Plattformen, wie z. B. AWS, ermöglichen Ihnen eine umfassende Anpassung Ihrer Umgebung, während andere möglicherweise restriktiver sind.

Ein weiterer Gesichtspunkt sind die Bereitstellungskosten. Einige Plattformen bieten Pay-as-you-go-Preismodelle an, während andere ein monatliches Abonnement oder eine Vorauszahlung erfordern.

Insgesamt ist es wichtig, eine Bereitstellungsplattform zu wählen, die Ihren spezifischen Anforderungen und Ihrem Budget entspricht. Scheuen Sie sich nicht, verschiedene Plattformen auszuprobieren, um diejenige zu finden, die für Sie am besten geeignet ist.

Modellleistung für die Bereitstellung optimieren

Nach der Auswahl einer Bereitstellungsplattform besteht der nächste Schritt darin, das Produktionsmodell zu optimieren. Dies umfasst mehrere wichtige Schritte, darunter:

Modellkomplexität reduzieren: Komplexe Modelle können beim Training gut funktionieren, die Bereitstellung kann jedoch langsam und ressourcenintensiv sein. Durch die Vereinfachung der Modellarchitektur und die Reduzierung der Parameteranzahl können Sie die Leistung verbessern und die Bereitstellungszeit verkürzen.

Datenkonsistenz sicherstellen: Damit Ihr Modell in einer Produktionsumgebung konsistent funktioniert, ist es wichtig sicherzustellen, dass die Eingabedaten konsistent und von hoher Qualität sind. Dies kann eine Vorverarbeitung Ihrer Daten umfassen, um Ausreißer zu entfernen oder fehlende Werte zu verarbeiten.

Hyperparameter optimieren: Hyperparameter sind Einstellungen, die das Verhalten eines maschinellen Lernmodells steuern. Durch Anpassen dieser Bereitstellungsparameter können Sie die Modellleistung verbessern und die Bereitstellungszeit verkürzen.

Testen und validieren: Vor der Bereitstellung eines Modells ist es wichtig, seine Leistung in einer produktionsähnlichen Umgebung zu testen und zu validieren. Dies kann Ihnen helfen, Probleme zu erkennen und zu lösen, bevor sie zu Produktionsproblemen führen.

Durch Befolgen dieser Schritte stellen Sie sicher, dass Ihr maschinelles Lernmodell für die Produktion optimiert ist und in Ihrer Bereitstellungsumgebung eine konsistente Leistung erbringt.

Bereitstellungsstrategien und Best Practices

Nach der Optimierung Ihres Bereitstellungsmodells ist es an der Zeit, die Bereitstellungsstrategie auszuwählen, die am besten zu Ihrem Anwendungsfall passt. Zu den gängigen Bereitstellungsstrategien gehören:

API-basierte Bereitstellung: Bei dieser Strategie wird Ihr Modell für maschinelles Lernen als Webdienst bereitgestellt, auf den über API zugegriffen werden kann. Dieser Ansatz wird typischerweise in Anwendungen verwendet, die Echtzeitvorhersagen erfordern.

Containerbasierte Bereitstellung: Bei der Containerisierung geht es darum, Ihr maschinelles Lernmodell und seine Abhängigkeiten in einen leichten Container zu packen, der problemlos in jeder Umgebung bereitgestellt werden kann. Dieser Ansatz wird typischerweise für umfangreiche Bereitstellungen oder Anwendungen verwendet, die lokal ausgeführt werden müssen.

Serverlose Bereitstellung: Bei einer serverlosen Bereitstellung wird Ihr Modell für maschinelles Lernen auf einer serverlosen Plattform wie AWS Lambda oder Google Cloud Functions bereitgestellt. Für Anwendungen mit variablen Anforderungen kann dieser Ansatz eine kostengünstige und skalierbare Option sein.

Best Practices für die Modellbereitstellung

Egal für welche Bereitstellungsstrategie Sie sich entscheiden, es gibt einige Best Practices, die Sie befolgen sollten, um einen reibungslosen Bereitstellungsprozess zu gewährleisten:

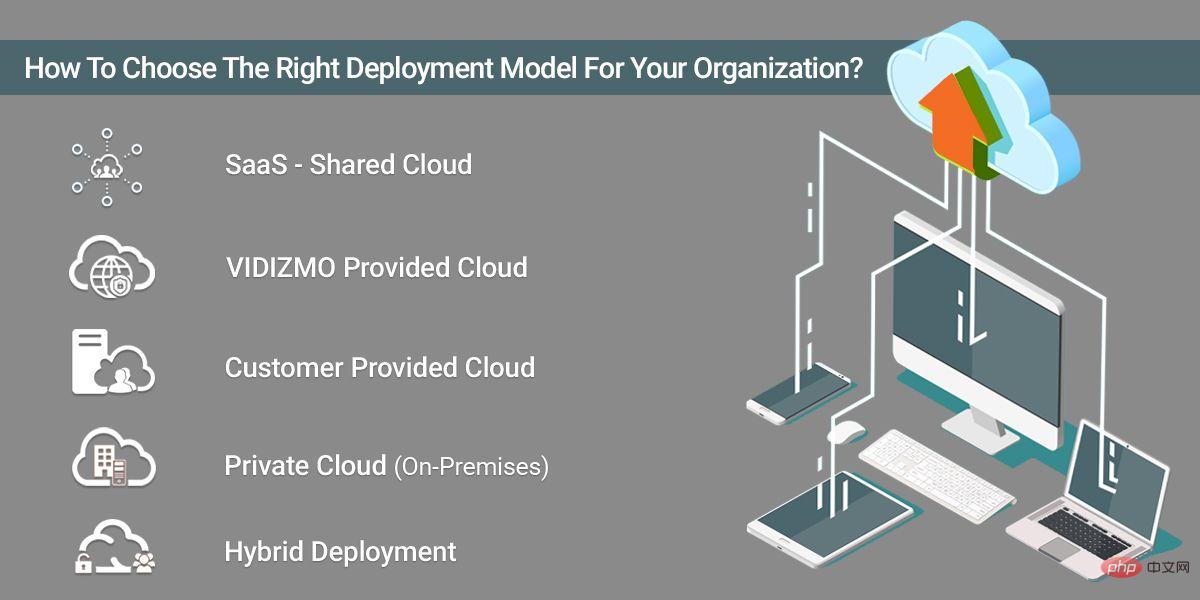

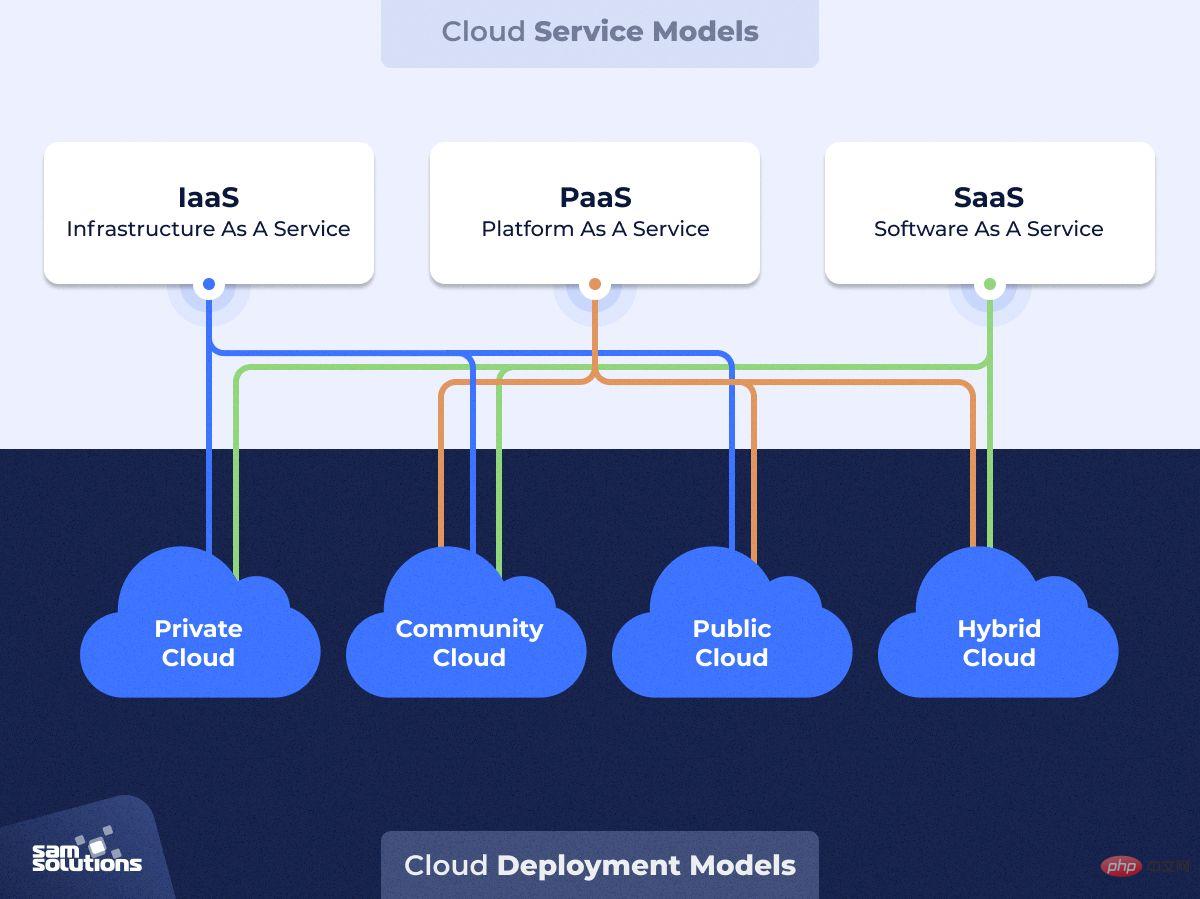

Wählen Sie die richtige Bereitstellungsmethode: Es stehen mehrere Bereitstellungsmethoden zur Verfügung, darunter Cloudbasierte Lösungen wie Amazon SageMaker und Microsoft Azure, Container-basierte Lösungen wie Docker und Kubernetes sowie lokale Lösungen. Wählen Sie die Bereitstellungsmethode, die den Anforderungen Ihres Unternehmens am besten entspricht.

Containerisieren Sie Ihr Modell: Durch die Containerisierung können Sie Ihr Modell und alle seine Abhängigkeiten in einen Container packen, der einfach bereitgestellt und skaliert werden kann. Dies vereinfacht den Bereitstellungsprozess und gewährleistet die Konsistenz über verschiedene Umgebungen hinweg.

Verwenden Sie die Versionskontrolle: Die Versionskontrolle ist wichtig, um Codeänderungen zu verfolgen und sicherzustellen, dass Sie bei Bedarf auf eine frühere Version zurückgreifen können. Verwenden Sie ein Versionskontrollsystem wie Git, um Änderungen an Ihrem Code und Ihren Modellen zu verfolgen.

Automatisierte Bereitstellung: Durch die Automatisierung des Bereitstellungsprozesses können Sie Fehler reduzieren und die Konsistenz in verschiedenen Umgebungen sicherstellen. Verwenden Sie Tools wie Jenkins oder CircleCI, um den Bereitstellungsprozess zu automatisieren.

Implementieren Sie Sicherheitsmaßnahmen: Modelle für maschinelles Lernen sind anfällig für Angriffe. Daher ist es wichtig, Sicherheitsmaßnahmen wie Authentifizierung und Verschlüsselung zu implementieren, um Ihr Modell und Ihre Daten zu schützen.

Überwachen Sie die Leistung kontinuierlich: Sie wissen bereits, dass die Modellüberwachung für die Identifizierung und Lösung von Leistungsproblemen von entscheidender Bedeutung ist. Überwachen Sie kontinuierlich die Leistung des Modells und nehmen Sie bei Bedarf Änderungen vor, um seine Genauigkeit und Zuverlässigkeit zu verbessern.

Durch die Befolgung dieser Best Practices stellen Sie sicher, dass Ihre Machine-Learning-Modelle effektiv und effizient eingesetzt werden und in Produktionsumgebungen weiterhin optimal laufen.

Was ist Modellüberwachung?

Bei der Modellüberwachung geht es um die Verfolgung und Analyse der Leistung von Modellen für maschinelles Lernen in einer Produktionsumgebung. Auf diese Weise können Sie Probleme mit Ihrem Modell identifizieren und diagnostizieren, z. B. verringerte Genauigkeit oder Änderungen in der Datenverteilung.

Bei der Bereitstellung eines Modells für maschinelles Lernen sollten Sie mehrere Schlüsselmetriken überwachen, darunter:

Vorhersagegenauigkeit: Dies misst, wie genau Ihr Modell die Zielvariable in Ihrem Datensatz vorhersagt.

Präzision und Rückruf: Diese Metriken werden üblicherweise zur Bewertung binärer Klassifizierungsmodelle und zur Messung des Kompromisses zwischen der korrekten Identifizierung positiver Beispiele (Präzision) und der korrekten Identifizierung aller positiven Beispiele (Rückruf) verwendet.

F1-Score: Der F1-Score ist eine Metrik, die Präzision und Erinnerung kombiniert, um ein Gesamtmaß für die Modellleistung zu liefern.

Datendrift: Datendrift tritt auf, wenn sich die Verteilung der Eingabedaten im Laufe der Zeit ändert, was sich negativ auf die Modellleistung auswirken kann.

Latenz und Durchsatz: Diese Metriken messen, wie schnell Ihr Modell Eingabedaten verarbeitet und Vorhersagen generiert.

Durch die Überwachung dieser Metriken können Sie Leistungsprobleme frühzeitig erkennen und Maßnahmen ergreifen, um die Leistung Ihres Modells im Laufe der Zeit zu verbessern. Dies kann eine Neuschulung Ihres Modells auf der Grundlage aktualisierter Daten, eine Änderung Ihrer Modellarchitektur oder eine Feinabstimmung Ihrer Hyperparameter umfassen. Für die Modellüberwachung stehen verschiedene Tools und Plattformen zur Verfügung, darunter Open-Source-Bibliotheken wie TensorFlow Model Analysis und kommerzielle Plattformen wie Seldon und Algorithmia. Durch den Einsatz dieser Tools können Sie den Modellüberwachungsprozess automatisieren und sicherstellen, dass Ihre Machine-Learning-Modelle in der Produktion optimal laufen. FazitDie Bereitstellung von Modellen für maschinelles Lernen ist eine Schlüsselkomponente des Entwicklungsprozesses für maschinelles Lernen. Es ist wichtig sicherzustellen, dass Ihre Modelle effektiv und effizient bereitgestellt werden und in Produktionsumgebungen weiterhin optimal laufen. In diesem Artikel haben Sie die Grundlagen der Modellbereitstellung für maschinelles Lernen kennengelernt, einschließlich der verschiedenen verfügbaren Bereitstellungsmethoden, der Bedeutung der Modellüberwachung und Best Practices für die Modellbereitstellung. Dieser Artikel vermittelt Ihnen außerdem ein gutes Verständnis der Schlüsselkonzepte bei der Bereitstellung von Modellen für maschinelles Lernen und gibt Ihnen einige nützliche Tipps, um sicherzustellen, dass Ihre Modelle effektiv bereitgestellt werden. Denken Sie daran, dass eine effektive Bereitstellung von Modellen für maschinelles Lernen eine Kombination aus technischen Fähigkeiten, Best Practices und einem Verständnis des Geschäftskontexts erfordert, in dem das Modell bereitgestellt wird. Indem Sie die in diesem Artikel beschriebenen Best Practices befolgen und die Leistung Ihres Modells kontinuierlich überwachen, können Sie sicherstellen, dass Ihre Modelle für maschinelles Lernen einen positiven Einfluss auf die Ziele Ihres Unternehmens haben.Das obige ist der detaillierte Inhalt vonOptimierung von Machine-Learning-Bereitstellungen: Tipps und Tricks. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr