Heim >Technologie-Peripheriegeräte >KI >Das erste ultragroße GAN-Modell! Die Generierungsgeschwindigkeit ist mehr als 20-mal schneller als bei Diffusion und das Bild wird in 0,13 Sekunden erstellt. Es werden bis zu 16 Millionen Pixel unterstützt.

Das erste ultragroße GAN-Modell! Die Generierungsgeschwindigkeit ist mehr als 20-mal schneller als bei Diffusion und das Bild wird in 0,13 Sekunden erstellt. Es werden bis zu 16 Millionen Pixel unterstützt.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-04 11:50:071424Durchsuche

Mit der Veröffentlichung von DALL-E 2 durch OpenAI sind autoregressive und Diffusionsmodelle über Nacht zum neuen Standard für groß angelegte generative Modelle geworden. Davor waren Generative Adversarial Networks (GAN) immer die gängige Wahl und abgeleitete Technologien wie StyleGAN . .

Hinter der Popularität von AIGC stand aus technischer Sicht eine große Veränderung in der Architektur des Bilderzeugungsmodells.

Mit der Veröffentlichung von DALL-E 2 durch OpenAI sind autoregressive und Diffusionsmodelle über Nacht zum neuen Standard für groß angelegte generative Modelle geworden. Davor waren Generative Adversarial Networks (GAN) immer die gängige Wahl und abgeleitete StyleGAN und andere Technologien.

Der architektonische Wandel vom GAN- zum Diffusionsmodell wirft auch eine Frage auf: Kann die Leistung durch eine Vergrößerung des GAN-Modells beispielsweise in einem großen Datensatz wie LAION weiter verbessert werden?

Als Reaktion auf das Instabilitätsproblem, das durch die Erhöhung der Kapazität der StyleGAN-Architektur verursacht wurde, haben Forscher der Pohang University of Science and Technology (Südkorea), der Carnegie Mellon University und dem Adobe Research Institute kürzlich eine neue generative kontradiktorische Netzwerkarchitektur GigaGAN vorgeschlagen durchbricht die Skalierungsgrenze des Modells und zeigt, dass GAN weiterhin als Text-zu-Bild-Synthesemodell geeignet sein kann.

Papierlink: https://arxiv.org/abs/2303.05511

Projektlink: https://mingukkang.github.io/GigaGAN/

GigaGAN hat drei große Vorteile.

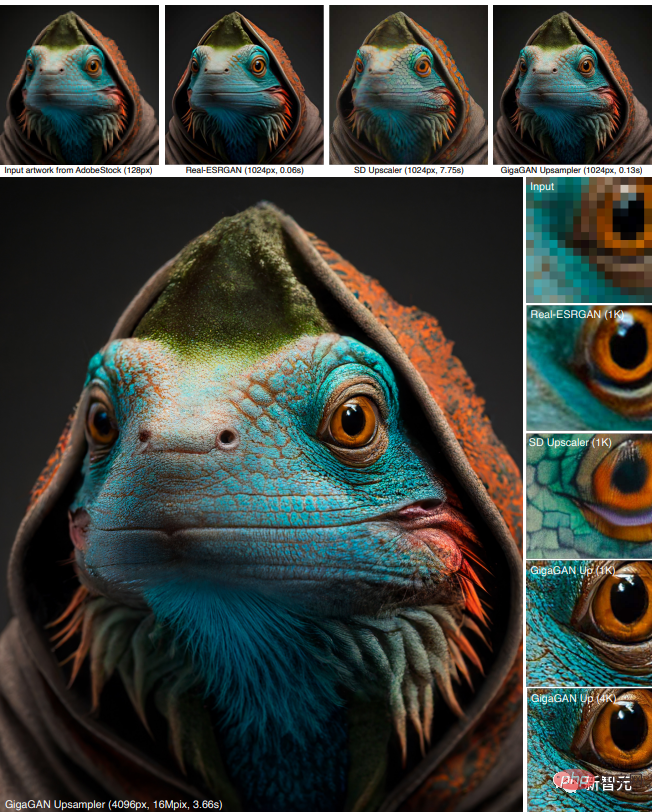

1. Im Vergleich zu Stable Diffusion-v1.5 mit der gleichen Parameterstufe ist die Generierungsgeschwindigkeit bei 512 Sekunden von 2,9 Sekunden auf 0,13 Sekunden verkürzt.

2. Kann hochauflösende Bilder synthetisieren, beispielsweise ein 16-Megapixel-Bild in 3,66 Sekunden.

3 Unterstützt verschiedene Anwendungen zur Bearbeitung latenter Räume, wie z. B. latente Interpolation, Stilmischung und Vektorarithmetikoperationen.

Eine Reihe kürzlich veröffentlichter Modelle wie DALL-E 2, Imagen, Parti und Stable Diffusion läuten eine neue Ära der Bilderzeugung ein und erreichen ein beispielloses Maß an Bildqualität und Modellflexibilität.

Die derzeit vorherrschenden Paradigmen „Diffusionsmodell“ und „autoregressives Modell“ basieren beide auf dem zweischneidigen Schwert des iterativen Denkens, da die iterative Methode ein stabiles Training mit einfachen Zielen durchführen kann, während des Inferenzprozesses jedoch Fehler erzeugt Rechenaufwand.

Im Gegensatz dazu benötigen Generative Adversarial Networks (GAN) nur einen Vorwärtsdurchlauf, um Bilder zu generieren, sodass sie von Natur aus effizienter sind.

Obwohl GAN-Modelle die „vorherige Ära“ der generativen Modellierung dominierten, erfordert die Erweiterung von GAN aufgrund der Instabilität im Trainingsprozess eine sorgfältige Anpassung der Netzwerkstruktur und Trainingsüberlegungen. Daher werden GANs zwar für Einzel- oder Einzelmodelle verwendet Die Modellierung mehrerer Objektklassen, aber die Skalierung auf komplexe Datensätze (ganz zu schweigen von der Generierung von Open-World-Objekten) bleibt eine Herausforderung.

Daher konzentrieren sich derzeit sehr große Modelle, Daten und Rechenressourcen hauptsächlich auf Diffusions- und autoregressive Modelle.

In dieser Arbeit beschäftigen sich die Forscher hauptsächlich mit den folgenden Fragen:

Kann GAN weiterhin skalieren und möglicherweise von diesen Ressourcen profitieren? Oder stößt GAN bereits an seine Grenzen? Was behindert den weiteren Ausbau von GANs? Können diese Hindernisse überwunden werden?

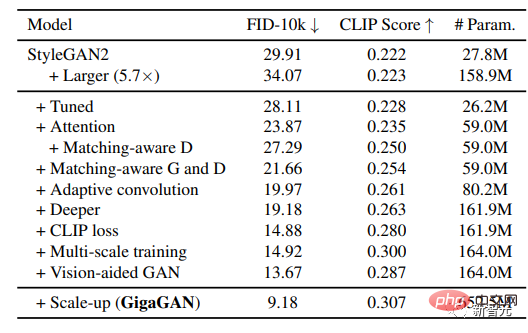

Die Forscher führten zunächst Experimente mit StyleGAN2 durch und stellten fest, dass eine einfache Erweiterung des Backbone-Netzwerks zu instabilem Training führen würde. Nachdem sie mehrere Schlüsselprobleme identifiziert hatten, schlugen sie vor, das Training zu stabilisieren und gleichzeitig die Modellkapazität zu erhöhen.

Erweitern Sie zunächst effektiv die Kapazität des Generators, indem Sie eine Reihe von Filtern beibehalten und eine lineare Kombination spezifischer Proben entnehmen.

Mehrere Techniken, die üblicherweise im Kontext von Diffusionsmodellen verwendet werden, wurden angepasst und bestätigt, dass sie ähnliche Leistungsverbesserungen für GANs bewirken können, wie z. B. die Kombination von Selbstaufmerksamkeitsmechanismus (nur Bild) und Kreuzaufmerksamkeitsmechanismus (Bild-Text) mit Faltung Schichten verbessern die Leistung.

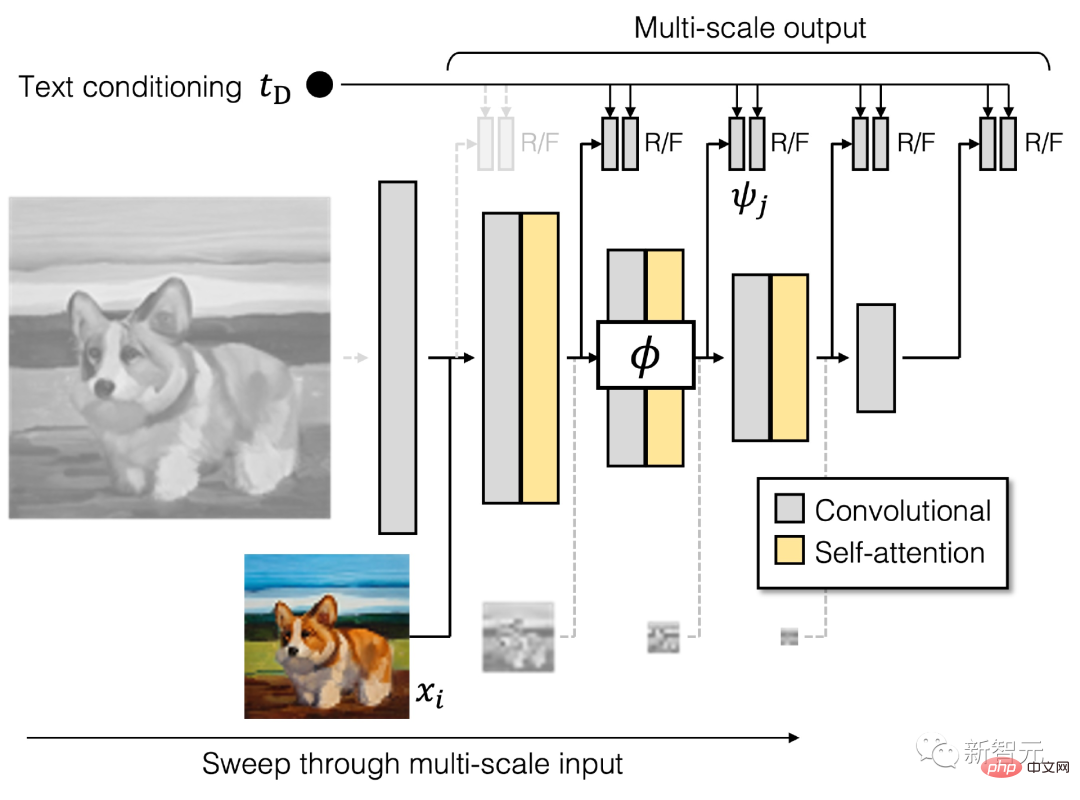

Darüber hinaus führten die Forscher das Multiskalentraining wieder ein und fanden ein neues Schema, das die Bild-Text-Ausrichtung verbessern und niederfrequente Details in der Ausgabe erzeugen kann.

Multiskalentraining ermöglicht es GAN-basierten Generatoren, Parameter in Blöcken mit niedriger Auflösung effizienter zu nutzen, was zu einer besseren Bild-Text-Ausrichtung und Bildqualität führt.

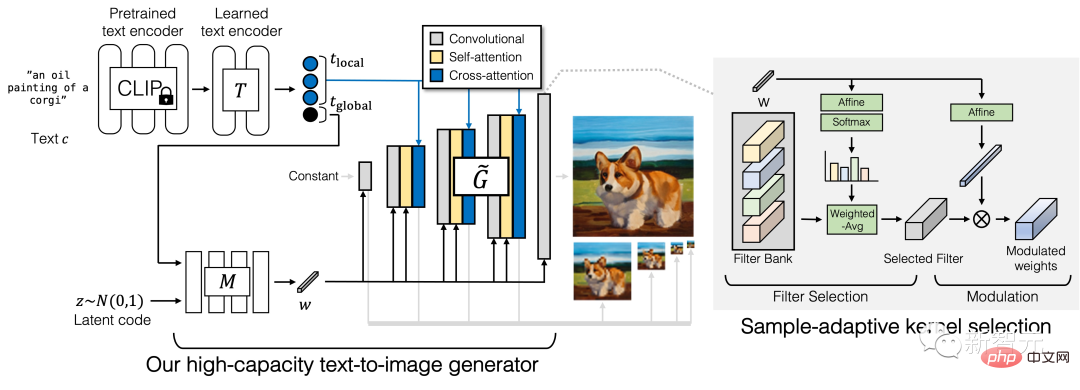

Generator

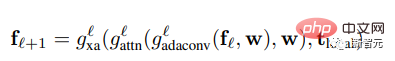

Der Generator von GigaGAN besteht aus einem Textkodierungszweig, einem Stilzuordnungsnetzwerk und einem Multiskalensynthesenetzwerk, ergänzt durch stabile Aufmerksamkeit und adaptive Kernelauswahl.

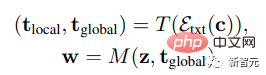

Im Textkodierungszweig werden zunächst ein vorab trainiertes CLIP-Modell und eine erlernte Aufmerksamkeitsschicht T verwendet, um Texteinbettungen zu extrahieren, und dann wird der Einbettungsprozess an das Stilzuordnungsnetzwerk M übergeben, um einen ähnlichen Stilvektor w zu generieren zu StyleGAN

Das Synthesenetzwerk verwendet Stilkodierung als Modulation und Texteinbettung als Aufmerksamkeit, um eine Bildpyramide zu generieren. Auf dieser Grundlage wird ein Beispielalgorithmus für die adaptive Kernelauswahl eingeführt, um eine Faltung basierend auf Eingabetextbedingungen zu implementieren. Adaptive Kernelauswahl.

Diskriminator

Ähnlich wie der Generator besteht der Diskriminator von GigaGAN aus zwei Zweigen, die zur Verarbeitung von Bild- bzw. Textbedingungen verwendet werden.

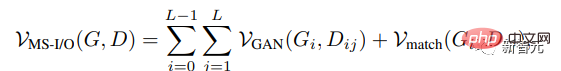

Der Textzweig verarbeitet den Textzweig ähnlich wie der Generator; der Bildzweig erhält eine Bildpyramide als Eingabe und trifft unabhängige Vorhersagen für jeden Bildmaßstab.

In die Formel werden mehrere zusätzliche Verlustfunktionen eingeführt, um eine schnelle Konvergenz zu fördern.

Die Durchführung einer systematischen, kontrollierten Bewertung umfangreicher Text-Bild-Syntheseaufgaben ist schwierig, da die meisten vorhandenen Modelle nicht öffentlich verfügbar sind und selbst wenn der Trainingscode verfügbar ist, das Training eines neuen Modells von Grund auf erforderlich ist Auch die Kosten des Modells wären unerschwinglich.

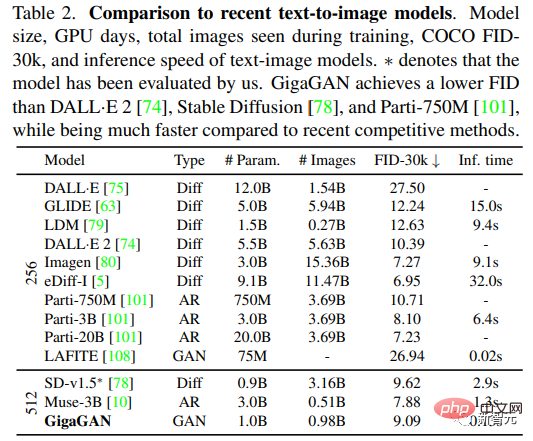

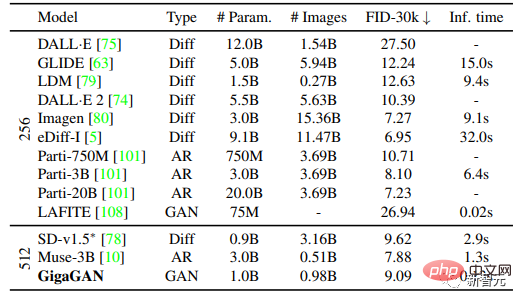

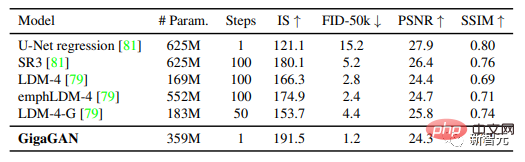

Die Forscher entschieden sich für den Vergleich in ihren Experimenten mit Imagen, Latent Diffusion Models (LDM), Stable Diffusion und Parti, räumten jedoch ein, dass es erhebliche Unterschiede bei Trainingsdatensätzen, Anzahl der Iterationen, Batchgrößen und Modellgrößen gibt.

Für quantitative Bewertungsindikatoren wird die Frechet Inception Distance (FID) hauptsächlich zur Messung der Authentizität der Ausgabeverteilung verwendet, und der CLIP-Score wird zur Bewertung der Bild-Text-Ausrichtung verwendet.

Fünf verschiedene Experimente wurden in der Arbeit durchgeführt:

1 Um die Wirksamkeit der vorgeschlagenen Methode durch schrittweise Einbeziehung jeder technischen Komponente zu demonstrieren;

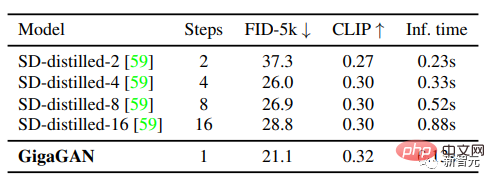

2 Zeigen Sie, dass GigaGAN eine vergleichbare FID wie stabile Diffusion (SD-v1.5) aufweist und dabei hunderte Male schneller Ergebnisse liefert als Diffusions- oder autoregressive Modelle. 3. Vergleich von GigaGAN mit destillationsbasiertem Vergleich mit der Diffusion Das Modell zeigt, dass GigaGAN schneller Bilder mit höherer Qualität synthetisieren kann als das destillationsbasierte Diffusionsmodell.

4

5 Die Ergebnisse zeigen, dass große GANs immer noch die kontinuierlichen und zerlegten latenten Raumoperationen von GANs nutzen, was neue Bildbearbeitungsmodi ermöglicht.

Nach der Anpassung der Parameter haben Forscher ein stabiles und skalierbares Training eines Milliarden-Parameter-GAN (GigaGAN) auf großen Datensätzen wie LAION2B-en erreicht.

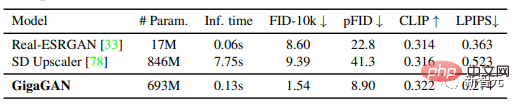

Und die Methode verfolgt einen mehrstufigen Ansatz, bei dem zunächst mit 64×64 generiert und dann auf 512×512 hochgesampelt wird. Diese beiden Netzwerke sind modular und leistungsstark genug, um Plug-and-Play-Nutzung zu ermöglichen .

Die Ergebnisse zeigen, dass das textkonditionierte GAN-Upsampling-Netzwerk als effizienter, hochwertiger Upsampler für grundlegende Diffusionsmodelle (wie DALL-E 2) dienen kann, obwohl während des Trainings nie Bilder des Diffusionsmodells gesehen werden.

Zusammengenommen machen diese Ergebnisse GigaGAN früheren GAN-Modellen weit überlegen, 36-mal größer als StyleGAN2 und 6-mal größer als StyleGAN-XL und XMC-GAN.

Obwohl das Parametervolumen von 1 Milliarde GiGAN immer noch geringer ist als das der größten kürzlich veröffentlichten synthetischen Modelle wie Imagen (3B), DALL-E 2 (5,5B) und Parti (20B), ist dies noch nicht der Fall Es wurde eine Sättigung der verfügbaren Masse in Bezug auf die Modellgröße beobachtet.

GigaGAN erreichte im COCO2014-Datensatz einen Zero-Shot-FID von 9,09, was niedriger ist als der FID von DALL-E 2, Parti-750M und Stable Diffusion

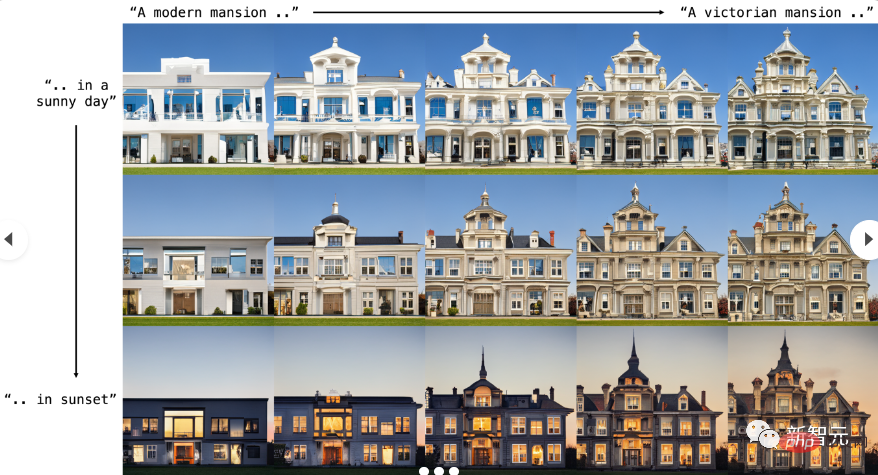

Prompte Interpolation

GigaGAN kann reibungslos zwischen Hinweisen interpolieren. Die vier Ecken im Bild unten werden durch denselben latenten Code generiert, jedoch mit unterschiedlichen Texthinweisen.

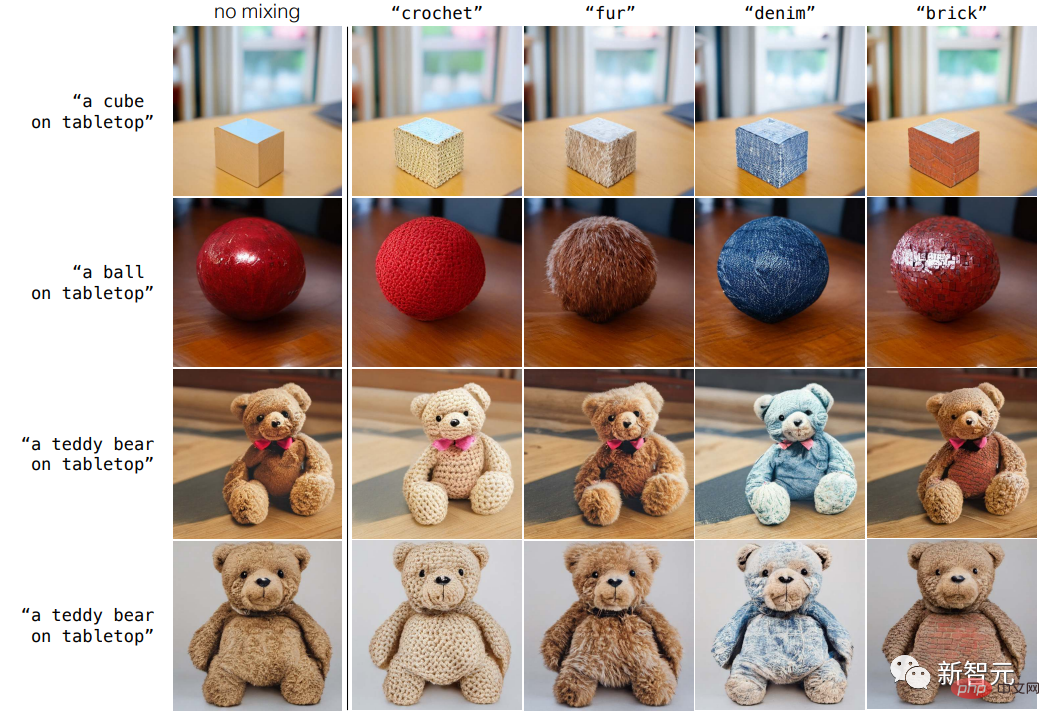

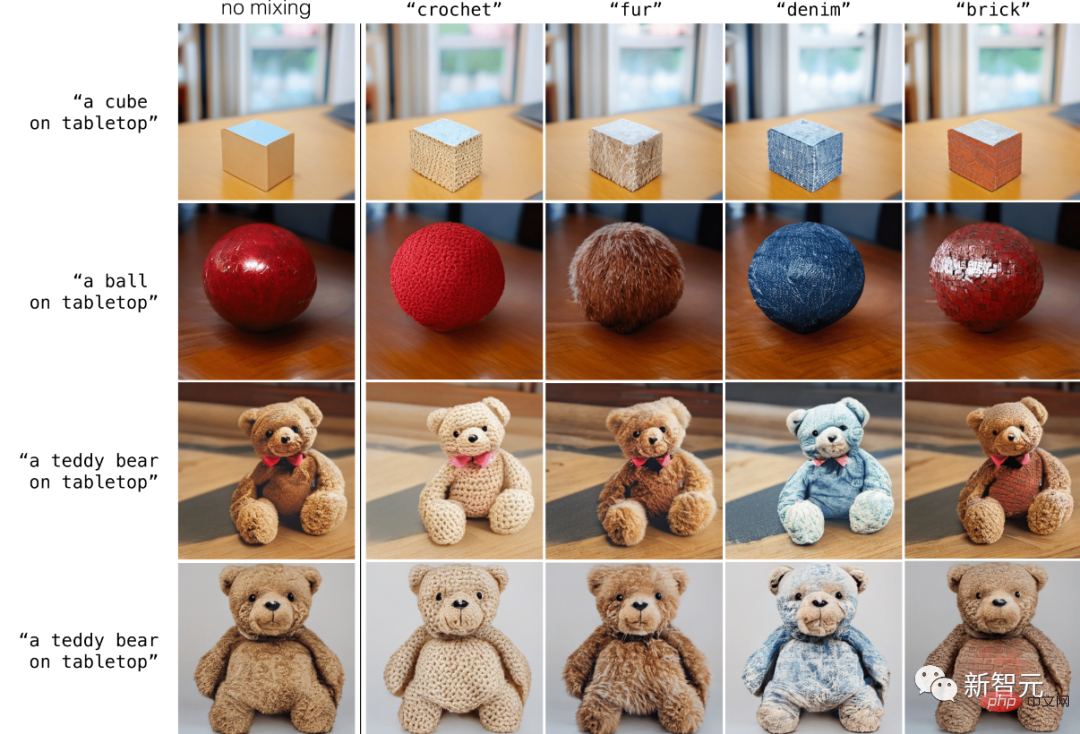

Entwirrtes Prompt-Mixing

GigaGAN bewahrt einen getrennten latenten Raum und ermöglicht so die Kopplung des groben Stils einer Probe mit dem feinen Stil einer anderen Probe, und GigaGAN kann Stile direkt über Textaufforderungen steuern .

Austausch von groben zu feinen Stilen

Die GAN-basierte Modellarchitektur behält einen separaten latenten Raum bei, sodass der grobe Stil einer Probe mit einer anderen verglichen werden kann. Eine Probe feiner Stile gemischt zusammen.

Referenz:

https://mingukkan.github.io/GigaGAN/

Das obige ist der detaillierte Inhalt vonDas erste ultragroße GAN-Modell! Die Generierungsgeschwindigkeit ist mehr als 20-mal schneller als bei Diffusion und das Bild wird in 0,13 Sekunden erstellt. Es werden bis zu 16 Millionen Pixel unterstützt.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr