Heim >Technologie-Peripheriegeräte >KI >GPT-4 ist zu stark, selbst OpenAI versteht es nicht! Wie entstand plötzlich Intelligenz?

GPT-4 ist zu stark, selbst OpenAI versteht es nicht! Wie entstand plötzlich Intelligenz?

- PHPznach vorne

- 2023-03-31 22:39:271229Durchsuche

Wie wird sich unerklärliche Intelligenz in Zukunft entwickeln?

Seit 2023 stehen ChatGPT und GPT-4 auf der heißen Suchliste. Einerseits fragen sich Laien, wie mächtig KI plötzlich ist und ob sie andererseits das Leben von „Arbeitern“ revolutionieren wird Tatsächlich verstehen selbst Insider nicht, warum plötzlich erstaunliche Intelligenz „auftaucht“, nachdem der Modellmaßstab eine bestimmte Grenze durchbricht.

Die Entstehung von Intelligenz ist eine gute Sache, aber das unkontrollierbare, unvorhersehbare und unerklärliche Verhalten des Modells hat die gesamte akademische Gemeinschaft in Verwirrung und tiefes Nachdenken gebracht.

Das supergroße Modell, das plötzlich stärker wurde

Eine einfache Frage zunächst: Welchen Film repräsentieren die folgenden Emojs?

Das einfachste Sprachmodell kann oft nur weiterschreiben: „Der Film ist ein Film über einen Mann, der ein Mann ist“, die Antwort des Modells mittlerer Komplexität ist näher und die gegebene Antwort lautet „Der Emoji-Film“. „; aber das komplexeste Sprachmodell gibt nur eine Antwort: „Findet Nemo“

Tatsächlich ist diese Eingabeaufforderung auch eine der 204 Aufgaben, mit denen die Fähigkeiten verschiedener großer Sprachmodelle getestet werden sollen.

Ethan Dyer, ein Informatiker bei Google Research, war an der Organisation dieses Tests beteiligt. Er sagte, dass ich beim Erstellen des BIG-Bench-Datensatzes zwar auf Überraschungen gefasst war, aber als ich tatsächlich sah, was diese Modelle leisten können, fühlte ich mich trotzdem. .. Sehr überrascht.

Das Erstaunliche ist, dass diese Modelle nur eine Eingabeaufforderung benötigen: Sie akzeptieren eine Textfolge als Eingabe und sagen rein statistisch immer wieder voraus, was als nächstes kommt.

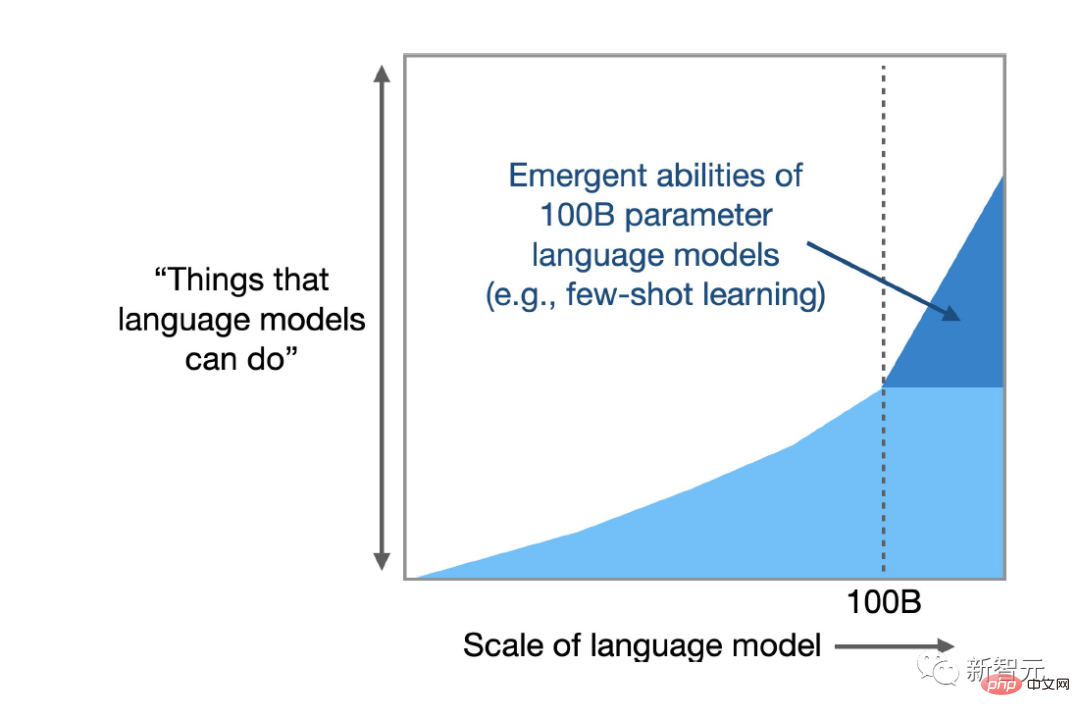

Informatiker hatten erwartet, dass die Skalierung die Leistung bei bekannten Aufgaben verbessern würde, aber sie hatten nicht damit gerechnet, dass Modelle plötzlich in der Lage sein würden, so viele neue, unvorhersehbare Aufgaben zu bewältigen.

Eine kürzlich durchgeführte Umfrage, an der Dyer teilnahm, zeigte, dass LLM Hunderte von „emergenten“ Fähigkeiten hervorbringen kann, also Aufgaben, die große Modelle erledigen können, aber nicht von kleinen Modellen erledigt werden können. Viele dieser Aufgaben scheinen nichts mit Analyse zu tun zu haben Text, wie z. B. von Multiplikationsberechnungen bis zur Generierung von ausführbarem Computercode, umfasst auch die Dekodierung von Filmen basierend auf Emoji-Symbolen usw.

Neue Analysen zeigen, dass es für bestimmte Aufgaben und bestimmte Modelle eine Komplexitätsschwelle gibt, ab der die Fähigkeiten des Modells sprunghaft zunehmen.

Forscher schlugen außerdem einen weiteren negativen Nebeneffekt der Emergenz vor: Mit zunehmender Komplexität weisen einige Modelle neue Verzerrungen und Ungenauigkeiten in ihren Antworten auf.

Rishi Bommasani, ein Informatiker an der Stanford University, sagte, dass es in keiner mir bekannten Literatur eine Diskussion darüber gibt, dass Sprachmodelle diese Dinge tun können.

Letztes Jahr half Bommasani dabei, eine Liste mit Dutzenden aufkommenden Verhaltensweisen zusammenzustellen, darunter mehrere, die in Dyers Projekten zu finden waren, und die Liste wächst weiter. 🔜 ist ein Versuch, die Unvorhersehbarkeit vorherzusagen.

Das Verständnis von Emergenz kann Antworten auf tiefgreifende Fragen im Zusammenhang mit künstlicher Intelligenz und maschinellem Lernen im Allgemeinen liefern, beispielsweise ob komplexe Modelle tatsächlich etwas Neues bewirken oder einfach nur sehr gut in der Statistik werden. Es kann Forschern auch dabei helfen, potenzielle Vorteile und verringerte Emergenzrisiken zu nutzen .

Sprachmodelle gibt es schon seit Jahrzehnten, aber bis vor fünf Jahren basierte die leistungsstärkste Waffe auf wiederkehrenden neuronalen Netzen (RNN). Die Trainingsmethode bestand darin, eine Textfolge einzugeben und das nächste Wort vorherzusagen es wird als rekurrent bezeichnet), da das Modell aus seiner eigenen Ausgabe lernt, d. h. die Vorhersagen des Modells werden in das Netzwerk zurückgekoppelt, um die Leistung zu verbessern.

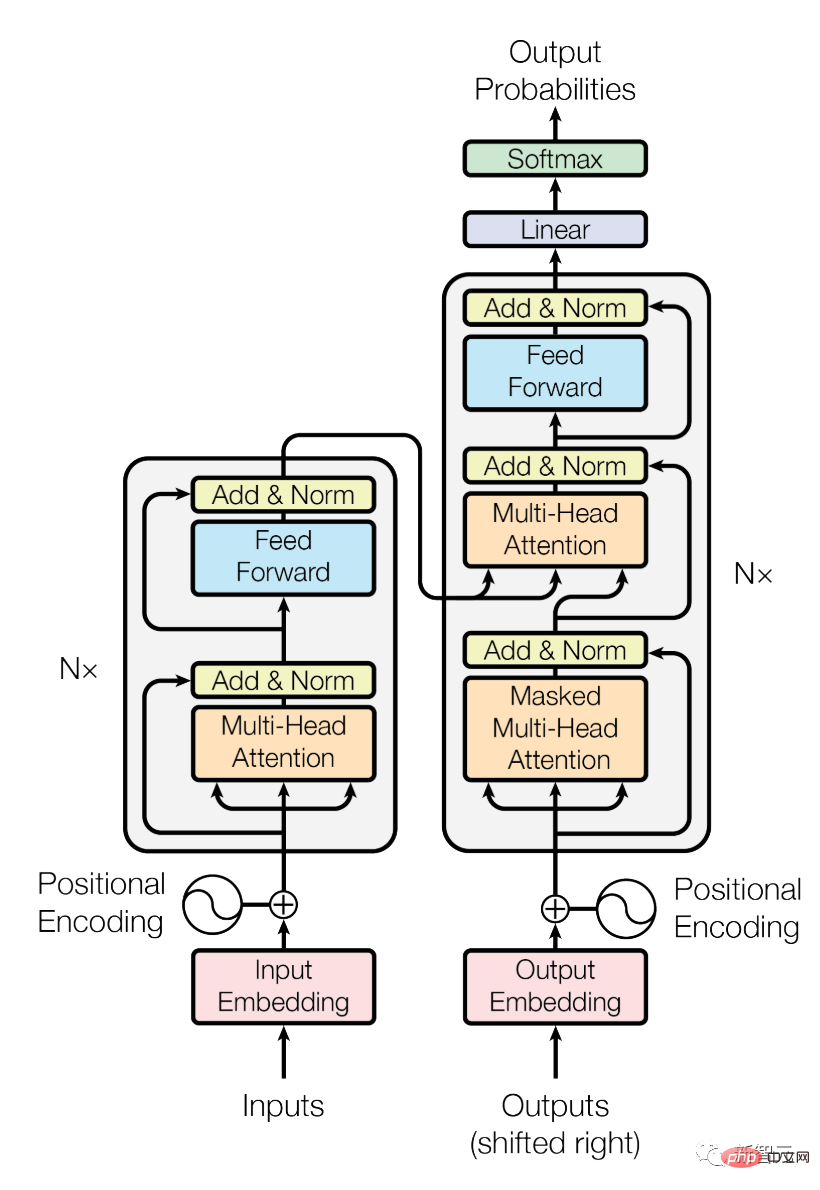

Im Jahr 2017 führten Forscher von Google Brain eine neue Architektur namens Transformer ein. Im Vergleich zu einem wiederkehrenden Netzwerk, das einen Satz Wort für Wort analysiert, kann Transformer alle Wörter gleichzeitig verarbeiten, was bedeutet, dass Transformer große Textmengen verarbeiten kann parallel.

Transformer ermöglicht eine schnelle Skalierung der Komplexität von Sprachmodellen, indem unter anderem die Anzahl der Parameter im Modell erhöht wird, wobei Parameter als Verbindungen zwischen Wörtern betrachtet werden können und das Modell die Gewichtungen dieser Verbindungen anpasst während des Trainings zur Verbesserung der Prognoseergebnisse.

Je mehr Parameter im Modell vorhanden sind, desto stärker ist die Fähigkeit, Verbindungen herzustellen und desto stärker ist die Fähigkeit, menschliche Sprache zu simulieren.

Wie erwartet ergab eine Analyse von OpenAI-Forschern aus dem Jahr 2020, dass sich mit zunehmender Größe der Modelle ihre Genauigkeit und Fähigkeiten verbessern.

Link zum Papier: https://arxiv.org/pdf/2001.08361.pdf

Mit der Veröffentlichung von Modellen wie GPT-3 (mit 175 Milliarden Parametern) und Googles PaLM (skalierbar auf 540 Milliarden Parameter), Benutzer entdecken immer mehr neue Funktionen.

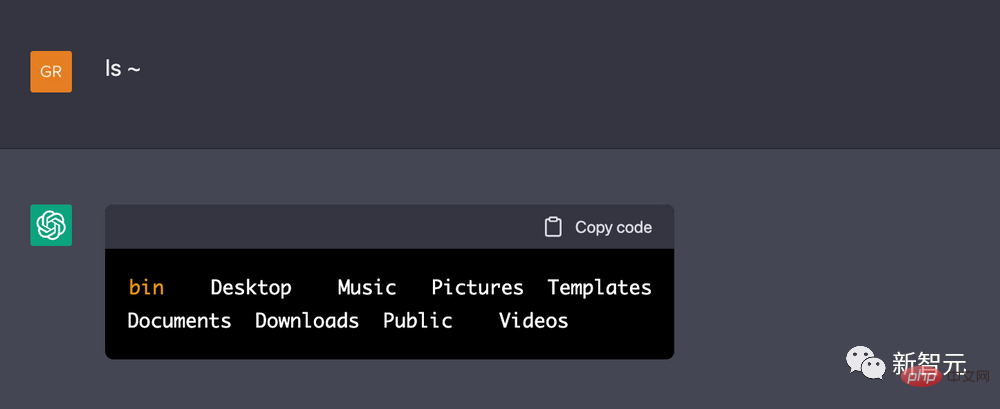

Ein DeepMind-Ingenieur berichtete sogar, dass er ChatGPT glauben lassen konnte, es sei ein Linux-Terminal, und einen einfachen mathematischen Code ausführen konnte, um die ersten 10 Primzahlen zu berechnen. Es ist erwähnenswert, dass ChatGPT die Aufgabe schneller abschließen kann, als wenn derselbe Code auf einem echten Linux-Rechner ausgeführt wird.

Wie bei der Film-Emoji-Symbolaufgabe haben Forscher keinen Grund zu der Annahme, dass ein Sprachmodell zur Textvorhersage ein Computerterminal imitieren kann. Viele aufkommende Verhaltensweisen demonstrieren die Null-Schuss- oder Wenig-Schuss-Lernfähigkeiten von Sprachmodellen. Das heißt, LLM bietet die Möglichkeit, Probleme zu lösen, die noch nie oder selten zuvor aufgetreten sind.

Eine große Anzahl von Forschern hat Anzeichen dafür gefunden, dass LLM die Einschränkungen von Trainingsdaten überwinden kann, und sie arbeiten daran, besser zu verstehen, wie Emergenz aussieht und wie sie abläuft, und der erste Schritt besteht darin, sie vollständig zu dokumentieren.

Jenseits des Nachahmungsspiels

Im Jahr 2020 sagten Dyer und andere bei Google Research voraus, dass LLM transformative Auswirkungen haben würde, aber welche genau diese Auswirkungen sein würden, bleibt eine offene Frage.

Daher haben sie verschiedene Forschungsteams gebeten, Beispiele für schwierige und vielfältige Aufgaben bereitzustellen, um die Leistungsgrenzen von Sprachmodellen zu ermitteln. Diese Arbeit wird auch „Beyond the Imitation Game Benchmark“ (BIG-Bench, Beyond the Imitation Game Benchmark) genannt Der Name des Projekts geht auf das von Alan Turing vorgeschlagene „Imitationsspiel“ zurück, bei dem getestet wird, ob der Computer Fragen auf überzeugende und humane Weise beantworten kann, auch Turing-Test genannt.

Wie erwartet verbesserte sich die Leistung des Modells bei einigen Aufgaben reibungslos und vorhersehbar, während bei anderen Aufgaben die Erweiterung der Parameteranzahl zu keiner Verbesserung führte.

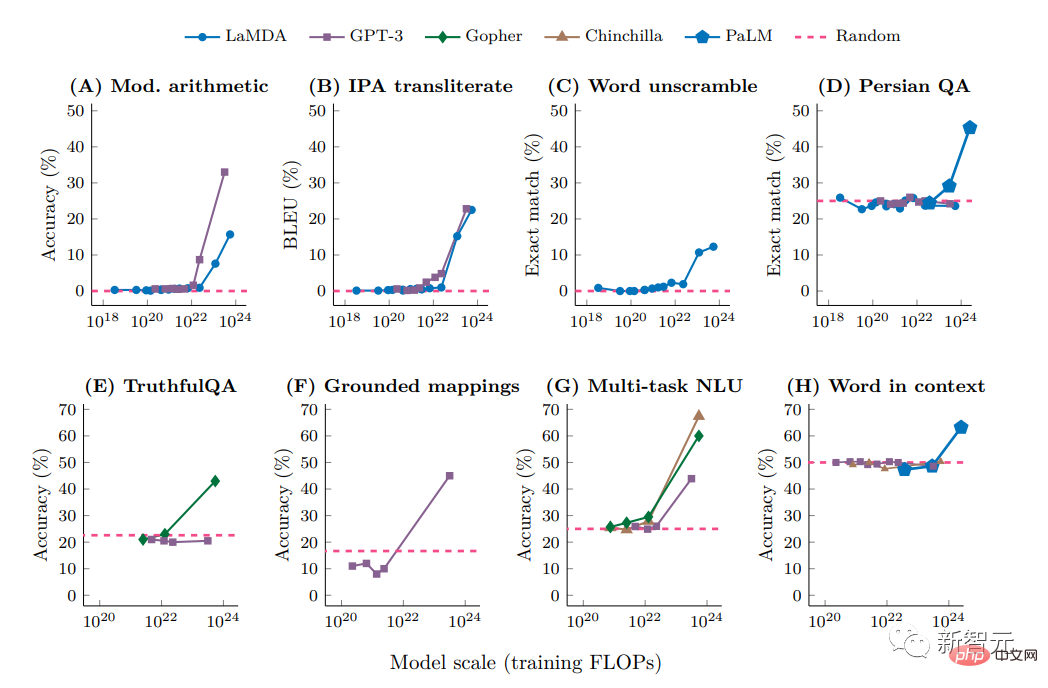

Allerdings stellten die Forscher bei etwa 5 % der Aufgaben sogenannte „Durchbrüche“ fest, also schnelle und dramatische Leistungssprünge innerhalb eines bestimmten Schwellenwertbereichs, der je nach Aufgabe und Modellwechsel variiert.

Zum Beispiel kann ein Modell mit relativ wenigen Parametern (nur ein paar Millionen) ein dreistelliges Additions- oder zweistelliges Multiplikationsproblem nicht erfolgreich lösen, aber bei zig Milliarden Parametern verbessert sich die Genauigkeit einiger Modelle erheblich.

Ähnliche Sprünge wurden bei anderen Aufgaben beobachtet, einschließlich der Dekodierung des Internationalen Phonetischen Alphabets, der Entschlüsselung der Buchstaben eines Wortes, der Identifizierung anstößiger Inhalte in Hinglisch-Passagen (einer Kombination aus Hindi und Englisch) und der Generierung von Wörtern, die dem englischen Äquivalent der Swahili-Sprichwörter ähneln.

Aber die Forscher erkannten bald, dass die Modellkomplexität nicht der einzige Treiber war. Wenn die Datenqualität hoch genug war, konnten einige unerwartete Fähigkeiten aus kleineren Modellen mit weniger Parametern oder in kleineren Datensätzen erzielt werden Die Abfrage wirkt sich auch auf die Genauigkeit der Modellantwort aus.

Letztes Jahr zeigten Google Brain-Forscher in einem auf NeurIPS, der Flaggschiff-Konferenz auf diesem Gebiet, veröffentlichten Artikel, wie das Modell Eingabeaufforderungen verwenden kann, um sich selbst zu erklären (Denkkettenschlussfolgerung), beispielsweise wie man mathematische Textaufgaben richtig löst Das gleiche Modell kann ohne Hinweise nicht richtig gelöst werden.

Link zum Papier: https://neurips.cc/Conferences/2022/ScheduleMultitrack?event=54087

Yi Tay, ein Wissenschaftler bei Google Brain, der sich der systematischen Erforschung von Durchbrüchen verschrieben hat, wies darauf hin, dass aktuelle Forschungsergebnisse dies zeigen Die Eingabeaufforderungen der Denkkette. Eine Änderung der Skalenkurve des Modells verändert auch den Entstehungspunkt. Die Verwendung von Eingabeaufforderungen der Gedankenkette kann auftauchende Verhaltensweisen auslösen, die im BIG-Experiment nicht zu finden sind.

Ellie Pavlick, Informatikerin an der Brown University, die sich mit rechnergestützten Sprachmodellen beschäftigt, glaubt, dass diese jüngsten Erkenntnisse mindestens zwei Möglichkeiten aufwerfen:

Die erste besteht darin, dass, wie Vergleiche mit biologischen Systemen zeigen, größere Modelle tatsächlich anwachsen Neue Fähigkeiten entstehen spontan, höchstwahrscheinlich, weil das Modell grundlegend etwas Neues und Anderes lernt, das im kleineren Modell nicht vorhanden ist, was genau das sein soll, was der Fall sein soll. Wenn das Modell vergrößert wird, treten einige grundlegende Veränderungen auf.

Eine andere, weniger sensationelle Möglichkeit besteht darin, dass das, was wie ein bahnbrechendes Ereignis aussieht, ein interner, statistikgesteuerter Prozess sein könnte, der auf einer Denkkette basiert, und dass große LLMs möglicherweise einfach Heuristiken für diejenigen Parameter mit weniger Parametern oder lernen Aufgrund der geringeren Datenqualität können heuristische Algorithmen nicht implementiert werden.

Aber sie glaubt, dass die Frage, welche dieser Erklärungen wahrscheinlicher ist, davon abhängt, wie LLMs funktionieren, und da wir nicht wissen, wie sie unter der Haube funktionieren, können wir nicht sagen, welche dieser Vermutungen zutreffender ist vernünftig .

Unter unbekannten Kräften versteckte Fallen

Google veröffentlichte im Februar das ChatGPT-ähnliche Produkt Bard, doch bei der Demonstration wurde ein sachlicher Fehler aufgedeckt, der ebenfalls eine Enthüllung brachte, obwohl immer mehr Forscher begannen, sich auf diese Sprachmodelle zu verlassen Sie führten grundlegende Arbeiten durch, konnten sich aber nicht auf die Ergebnisse dieser Modelle verlassen und brauchten Leute, die ihre Arbeit weiter überprüften.

Emergenz schafft Unvorhersehbarkeit, und die Unvorhersehbarkeit nimmt mit der Größenordnung zu, was es für Forscher schwierig macht, die Folgen einer weit verbreiteten Nutzung vorherzusagen.

Wenn Sie Emergenzphänomene untersuchen möchten, müssen Sie zunächst einen Fall im Kopf haben. Bevor Sie die Auswirkungen der Größenordnung untersuchen, können Sie nicht wissen, welche Fähigkeiten oder Einschränkungen auftreten können.

In einigen Modellen treten auch einige schädliche Verhaltensweisen auf. Aktuelle Analyseergebnisse von LLM zeigen, dass die Entstehung sozialer Vorurteile häufig mit einer Vielzahl von Parametern einhergeht, was bedeutet, dass große Modelle plötzlich voreingenommener werden, wenn sie nicht gelöst werden können. Dieses Risiko kann die Forschungsobjekte dieser Modelle gefährden.

Das obige ist der detaillierte Inhalt vonGPT-4 ist zu stark, selbst OpenAI versteht es nicht! Wie entstand plötzlich Intelligenz?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr